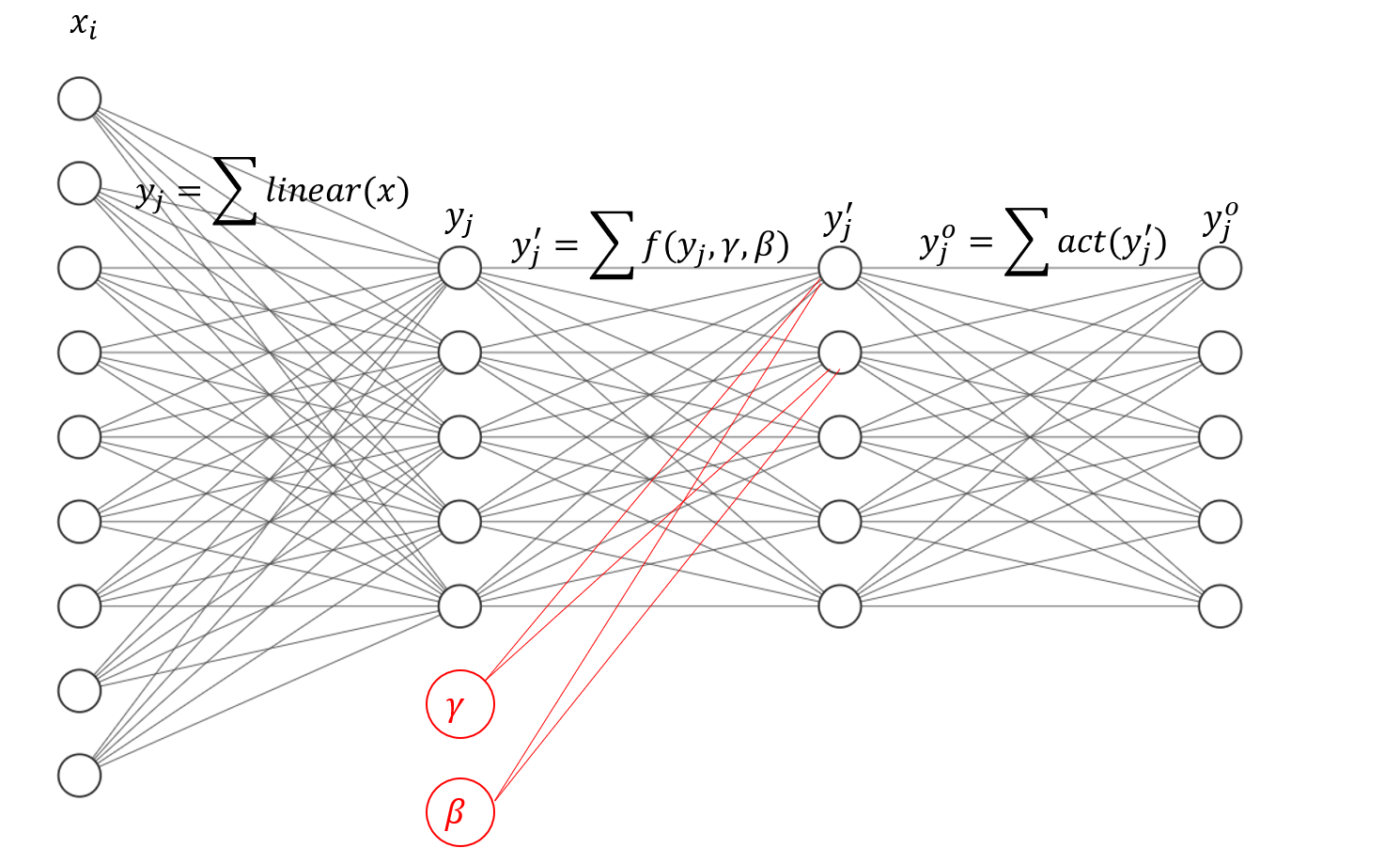

全连接批量归一化

- 目的是:只有一个学习率, 通过归一化,让所有的 x i x_i xi具有一样的分布,则对每个参数 w i w_i wi梯度的作用是相当的

- 实现是:实际上是在全连接中增加了两个节点 γ \gamma γ, β \beta β

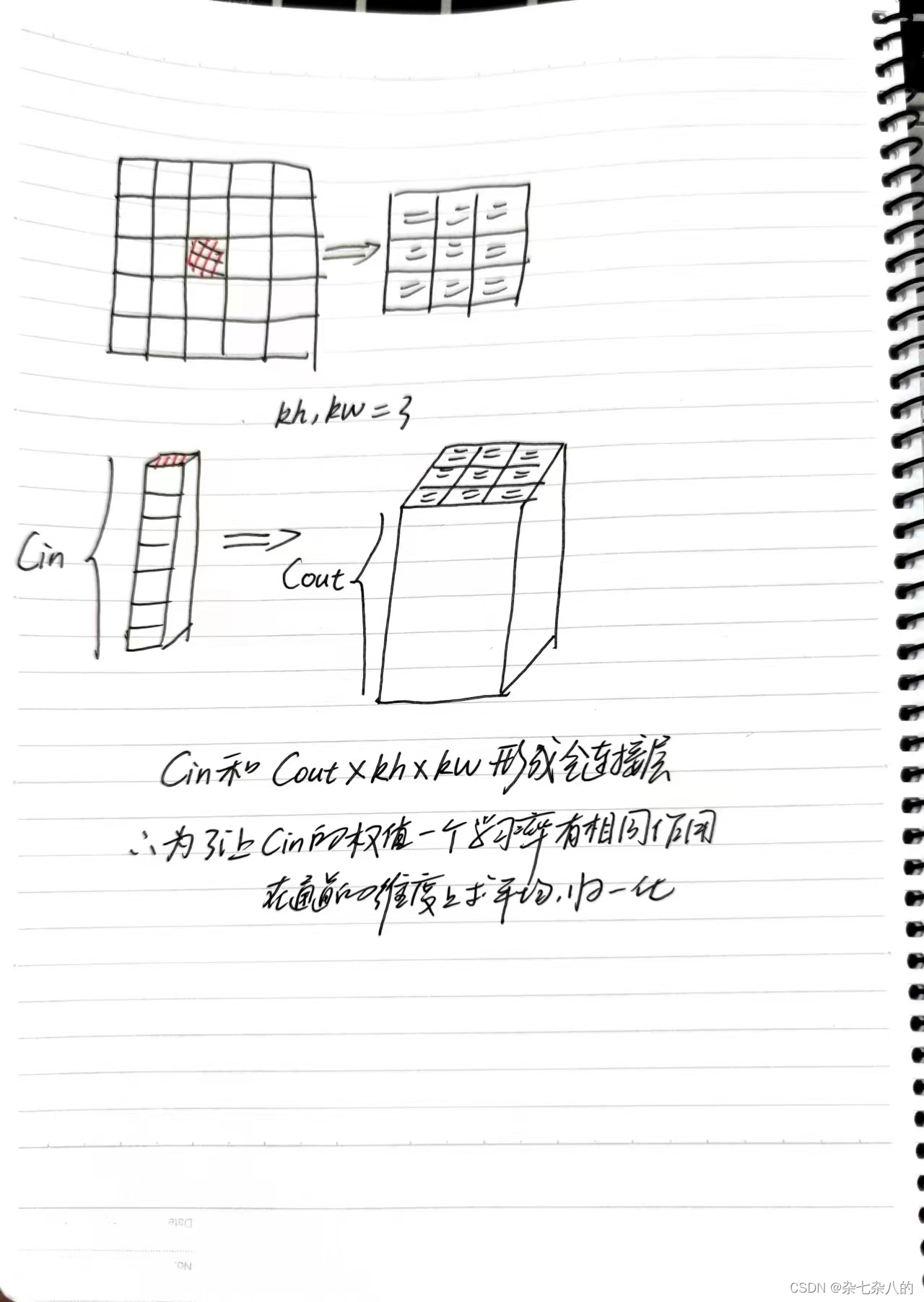

卷积批量归一化

- 卷积实际上是一种共用权值的批量归一化层,输入一个特征图通道上的所有值和输出的一块区域事实上形成了全连接

- 输入: 1 × 1 × C i n 1 \times 1 \times C_{in} 1×1×Cin

- 输出: h k × w k × C o u t h_k \times w_k \times C_{out} hk×wk×Cout

参数总量: C i n × h k × w k × C o u t C_{in} \times h_k \times w_k \times C_{out} Cin×hk×wk×Cout

torch张量维度重构

参考:

一文读懂torch的view机制

torch的view和reshape底层机制

import torch

arr = torch.rand(2, 3, 4, 5)

arr_1d = arr.flatten()

for d1 in range(2):for d2 in range(3):for d3 in range(4):for d4 in range(5):index = d1 * 3 * 4 * 5 + d2 * 4 * 5 + d3 * 5 + d4 * 1print(arr_1d[index])