随着ChatGPT等大模型的出现,AGI概念正在从哲学层面快速转向实际应用落地,并且ChatGPT已经展示出了初级AGI的功能(如AutoGPT),有不少专家认为,AGI时代可能在10年内到来。

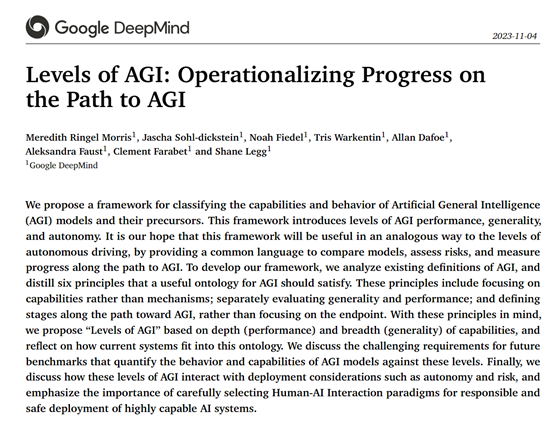

因此,需要一个明确的技术框架来讨论和衡量不同系统的AGI能力。谷歌的DeepMind研究人员提出了6项关于“AGI框架”的定义原则。

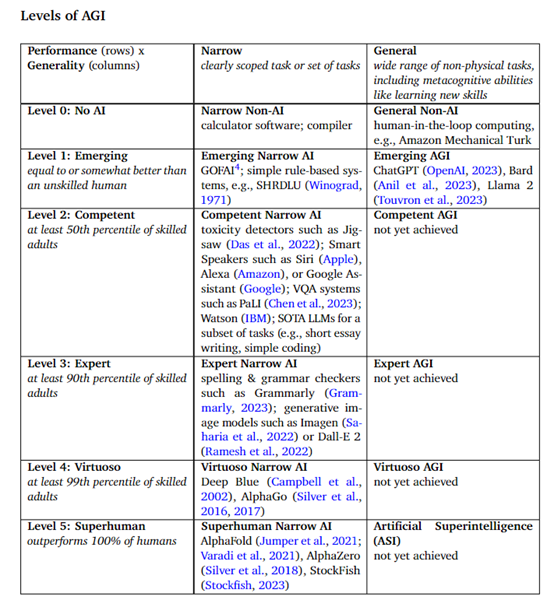

基于这些原则,又提出了表现力和通用性两个维度的AGI技术框架,包含5个表现力等级(初级、熟练、专家、大师和超人)和通用详细等级划分。

论文地址:https://arxiv.org/abs/2311.02462

谷歌研究人员表示,这一框架有助于指导AGI定义和风险评估,为技术研究指明了发展方向。期待学术界可以在此基础上开展后续研究,逐步完善AGI的量化框架和基准测试,以更准确地衡量AI的进步,并谨慎应对风险。

AGI简单介绍

AGI英文全称是Artificial General Intelligence,中文译为通用人工智能。AGI是指在任何任务上,AI都可以像人类一样表现出高度适应性和灵活性,高效率地完成指定任务。

当前的AI通常被设计为在特定的任务或问题范围内表现出色,而AGI能够跨领域学习、理解、推理并应用所学知识。

ChatGPT已经具备初级AGI功能,例如,它既能当情感伴侣与你聊天,也能查看邮件、生成创意文本/图片等,帮你处理日常工作。

AGI的主要技术特征包括学习、推理、理解、感知、创造、通用学习、自我意识等重要能力。

学习能力:AGI应能够自主学习新任务,而无需针对每项任务的特殊编程。

推理能力:能够用拟人化的逻辑推理来解决复杂问题。

理解力:可以理解语言、概念、情感等,以及如何处理它们之间的关系。

感知能力:能够通过感官(例如,计算机视觉、语音识别)来感知这个世界。

创造力:能够创造性地解决问题,例如,生成图片、语音、视频等。

通用学习:能够将在一领域学到的知识,迁移到其他领域。

自我意识:理论上,AGI需具备记忆存储、历史查询的能力,让其拥有自我意识以提升工作效率。

谷歌对于AGI则提出了6项更具体,有指导意义的原则,这有助于该技术以健康、安全的方式发展。

通用性和表现力

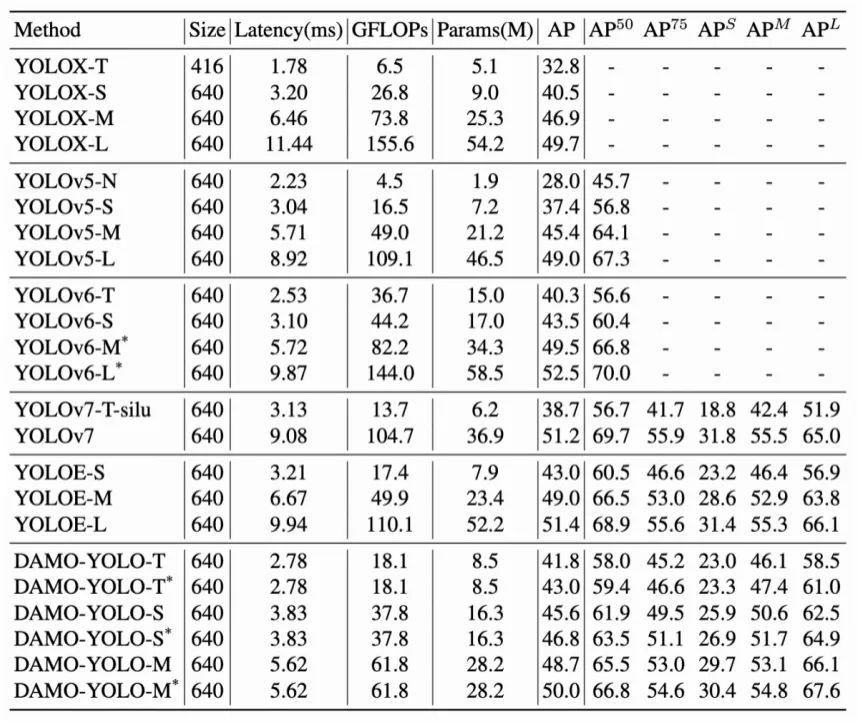

衡量一个AGI需要同时考量其通用性和表现力两个维度。通用性指能够处理任务的广度和多样性,表现力指在这些任务上达到的水平。

高通用性和表现力都对AGI意义重大且不可或缺。一个系统即使在很多任务上有出色表现,如果这些任务过于相似或局限,也难称为AGI。

反过来,一个极为通用的系统,如果所有任务的完成质量都很差,也与人类智能难以媲美。通用性和表现力必须同时达标,才可能成为AGI。谷歌对于这两个维度给出了详细的定义框架。

1)表现力

初级(Emerging)

要求与不熟练的人类差不多或略胜。对应狭窄AI中的早期专家系统,通用AI中的大型语言模型。

熟练(Competent)

要求超过50%熟练成人的表现。对应狭窄AI中的语音助手、VQA系统等。尚无通用AI达到。

专家(Expert)

要求超过90%熟练成人的表现。对应狭窄AI中的语法检查、图像生成模型等。尚无通用AI达到。

大师(Virtuoso)

要求超过99%熟练成人的表现。对应狭窄AI中的围棋软件AlphaGo等。尚无通用AI达到。

超人(Superhuman)

要求超过100%人类的表现,做到人类根本无法企及的任务。对应狭窄AI中的AlphaFold蛋白结构预测等。

2)通用性

狭窄AI(Narrow AI)

只能处理一小类特定的任务。不同表现力层次要求同上。

通用AI(General AI)

需要能处理广泛的认知任务,包括语言、逻辑、创造等大部分人类有能力的任务。

不同表现力层次对应的最低要求如下:

初级:各任务表现尚可,但大多数任务不佳。

熟练:大多数任务达到一般人中等水平。

专家:大多数任务超过90%人类表现。

大师:所有任务超过99%人类表现。

超人:所有任务超出人类极限。

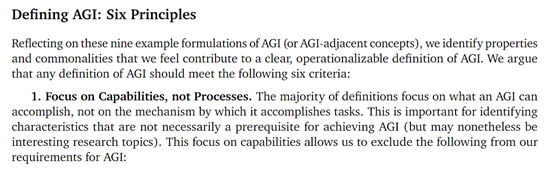

关注能力而非机制

AGI的定义应该关注AI系统的能力,而不是实现这些能力的具体机制。例如,我们不应该要求AGI必须通过类似人脑的学习机制来实现其能力,也不应将AGI的定义建立在“强AI”这样主观意识方面的假设上。AGI的重点应是评估其可以完成的任务类型和效果。

这条原则的合理性在于,神经网络等当前主流技术的成功正是建立在不完全拟人的基础上。与人脑相比,它们有着完全不同的计算机构成和信息处理方式。

面向能力而非特定机制,既可以避免因为假设了不必要的实现条件而过早地限制AGI的定义,也可以忽略那些目前难以科学检验的主观意识属性,把讨论集中在较为客观和可操作的能力层面。

元认知能力

AGI的定义应该关注处理非物理世界的认知任务,而不是要求必须具备机器人那样的物理能力。元认知能力,如学习新技能的能力,也被认为是AGI达到高通用性的关键。

之所以这样,是因为目前在非物理领域如语言、视觉、推理等方面,AI系统取得的进展明显领先于具备实际移动操作能力的机器人。

将物理能力作为AGI的先决条件,显然过于苛刻。当然,长远来看,在物理世界获得经验可能会提升一些认知能力,但短期内应该关注AI已比较拔尖的认知能力。

关注潜力而非部署

谷歌认为,我们不应该要求一个系统必须被实际大规模部署,才能被认定为AGI。只要一个系统能够在受控环境下,通过标准测试展示完成某类别任务的能力,就可以认定它具备对应的AGI水平。

因为实际部署会带来很多技术之外的障碍,如法律监管、社会接受度等。把部署作为AGI的必要条件,让AGI的判定标准包含了太多非技术因素。我们应该关注AI系统的本质能力,而不是它的实际应用程度。

关于生态

用于衡量AGI的任务应具有生态效度,即与人类在现实生活中重视的任务尽可能接近。不应只关注那些易于量化但是与实际生活脱节的任务。

现有的许多AI基准测试过于简化,脱离实际场景,很难真正评估一个系统在复杂环境下协助人类的能力。

相反,我们需要设计更贴近真实世界,模拟人类活动的测试,以得到对AGI实际能力的准确评估。这需要我们跳出传统的思维定势,不仅追求易测量,也要追求对用户有意义。

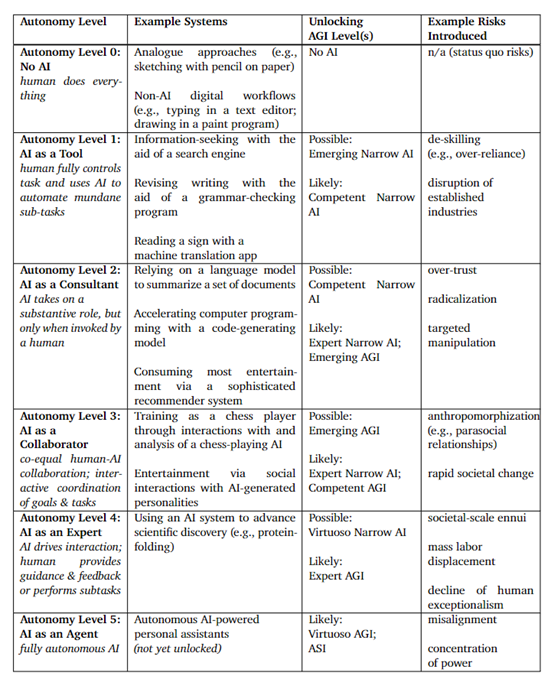

关注通往AGI的路径,而非单一目标

谷歌认为,我们应该将AGI视为一个连续发展的过程,而不是一个固定的目标。需要设定AGI发展路径上的多个进展阶段,而不是只关注最终的AGI概念。

这种层次化和渐进的方法有助于我们理解和把控AGI的进展轨迹。不同层次也对应着不同的风险和对策。

如果只一味追求最终的AGI,很容易忽视进展过程中的重要问题。而一个循序渐进的多阶段框架,则支持我们在每一步都审慎地评估机遇和风险,以确保AI的健康发展。

本文素材来源谷歌论文,如有侵权请联系删除