注1:本文系“简要介绍”系列之一,仅从概念上对神经符号结合进行非常简要的介绍,不适合用于深入和详细的了解。

融合深度学习与符号逻辑:神经符号结合的探索

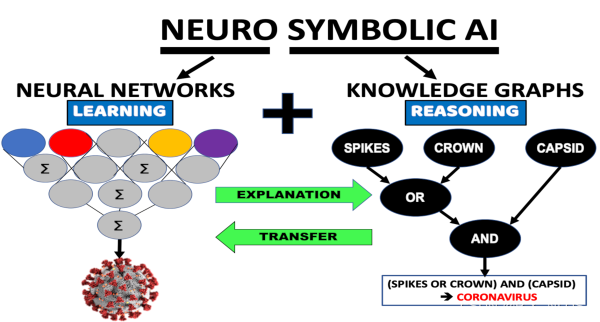

Neuro-Symbolic AI

本文将探讨神经符号结合的概念、原理、研究现状、挑战和未来展望。神经符号结合旨在将深度学习的强大表示学习能力与符号推理的逻辑性结合起来,以提高模型的解释性和鲁棒性。

背景介绍

在过去的十年里,深度学习取得了显著的进展,广泛应用于图像识别、自然语言处理、语音识别等领域。然而,深度学习模型往往缺乏解释性和鲁棒性,这使得它们在处理需要逻辑推理、规划和抽象表示的任务时表现不佳。为了解决这些问题,研究人员开始探索将深度学习与符号逻辑相结合的方法,即神经符号结合。

原理介绍和推导

神经符号结合的核心思想是将神经网络和符号逻辑相结合,使模型具有更强的解释性和鲁棒性。具体来说,神经符号结合可以分为以下几个方面:

-

知识表示:使用符号逻辑表示领域知识,例如知识图谱、本体论等。神经网络可以从这些结构化知识中学习潜在的模式和关系。

-

推理和规划:将符号逻辑推理与神经网络的强大表示学习能力结合起来,实现深度推理和规划。例如,可以设计神经网络来模拟逻辑推理过程,从而解决复杂的推理问题。

-

抽象表示:通过结合神经网络和符号逻辑,可以实现更高层次的抽象表示。例如,可以使用神经网络自动地学习符号表示,从而实现更高层次的抽象。

研究现状

神经符号结合领域的研究取得了一些初步的进展,以下是一些重要的研究方向:

-

神经程序合成:通过结合神经网络和符号程序,实现程序自动生成。例如,可以使用循环神经网络(RNN)来生成程序代码,实现自动程序合成。

-

神经图灵机:将神经网络与图灵机相结合,实现可微分的符号计算。神经图灵机可以在内部存储器上执行读写操作,实现复杂的符号推理和规划任务。

-

神经符号推理:设计基于神经网络的符号推理算法,实现深度推理任务。例如,可以使用注意力机制实现神经符号推理。

挑战

尽管神经符号结合领域取得了一些初步的进展,但仍然面临许多挑战,包括:

-

模型可解释性:神经网络的黑盒性质使得模型的解释性成为一个挑战。如何将符号逻辑与神经网络相结合,以提高模型的可解释性,仍然是一个需要研究的问题。

-

知识表示与推理:如何有效地将领域知识表示成符号逻辑,并在神经网络中实现推理,仍然是一个具有挑战性的问题。

-

抽象表示学习:如何在神经网络中实现更高层次的抽象表示,以支持复杂的推理和规划任务,仍然需要进一步研究。

-

模型鲁棒性:神经网络容易受到对抗攻击和噪声的影响,如何在神经符号结合的框架下提高模型的鲁棒性,是一个重要的研究方向。

未来展望

神经符号结合领域仍处于起步阶段,具有巨大的研究潜力和应用前景。未来,神经符号结合可能会取得以下方面的突破:

-

更强大的知识表示与推理能力:通过发展新的知识表示和推理方法,提高模型的推理能力和鲁棒性。

-

自动化的抽象表示学习:发展新的神经网络架构和学习算法,实现更高层次的抽象表示学习。

-

应用于实际问题:将神经符号结合技术应用于实际问题,例如自动驾驶、智能制造等领域,实现新的突破。

-

模型的可解释性和安全性:通过结合符号逻辑,提高神经网络模型的可解释性和安全性,以满足实际应用的需求。

代码示例

以下是一个使用神经网络模拟逻辑推理过程的简单示例,基于PyTorch实现:

import torch

import torch.nn as nn# 神经网络架构

class LogicInference(nn.Module):def __init__(self):super(LogicInference, self).__init__()self.fc1 = nn.Linear(2, 10)self.fc2 = nn.Linear(10, 1)def forward(self, x):x = torch.relu(self.fc1(x))x = torch.sigmoid(self.fc2(x))return x# 训练数据:逻辑“与”运算

train_data = torch.tensor([[0, 0], [0, 1], [1, 0], [1, 1]], dtype=torch.float32)

train_labels = torch.tensor([[0], [0], [0], [1]], dtype=torch.float32)# 实例化模型、损失函数和优化器

model = LogicInference()

criterion = nn.BCELoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)# 训练模型

for epoch in range(1000):optimizer.zero_grad()outputs = model(train_data)loss = criterion(outputs, train_labels)loss.backward()optimizer.step()# 测试模型

test_data = torch.tensor([[0, 0], [0, 1], [1, 0], [1, 1]], dtype=torch.float32)

predictions = model(test_data)

print(predictions)本示例仅用于演示如何使用神经网络实现简单的逻辑推理过程,实际应用中可能需要使用更复杂的神经网络架构和知识表示方法。