目录

- 工具库介绍

- scikit-learn

- statsmodels

- Seaborn

- PyTorch

- TensorFlow Datasets

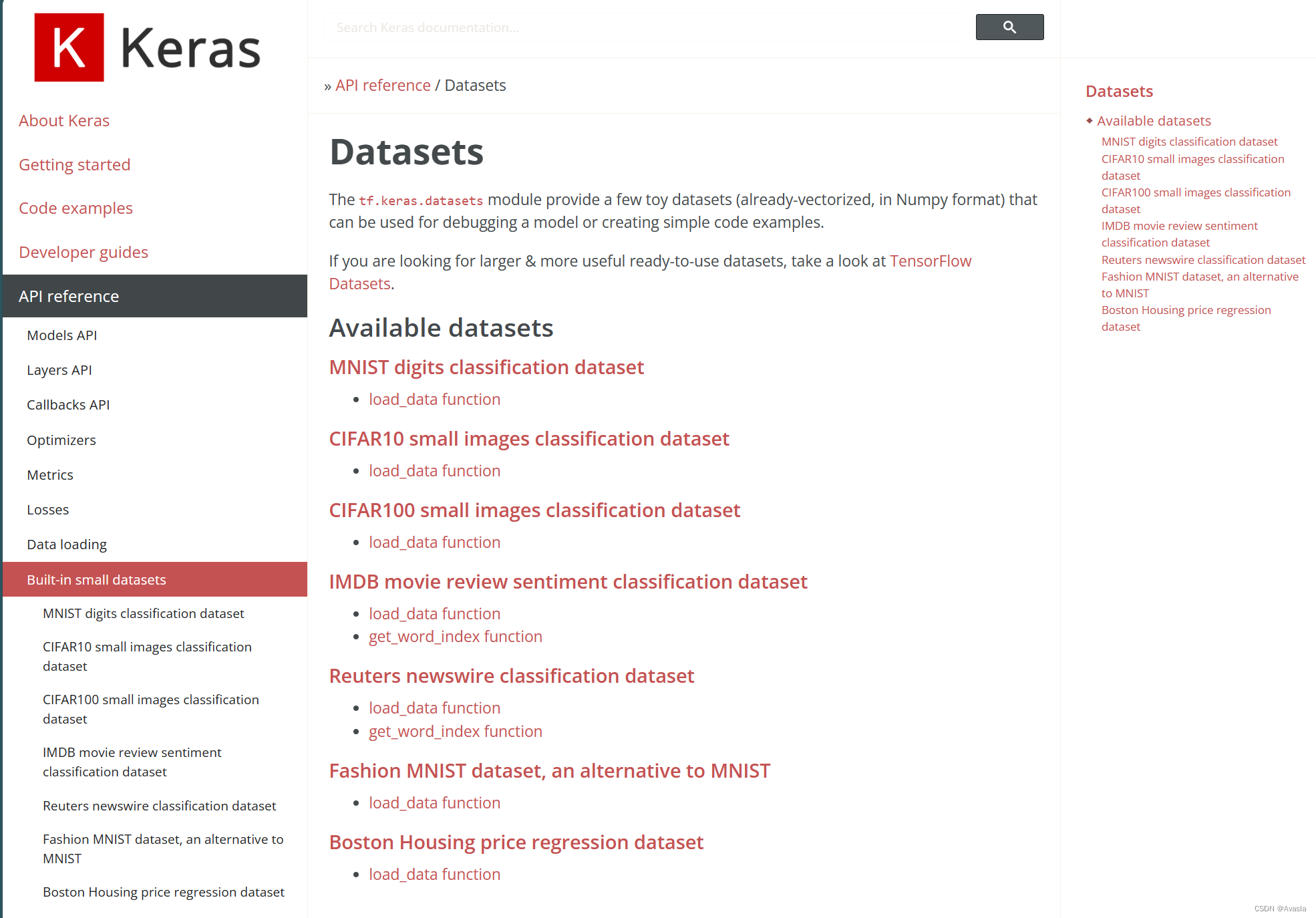

- Keras

- NLTK

- 参考链接

工具库介绍

为了使初学者更容易入门,许多开源库提供了丰富而标准化的示例数据集,其中包括scikit-learn、NLTK、TensorFlow Datasets、Keras Datasets、Statsmodels以及Seaborn等。

这些工具库不仅为初学者提供了方便的数据资源,还有对应的使用教程案例,基本上涵盖了所有数据类型:分类任务、预测问题、NLP自然语言处理项目以及深度学习中的图像、音频等等。

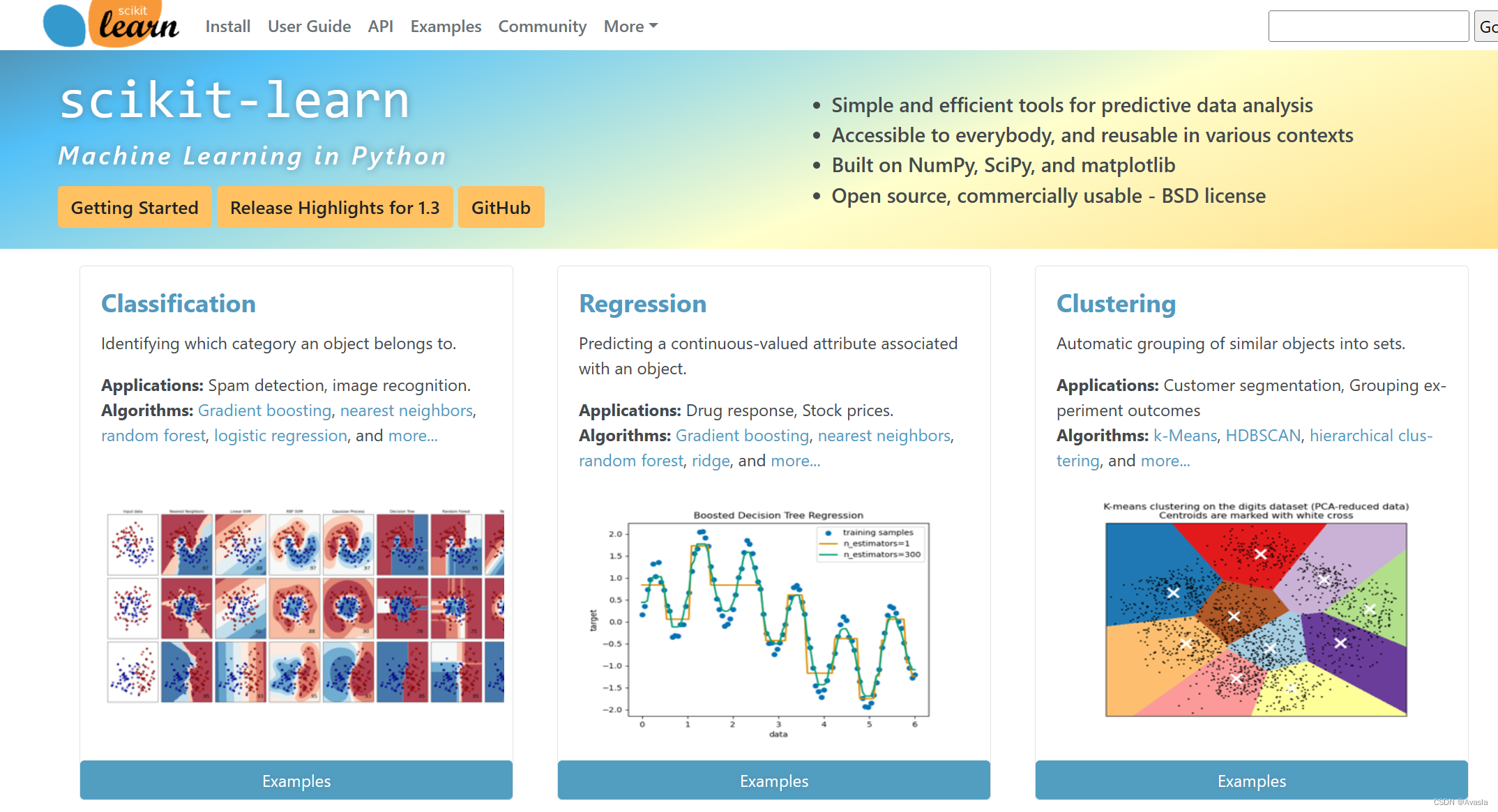

- Scikit-learn: Scikit-learn是一个用于机器学习和数据挖掘的Python开源库,提供了丰富而灵活的工具,用于数据预处理、模型选择、分类、回归等机器学习任务。

- Seaborn Datasets: Seaborn是一个用于绘制统计图形的库,同时也包含一些用于数据可视化的示例数据集,可通过

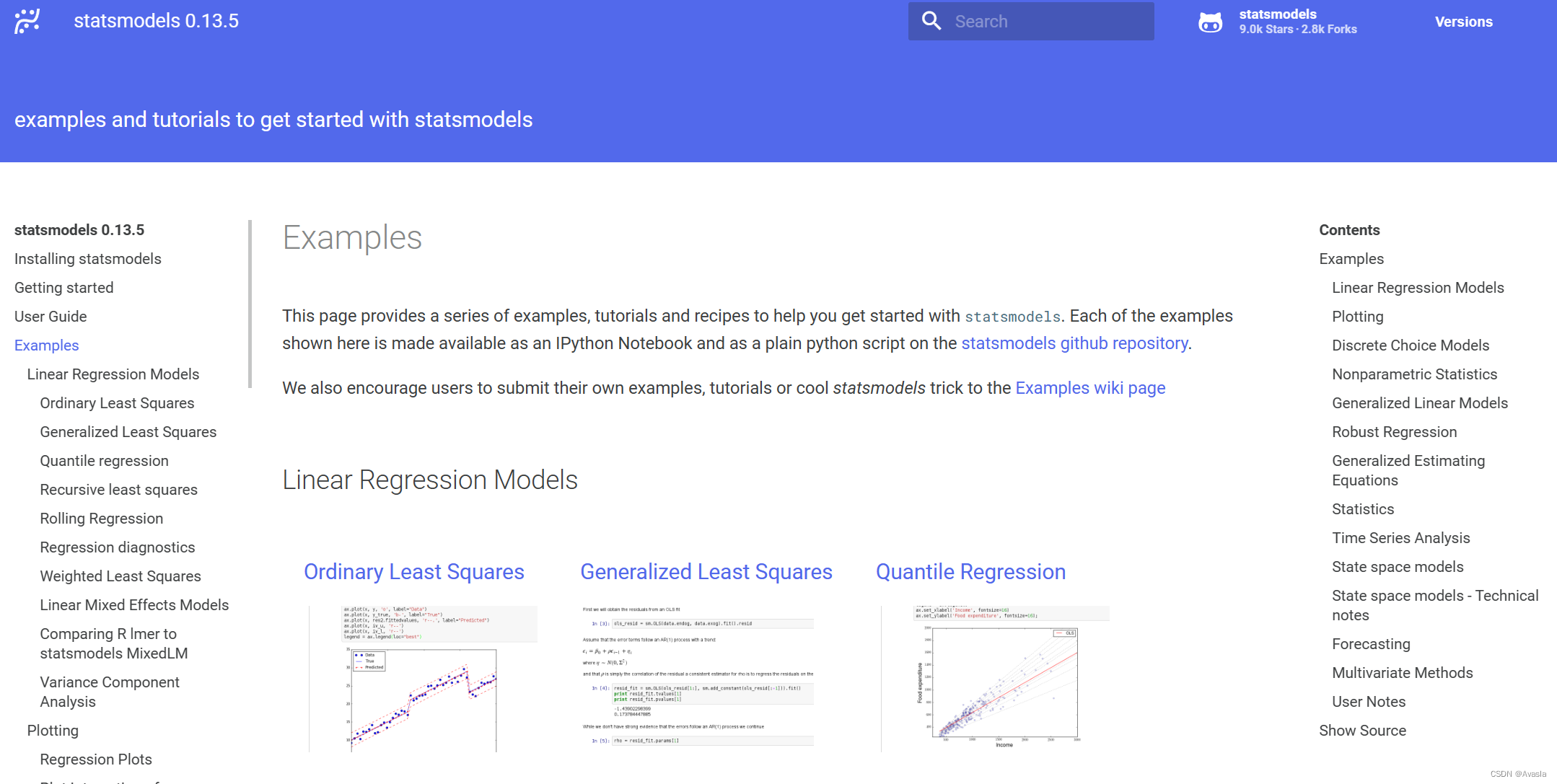

seaborn.load_dataset加载。 - Statsmodels Datasets: Statsmodels是一个用于估计和统计模型的库,它包含一些示例数据集,用于演示其统计模型的应用。

- TensorFlow Datasets (tfds): TensorFlow Datasets是由TensorFlow提供的一个库,其中包含了各种用于机器学习的数据集。

- PyTorch Datasets: PyTorch也提供了一些内置数据集,可通过

torchvision.datasets等模块进行访问。这些数据集通常用于计算机视觉任务。 - Keras Datasets: Keras(现在是TensorFlow的一部分)包含一些内置数据集,特别是用于深度学习的图像和文本数据集。

- NLTK (Natural Language Toolkit): NLTK是用于自然语言处理的库,提供了一些文本数据集,如语料库和语言模型。

scikit-learn

scikit-learn(sklearn)中常用数据集以及加载和探索它们的示例代码:

-

鸢尾花数据集(Iris Dataset): 包含150朵鸢尾花的数据集,每朵花属于三个不同的物种,可以用于各种分类任务的练习。

from sklearn.datasets import load_irisiris = load_iris() X, y = iris.data, iris.target# 现在 X 包含特征,y 包含标签 -

手写数字数据集(Digits Dataset):

- 包含8x8像素的手写数字图像数据集,涵盖数字0到9。

from sklearn.datasets import load_digitsdigits = load_digits() X, y = digits.data, digits.target# 现在 X 包含特征,y 包含标签 -

乳腺癌数据集(Breast Cancer Dataset):

- 用于乳腺癌诊断的数据集,包含从乳腺块的数字化图像中计算的特征。

from sklearn.datasets import load_breast_cancercancer = load_breast_cancer() X, y = cancer.data, cancer.target# 现在 X 包含特征,y 包含标签 -

葡萄酒数据集(Wine Dataset):

- 包含来自三种不同葡萄品种的葡萄酒的化学分析结果。

from sklearn.datasets import load_winewine = load_wine() X, y = wine.data, wine.target# 现在 X 包含特征,y 包含标签 -

糖尿病数据集(Diabetes Dataset):

- 用于糖尿病患者的数据集,包含十个基线变量,如年龄、性别、体重指数、平均血压和六项血清测量。

from sklearn.datasets import load_diabetesdiabetes = load_diabetes() X, y = diabetes.data, diabetes.target# 现在 X 包含特征,y 包含标签

statsmodels

statsmodels库提供了一些用于估计和统计模型的示例数据集。以下是一些常见的statsmodels数据集:

-

Anes96 数据集:

- 美国1996年总统选举的调查数据,包含有关选民投票的信息。

import statsmodels.api as sm anes96 = sm.datasets.anes96.load_pandas().data -

Ccard 数据集:

- 包含有关信用卡持有者和非持有者的信息。

import statsmodels.api as sm ccard = sm.datasets.ccard.load_pandas().data -

Copper 数据集:

- 描述了铜价格和生产量的时间序列数据。

import statsmodels.api as sm copper = sm.datasets.copper.load_pandas().data -

Longley 数据集:

- 由经济学家 Robert Longley 创建的数据集,包含了20世纪50年代至60年代初期的美国经济数据。

import statsmodels.api as sm longley = sm.datasets.longley.load_pandas().data -

Macrodata 数据集:

- 包含美国宏观经济数据的时间序列。

import statsmodels.api as sm macrodata = sm.datasets.macrodata.load_pandas().data -

Nile 数据集:

- 描述了尼罗河每年的水位。

import statsmodels.api as sm nile = sm.datasets.nile.load_pandas().data

这些数据集可以通过statsmodels.api中的相应函数进行加载,然后使用Pandas或其他数据处理工具进行进一步的分析和建模。请注意,这些数据集通常以Pandas DataFrame的形式返回,因此可以直接使用Pandas的功能进行数据处理和可视化。

Seaborn

Seaborn是一个基于Matplotlib的数据可视化库,它提供了一些示例数据集,用于绘制统计图形。以下是一些常见的Seaborn数据集:

-

Tips 数据集:

- 包含餐厅顾客给出的小费、总账单、顾客性别、就餐日期和就餐时间等信息。

import seaborn as sns tips = sns.load_dataset("tips") -

Flights 数据集:

- 包含了每个月的航班乘客数量的时间序列数据。

import seaborn as sns flights = sns.load_dataset("flights") -

Iris 数据集:

- 鸢尾花数据集,包含了三种不同鸢尾花的花瓣和萼片的测量值。

import seaborn as sns iris = sns.load_dataset("iris") -

Titanic 数据集:

- 包含了泰坦尼克号乘客的信息,如年龄、性别、仓位等,以及是否幸存的信息。

import seaborn as sns titanic = sns.load_dataset("titanic") -

Planets 数据集:

- 包含有关已知系外行星的信息,如发现日期、质量、距离等。

import seaborn as sns planets = sns.load_dataset("planets")

这些数据集可以通过seaborn.load_dataset函数加载,并且以Pandas DataFrame的形式返回。一旦加载了这些数据集,可以使用Seaborn和Matplotlib来创建各种统计图形。

PyTorch

PyTorch 提供了一些内置的数据集,这些数据集通常用于计算机视觉任务,可以使用 torchvision 库来访问这些数据集。以下是一些常见的 PyTorch 数据集及其加载代码:

-

MNIST 数据集:

- 包含手写数字(0到9)的灰度图像。

import torchvision.datasets as datasetsmnist_train = datasets.MNIST(root="./data", train=True, download=True) mnist_test = datasets.MNIST(root="./data", train=False, download=True) -

CIFAR-10 数据集:

- 包含 10 个不同类别的彩色图像。

import torchvision.datasets as datasetscifar10_train = datasets.CIFAR10(root="./data", train=True, download=True) cifar10_test = datasets.CIFAR10(root="./data", train=False, download=True) -

Fashion MNIST 数据集:

- 与 MNIST 类似,但包含了 10 种不同的时尚物品的灰度图像。

import torchvision.datasets as datasetsfashion_mnist_train = datasets.FashionMNIST(root="./data", train=True, download=True) fashion_mnist_test = datasets.FashionMNIST(root="./data", train=False, download=True) -

ImageNet 数据集:

- 包含大量类别的图像,用于图像分类任务。

import torchvision.datasets as datasets# 需要指定 ImageNet 数据集的路径 imagenet_train = datasets.ImageNet(root="./imagenet", split="train", download=True) imagenet_val = datasets.ImageNet(root="./imagenet", split="val", download=True)

这里,root 参数指定数据集下载的路径,train 参数指定是否下载训练集,download 参数用于指定是否下载数据集(如果尚未下载)。

TensorFlow Datasets

需要安装 tensorflow-datasets 库,使用以下命令安装:pip install tensorflow-datasets

TensorFlow Datasets (tfds) 是 TensorFlow 提供的一个库,用于加载和管理各种机器学习数据集。以下是一些常见的 TensorFlow Datasets 及其加载代码:

-

MNIST 数据集:

- 包含手写数字(0到9)的灰度图像。

import tensorflow_datasets as tfdsmnist, info = tfds.load("mnist", with_info=True) -

CIFAR-10 数据集:

- 包含 10 个不同类别的彩色图像。

import tensorflow_datasets as tfdscifar10, info = tfds.load("cifar10", with_info=True) -

IMDB 电影评论数据集:

- 包含来自 Internet Movie Database (IMDB) 的电影评论,用于情感分析任务。

import tensorflow_datasets as tfdsimdb, info = tfds.load("imdb_reviews", with_info=True) -

Fashion MNIST 数据集:

- 与 MNIST 类似,但包含了 10 种不同的时尚物品的灰度图像。

import tensorflow_datasets as tfdsfashion_mnist, info = tfds.load("fashion_mnist", with_info=True) -

tf_flowers 数据集:

- 包含五个不同类别的花卉图像。

import tensorflow_datasets as tfdsflowers, info = tfds.load("tf_flowers", with_info=True)

这里的 with_info=True 参数可用于获取有关数据集的额外信息,例如数据集的大小、```

Keras

在Keras中,keras.datasets模块提供了一些内置的数据集,用于快速测试和构建深度学习模型。以下是一些常见的Keras数据集及其加载代码:

-

MNIST 数据集:

- 包含手写数字(0到9)的灰度图像。

from keras.datasets import mnist(x_train, y_train), (x_test, y_test) = mnist.load_data() -

CIFAR-10 数据集:

- 包含 10 个不同类别的彩色图像。

from keras.datasets import cifar10(x_train, y_train), (x_test, y_test) = cifar10.load_data() -

Fashion MNIST 数据集:

- 与 MNIST 类似,但包含了 10 种不同的时尚物品的灰度图像。

from keras.datasets import fashion_mnist(x_train, y_train), (x_test, y_test) = fashion_mnist.load_data() -

IMDB 电影评论数据集:

- 包含来自 Internet Movie Database (IMDB) 的电影评论,用于情感分析任务。

from keras.datasets import imdb(x_train, y_train), (x_test, y_test) = imdb.load_data() -

Boston Housing 数据集:

- 包含波士顿地区的房价数据,用于回归任务。

from keras.datasets import boston_housing(x_train, y_train), (x_test, y_test) = boston_housing.load_data()

NLTK

NLTK(Natural Language Toolkit)是一个用于处理自然语言文本数据的Python库。NLTK包含了一些示例数据集,以及用于自然语言处理的工具和资源。

这些数据集和资源可以通过使用nltk.download函数进行下载。

以下是一些NLTK数据集及其加载代码的示例:

-

Gutenberg 语料库:

- 包含来自Project Gutenberg的文本文学作品。

import nltk from nltk.corpus import gutenbergnltk.download('gutenberg') gutenberg.fileids() -

Brown 语料库:

- 包含按照不同主题和文体划分的文本。

import nltk from nltk.corpus import brownnltk.download('brown') brown.categories() -

Movie Reviews 语料库:

- 包含正面和负面电影评论的语料库。

import nltk from nltk.corpus import movie_reviewsnltk.download('movie_reviews') movie_reviews.categories() -

Stopwords 停用词:

- 包含常见的停用词,用于文本处理时过滤掉常见的无意义词语。

import nltk from nltk.corpus import stopwordsnltk.download('stopwords') stop_words = set(stopwords.words('english')) -

WordNet 语料库:

- 包含词汇和单词之间的关系。

import nltk from nltk.corpus import wordnetnltk.download('wordnet')

参考链接

- scikit-learn官网: scikit-learn: machine learning in Python

- NLTK (Natural Language Toolkit)官方网站:NLTK

- TensorFlow Datasets 文档:tfds Documentation

- Keras Datasets 文档:Keras Datasets Documentation

- Statsmodels 官方网站:Statsmodels

- Seaborn 官方网站:Seaborn

- TensorFlow 官方网站:TensorFlow

- PyTorch 官方网站:PyTorch