在当今数字化时代,信息爆炸已成为常态。数据是现代商业的核心,而爬虫程序是获取数据的重要工具。Python作为一门通用编程语言,提供了许多方便快捷的库来配置爬虫代码。下面是一个简单的Python爬虫代码示例,帮助你快速上手。

首先,确保你已经安装了Python。然后,你需要安装requests和BeautifulSoup4库。你可以使用以下命令通过pip安装它们:

bash复制代码

| pip install requests beautifulsoup4 |

接下来,我们以爬取一个简单的网页为例。假设你想爬取一个商品列表页面,获取每个商品的名称和价格。

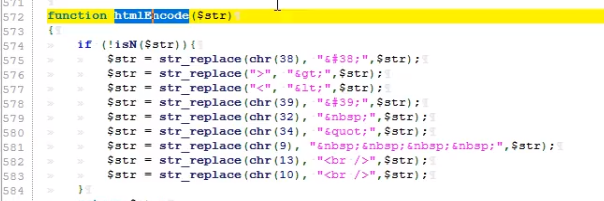

导入所需库:

python复制代码

| import requests | |

| from bs4 import BeautifulSoup |

发送HTTP请求并获取网页内容:

python复制代码

| url = 'https://example.com/products' # 替换为你要爬取的网页URL | |

| response = requests.get(url) | |

| html_content = response.content |

使用BeautifulSoup解析网页内容:

python复制代码

| soup = BeautifulSoup(html_content, 'html.parser') |

查找并提取所需数据:

python复制代码

| products = soup.find_all('div', class_='product') # 根据网页结构选择适当的标签和类名 | |

| for product in products: | |

| name = product.find('h2').text # 商品名称通常在h2标签内 | |

| price = product.find('span', class_='price').text # 商品价格通常在span标签内,具有特定的类名 | |

| print(f"Name: {name}, Price: {price}") # 输出商品名称和价格 |

- 可选:处理异常和错误。例如,如果目标网站有反爬虫机制,你可能需要添加适当的延迟以避免被封禁。此外,处理网络错误、解析异常等情况也是良好的编程实践。

- 运行程序:将上述代码保存到一个.py文件中(例如spider.py),然后在命令行中运行python spider.py。程序将自动爬取指定网页并输出商品信息。

- 调试和优化:根据实际需求和目标网站的结构,你可能需要调整代码以适应不同的情况。此外,你可以考虑使用更高级的爬虫框架(如Scrapy)来简化开发过程并提高效率。