文章目录

- 大数据深度解析NLP文本摘要技术:定义、应用与PyTorch实战

- 1. 概述

- 1.1 什么是文本摘要?

- 1.2 为什么需要文本摘要?

- 2. 发展历程

- 2.1 早期技术

- 2.2 统计方法的崛起

- 2.3 深度学习的应用

- 2.4 文本摘要的演变趋势

- 3. 主要任务

- 3.1 单文档摘要

- 3.2 多文档摘要

- 3.3 信息性摘要 vs. 背景摘要

- 3.4 实时摘要

- 4. 主要类型

- 4.1 抽取式摘要

- 4.2 生成式摘要

- 4.3 指示性摘要

- 4.4 信息性摘要

- 5. 抽取式文本摘要

- 5.1 定义

- 5.2 抽取式摘要的主要技术

- 5.3 Python实现

- 6. 生成式文本摘要

- 6.1 定义

- 6.2 主要技术

- 6.3 PyTorch实现

- 7. 总结

- 7. 总结

大数据深度解析NLP文本摘要技术:定义、应用与PyTorch实战

在本文中,我们深入探讨了自然语言处理中的文本摘要技术,从其定义、发展历程,到其主要任务和各种类型的技术方法。文章详细解析了抽取式、生成式摘要,并为每种方法提供了PyTorch实现代码。最后,文章总结了摘要技术的意义和未来的挑战,强调了其在信息过载时代的重要性。

1. 概述

文本摘要是自然语言处理(NLP)的一个重要分支,其核心目的是提取文本中的关键信息,生成简短、凝练的内容摘要。这不仅有助于用户快速获取信息,还能有效地组织和归纳大量的文本数据。

1.1 什么是文本摘要?

文本摘要的目标是从一个或多个文本源中提取主要思想,创建一个短小、连贯且与原文保持一致性的描述性文本。

例子: 假设有一篇新闻文章,描述了一个国家领导人的访问活动,包括他的行程、会面的外国领导人和他们讨论的议题。文本摘要的任务可能是生成一段如下的摘要:“国家领导人A于日期B访问了国家C,并与领导人D讨论了E议题。”

1.2 为什么需要文本摘要?

随着信息量的爆炸性增长,人们需要处理的文本数据量也在快速增加。文本摘要为用户提供了一个高效的方法,可以快速获取文章、报告或文档的核心内容,无需阅读整个文档。

例子: 在学术研究中,研究者们可能需要查阅数十篇或数百篇的文献来撰写文献综述。如果每篇文献都有一个高质量的文本摘要,研究者们可以迅速了解每篇文献的主要内容和贡献,从而更加高效地完成文献综述的撰写。

文本摘要的应用场景非常广泛,包括但不限于新闻摘要、学术文献摘要、商业报告摘要和医学病历摘要等。通过自动化的文本摘要技术,不仅可以提高信息获取的效率,还可以在多种应用中带来巨大的商业价值和社会效益。

2. 发展历程

文本摘要的历史可以追溯到计算机科学和人工智能的早期阶段。从最初的基于规则的方法,到现今的深度学习技术,文本摘要领域的研究和应用都取得了长足的进步。

2.1 早期技术

在计算机科学早期,文本摘要主要依赖基于规则和启发式的方法。这些方法主要根据特定的关键词、短语或文本的句法结构来提取关键信息。

例子: 假设在一个新闻报道中,频繁出现的词如“总统”、“访问”和“协议”可能会被认为是文本的关键内容。因此,基于这些关键词,系统可能会从文本中选择包含这些词的句子作为摘要的内容。

2.2 统计方法的崛起

随着统计学方法在自然语言处理中的应用,文本摘要也开始利用TF-IDF、主题模型等技术来自动生成摘要。这些方法在某种程度上改善了摘要的质量,使其更加接近人类的思考方式。

例子: 通过TF-IDF权重,可以识别出文本中的重要词汇,然后根据这些词汇的权重选择句子。例如,在一篇关于环境保护的文章中,“气候变化”和“可再生能源”可能具有较高的TF-IDF权重,因此包含这些词汇的句子可能会被选为摘要的一部分。

2.3 深度学习的应用

近年来,随着深度学习技术的发展,尤其是**循环神经网络(RNN)和变压器(Transformers)**的引入,文本摘要领域得到了革命性的提升。这些技术能够捕捉文本中的深层次语义关系,生成更为流畅和准确的摘要。

例子: 使用BERT或GPT等变压器模型进行文本摘要,模型不仅仅是根据关键词进行选择,而是可以理解文本的整体含义,并生成与原文内容一致但更为简洁的摘要。

2.4 文本摘要的演变趋势

文本摘要的方法和技术持续在进化。目前,研究的焦点包括多模态摘要、交互式摘要以及对抗生成网络在摘要生成中的应用等。

例子: 在一个多模态摘要任务中,系统可能需要根据给定的文本和图片生成一个摘要。例如,对于一个报道某项体育赛事的文章,系统不仅需要提取文本中的关键信息,还需要从与文章相关的图片中提取重要内容,将二者结合生成摘要。

3. 主要任务

文本摘要作为自然语言处理的一部分,其主要任务涉及多个方面,旨在满足不同的应用需求。以下是文本摘要中的几个关键任务,以及相关的定义和示例。

3.1 单文档摘要

这是文本摘要的最基本形式,从一个给定的文档中提取关键信息,生成一个简洁的摘要。

定义: 对一个单独的文档进行处理,提取其核心信息,生成一个凝练的摘要。

例子: 从一篇关于某地震事件的新闻报道中提取关键信息,生成摘要:“日期X,在Y地区发生了Z级地震,导致A人受伤,B人死亡。”

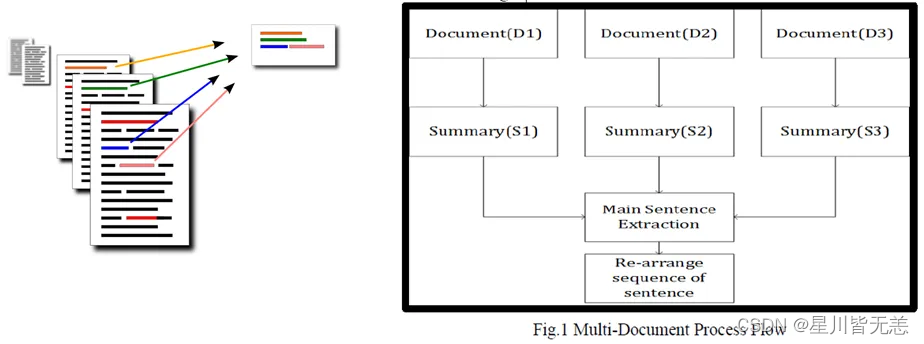

3.2 多文档摘要

该任务涉及从多个相关文档中提取和整合关键信息,生成一个综合摘要。

定义: 对一组相关的文档进行处理,合并它们的核心信息,生成一个综合的摘要。

例子: 从五篇关于同一项技术大会的报道中提取关键信息,生成摘要:“在日期X的技术大会上,公司Y、Z和W分别发布了他们的最新产品,并讨论了未来技术的发展趋势。”

3.3 信息性摘要 vs. 背景摘要

信息性摘要重点关注文档中的主要新闻或事件,而背景摘要则关注为读者提供背景或上下文信息。

定义: 信息性摘要提供文档的核心内容,而背景摘要提供与该内容相关的背景或上下文信息。

例子:

- 信息性摘要:“国家A和国家B签署了贸易协议。”

- 背景摘要:“国家A和国家B自去年开始进行贸易谈判,旨在增加两国间的商品和服务交易。”

3.4 实时摘要

这是一种生成动态摘要的任务,特别是当信息源持续更新时。

定义: 根据不断流入的新信息,实时地更新并生成摘要。

例子: 在一项体育赛事中,随着比赛的进行,系统可以实时生成摘要,如:“第一节结束,队伍A领先队伍B 10分。队伍A的球员C已经得到15分。”

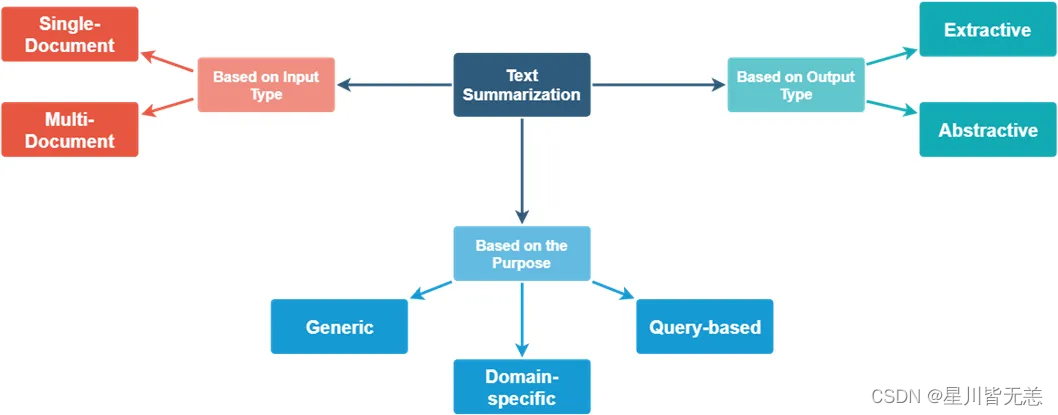

4. 主要类型

文本摘要可以根据其生成方式和特点划分为多种类型。以下是文本摘要领域中的主要类型及其定义和示例。

4.1 抽取式摘要

这种类型的摘要直接从原文中提取句子或短语来构成摘要,而不生成新的句子。

定义: 直接从原始文档中选择性地提取句子或短语,以生成摘要。

例子:

原文: “北京是中国的首都。它有着悠久的历史和丰富的文化遗产。故宫、长城和天安门都是著名的旅游景点。”

抽取式摘要: “北京是中国的首都。故宫、长城和天安门都是著名的旅游景点。”

4.2 生成式摘要

与抽取式摘要不同,生成式摘要会产生新的句子,为读者提供更为简洁和流畅的文本摘要。

定义: 基于原始文档的内容,生成新的句子来构成摘要。

例子:

原文: “北京是中国的首都。它有着悠久的历史和丰富的文化遗产。故宫、长城和天安门都是著名的旅游景点。”

生成式摘要: “北京,中国的首都,以其历史遗迹如故宫、长城和天安门而闻名。”

4.3 指示性摘要

这种类型的摘要旨在提供文档的大致内容,通常较为简短。

定义: 对文档进行快速概括,给出主要内容的简短描述。

例子:

原文: “微软公司是一家总部位于美国的跨国技术公司。它是世界上最大的软件制造商,并且生产多种消费电子产品。”

指示性摘要: “微软是一家大型的美国技术公司,生产软件和消费电子。”

4.4 信息性摘要

这种摘要提供更详细的信息,通常较长,涵盖文档的多个方面。

定义: 提供文档的详细内容概括,涵盖文档的核心信息。

例子:

原文: “微软公司是一家总部位于美国的跨国技术公司。它是世界上最大的软件制造商,并且生产多种消费电子产品。”

信息性摘要: “位于美国的微软公司是全球最大的软件生产商,同时还制造了多种消费电子产品。”

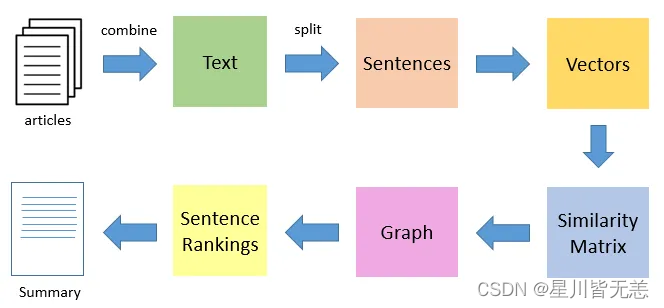

5. 抽取式文本摘要

抽取式文本摘要方法通过从原始文档中直接提取句子或短语来形成摘要,而不重新构造新的句子。

5.1 定义

定义: 抽取式文本摘要是从原始文档中选择性地提取句子或短语以生成摘要的过程。该方法通常依赖于文档中句子的重要性评分。

例子:

原文: “北京是中国的首都。它有着悠久的历史和丰富的文化遗产。故宫、长城和天安门都是著名的旅游景点。”

抽取式摘要: “北京是中国的首都。故宫、长城和天安门都是著名的旅游景点。”

5.2 抽取式摘要的主要技术

- 基于统计:使用词频、逆文档频率等统计方法为文档中的句子分配重要性分数。

- 基于图:如TextRank算法,将句子视为图中的节点,基于它们之间的相似性建立边,并通过迭代过程为每个句子分配得分。

5.3 Python实现

下面是一个简单的基于统计的抽取式摘要的Python实现:

import re

from collections import defaultdict

from nltk.tokenize import word_tokenize, sent_tokenizedef extractive_summary(text, num_sentences=2):# 1. Tokenize the textwords = word_tokenize(text.lower())sentences = sent_tokenize(text)# 2. Compute word frequenciesfrequency = defaultdict(int)for word in words:if word.isalpha(): # ignore non-alphabetic tokensfrequency[word] += 1# 3. Rank sentencesranked_sentences = sorted(sentences, key=lambda x: sum([frequency[word] for word in word_tokenize(x.lower())]), reverse=True)# 4. Get the top sentencesreturn ' '.join(ranked_sentences[:num_sentences])# Test

text = "北京是中国的首都。它有着悠久的历史和丰富的文化遗产。故宫、长城和天安门都是著名的旅游景点。"

print(extractive_summary(text))

输入:原始文本

输出:抽取的摘要

处理过程:该代码首先计算文档中每个词的频率,然后根据其包含的词频为每个句子分配重要性得分,并返回得分最高的句子作为摘要。

6. 生成式文本摘要

与直接从文档中提取句子的抽取式摘要方法不同,生成式文本摘要旨在为原始文档内容生成新的、更简洁的表达。

6.1 定义

定义: 生成式文本摘要涉及利用原始文档内容创造新的句子和短语,为读者提供更为简洁且相关的信息。

例子:

原文: “北京是中国的首都。它有着悠久的历史和丰富的文化遗产。故宫、长城和天安门都是著名的旅游景点。”

生成式摘要: “北京,中国的首都,以其历史遗迹如故宫、长城和天安门而闻名。”

6.2 主要技术

- 序列到序列模型 (Seq2Seq):这是一种深度学习方法,通常用于机器翻译任务,但也被广泛应用于生成式摘要。

- 注意力机制:在Seq2Seq模型中加入注意力机制可以帮助模型更好地关注原始文档中的重要部分。

6.3 PyTorch实现

下面是一个简单的Seq2Seq模型的概述,由于其复杂性,这里只提供一个简化版本:

import torch

import torch.nn as nnclass Encoder(nn.Module):def __init__(self, input_dim, emb_dim, hidden_dim):super(Encoder, self).__init__()self.embedding = nn.Embedding(input_dim, emb_dim)self.rnn = nn.GRU(emb_dim, hidden_dim)def forward(self, src):embedded = self.embedding(src)outputs, hidden = self.rnn(embedded)return hiddenclass Decoder(nn.Module):def __init__(self, output_dim, emb_dim, hidden_dim):super(Decoder, self).__init__()self.embedding = nn.Embedding(output_dim, emb_dim)self.rnn = nn.GRU(emb_dim + hidden_dim, hidden_dim)self.out = nn.Linear(hidden_dim, output_dim)def forward(self, input, hidden, context):input = input.unsqueeze(0)embedded = self.embedding(input)emb_con = torch.cat((embedded, context), dim=2)output, hidden = self.rnn(emb_con, hidden)prediction = self.out(output.squeeze(0))return prediction, hidden# 注: 这是一个简化的模型,仅用于展示目的。在实际应用中,您需要考虑添加更多细节,如注意力机制、优化器、损失函数等。

输入: 原始文档的词向量序列

输出: 生成的摘要的词向量序列

处理过程: 编码器首先将输入文档转换为一个固定大小的隐藏状态。然后,解码器使用这个隐藏状态作为上下文,逐步生成摘要的词向量序列。

7. 总结

随着科技的迅速发展,自然语言处理已从其原始的文本处理任务进化为复杂的多模态任务,如我们所见,文本摘要正是其中的一个明显例子。从基本的抽取式和生成式摘要到现今的多模态摘要,每一个阶段都反映了我们对信息和知识的不断深化和重新定义。

重要的是,我们不仅仅要关注技术如何实现这些摘要任务,更要明白为什么我们需要这些摘要技术。摘要是对大量信息的简化,它可以帮助人们快速捕获主要观点、节省时间并提高效率。在一个信息过载的时代,这种能力变得尤为重要。

上下文,逐步生成摘要的词向量序列。

7. 总结

随着科技的迅速发展,自然语言处理已从其原始的文本处理任务进化为复杂的多模态任务,如我们所见,文本摘要正是其中的一个明显例子。从基本的抽取式和生成式摘要到现今的多模态摘要,每一个阶段都反映了我们对信息和知识的不断深化和重新定义。

重要的是,我们不仅仅要关注技术如何实现这些摘要任务,更要明白为什么我们需要这些摘要技术。摘要是对大量信息的简化,它可以帮助人们快速捕获主要观点、节省时间并提高效率。在一个信息过载的时代,这种能力变得尤为重要。

但是,与此同时,我们也面临着一个挑战:如何确保生成的摘要不仅简洁,而且准确、客观,并且不失真。这需要我们不断完善和调整技术,确保其在各种场景下都能提供高质量的摘要。

![洛谷 P8772 [蓝桥杯 2022 省 A] 求和 刷题笔记](https://img-blog.csdnimg.cn/direct/7994d7cbf1ca4092b679a8134fefb703.png)