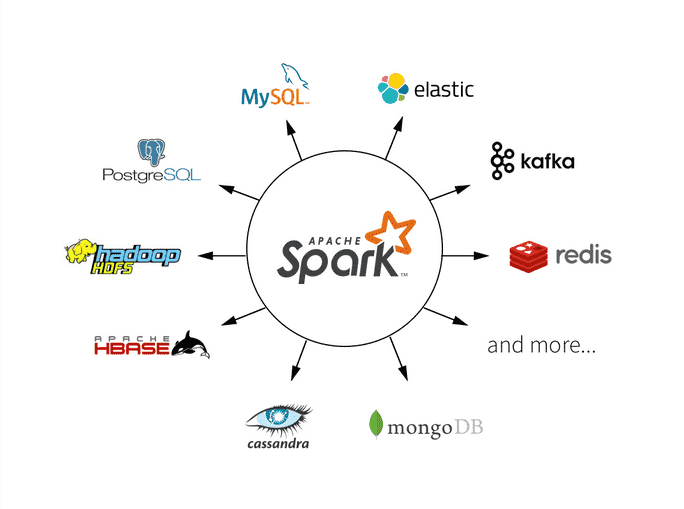

Apache Spark是一个强大的分布式计算框架,用于处理大规模数据。在开发和运行Spark应用程序时,经常会遇到各种错误和问题。了解Spark的错误处理与调试技巧是解决这些问题的关键。本文将深入探讨Spark中常见的错误类型、调试工具和技巧,并提供丰富的示例代码,以帮助大家更好地理解和解决问题。

Spark中的常见错误类型

在开发Spark应用程序时,可能会遇到各种错误类型。以下是一些常见的Spark错误类型:

1 Java虚拟机错误(Java Virtual Machine Errors)

这些错误通常是由于内存不足或虚拟机配置不当引起的。常见的错误包括OutOfMemoryError和StackOverflowError。解决这些错误通常需要调整虚拟机参数,如堆内存大小。

2 Spark异常(Spark Exceptions)

Spark本身会引发各种异常,如SparkException和IllegalArgumentException。这些异常通常是由于应用程序逻辑错误或配置问题引起的。

3 数据倾斜(Data Skew)

数据倾斜是一个常见的性能问题,它会导致某些任务比其他任务执行时间更长。这种情况通常需要特殊的处理和优化。

4 依赖问题(Dependency Issues)

依赖问题包括缺失的依赖库或版本冲突问题。这些问题可能会导致应用程序无法正常运行。

5 任务失败(Task Failures)

任务失败是指执行任务时出现错误,如数据丢失或节点故障。任务失败通常需要进行故障恢复和重试。

调试Spark应用程序的工具与技巧

为了更有效地调试Spark应用程序,可以使用各种工具和技巧。以下是一些常用的调试工具与技巧:

1 Spark Web UI

Spark提供了一个Web用户界面,可以通过浏览器访问。在这个界面中,可以查看应用程序的进度、任务执行情况、内存使用情况等信息。要启动Web UI,可以使用以下代码:

# 在驱动程序中查看Web UI地址

print("Spark Web UI: " + sc.uiWebUrl)

2 日志文件

Spark会生成详细的日志文件,记录应用程序的运行情况。可以查看这些日志文件以了解错误信息和调试信息。在驱动程序中,可以使用以下代码获取日志文件的路径:

# 获取Spark日志文件路径

log_file = sc.getConf().get("spark.driver.logFile")

print("Spark Log File: " + log_file)

3 调试工具

Spark提供了一些调试工具,如spark-submit的--conf选项,可以用来配置调试参数。例如,可以启用远程调试模式来连接驱动程序以进行实时调试。

spark-submit --conf "spark.driver.extraJavaOptions=-agentlib:jdwp=transport=dt_socket,server=y,suspend=n,address=5005" your_app.py

4 分析数据倾斜

对于数据倾斜问题,可以使用一些工具和技巧来分析和解决。例如,可以使用groupByKey操作而不是reduceByKey来避免数据倾斜,或者使用sample操作来查看数据分布情况。

# 使用sample操作查看数据分布

sampled_data = rdd.sample(False, 0.1)

示例:调试Spark应用程序

下面将演示一个示例,演示如何调试一个简单的Spark应用程序。假设有一个RDD,包含一些整数,想要计算它们的平均值。

from pyspark import SparkContext# 创建SparkContext

sc = SparkContext("local", "DebuggingExample")# 创建一个包含整数的RDD

data = [1, 2, 3, 4, 5]

rdd = sc.parallelize(data)# 计算平均值

total = rdd.reduce(lambda x, y: x + y)

count = rdd.count()

average = total / count# 打印结果

print(f"Average: {average}")# 停止SparkContext

sc.stop()

在这个示例中,首先创建了一个SparkContext,然后创建了一个包含整数的RDD。接下来,我们使用reduce操作计算总和和count操作计算元素数量,最后计算平均值。如果应用程序出现错误,可以使用前面提到的工具和技巧来调试问题。

性能优化和注意事项

在开发和调试Spark应用程序时,性能优化是一个重要的考虑因素。以下是一些性能优化和注意事项:

1 数据本地性优化

尽量保持数据本地性以降低网络传输开销。

2 持久化(Persistence)

在迭代计算中,可以使用persist操作将RDD的中间结果缓存到内存中,以避免重复计算。这可以显著提高性能。

rdd.persist()

3 数据倾斜处理

处理数据倾斜是一个重要的性能优化问题。可以使用groupByKey的变体或采样操作来减轻数据倾斜。

# 使用sample操作查看数据分布

sampled_data = rdd.sample(False, 0.1)

监控与性能分析

除了调试工具和技巧之外,监控和性能分析也是关键的方面,可以帮助您识别和解决Spark应用程序中的问题。以下是一些监控和性能分析的关键点:

1 Spark应用程序监控

使用Spark的监控工具来跟踪应用程序的运行情况。可以使用工具如Ganglia、Graphite、或Prometheus等来收集和可视化有关集群资源使用、任务执行、内存使用等信息。

2 日志级别设置

根据需要调整Spark应用程序的日志级别。在开发和调试阶段,可以将日志级别设置为DEBUG以获取更详细的信息,而在生产环境中可以将其设置为INFO或更高级别以减少日志输出量。

# 设置日志级别为DEBUG

sc.setLogLevel("DEBUG")

3 性能分析工具

使用性能分析工具来识别性能瓶颈和潜在的优化机会。工具如Apache Hadoop的YARN ResourceManager、Apache Spark的History Server以及第三方工具如VisualVM和YourKit可以分析应用程序的性能。

4 Spark UI的使用

利用Spark的Web用户界面(Spark UI)来监控应用程序的运行情况。Spark UI提供了有关作业、阶段、任务、内存使用等的详细信息,可以识别问题并优化性能。

错误处理最佳实践

除了上述工具和技巧,以下是一些错误处理的最佳实践,可更有效地管理和调试Spark应用程序:

1 异常处理

在代码中实现异常处理,捕获并记录异常信息。这有助于识别和调试问题,并提供更友好的错误消息。

try:# Spark操作

except Exception as e:# 记录异常信息logger.error("An error occurred: %s", str(e))# 可以选择抛出异常或采取其他措施

2 单元测试

编写单元测试来测试您的Spark操作。使用框架如PyTest或ScalaTest来编写测试用例,以确保代码在各种情况下都能正确运行。

3 监控报警

设置监控报警以及时发现问题。使用监控工具和报警系统来监控集群健康状况,并在发生异常或性能下降时及时通知运维人员。

总结

了解Spark的错误处理与调试技巧以及合理使用监控和性能分析工具是构建高效分布式应用程序的关键。本文深入探讨了常见的Spark错误类型、调试工具、技巧以及最佳实践,并提供了示例代码来帮助更好地理解和解决问题。

希望本文能够帮助大家更好地调试和优化Spark应用程序,顺利解决开发和部署中可能遇到的各种问题。