🍎个人博客:个人主页

🏆个人专栏: 日常聊聊

⛳️ 功不唐捐,玉汝于成

目录

前言

正文

1. 数据偏见:

介绍和解释:

解决方法:

2. 复制训练数据:

介绍和解决方法:

解决方法:

3. 不确定性问题:

介绍和解决方法:

解决方法:

4. 对抗攻击:

介绍和解决方法:

1. 对抗攻击的类型:

2. 黑盒攻击 vs 白盒攻击:

解决方法:

5. 模型解释性:

模型解释性:

6. 过度自信:

过度自信:

结语

我的其他博客

前言

深度学习模型在各领域展现出卓越的性能,但同时也面临模型解释性和过度自信的问题。理解模型的内部决策过程和解决过度自信是确保模型在实际应用中可信度和鲁棒性的关键。本文将深入探讨这两个问题,并提供解决方法,以平衡模型的解释性和鲁棒性。

正文

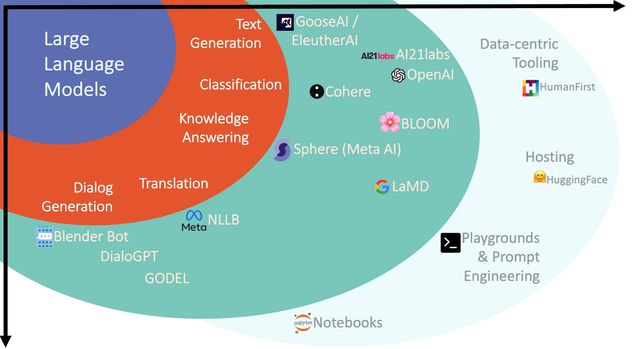

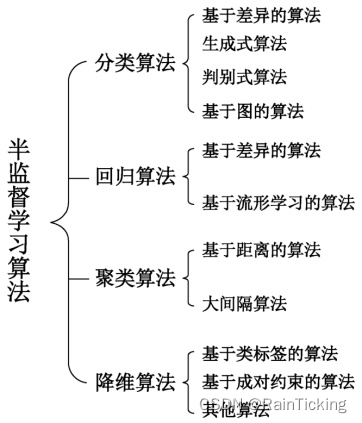

在深度学习领域,特别是大型语言模型(LLM,Large Language Models)的使用中,"幻觉"通常指的是模型生成的输出中包含虚假或不准确的信息。这种现象可能由于模型在训练数据中学到的噪声、偏见、或者不准确的关联性引起。以下是一些关于大模型幻觉问题的详细介绍和解决方法:

1. 数据偏见:

大型语言模型通常在庞大的文本数据集中进行训练,这些数据集可能包含社会、文化和性别偏见。模型可能会学到这些偏见,并在生成的文本中表现出来。解决方法包括使用更加多样化和平衡的训练数据,以减少模型学到的偏见。

介绍和解释:

1. 概念理解: 数据偏见可能涉及到对特定概念、群体或主题的不公平对待。例如,在社交媒体上的评论数据集中,可能存在对某一群体的负面刻板印象,这种偏见可能被模型学到并在生成文本时表现出来。

2. 数据收集源: 数据偏见通常来自于数据的收集源。如果某一特定群体在数据集中被低估或者被过度代表,模型就有可能在输出中反映这一失衡。例如,在医疗领域的数据集中,过度关注某一族群可能导致模型在生成医疗建议时偏向于这一族群。

3. 文本表达不平衡: 文本中的不同表达方式可能受到社会文化因素的影响,导致某些观点或群体被忽视。模型可能学到这种不平衡,从而在生成文本时反映出这些观点的偏见。

4. 镜像社会偏见: 数据集可能反映社会中已存在的偏见,例如性别、种族、地域等。如果这些社会偏见存在于数据集中,模型可能在生成文本时反映这些偏见,加深或传递社会上已有的刻板印象。

解决方法:

a. 多样性数据集: 使用更加多样化、平衡的数据集,确保各种群体和观点都得到充分的代表。这有助于减少模型学到的偏见。

b. 数据清理: 审查和清理训练数据,去除或减弱可能导致偏见的样本。这可能需要领域专业知识和人工审核。

c. 公平性评估: 使用公平性评估指标来检测模型的输出是否受到偏见影响。这可以帮助识别模型中的潜在问题并进行改进。

d. 贴标签的平衡性: 在进行监督学习时,确保标签的分布是平衡的,以防止模型过度关注某一类别。

e. 解释性工具: 使用模型解释性工具,帮助了解模型在生成输出时选择的依据,从而更好地识别和纠正潜在的偏见。

在处理数据偏见时,需要注意保护用户隐私和确保模型的公平性。这是一个复杂而持续的挑战,需要跨学科的合作和不断的改进。

2. 复制训练数据:

如果模型在训练数据中遇到了某个特定的模式或实例,它可能会过度关注这个模式,并在生成文本时反复使用。解决方法包括使用更多的数据增强技术,如随机裁剪、旋转和替换,以减轻模型对训练数据的过拟合。

介绍和解决方法:

1. 过度拟合: 复制训练数据通常是过度拟合(overfitting)的结果。模型可能在训练数据中学到了噪声或局部特定的模式,而未能很好地泛化到新的、未见过的数据。

2. 训练数据中的模式: 大型语言模型可能会特别关注训练数据中的重复模式、短语或结构,因为这些是模型能够轻松捕捉的特征。这导致生成的文本中反复出现相似的表达。

解决方法:

a. 数据增强: 引入数据增强技术,通过对训练数据进行随机变换、替换或扩展,以产生更多样化的样本。这可以帮助模型更好地泛化到不同的情境。

b. 提高模型复杂性: 在一定程度上,增加模型的复杂性可能有助于更好地学习训练数据中的细微差异,但也需要小心避免过拟合。

c. 集成学习: 使用集成学习技术,将多个训练得到的模型结合在一起,以减少单个模型的过拟合风险,并提高模型的鲁棒性。

d. 正则化: 引入正则化技术,如dropout或权重衰减,以防止模型对训练数据的过度拟合。

e. 对抗训练: 使用对抗训练方法,通过在训练中引入对抗性样本,使模型更加鲁棒,不容易受到训练数据中的细节影响。

f. 监控生成文本的多样性: 在训练过程中监控生成文本的多样性,确保模型生成的文本不过于单一或重复。

g. 自监督学习: 引入自监督学习方法,通过模型自身的生成来引导训练,从而提高模型对更广泛语境的适应能力。

解决复制训练数据的问题是提高语言模型生成质量的关键一步。这需要在训练过程中平衡模型的拟合与泛化能力,并使用各种技术来确保生成文本的多样性和创新性。

3. 不确定性问题:

大模型在处理不确定性问题时可能表现出一定的“幻觉”,即生成的输出可能过于自信,而实际上有可能是错误的。解决方法包括在训练中引入更多的不确定性,使用模型融合技术,或者采用概率性生成方法。

介绍和解决方法:

1. 不确定性来源: 不确定性可以来自多个方面,包括数据噪声、语境歧义、模型对新颖情境的处理等。在这些情况下,模型可能过于自信地选择其中一种可能性,而不考虑其他可能性。

2. 缺乏全局上下文: 大型语言模型通常处理上下文时可能局限于局部信息,而忽略全局上下文。这导致模型在处理长期依赖和全局语境时产生不确定性。

解决方法:

a. 引入不确定性信息: 在训练中引入不确定性信息,例如使用蒙特卡洛 Dropout 技术,以便模型能够更好地反映其对不同可能性的置信度。

b. 概率性生成: 模型可以输出概率分布而不是确定性结果。这有助于表达模型对不同输出的相对置信度,而不是仅仅选择一个确定性的输出。

c. 集成学习: 结合多个模型的输出,通过集成学习方法(如投票或平均)来获得更鲁棒和准确的结果,从而减缓过度自信的问题。

d. 强化学习: 使用强化学习技术,通过模型在生成文本时考虑多个可能性,并使用奖励和惩罚机制来引导模型生成更加准确的输出。

e. 多模态信息: 结合文本与其他模态信息(如图像、声音等),以提供更多的上下文信息,帮助模型更好地理解语境,减少不确定性。

f. 对抗性训练: 引入对抗性训练,通过在训练中引入对抗性样本,使模型更具鲁棒性,能够更好地处理不确定性情境。

g. 自监督学习: 通过模型自身生成的数据来进行监督学习,从而提高模型对不确定性的理解和处理能力。

h. 网络结构设计: 选择更适合处理长期依赖和全局上下文的网络结构,以减轻模型在这些方面的不确定性。

4. 对抗攻击:

大型语言模型可能对对抗性样本(adversarial examples)敏感,即微小的扰动可能导致模型产生不合理的输出。解决方法包括使用对抗训练技术,增加模型的鲁棒性。

介绍和解决方法:

1. 对抗攻击的类型:

- 添加攻击(Addition Attack): 向输入文本中添加一些噪声或干扰,使模型输出不正确的结果。

- 删除攻击(Deletion Attack): 从输入文本中删除一些关键信息,导致模型失去正确的上下文。

- 替换攻击(Substitution Attack): 替换输入文本中的某些词语,以引导模型生成错误的文本。

2. 黑盒攻击 vs 白盒攻击:

- 黑盒攻击: 攻击者只能观察到模型的输入和输出,但无法获取模型的内部结构和参数信息。

- 白盒攻击: 攻击者具有对模型的完全访问权限,包括其内部结构和参数信息。

解决方法:

a. 对抗训练(Adversarial Training): 在训练过程中引入对抗样本,通过模型对抗攻击,提高模型的鲁棒性。

b. 梯度裁剪(Gradient Clipping): 限制模型在输入空间中的梯度,减少对抗攻击的影响。

c. 鲁棒性评估: 使用鲁棒性评估指标来测量模型对对抗攻击的抵抗力,以便更好地理解模型的弱点并加以改进。

d. 集成学习: 结合多个模型的输出,通过多数投票或平均化来减缓对抗攻击的影响。

e. 随机性输入: 在生成文本时引入一些随机性,使攻击者难以预测模型的响应。

f. 模型解释性: 了解模型内部决策过程,有助于识别攻击并采取相应的防御措施。

g. 使用对抗性训练集: 构建包含对抗样本的训练集,使模型更好地适应对抗攻击。

h. 强调模型不确定性: 在输出中引入不确定性信息,让模型更加谨慎地处理不确定的情况。

i. 防御性层(Defensive Layers): 添加专门设计的层,如对抗性训练过程中的防御性网络层,来提高模型的抵抗力。

j. 监测和反馈机制: 建立监测系统,及时检测对抗攻击,并在检测到攻击时采取相应的反馈措施。

5. 模型解释性:

大型语言模型通常是黑盒模型,难以解释其内部决策过程。这使得难以理解模型为何生成特定的输出。解决方法包括研究和开发更可解释的模型,以便用户更好地理解模型的工作原理。

模型解释性:

1. 黑盒模型: 大型深度学习模型通常是黑盒模型,难以理解其内部是如何进行决策的。这使得用户、监管机构或终端用户难以信任和解释模型的输出。

2. 解释性工具: 使用解释性工具,如LIME(Local Interpretable Model-agnostic Explanations)或SHAP(SHapley Additive exPlanations),来生成关于模型决策的可解释性结果。这些工具能够为模型的预测提供可解释性的局部解释。

3. 透明模型选择: 在特定场景中,可以选择更加透明和易解释的模型,如决策树、规则模型或线性模型。

4. 可视化技术: 使用可视化技术来呈现模型的内部结构和决策流程,使用户更容易理解模型是如何做出决策的。

5. 生成性模型: 考虑使用生成性模型,这些模型通常更容易理解,可以提供更直观的解释。

6. 过度自信:

大模型可能在不确定的情况下过于自信,导致生成的文本过于断言。解决方法包括使用校正技术,如在输出中引入置信度得分,以更好地反映模型的不确定性。

解决大模型幻觉问题是一个复杂的任务,通常需要综合运用数据处理、模型架构设计、训练技巧等多个方面的方法。这些问题的解决有助于提高大型语言模型的可靠性、鲁棒性和透明性,使其更适用于各种应用场景。

过度自信:

1. 置信度评估: 在输出中引入置信度评估,让模型能够对其生成的结果给出相应的置信度分数,使用户能够更好地理解模型的确定性。

2. 不确定性建模: 引入不确定性建模,例如使用贝叶斯神经网络或蒙特卡洛方法,使模型能够更好地处理不确定性情境,并避免过度自信。

3. 拓展标签集: 考虑使用更多类别或标签,包括“不确定”或“无法确定”等类别,以允许模型更灵活地处理不确定性情况。

4. 集成学习: 使用集成学习方法,通过结合多个模型的输出来提高系统的鲁棒性,并减少单个模型的过度自信。

5. 对抗训练: 引入对抗训练技术,通过在训练过程中引入对抗性样本,增加模型对输入的鲁棒性,减轻过度自信的问题。

6. 弱监督学习: 使用弱监督学习技术,使模型更加谨慎地对输入进行预测,避免对未知领域的过度自信。

7. 校正方法: 引入校正方法,通过后处理或校正网络输出,以更好地对抗过度自信的问题。

结语

在发展深度学习模型的道路上,我们必须在模型解释性和鲁棒性之间取得平衡。通过引入解释性工具、提高模型的鲁棒性、加入不确定性建模等手段,我们可以更好地理解模型的内部机制,减轻过度自信的问题。这一平衡不仅有助于提高模型的可靠性,也为深度学习在各个应用领域的广泛应用奠定了更加牢固的基础。

我的其他博客

【软件工程】走进敏捷开发:灵活、协作、迭代的软件工艺之旅-CSDN博客

【软件工程】融通未来的工艺:深度解析统一过程在软件开发中的角色-CSDN博客

【软件工程】走进瀑布模型:传统软件开发的经典之路-CSDN博客

【软件工程】走近演化过程模型:软件开发的不断进化之路-CSDN博客

【软件工程】漫谈增量过程模型:软件开发的逐步之道-CSDN博客

【Spring】理解IoC与AOP:构建灵活而模块化的软件架构-CSDN博客

【MySQL】数据库并发控制:悲观锁与乐观锁的深入解析-CSDN博客

【MySQL】数据库规范化的三大法则 — 一探范式设计原则-CSDN博客

【MySQL】数据库中为什么使用B+树不用B树-CSDN博客

【MySQL】SQL优化-CSDN博客

【MySQL】脏读、不可重复读、幻读介绍及代码解释-CSDN博客

【MySQL】多表连接查询-CSDN博客

【MySQL】数据库索引(简单明了)-CSDN博客

【Web开发】深度剖析RBAC:概念、实现方法、优势及在Web应用中的应用-CSDN博客

【Mybatis】深入学习MyBatis:高级特性与Spring整合-CSDN博客

【Mybatis】深入学习MyBatis:CRUD操作与动态SQL实战指南-CSDN博客

【MySQL】数据库索引(简单明了)-CSDN博客

![Matlab技巧[绘画逻辑分析仪产生的数据]](https://img-blog.csdnimg.cn/direct/2d9aabee8a4f40e484181d7d0e218033.png)

![[2024区块链开发入门指引] - 比特币与区块链诞生](https://img-blog.csdnimg.cn/img_convert/e13ebfbe3964e908f36c00cfd9e11bc4.webp?x-oss-process=image/format,png#pic_center)