今天我们分享的主要目的就是通过在 Python 中使用命令行和配置文件来提高代码的效率

Let’s go!

我们以机器学习当中的调参过程来进行实践,有三种方式可供选择。第一个选项是使用 argparse,它是一个流行的 Python 模块,专门用于命令行解析;另一种方法是读取 JSON 文件,我们可以在其中放置所有超参数;第三种也是鲜为人知的方法是使用 YAML 文件!好奇吗,让我们开始吧!

先决条件

在下面的代码中,我将使用 Visual Studio Code,这是一个非常高效的集成 Python 开发环境。这个工具的美妙之处在于它通过安装扩展支持每种编程语言,集成终端并允许同时处理大量 Python 脚本和 Jupyter 笔记本

数据集,使用的是 Kaggle 上的共享自行车数据集,可以在这里下载或者在文末获取

https://www.kaggle.com/datasets/lakshmi25npathi/bike-sharing-dataset

使用 argparse

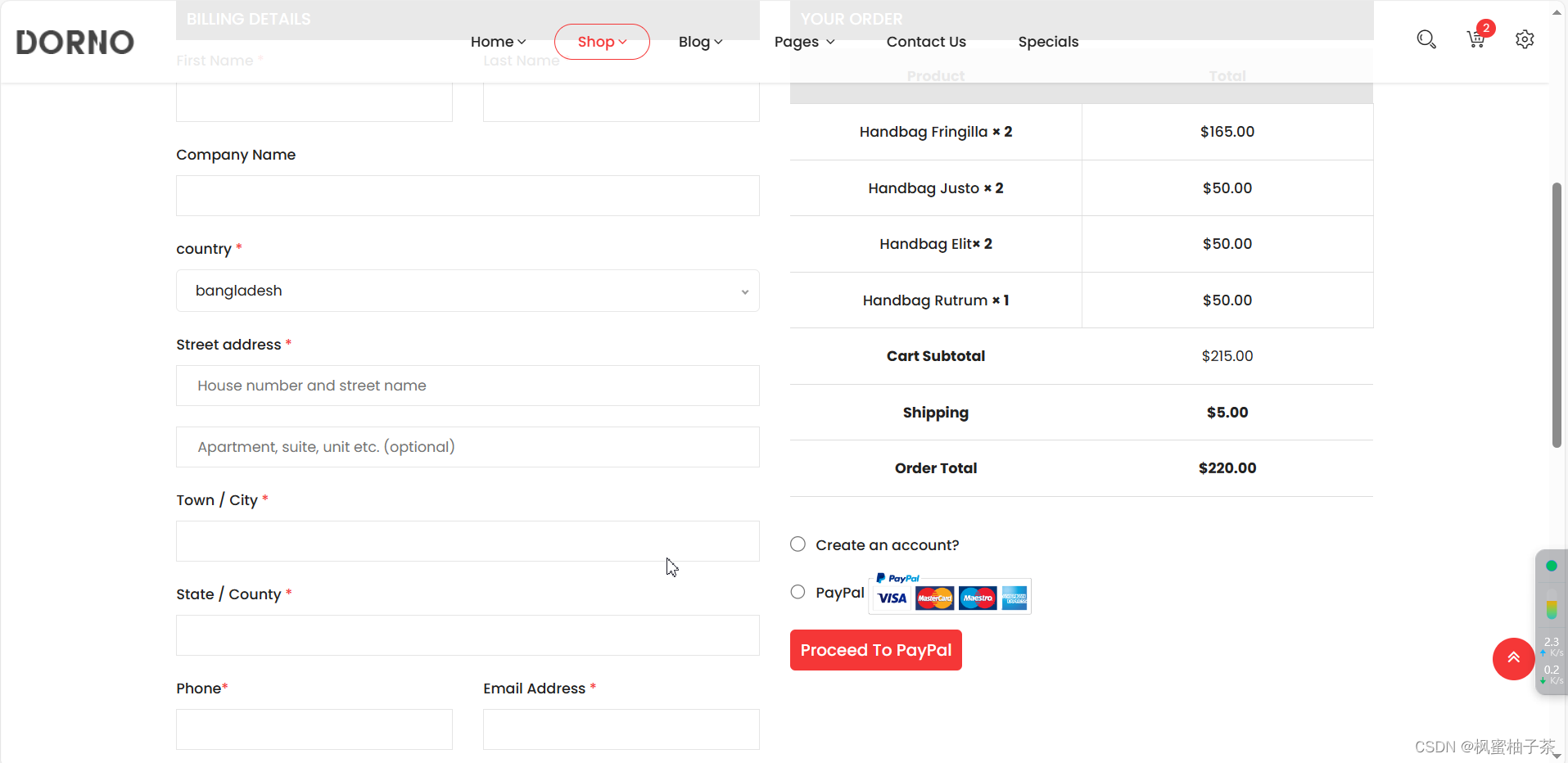

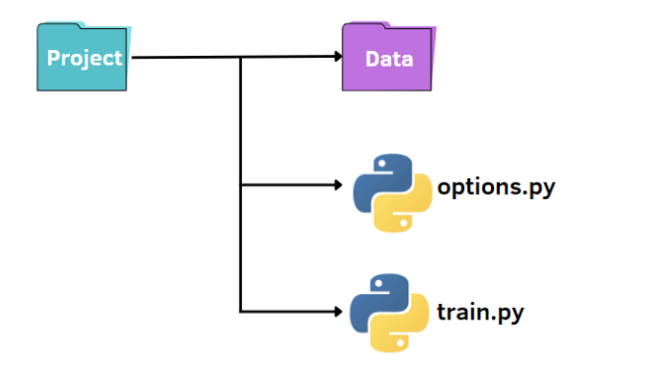

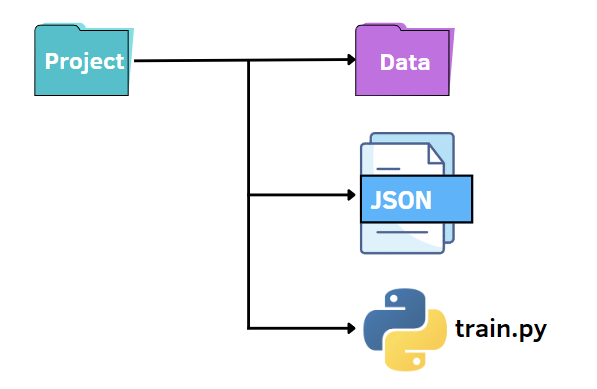

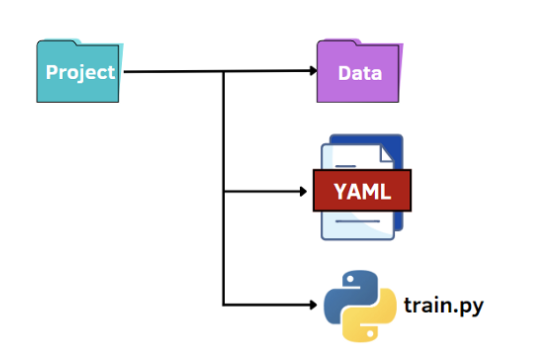

就像上图所示,我们有一个标准的结构来组织我们的小项目:

- 包含我们数据集的名为 data 的文件夹

- train.py 文件

- 用于指定超参数的 options.py 文件

首先,我们可以创建一个文件 train.py,在其中我们有导入数据、在训练数据上训练模型并在测试集上对其进行评估的基本程序:

import pandas as pd

import numpy as np

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import mean_squared_error, mean_absolute_errorfrom options import train_optionsdf = pd.read_csv('data\hour.csv')

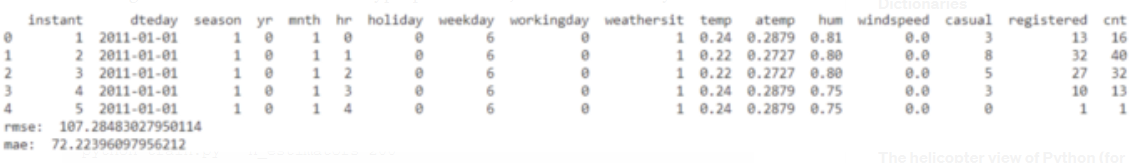

print(df.head())

opt = train_options()X=df.drop(['instant','dteday','atemp','casual','registered','cnt'],axis=1).values

y =df['cnt'].values

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)if opt.normalize == True:scaler = StandardScaler()X = scaler.fit_transform(X)rf = RandomForestRegressor(n_estimators=opt.n_estimators,max_features=opt.max_features,max_depth=opt.max_depth)

model = rf.fit(X_train,y_train)

y_pred = model.predict(X_test)

rmse = np.sqrt(mean_squared_error(y_pred, y_test))

mae = mean_absolute_error(y_pred, y_test)

print("rmse: ",rmse)

print("mae: ",mae)在代码中,我们还导入了包含在 options.py 文件中的 train_options 函数。后一个文件是一个 Python 文件,我们可以从中更改 train.py 中考虑的超参数:

import argparsedef train_options():parser = argparse.ArgumentParser()parser.add_argument("--normalize", default=True, type=bool, help='maximum depth')parser.add_argument("--n_estimators", default=100, type=int, help='number of estimators')parser.add_argument("--max_features", default=6, type=int, help='maximum of features',)parser.add_argument("--max_depth", default=5, type=int,help='maximum depth')opt = parser.parse_args()return opt在这个例子中,我们使用了 argparse 库,它在解析命令行参数时非常流行。首先,我们初始化解析器,然后,我们可以添加我们想要访问的参数。

这是运行代码的示例:

python train.py

要更改超参数的默认值,有两种方法。第一个选项是在 options.py 文件中设置不同的默认值。另一种选择是从命令行传递超参数值:

python train.py --n_estimators 200

我们需要指定要更改的超参数的名称和相应的值。

python train.py --n_estimators 200 --max_depth 7

使用 JSON 文件

和前面一样,我们可以保持类似的文件结构。在这种情况下,我们将 options.py 文件替换为 JSON 文件。换句话说,我们想在 JSON 文件中指定超参数的值并将它们传递给 train.py 文件。与 argparse 库相比,JSON 文件可以是一种快速且直观的替代方案,它利用键值对来存储数据。下面我们创建一个 options.json 文件,其中包含我们稍后需要传递给其他代码的数据。

{

"normalize":true,

"n_estimators":100,

"max_features":6,

"max_depth":5

}如上所见,它与 Python 字典非常相似。但是与字典不同的是,它包含文本/字符串格式的数据。此外,还有一些语法略有不同的常见数据类型。例如,布尔值是 false/true,而 Python 识别 False/True。JSON 中其他可能的值是数组,它们用方括号表示为 Python 列表。

在 Python 中使用 JSON 数据的美妙之处在于,它可以通过 load 方法转换成 Python 字典:

f = open("options.json", "rb")

parameters = json.load(f)要访问特定项目,我们只需要在方括号内引用它的键名:

if parameters["normalize"] == True:scaler = StandardScaler()X = scaler.fit_transform(X)

rf=RandomForestRegressor(n_estimators=parameters["n_estimators"],max_features=parameters["max_features"],max_depth=parameters["max_depth"],random_state=42)

model = rf.fit(X_train,y_train)

y_pred = model.predict(X_test)

使用 YAML 文件

最后一种选择是利用 YAML 的潜力。与 JSON 文件一样,我们将 Python 代码中的 YAML 文件作为字典读取,以访问超参数的值。YAML 是一种人类可读的数据表示语言,其中层次结构使用双空格字符表示,而不是像 JSON 文件中的括号。下面我们展示 options.yaml 文件将包含的内容:

normalize: True

n_estimators: 100

max_features: 6

max_depth: 5在 train.py 中,我们打开 options.yaml 文件,该文件将始终使用 load 方法转换为 Python 字典,这一次是从 yaml 库中导入的:

import yaml

f = open('options.yaml','rb')

parameters = yaml.load(f, Loader=yaml.FullLoader)和前面一样,我们可以使用字典所需的语法访问超参数的值。

最后的想法

配置文件的编译速度非常快,而 argparse 则需要为我们要添加的每个参数编写一行代码。

所以我们应该根据自己的不同情况来选择最为合适的方式

例如,如果我们需要为参数添加注释,JSON 是不合适的,因为它不允许注释,而 YAML 和 argparse 可能非常适合。

总结

外行对于程序员的认知很单一,也有很多刻板印象,但不管如何,作为测试人员的我们,自己一定要正视自己。如果我们连自嘲和自卑都分不清楚了,那发展也就仅限如此了。

所以,尽早规划自己,朝目标发展,才是上策之道,而不是怨天尤人,等到 30 岁后再去焦虑。

在企业你如果不想成为“工具人”,就不要停下成长的步伐,打造属于自己的独特价值,具备不可替代的稀缺属性,这样才能不被淘汰,也能够在遭遇变化时,随自己所愿进行选择。

下面是你需要的资料吗!

↓↓

![]()

❤学习安排上❤

如果你不想一个人野蛮生长,找不到系统的资料,问题得不到帮助,坚持几天便放弃的感受的话,请及时加入群:1150305204,大家可以一起讨论交流,里面会有各种软件测试资料和技术交流。