英文原文地址:https://artgor.medium.com/paper-review-chain-of-note-enhancing-robustness-in-retrieval-augmented-language-models-3b4e7fce188a

2023 年 11 月 20 日

论文链接

检索增强语言模型(RALM)通过使用外部知识源来增强,但它们面临着检索不相关信息和无法使用其固有知识等挑战。他们还很难确定何时拥有足够的信息来获得准确的答案,而通常不会表明何时缺乏知识。为了改善这一点,引入了注释链(CON),它为检索到的文档生成顺序阅读笔记,以评估它们的相关性并将此评估整合到最终答案中。CON 使用 ChatGPT 作为训练数据进行开发,并应用于 LLaMa-2 7B 模型,显着提高了 RALM 在四个开放域 QA 基准上的性能。它在处理模型预训练知识之外的噪声文档和问题时特别有效,从而对未知场景带来更高的准确性和更好的拒绝率。

方法

背景

RALM 通过整合外部知识源代表了语言模型的进步。这些模型的工作原理是使用表示检索到的文档的辅助变量,根据输入查询和这些文档的内容生成响应。然而,由于潜在来源数量巨大,他们使用排名靠前的文档来近似响应生成过程。

尽管取得了进步,RALM 仍存在一些局限性:

- 表面处理的风险:RALM 可能依赖于表面信息,而忽略了复杂或间接问题中的细微差别。

- 处理矛盾信息的困难:当面对文件中的矛盾信息时,他们会陷入困境,发现解决这些矛盾或确定哪些信息更可信具有挑战性。

- 透明度和可解释性降低:RALM 直接生成答案对决策过程的洞察力有限,使用户很难理解结论是如何得出的。

- 对检索到的文档的过度依赖:RALM 可能过度依赖于检索到的文档的内容,可能会忽略模型的固有知识。这可能会产生问题,尤其是当文档有噪音或过时时。

笔记链框架

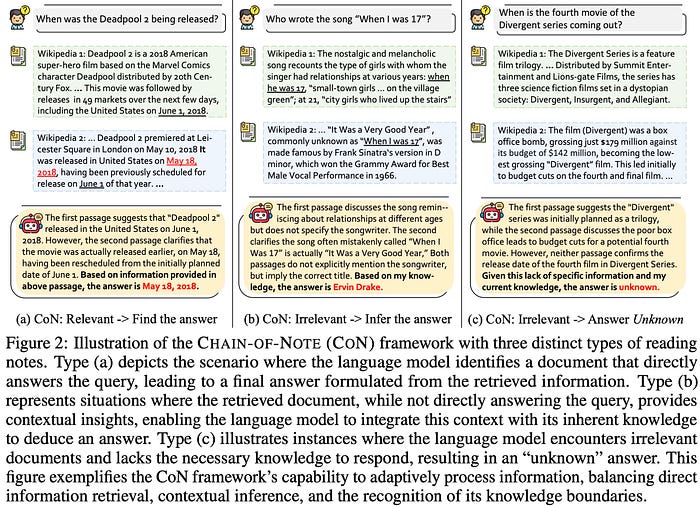

注释链框架通过增强 RALM 严格评估检索到的文档的能力来解决 RALM 的局限性。这是通过结构化笔记过程实现的,模型为每个文档生成简洁、相关的摘要。该方法可以系统地评估信息的相关性和准确性,从而提高响应质量。

在实践中,给定输入问题和检索到的文档,该模型会在合成最终响应之前为每个文档生成阅读笔记。CON 框架遵循三个关键步骤:

- 笔记设计:CON 根据文档与查询的相关性构建阅读笔记。它直接从相关文档中回答,使用部分相关文档中的上下文推断答案,如果文档不相关或不足以回答,则默认为“未知”。

- 数据收集:这些阅读笔记的训练数据是使用 ChatGPT 生成的。这涉及从 NQ 数据集中抽取 10k 个问题,并提示 ChatGPT 创建注释,然后通过人工评估进行评估。该模型的适应性在各种开放域数据集上得到进一步测试。

- 模型训练:该模型基于 LLaMa-2 7B 架构,使用收集的数据进行训练。它学习生成与每个文档与输入查询的相关性相对应的阅读笔记。加权损失用于平衡阅读笔记和最终答案之间的焦点,确保答案的准确性和可靠性。

实验

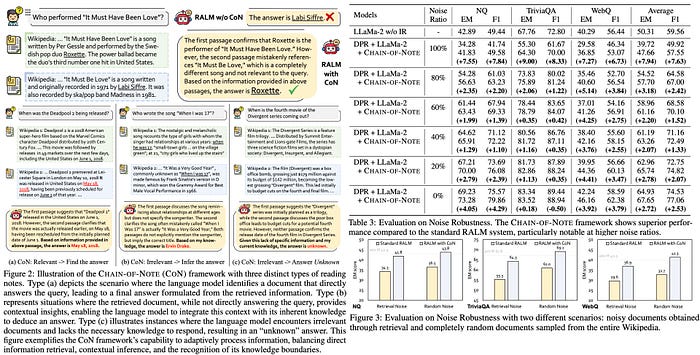

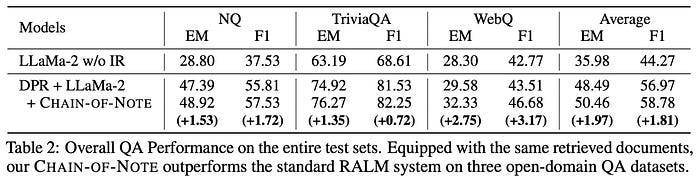

结合密集通道检索 (DPR) 方法和具有检索功能的 LLaMa-2 模型的 RALM 始终优于单独的 LLaMa-2 模型。这种改进很大程度上归功于检索过程的有效性。值得注意的是,与 WebQ 相比,DPR 在 NQ 和 TriviaQA 数据集上表现出更好的检索性能,表明在这些数据集上检索的好处更明显。

此外,集成 CON 的增强型 RALM 的性能优于标准 RALM。所有数据集的精确匹配分数平均提高了 +1.97。CON 特别提高了 RALM 在最初检索到更多噪声文档的情况下的性能。

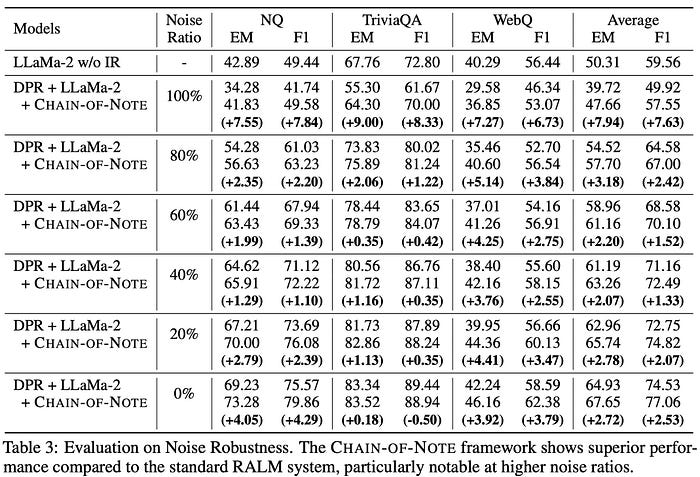

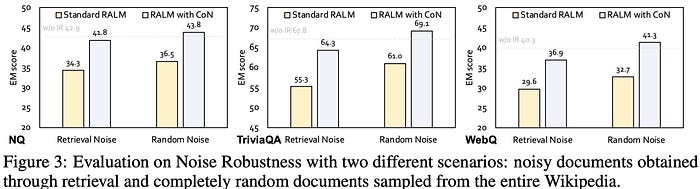

使用 CON 的 RALM 中的噪声鲁棒性评估是在两种情况下进行的:使用从实际查询中检索到的排名靠前的不相关文档(代表语义噪声)和使用来自维基百科的完全随机文档(总噪声)。在仅包含噪声文档的场景中,使用 CON 增强的 RALM 始终优于标准 RALM,三个开放域 QA 数据集的精确匹配分数平均提高了 +7.9。

当处理完全有噪声的文档时,标准 RALM 和使用 CON 增强的 RALM 的性能都比没有信息检索的原始 LLaMa-2 模型差,这表明容易受到误导性信息的影响。然而,CON 增强模型在没有信息检索的情况下几乎与 LLaMa-2 的性能相匹配,证明了其鲁棒性和忽略不相关数据的能力。

此外,作者观察到,标准 RALM 和具有 CON 的 RALM 在随机文档上的表现都比在语义噪声文档上表现得更好,这表明语义相关噪声更具欺骗性。

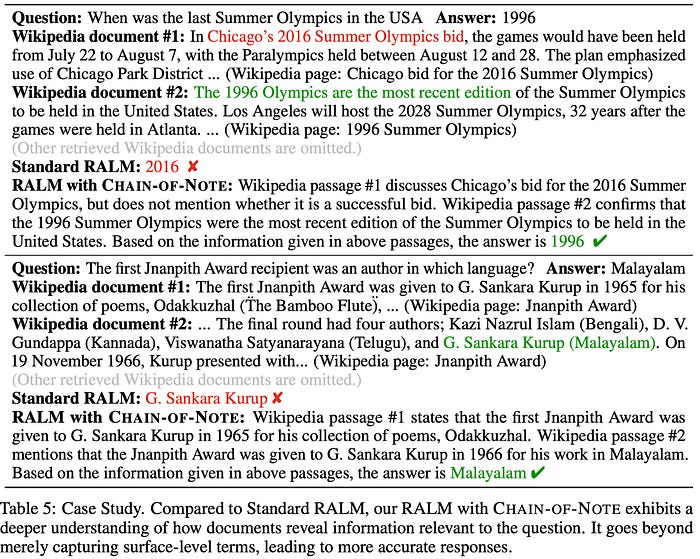

在比较标准 RALM 与 CON 增强的 RALM 的案例研究中,观察到信息处理和解释方面的明显差异。在一个案例中,问题与美国最近举办的夏季奥运会有关。标准 RALM 错误地关注了芝加哥最近申办 2016 年奥运会的情况,导致答案不准确。相比之下,RALM 和 CON 承认芝加哥申办失败,并正确得出美国最近一届奥运会举办于 1996 年的结论。

在另一个案例中,关于第一位 Jnanpith 奖获奖者的语言,标准 RALM 识别了获奖者,但未能将其与其作品的语言联系起来。然而,带有 CON 的 RALM 有效地综合了多个文档中的信息,正确地将马拉雅拉姆语识别为语言。这些案例凸显了 CON 增强型 RALM 在理解和整合各种来源的信息、避免表面细节并提供更细致和准确的结论方面的卓越能力。

![Siemens-NXUG二次开发-导入与导出(可移除参数)prt文件[Python UF][20240121]](https://img-blog.csdnimg.cn/direct/5ecd9d9bee0142f6abd786d7af94f641.png#pic_center)