文章目录

- Pandas数据预处理之数据标准化:提升机器学习模型性能的关键步骤

- 1. 数据标准化的重要性

- 2. 使用Pandas进行数据标准化

- 2.1 导入必要的库

- 2.2 读取数据

- 2.3 数据标准化

- 3. 代码解析

- 4. 进一步优化

- 4.1 最小-最大缩放

- 4.2 自定义标准化方法

- 5. 处理缺失值和异常值

- 5.1 缺失值处理

- 5.2 异常值处理

- 6. 可视化数据标准化效果

- 7. 结合交叉验证进行数据标准化

- 8. 自动化数据预处理流程

- 总结

Pandas数据预处理之数据标准化:提升机器学习模型性能的关键步骤

在进行机器学习任务时,数据预处理是至关重要的一环。其中,数据标准化是一项关键技术,它可以确保不同特征的值处于相似的尺度,从而提高机器学习模型的性能。在本文中,我们将深入探讨使用Pandas进行数据标准化的方法,并提供详细的代码实例和解析。

1. 数据标准化的重要性

在处理不同尺度的特征时,机器学习模型可能会出现性能不佳的情况。例如,一个特征的值范围在0到1之间,而另一个特征的值可能在几千到几百万之间,这会导致模型更关注数值较大的特征。数据标准化的目标是通过调整特征的值,使其具有相似的尺度,从而避免这种情况。

2. 使用Pandas进行数据标准化

2.1 导入必要的库

首先,我们需要导入必要的Python库,包括Pandas和Scikit-learn。

import pandas as pd

from sklearn.preprocessing import StandardScaler

2.2 读取数据

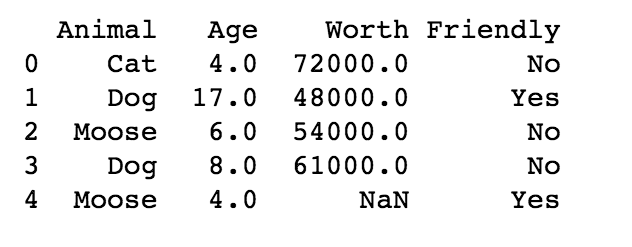

在本例中,我们将使用Pandas读取一个示例数据集,以展示数据标准化的过程。

# 读取数据

data = pd.read_csv('your_dataset.csv')

2.3 数据标准化

接下来,我们将选择需要标准化的特征,并使用StandardScaler进行数据标准化。

# 选择需要标准化的特征列

features_to_standardize = ['feature1', 'feature2', 'feature3']# 初始化StandardScaler

scaler = StandardScaler()# 对选择的特征进行标准化

data[features_to_standardize] = scaler.fit_transform(data[features_to_standardize])

3. 代码解析

-

StandardScaler是Scikit-learn库提供的标准化工具,它通过计算每个特征的均值和标准差,然后将数据转换为均值为0,标准差为1的标准正态分布。 -

fit_transform方法用于计算均值和标准差,并进行标准化转换。 -

最后,我们将标准化后的值更新到原始数据集中。

4. 进一步优化

除了简单的数据标准化外,根据实际情况,你可能还需要考虑一些其他优化方法,以更好地适应不同的数据集和模型需求。

4.1 最小-最大缩放

另一种常用的标准化方法是最小-最大缩放,它将数据缩放到指定的范围内。在Scikit-learn中,你可以使用MinMaxScaler来实现。

from sklearn.preprocessing import MinMaxScaler# 初始化MinMaxScaler

min_max_scaler = MinMaxScaler()# 对选择的特征进行最小-最大缩放

data[features_to_standardize] = min_max_scaler.fit_transform(data[features_to_standardize])

4.2 自定义标准化方法

有时,特定的业务场景可能需要自定义的标准化方法。你可以通过定义自己的标准化函数并应用于数据集来实现。

def custom_scaler(column):# 自定义标准化逻辑return (column - column.mean()) / column.std()# 对选择的特征进行自定义标准化

data[features_to_standardize] = data[features_to_standardize].apply(custom_scaler)

5. 处理缺失值和异常值

在进行数据标准化之前,还需要处理可能存在的缺失值和异常值,以确保标准化的过程更加稳健。使用Pandas可以轻松地进行缺失值和异常值处理。

5.1 缺失值处理

# 检查缺失值

missing_values = data.isnull().sum()# 填充缺失值,例如使用均值进行填充

data.fillna(data.mean(), inplace=True)

5.2 异常值处理

对于异常值,可以使用统计方法或者专门的算法进行识别和处理。这里使用简单的Z-score方法来识别和处理异常值。

from scipy import stats# 计算Z-score

z_scores = stats.zscore(data[features_to_standardize])# 定义阈值,通常选择Z-score大于3或小于-3为异常值

threshold = 3# 过滤掉异常值

data_no_outliers = data[(z_scores < threshold).all(axis=1)]

6. 可视化数据标准化效果

使用数据可视化工具如Matplotlib或Seaborn,可以直观地展示标准化的效果,有助于理解数据分布的变化。

import matplotlib.pyplot as plt

import seaborn as sns# 绘制标准化前后的特征分布图

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

sns.histplot(data[features_to_standardize], kde=True)

plt.title('Before Standardization')plt.subplot(1, 2, 2)

sns.histplot(data_no_outliers[features_to_standardize], kde=True)

plt.title('After Standardization and Outlier Removal')plt.show()

7. 结合交叉验证进行数据标准化

在进行数据标准化时,我们通常将其嵌入到交叉验证的流程中,以确保在训练集和测试集上都能得到一致的标准化效果。这有助于避免信息泄露和提高模型的泛化性能。

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.linear_model import LinearRegression# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(data.drop('target_column', axis=1), data['target_column'], test_size=0.2, random_state=42)# 初始化StandardScaler

scaler = StandardScaler()# 在训练集上进行标准化

X_train[features_to_standardize] = scaler.fit_transform(X_train[features_to_standardize])# 在测试集上使用同样的标准化参数

X_test[features_to_standardize] = scaler.transform(X_test[features_to_standardize])# 初始化模型

model = LinearRegression()# 使用交叉验证评估模型性能

cv_scores = cross_val_score(model, X_train, y_train, cv=5, scoring='r2')# 输出交叉验证得分

print("Cross-Validation R^2 Scores:", cv_scores)

8. 自动化数据预处理流程

为了进一步简化数据预处理的流程,可以考虑使用Pipeline来组织数据处理步骤,使其更加自动化和可重复。

from sklearn.pipeline import Pipeline# 创建数据处理的Pipeline

preprocessing_pipeline = Pipeline([('imputer', SimpleImputer(strategy='mean')), # 填充缺失值('scaler', StandardScaler()), # 数据标准化# 添加其他数据处理步骤...

])# 在训练集上拟合Pipeline

X_train_preprocessed = preprocessing_pipeline.fit_transform(X_train)# 在测试集上使用同样的数据处理Pipeline

X_test_preprocessed = preprocessing_pipeline.transform(X_test)

总结

在本文中,我们深入探讨了使用Pandas进行数据预处理中的关键步骤——数据标准化。通过标准化数据,我们可以确保不同特征具有相似的尺度,提高机器学习模型的性能和鲁棒性。以下是本文的主要要点:

-

数据标准化的重要性: 不同尺度的特征可能导致机器学习模型性能下降,数据标准化是解决这一问题的关键步骤之一。

-

使用Pandas和Scikit-learn进行标准化: 我们介绍了如何使用Pandas和Scikit-learn库进行数据标准化的基本步骤,并提供了详细的代码实例和解析。

-

进一步优化: 除了基本的数据标准化外,我们探讨了最小-最大缩放和自定义标准化方法,以及如何处理缺失值和异常值,进一步提升数据预处理效果。

-

结合交叉验证: 我们演示了如何将数据标准化嵌入交叉验证流程中,以确保在训练集和测试集上一致地应用标准化。

-

自动化数据预处理流程: 引入了Pipeline来自动化数据预处理流程,简化代码结构,提高代码可维护性。

-

总结与展望: 最后,我们强调了数据预处理的重要性,鼓励不断学习和尝试新的技术,将数据预处理作为机器学习流程中不可或缺的关键环节,以构建稳健、高性能的预测模型。通过适当的数据处理,我们能够为模型提供更具实用性和可靠性的数据基础,从而在实际应用中取得更好的效果。