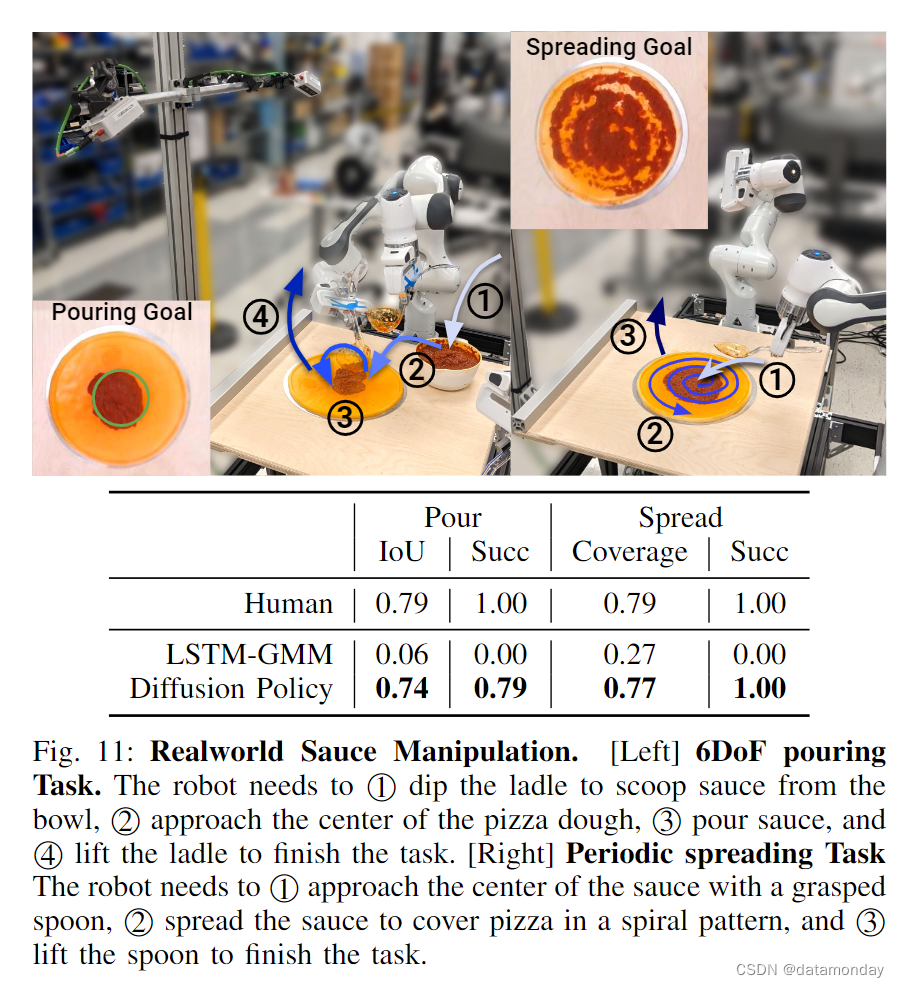

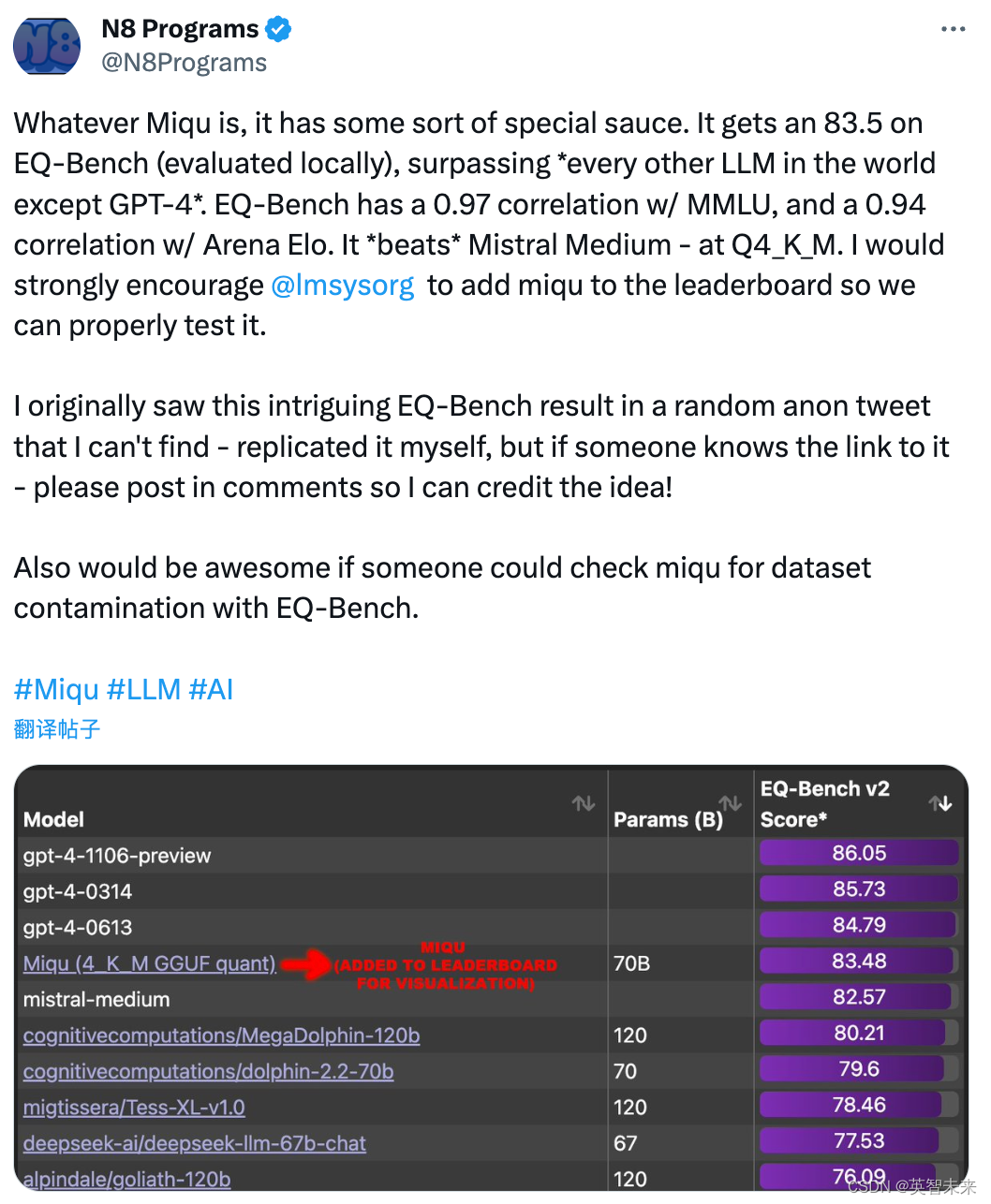

近期开源 AI 社区发生了一场大事件,一位用户在 HuggingFace 平台上传了一系列文件,包含一个看似新的开源大型语言模型“miqu-1-70b”。这一模型被认为是最接近 OpenAI 的 GPT-4,引发了广泛关注和猜测。

不少用户则在社交平台 X (原名Twitter)上分享了测试比较,miqu和Mixtral模型的能力非常相似,无论在德语拼写和双语语法上,还是回复中的一些语言习惯上。

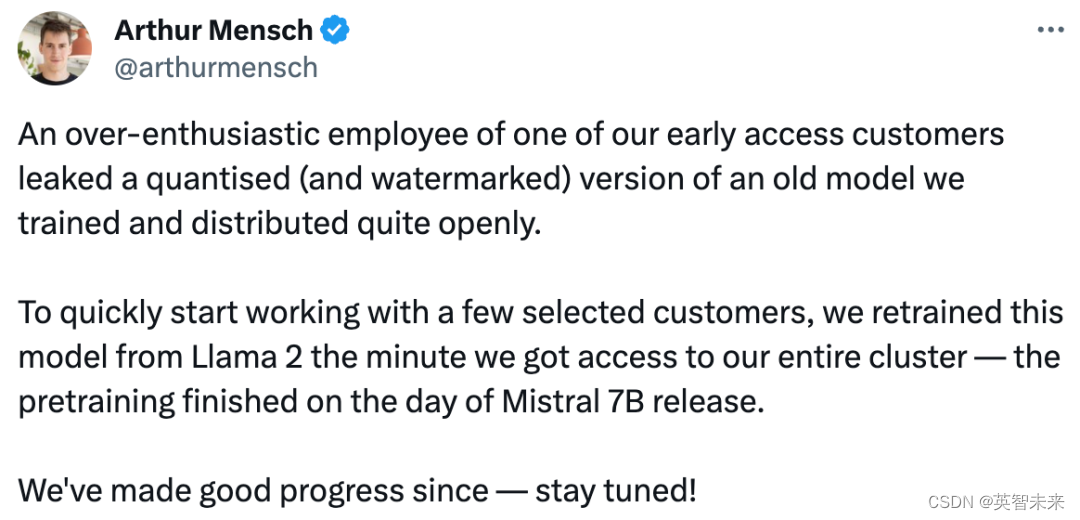

Mistral 公司的 CEO 证实了这一模型的“泄露”,表示这是一款曾经公开训练和分发的老模型的量化版本,目前在完全控制集群的第一时间对这个模型进行了重新训练,在 Mistral 7B 发布当天就完成预训练。

然而,随着 Mensch 的 “敬请期待!”,似乎不仅暗示 Mistral 正在培训一款名为 “Miqu” 的模型,其性能接近 GPT-4 级别,而且根据他的评论,这款模型甚至有可能达到甚至超越 GPT-4 的水平。

这一消息可能对 OpenAI 和整个 AI 领域产生重大影响,因为开源 AI 社区正在迅速赶上闭源模型的竞争力。

如果真的发生,这将是一个对开源生成式 AI 乃至整个 AI 和计算机科学领域的重大转变。自 2023 年 3 月发布以来,GPT-4 一直被大多数标准视为世界上最强大、性能最出色的 LLM。

如果有一个功能类似 GPT-4 的开源模型,而且是免费商用,必定将给 OpenAI 的收费订阅功能带来巨大挑战,尤其是现在越来越多的企业开始转向开源模型,开源与闭源混合使用以推动他们的应用开发。

尽管 OpenAI 可能依然保持领先,拥有更快速的 GPT-4 Turbo 和具备视觉功能的 GPT-4V,但竞争已经很明显:开源模型正迅速乘胜追击。随着GPT-4和更多模型的并发式增长,对智能算力的需求愈发旺盛。GPT-4模型训练使用了3125台英伟达A100服务器,对应15625P算力,都要训练90-100天。

随着一大批大模型的应用涌现,企业对算力的需求将是以前的10倍、100倍,甚至更多。BayStone平台目前已经聚合全球GPU算力资源,实现灵活调度H100、A100、4090等给企业使用,助力企业以更低陈本、更优算力资源,为企业实现安全高效的算力支持。【点击申请GPU资源】

![[2024]常用的pip指令](https://img-blog.csdnimg.cn/direct/b3c1f42d88ef4707be65d792d6994465.png#pic_center)