陈述式资源管理方法:

1.kubernetes 集群管理集群资源的唯一入口是通过相应的方法调用 apiserver 的接口

2.kubectl 是官方的CLI命令行工具,用于与 apiserver 进行通信,将用户在命令行输入的命令,组织并转化为 apiserver 能识别的信息,进而实现管理 k8s 各种资源的一种有效途径

3.kubectl 的命令大全

kubectl --help

k8s中文文档:http://docs.kubernetes.org.cn/683.html

4.对资源的增、删、查操作比较方便,但对改的操作就不容易了

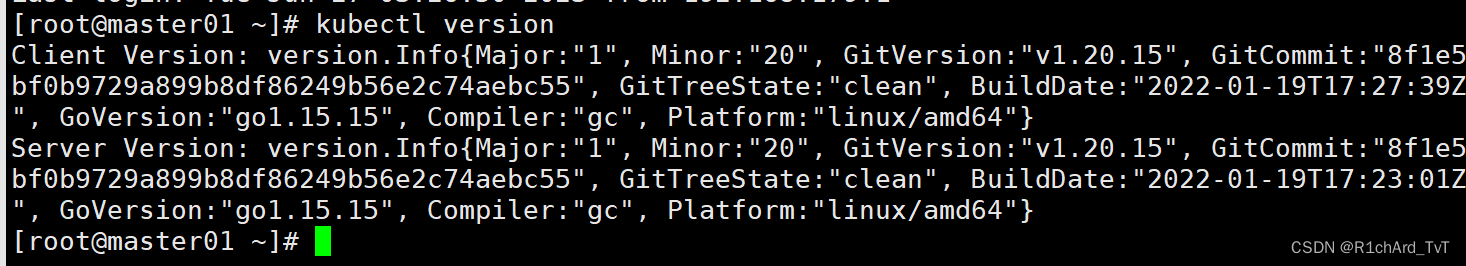

//查看版本信息

kubectl version

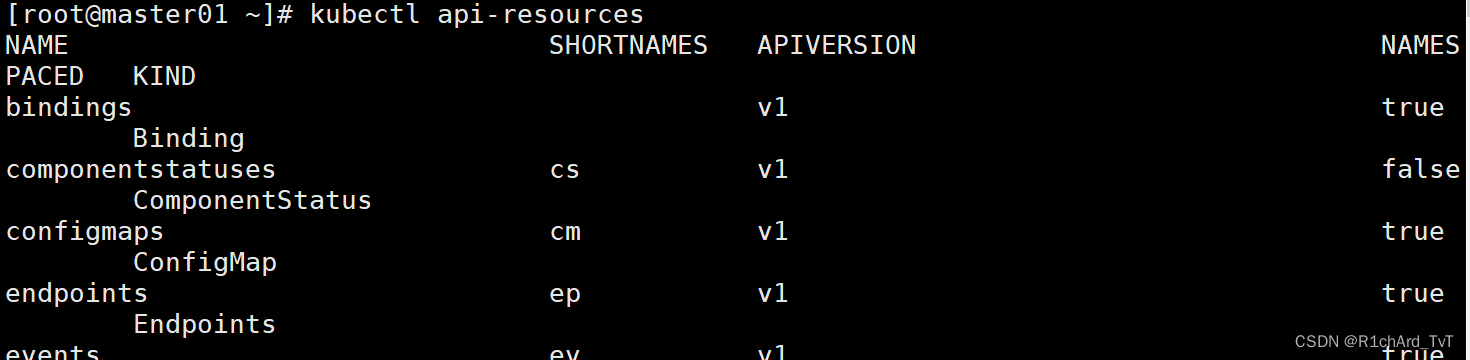

//查看资源对象简写

kubectl api-resources

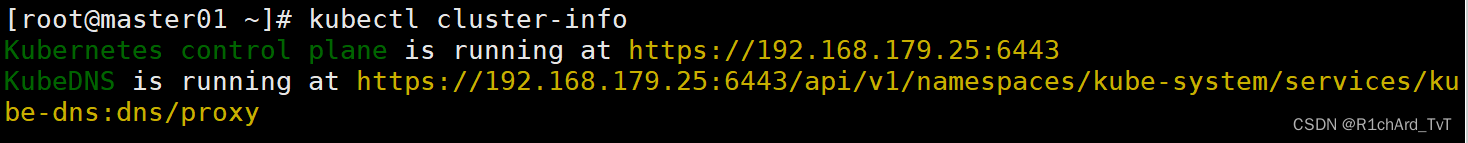

//查看集群信息

kubectl cluster-info

//配置kubectl自动补全

source <(kubectl completion bash)

//node节点查看日志

journalctl -u kubelet -f

---------- 基本信息查看 ----------

kubectl get <resource> [-o wide|json|yaml] [-n namespace]

获取资源的相关信息,-n 指定命令空间,-o 指定输出格式

resource可以是具体资源名称,如pod nginx-xxx;也可以是资源类型,如pod;或者all(仅展示几种核心资源,并不完整)

--all-namespaces 或 -A :表示显示所有命名空间,

--show-labels :显示所有标签

-l app :仅显示标签为app的资源

-l app=nginx :仅显示包含app标签,且值为nginx的资源

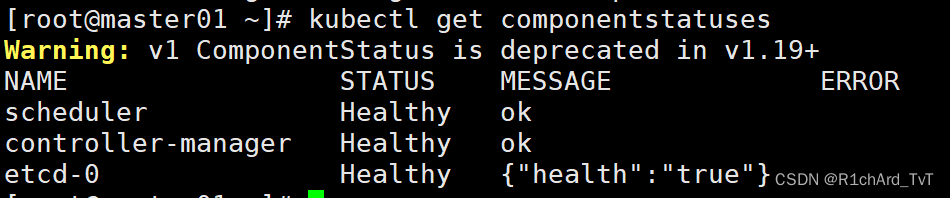

//查看 master 节点状态

kubectl get componentstatuses

kubectl get cs

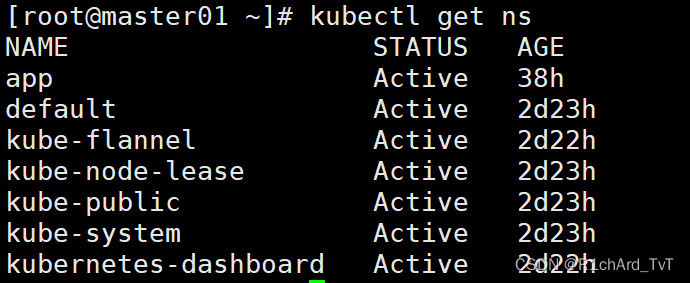

//查看命名空间

kubectl get namespace

kubectl get ns

//命令空间的作用:用于允许不同 命名空间 的 相同类型 的资源 重名的

//查看default命名空间的所有资源

kubectl get all [-n default]

//创建命名空间app

kubectl create ns app

kubectl get ns

//删除命名空间app

kubectl delete namespace app

kubectl get ns

//在命名空间kube-public 创建副本控制器(deployment)来启动Pod(nginx-wl)

kubectl create deployment nginx-xny --image=nginx -n kube-public

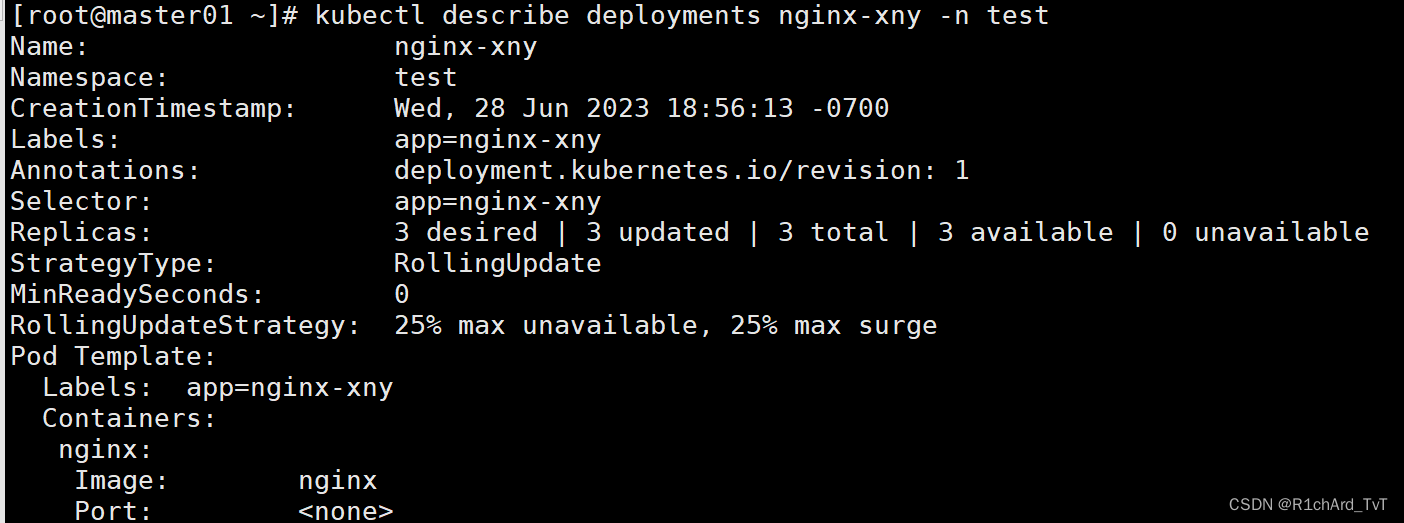

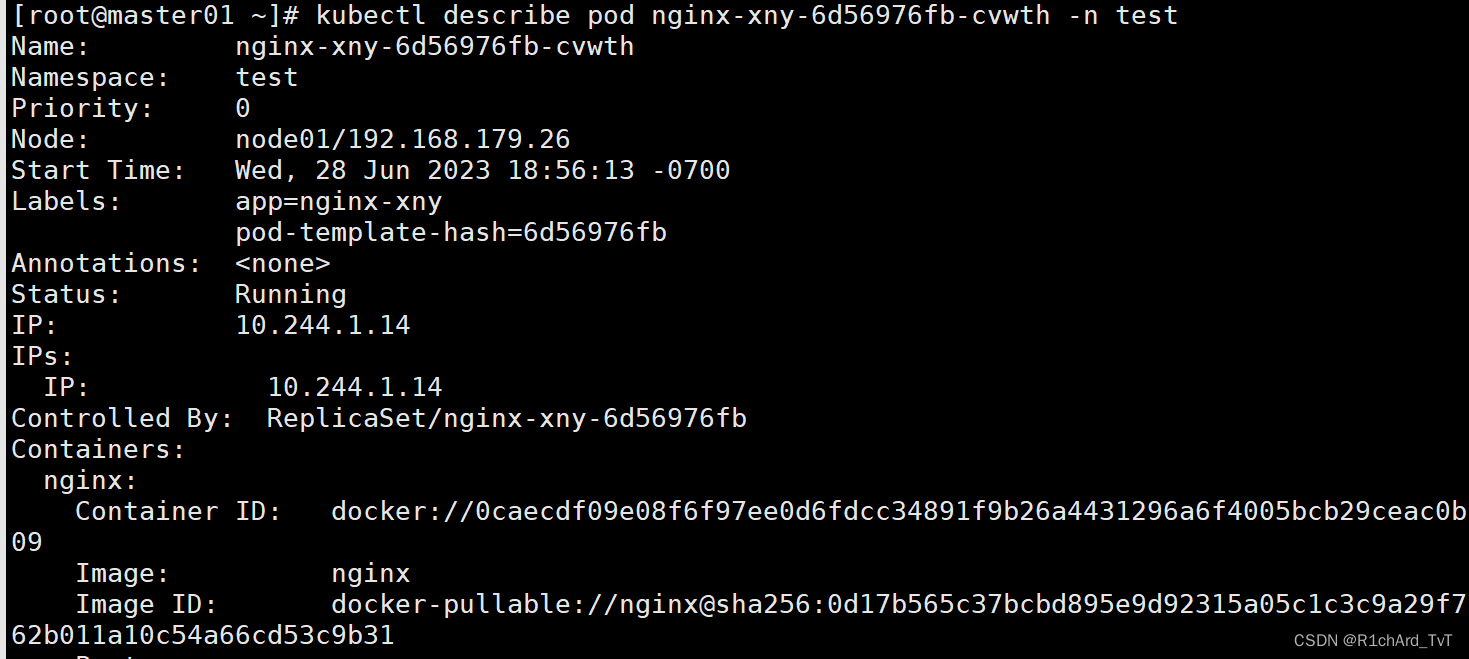

//描述某个资源的详细信息

kubectl describe deployment nginx-xny -n test

kubectl describe pod nginx-xny-d47f99cb6-hv6gz -n test

//查看命名空间kube-public 中的pod 信息

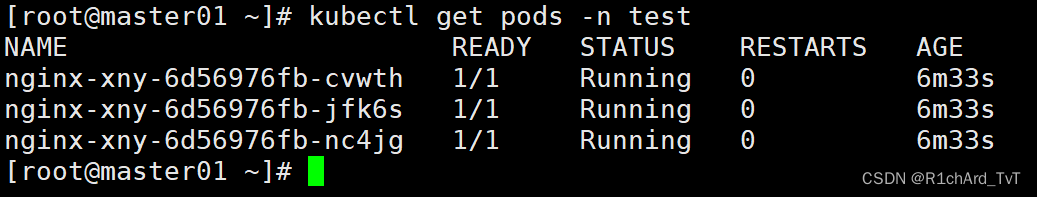

kubectl get pods -n test

NAME READY STATUS RESTARTS AGE

nginx-xny-d47f99cb6-hv6gz 1/1 Running 0 24m

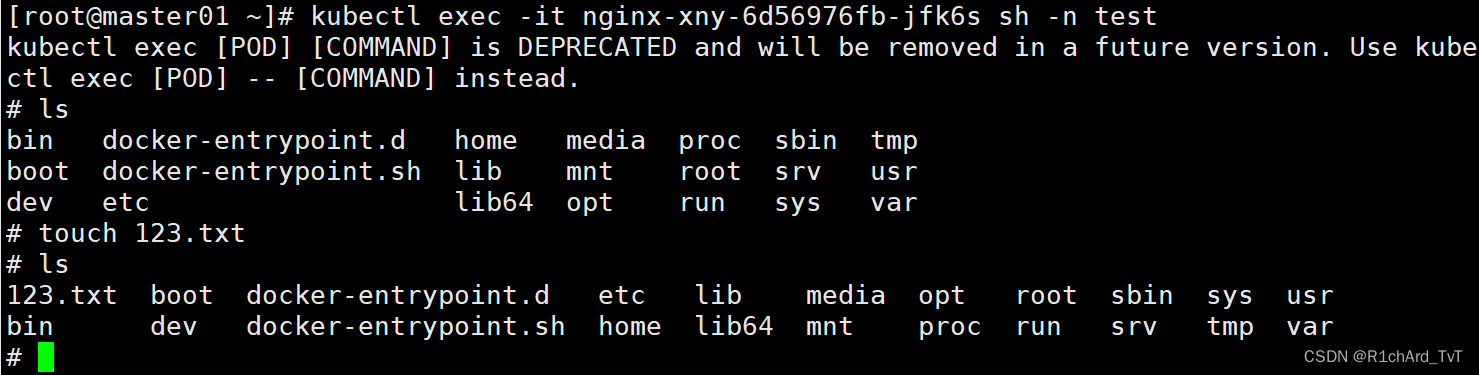

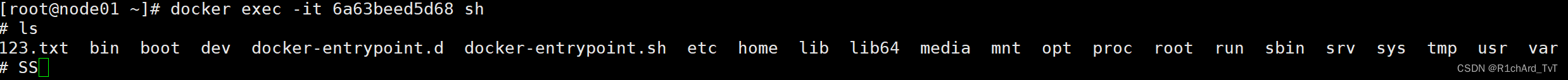

//kubectl exec可以跨主机登录容器,docker exec 只能在容器所在主机上登录

kubectl exec -it nginx-xny-d47f99cb6-hv6gz bash -n kube-public

然后到node节点docker查看

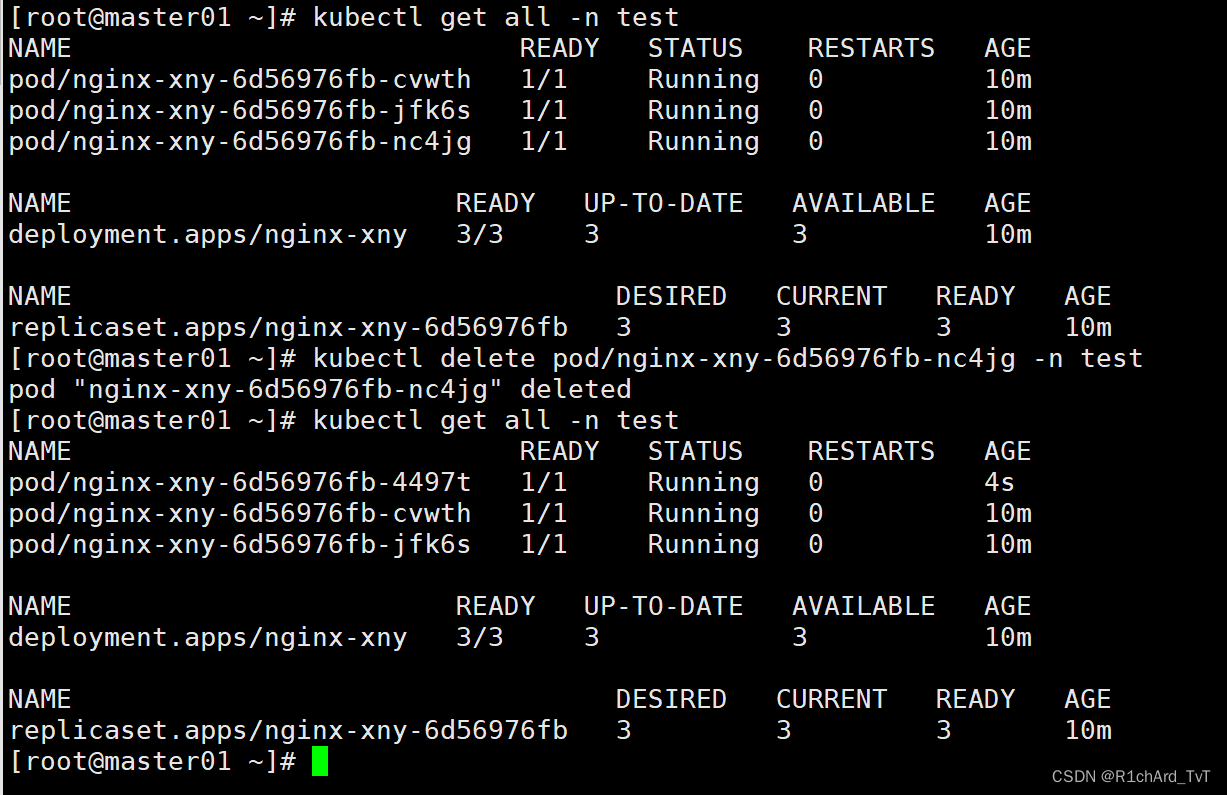

//删除(重启)pod资源,由于存在deployment/rc之类的副本控制器,删除pod也会重新拉起来

kubectl delete pod nginx-xny-d47f99cb6-hv6gz -n kube-public

//若pod无法删除,总是处于terminate状态,则要强行删除pod

kubectl delete pod <pod-name> -n <namespace> --force --grace-period=0

#grace-period表示过渡存活期,默认30s,在删除pod之前允许pod慢慢终止其上的容器进程,从而优雅退出,0表示立即终止pod

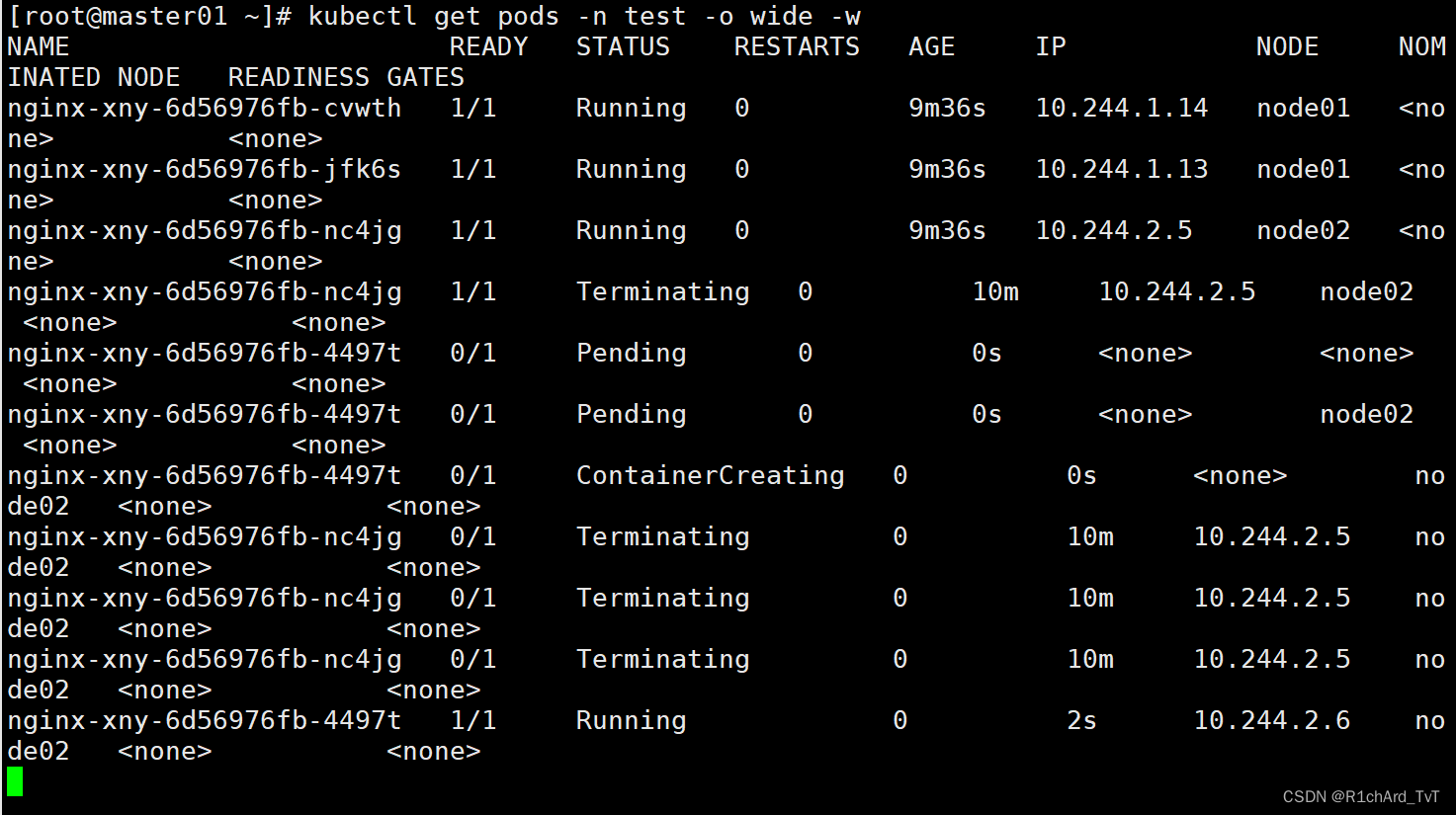

#删除pod会删除,但是会再拉起一个!原来的为pod/nginx-xny-6d56976fb-nc4jg,现在的为pod/nginx-xny-6d56976fb-jfk6s

可以再起一个终端查看: kubectl get pods -n test -o wide -w 查看删除过程

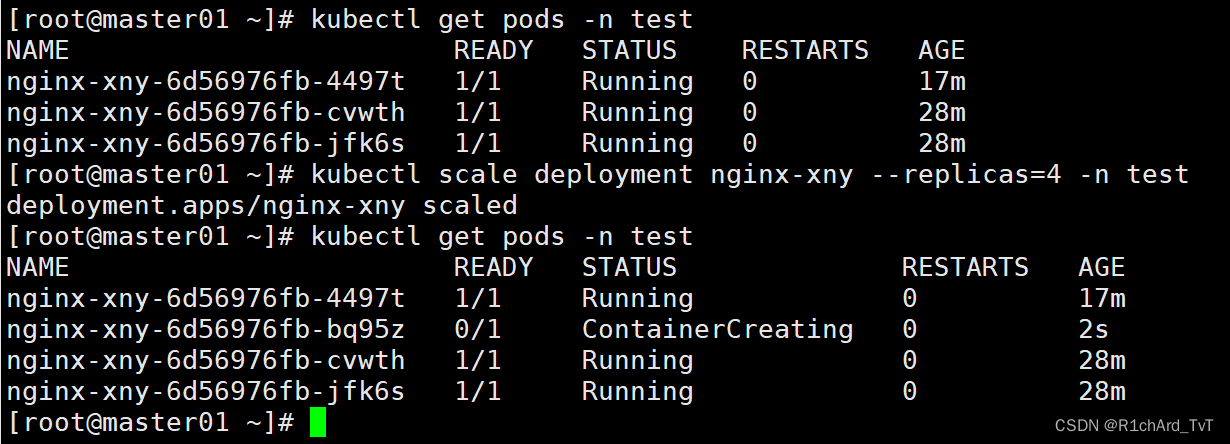

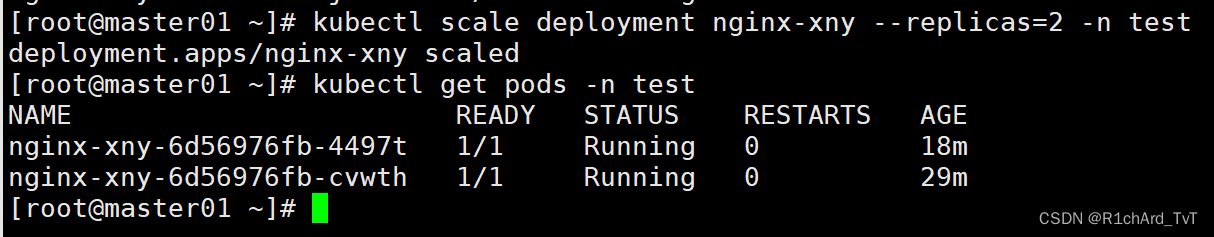

//扩缩容

kubectl scale deployment nginx-xny --replicas=2 -n kube-public # 扩容

kubectl scale deployment nginx-xny --replicas=1 -n kube-public # 缩容

//删除副本控制器

kubectl delete deployment nginx-xny -n test

kubectl delete deployment/nginx-xny -n test

//项目的生命周期:创建-->发布-->更新-->回滚-->删除

1、创建 kubectl create命令

●创建并运行一个或多个容器镜像。

●创建一个deployment 或job 来管理容器。

kubectl create --help

//启动 nginx 实例,暴露容器端口 80,设置副本数 3

kubectl create deployment nginx --image=nginx:1.14 --port=80 --replicas=3

kubectl get pods

kubectl get all

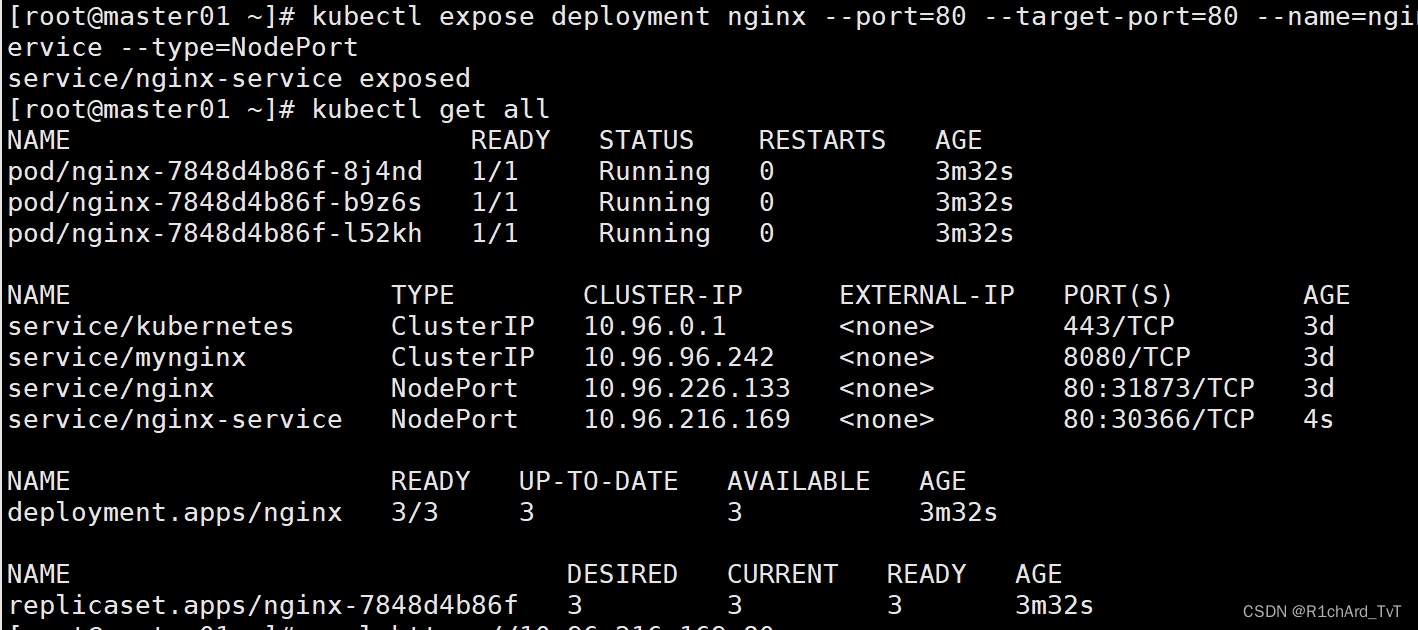

2、发布 kubectl expose命令

●将资源暴露为新的 Service。

kubectl expose --help

//为deployment的nginx创建service,并通过Service的80端口转发至容器的80端口上,Service的名称为nginx-service,类型为NodePort

kubectl expose deployment nginx --port=80 --target-port=80 --name=nginx-service --type=NodePort

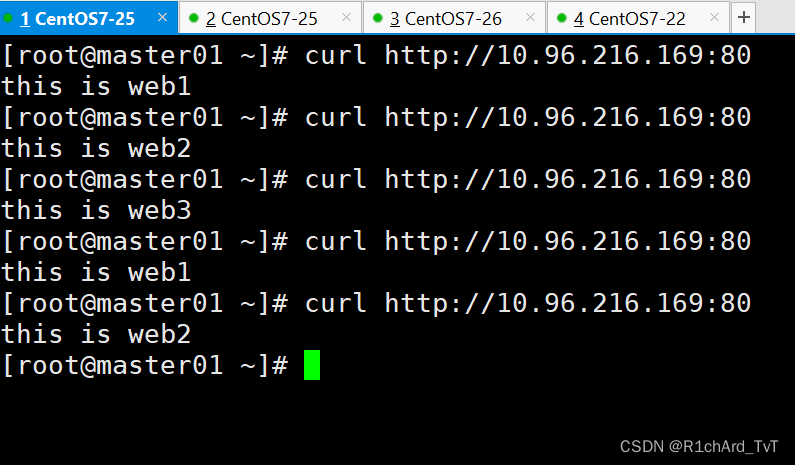

#可以访问一下

#同时可以exec进去修改/usr/share/nginx/html/index.html文件,测试负载均衡

------------------------------------------------------------------------------------------

Kubernetes 之所以需要 Service,一方面是因为 Pod 的 IP 不是固定的(Pod可能会重建),另一方面则是因为一组 Pod 实例之间总会有负载均衡的需求。

Service 通过 Label Selector 实现的对一组的 Pod 的访问。

对于容器应用而言,Kubernetes 提供了基于 VIP(虚拟IP) 的网桥的方式访问 Service,再由 Service 重定向到相应的 Pod。

service 的 type 类型:

●ClusterIP:提供一个集群内部的虚拟IP以供Pod访问(service默认类型)

●NodePort:在每个Node上打开一个端口以供外部访问,Kubernetes将会在每个Node上打开一个端口并且每个Node的端口都是一样的,通过 NodeIp:NodePort 的方式Kubernetes集群外部的程序可以访问Service。

每个端口只能是一种服务,端口范围只能是 30000-32767。

●LoadBalancer:通过设置LoadBalancer映射到云服务商提供的LoadBalancer地址。这种用法仅用于在公有云服务提供商的云平台上设置Service的场景。通过外部的负载均衡器来访问,通常在云平台部署LoadBalancer还需要额外的费用。

在service提交后,Kubernetes就会调用CloudProvider在公有云上为你创建一个负载均衡服务,并且把被代理的Pod的IP地址配置给负载均衡服务做后端。

●externalName:将service名称映射到一个DNS域名上,相当于DNS服务的CNAME记录,用于让Pod去访问集群外部的资源,它本身没有绑定任何的资源。

------------------------------------------------------------------------------------------

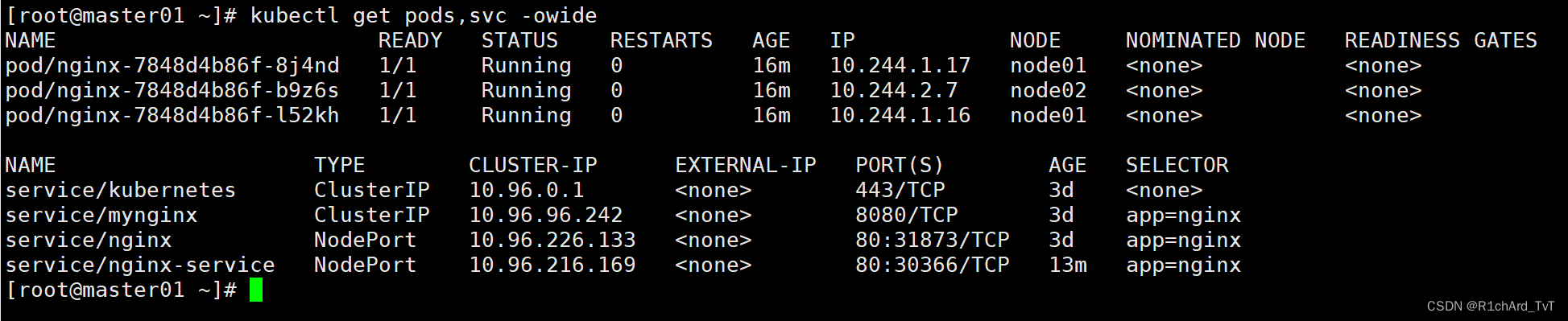

//查看pod网络状态详细信息和 Service暴露的端口

kubectl get pods,svc -o wide

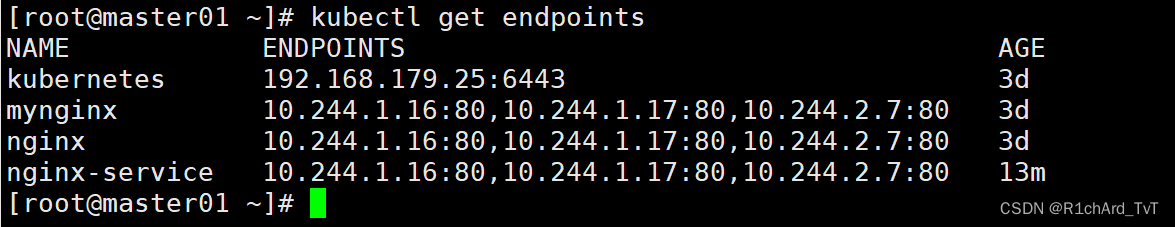

//查看关联后端的节点

kubectl get endpoints

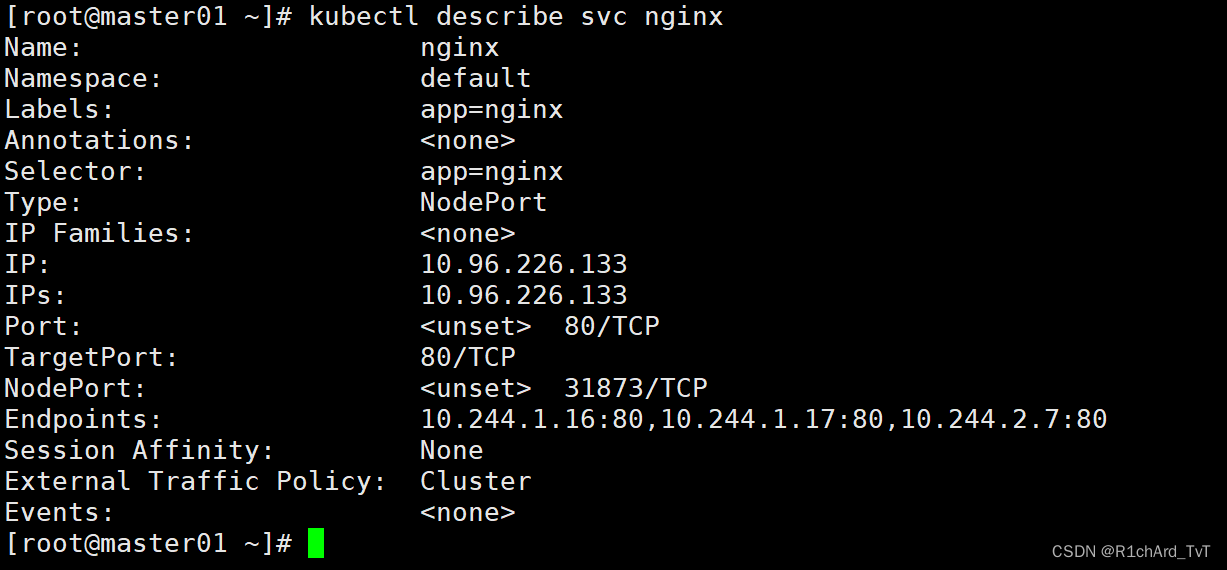

//查看 service 的描述信息

kubectl describe svc nginx

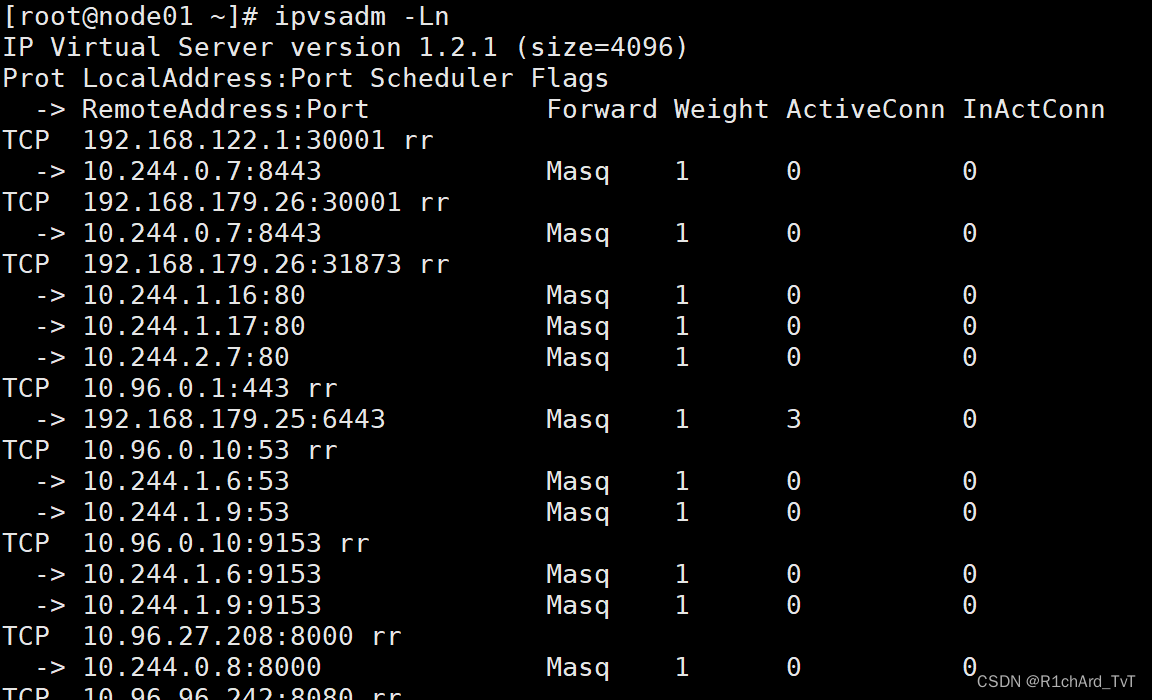

//在 node01 节点上操作,查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

//外部访问的IP和端口

TCP 192.168.80.11:44847 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

//pod集群组内部访问的IP和端口

TCP 10.0.0.189:80 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

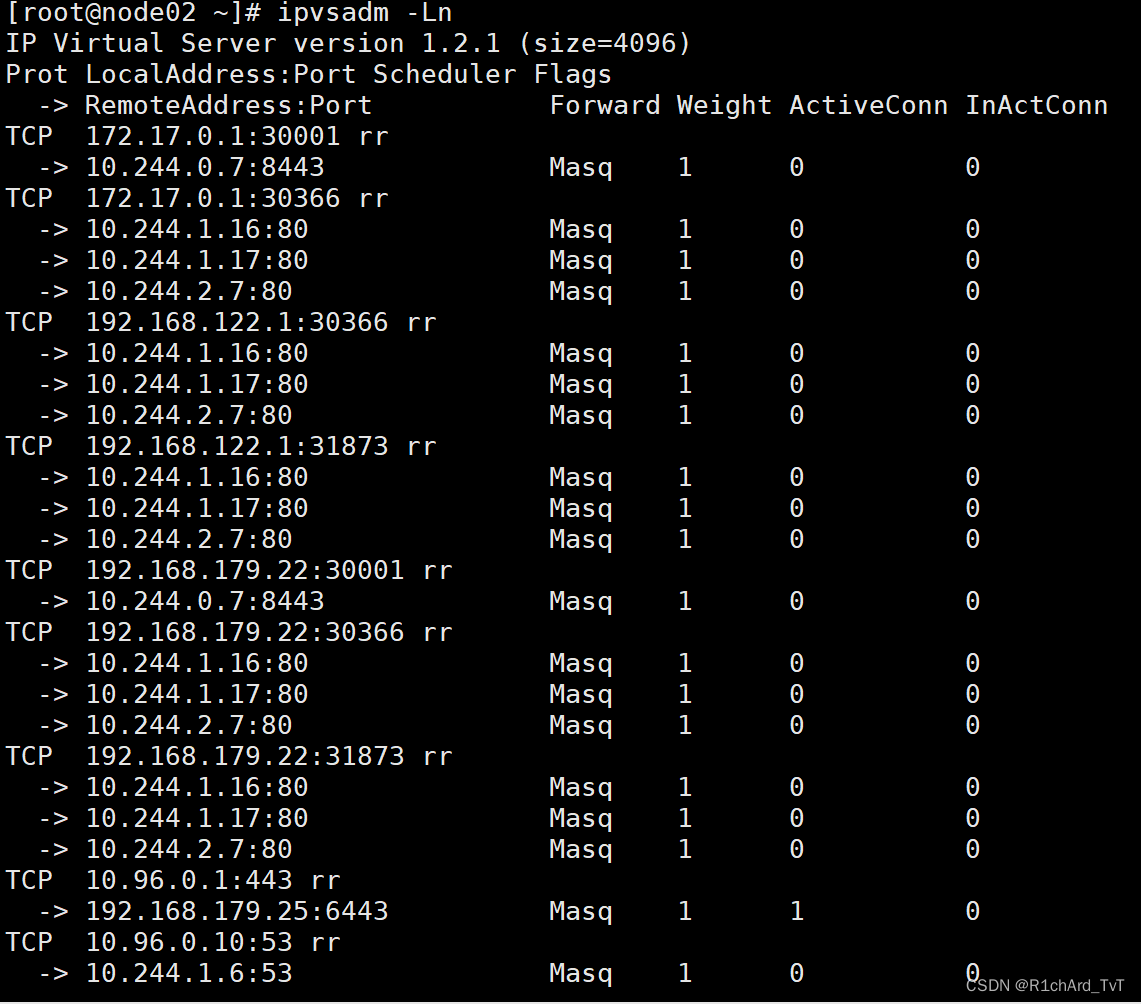

//在 node02 节点上操作,同样方式查看负载均衡端口

yum install ipvsadm -y

ipvsadm -Ln

TCP 192.168.80.12:44847 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

TCP 10.0.0.189:80 rr

-> 172.17.26.3:80 Masq 1 0 0

-> 172.17.36.2:80 Masq 1 0 0

-> 172.17.36.3:80 Masq 1 0 0

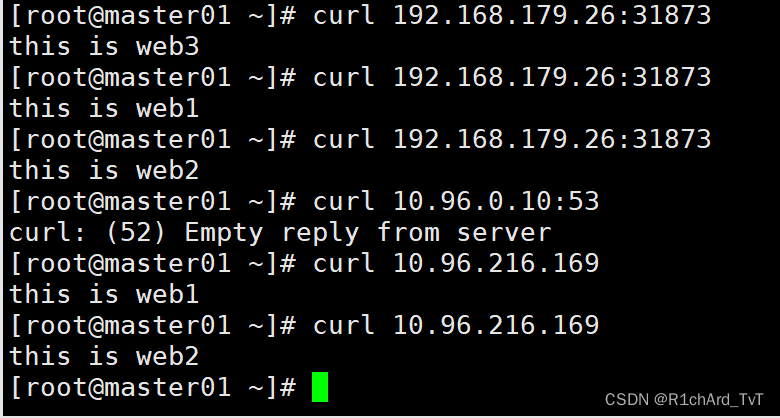

curl 10.96.216.169

curl 192.168.179.26:31873

//在master01操作 查看访问日志

kubectl logs nginx-cdb6b5b95-fjm2x

kubectl logs nginx-cdb6b5b95-g28wz

kubectl logs nginx-cdb6b5b95-x4m24

3、更新 kubectl set

●更改现有应用资源一些信息。

kubectl set --help

//获取修改模板

kubectl set image --help

Examples:

# Set a deployment's nginx container image to 'nginx:1.9.1', and its busybox container image to 'busybox'.

kubectl set image deployment/nginx busybox=busybox nginx=nginx:1.9.1

//查看当前 nginx 的版本号

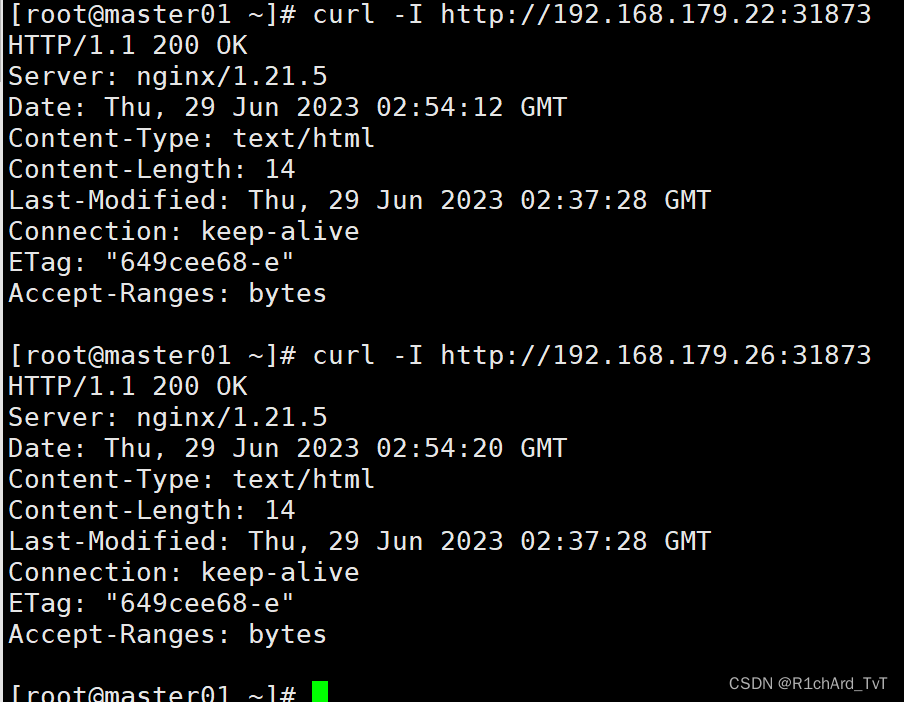

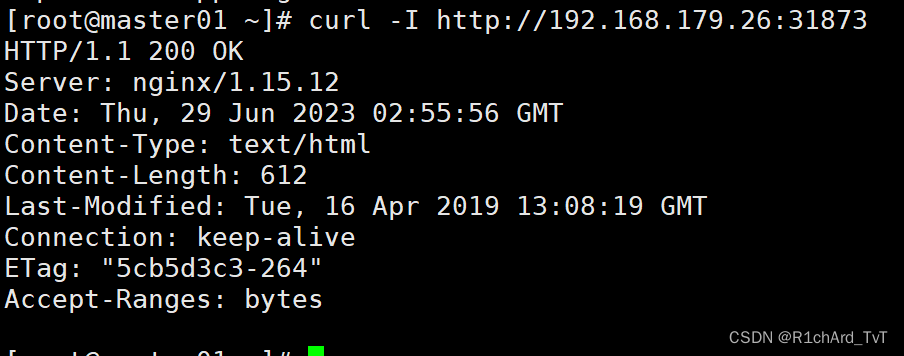

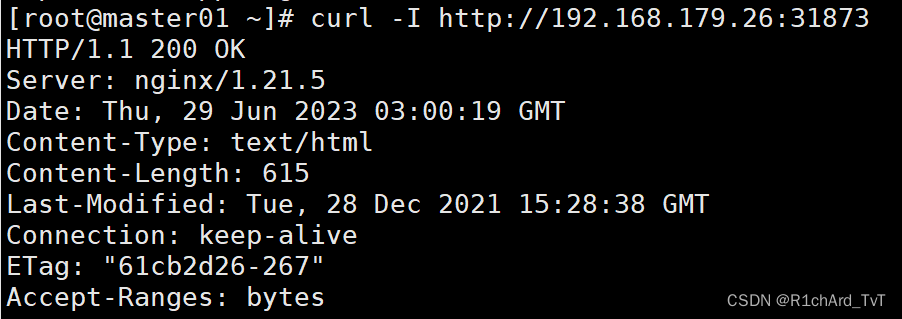

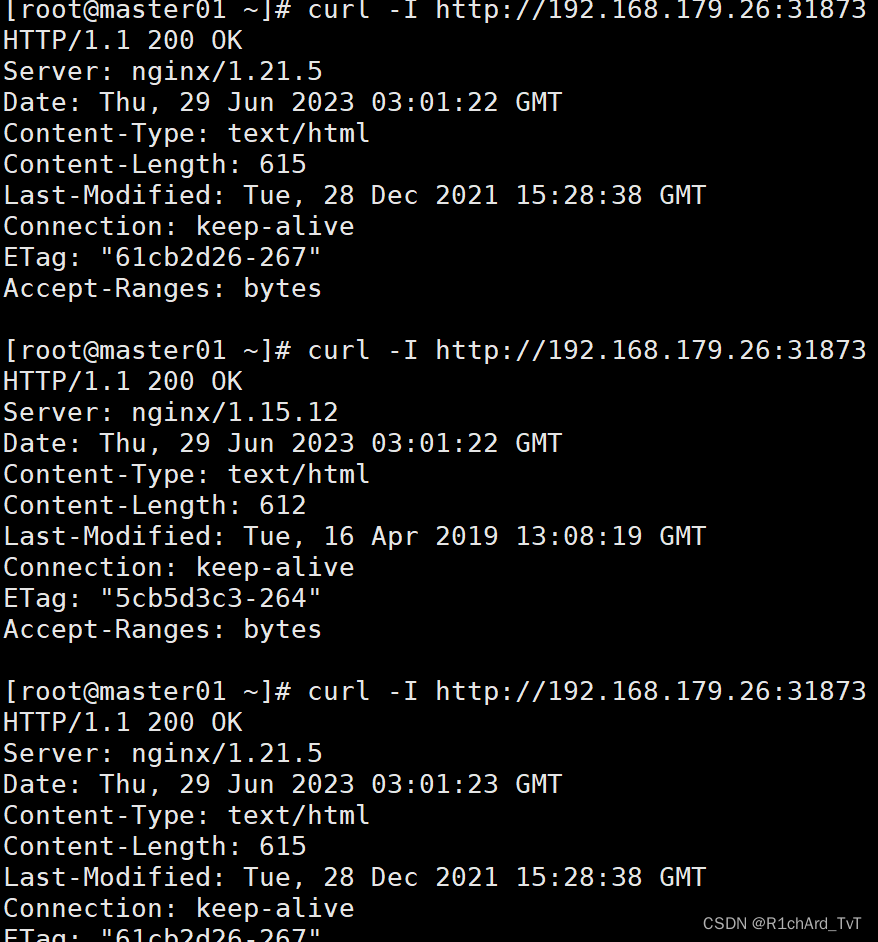

curl -I http://192.168.179.26:31873

curl -I http://192.168.179.22:31873

//将nginx 版本更新为 1.15 版本

kubectl set image deployment/nginx nginx=nginx:1.15

#更新过程:

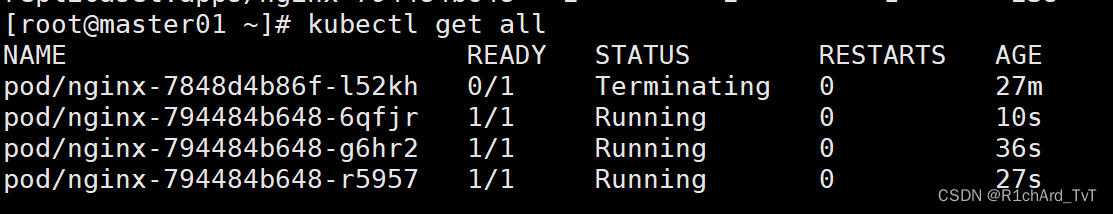

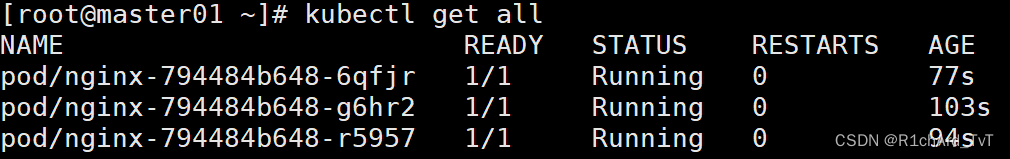

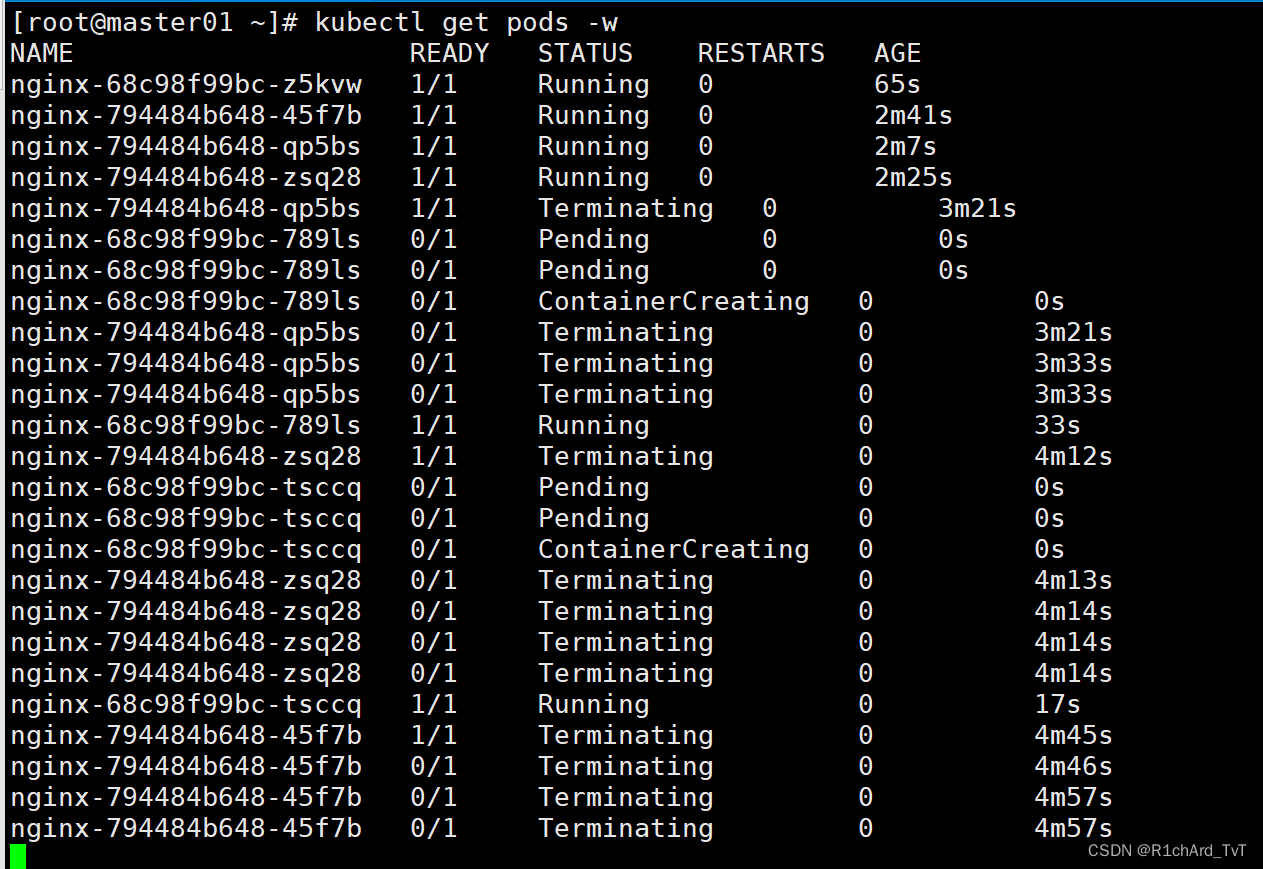

//处于动态监听 pod 状态,由于使用的是滚动更新方式,所以会先生成一个新的pod,然后删除一个旧的pod,往后依次类推

kubectl get pods -w

---------------------------------------------------------------------------------------------

#滚动更新详解:

kubectl get all

DESIRED:表示期望的状态是 10 个 READY 的副本

CURRENT:表示当前副本的总数: 即8 个日副本 + 5 个新副本

UP_TO-DATE:表示当前已经完成更新的副本数: 即 5个新副本

AVAILABLE:表示当前处于 READY 状态的副本数: 即8个日副本。

kubectl describe deployment/nginx

滚动更新通过参数 maxSurge 和 maxUnavailable 来控制副本替换的数量

maxSurge:此参数控制滚动更新过程中副本总数的超过 DESIRED 的上限。maxSurge 可以是具体的整数(比如 3),也可以是百分百,向上取整。maxSurge 默认值为 25%。

例如,DESIRED 为 10,那么副本总数的最大值为 10 + 10 * 25% = 13,即 CURRENT 为 13。

maxUnavailable:此参数控制滚动更新过程中,不可用的副本相占 DESIRED 的最大比例。maxUnavailable 可以是具体的整数(比如 3),也可以是百分百,向下取整。 maxUnavailable 默认值为 25%。

例如,DESIRED 为 10,那么可用的副本数至少要为 10 - 10 * 25% = 8,即 AVAILABLE 为 8。

因此 maxSurge 值越大,初始创建的新副本数量就越多;maxUnavailable 值越大,初始销毁的旧副本数量就越多。

理想情况下,DESIRED 为 10 的滚动更新的过程应该是这样的:

首先创建 3 个新副本使副本总数达到 13 个。

然后销毁 2 个旧副本使可用的副本数降到 8 个。

当这 2 个旧副本成功销毁后,可再创建 2 个新副本,使副本总数保持为 13 个。

当新副本通过 Readiness 探测后,会使可用副本数增加,超过 8。

进而可以继续销毁更多的旧副本,使可用副本数回到 8。

旧副本的销毁使副本总数低于 13,这样就允许创建更多的新副本。

这个过程会持续进行,最终所有的旧副本都会被新副本替换,滚动更新完成。

---------------------------------------------------------------------------------------------

//再看更新好后的 Pod 的 ip 会改变

kubectl get pods -o wide

//再看 nginx 的版本号

curl -I http://192.168.80.11:44847

curl -I http://192.168.80.12:44847

4、回滚 kubectl rollout

●对资源进行回滚管理

kubectl rollout --help

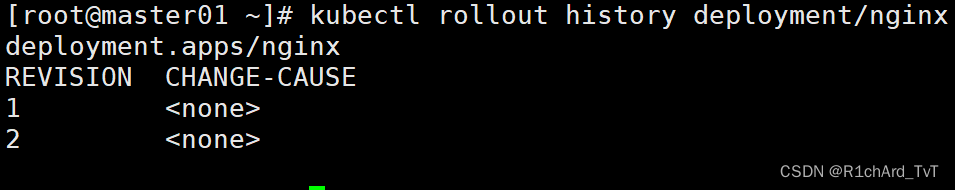

//查看历史版本

kubectl rollout history deployment/nginx

//执行回滚到上一个版本

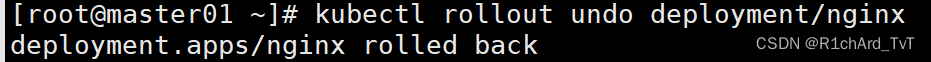

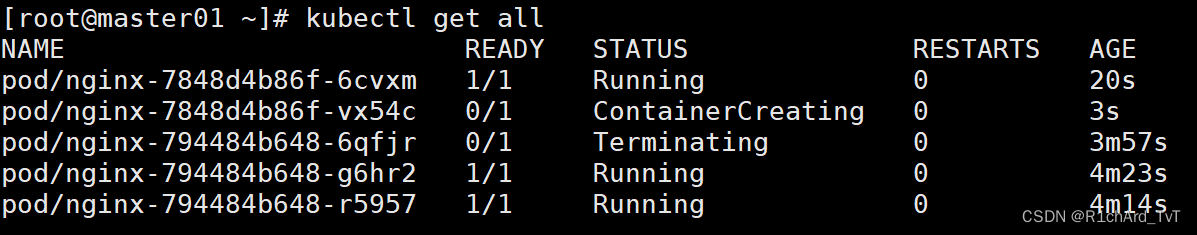

kubectl rollout undo deployment/nginx

## 又回到了1.21.5版本

//执行回滚到指定版本

kubectl rollout undo deployment/nginx --to-revision=1

#负载均衡,以及回溯到第二个版本1个pod

//检查回滚状态

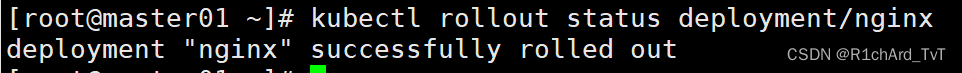

kubectl rollout status deployment/nginx

5、删除 kubectl delete

//删除副本控制器

kubectl delete deployment/nginx

//删除service

kubectl delete svc/nginx-service

kubectl get all

//金丝雀发布(Canary Release)

Deployment控制器支持自定义控制更新过程中的滚动节奏,如“暂停(pause)”或“继续(resume)”更新操作。比如等待第一批新的Pod资源创建完成后立即暂停更新过程,此时,仅存在一部分新版本的应用,主体部分还是旧的版本。然后,再筛选一小部分的用户请求路由到新版本的Pod应用,继续观察能否稳定地按期望的方式运行。确定没问题之后再继续完成余下的Pod资源滚动更新,否则立即回滚更新操作。这就是所谓的金丝雀发布。

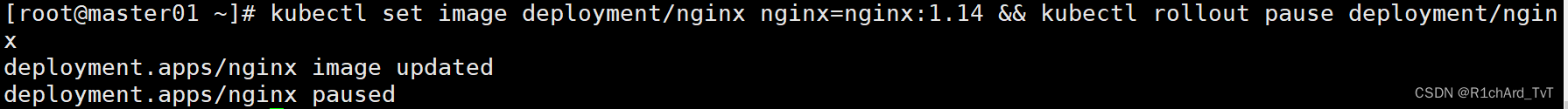

(1)更新deployment的版本,并配置暂停deployment

kubectl set image deployment/nginx nginx=nginx:1.14 && kubectl rollout pause deployment/nginx

kubectl rollout status deployment/nginx #观察更新状态

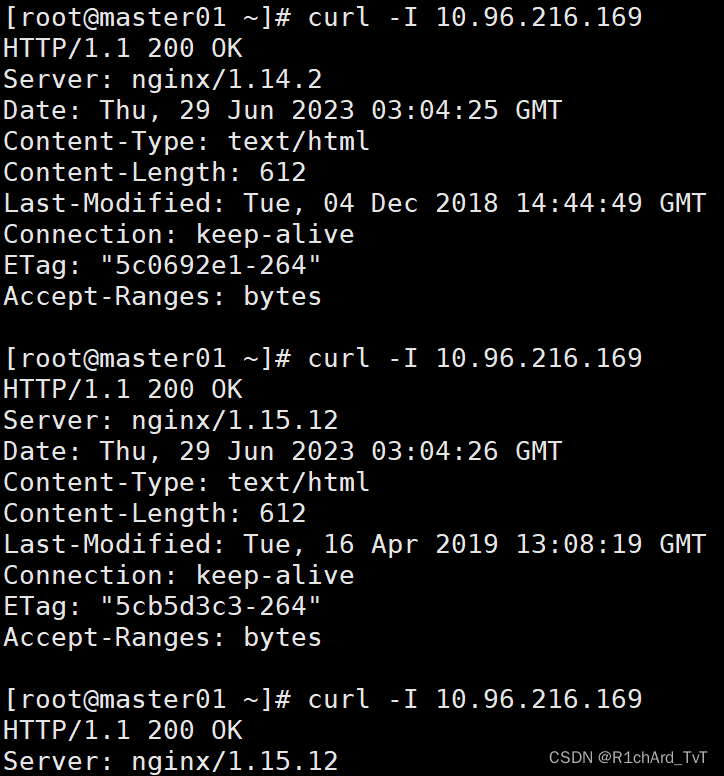

(2)监控更新的过程,可以看到已经新增了一个资源,但是并未按照预期的状态去删除一个旧的资源,就是因为使用了pause暂停命令

kubectl get pods -w

curl [-I] 10.0.0.189

curl [-I] 192.168.80.11:44847

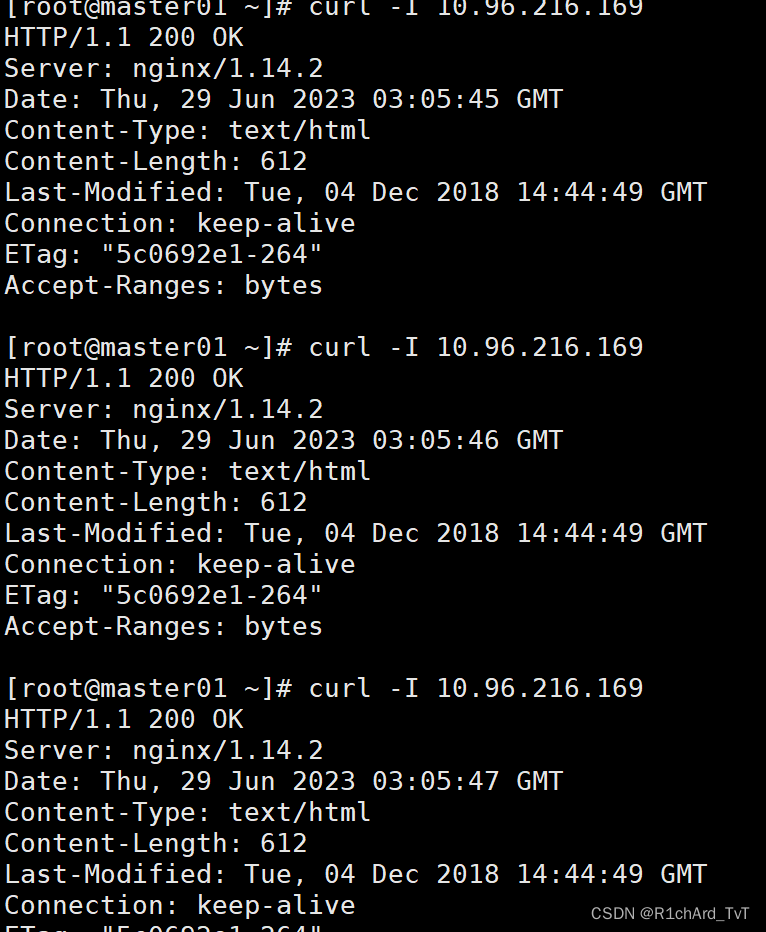

(3)确保更新的pod没问题了,继续更新

kubectl rollout resume deployment/nginx

(4)查看最后的更新情况

kubectl get pods -w

curl [-I] 10.0.0.189

curl [-I] 10.0.0.189

curl [-I] 192.168.80.11:44847

声明式管理方法:

1.适合于对资源的修改操作

2.声明式资源管理方法依赖于资源配置清单文件对资源进行管理

资源配置清单文件有两种格式:yaml(人性化,易读),json(易于api接口解析)

3.对资源的管理,是通过事先定义在统一资源配置清单内,再通过陈述式命令应用到k8s集群里

4.语法格式:kubectl create/apply/delete -f xxxx.yaml

//查看资源配置清单

kubectl get deployment nginx -o yaml

apiVersion: apps/v1

kind: Deployment

metadata:annotations:deployment.kubernetes.io/revision: "5"creationTimestamp: "2023-06-29T02:28:10Z"generation: 7labels:app: nginxmanagedFields:- apiVersion: apps/v1fieldsType: FieldsV1fieldsV1:f:metadata:f:labels:.: {}f:app: {}f:spec:f:progressDeadlineSeconds: {}f:replicas: {}f:revisionHistoryLimit: {}f:selector: {}f:strategy:f:rollingUpdate:.: {}f:maxSurge: {}f:maxUnavailable: {}f:type: {}f:template:f:metadata:f:labels:.: {}f:app: {}f:spec:f:containers:k:{"name":"nginx"}:.: {}f:imagePullPolicy: {}f:name: {}f:ports:.: {}k:{"containerPort":80,"protocol":"TCP"}:.: {}f:containerPort: {}f:protocol: {}f:resources: {}f:terminationMessagePath: {}f:terminationMessagePolicy: {}f:dnsPolicy: {}f:restartPolicy: {}f:schedulerName: {}f:securityContext: {}f:terminationGracePeriodSeconds: {}manager: kubectl-createoperation: Updatetime: "2023-06-29T02:28:10Z"- apiVersion: apps/v1fieldsType: FieldsV1fieldsV1:f:spec:f:template:f:spec:f:containers:k:{"name":"nginx"}:f:image: {}manager: kubectl-setoperation: Updatetime: "2023-06-29T03:02:34Z"- apiVersion: apps/v1fieldsType: FieldsV1fieldsV1:f:metadata:f:annotations:.: {}f:deployment.kubernetes.io/revision: {}f:status:f:availableReplicas: {}f:conditions:.: {}k:{"type":"Available"}:.: {}f:lastTransitionTime: {}f:lastUpdateTime: {}f:message: {}f:reason: {}f:status: {}f:type: {}k:{"type":"Progressing"}:.: {}f:lastTransitionTime: {}f:lastUpdateTime: {}f:message: {}f:reason: {}f:status: {}f:type: {}f:observedGeneration: {}f:readyReplicas: {}f:replicas: {}f:updatedReplicas: {}manager: kube-controller-manageroperation: Updatetime: "2023-06-29T03:05:43Z"name: nginxnamespace: defaultresourceVersion: "19903"uid: eb1e4866-0c15-4439-8f93-c7b746218b4f

spec:progressDeadlineSeconds: 600replicas: 3revisionHistoryLimit: 10selector:matchLabels:app: nginxstrategy:rollingUpdate:maxSurge: 25%maxUnavailable: 25%type: RollingUpdatetemplate:metadata:creationTimestamp: nulllabels:app: nginxspec:containers:- image: nginx:1.14imagePullPolicy: Alwaysname: nginxports:- containerPort: 80protocol: TCPresources: {}terminationMessagePath: /dev/termination-logterminationMessagePolicy: FilednsPolicy: ClusterFirstrestartPolicy: AlwaysschedulerName: default-schedulersecurityContext: {}terminationGracePeriodSeconds: 30

status:availableReplicas: 3conditions:- lastTransitionTime: "2023-06-29T02:28:43Z"lastUpdateTime: "2023-06-29T02:28:43Z"message: Deployment has minimum availability.reason: MinimumReplicasAvailablestatus: "True"type: Available- lastTransitionTime: "2023-06-29T03:04:53Z"lastUpdateTime: "2023-06-29T03:05:43Z"message: ReplicaSet "nginx-68c98f99bc" has successfully progressed.reason: NewReplicaSetAvailablestatus: "True"type: ProgressingobservedGeneration: 7readyReplicas: 3replicas: 3updatedReplicas: 3

//解释资源配置清单

kubectl explain deployment.metadata

kubectl get service nginx -o yaml

kubectl explain service.metadata

//修改资源配置清单并应用

离线修改:

修改yaml文件,并用 kubectl apply -f xxxx.yaml 文件使之生效

注意:当apply不生效时,先使用delete清除资源,再apply创建资源

kubectl get service nginx -o yaml > nginx-svc.yaml

vim nginx-svc.yaml #修改port: 8888

kubectl delete -f nginx-svc.yaml

kubectl apply -f nginx-svc.yaml

kubectl get svc

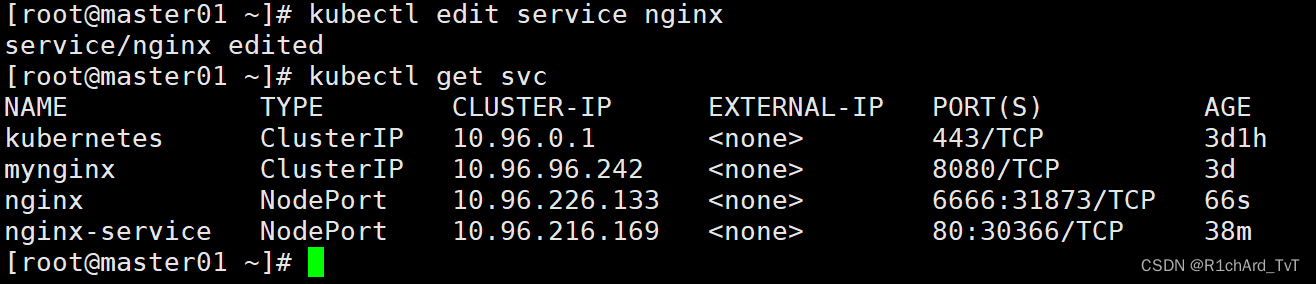

在线修改:

直接使用 kubectl edit service nginx 在线编辑资源配置清单并保存退出即时生效(如port: 6666)

PS:此修改方式不会对yaml文件内容修改

//删除资源配置清单

陈述式删除:

kubectl delete service nginx

声明式删除:

kubectl delete -f nginx-svc.yaml

Service yaml文件详解

apiVersion: v1

kind: Service

matadata: #元数据

name: string #service的名称

namespace: string #命名空间

labels: #自定义标签属性列表

- name: string

annotations: #自定义注解属性列表

- name: string

spec: #详细描述

selector: [] #label selector配置,将选择具有label标签的Pod作为管理

#范围

type: string #service的类型,指定service的访问方式,默认为

#clusterIp

clusterIP: string #虚拟服务地址

sessionAffinity: string #是否支持session

ports: #service需要暴露的端口列表

- name: string #端口名称

protocol: string #端口协议,支持TCP和UDP,默认TCP

port: int #服务监听的端口号

targetPort: int #需要转发到后端Pod的端口号

nodePort: int #当type = NodePort时,指定映射到物理机的端口号

status: #当spce.type=LoadBalancer时,设置外部负载均衡器的地址

loadBalancer: #外部负载均衡器

ingress: #外部负载均衡器

ip: string #外部负载均衡器的Ip地址值

hostname: string #外部负载均衡器的主机名

deployment.yaml文件详解

apiVersion: extensions/v1beta1 #接口版本

kind: Deployment #接口类型

metadata:

name: cango-demo #Deployment名称

namespace: cango-prd #命名空间

labels:

app: cango-demo #标签

spec:

replicas: 3

strategy:

rollingUpdate: ##由于replicas为3,则整个升级,pod个数在2-4个之间

maxSurge: 1 #滚动升级时会先启动1个pod

maxUnavailable: 1 #滚动升级时允许的最大Unavailable的pod个数

template:

metadata:

labels:

app: cango-demo #模板名称必填

sepc: #定义容器模板,该模板可以包含多个容器

containers:

- name: cango-demo #镜像名称

image: swr.cn-east-2.myhuaweicloud.com/cango-prd/cango-demo:0.0.1-SNAPSHOT #镜像地址

command: [ "/bin/sh","-c","cat /etc/config/path/to/special-key" ] #启动命令

args: #启动参数

- '-storage.local.retention=$(STORAGE_RETENTION)'

- '-storage.local.memory-chunks=$(STORAGE_MEMORY_CHUNKS)'

- '-config.file=/etc/prometheus/prometheus.yml'

- '-alertmanager.url=http://alertmanager:9093/alertmanager'

- '-web.external-url=$(EXTERNAL_URL)'

#如果command和args均没有写,那么用Docker默认的配置。

#如果command写了,但args没有写,那么Docker默认的配置会被忽略而且仅仅执行.yaml文件的command(不带任何参数的)。

#如果command没写,但args写了,那么Docker默认配置的ENTRYPOINT的命令行会被执行,但是调用的参数是.yaml中的args。

#如果如果command和args都写了,那么Docker默认的配置被忽略,使用.yaml的配置。

imagePullPolicy: IfNotPresent #如果不存在则拉取

livenessProbe: #表示container是否处于live状态。如果LivenessProbe失败,LivenessProbe将会通知kubelet对应的container不健康了。随后kubelet将kill掉container,并根据RestarPolicy进行进一步的操作。默认情况下LivenessProbe在第一次检测之前初始化值为Success,如果container没有提供LivenessProbe,则也认为是Success;

httpGet:

path: /health #如果没有心跳检测接口就为/

port: 8080

scheme: HTTP

initialDelaySeconds: 60 ##启动后延时多久开始运行检测

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

readinessProbe:

httpGet:

path: /health #如果没有心跳检测接口就为/

port: 8080

scheme: HTTP

initialDelaySeconds: 30 ##启动后延时多久开始运行检测

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

resources: ##CPU内存限制

requests:

cpu: 2

memory: 2048Mi

limits:

cpu: 2

memory: 2048Mi

env: ##通过环境变量的方式,直接传递pod=自定义Linux OS环境变量

- name: LOCAL_KEY #本地Key

value: value

- name: CONFIG_MAP_KEY #局策略可使用configMap的配置Key,

valueFrom:

configMapKeyRef:

name: special-config #configmap中找到name为special-config

key: special.type #找到name为special-config里data下的key

ports:

- name: http

containerPort: 8080 #对service暴露端口

volumeMounts: #挂载volumes中定义的磁盘

- name: log-cache

mount: /tmp/log

- name: sdb #普通用法,该卷跟随容器销毁,挂载一个目录

mountPath: /data/media

- name: nfs-client-root #直接挂载硬盘方法,如挂载下面的nfs目录到/mnt/nfs

mountPath: /mnt/nfs

- name: example-volume-config #高级用法第1种,将ConfigMap的log-script,backup-script分别挂载到/etc/config目录下的一个相对路径path/to/...下,如果存在同名文件,直接覆盖。

mountPath: /etc/config

- name: rbd-pvc #高级用法第2中,挂载PVC(PresistentVolumeClaim)

#使用volume将ConfigMap作为文件或目录直接挂载,其中每一个key-value键值对都会生成一个文件,key为文件名,value为内容,

volumes: # 定义磁盘给上面volumeMounts挂载

- name: log-cache

emptyDir: {}

- name: sdb #挂载宿主机上面的目录

hostPath:

path: /any/path/it/will/be/replaced

- name: example-volume-config # 供ConfigMap文件内容到指定路径使用

configMap:

name: example-volume-config #ConfigMap中名称

items:

- key: log-script #ConfigMap中的Key

path: path/to/log-script #指定目录下的一个相对路径path/to/log-script

- key: backup-script #ConfigMap中的Key

path: path/to/backup-script #指定目录下的一个相对路径path/to/backup-script

- name: nfs-client-root #供挂载NFS存储类型

nfs:

server: 10.42.0.55 #NFS服务器地址

path: /opt/public #showmount -e 看一下路径

- name: rbd-pvc #挂载PVC磁盘

persistentVolumeClaim:

claimName: rbd-pvc1 #挂载已经申请的pvc磁盘

//Pod yaml文件详解

apiVersion: v1 #必选,版本号,例如v1

kind: Pod #必选,Pod

metadata: #必选,元数据

name: string #必选,Pod名称

namespace: string #必选,Pod所属的命名空间

labels: #自定义标签

- name: string #自定义标签名字

annotations: #自定义注释列表

- name: string

spec: #必选,Pod中容器的详细定义

containers: #必选,Pod中容器列表

- name: string #必选,容器名称

image: string #必选,容器的镜像名称

imagePullPolicy: [Always | Never | IfNotPresent] #获取镜像的策略:Alawys表示总是下载镜像,IfnotPresent表示优先使用本地镜像,否则下载镜像,Nerver表示仅使用本地镜像

command: [string] #容器的启动命令列表,如不指定,使用打包时使用的启动命令

args: [string] #容器的启动命令参数列表

workingDir: string #容器的工作目录

volumeMounts: #挂载到容器内部的存储卷配置

- name: string #引用pod定义的共享存储卷的名称,需用volumes[]部分定义的的卷名

mountPath: string #存储卷在容器内mount的绝对路径,应少于512字符

readOnly: boolean #是否为只读模式

ports: #需要暴露的端口库号列表

- name: string #端口号名称

containerPort: int #容器需要监听的端口号

hostPort: int #容器所在主机需要监听的端口号,默认与Container相同

protocol: string #端口协议,支持TCP和UDP,默认TCP

env: #容器运行前需设置的环境变量列表

- name: string #环境变量名称

value: string #环境变量的值

resources: #资源限制和请求的设置

limits: #资源限制的设置

cpu: string #Cpu的限制,单位为core数,将用于docker run --cpu-shares参数

memory: string #内存限制,单位可以为Mib/Gib,将用于docker run --memory参数

requests: #资源请求的设置

cpu: string #Cpu请求,容器启动的初始可用数量

memory: string #内存清楚,容器启动的初始可用数量

livenessProbe: #对Pod内个容器健康检查的设置,当探测无响应几次后将自动重启该容器,检查方法有exec、httpGet和tcpSocket,对一个容器只需设置其中一种方法即可

exec: #对Pod容器内检查方式设置为exec方式

command: [string] #exec方式需要制定的命令或脚本

httpGet: #对Pod内个容器健康检查方法设置为HttpGet,需要制定Path、port

path: string

port: number

host: string

scheme: string

HttpHeaders:

- name: string

value: string

tcpSocket: #对Pod内个容器健康检查方式设置为tcpSocket方式

port: number

initialDelaySeconds: 0 #容器启动完成后首次探测的时间,单位为秒

timeoutSeconds: 0 #对容器健康检查探测等待响应的超时时间,单位秒,默认1秒

periodSeconds: 0 #对容器监控检查的定期探测时间设置,单位秒,默认10秒一次

successThreshold: 0

failureThreshold: 0

securityContext:

privileged:false

restartPolicy: [Always | Never | OnFailure] #Pod的重启策略,Always表示一旦不管以何种方式终止运行,kubelet都将重启,OnFailure表示只有Pod以非0退出码退出才重启,Nerver表示不再重启该Pod

nodeSelector: obeject #设置NodeSelector表示将该Pod调度到包含这个label的node上,以key:value的格式指定

imagePullSecrets: #Pull镜像时使用的secret名称,以key:secretkey格式指定

- name: string

hostNetwork:false #是否使用主机网络模式,默认为false,如果设置为true,表示使用宿主机网络

volumes: #在该pod上定义共享存储卷列表

- name: string #共享存储卷名称 (volumes类型有很多种)

emptyDir: {} #类型为emtyDir的存储卷,与Pod同生命周期的一个临时目录。为空值

hostPath: string #类型为hostPath的存储卷,表示挂载Pod所在宿主机的目录

path: string #Pod所在宿主机的目录,将被用于同期中mount的目录

secret: #类型为secret的存储卷,挂载集群与定义的secre对象到容器内部

scretname: string

items:

- key: string

path: string

configMap: #类型为configMap的存储卷,挂载预定义的configMap对象到容器内部

name: string

items:

- key: string

声明式资源管理

Kubernetes 支持 YAML 和 JSON 格式管理资源对象

JSON 格式:主要用于 api 接口之间消息的传递

YAML 格式:用于配置和管理,YAML 是一种简洁的非标记性语言,内容格式人性化,较易读

YAML 语法格式:

●大小写敏感

●使用缩进表示层级关系

●不支持Tab键制表符缩进,只使用空格缩进

●缩进的空格数目不重要,只要相同层级的元素左侧对齐即可,通常开头缩进两个空格

●符号字符后缩进一个空格,如冒号,逗号,短横杆(-)等

●“---”表示YAML格式,一个文件的开始,用于分隔文件间

●“#”表示注释

//查看 api 资源版本标签

kubectl api-versions

admissionregistration.k8s.io/v1beta1

apiextensions.k8s.io/v1beta1

apiregistration.k8s.io/v1

apiregistration.k8s.io/v1beta1

apps/v1 #如果是业务场景一般首选使用 apps/v1

apps/v1beta1 #带有beta字样的代表的是测试版本,不用在生产环境中

apps/v1beta2

authentication.k8s.io/v1

authentication.k8s.io/v1beta1

authorization.k8s.io/v1

authorization.k8s.io/v1beta1

autoscaling/v1

autoscaling/v2beta1

autoscaling/v2beta2

batch/v1

batch/v1beta1

certificates.k8s.io/v1beta1

coordination.k8s.io/v1beta1

events.k8s.io/v1beta1

extensions/v1beta1

networking.k8s.io/v1

policy/v1beta1

rbac.authorization.k8s.io/v1

rbac.authorization.k8s.io/v1beta1

scheduling.k8s.io/v1beta1

storage.k8s.io/v1

storage.k8s.io/v1beta1

v1

//写一个yaml文件demo

mkdir /opt/demo

cd demo/

vim nginx-deployment.yaml

apiVersion: apps/v1 #指定api版本标签

kind: Deployment #定义资源的类型/角色,deployment为副本控制器,此处资源类型可以是Deployment、Job、Ingress、Service等

metadata: #定义资源的元数据信息,比如资源的名称、namespace、标签等信息name: nginx-deployment #定义资源的名称,在同一个namespace空间中必须是唯一的labels: #定义Deployment资源标签app: nginx

spec: #定义deployment资源需要的参数属性,诸如是否在容器失败时重新启动容器的属性replicas: 3 #定义副本数量selector: #定义标签选择器matchLabels: #定义匹配标签app: nginx #需与 .spec.template.metadata.labels 定义的标签保持一致template: #定义业务模板,如果有多个副本,所有副本的属性会按照模板的相关配置进行匹配metadata:labels: #定义Pod副本将使用的标签,需与 .spec.selector.matchLabels 定义的标签保持一致app: nginxspec:containers: #定义容器属性- name: nginx #定义一个容器名,一个 - name: 定义一个容器image: nginx:1.15.4 #定义容器使用的镜像以及版本ports:- containerPort: 80 #定义容器的对外的端口//创建资源对象

kubectl create -f nginx-deployment.yaml

//查看创建的pod资源

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

nginx-deployment-d55b94fd-29qk2 1/1 Running 0 7m9s 172.17.36.4 192.168.80.12 <none>

nginx-deployment-d55b94fd-9j42r 1/1 Running 0 7m9s 172.17.36.3 192.168.80.12 <none>

nginx-deployment-d55b94fd-ksl6l 1/1 Running 0 7m9s 172.17.26.3 192.168.80.11 <none>

//创建service服务对外提供访问并测试

vim nginx-service.yaml

apiVersion: v1

kind: Service

metadata:name: nginx-servicelabels:app: nginx

spec:type: NodePort ports:- port: 80targetPort: 80 selector:app: nginx//创建资源对象

kubectl create -f nginx-service.yaml

//查看创建的service

kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 16d

nginx-service NodePort 10.0.0.119 <none> 80:35680/TCP 14s//在浏览器输入 nodeIP:nodePort 即可访问

http://192.168.80.11:35680

http://192.168.80.12:35680

------------------------------------------------------------------------------------------

详解k8s中的port:

●port

port 是 k8s 集群内部访问service的端口,即通过 clusterIP: port 可以从 Pod 所在的 Node 上访问到 service●nodePort

nodePort 是外部访问 k8s 集群中 service 的端口,通过 nodeIP: nodePort 可以从外部访问到某个 service。●targetPort

targetPort 是 Pod 的端口,从 port 或 nodePort 来的流量经过 kube-proxy 反向代理负载均衡转发到后端 Pod 的 targetPort 上,最后进入容器。●containerPort

containerPort 是 Pod 内部容器的端口,targetPort 映射到 containerPort。

------------------------------------------------------------------------------------------

//kubectl run --dry-run=client 打印相应的 API 对象而不执行创建

kubectl run nginx-test --image=nginx --port=80 --dry-run=client

kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client

//查看生成yaml格式

kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o yaml

kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o yaml

//查看生成json格式

kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o json

kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o json

//使用yaml格式导出生成模板,并进行修改以及删除一些不必要的参数

kubectl run nginx-test --image=nginx --port=80 --dry-run=client -o yaml > nginx-test.yaml

kubectl create deployment nginx-deploy --image=nginx --port=80 --replicas=3 --dry-run=client -o yaml > nginx-deploy.yaml

vim nginx-test.yaml

apiVersion: v1

kind: Pod

metadata:

creationTimestamp: null #删除

labels:

run: nginx-test

name: nginx-test

spec:

containers:

- image: nginx

name: nginx-test

ports:

- containerPort: 80

resources: {} #删除

dnsPolicy: ClusterFirst

restartPolicy: Always

status: {} #删除

//将现有的资源生成模板导出

kubectl get svc nginx-service -o yaml

//保存到文件中

kubectl get svc nginx-service -o yaml > my-svc.yaml

//查看字段帮助信息,可一层层的查看相关资源对象的帮助信息

kubectl explain deployments.spec.template.spec.containers

或

kubectl explain pods.spec.containers

//写yaml太累怎么办?

●用 --dry-run 命令生成

kubectl run my-deploy --image=nginx --dry-run=client -o yaml > my-deploy.yaml

●用get命令导出

kubectl get svc nginx-service -o yaml > my-svc.yaml

或

kubectl edit svc nginx-service #复制配置,再粘贴到新文件

//yaml文件的学习方法:

(1)多看别人(官方)写的,能读懂

(2)能照着现场的文件改着用

(3)遇到不懂的,善用kubectl explain ... 命令查

总结:

陈述式资源管理:

kubectl create <资源类型> <资源名称> [选项] -n 命名空间

--image=镜像 --replicas=副本数 port=容器端口kubectl get <资源类型|all> [资源名称] -n 命名空间 -o wide|yaml|json -w

kubectl delete <资源类型> <资源名称>|--all -n 命名空间 [--force --grace-period=0] #立即终止Pod并强制删除Pod

kubectl describe <资源类型> <资源名称> -n 命名空间

kubectl exec -it <pod资源名称> [-c <容器名>] sh|bash -n 命名空间

kubectl scale deployment <资源名称> --replicas= -n 命名空间

kubectl expose deployment <资源名称> --port <clusterip的端口> --target-port <容器的端口> --name <自定义svc资源名称> --type <svc类型>

kubectl logs <pod资源名称> [-c <容器名>] [–previous] #–previous 读的是上次退出的容器的日志文件

kubectl set image deployment <资源名称> 容器名=镜像名

kubectl rollout history deployment <资源名称>

kubectl rollout undo deployment <资源名称> [--to-revision= ] #--to-revision= 指定版本回滚

kubectl rollout status deployment <资源名称>kubectl set image deployment <资源名称> 容器名=镜像名 && kubectl rollout pause deployment <资源名称> 金丝雀发布,更新+暂停

kubectl rollout resume deployment <资源名称> 恢复继续更新

serivce类型:

ClusterIP : 默认的service资源的类型,提供clusterIP 供K8S集群内部访问

NodePort : 在每个Node节点上开启一个端口,K8S集群内外的用户都可以通过 Node节 点的IP 和 NodePort 即可访问到service以及关联的相关pod

LoadBalancer : 使用公有云的LB服务和Service做映射,使得用户使用公有云LB服务的IP地 址即可通过NodeIP:NodePort访问到service以及关联的相关pod

ExternalName : 相当于给一个域名做别名,Pod可以通过这个service访问集群外部的资源

serivce 和 pod 的端口

port : serivce 的 ClusterIP 所使用的端口

nodePort : NodePort类型的service所定义的 在每个Node节点上开启的端口(默认端口范围30000~32767)

targetPort : 以上port或nodePort 所要转发到的后端 Pod 的容器端口containerPort : 后端 Pod 的容器 所使用的端口

K8S集群内部 http://ClusterIp:port -> PodIP:containerPort

K8S集群外部 http://NodeIp:NodePort -> PodIP:containerPort

业务发布策略:

蓝绿发布

滚动发布

金丝雀发布/灰度发布

声明式管理方法:

离线修改: [ kubectl delete -f XXX.yaml && ] kubectl apply -f XXX.yaml

在线修改: kubectl edit 资源类型 资源名称 -n 命名空间 #注:部分字段配置不支持在线修改如何生成一个资源配置清单(yaml配置文件)?

1)结合 kubectl explain 资源类型.第一层字段.第二层字段... 可一层层查看相关资源对象的字段解析帮助信息,手打yaml配置文件

kubectl explain deployment.spec.template.containers

kubectl explain svc.spec.pods2)用 kubectl get 或 kubectl edit 查看资源对象的配置生成配置模板文件

kubectl get 资源类型 资源名称 -n 命名空间 -o yaml > XXX.yaml

kubectl get deployment nginx-ky27 -o yaml > nginx-ky27-deploy.yamlkubectl edit 资源类型 资源名称 -n 命名空间 #手动复制配置内容,再粘贴内容到新文件

3)去官网查找资源的配置案例 kubernetes.io

4)用 --dry-run=client 参数选项生成配置模板

kubectl create 资源类型 资源名称 [选项] --dry-run=client -o yaml > XXX.yaml

kubectl create deployment nginx-ky27 --image=nginx:1.16 --port=80 --replicas=3 --dry-run=client -o yaml > nginx-ky27-deploy.yaml

kubectl create svc svc类型 资源名称 --tcp=<port>:<targetPort> --node-port=<nodeport> --dry-run=client -o yaml > svc.yaml