最近我注意到Ollama提供了Python和JavaScript库的Libraries。

我通过GitHub搜寻了一些Web项目,并尝试了其中一些项目。以下是我体验过的几个项目:

- open-webui

- ollama-webui-lite

- ollama-gui

- nextjs-ollama-llm-ui

- llamazing

客户端

客户端中,我发现 chatbox 是更新了支持ollama的且他还是多端支持的。

对于nextjs-ollama-llm-ui这个项目,我进行了测试,发现它支持图片上传、模型下载和模型切换等功能,整体体验还不错。

在开发环境中,我还发现了一个名为Continue的插件,它是VS Code和JetBrains的开源插件,使用LLM代码变得非常简单。

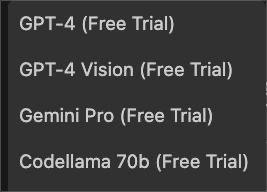

对于试用模型,一旦安装好上述插件,您会发现它直接提供了几个试用模型。

以下是Continue支持的模型:

开源LLMs

- Code Llama-Instruct-7B

- Code Llama-Instruct-13B

- Code Llama-Instruct-34B

- Code Llama-Instruct-70B

- WizardCoder-7B

- WizardCoder-13B

- WizardCoder-34B

- Phind-CodeLlama-34B

- Mistral-Instruct-7B

- StarCoder-15B

- Deepseek-Coder-1.3b-Instruct

- Deepseek-Coder-6.7b-Instruct

- Deepseek-Coder-33b-Instruct

- Llama2-Chat-7B

- Llama2-Chat-13B

- Llama2-Chat-70B

- CodeUp-13B

- Zephyr-7B

- Neural-Chat-7B

商业模型

- GPT-4

- GPT-4-Turbo

- GPT-3.5-Turbo

- Claude-2

- Gemini Pro

您可以在config.json中进行配置,这个配置文件用于设置本地模型。

例如加入本地的codeLlama:

{"models": [{"title": "codellama","model": "codellama","completionOptions": {},"apiBase": "http://localhost:11434","provider": "ollama"}]

}同时,我还发现了一个通过JavaScript编写的演示Demo,支持远程访问。您可以在ytb-开发小demo中找到这个有趣的演示。

![[OpenAI]继ChatGPT后发布的Sora模型原理与体验通道](https://img-blog.csdnimg.cn/direct/6f21b60b46e84e9aaec5932e802046ae.jpeg)