随着互联网的发展,网络爬虫已经成为了一项重要的技能。Python 3 作为一种流行的编程语言,也是网络爬虫的常用工具之一。本文将介绍如何使用 Python 3 编写网络爬虫,以及如何使用 Python 3 中的一些库进行网页解析和数据提取。

确定目标

在开始编写爬虫之前,需要明确自己的目标。要想成功爬取数据,需要确定要爬取的网站和要提取的数据类型。在本文中,我们将以豆瓣电影网站为例,爬取电影名称、评分和评价人数等信息。

1.安装必要的库

Python 3 中有很多库可以用于编写网络爬虫,其中最常用的是 requests、beautifulsoup4 和 lxml。在开始之前,需要先安装这些库。可以使用以下命令进行安装:

pip install requests beautifulsoup4 lxml2.获取网页内容

在 Python 3 中,使用 requests 库可以方便地获取网页内容。首先需要导入该库:

import requests然后,使用 requests 库的 get() 函数可以获取网页的内容:

url = 'https://movie.douban.com/top250'

response = requests.get(url)

html = response.text这段代码将豆瓣电影 Top250 页面的 HTML 代码获取到了 html 变量中。

3.解析网页内容

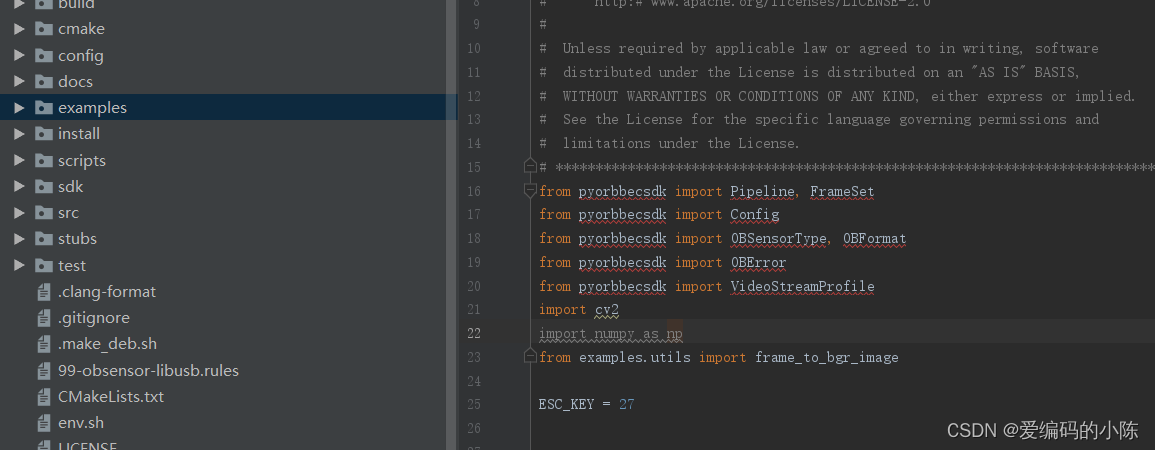

获取到网页的 HTML 代码后,需要使用 beautifulsoup4 和 lxml 库对其进行解析。首先需要导入这两个库:

from bs4 import BeautifulSoup

import lxml然后,可以使用 beautifulsoup4 库的 BeautifulSoup 类对 HTML 代码进行解析:

soup = BeautifulSoup(html, 'lxml')在获取到 BeautifulSoup 对象之后,就可以使用它提供的一些方法来获取特定的元素。在本例中,我们需要获取电影名称、评分和评价人数等信息。可以使用以下代码获取电影名称:

movies = soup.select('.hd')

for movie in movies:name = movie.select_one('.title').text.strip()print(name)在这段代码中,我们使用了 CSS 选择器来选择 HTML 元素。soup.select('.hd') 表示选择 class 为 hd 的元素,即电影信息所在的 div 元素。

然后,对于每个电影信息,使用 movie.select_one('.title') 选择 class 为 title 的元素,即电影名称所在的 a 元素。最后使用 text.strip() 获取电影名称并去掉空格。

类似地,可以使用以下代码获取评分和评价人数:

ratings = soup.select('.rating-num')

for rating in ratings:score = rating.text.strip第三步:解析网页数据并存储

现在我们已经成功地获取到了网页的 HTML 内容,接下来需要解析 HTML 并提取需要的数据,最后将数据存储起来。

在 Python 中,有许多 HTML 解析库可供选择。其中比较流行的是 BeautifulSoup。使用前需要先安装:

pip install beautifulsoup4安装完成后,我们可以先简单地打印出 HTML 内容,以检查是否成功获取到数据:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

print(soup.prettify())可以看到,输出结果与我们在浏览器中查看到的网页 HTML 内容基本相同。接下来,我们需要从 HTML 中提取需要的数据。

我们可以通过浏览器的开发者工具(DevTools)来查看 HTML 元素的结构,并据此提取数据。比如,我们想要提取搜索结果页面中每个搜索结果的标题和链接,可以通过以下方式:

for result in soup.select('.result'):title = result.select_one('.title').get_text()link = result.select_one('.link').get('href')print(title, link)在这里,我们使用了 CSS 选择器来查找每个搜索结果,并通过 .select_one() 方法来提取标题和链接。其中,get_text() 方法用于获取元素的文本内容,get() 方法则用于获取元素的属性值。

最后,我们需要将数据存储到本地或数据库中。这个过程可以根据实际需求来进行设计。比如,可以将数据存储为 CSV 文件或 JSON 文件,也可以存储到关系型数据库或 NoSQL 数据库中。

下面是一个将搜索结果存储为 CSV 文件的示例代码:

import csv

with open('results.csv', 'w', encoding='utf-8', newline='') as f:writer = csv.writer(f)writer.writerow(['Title', 'Link'])for result in soup.select('.result'):title = result.select_one('.title').get_text()link = result.select_one('.link').get('href')writer.writerow([title, link])以上就是一个简单的 Python 网络爬虫的实现流程。当然,实际应用中还需要考虑反爬虫、数据清洗等问题。但是,对于初学者来说,以上的代码已经足够了解网络爬虫的基本流程和方法。

总结

网络爬虫是一种强大的工具,可以用于自动化数据采集、网站监测等应用场景。

Python 作为一门简洁、易学的语言,成为了开发网络爬虫的首选语言。

在开发网络爬虫时,我们需要先确定要爬取的网站和目标数据,然后设计数据采集方案、编写代码实现数据的获取和解析,最后将数据存储到本地或数据库中。

如果你对Python感兴趣,想要学习python,这里给大家分享一份Python全套学习资料,都是我自己学习时整理的,希望可以帮到你,一起加油!

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

1️⃣零基础入门

① 学习路线

对于从来没有接触过Python的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

② 路线对应学习视频

还有很多适合0基础入门的学习视频,有了这些视频,轻轻松松上手Python~

③练习题

每节视频课后,都有对应的练习题哦,可以检验学习成果哈哈!

2️⃣国内外Python书籍、文档

① 文档和书籍资料

3️⃣Python工具包+项目源码合集

①Python工具包

学习Python常用的开发软件都在这里了!每个都有详细的安装教程,保证你可以安装成功哦!

②Python实战案例

光学理论是没用的,要学会跟着一起敲代码,动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。100+实战案例源码等你来拿!

③Python小游戏源码

如果觉得上面的实战案例有点枯燥,可以试试自己用Python编写小游戏,让你的学习过程中增添一点趣味!

4️⃣Python面试题

我们学会了Python之后,有了技能就可以出去找工作啦!下面这些面试题是都来自阿里、腾讯、字节等一线互联网大厂,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

上述所有资料 ⚡️ ,朋友们如果有需要的,可以扫描下方👇👇👇二维码免费领取🆓