原文地址:Prompt Tuning: A Powerful Technique for Adapting LLMs to New Tasks

2023 年 10 月 18 日

提示词微调是一种通过训练少量提示参数来使大型语言模型 (LLM) 适应新任务的技术。提示文本添加在输入文本之前,以指导LLM生成所需的输出。由于其高效性和灵活性,它在自然语言处理领域获得了广泛的关注。

来源

什么是提示词微调?

提示词微调是通过训练一小组称为提示的参数来使LLM适应新任务的过程。这些提示被添加到输入文本之前,以指导LLM生成所需的输出。

提示词微调的好处

1. 高效

与微调整个 LLM 相比,提示词微调提供了更有效的方法。它只需要训练少量的提示参数,从而更快地适应新任务。

2. 灵活

提示词微调可应用于各个领域的广泛任务,包括自然语言处理、图像分类和代码生成。这种灵活性使得快速调整成为适应法学硕士的通用技术。

3.可解释性

通过提示词微调,可以检查提示参数以了解如何引导 LLM 生成所需的输出。这种可解释性为模型的决策过程提供了宝贵的见解。

提示词微调的最大挑战

1. 设计复杂的提示

设计有效的提示可能具有挑战性,尤其是对于复杂的任务。它需要仔细考虑语言、结构和上下文以确保最佳性能。

想象一下,您在一家专注于糖尿病和肥胖等代谢疾病的制药公司工作。您希望使用语言模型来收集特定于您的工作的信息或见解,但不希望获得有关其他条件或提及特定竞争公司或产品的不相关详细信息。这是提示调整的典型用例。

挑战:您想要向人工智能模型询问有关您关注领域(代谢疾病)的信息,但您需要过滤掉不相关的信息并避免引用特定的公司名称和产品。

提示示例:

错误提示: “告诉我有关代谢疾病、糖尿病和肥胖症的所有信息,但不要提及任何其他疾病,并避免谈论我们的竞争对手 ABC Pharmaceuticals 及其产品 XYZ。”

这是一个不好的例子,因为它太长太复杂,模型无法有效处理。该模型可能无法完全理解细微的需求。

更好的提示: “我需要有关糖尿病和肥胖等代谢疾病的见解。请重点关注症状、治疗方案和最近的研究进展,而不要提及具体的公司名称或产品。”

在这个更好的例子中,你简洁而明确地表达了你想要的东西。您要求提供有关您感兴趣的领域(代谢疾病)的信息,同时设定明确的界限(没有公司或产品名称)。这使得模型更容易理解并提供相关信息。

2. 过拟合

提示词微调很容易出现过度拟合,特别是当提示太大或太具体时。过度拟合可能会导致对未见过的数据的泛化能力较差,从而限制了改编后的LLM的性能。

想象一下您想要使用语言模型来回答有关动物的问题。您首先使用以下提示训练模型:

“你能告诉我关于狮子的事情吗?提供有关它们的大小、栖息地和饮食的信息。”

该模型了解狮子并提供出色的响应。但是,当您在不同的环境中遇到有关狮子的问题时,例如在动物园中:

“给我讲讲动物园里的狮子吧。”

过度拟合的模型可能很难提供相关答案,因为它经过训练可以回答有关野生狮子的非常具体的问题。它不理解上下文转换。

为了防止过度拟合,您应该使提示更加通用和强大。例如:

“告诉我有关狮子的事以及它们的共同特征。”

这种更广泛的提示鼓励模型提供有关狮子的一般信息,这些信息可适用于各种环境,包括动物园。

总之,当您让提示过于具体时,提示词微调中就会发生过度拟合,从而导致模型产生狭隘的定制响应。为了避免过度拟合,创建多功能且适应不同场景的提示非常重要。

3. 可扩展性

将提示词微调扩展到具有大量训练数据的任务可能具有挑战性。随着训练数据规模的增加,有效地适应 LLM 需要仔细的优化策略。

想象一下,您有一个友好的小型机器人,您想教它在家里完成一些任务,例如煮咖啡或打扫卫生。您使用简单的命令并且效果很好。

现在,您决定将同一个机器人放入一个巨大的工厂中,并希望它控制复杂的机械。

问题是,您在家里使用的命令在工厂中不起作用。你需要给机器人更精确、更详细的指令。你必须微调与它沟通的方式。

如何克服提示词微调的挑战

1. 简化复杂的提示

确定核心请求:首先确定您想要提出的主要问题或请求。您需要从模型中获得的最关键的信息或操作是什么?

将其分解:如果您的初始提示包含多个部分或请求,请将其分解为较小的、集中的组件。每个组件应该解决一个特定的问题或任务。

确定信息的优先级:确定哪些信息最重要,哪些信息次要。重点关注提示中的基本细节。

使用清晰的语言:避免行话、模棱两可的术语或过于技术性的语言。使用任何人都能理解的清晰、直接的语言。

删除不必要的信息:删除任何不必要的背景、背景或不直接影响核心请求的细节。

重组提示:将简化的组件重新组织为清晰简洁的提示。您可能需要使用项目符号或编号列表来分隔不同的问题或任务。

避免双重否定:避免在提示中使用双重否定或复杂否定。他们可能会混淆模型。相反,使用积极的语言来表达你想要什么。

指定约束:如果您有特定的约束,例如避免某些主题或引用,请在提示中明确说明。

提供上下文:如果上下文很重要,请将其包含在提示中。这有助于模型了解您请求的具体情况或背景。

测试清晰度:在提交提示之前,请其他人检查它以确保其清晰易懂。如果他们有疑问,则可能表明提示需要进一步简化。

避免过长的提示:保持提示简洁。冗长、复杂的提示可能会使模型感到困惑。如有必要,请针对请求的不同方面提交单独的提示。

来源

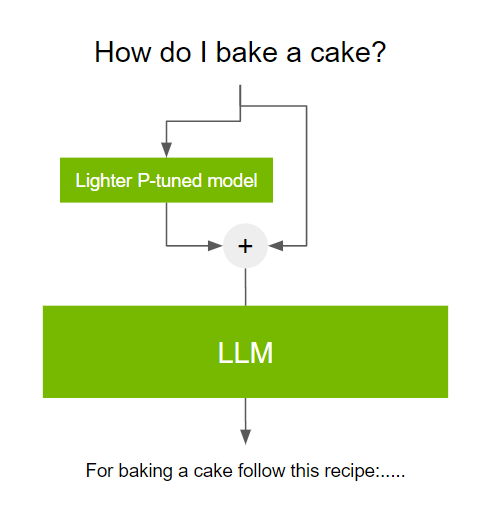

NVIDIA描述了提示词微调的过程如下。

提示词微调涉及在使用LLM之前使用小型可训练模型。小模型用于对文本提示进行编码并生成特定于任务的虚拟令牌。

软提示

软提示是一种告诉大型语言模型 (LLM) 做什么的方法,但无需使用任何文字。相反,LLM接受一组示例的培训,然后学习识别这些示例中的模式。然后使用这些模式创建一个软提示,它是代表这些模式的一串数字。

软提示比硬提示(基于文本的提示)更能有效地指导 LLM 执行所需的任务。然而,软提示是不可解释的,这意味着很难理解为什么LLM选择了它所选择的特定软提示。

尽管存在这一缺点,软提示仍然是使LLM适应新任务的强大工具,特别是对于可用训练数据有限的任务。

以下是如何使用软提示的示例:

想象一下,您想培训一名LLM写诗。您可以首先为LLM提供一组示例诗歌。然后,LLM将学习识别这些诗歌中的模式,例如韵律、韵律和主题。

一旦LLM学习了示例诗歌中的模式,您就可以通过从示例中提取模式来创建软提示。这种软提示可以用来指导LLM写自己的诗。

LLM将无法阅读软提示,但它能够识别软提示中的模式并使用这些模式生成创意文本。

上述示例的软提示的格式可以是一串数字,代表示例诗歌的韵律方案、韵律和主题。例如,可以使用以下软提示来指导法学硕士写一首关于爱情的诗:

[ABAB rhyme scheme], [iambic tetrameter], [love]这个软提示告诉LLM用ABAB韵律、抑扬格四音步写一首关于爱的主题的诗。

新的 PeFT 优化技术!

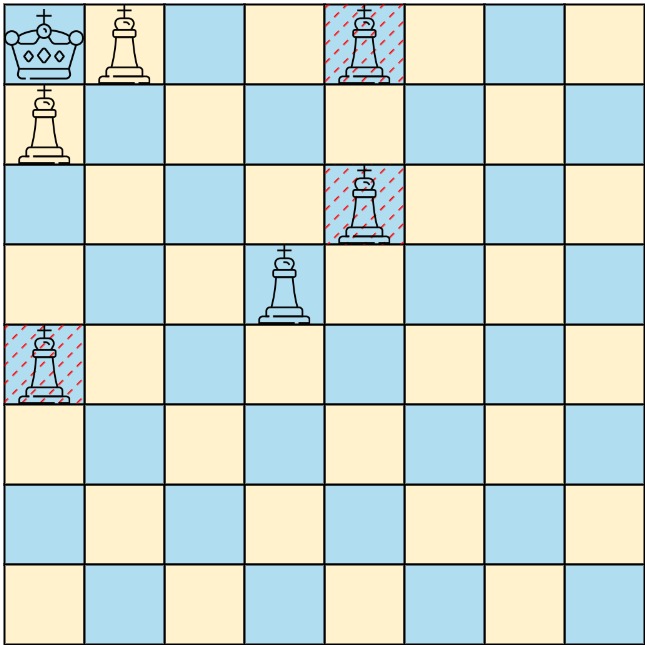

在下游任务上对 GPT-3 等大型语言模型 (LLM) 进行微调已导致自然语言处理领域取得重大进展。然而,完全微调需要更新模型的所有参数,这在计算上是昂贵的。参数高效微调(PEFT)方法通过仅更新每个任务的一小部分参数来解决这个问题。

PEFT

P-tuning 以定制 LLM

为下游任务微调大型语言模型具有挑战性,因为它们有太多参数。要解决此问题,您可以使用提示将模型引导至特定的下游任务,而无需完全微调模型。通常,这些提示是手工制作的,这可能不切实际,因为您需要非常大的验证集才能找到最佳提示。P-tuning是一种在连续空间中自动搜索和优化以获得更好提示的方法。

来源

P-tuning,或者说 prompt tuning, 是一种参数高效的调优技术,可以解决这个挑战。P-tuning 涉及在使用 LLM 之前使用小型可训练模型。小模型用于对文本提示进行编码并生成特定于任务的虚拟令牌。

结论

Prompt tuning是使大型语言模型 (LLM) 在特定任务上表现更好的一种方法。这是一个高效且简化的过程,涉及创建软提示以与静态预训练的LLM进行交互。

当LLM获得背景信息时,他们的表现会更好。软提示是一种为LLM即时提供背景信息的方法。这意味着快速调整可用于快速、轻松地使LLM适应新任务。

然而,提示词微调并非没有挑战。理解软提示的工作原理可能很困难,这使得对LLM的表现进行基准测试和测试变得困难。当对提示进行微小更改时尤其如此。

克服这些挑战的一种方法是使用向量数据库、代理和提示管道在正确的时间为LLM提供相关的上下文数据。这些方法的效率低于即时调整,但它们更加透明和可解释。这使得它们对需要能够微调和扩展LLM的组织更具吸引力。

简而言之,提示词微调是提高LLM在特定任务上的表现的强大工具。然而,重要的是要意识到与及时调整相关的挑战,例如缺乏透明度和可解释性。需要能够微调和扩展LLM的组织可能需要考虑使用其他方法,例如向量数据库、代理和提示管道。