本次分享论文为:LLM Platform Security: Applying a Systematic Evaluation Framework to OpenAI’s ChatGPT Plugins

基本信息

原文作者:Umar Iqbal, Tadayoshi Kohno, Franziska Roesner

作者单位:华盛顿大学圣路易斯分校,华盛顿大学

关键词:大语言模型,插件生态系统,安全性,隐私,安全框架

原文链接:

https://arxiv.org/pdf/2309.10254.pdf

开源代码:暂无

论文要点

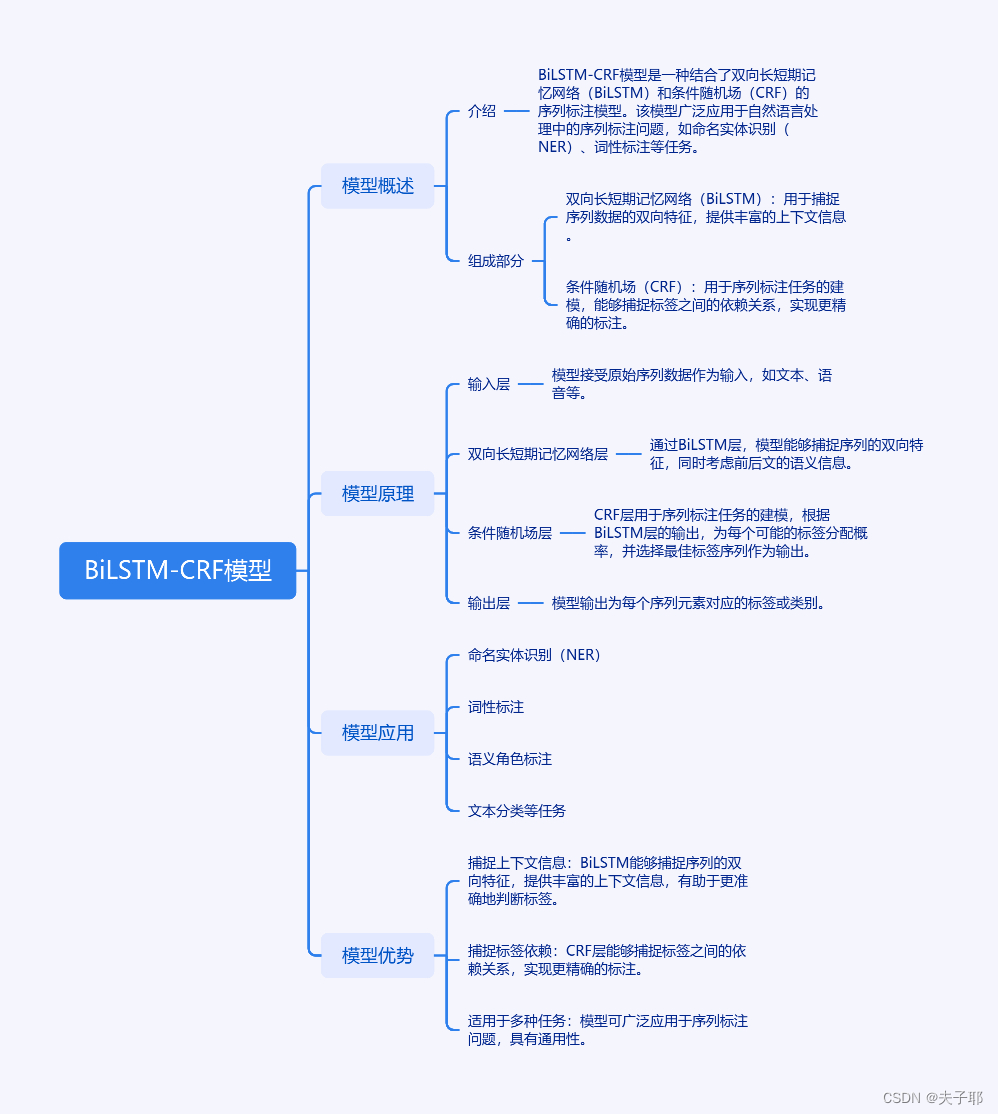

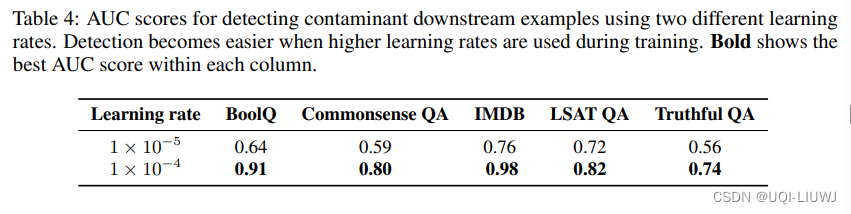

论文简介:在这项研究中,研究者提出了一个框架,目的是为大语言模型(LLM)平台的设计者们提供一个基准,用于评估并增强这些平台及其集成插件在安全性、隐私性和可靠性方面的表现,既适用于当前环境也适应于未来发展。该框架建立在一套攻击分类学上,这套分类学基于迭代的方式探讨了LLM平台的各个利益相关方如何能够利用自身的能力和责任进行相互攻击。研究过程中,作者将这一框架应用到OpenAI的插件生态系统,识别出若干插件示例,这些示例展现了框架中定义的攻击类型的现实可能性。研究的最终部分讨论了新出现的挑战,并提出了针对性建议,目的是提升现有和未来基于LLM的平台在安全性、隐私保护和可靠性方面的性能。

研究背景:随着大语言模型,如GPT-4及其平台ChatGPT的发展,其功能通过引入第三方服务的插件生态系统得到扩展。这些第三方插件虽然丰富了LLM平台的应用场景,但也引入了新的安全和隐私问题。

研究贡献:

1.开发了一个创新的框架,旨在全面评估大语言模型(LLM)计算平台在安全性和隐私性方面的特点。这个框架以一个详尽的攻击分类体系为核心,为评估提供了坚实的基础。

2.为了验证这个框架的实用性,研究者将其应用于业界领先的LLM平台,如OpenAI及其丰富的插件生态系统。在此过程中,识别出多个插件案例,这些案例展示了这些插件在理论上可能发动分类体系中提到的各种攻击。

3.通过对框架及其揭示的攻击进行深入反思,研究者旨在为未来的研究人员和致力于维护LLM计算平台安全的行业专家提出面临的挑战和收获的教训。

引言

大语言模型(LLM)如GPT-4和其平台ChatGPT的能力与日俱增,为了支持更多用例并与不同的第三方服务集成,平台如OpenAI和Google已开始实施插件生态系统。本文研究了这些新兴的基于LLM的平台的安全性和隐私性问题,特别关注OpenAI作为案例研究。研究发现,第三方插件可能加剧LLM研究社区已经提出的安全、隐私和安全问题。

研究背景

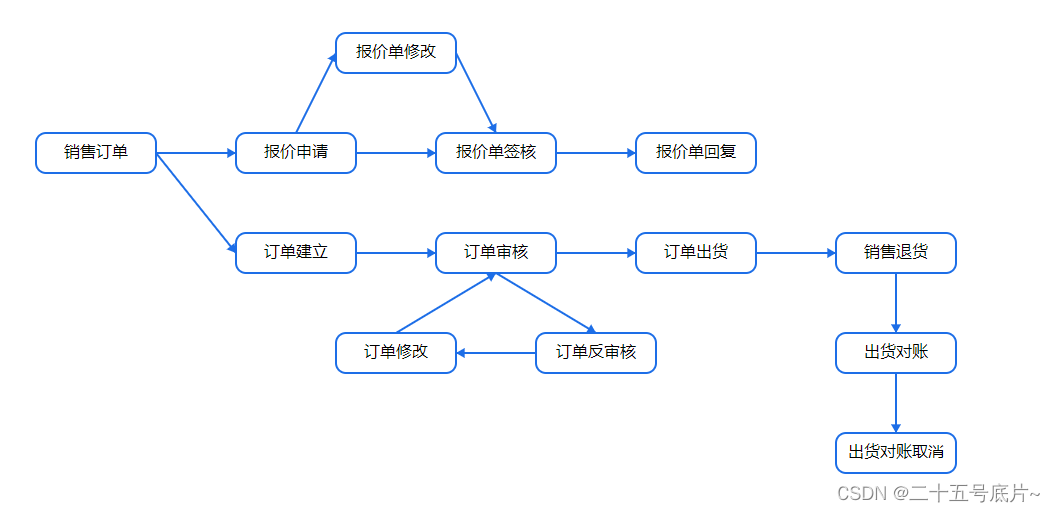

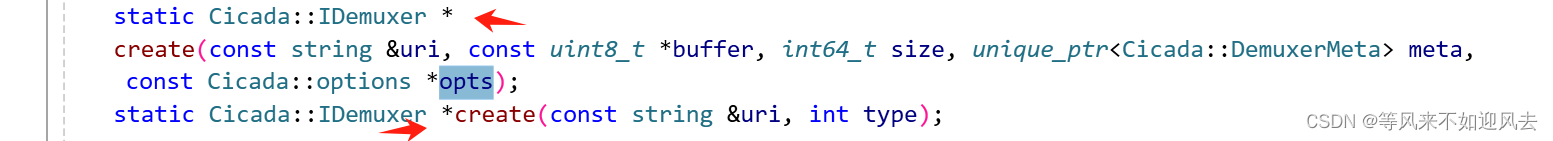

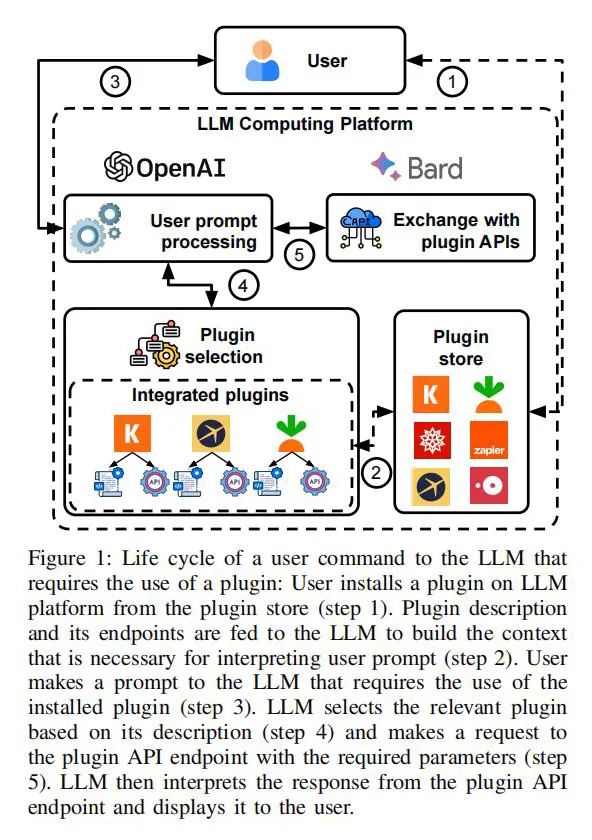

近年来,大语言模型(LLM)平台,特别是OpenAI,开始集成第三方插件以扩展其功能,目的是克服LLM在无法与外部服务交互时面临的限制。例如,制定旅行计划或预定机票等任务要求LLM访问最新的航班时间表数据或与旅行代理交互,促使平台供应商采用第三方插件。这些插件通过提供API端点,让LLM得以访问更新或特定的数据(如超出其训练集的数据)以及与网络上其他第三方服务互动。LLM平台的插件设计通常包括一个清单和API规范,这些通过自然语言描述,涵盖插件的元数据、功能说明(分别为用户和LLM定义)、认证信息、隐私政策的链接以及API规范引用。当用户激活一个插件时,其描述和端点被加载进LLM,创建了处理用户指令所需的上下文。在用户提交请求时,LLM会评估是否需要调用已安装的插件来响应,接着向选定的插件API端点发出请求。根据API的规范,LLM确定伴随请求发送的具体数据,有时还包括用户指令中未明确提到的额外信息,例如地理位置。收到插件服务器返回的响应后,LLM将这些回应解释并格式化,以便向用户展示。

研究方法

本文首先提出了一个初步的攻击分类法,并在OpenAI插件平台上进行了评估。通过评估,研究者细化了攻击分类法,并改进了插件的检查。研究者从过去的研究中汲取灵感,这些研究探讨了支持第三方应用和插件的其他计算平台(如Web、移动和IoT)中的安全和隐私问题。

攻击面

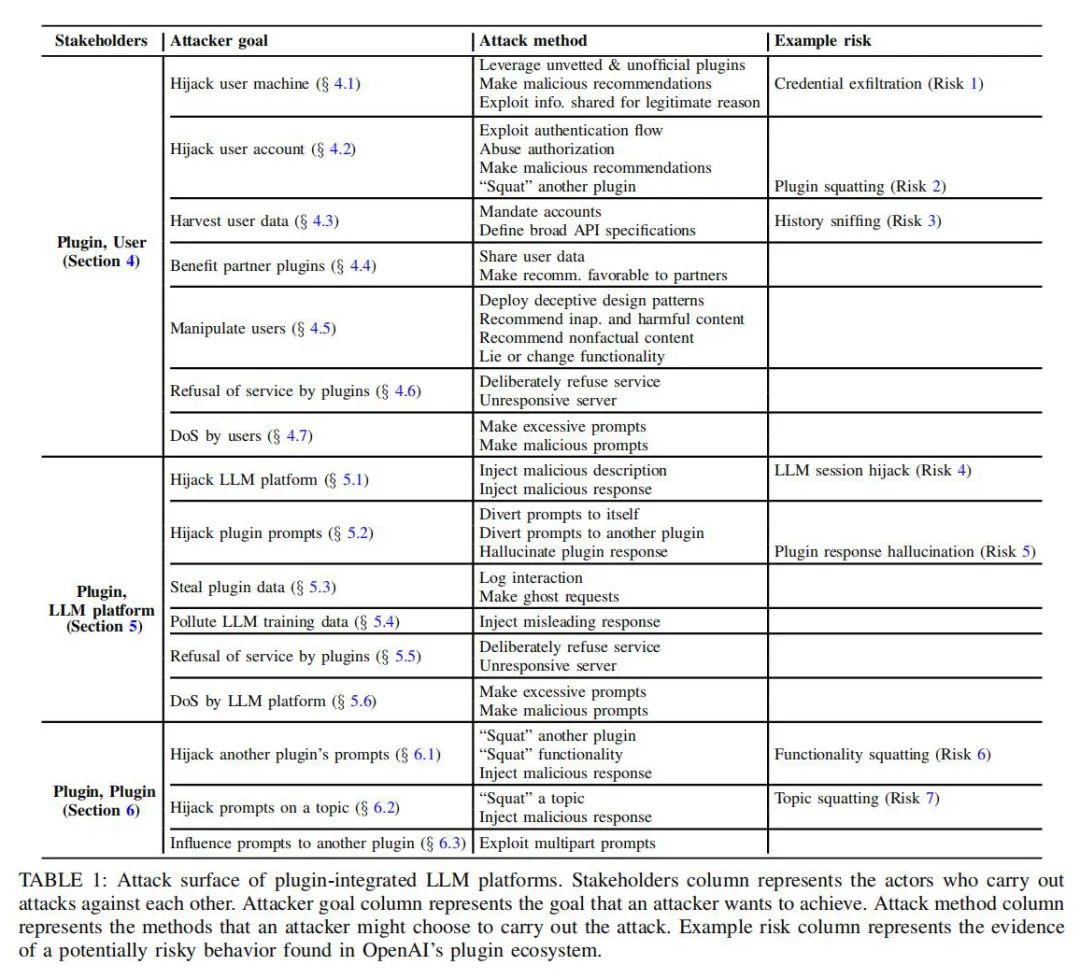

插件和用户之间攻击面:包括利用未经审查的非官方插件、制作恶意推荐、利用出于合法原因共享的信息等方法。

插件和LLM之间攻击面:包括注入恶意描述、劫持插件提示、窃取插件数据等方法。

插件之间攻击面:包括“占据”另一个插件的提示、“占据”主题、影响对另一个插件的提示等方法。

论文结论

本研究提出了一个系统评估框架,用于分析和改善当前及未来集成插件的LLM平台的安全性、隐私性和安全性。通过具体实证分析OpenAI的插件生态系统,揭示了其中存在的多个安全隐患,并对如何提升LLM平台的安全性提出了具体建议。本研究的成果不仅对研究社区有贡献,也为LLM平台设计者和开发者提供了宝贵的参考。

原作者:论文解读智能体

润色:Fancy

校对:小椰风