论文1 【Evaluating Object Hallucination in Large Vision-Language Models】

这篇文章主要是评价视觉-语言模型中出现“幻觉”的评价。论文中是这样定义幻觉的

we find that LVLMs suffer from the hallucination problem, i.e., they tend to generate objects that are inconsistent with the target images in the descriptions

即,LVLM(Large Vision-Language Models)倾向于生成与描述中的目标图像不一致的对象。

Motivation

- 视觉指令对幻觉的影响,发现:在视觉指令中频繁出现或与图像中对象经常共同出现的对象,容易让LVLM产生幻觉

- 现有的评估方法可能会受到LVLM的输入指令和生成风格的影响

Methods

本文提出了Polling-based Object Probing Evaluation(POPE,基于轮询的对象探测评估)。

- 问题设置

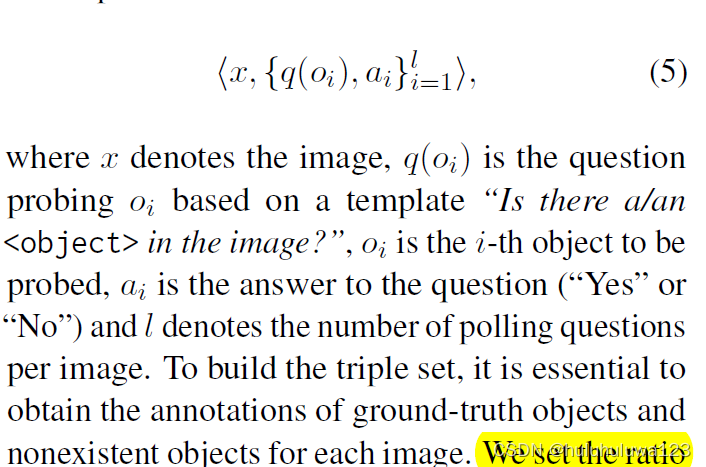

{图像,问题,答案}三元组的形式。- 问题的形式:“Is there a/an in the image?”。对于一幅图,会问多个物体,Oi表示问的第i个物体。object选取规则是图片中存在的物体和图片中不存在的物品都选,选取的比例是1:1

- 答案:“Yes” 或者 “No”

图片种不存在的object的选取方式

在选择图片中不存在的物品时,有3种方式“Random Sampling”、“Popular Sampling”和“Adversarial Sampling”。

- Random Sampling 随机采样图像中不存在的对象

- Popular Sampling 数据集中top-k的类别,且没有在图片中出现的物品

- Adversarial Sampling 先对数据集中最常出现的物品对进行排序,选出与图片中物品经常一起出现的前K中物品

最后在用几种LVLM测试,Random Sampling > Popular Sampling > Adversarial Sampling

一些讨论

- 本文只讨论了LVLM幻觉的问题。模型在幻觉问题上表现得好,并不代表在其他问题上也表现得好

- 仅仅测试了部分数据,模型的表现与数据分布有关

- 模型只回答“Yes”或“No”,容易评价不准确

- 受标注工具的标签集影响

- 仅仅对比了几个开源模型