今天凌晨,OpenAI又双缀缀发大招了,直接放出新的模型–GPT-4o,并号称可以实时对音频、视觉和文本进行推理。现场直播效果非常炸裂,能听、说、看,而且几乎没有延迟。

在GPT-4o出来以前,GPT也有语音对话功能,然而使用的体验并不好。以前语音的处理过程大概如下:用户输入语音—>转换为文本—>GPT理解文本并输出回答—>回答内容转换成语音播放,整个转换流程下来,基本耗时都在2s以上,而且不能输出语气、停顿等非语言信息。GPT-4o则是跨文本、视觉和音频端到端训练的新模型,这意味着所有输入和输出都由同一个神经网络处理。它可以通过摄像头实时识别用户环境中的内容,甚至跟你一起玩石头剪刀布。说到这个,就让我不得不想起Google Gemini发布时的宣传视频。OpenAI可能也考虑到这个,特意加了一句话:

“此页面上的所有视频均为 1 倍速实时”

鉴于Google I/O大会将在5月15日凌晨召开,OpenAI却选择这个时候放大招,很难说两者没有什么关系。

OpenAI:没有的事,只是巧合(包括上次的Sora)

GPT-4o真正厉害的地方在于互动性的全面提升,以前的GPT模型已经在智能的方面走了很远,但在与人互动方面还差点意思。就像我们平时人与人之间的对话,经常有打断情况,语气的不同会表示不同的意思等等,GPT-4o很好地解决这些问题,能清晰表达情感,对话延迟低,让AI更像人一样了。

GPT-4o后面那个o表示“omni”,意思是“全能的”、“全面的”。据说就是之前在大模型竞技场搞A/B测试的模型之一,im-also-a-good-gpt2-chatbot。

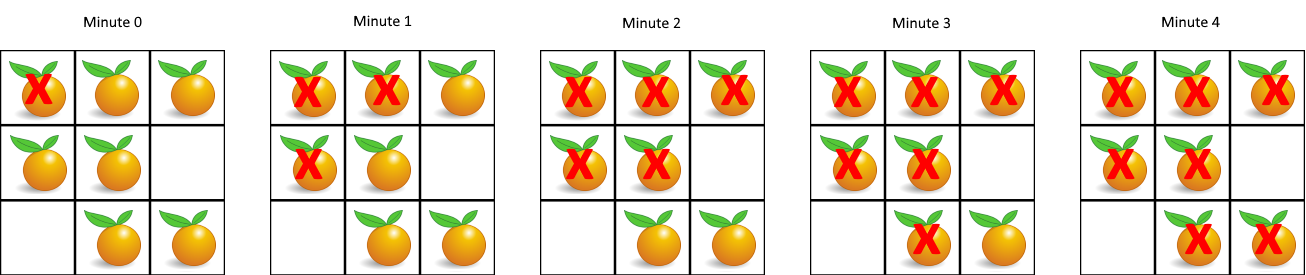

下面是文本评价得分对比:

以及视觉理解评估:

这里可以看出GPT-4o的视觉理解评分都要强于其他模型。

当然对于用户来说,最关心的还是GPT-4o的定价问题。OpenAI在发布会上明确说明了GPT-4o将免费提供给所有人使用,是的,你没看错,就是免费。

ChatGPT免费用户可以访问新模型加持下的功能,包括:

- 体验GPT-4级别的智能

- 从联网后的模型得到响应

- 分析数据并创建图表

- 畅聊你拍的照片

- 上传文件以帮助总结、撰写或分析

- 发现和使用GPTs和GPT Store

- 用记忆构建更有用的体验

当然在使用额度上,Plus会员是免费的5倍。还有API方面,GPT-4o相较于GPT-4 Turbo,推理速度提升2倍,消息限制提高五倍,而且价格还会降低50%,可以说相当良心了。

而且,为了真正实现「让AGI惠及全人类」的愿景,GPT-4o有50种语言的版本,并改进了推理的质量和速度,这也就意味着,全球97%的人口都可以使用GPT-4o了!

GPT-4o有50种语言的版本,并改进了推理的质量和速度,这也就意味着,全球97%的人口都可以使用GPT-4o了!

如果你想升级到ChatGPT 4.0,请看我的另一篇教程:【GPT4.0】怎样才能使用GPT4.0?如何升级GPT4.0?