从 5 月初爆出将在 9 日发布搜索引擎;到 5 月 11 日,官宣将在当地时间 5 月 13 日 10 时发布 ChatGPT 与 GPT-4 更新;再到 Sam Altman 亲自下场辟谣「不是 GPT-5,也不是搜索引擎」,而是「像魔法一样的新东西」;随后,网友开始通过各种蛛丝马迹深挖其发布内容,最终 GPT-4.5 和 ChatGPT 的通话功能成为热门候选。

最初,有网友调侃 Sam Altman 此举是准备和 Google I/O 大会抢风头,但对比 Gemini 1.5 和 Sora 的对决,如果没点「硬货」,Altman 恐怕也不愿铤而走险在谷歌年度大会的前一天发布更新。

事实也的确如此,OpenAI 这一次看似临时攒局的线上直播发布会,实则有备而来。

本次 OpenAI spring updates 未见 Sam Altman 的身影,而是由公司的 CTO Muri Murati 带来了一系列更新,包括了:

-

GPT-4o

-

ChatGPT 的语音交互功能

-

ChatGPT 的视觉能力

点击链接即可查看完整直播回放:

【中字】OpenAI Spring Updates 春季更新大会|官宣旗舰模型 GPT-4o!完全免费!实时交流!

GPT-4o:语音 buff 加持,所有用户免费使用

自 2023 年 3 月发布以来,GPT-4 霸榜已久,只要有新模型发布,便会被搬出山来进行一番对比,这也足以证明其性能之强大。此外,GPT-4 也是 OpenAI 现阶段极具商业价值的「摇钱树」,屡屡被马斯克炮轰「不 Open」。

更重要的是,面对 Meta 开源的 Llama、谷歌开源的 Gemma、马斯克开源的 Grok,基于 GPT-3.5 的免费版 ChatGPT 压力倍增。而在 GPT-5 迟迟没有露面之际,不少网友都猜测,OpenAI 会释放出新版本的 GPT-4 来接替 GPT-3.5。

不出所望,在今天的直播中,OpenAI 发布了新版本 GPT-4o,所有用户都可以免费使用,付费用户将拥有 5 倍于免费用户的容量限制。其中的 「o」表示「omni」,寓意着向更自然的人机交互迈进。

OpenAI CTO Muri Murati 介绍道,GPT-4o 提供了 GPT-4 级别的 AI 能力,能够基于语音、文字和视觉进行推理。其接受文本、音频和图像的任意组合输入,并能够生成文本、音频和图像的任意组合输出。

点击链接查看 GPT-4o 演示视频:

https://www.bilibili.com/video/BV1PH4y137ch

在 GPT-4o 之前,使用语音模式与 ChatGPT 对话的平均延迟时间为 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。为优化交互体验,OpenAI 在文本、视觉和音频方面训练了一个端到端新模型,这意味着所有输入和输出都由同一个神经网络处理,从而减少了信息丢失。

性能方面,GPT-4o 能在 232 毫秒内对音频输入做出反应,平均反应时间为 320 毫秒,这与人类在对话中的反应时间相近。此外,GPT-4o 在英语和代码文本方面的性能与 GPT-4 Turbo 相当,在非英语语言文本方面也有显著提高,改进了 50 种不同语言的质量和识别速度。同时,在 API 方面速度是原来的 2 倍,但价格却便宜 50%。

此外,GPT-4o 的推理能力也有大幅提升,官方数据表示,GPT-4o 在 0-shot COT MMLU(常识题)中创造了 88.7% 的新高分。

OpenAI 的 William Fedus 晒出了 GPT-4o 在 LMSys 榜单上的排名情况,团队给 GPT-4o 的命名也很有意思:im-also-a-good-gpt2-chatbot。

他还介绍道,在更难的提示集上、尤其是在编码能力上,GPT-4o 的水平比 OpenAI 此前最先进的大模型高出 +100 ELO。

William Fedus 直言,GPT-4o 不仅是世界上最好的模型,而且在 ChatGPT 中免费提供,这在前沿模型中开辟了先例。

在某种程度上,GPT-4o 可以看作是 OpenAI 对于其「开源」产品的更新,而对于外界屡次诟病的「OpenAI 不 Open」,Sam Altman 也在其 blog 中表示:「OpenAI 的使命之一就是免费(或以优惠价格)向人们提供功能强大的人工智能工具。我感到非常自豪的是,我们在 ChatGPT 中免费提供了世界上最好的模型,没有广告或类似的东西。」

对于 GPT-4o 的性能,Sam Altman 也毫不吝啬赞美之词:「新的语音(和视频)模式是我用过的最好的计算界面。它给人的感觉就像电影中的人工智能;而它的真实性仍然让我感到有些惊讶,其中的一个重要变化便是达到人类水平的响应时间和表现力。」

随后,Altman 还在其账号发布了「her」,也暗示了自己新版模型将开启「Her 时代」。

值得注意的是,GPT-4o API 中并没有为所有客户提供语音功能。

OpenAI 表示,GPT-4o 通过过滤训练数据和后期训练完善模型行为 (refining the model’s behavior through post-training) 等技术,在设计中就考虑到了各种模式的安全性,团队还创建了新的安全系统,从而为语音输出提供保护。

尽管如此,OpenAI 还是以滥用风险为由表示,计划在未来几周内首先向 「一小部分可信赖的合作伙伴」推出对 GPT-4o 的新音频与视频功能。

而 GPT-4o 的文本和图像功能今天开始便会在 ChatGPT 中推出。未来几周,OpenAI 将在 ChatGPT Plus 中推出带有 GPT-4o 的新版语音模式 alpha。开发人员现在也可以在 API 中以文本和视觉模式访问 GPT-4o。

Her 时代来了:ChatGPT 有感情的语音交互

早在今年 2 月,前 OpenAI 开发者关系负责人就提及,ChatGPT 的终极形态不仅仅是聊天。

5 月 11 日,Sam Altman 也在一档播客节目中称,OpenAI 将继续改进并提升 ChatGPT 的语音功能质量,并表示语音交互是通向未来交互方式的一个重要途径。

在今天的发布会上,OpenAI 也展示了其提升 ChatGPT 语音质量的阶段性成果——基于 GPT-4o 实现了语音交互,且响应速度大幅提升。

具体而言,ChatGPT 的升级更新主要体现在三个方面——实时交互、多模态输入输出、感知情绪。

在实时交互方面,在现场演示中,ChatGPT 几乎可以即时回应提问者的所有问题,提问者如果出言打断 ChatGPT 的回答,其也能够停下来。Muri Murati 还应现场观众的要求,展示了 GPT-4o 的实时翻译功能。

多模态输入/输出则无需赘述,基于 GPT-4o 的 ChatGPT 能够识别文本、语音与视觉信息,并根据需求以任一形式进行回答。

在感知情绪与情绪反馈方面,升级后的 ChatGPT 能够根据人物自拍照,快速分析人物的面部情绪。同时还可以根据对话者的要求调整说话时的语气,从夸张戏剧到冰冷机械,甚至还可以唱歌,这展示了其出色的可塑性。

对此,Muri Murati 表示:「我们知道这些模型越来越复杂,但我们希望交互体验变得更自然、更简单,让你完全不用关注用户界面,而只关注与 GPT 的协作,这一点非常重要。」

此外,在推理分析方面,GPT-4o 还改进了 ChatGPT 的视觉功能。给它一张拍摄的照片,ChatGPT 可以快速浏览图片的内容并回答相关问题,比如拍照解决数学问题。

还可以根据分享的代码图片描述代码的具体内容,分析假若改变代码其中的一个变量,将会产生什么具体影响。

给 GPT-4o 一个图表,它还能够对图表的内容进行具体分析。

OpenAI 的这一创新尝试将 ChatGPT 的应用横跨语音、文本和视觉,这预示着未来人机交互可能会更加自然和流畅。

对此,OpenAI 表示,具有视觉和音频功能的 AI 语音助手具有像智能手机一样的变革性潜力,理论上它可以做到一系列现在的 AI 助手无法做到的事,比如充当论文、数学指导老师,或是翻译交通标识、帮助解决汽车故障等。

写在最后

从 GPT 横空出世以来,OpenAI 一度被视为大模型时代的「风向标」。细数硅谷的传统巨头:

- 微软与 OpenAI 的关系微妙,既是金主投资人,也在自家业务中部署了 GPT 模型,同时还为 OpenAI 提供云服务;

- 苹果今年开始在生成式 AI 上加大投入,并发布了自研大模型,但起步稍晚,能否撼动 OpenAI 地位仍未可知,同时还有爆料称苹果已经要和 OpenAI、谷歌在大模型上进行合作;

- 亚马逊作为全球最大的云基础设施提供商,虽然也推出了自家的大模型 Amazon Titan,但这只是其云托管服务 Bedrock 的一部分,尽管亚马逊还投资了 Anthropic,但目前看来还是难与 OpenAI 抗衡。

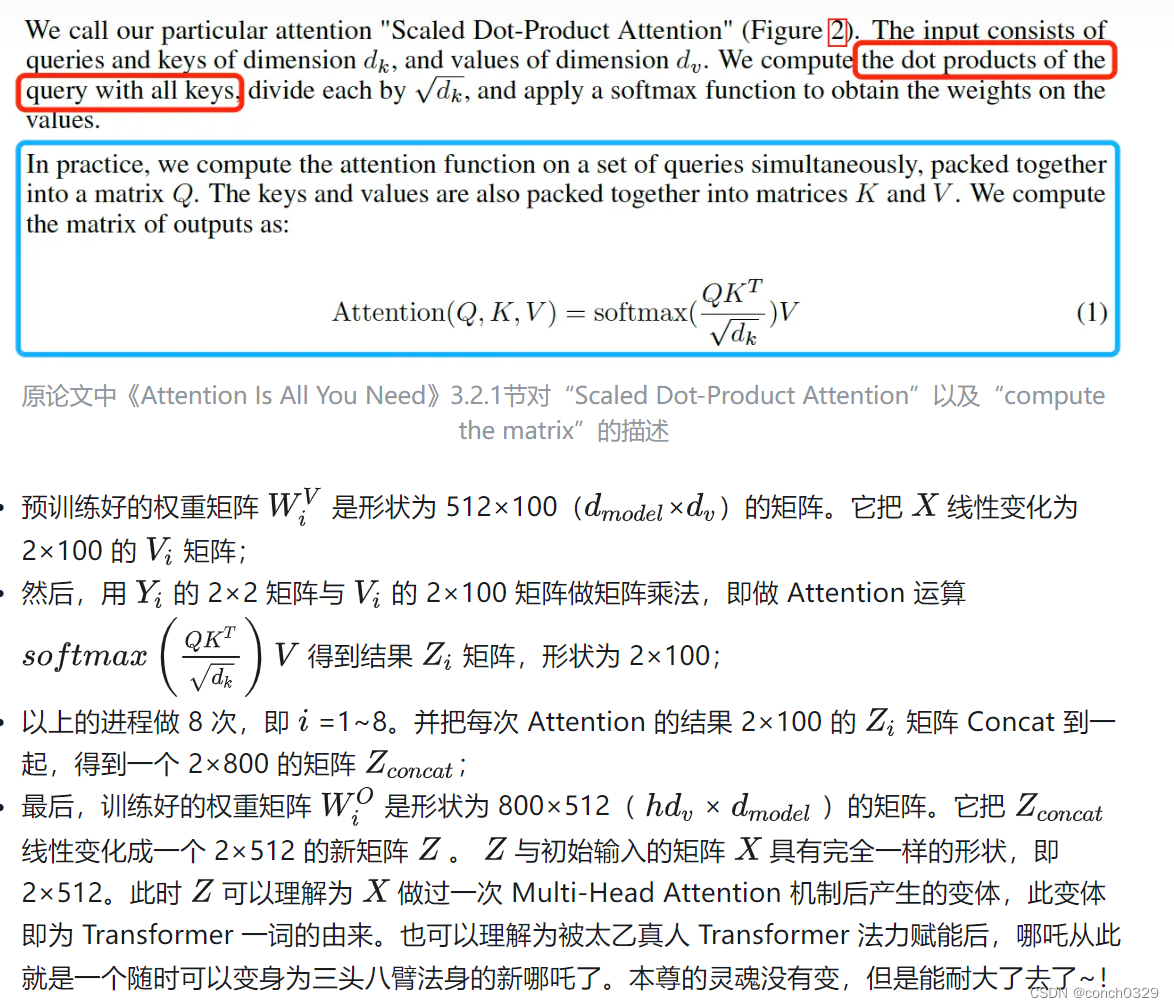

一番对比,谷歌似乎是最有希望和 OpenAI 掰掰手腕的企业,不仅有深厚的技术积累(Transformer 架构便是出自谷歌),还有丰富的生态供大模型一展拳脚。

然而,关注谷歌的读者或许能够发现,这位老牌巨头在大模型时代有点「汪峰」体质了(狗头保命)——从 Bard、PaLM 2 在性能上不及 GPT-4,到颠覆巨作 Gemini 1.5 发布被 Sora 抢热度,再到 3 月就定档的 Google I/O 大会在最佳造势期被 OpenAI 的一个「临时起意」的直播抢风头……

就在今天(5 月 14 日)凌晨,OpenAI 祭出了「世界上最好的模型」,不知道劈柴哥看了今天的发布会,会不会连夜「改剧本」?

答案将在明天凌晨揭晓,期待谷歌能打一场「翻身仗」,HyperAI超神经也将持续带来一手报道!