今天OpenAI发布了gpt-4o,我体验之后,gpt-4o简直逆天了。中文能力也挺别强。速度比现在的gpt4还要快。

早在 5 月 11 日,Sam 就在推文中表示:OpenAI 并没有推出 GPT-5,或搜索引擎,但团队一直在努力研发一些认为大家会喜欢的新东西(感觉就像是魔法一样)!

添加图片注释,不超过 140 字(可选)

现在来看应该说的就是 GPT-4o 了,它在免费和付费账户中均可使用(应该是目前最强的免费模型了)。除此之外,ChatGPT 页面也进行了许多细节方面的优化,并且推出了桌面应用,进一步提升用户体验。

一、什么是GPT-4o

GPT-4o(“o”代表“omni”)是 OpenAI 在实现更自然人机交互方面的重要进展(Hello GPT-4o[1])。它能够接受文本、音频和图像的任意组合输入,并生成相应的输出,包括文本、音频和图像。该模型在音频输入的响应时间非常短,最短可达 232 毫秒,平均为 320 毫秒,接近人类对话的反应时间。在文本(英语)和代码方面,GPT-4o 的表现与 GPT-4 Turbo 相当,但在处理非英语语言文本方面有显著提升,同时在 API 中的速度更快且成本降低 50%。此外,GPT-4o 在视觉和音频理解方面表现尤为出色。

在 GPT-4o 之前,使用语音模式与 ChatGPT 对话的平均延迟时间分别为 GPT-3.5 的 2.8 秒和 GPT-4 的 5.4 秒。实现这一功能的流水线涉及三个独立模型(音频 → 文本 → 音频):一个用于将音频转录为文本,GPT-3.5 或 GPT-4 处理文本并生成文本,然后第三个模型将文本转换回音频。这种方式导致 GPT-4 无法直接感知语调、多位说话者或背景噪音,也无法生成笑声、歌唱或表达情感。

为了克服这些局限,OpenAI 训练了一个新的端到端跨文本、视觉和音频的单一模型(GPT-4o),这意味着所有输入和输出都由同一个神经网络处理。由于这是 OpenAI 第一个结合所有这些模态的模型,因此其功能和局限性仍在探索中。

它将首先在 ChatGPT 和 API 中作为文本和视觉模型提供(ChatGPT 将继续通过现有的语音模式功能支持语音)。具体来说,GPT-4o 将在 ChatGPT 免费版、Plus 版和团队版(企业版即将推出)以及 Chat Completions API、Assistants API 和 Batch API 中提供。

二、GPT-4o vs GPT-4 Turbo 的区别

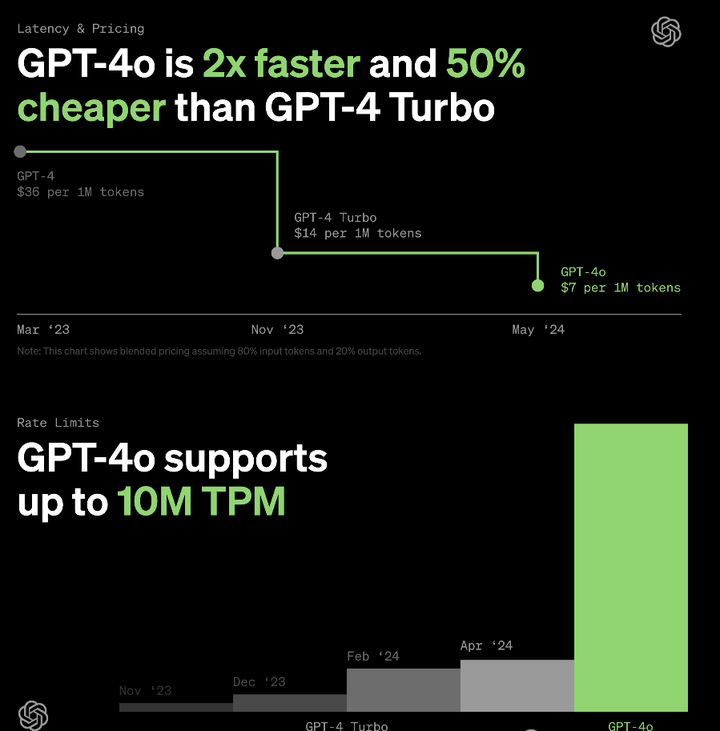

GPT-4o 拥有相同的高智能性,但比 GPT-4 Turbo 更快、更便宜,且速率限制更高。具体来说:

-

价格:GPT-4o 比 GPT-4 Turbo 便宜 50%,输入每百万 tokens 收费 $5,输出每百万 tokens 收费 $15。

-

速率限制:GPT-4o 的速率限制是 GPT-4 Turbo 的 5 倍——每分钟最多 1000 万 tokens。

-

速度:GPT-4o 是 GPT-4 Turbo 的两倍快。

-

视觉:在视觉能力相关评估中,GPT-4o 的表现优于 GPT-4 Turbo。

-

多语言:GPT-4o 对非英语语言的支持优于 GPT-4 Turbo。

GPT-4o 目前有 128k 的上下文窗口,知识截止日期为 2023 年 10 月。

添加图片注释,不超过 140 字(可选)

(1)ChatGPT 免费版

免费版用户将默认使用 GPT-4o,并限制使用 GPT-4o 发送消息的数量,这取决于当前的使用情况和需求。当不可用时,免费版用户将自动切换回 GPT-3.5。还可以有限地使用高级工具发送消息,例如:

-

数据分析(Data analysis)

-

文件上传(File Uploads)

-

联网(Browse)

-

发现和使用 GPTs(Discovering and using GPTs)

-

视觉(Vision)

GPT-4o 具有先进的视觉能力,能够更准确地理解你共享的图像,免费版用户随时可以点击 ChatGPT Plus 按钮来升级。

如果无法升级,或者不知道怎么升级Plus的用户,可以参考GPT4的升级方法:教程传送大门

(2)LLM基准测试区别

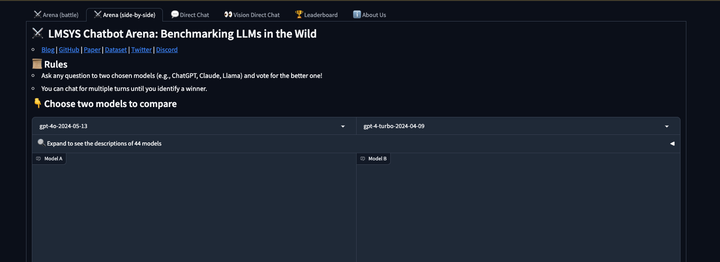

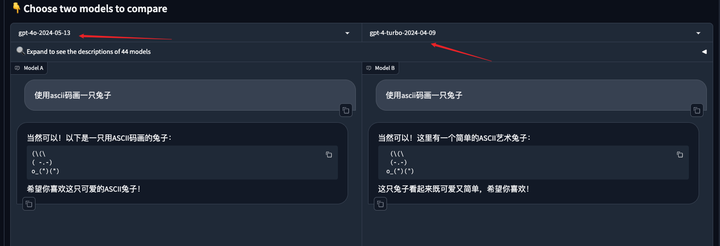

可以到竞技场去测试GPT-4o 和 GPT-4 turbo两者到区别。另外竞技场是可以直接免费体验GPT-4o的地方。但是有次数限制。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

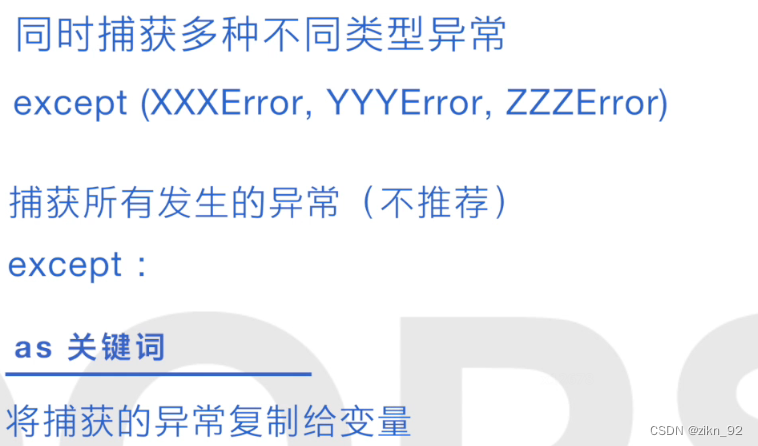

(3)通过申请Open API接口

通过Open API的接口,接入接口后,也可以快速的使用gpt-4o,前提你已经有了chatgpt账号。