ICML 2023

paper

code

紧接上一篇MAMBA,本文在同种问题设定下的在线模仿学习方法。

Intro

文章提出了一种新的模仿学习算法,名为 MAPS(Max-aggregation Active Policy Selection)和其变体 MAPS-SE(Max-aggregation Active Policy Selection with Active State Exploration),用于从多个次优的黑盒专家(oracle)中进行策略改进。这些专家在所有状态下并不总是相互超越,这就带来了一个挑战:如何主动决定使用哪个oracle,以及在哪个状态下使用。

文章的主要贡献包括:

- 提出了 MAPS 和 MAPS-SE 算法,它们通过主动选择要模仿的oracle并改进它们的价值函数估计来执行模仿学习。

- MAPS-SE 算法额外利用了一个主动状态探索标准,根据其状态值的不确定性来决定应该探索哪些状态。

- 提供了对 MAPS 和 MAPS-SE 的全面理论分析,并证明了它们在样本效率方面比现有的策略改进算法有优势。

- 通过在 DeepMind Control Suite 中的广泛控制任务上的实验,展示了 MAPS-SE 如何通过从多个 oracle 进行状态模仿学习显著加速策略优化。

Method

首先采用和MAMBA相同的对max-aggregations baseline的定义

MAMBA一个主要的问题其高样本复杂度。MAMBA 基于 f ^ max \hat{f}^{\max} f^max 估计策略梯度,并且策略随机均匀地采样oracle,导致算法需要长时间的episode识别给定状态的最佳oracle,因为它的策略是在随机均匀地采样预言机。因此,MAMBA 容易出现大量误差累积。此外,MAMBA 在选择状态进行roll-out时没有控制梯度估计的逼近误差。因此,本工作旨在通过主动选择oracle并通过主动状态探索来控制状态的不确定性来减少估计器的逼近误差。

算法的两个主要组件:主动策略选择和主动状态探索。在主动策略选择中,MAPS 利用上置信界限(UCB)的概念来决定在线学习过程中应该选择哪个oracle进行展开。在主动状态探索中,MAPS-SE 基于当前状态的不确定性来决定是否继续使用学习者策略或切换到选定的oracle。

Active Policy Selection

提出结合UCB选择Oracle,在离散空间下有

k ⋆ = arg max k ∈ [ K ] V ^ k ( s t ) + 2 H 2 log 2 δ N k ( s t ) , ( 4 ) k_{\star}=\arg\max_{k\in[K]}\hat{V}^{k}(s_{t})+\sqrt{\frac{2H^{2}\log\frac{2}{\delta}}{N_{k}\left(s_{t}\right)}}, (4) k⋆=argk∈[K]maxV^k(st)+Nk(st)2H2logδ2,(4)

对连续空间下有

k ⋆ = arg max k ∈ [ K ] V ^ k ( s t ) + σ k ( s t ) . ( 5 ) k_{\star}=\arg\max_{k\in[K]}\hat{V}^{k}(s_{t})+\sigma_{k}\left(s_{t}\right). (5) k⋆=argk∈[K]maxV^k(st)+σk(st).(5)

其中 V ^ π k ( s t ) ≐ 1 N k ( s t ) ∑ i = 1 N k ( s t ) ∑ j H λ j r ( s j , a j ) , ( 6 ) \hat{V}^{\pi_k}\left(s_t\right)\doteq\frac{1}{N_k\left(s_t\right)}\sum_{i=1}^{N_k\left(s_t\right)}\sum_{j}^{H}\lambda^jr\left(s_j,a_j\right), (6) V^πk(st)≐Nk(st)1∑i=1Nk(st)∑jHλjr(sj,aj),(6)

Active State Exploration

MAMBA 的第二个限制是没有对哪种状态下进行探索给出理由。在 MAPS 的基础上,提出了一种基于当前状态的不确定性度量的 MAPS (MAPS-SE) 主动状态探索变体,它决定是否在当前学习器策略中继续滚动或切换到最有希望的预言机,类似于 MAPS。这样,MAPS-SE 旨在主动选择最小化不确定性的状态。

在离散环境下由公式4选择出最优oracle.,连续空间下N无法计算,因此采用ensemble的价值网络估计,那么状态的不确定度由网络预测的标准差定义

Γ k ⋆ ( s t ) = { 2 H 2 log 2 δ N k ⋆ ( s t ) discrete σ k ⋆ ( s t ) continuous \Gamma_{k_\star}\left(s_t\right)=\begin{cases}\sqrt{\frac{2H^2\log\frac{2}{\delta}}{N_{k_\star}\left(s_t\right)}}&\text{discrete}\\\sigma_{k_\star}\left(s_t\right)&\text{continuous}\end{cases} Γk⋆(st)={Nk⋆(st)2H2logδ2σk⋆(st)discretecontinuous

在当前状态下是否执行最优oracle由 Γ k ⋆ \Gamma_{k_\star} Γk⋆与阈值 Γ s \Gamma_s Γs相关

Γ s = α ⋅ ( 2 H 2 log 2 δ K + ( ∑ i 1 Δ i 2 ) log ( K δ ) ) \Gamma_s=\alpha\cdot\left(\sqrt{\frac{2H^2\log\frac2\delta}{K+\left(\sum_i\frac1{\Delta_i^2}\right)\log\left(\frac K\delta\right)}}\right) Γs=α⋅ K+(∑iΔi21)log(δK)2H2logδ2

若不确定度大于阈值则采用oracle策略,小于则采用智能体策略进行rollout.

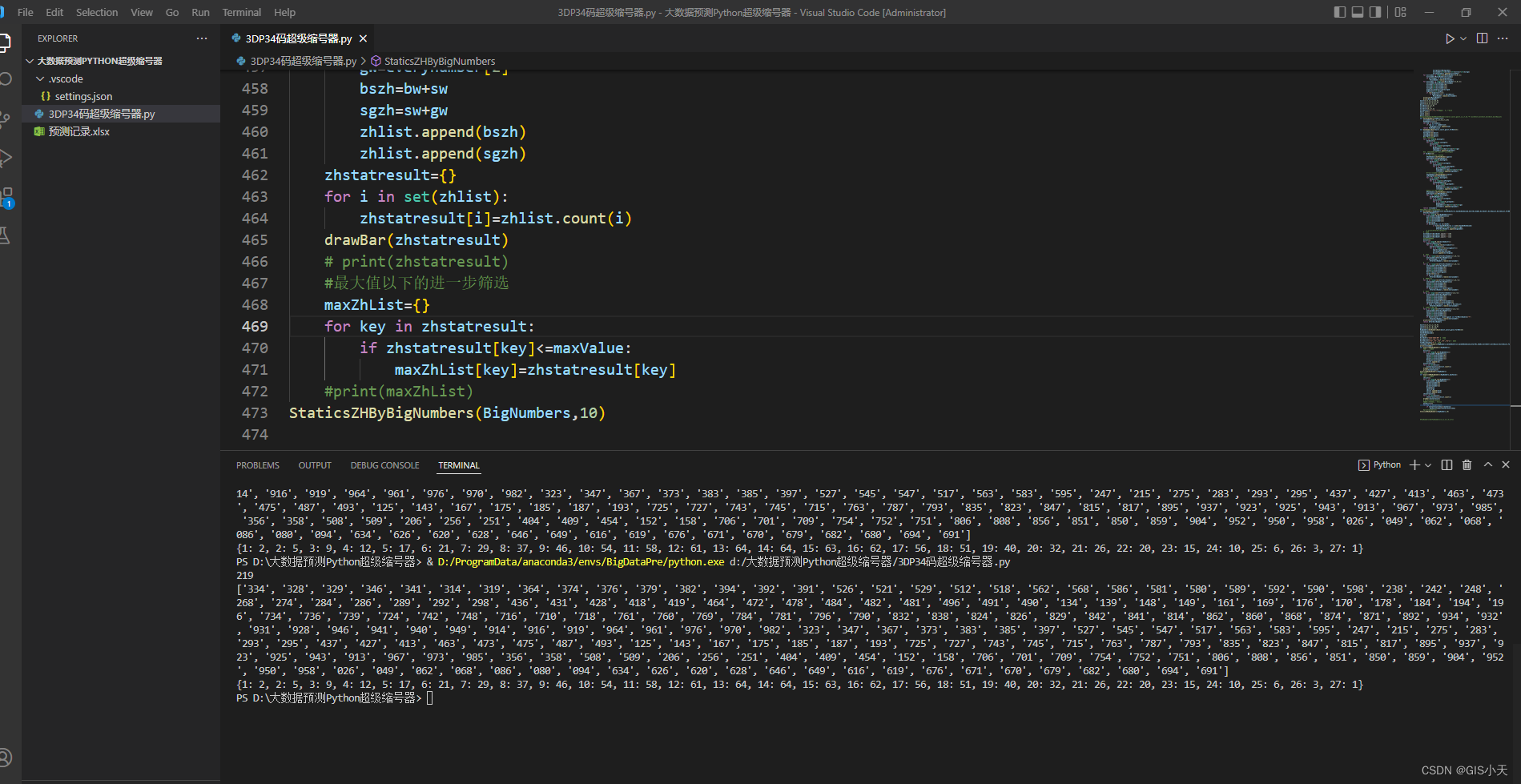

伪代码

其中第十行的优化目标与MAMBA中的目标相同

∇ ℓ ^ n ( π n ; λ ) = − H E s ∼ d π n , a ∼ π n ( ⋅ ∣ s ) [ ∇ log π n ( a ∣ s ) A λ f ^ max , π n ( s , a ) ] , (9) \nabla\hat{\ell}_{n}\left(\pi_{n};\lambda\right)=-H\mathbb{E}_{s\sim d^{\pi_{n}},a\sim\pi_{n}(\cdot|s)}\Big[\nabla\log\pi_{n}\left(a|s\right)A_{\lambda}^{\hat{f}^{\max},\pi_{n}}\left(s,a\right)\Big], \quad \text{(9)} ∇ℓ^n(πn;λ)=−HEs∼dπn,a∼πn(⋅∣s)[∇logπn(a∣s)Aλf^max,πn(s,a)],(9)

Results

其他

霍夫丁不等式给出有界随机变量靠近其均值的概率有多大,也用来对算法的样本复杂度进行分析。

Hoeffding’s inequality

cs229

机器学习数学原理(8)——霍夫丁不等式