来源链接:https://medium.com/ai-advances/introduction-to-opendevin-the-aspiring-ai-powered-software-development-platform-11ffc69e60cc

发布时间:2024-05-05T00:40:39.078Z

OpenDevin 是一个创新的开源项目,旨在通过引入一个自主的 AI 软件工程师来彻底改变软件开发。这个 AI 助手旨在处理复杂的工程任务,并与人类用户在各种软件项目上积极合作。该项目正在开发中,但已经发布的 alpha 版本清楚地展示了协作式 AI 开发的激动人心的未来。

更多详情请参阅:

- OpenDevin 的核心功能:它能做什么(或至少它渴望做什么)

- 开始使用 OpenDevin

- 理解 OpenDevin 的架构

- OpenDevin 的代理:专业化的 AI 助手

- OpenDevin 的潜在应用

- 结论

OpenDevin 的核心功能:它能做什么(或至少它渴望做什么)

想象一下有一个不知疲倦的队友,能够处理复杂的编码任务,理解你的意图,并在过程中提供建议和解释。这就是 OpenDevin 的潜在未来。该项目旨在创建一个全面的 AI 助手,能够:

- 自动化重复任务: OpenDevin 旨在处理各种编码杂务,包括生成代码、修复错误和重构现有代码,让开发者能够专注于项目的战略方面。

- 像伙伴一样协作: OpenDevin 不仅仅是一个自动化工具;它努力成为一个协作伙伴。它将通过自然语言处理理解你的意图,并提供智能建议、解释和针对你特定需求的代码示例。

- 持续学习和适应: OpenDevin 渴望成为一个快速学习者:通过与用户互动和分析过去的项目,它被设计为不断改进其性能并适应不同的编码风格和项目要求。

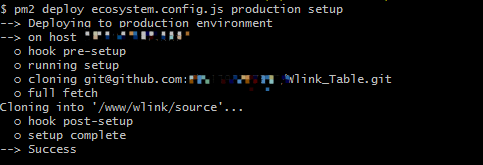

开始使用 OpenDevin

OpenDevin 主要在一个 Docker 容器内运行,为其操作提供了一个受控环境。以下是一个基本的入门指南:

- 设置你的工作区: 选择一个 OpenDevin 可以访问和修改你的代码的目录。

- 配置你的 LLM: 通过设置相关环境变量(如

LLM_API_KEY和LLM_MODEL)选择并配置你想要的 大型语言模型(LLM)。OpenDevin 支持多种 LLM,包括 GPT-4、Claude、Azure OpenAI、Google Gemini/Vertex 和本地模型,如 Ollama 提供的模型。 - 运行 OpenDevin: 使用提供的 Docker 命令和适当的环境变量启动 OpenDevin。

- 访问界面: 运行后,OpenDevin 可以通过 http://localhost:3000 上的网页界面访问。

如文档所示,启动只需使用以下代码行:

export WORKSPACE\_BASE=$(pwd)/workspace; # 你希望 OpenDevin 修改的目录。必须是绝对路径!docker run \\ --pull=always \\ -e SANDBOX\_USER\_ID=$(id -u) \\ -e WORKSPACE\_MOUNT\_PATH=$WORKSPACE\_BASE \\ -v $WORKSPACE\_BASE:/opt/workspace\_base \\ -v /var/run/docker.sock:/var/run/docker.sock \\ -p 3000:3000 \\ --add-host host.docker.internal=host-gateway \\ ghcr.io/opendevin/opendevin:0.5

一个重要的提示:虽然OpenDevin在Docker沙箱中运行以实现隔离,但请确保您选择的工作空间目录已备份,因为在操作过程中文件可能会被修改或删除!

另外,需要注意的是,OpenDevin将向配置的LLM发出许多提示,这可能会产生费用。因此,设置消费限额和监控使用情况是至关重要的。

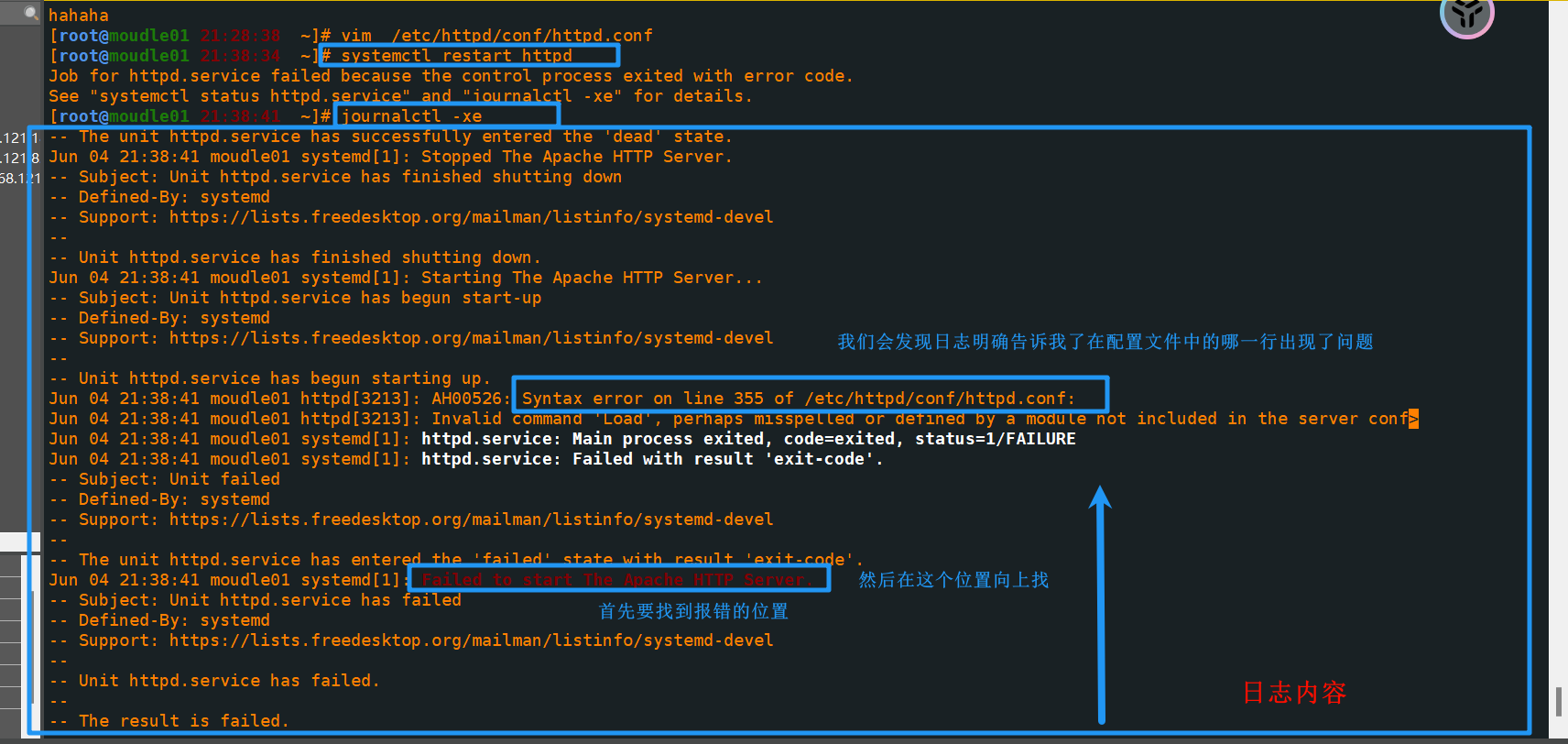

理解OpenDevin的架构

OpenDevin的系统架构由两个主要部分组成:

前端: 这是用户界面,开发者在这里与OpenDevin互动。它允许用户输入任务,查看代码建议和管理项目设置。

后端: 这个组件处理OpenDevin的核心功能,包括:

- LLM交互: 向选择的LLM发送提示并接收响应。

- 代理执行: 利用各种代理处理信息并执行操作。

- 工作空间管理: 与指定工作空间目录中的代码交互。

它们的相互连接以及构建块在以下图像中显示。

OpenDevin的架构

OpenDevin系统架构的关键组件包括:

- 聊天界面: 与聊天应用程序交互的用户界面

- 应用: 包含各种子组件以提供用户体验的主要组件

- settingsService: 管理用户偏好和个性化选项

- chatService: 处理核心聊天功能(消息传输、加密、存储)

- socket: 启用前端和后端之间的实时通信

- 客户端WS: 客户端的WebSocket,用于实时数据交换

- 服务器WS: 服务器端的WebSocket,用于实时数据交换

- VITE_TERMINAL_WS_URL: 指定WebSocket连接的网络地址的配置元素

- AgentController: 管理自动化代理或聊天机器人,用于智能聊天功能

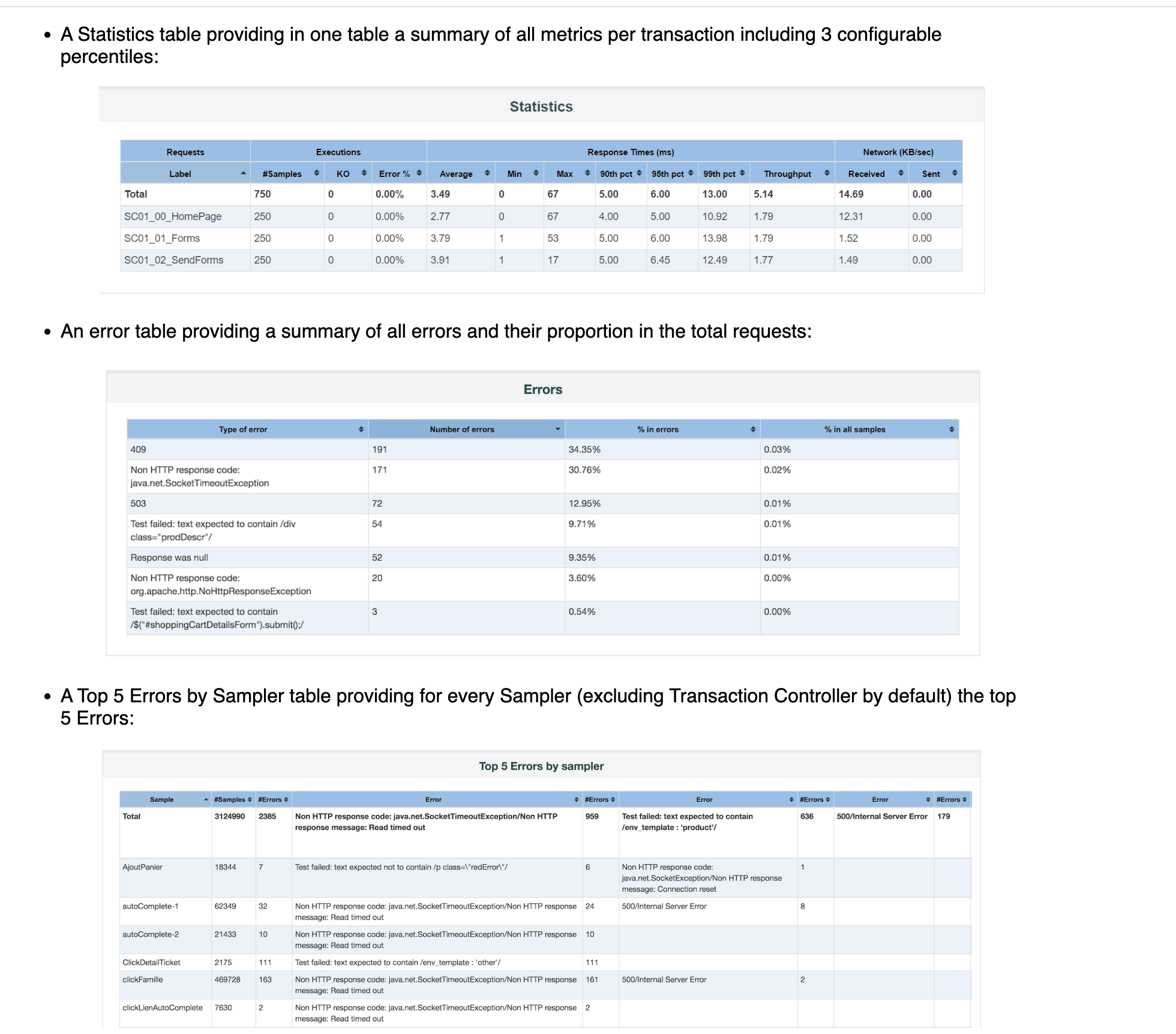

OpenDevin的代理:专业的AI助手

OpenDevin使用不同的代理,每个代理都具有独特的能力来处理特定任务:

- CodeAct代理: CodeAct代理体现了将LLM代理的行动整合到统一的代码操作空间的概念。这个代理可以与用户对话,执行Linux bash命令,并通过交互式解释器运行Python代码。它利用OpenDevin的插件系统,包括Jupyter插件用于IPython执行和SWE-agent工具插件用于软件开发任务。以下图像展示了这个代理的操作。

- Monologue Agent 独白代理: 独白代理利用长期和短期记忆的力量高效完成任务。它将长期记忆存储为 LongTermMemory 对象,使模型能够从过去搜索相关示例。短期记忆作为 Monologue 对象进行维护,模型可以根据需要进行压缩。该代理支持多种操作,包括运行命令、读写文件、回忆信息、浏览网址和推送至 GitHub。

- Planner Agent 规划代理: 规划代理采用独特的提示策略来制定解决问题的长期计划。它接收每一步的先前动作-观察对、当前任务以及基于最后执行动作的提示。该代理检查当前步骤是否完成,并返回 AgentFinishAction 或创建计划提示发送给模型进行推理。

OpenDevin 的潜在应用

OpenDevin 的功能(及类似项目)为软件开发生命周期内的多种应用打开了大门:

- 快速原型制作: 根据用户规格和反馈快速生成并迭代代码原型。

- 自动化代码生成: 自动化重复编码任务,如创建样板代码或实现标准算法。

- 智能代码补全: 接收上下文感知的代码建议和补全,以提高编码效率和准确性。

- 错误检测与修复: 利用 AI 驱动的分析和建议识别并修复现有代码中的错误。

- 代码重构: 通过自动重构现有代码,提高代码质量和可维护性。

- 学习和教育: 像 OpenDevin 这样的工具可以通过提供交互式解释和代码示例,作为学习新编程语言和概念的宝贵辅助。

结论

OpenDevin 代表了 AI 辅助软件开发的一个良好挑战,并且以开源方式出色地完成。随着 OpenDevin 的不断发展,它有望赋予开发者超能力,加速开发周期,并最终塑造软件开发的未来。这个多汁的果实何时会成熟到足以被食用(咳咳,使用)呢?