Simplifying Content-Based Neural News Recommendation: On User Modeling and Training Objectives论文阅读笔记

Abstract

存在的问题:

(1) 尽管设计具有普遍的同质性,但不同的评估数据集和协议阻碍了模型之间的直接比较;(2) 它使其他模型设计和训练目标的探索工作受到很大影响。

提出方法:

在这项工作中,我们提出了一个统一的新闻推荐框架,允许在几个关键的设计维度上对新闻推荐器进行系统而公平的比较:(i) 用户建模中的候选者感知,(ii) 点击行为融合,以及 (iii) 训练目标。我们的研究结果对神经新闻推荐的现状提出了挑战。我们发现,用候选新闻嵌入和点击新闻嵌入之间参数高效的点积(后期融合(LF))来替代庞大的用户编码器,往往能带来显著的性能提升。此外,我们的研究结果使对比训练成为点分类目标的可行替代方案。

Introduction

近年来,基于内容的新闻推荐出现了越来越复杂的神经推荐架构,旨在根据用户的兴趣定制推荐[13, 34]。大多数神经新闻推荐(NNR)模型通常包括(i)专用新闻编码器(NE)和(ii)用户编码器(UE)。神经编码器--实例化为卷积网络、自我注意网络、图注意网络或预训练转换器网络--将输入特征(如标题、类别、实体)转换为新闻嵌入。UE 通过顺序或注意编码器将点击新闻的嵌入聚合成用户级表示,这些编码器根据点击行为的模式将点击新闻的嵌入上下文化。我们将这种主要的范例称为早期融合(EF),因为它在与候选者进行比较之前,会汇总点击新闻的表征(即建立用户表征)。

大多数 NNR 模型都是将用户和候选新闻分开编码,采用与候选无关的方式。与此相反,候选者感知模型承认,并非所有被点击的新闻在候选者相关性方面都具有同等信息量(例如,候选者往往只代表用户偏好的一个子集),并在用户级聚合与 UE 的用户级聚合中,将被点击新闻与候选者嵌入进行上下文表示。最后,候选者的嵌入(NE 的输出)与用户的嵌入(UE 的输出)进行比较:候选者的推荐得分直接计算为两个嵌入的点积,或使用前馈评分器。NNR 模型主要通过标准分类目标和负抽样进行训练。

现有工作有两个主要缺点。首先,尽管在设计上存在普遍的同质性,但由于缺乏透明度和采用临时评估协议,阻碍了对最新的 NNR 进行直接比较。特别是,绝大多数个性化新闻推荐器都是在专有数据集上进行评估的。即使是使用 Adressa 或 MIND 等公开数据集进行评估的少数模型,由于数据集分割和评估协议(如模型选择策略)不同,也无法直接进行比较。其次,更简单、也可以说更直观的设计方案在很大程度上还没有被探索。首先,现有研究采用 EF 作为默认架构,提出了越来越复杂的用户编码组件,但往往缺乏增加复杂性的经验依据。其次,只有一小部分 NNR 利用了对比性学习目标,尽管这种训练标准在密切相关的检索和推荐任务中被证明非常有效。

在这项工作中,我们弥补了当前NNR的上述缺点,并为用户建模和培训目标提供了新的思路。

- 具体而言,我们引入了一个统一的神经新闻推荐框架,便于在三个关键设计维度上对神经新闻推荐模型进行系统而公平的比较:(i) 用户建模中的候选意识;(ii) 点击行为融合;(iii) 训练目标。

- 我们建议用候选新闻嵌入和点击新闻嵌入之间简单的点积分数池(即后期融合)取代复杂用户编码器的用户建模(即早期融合)。我们的研究表明,尽管概念简单,但 LF 比基于 EF 的 NNR 带来了实质性的性能提升,使复杂的 UE 在经验上变得不合理。

- 最后,我们展示了有监督的对比训练作为点分类的可行替代方案的优势。我们的工作从根本上挑战了 NNR 的现状,为基于复杂用户建模的既定范式引入了更简单、更有效的替代方案。

Method

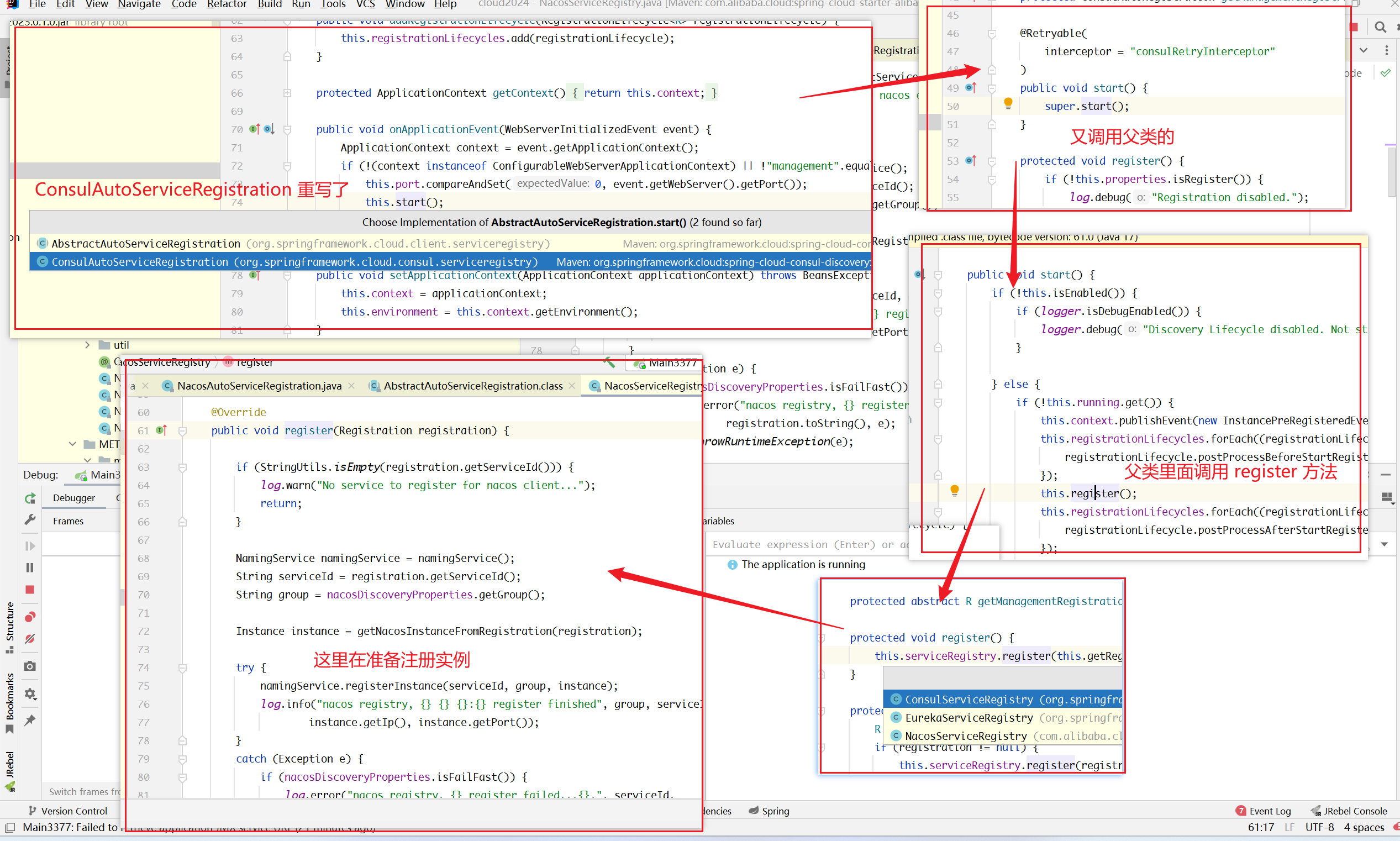

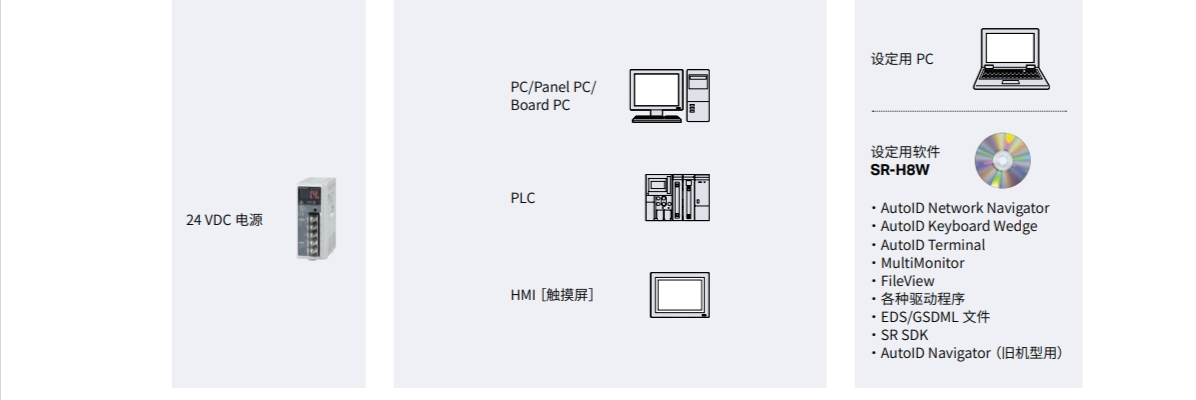

这个是统一的NNR的框架,重点关注三个关键的设计维度:(i) 用户建模中的候选人感知(绿色方框),(ii) 点击行为融合(橙色方框),以及 (iii) 训练目标(紫色方框)。

上图描述了我们对 NNR 的统一评估框架,重点关注新闻推荐的三个关键维度。给定由新闻和用户行为组成的输入数据后,我们分析了两种点击行为融合策略(即 EF 和 LF)下的候选无关(C-AG)与候选感知(C-AW)用户建模,其中每个模型都可以通过最小化标准交叉熵损失(CE)或监督对比目标(SCL)来训练。接下来,我们将介绍选定用于评估的模型,并正式说明具体的设计选择。

用户建模

候选无关的模型(C-AG)

在这些模型中,UE 从点击新闻的嵌入中生成用户嵌入,而不对候选新闻进行上下文关联。我们评估了以下 C-AG 模型,它们在 NE 部分(即如何嵌入点击新闻)上互不相同:

(1) NPA使用个性化注意力模块来聚合用户点击新闻的表征,并将用户 ID 的投影嵌入作为注意力查询;

(2) NAML使用加法注意力来编码用户的偏好;

(3) NRMS使用由多头自我注意力和加法注意力组成的双层编码器来学习用户表征;

(4) LSTUR使用递归网络来学习用户表征: 利用 GRU从点击新闻中生成短期用户嵌入,并与由随机初始化和微调部分组成的长期嵌入相结合;然后(i) 作为短期 GRU 的最终隐藏状态,用长期嵌入进行初始化(LSTURini),或(ii) 通过简单地连接短期和长期用户嵌入(LSTURcon),获得最终用户嵌入;

(5) CenNewsRec采用了与 LSTUR 相似的 UE 架构,但使用多头自我注意和注意力汇集网络序列从点击新闻中学习长期用户向量,而不是为每个用户存储显式嵌入;

(6) MINS通过多头自我注意、基于 GRU 的多通道递归网络和加法注意的组合对用户进行编码。

候选感知的模型(C-AW)

无论候选新闻的内容如何,候选无关模型中的UE都会产生相同的用户嵌入。与此相反,候选者感知模型(我们的实证分析中包括其中两个模型)中的 UE 产生的用户嵌入取决于候选者。

(7) DKN将用户点击新闻嵌入的加权和作为用户的候选感知表征,其权重由注意力网络产生,该网络将候选新闻和点击新闻的嵌入作为输入,由注意力网络产生。最近,

(8) CAUM 将(i) 候选者感知自我注意力网络和(ii) 候选者感知卷积网络(CNN)结合起来,前者以候选者为条件,对点击新闻之间的长距离依赖关系进行建模;后者同样以候选者的内容为条件,从相邻的点击中捕捉用户的短期兴趣。

新闻编码器

我们评估中的 NNR 模型主要使用新闻标题作为输入,它们通常通过预训练的词嵌入来嵌入新闻标题。NAML、LSTUR、MINS 和 CAUM 还利用类别信息,通过线性层嵌入类别。CAUM 还对标题实体进行了编码,而 DKN 则利用了知识图嵌入。浅层单词和实体嵌入是通过多头自注意组合(在 NRMS、MINS 和 CAUM 中)或 CNN和加法注意网络序列(在 NAML 和 LSTUR 中)进行上下文化的。NPA也使用 CNN 对词嵌入进行上下文分析,然后使用个性化注意力模块,类似于其用户编码器中使用的模块,而 DKN 则使用词实体对齐的知识感知 CNN。CenNewsRec将 CNN 网络与多头自注意和加法注意模块相结合。具有多个特征向量的模型可通过简单的连接(LSTUR、CAUM)或对其进行注意力处理(NAML、MINS)来生成最终的新闻嵌入。

点击行为融合

我们质疑早期融合(EF)的设计和计算复杂性,即在最先进的 NNR 模型中存在专门的用户编码器是否合理。为此,我们提出了晚期融合(LF)方法,作为一种轻量级的替代方案,用候选新闻的嵌入和点击新闻的嵌入之间的点积得分均值池化来取代复杂的用户编码器。

给定候选新闻𝑛 𝑐 和用户点击的新闻序列\(H=n_1^u,...,n_N^u,\),我们计算候选新闻与用户𝑢 历史记录的相关性得分为\(s(\mathbf{n}^c,u)=\frac1N\sum_{i=1}^N\mathbf{n}^c\cdot\mathbf{n}_i^u,\),其中 n 表示新闻编码器学习到的新闻嵌入,𝑁 表示历史长度。

这意味着,如果需要,LF 还可以无缝地提供用户嵌入(仅仅是点击新闻嵌入的平均值)。因此,LF 可被视为无参数用户编码器,即现有 EF 模型中复杂参数化 UE 的高效计算替代方案。由于(i)我们独立生成候选新闻和点击新闻的嵌入,以及(ii)将用户嵌入作为点击新闻嵌入的平均值,因此 LF 模型与候选新闻无关(C-AG)。

训练目标

无论具体的用户建模架构如何,现有的绝大多数 NNR 工作都是通过最小化最直接的分类目标--交叉熵损失--来调整参数,在很大程度上没有探索有效的替代方法,最重要的是对比目标。这妨碍了我们了解模型在不同训练机制下的有效性。为了解决这个问题,我们不仅用(1)普通的交叉熵损失(负采样),而且还用(2)对比学习目标,特别是有监督的对比损失来训练所有模型。

总结

这篇文章整体讲的非常清晰,这里来贴一下原文的Conclusion

个性化神经新闻推荐器的快速发展阻碍了对模型的公平比较评估和对设计选择的系统分析。在这项工作中,我们引入了一个统一的神经新闻推荐框架,重点关注神经网络推荐的三个关键设计维度:(i) 用户建模中的候选者感知,(ii) 点击行为融合,以及 (iii) 训练目标。对各种最新的先进模型进行广泛评估后发现,神经网络新闻推荐可以大幅简化:用无参数的点击新闻嵌入聚合取代复杂的用户编码器,可以全面提高性能,同时降低模型的复杂性。此外,我们还证明了对比学习可以替代基于分类的标准(交叉熵)损失。我们希望我们的发现能激发更透明的 NNR 评估,包括系统性的模型消减,以发现驱动性能的组成部分。