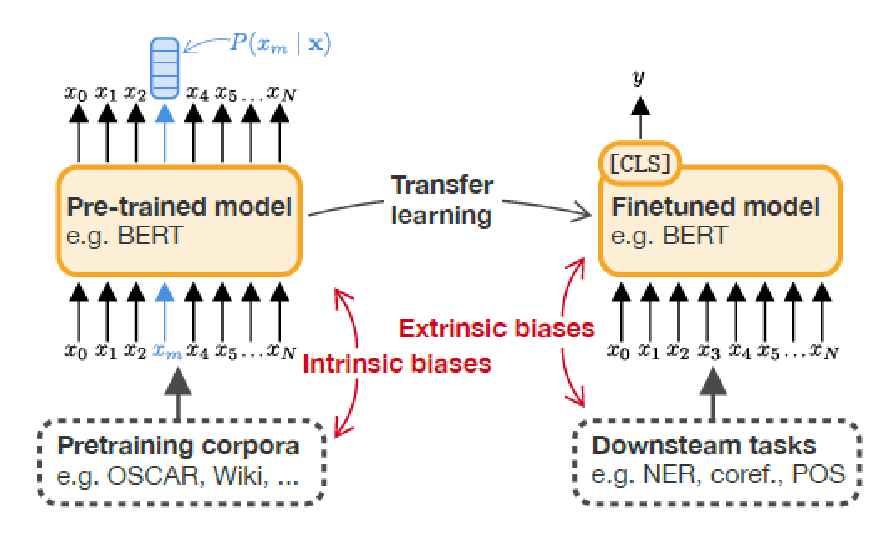

一、内在偏见与外在偏见

1、内在偏见:训练前数据集中存在的刻板印象;

2、外在偏见:用来衡量偏差如何在下游任务中传播。通常包括微调,然后评估其关于性别和种族等敏感属性的表现;

3、许多NLP应用程序对现有的语言模型进行了微调,这些模型将外在偏见和内在偏见交织在一起。

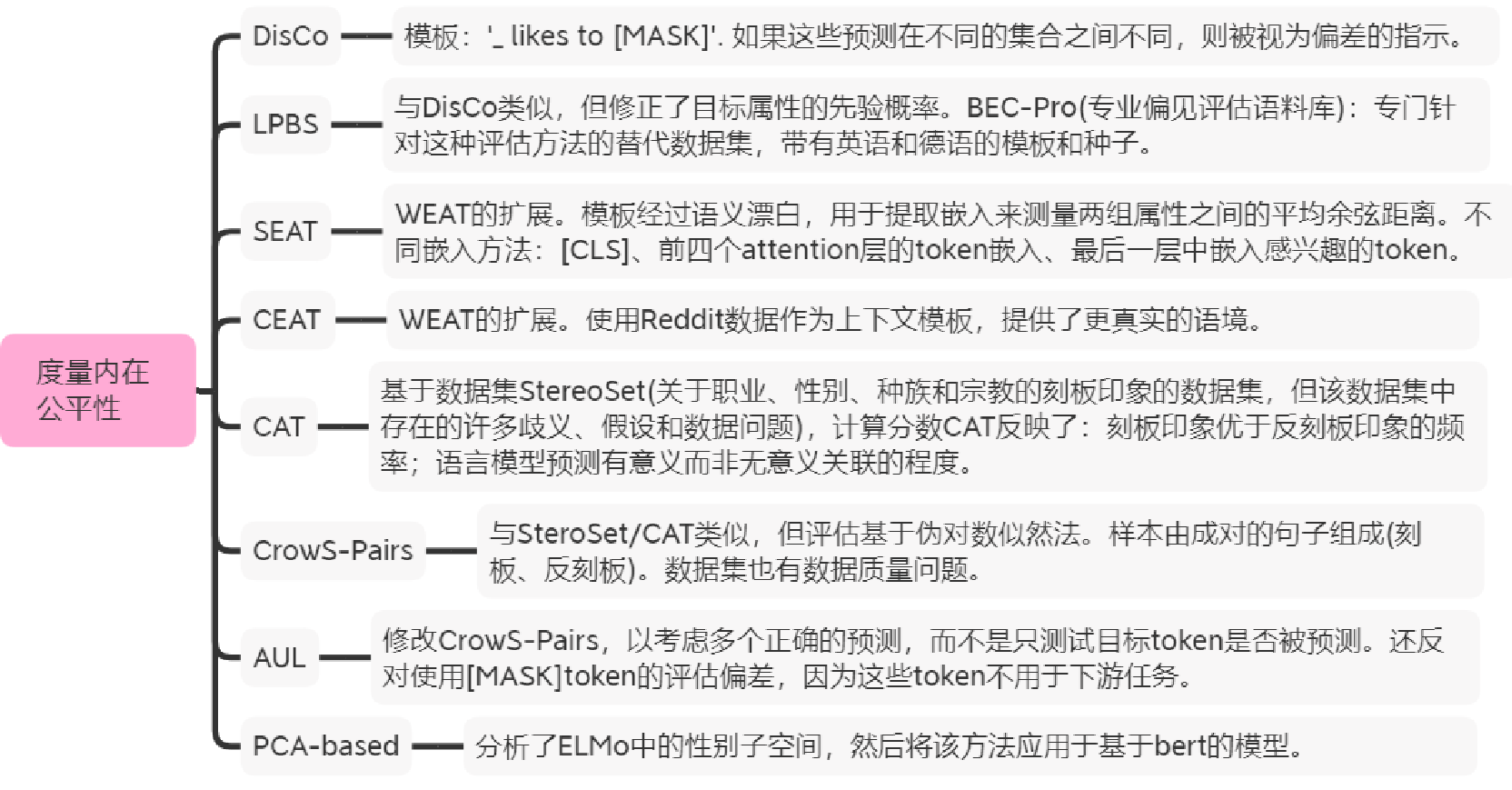

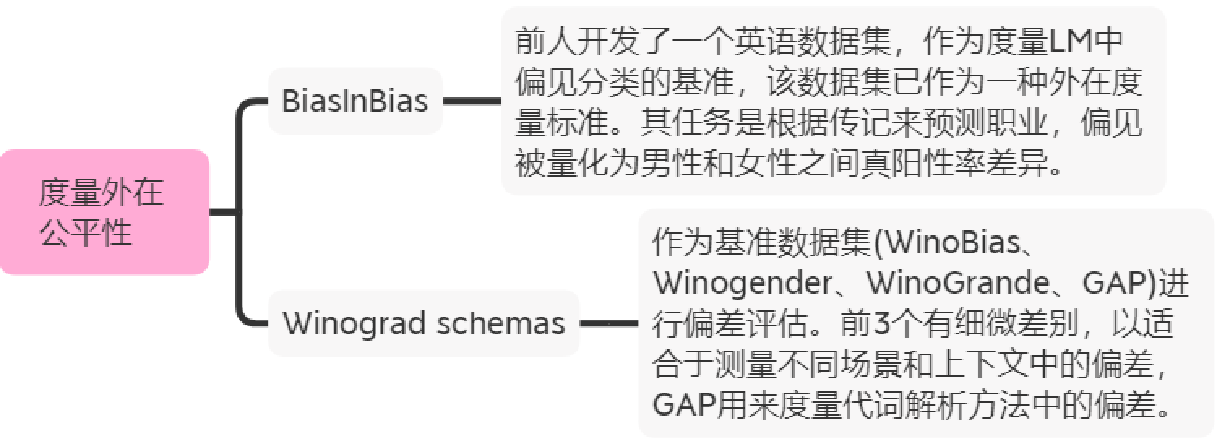

二、10种度量方法

2.1 内在度量

2.2 外在度量

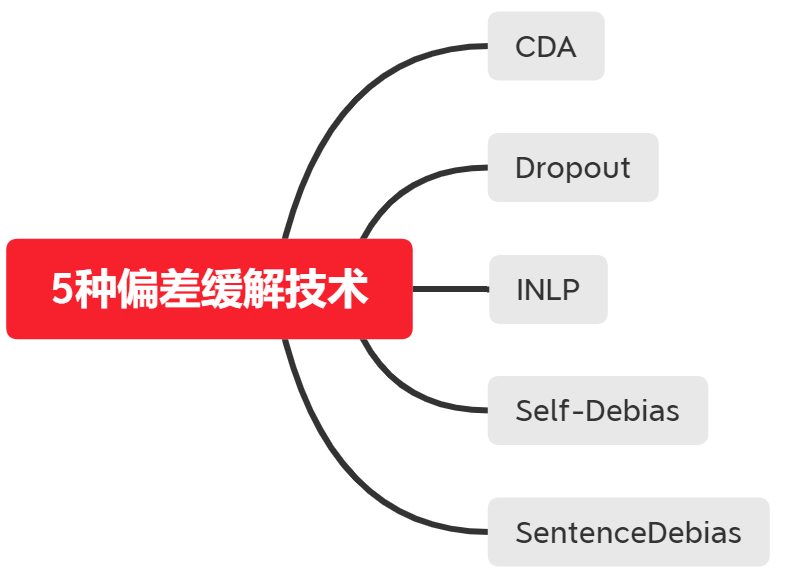

二、5种去偏方法

1、CDA:通过交换一个数据集中的偏差属性词来重新平衡一个语料库,然后进行额外的预训练;

2、Dropout:增加注意权重和隐藏激活的dropout参数,并进行额外的预训练;

3、INLP:训练一个线性分类器来预测想要从表示中删除的受保护的属性来削弱模型的表示,通过将表示投影到学习分类器权重矩阵的零空间来去偏。

4、Self-Debias:一种后去偏技术,利用模型的内部知识来阻止它生成有偏见的文本,不会改变模型的内部表示或其参数;

5、SentenceDebias:基于投影,需要对特定类型的偏差估计一个线性子空间,从原始的句子表示中减去投影到估计的偏差子空间上的句子表示来去偏。