一个标准 VMware Cloud Foundation 实例中具有管理工作负载域和 VI 工作负载域两种类型,管理域有且只有一个,而 VI 域可以创建多个,每种工作负载域中可以具有多个 vSphere 集群,而每个集群中可以具有多台主机,有关工作负载域所支持的集群和主机数等限制请查看 VMware Configuration Maximums。当部署完工作负载域之后,可能需要对管理工作负载域或 VI 工作负载域中的资源进行扩展,比如添加 ESXi 主机或者添加新的 vSphere 集群等,以此来获得主机故障时的最佳弹性和支持更多的工作负载。

其实,无论是管理域还是 VI 域,对于资源的扩展过程都是差不多的。所以,由于环境资源有限,下面以管理工作负载域为例,了解如何为工作负载域进行扩展资源,主要涉及工作负载域中对于主机和集群的添加或删除过程。

一、准备环境

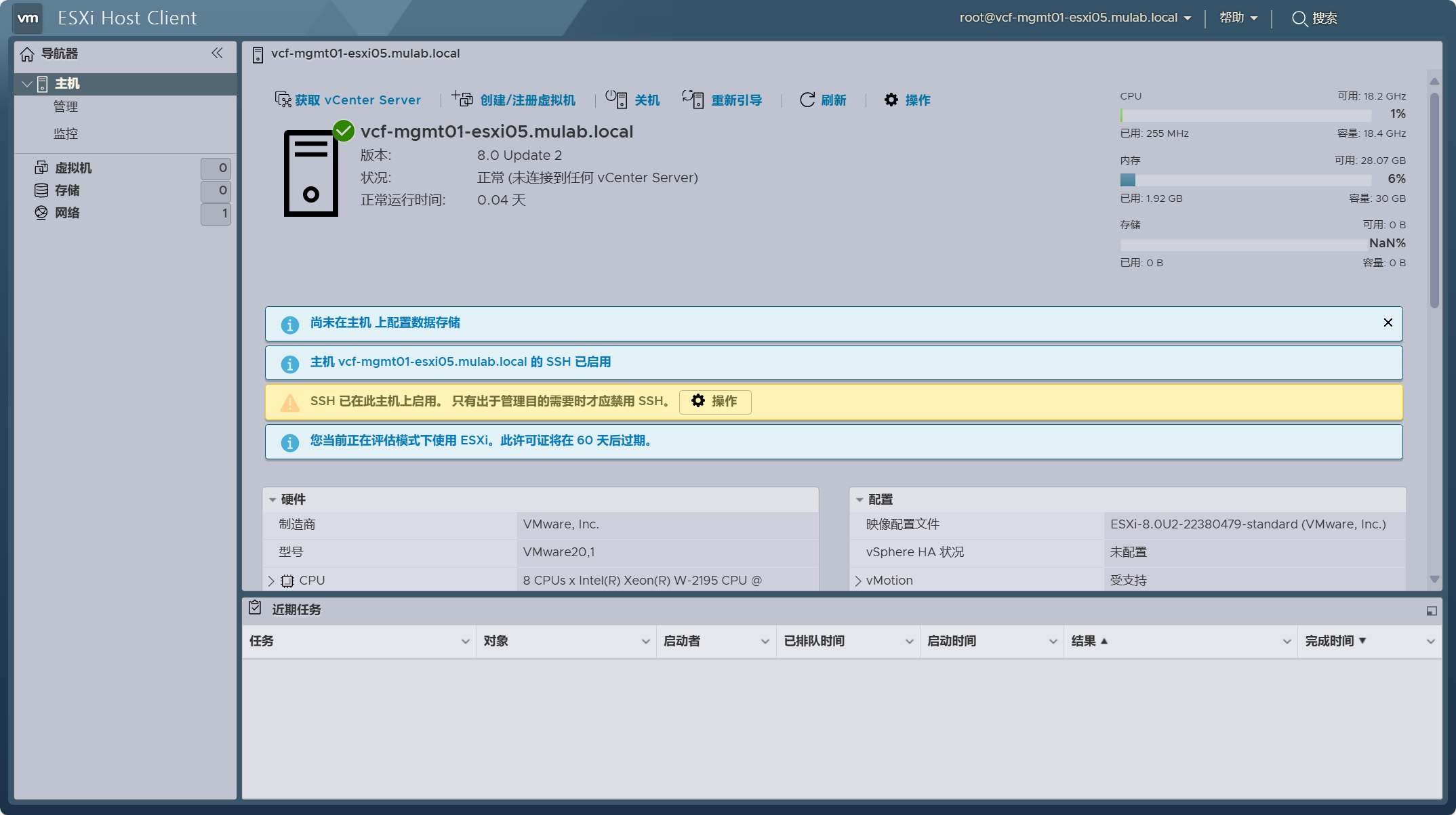

准备加入工作负载域中的 ESXi 主机,同样使用嵌套虚拟机的方式,所有安装配置过程请参照(VMware Cloud Foundation Part 04:准备 ESXi 主机。)文章中的方法。注意,ESXi 主机的版本请使用工作负载域中相同的版本,ESXi 主机请至少添加两块硬盘用于 vSAN 存储。在实际环境中,ESXi 主机的配置请尽量与已部署环境中的主机保持一致。

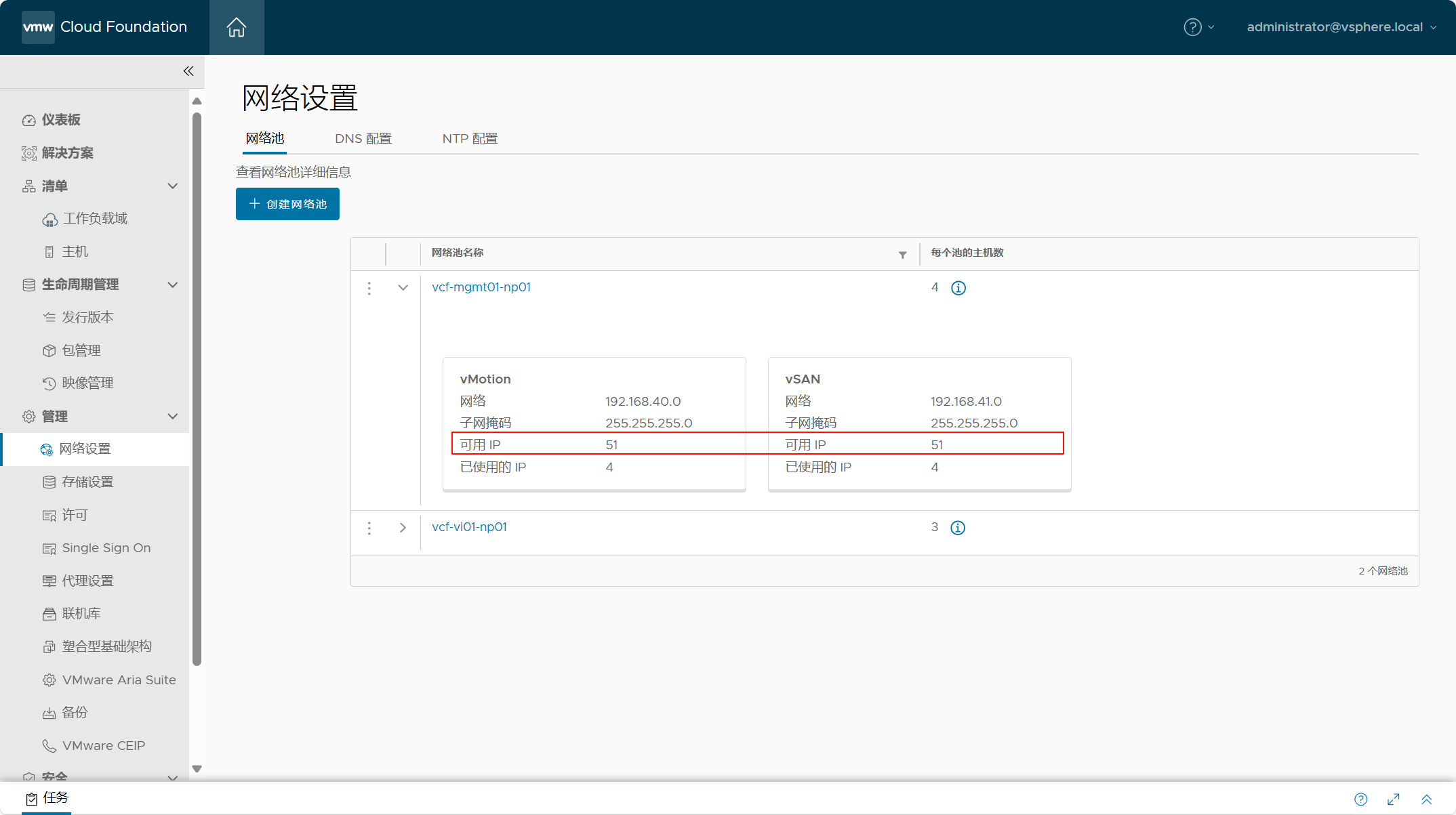

向工作负载域中添加主机或集群之前,请确保用于 ESXi 主机的网络池中具有可用的 IP 地址。可以编辑网络池,向地址池中增加可用 IP 范围用于添加到相同集群的 ESXi 主机;或者创建一个新的网络池,用于向工作负载域中添加新的集群。

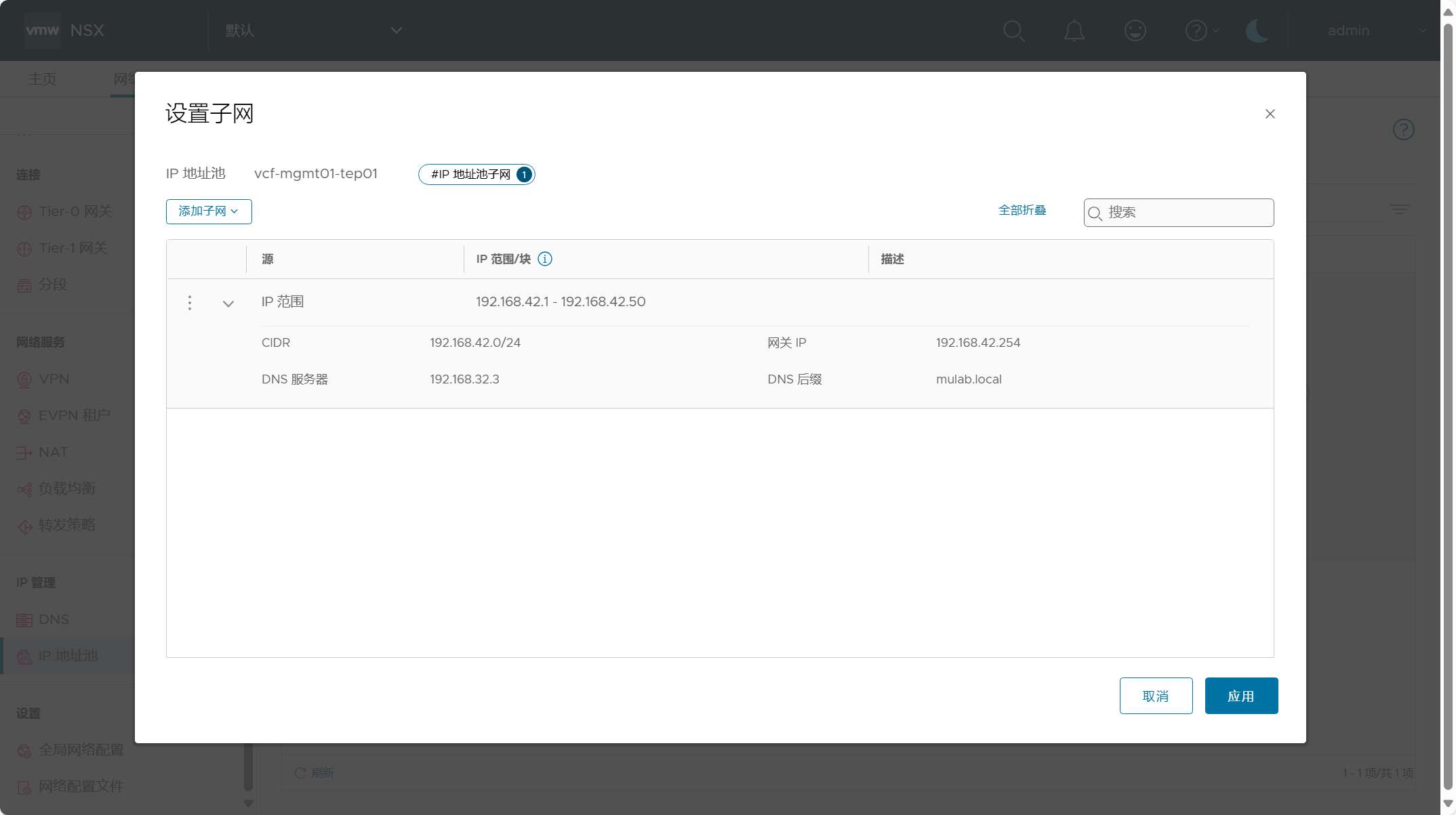

向工作负载域中添加主机之前,请确保所在工作负载域 NSX Manager 当中 TEP IP 地址池具有可用的 IP 地址;如果是添加新的集群,可以提前创建 TEP IP 地址池或在添加集群工作流中手动创建地址池。

二、服役主机

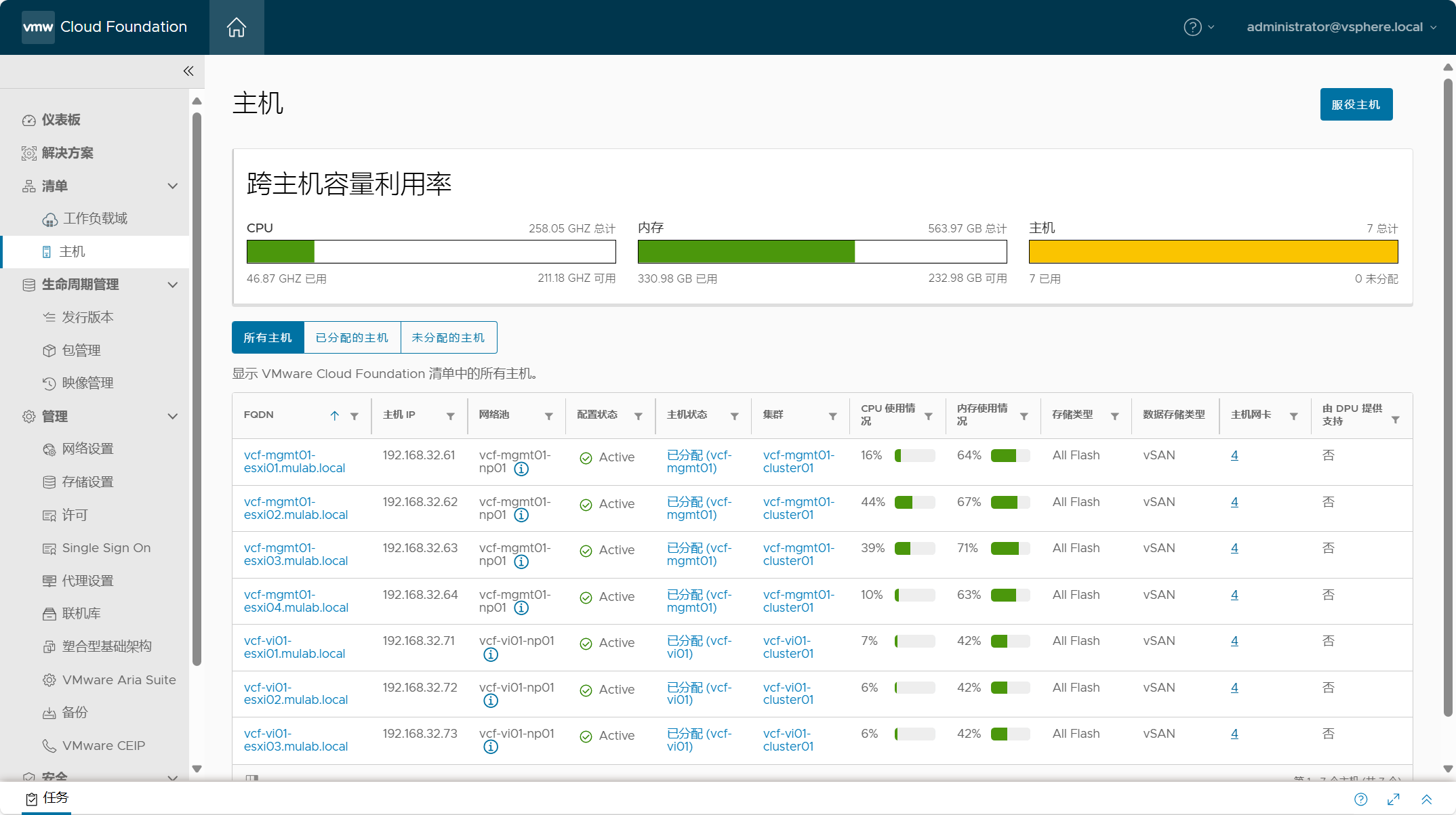

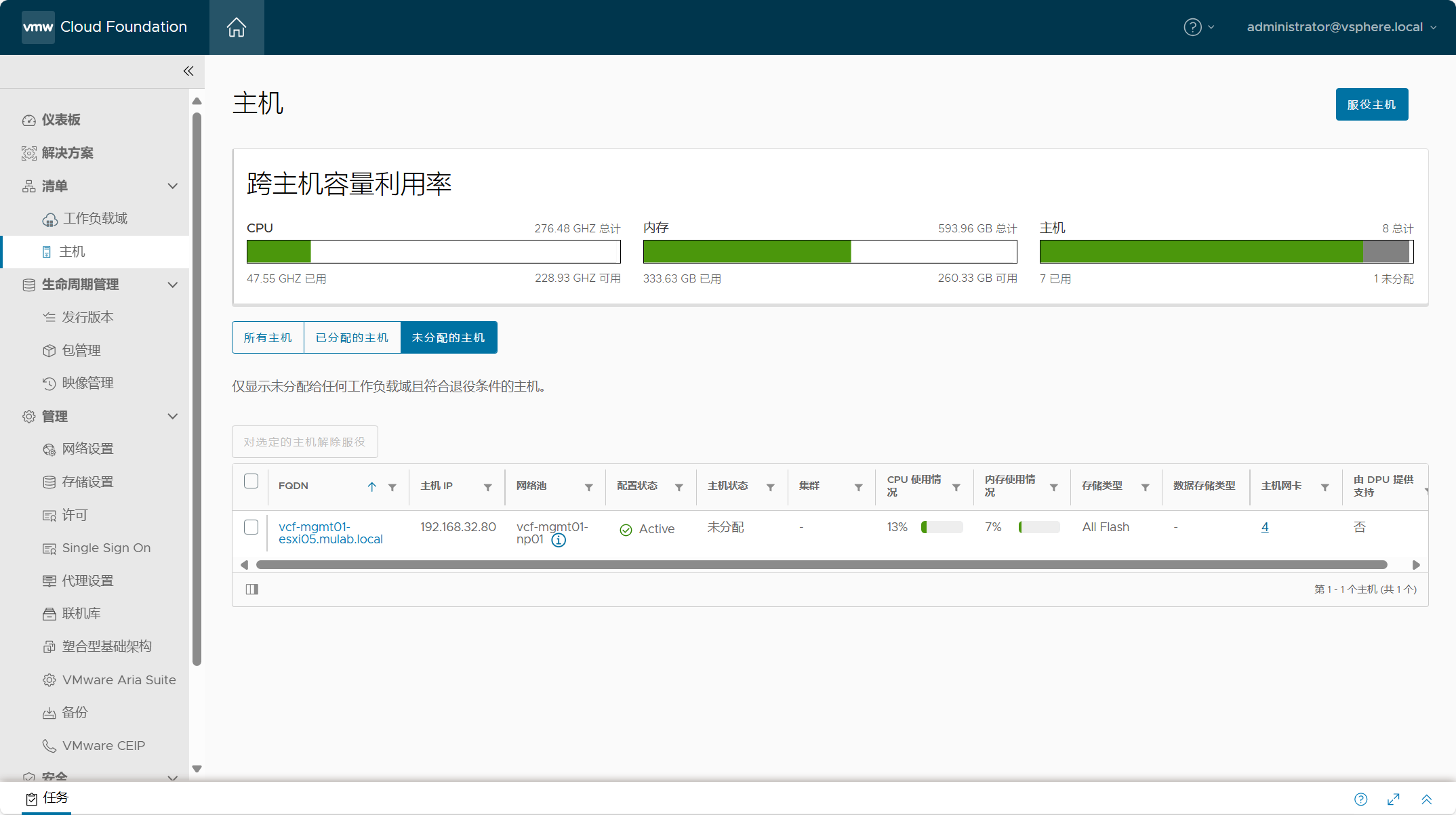

不管是任何一种工作负载域(管理域/VI域)需要添加主机或者集群,都需要先将 ESXi 主机添加到“服役主机”清单中。导航到 SDDC Manager->清单->主机,点击服役主机。

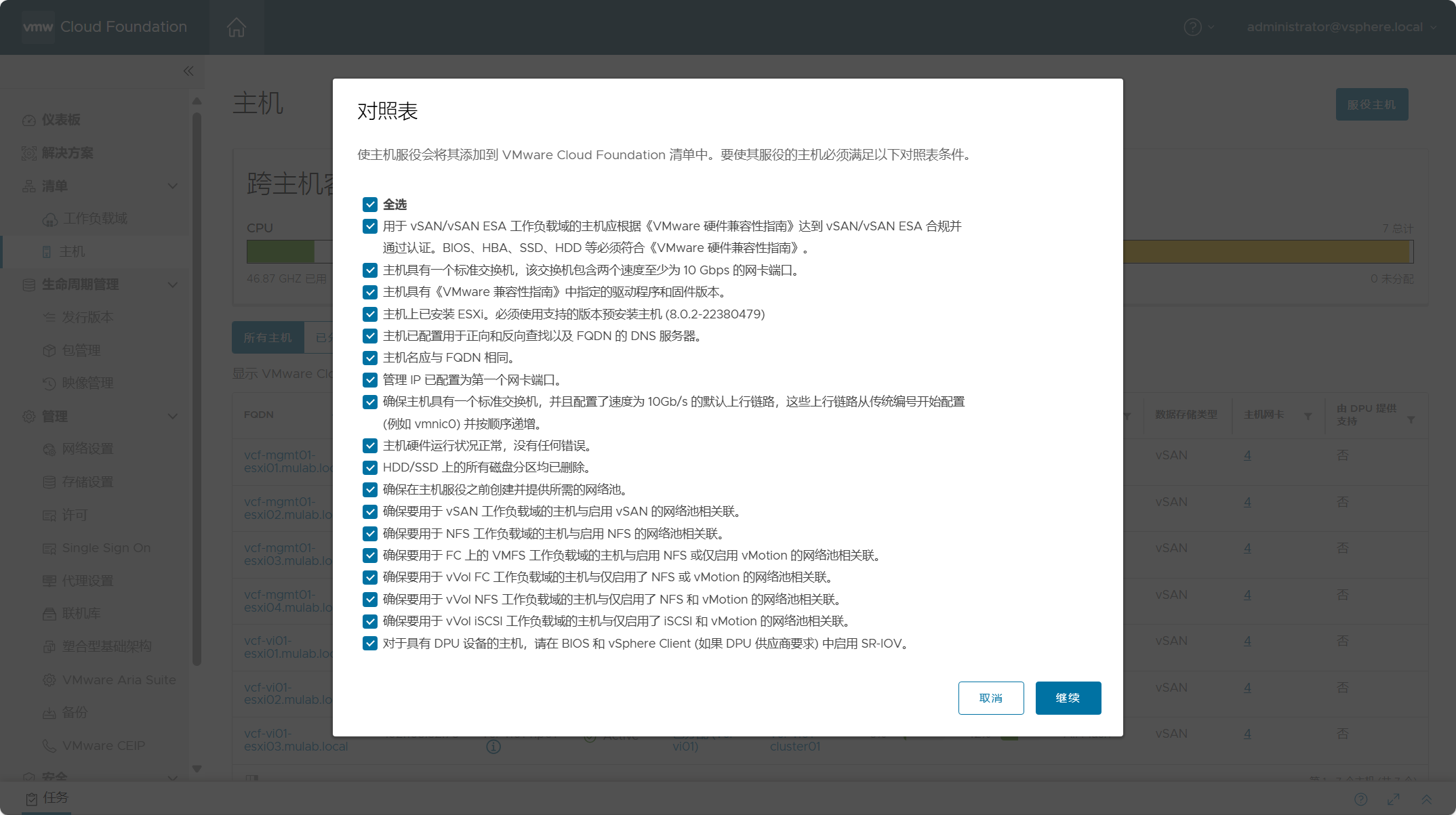

勾选全部,请确保所添加的 ESXi 主机符合服役条件,点击继续。

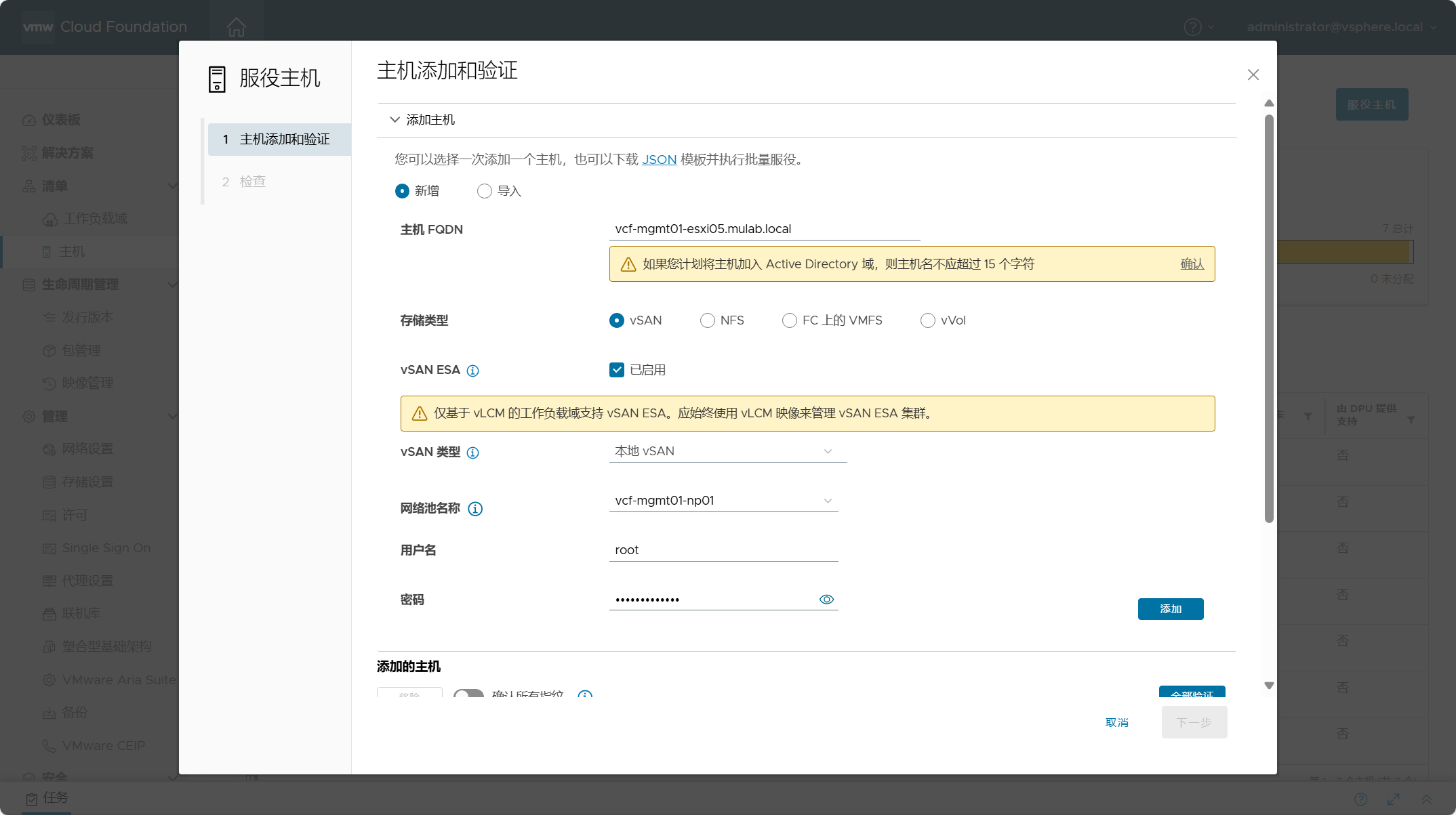

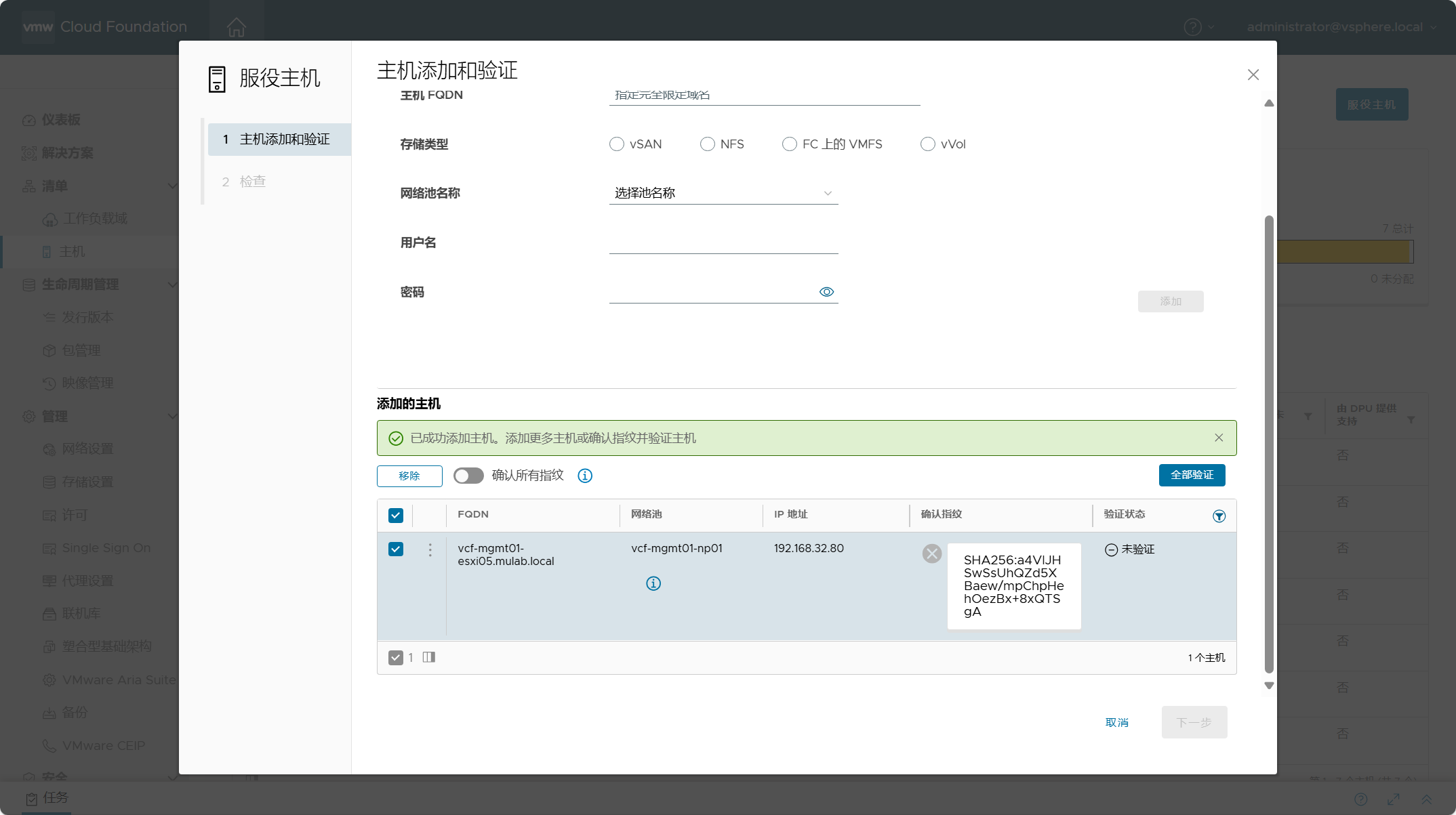

输入 ESXi 主机的 FQDN,根据工作负载域所使用的存储类型,选择主机使用的存储类型 ,这里选择 vSAN 并勾选 vSAN ESA。当前环境是 VCF 5.1.x 版本,vSAN 类型只能是“本地 vSAN”,也就是 vSAN HCI ESA;在 VCF 5.2 版本中,支持将主机用于基于 ESA 架构的 vSAN Max 分解存储。网络池名称一定要选择当前工作负载域所使用的网络池或专门用于某类工作负载域的网络池。填入 ESXi 主机的用户名和密码进行验证。

勾选添加的主机,点击“全部验证”。

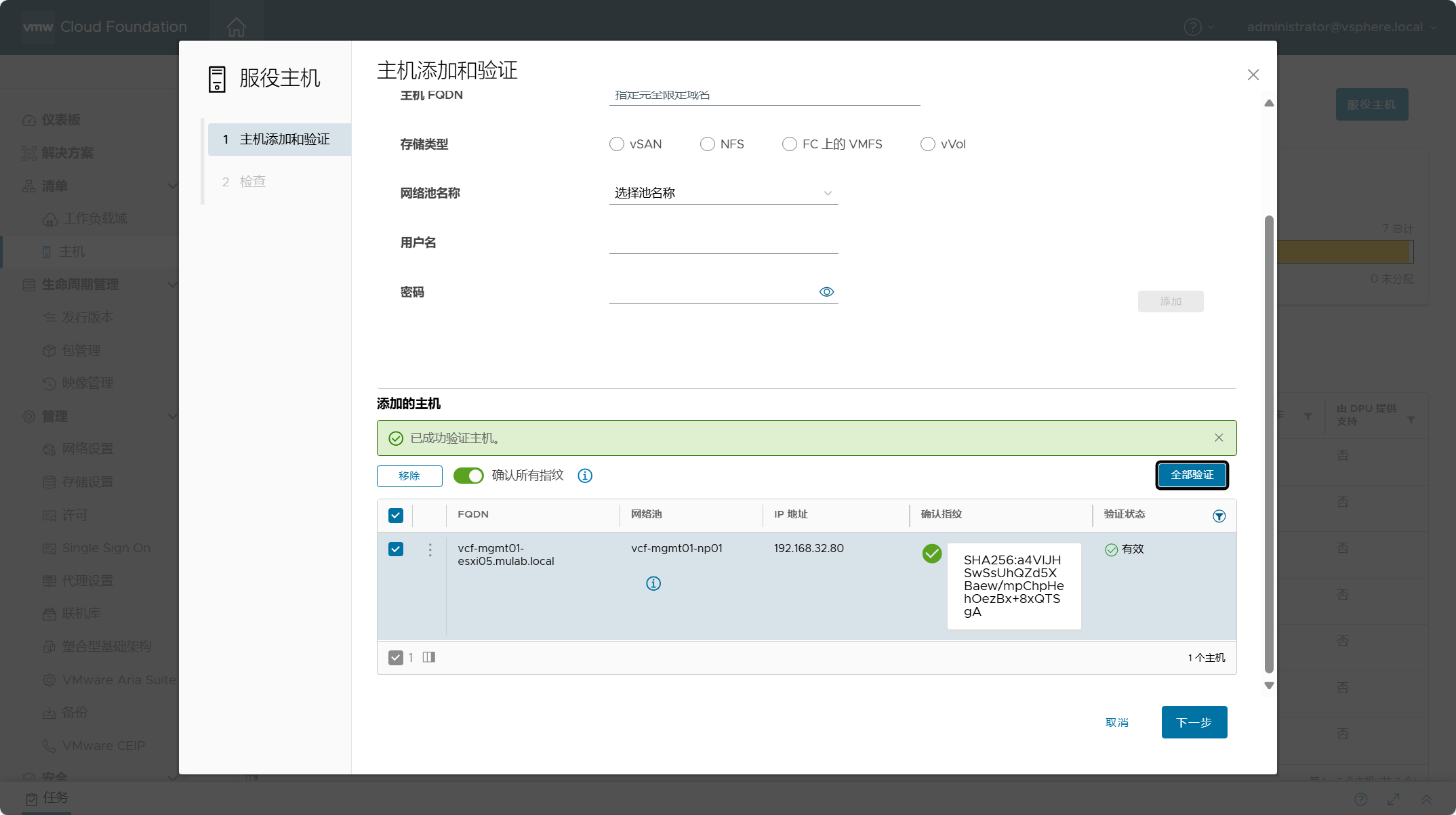

验证成功,点击下一步。

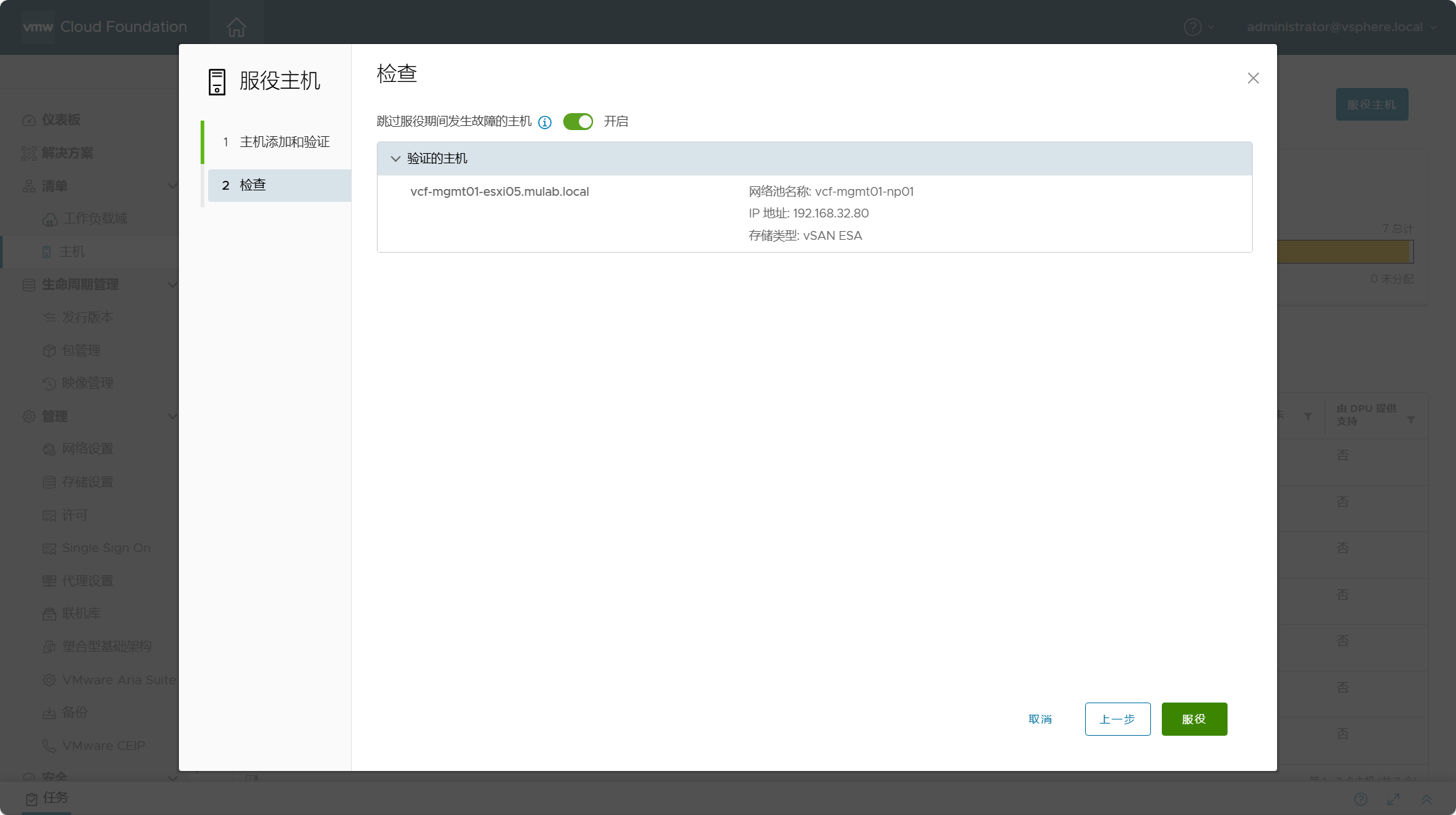

检查主机,点击服役。

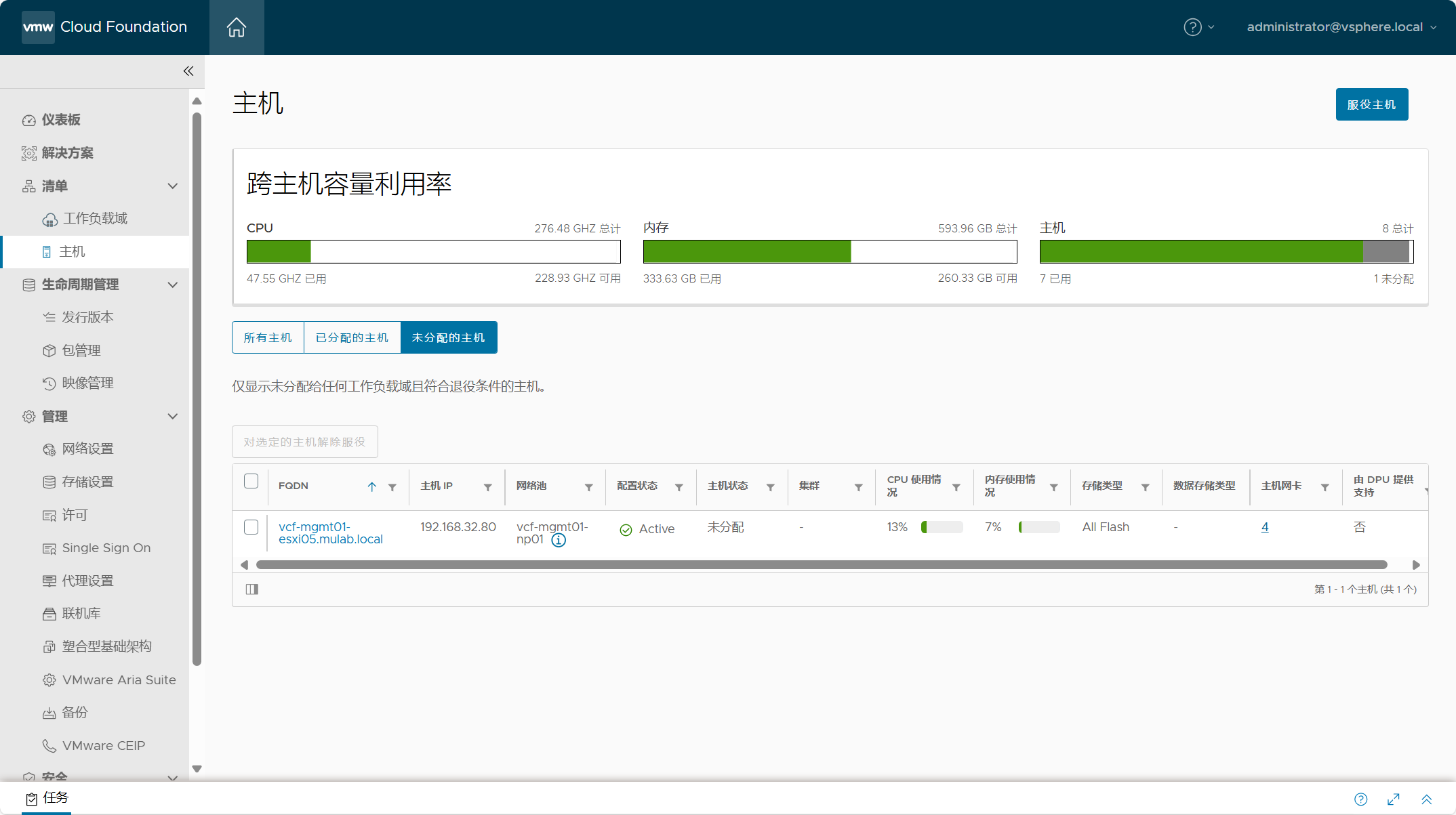

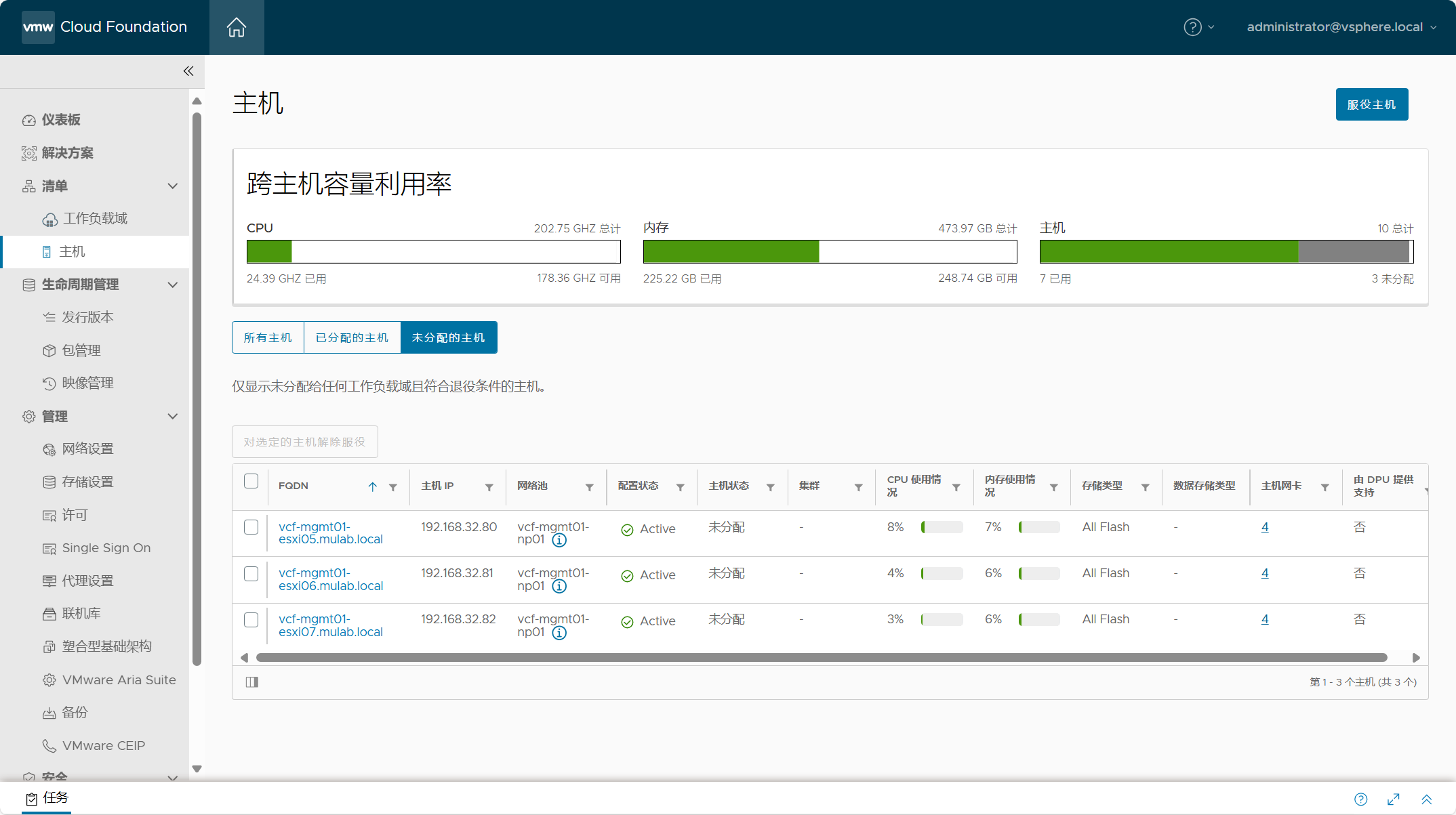

如果一切顺利,在“未分配的主机”中可以看到刚才添加的 ESXi 主机。

三、工作负载域中添加主机

在向工作负载域中的集群添加主机之前,请确保 ESXi 主机已经添加到服役主机当中,并且是“未分配”状态。

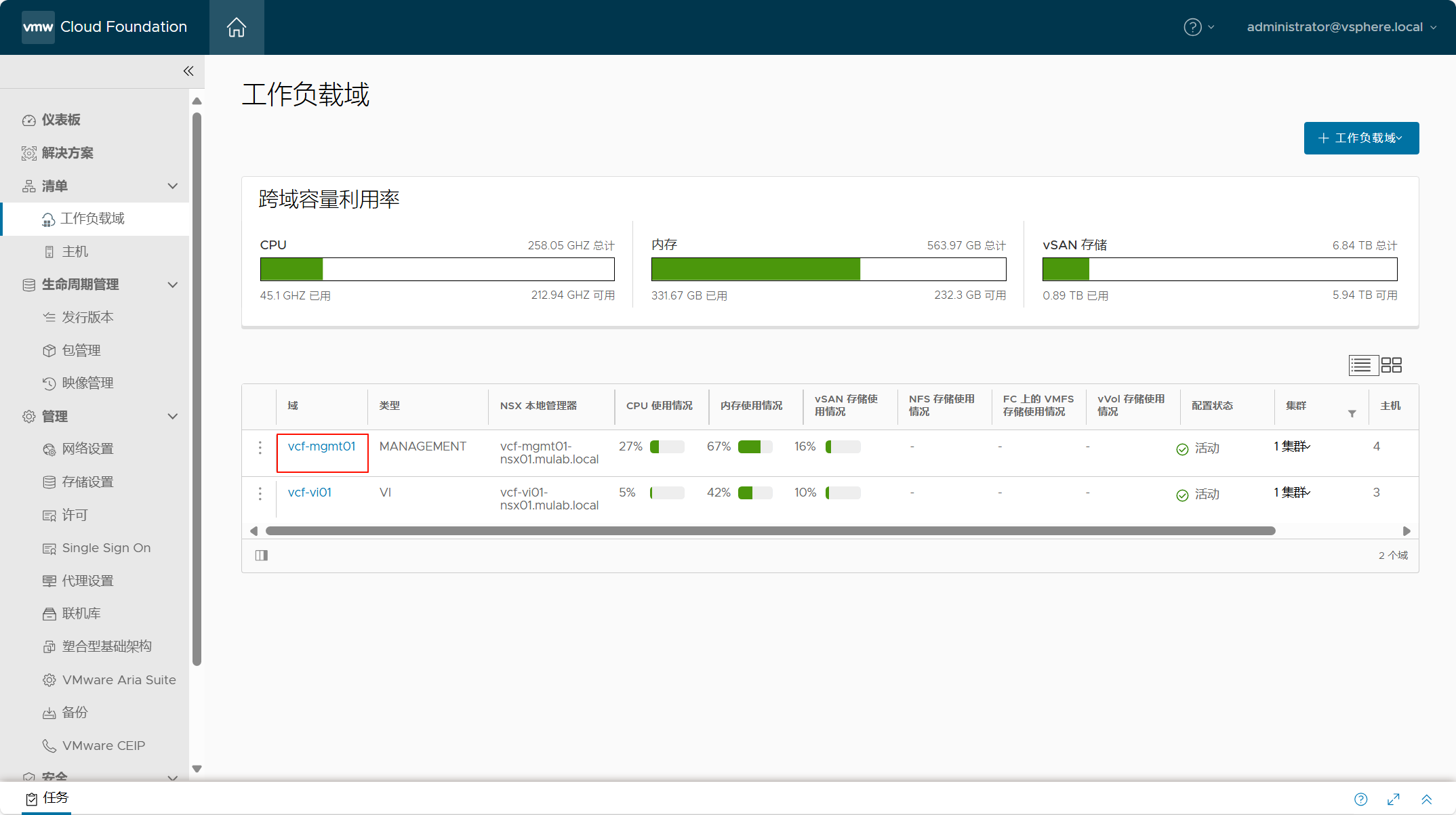

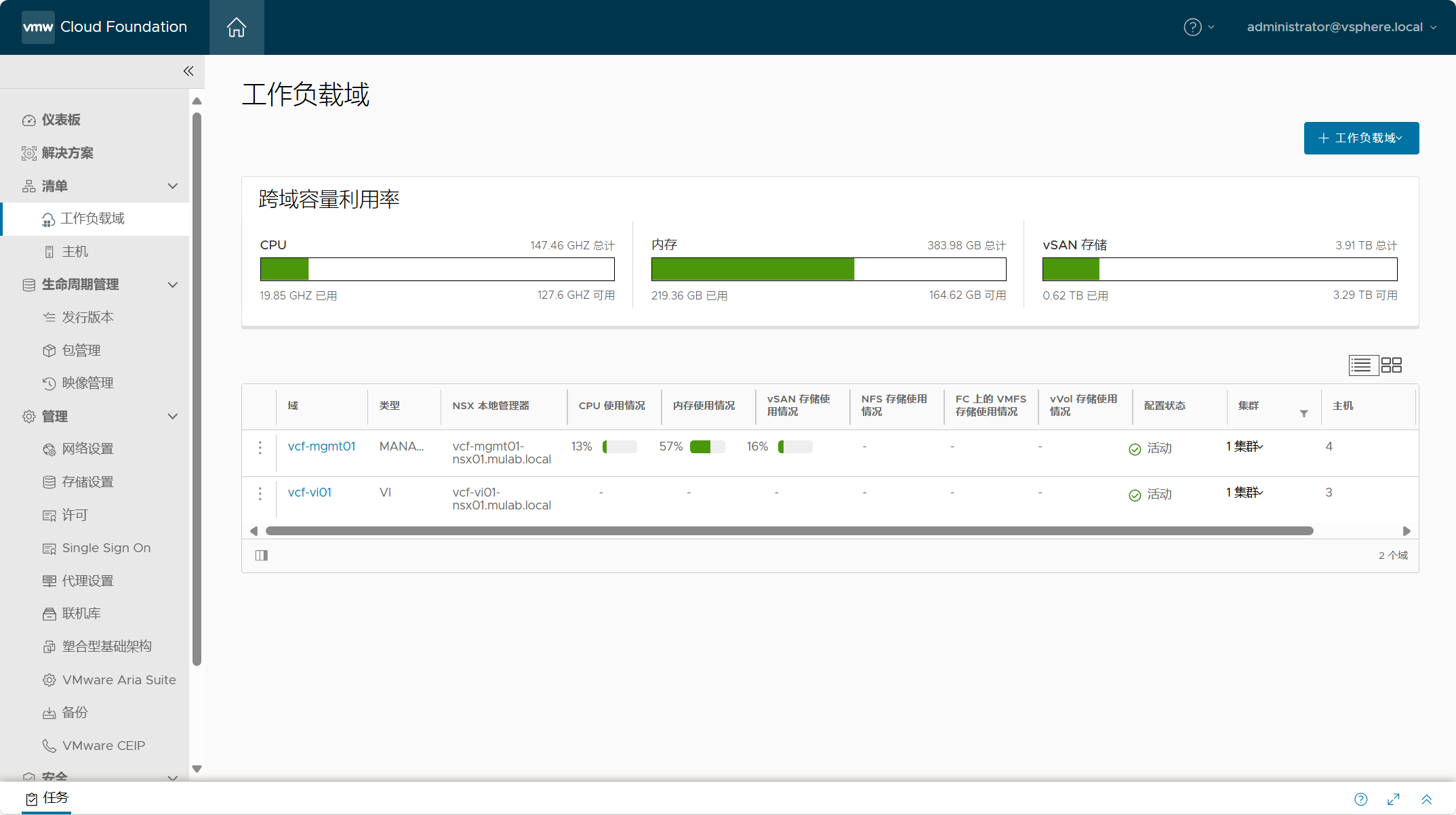

导航到 SDDC Manager->清单->工作负载域,点击需要添加主机的工作负载域。

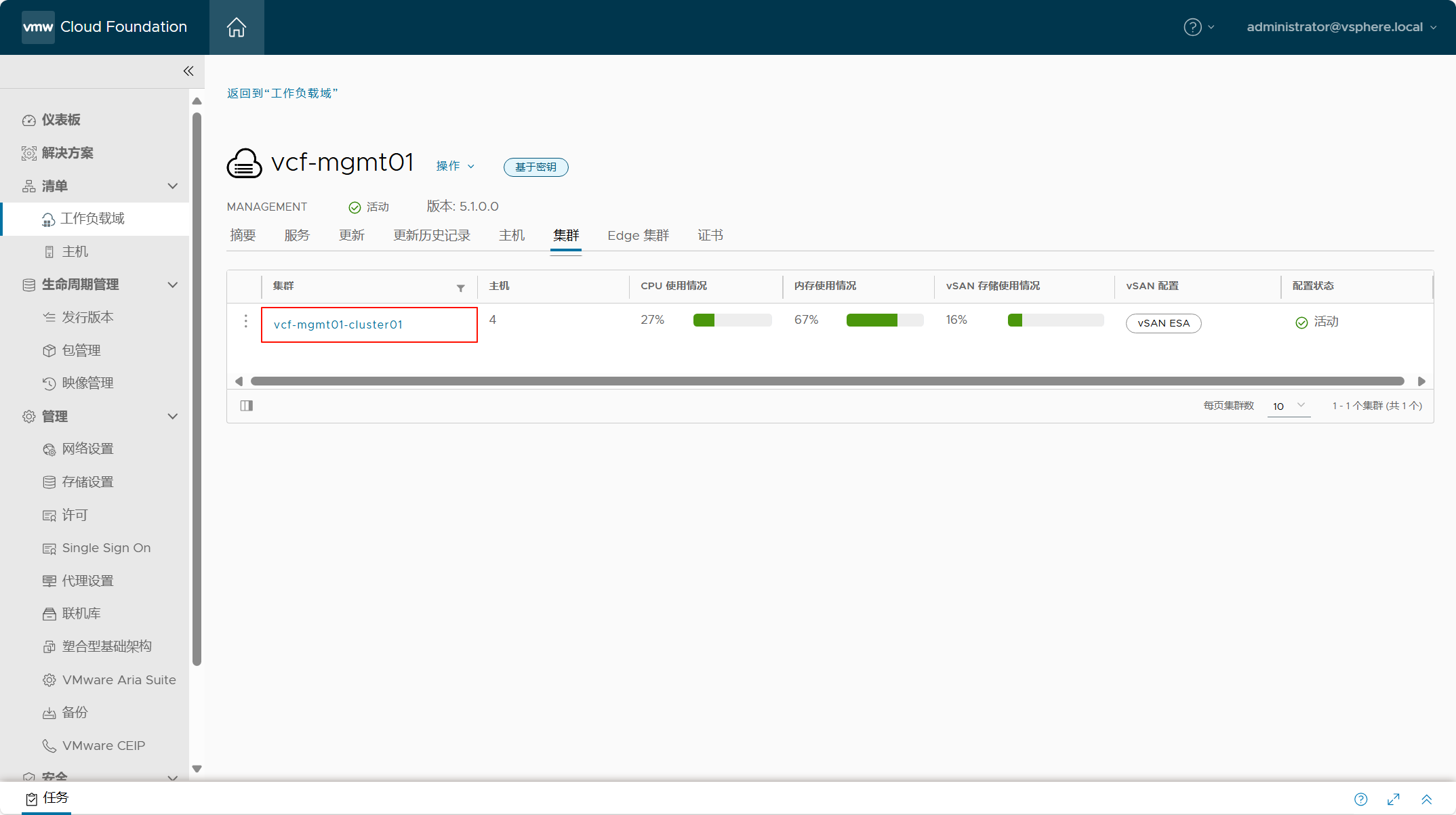

点击当前工作负载域的“集群”选项卡,点击需要添加主机的集群。

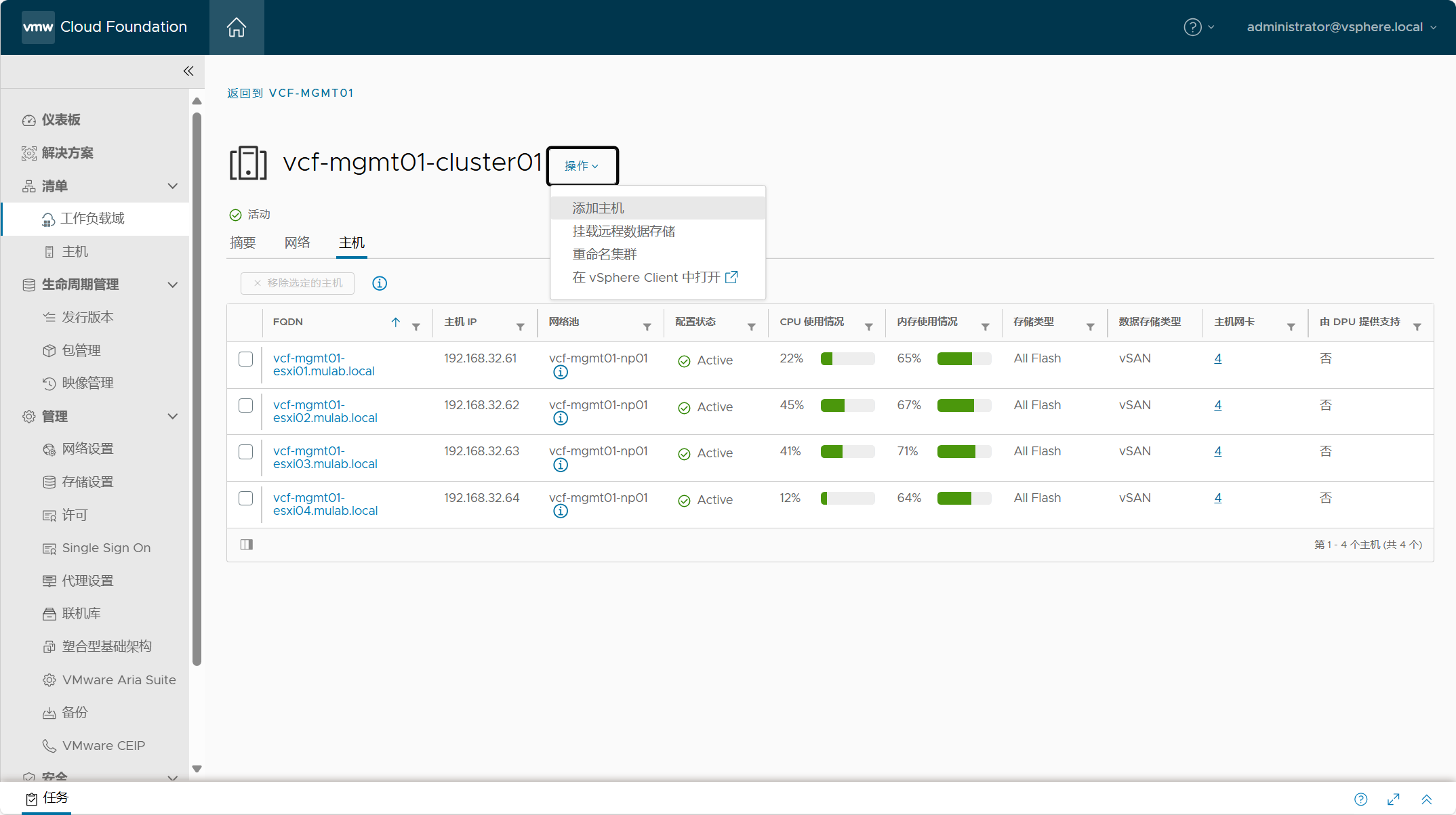

点击当前集群中的“操作”,选择“添加主机”。

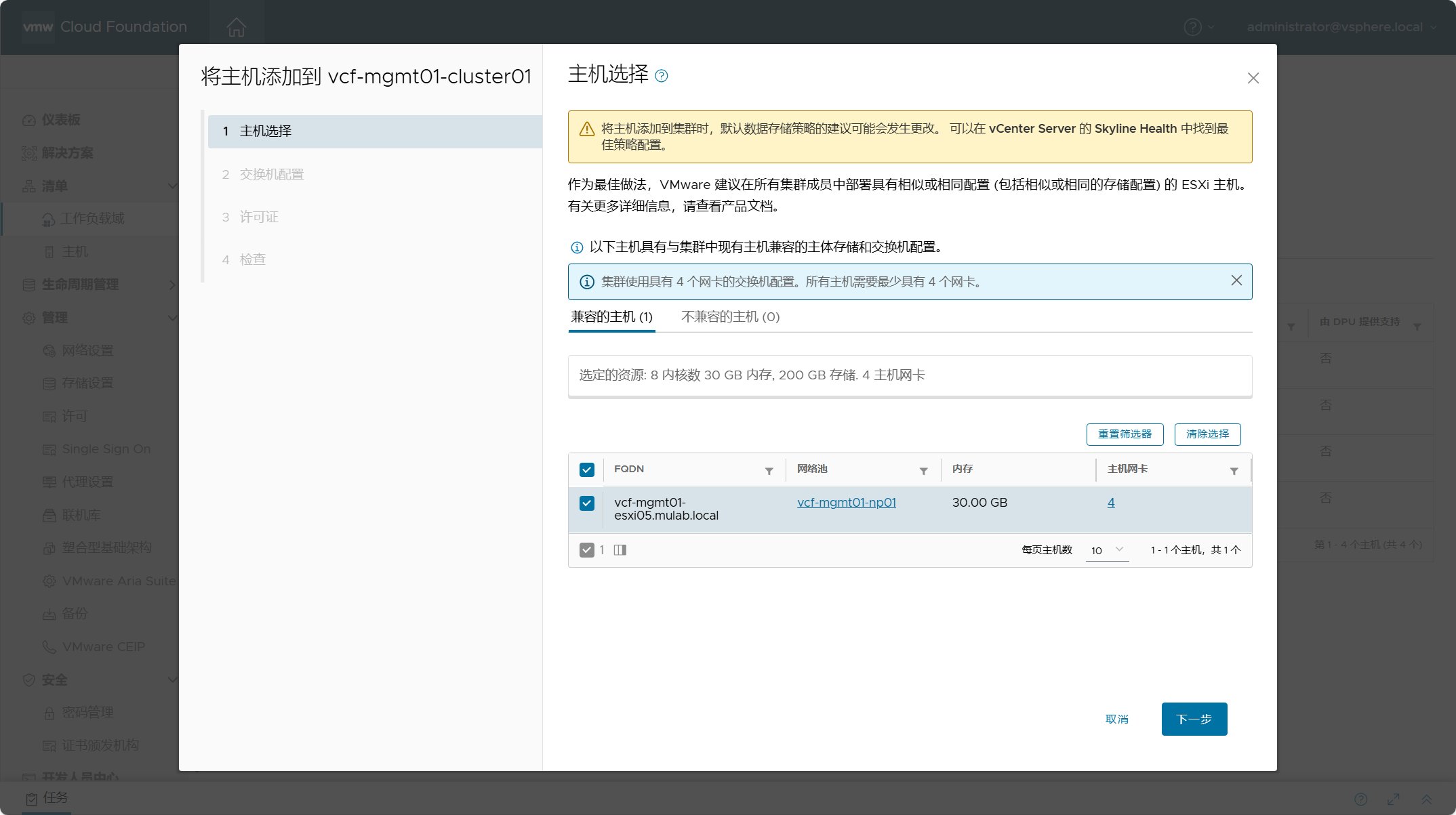

当 SDDC Manager 服役主机清单中没有可用的主机,会提示报错并要求你先添加主机;如果清单中具有可用的主机,则添加主机工作流才能正常继续。勾选用于当前集群的主机,点击下一步。

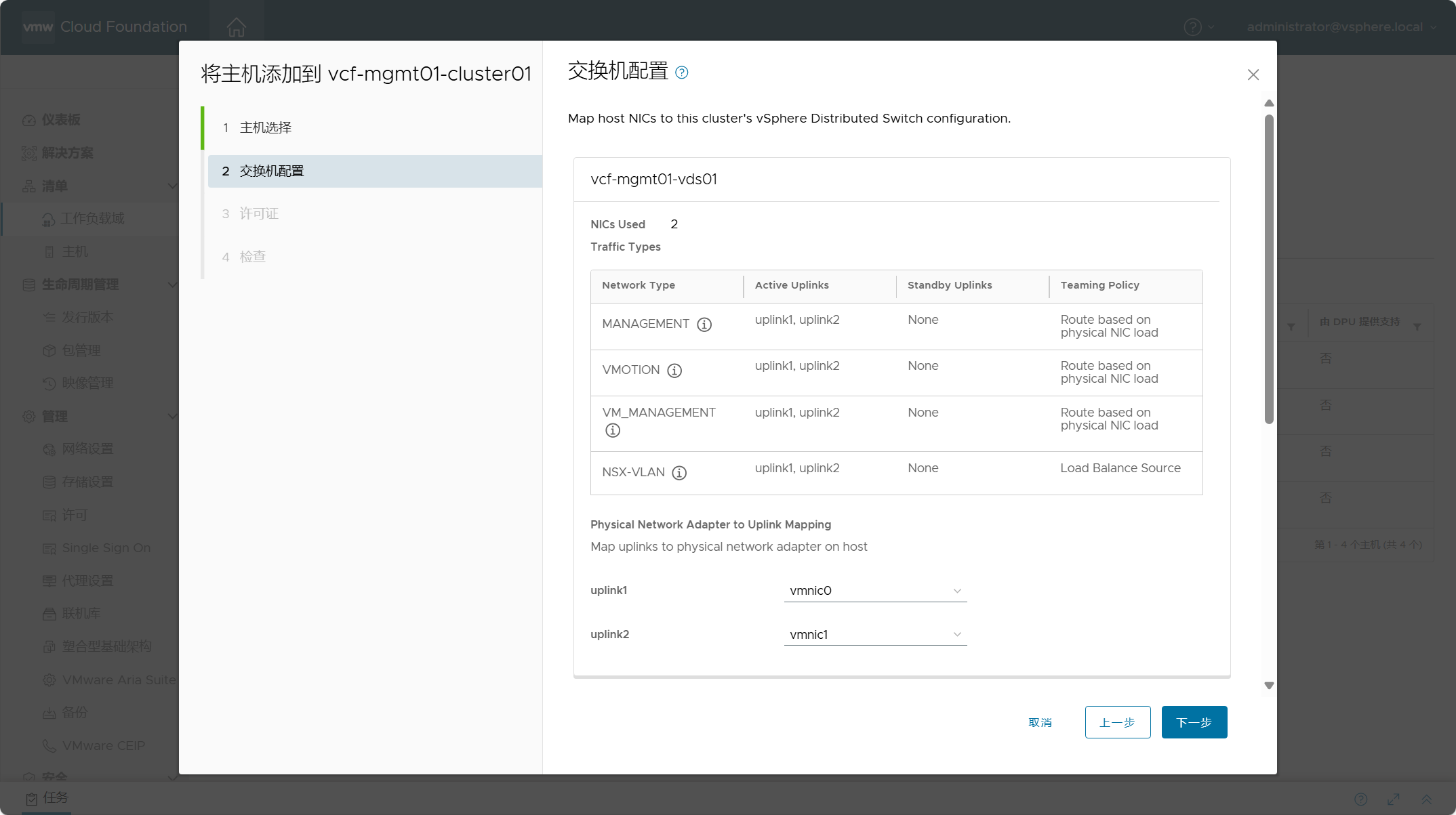

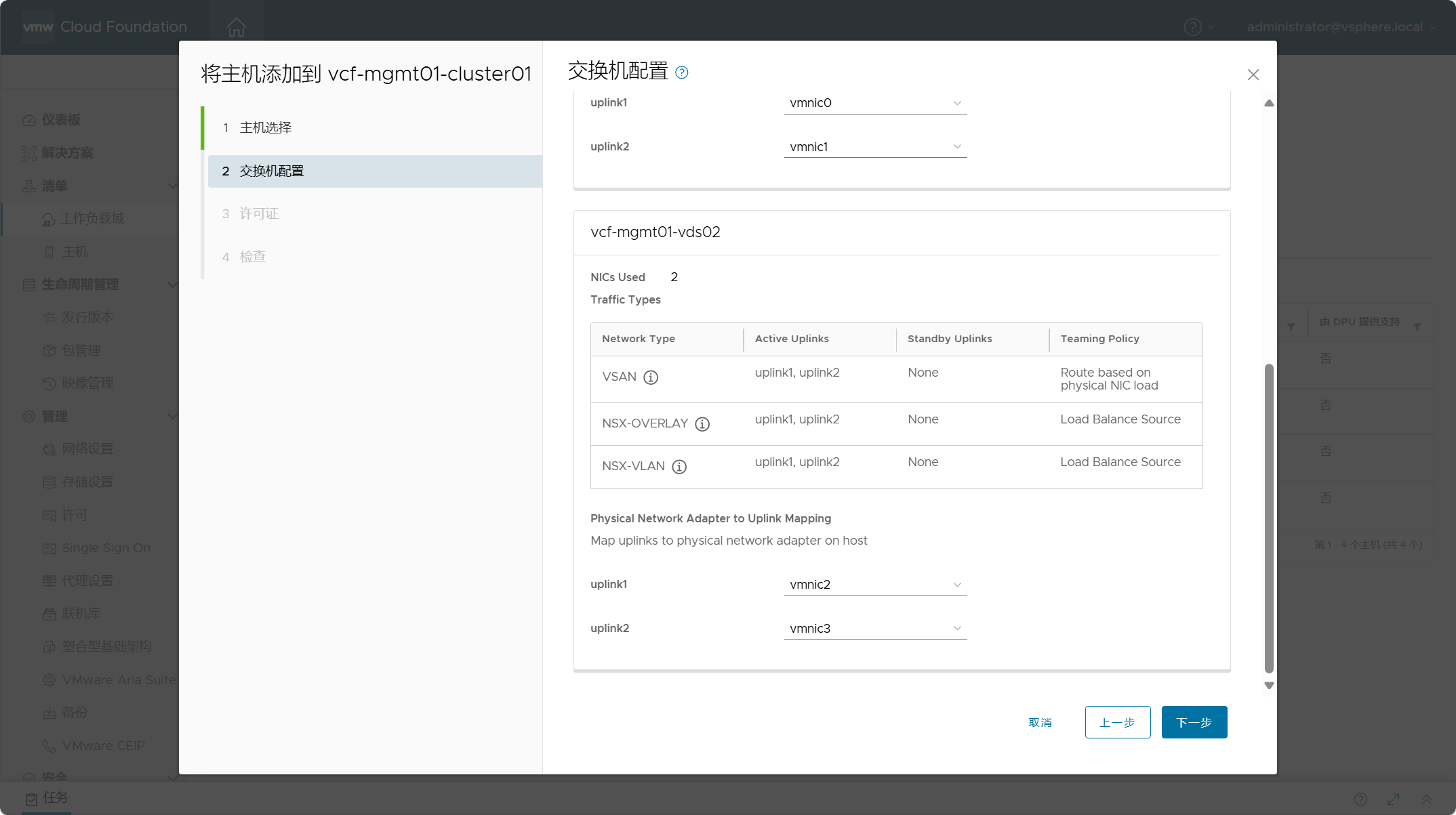

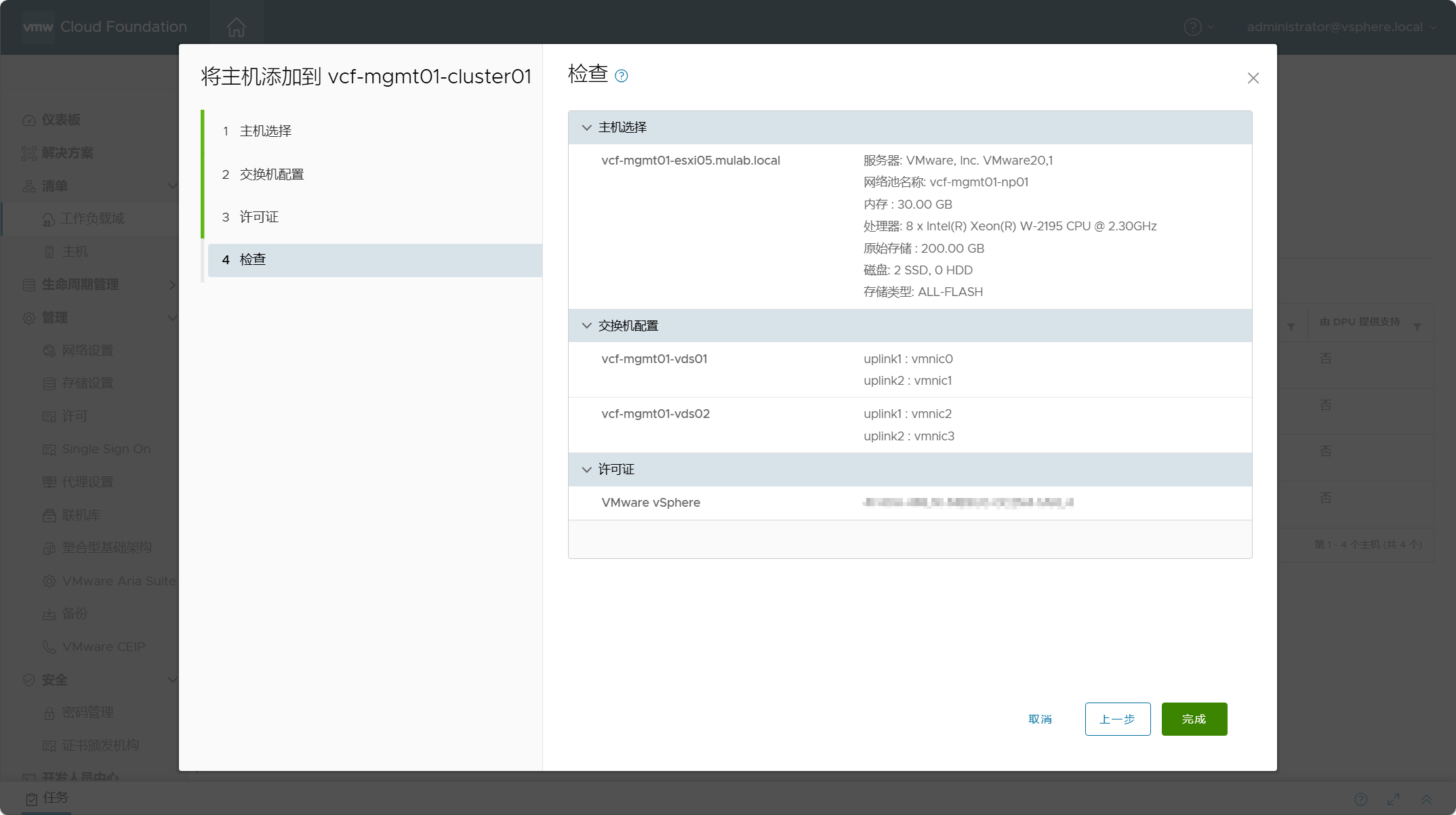

配置 ESXi 主机的虚拟交换机。当前集群具有两个分布式交换机,每个交换机具有两个上行链路,所以要求添加的 ESXi 主机具有四张网卡,这个根据不同环境的情况而定,选择 ESXi 主机上的网卡应用于不同交换机的网络类型。

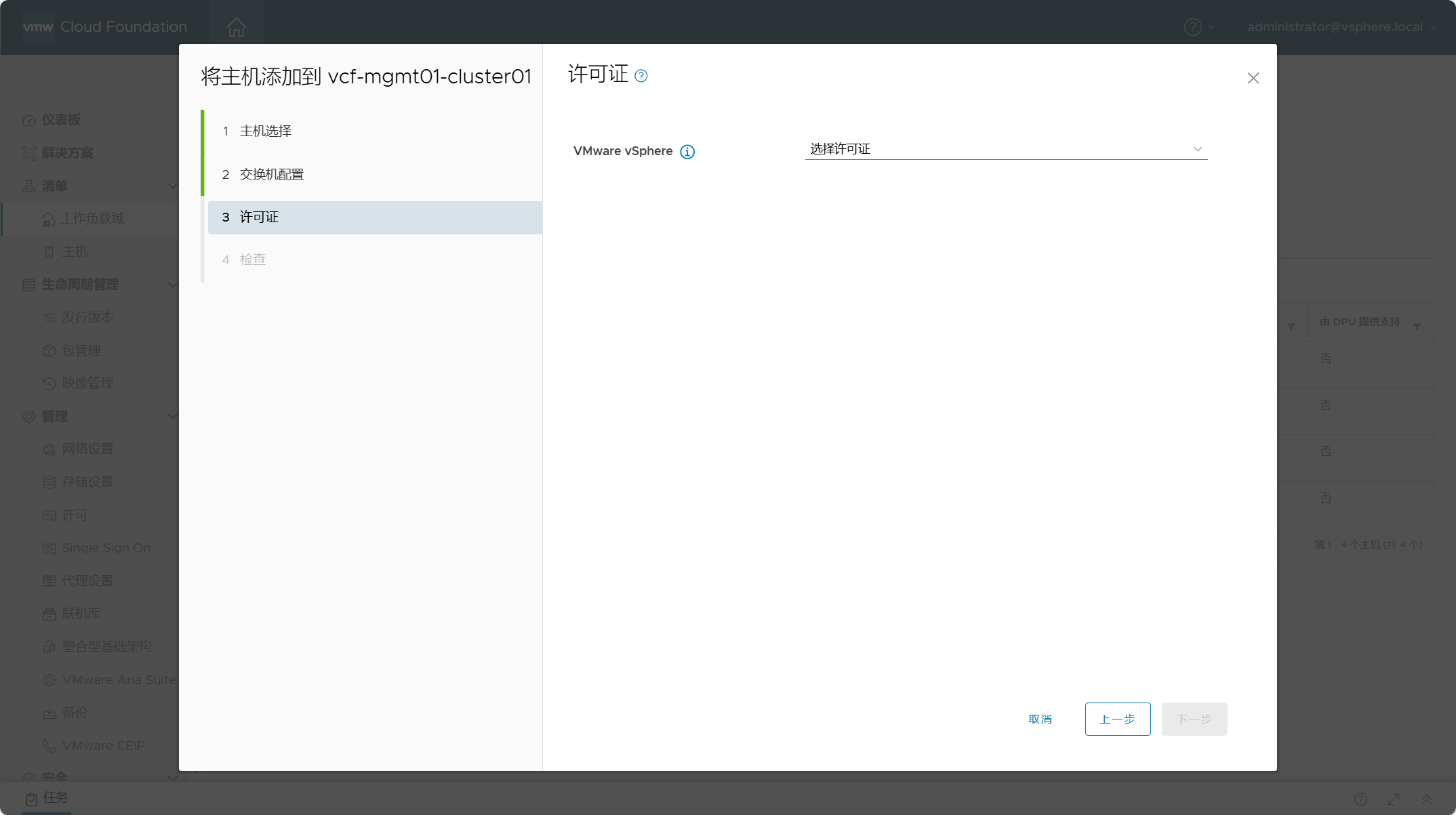

配置 ESXi 主机的许可证。

检查所有配置,点击完成。

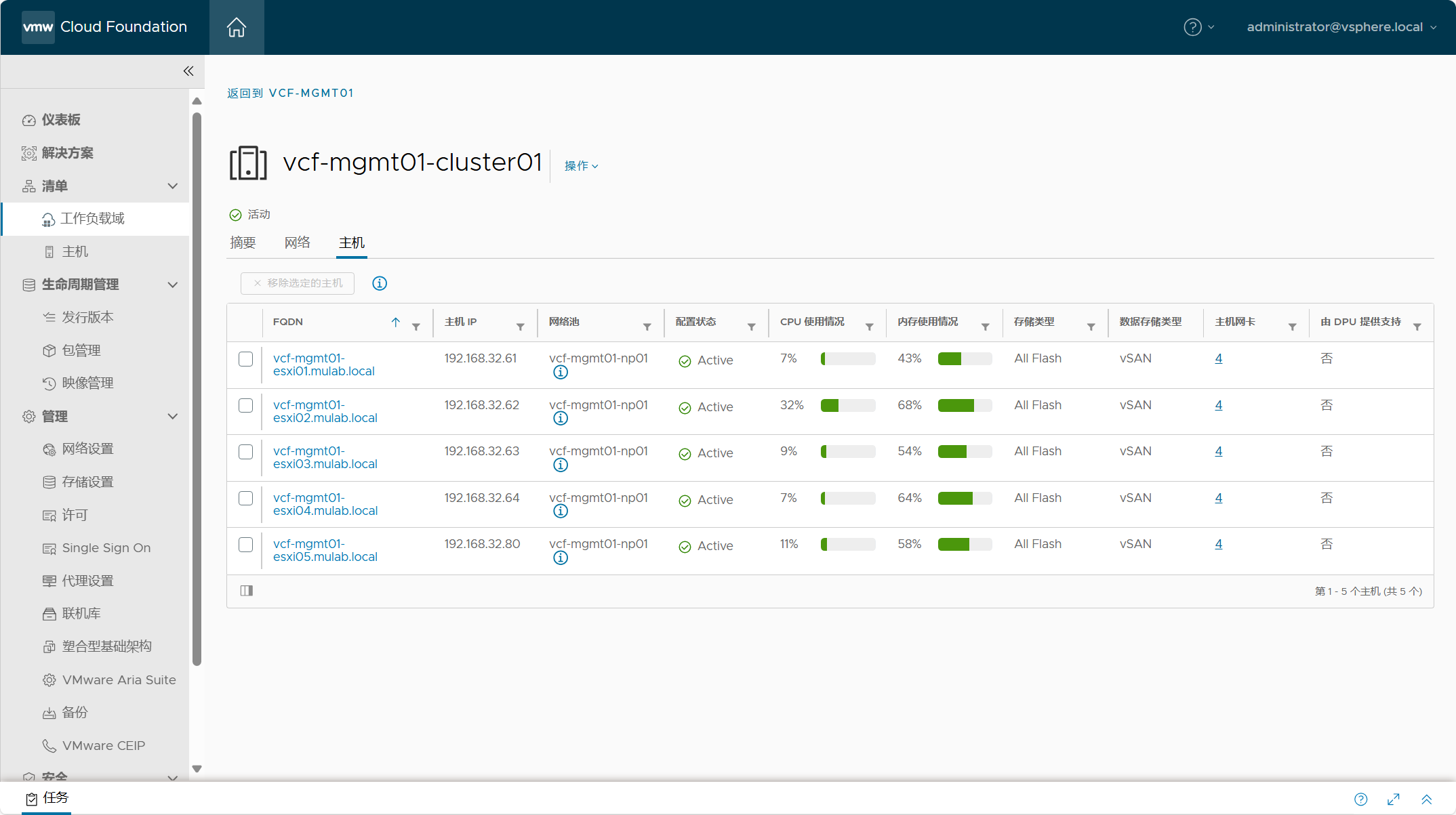

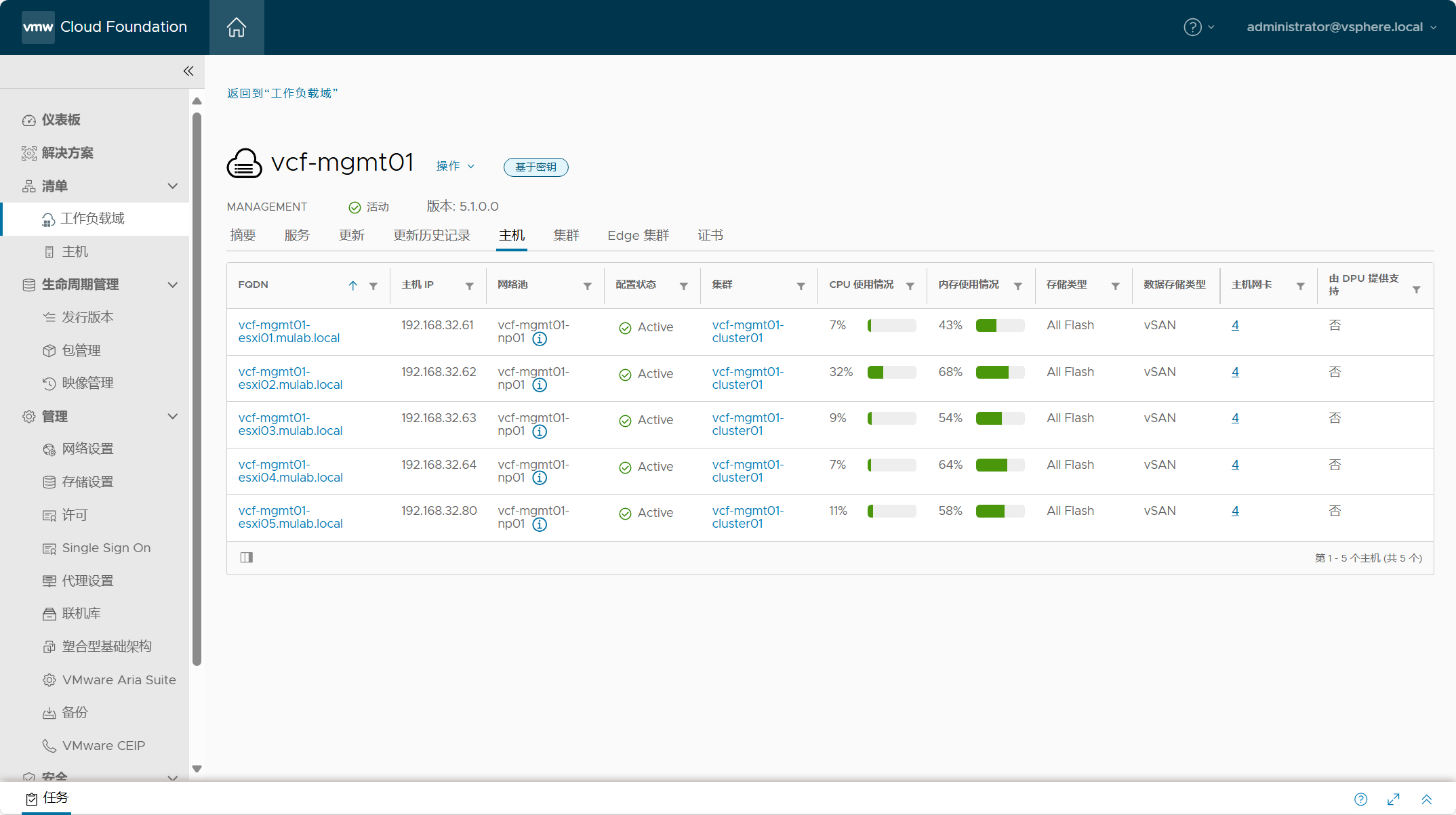

如果一切顺利,可以看到主机已被添加到工作负载域中。

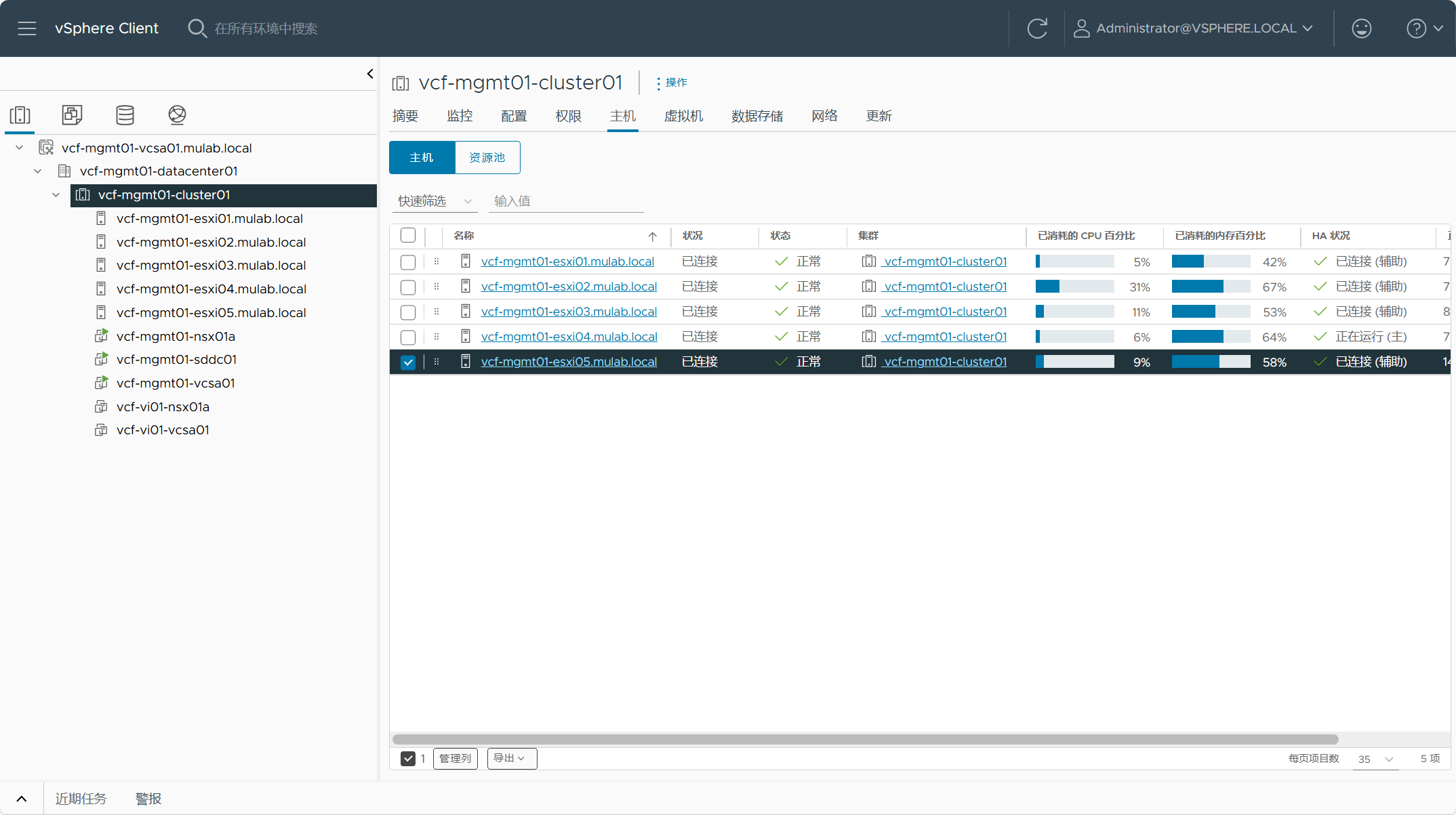

工作负载域所在的 vCenter Server UI 可以看到所添加的主机。

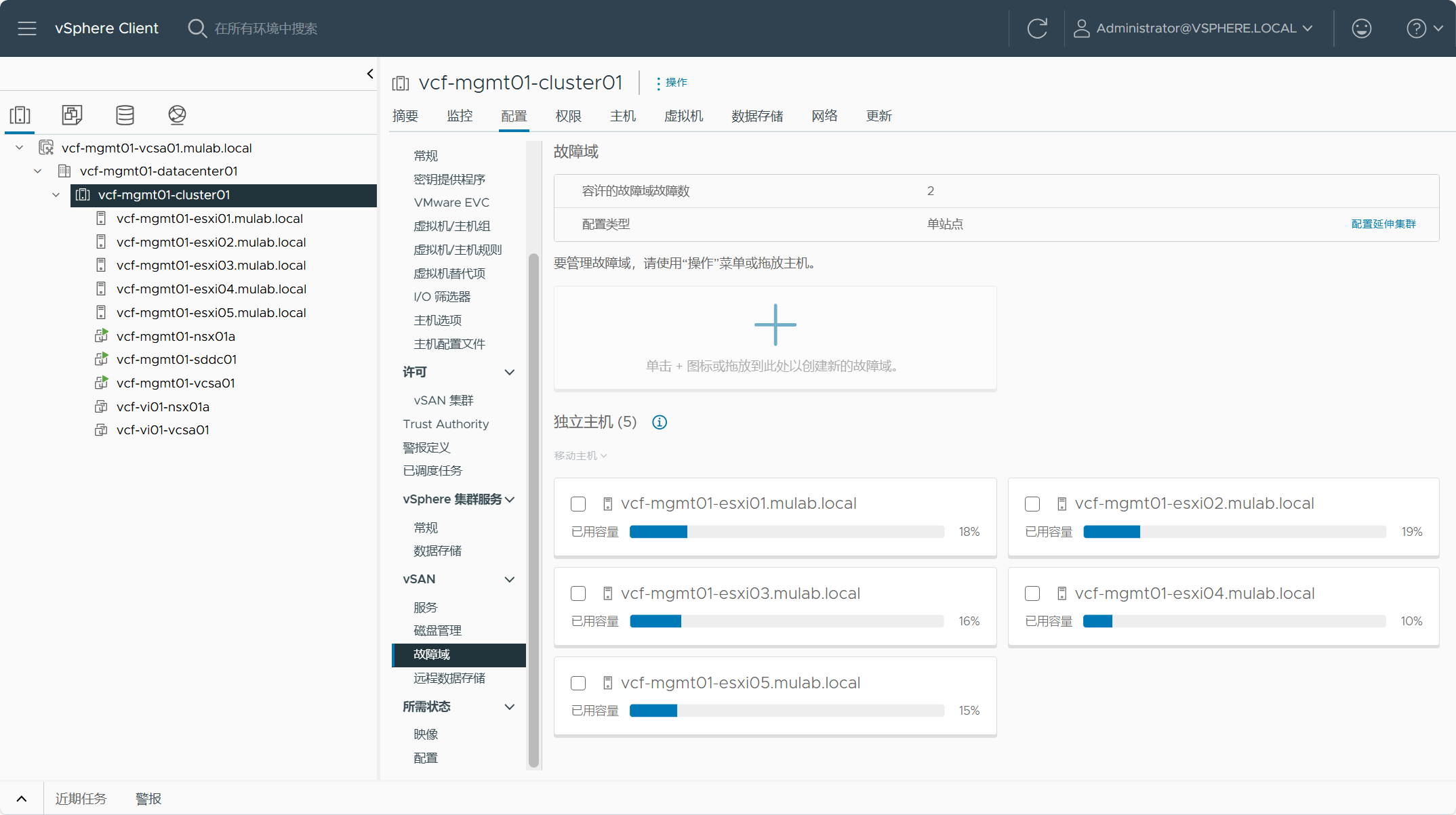

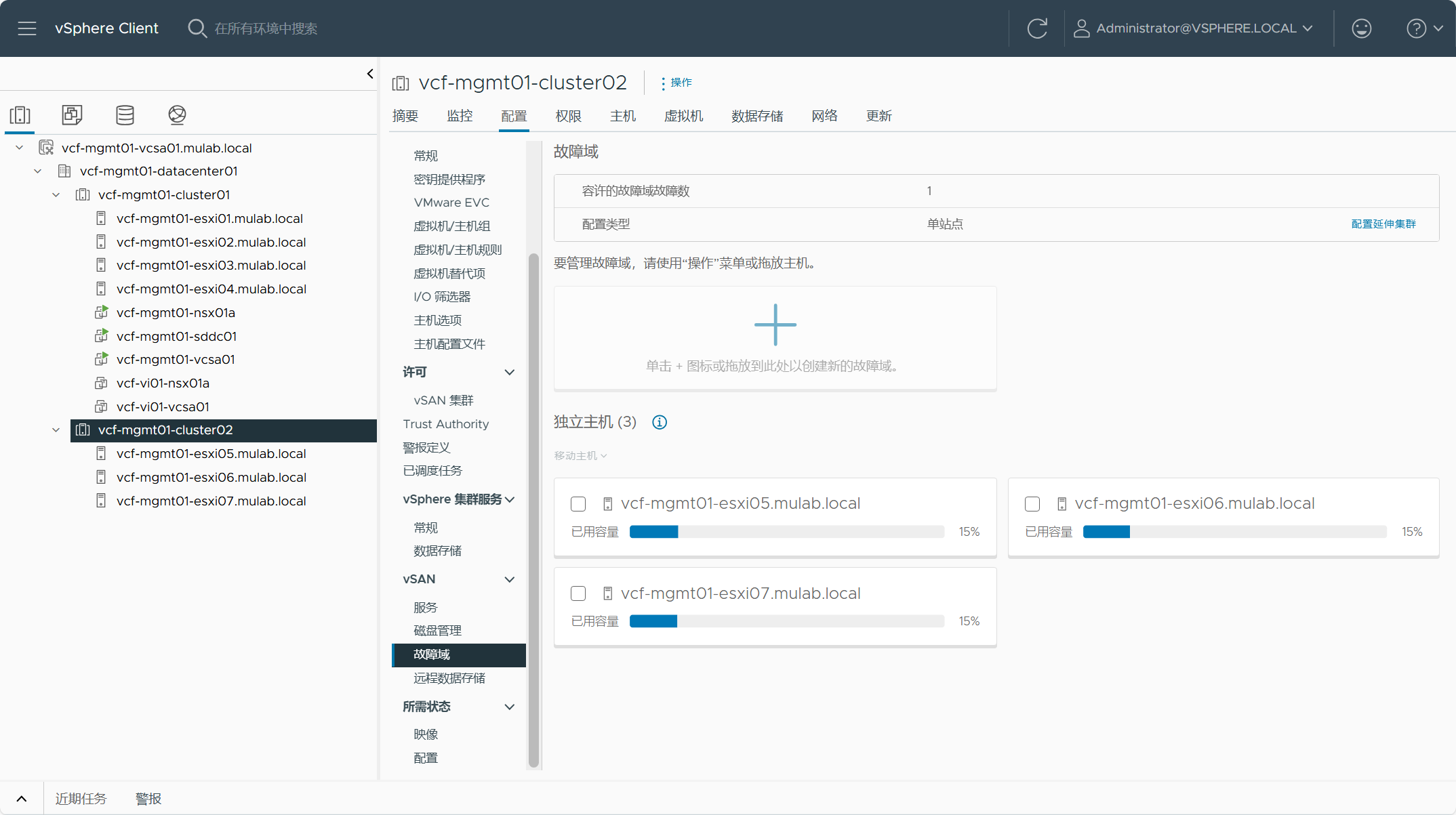

主机已被添加至 vSAN 故障域中。

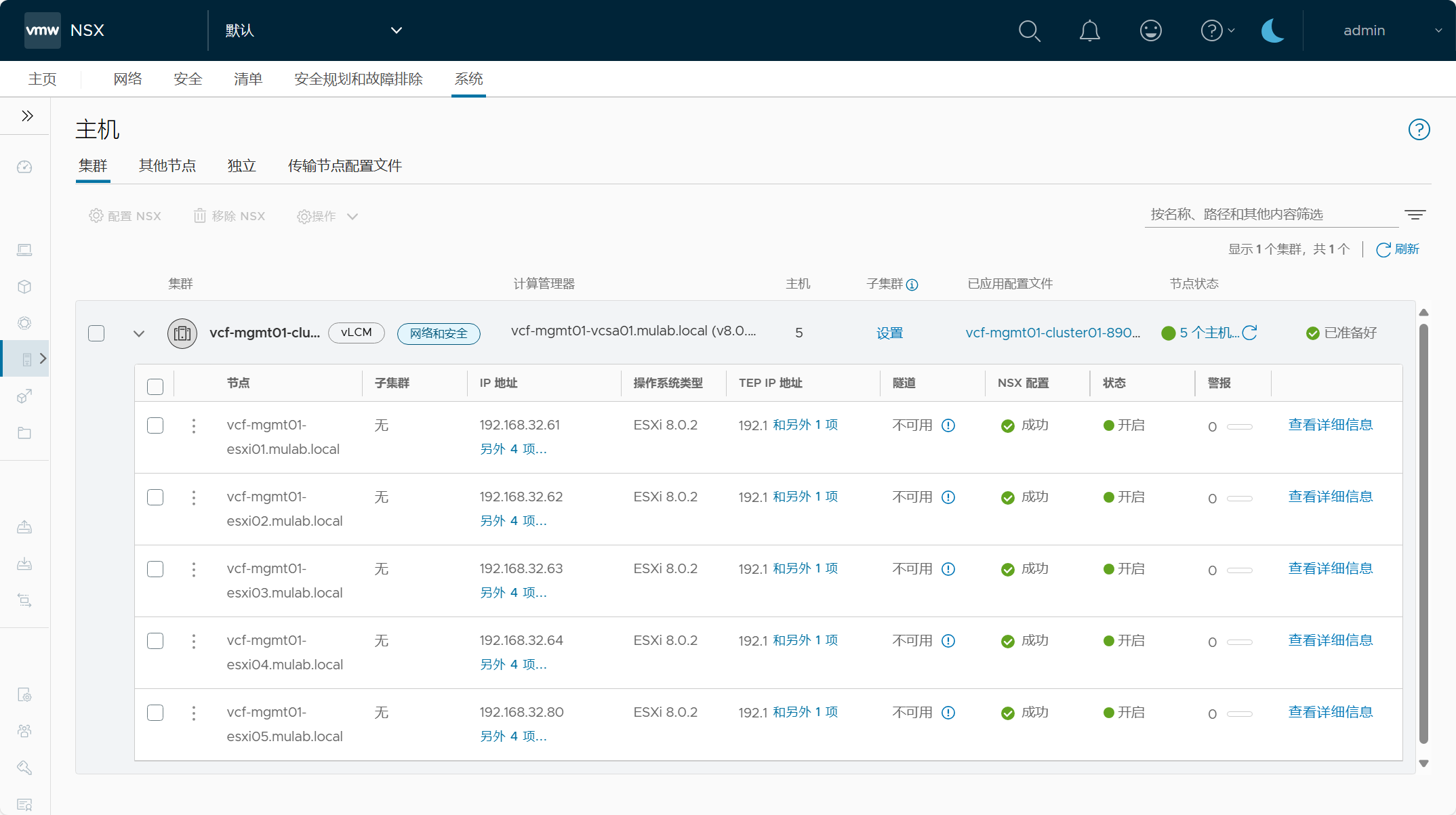

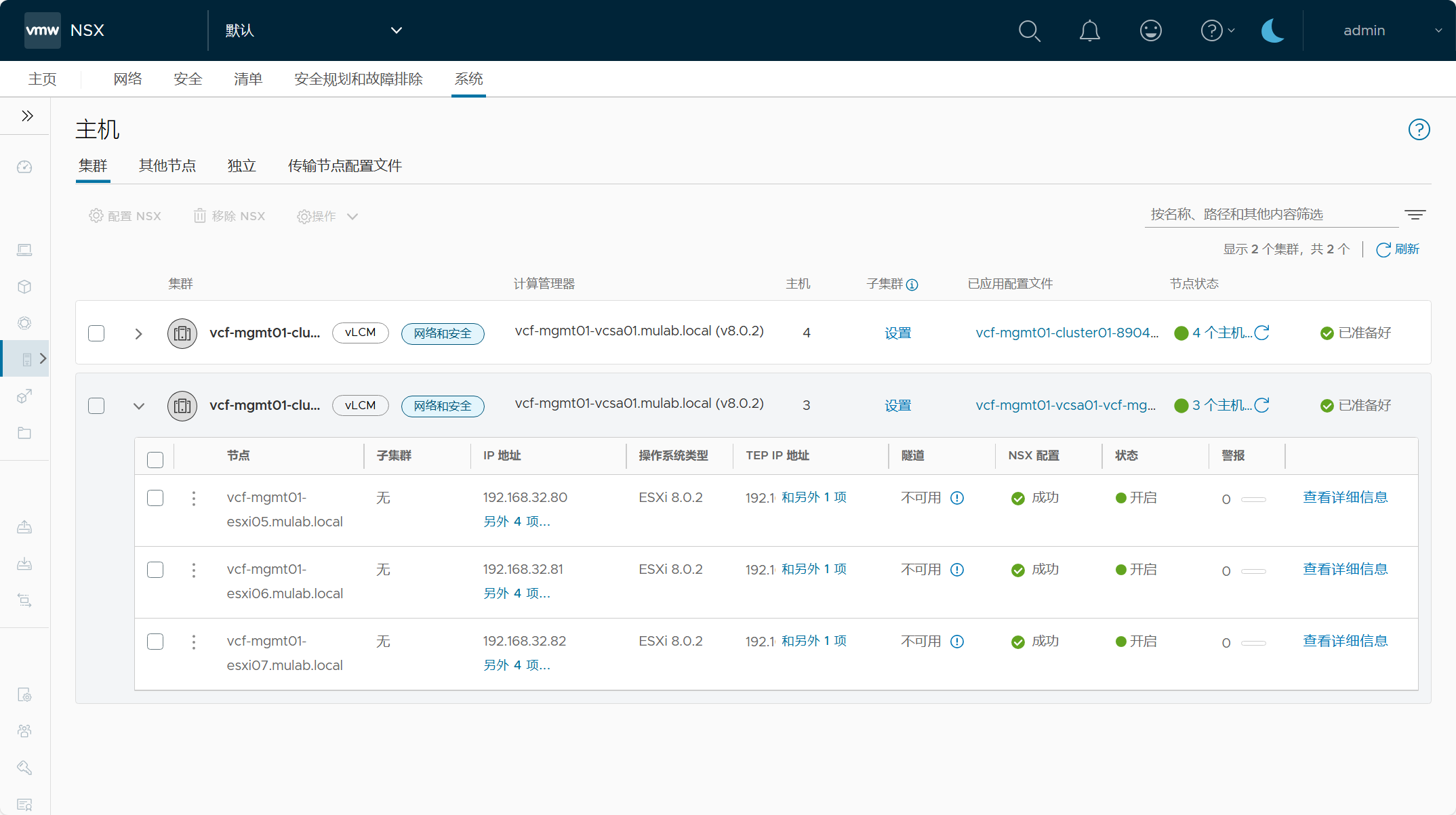

主机已被配置为 NSX 传输节点。

四、工作负载域中删除主机

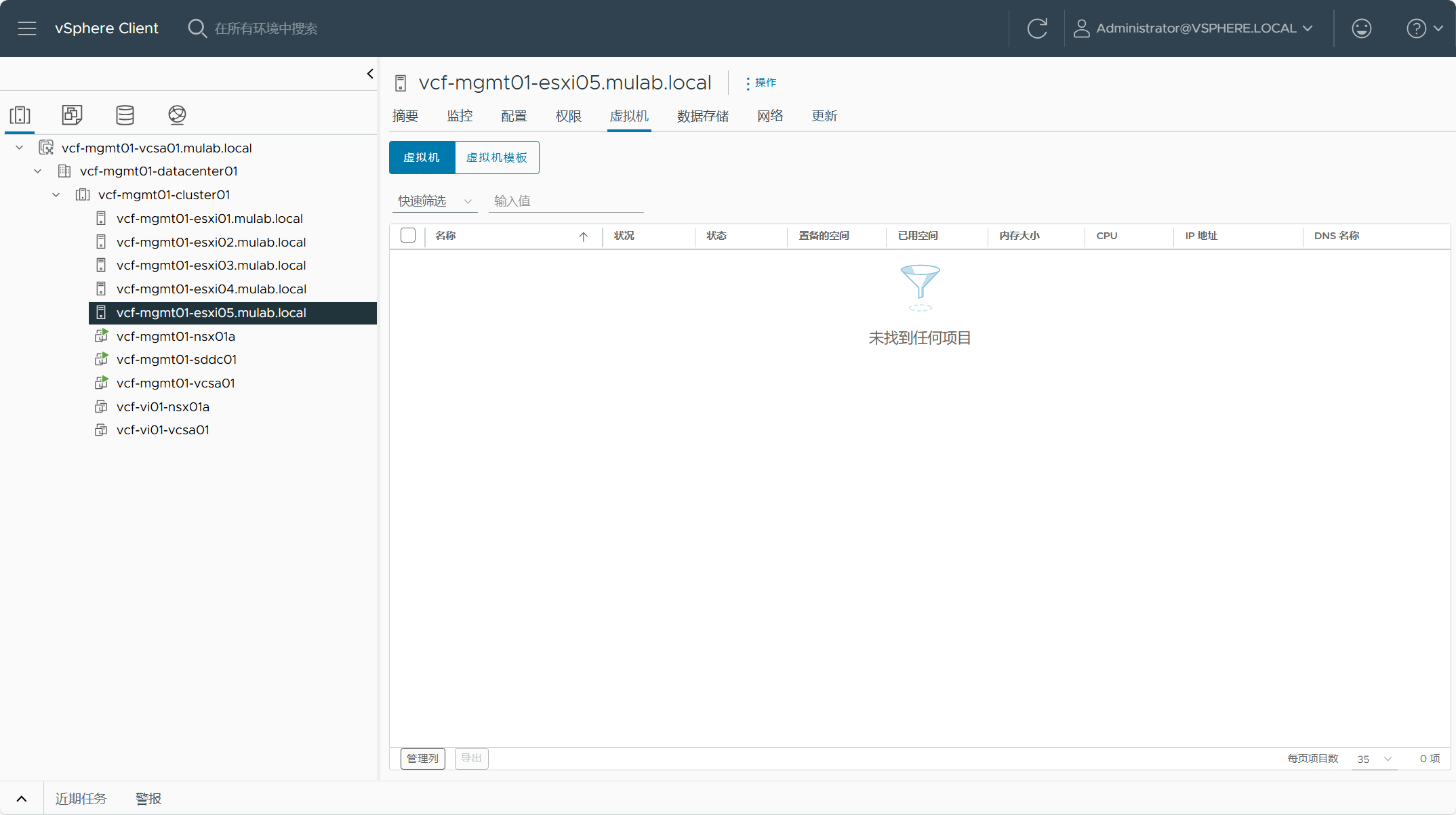

工作负载域中删除不需要的主机,整个过程相对来说要比添加主机的过程要简单的多。首先,确保要移除的所在主机上没有运行任何工作负载。因为是 vSAN 集群,在移除主机后,虚拟机可能会变得不合规,根据虚拟机所使用的不同存储策略的情况而定。所以,在调整了集群内的主机后,请修改虚拟机的存储策略使其符合当前集群可用的存储策略。

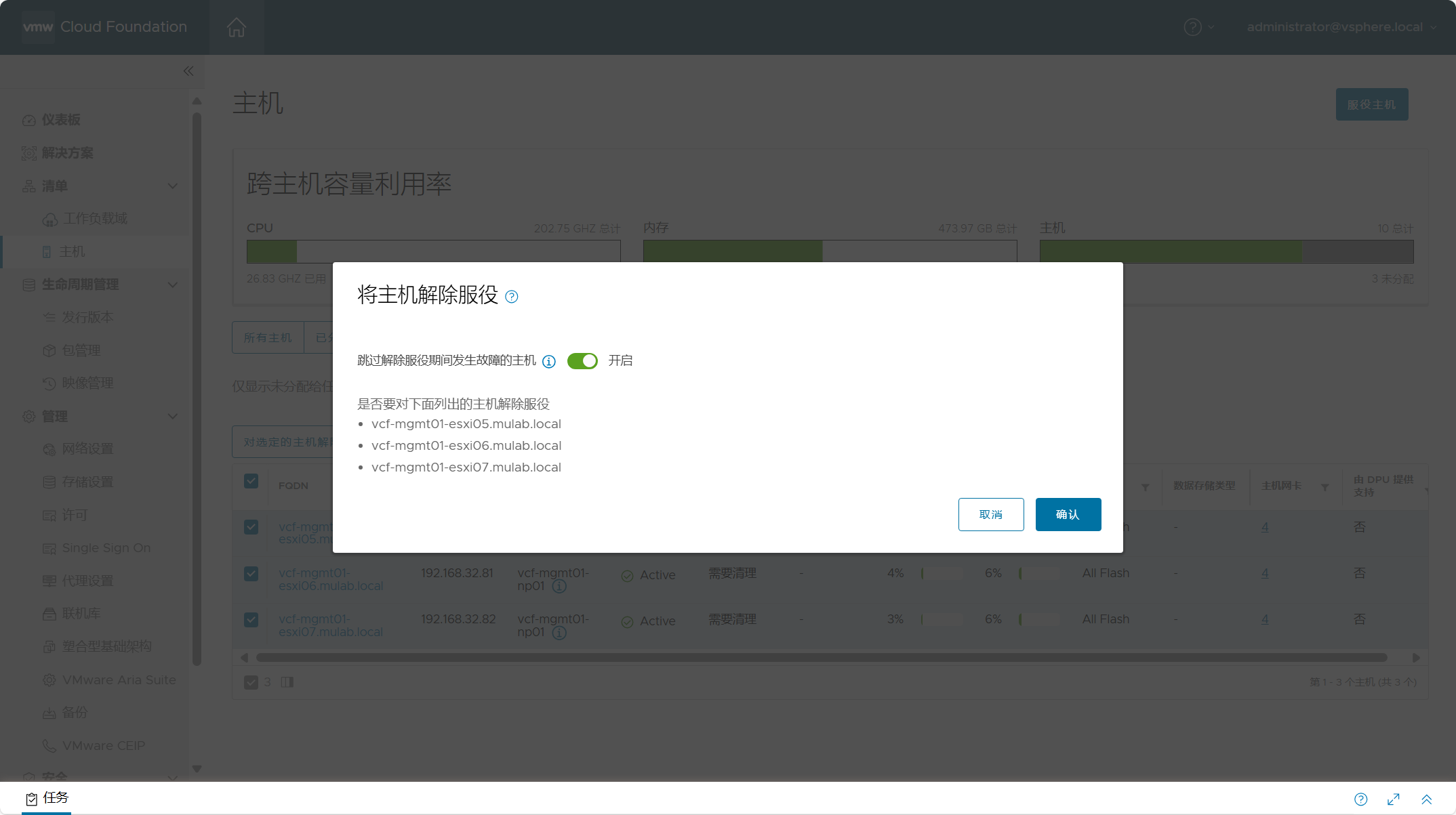

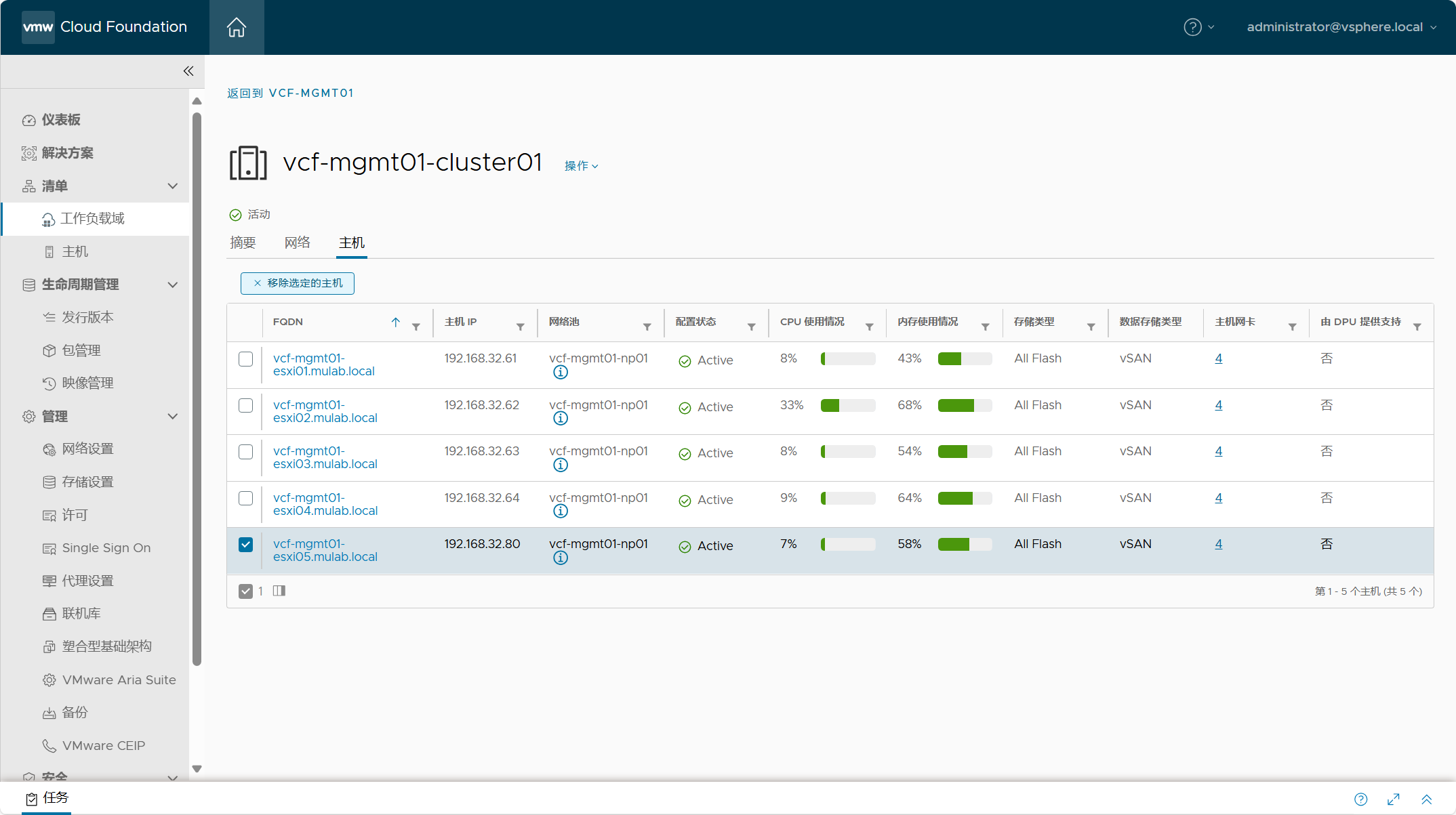

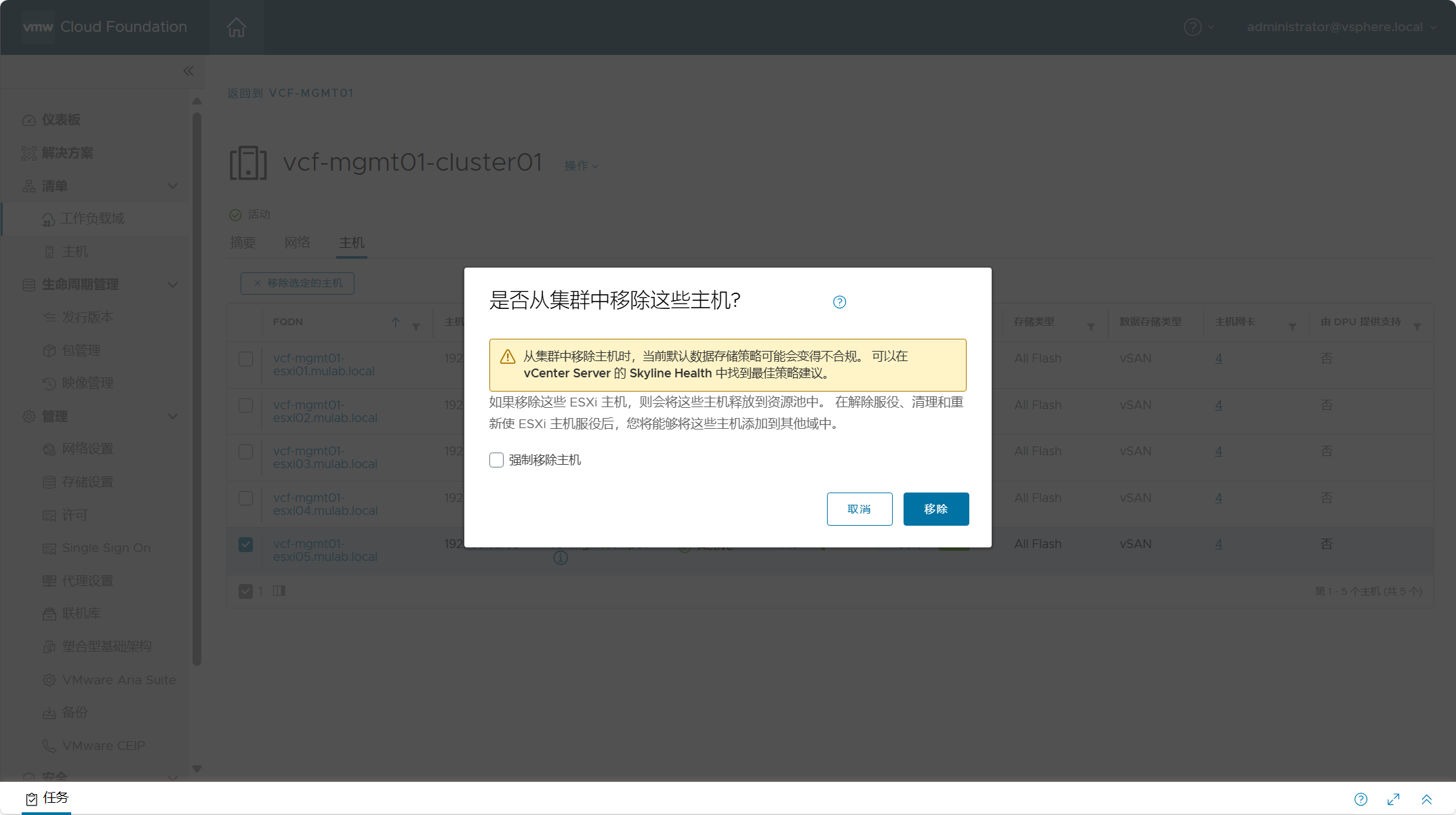

导航到 SDDC Manager->主机所在工作负载域->主机所在集群->主机,勾选所需移除的主机,然后点击“移除选定的主机”。

确定移除。

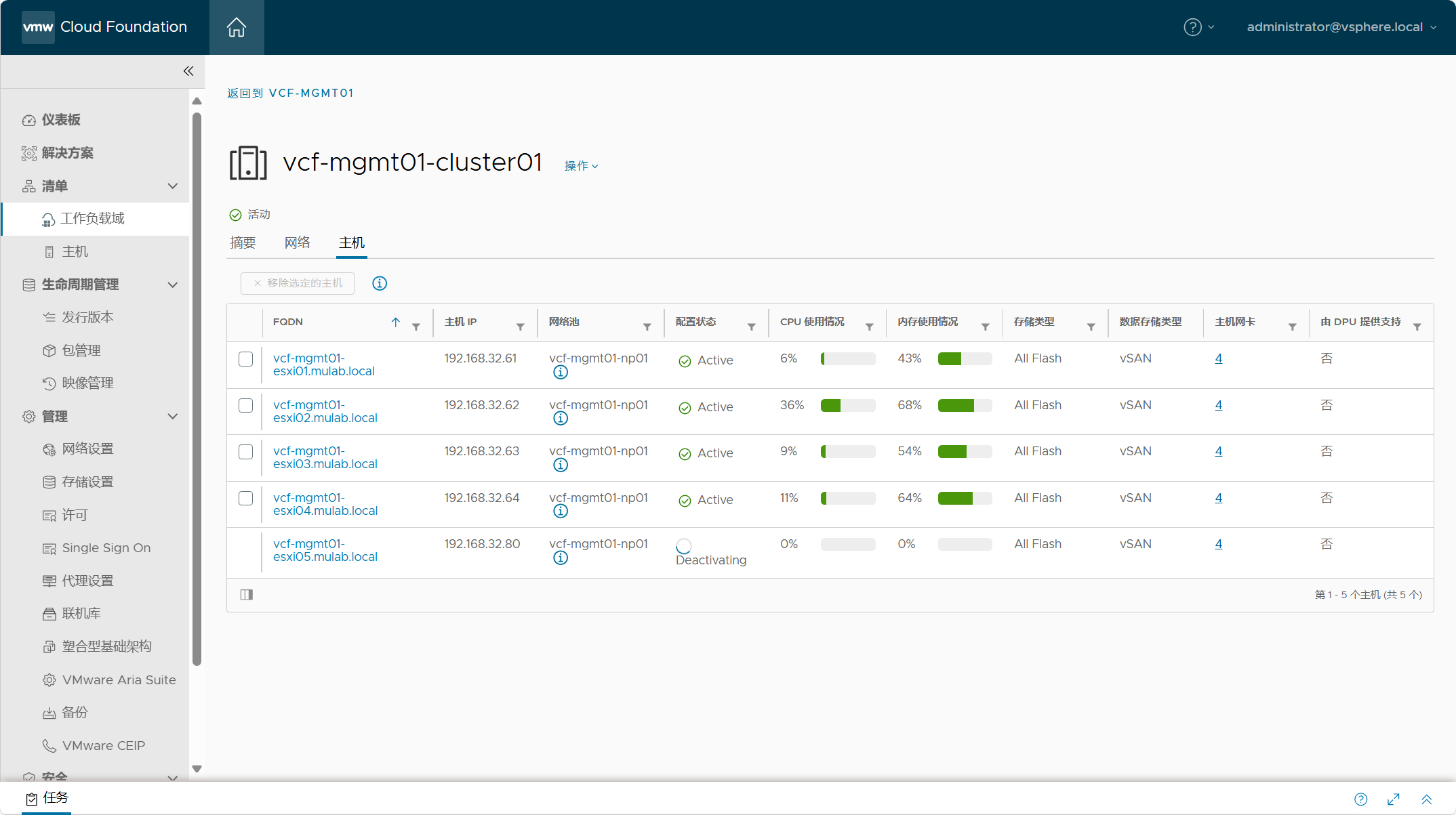

移除中......。如果一切顺利,主机会从集群中移除。

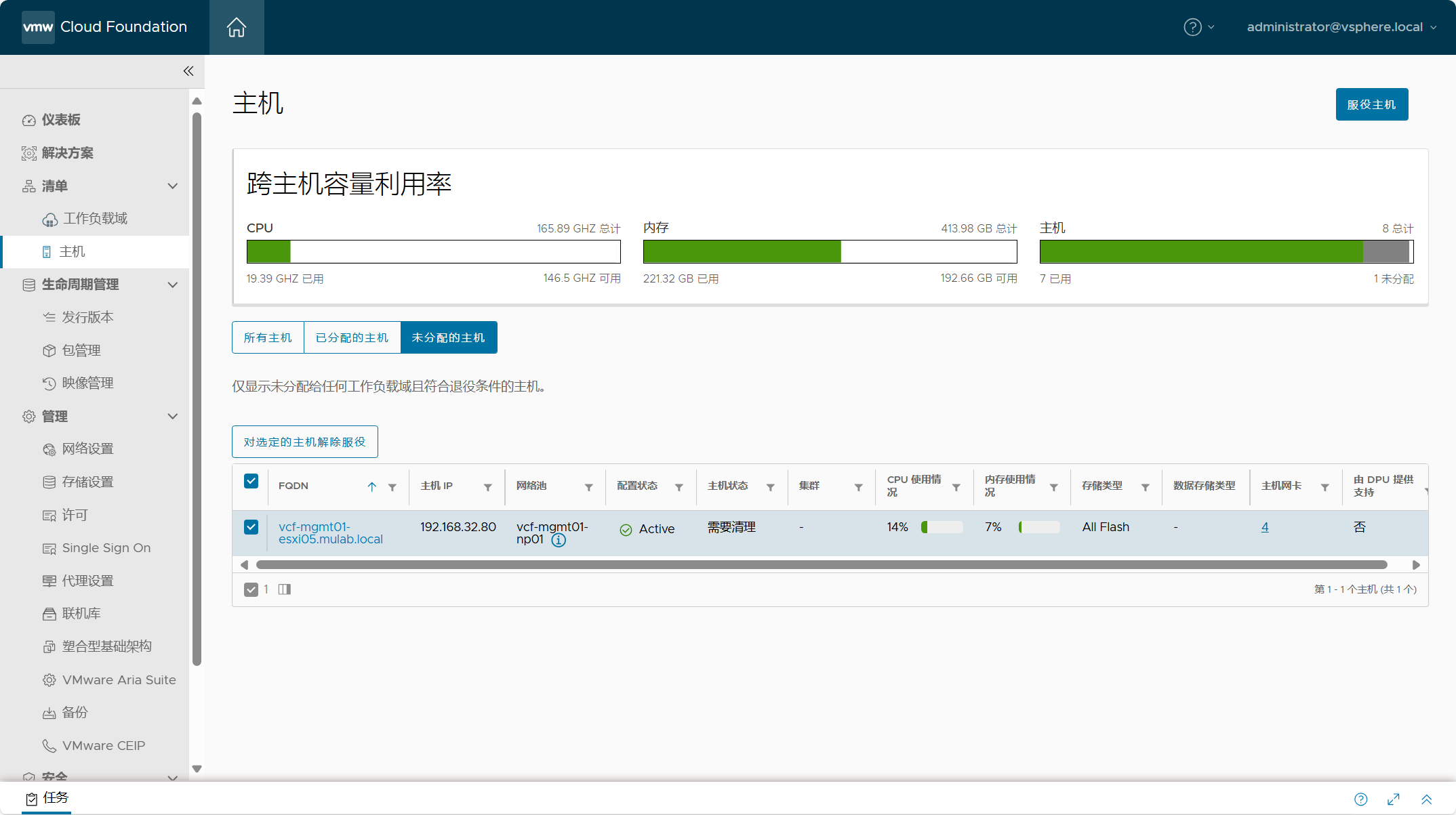

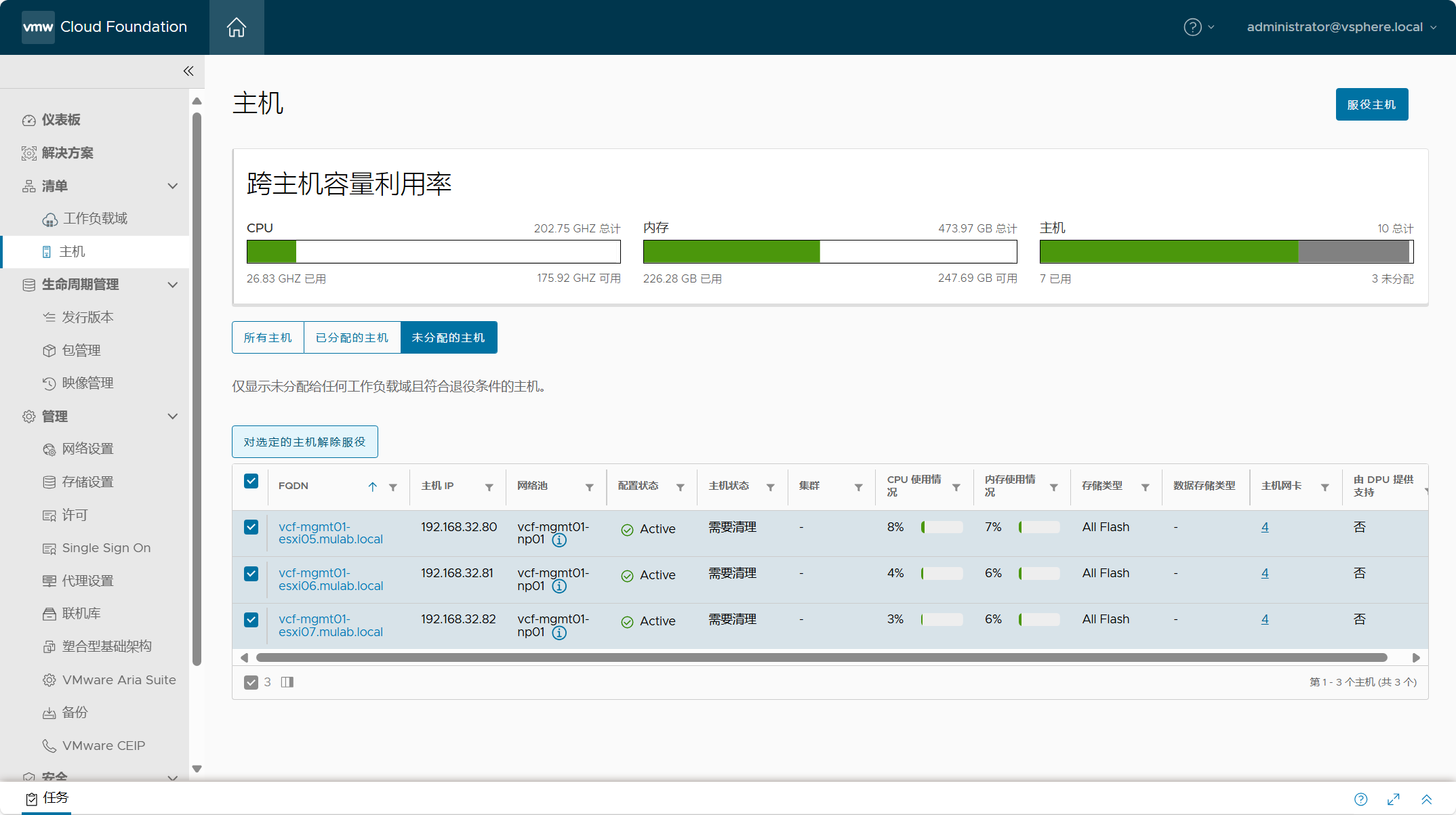

导航到 SDDC Manger->清单->主机->未分配的主机,被移除的主机会转到未分配的主机当中。你无法重新将该主机应用于任何工作负载域,被移除的主机需要清理,就是删除遗留在主机上的配置信息。在进行清理之前,需要先将主机从清单中删除(解除服役),当清理完以后,可以再重新对主机进行服役并应用于任何工作负载域。

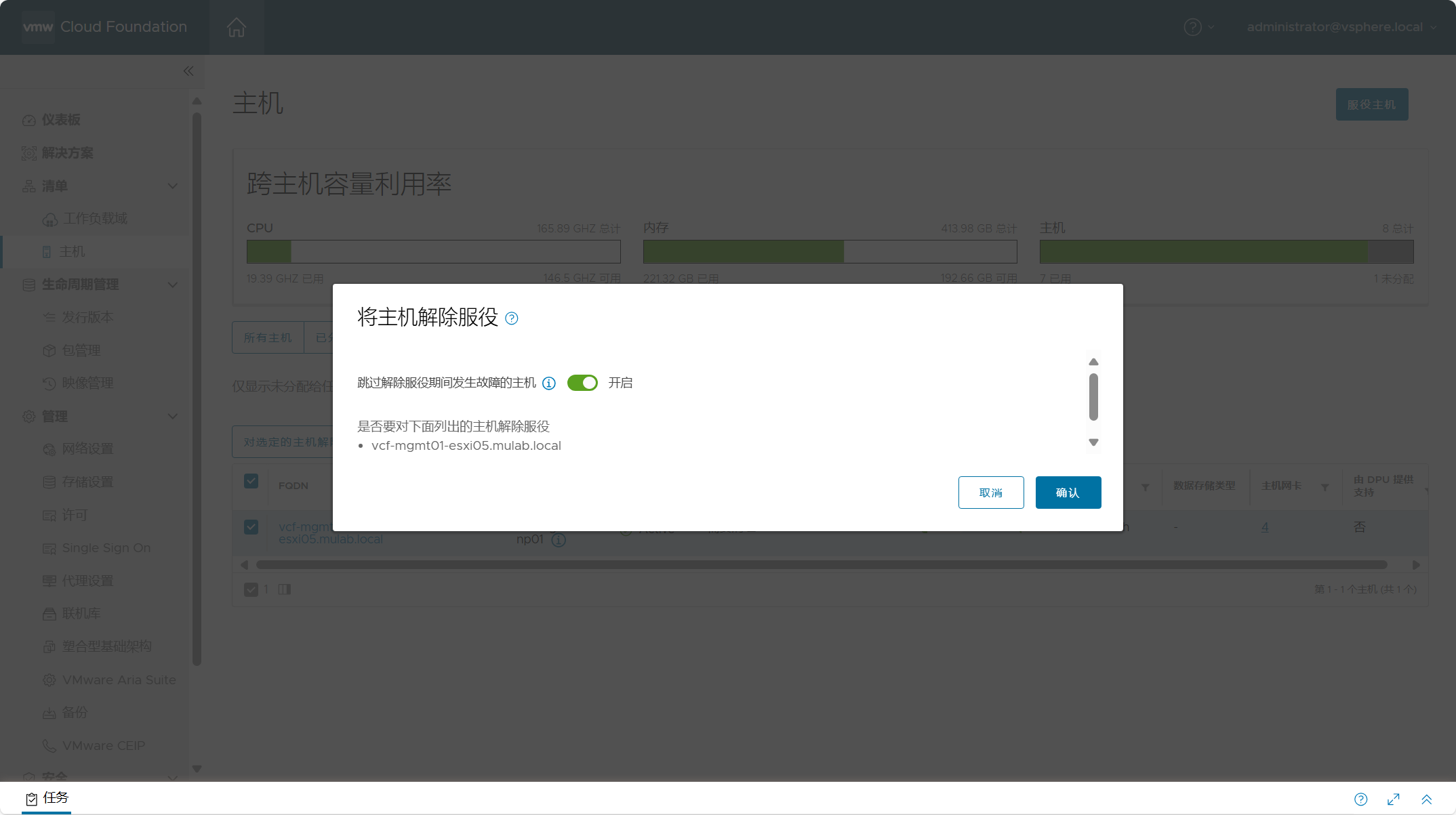

点击确认,解除服役。

五、工作负载域中添加集群

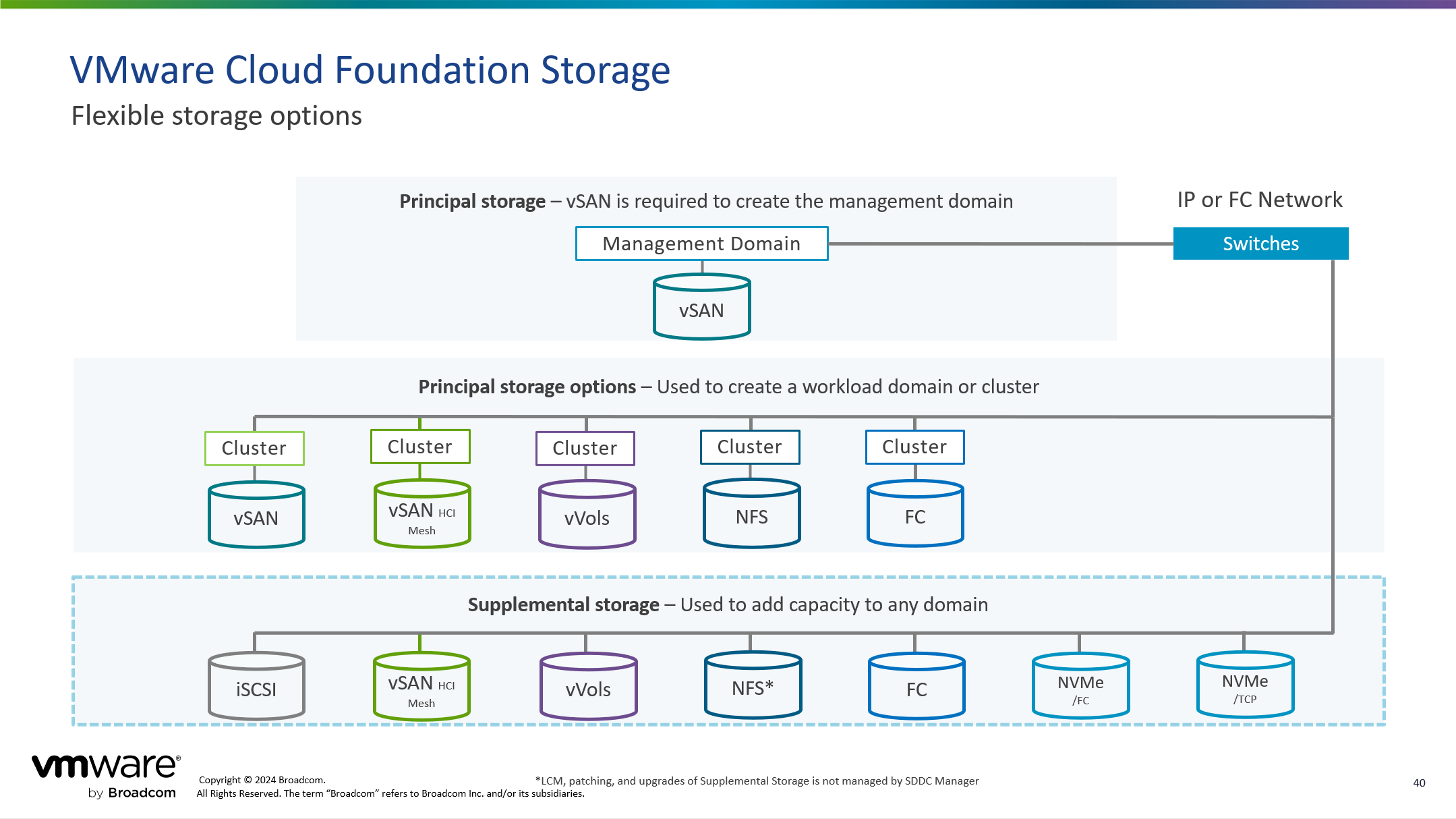

除了向工作负载域中的集群添加主机以外,还可以向工作负载域中添加新的 vSphere 集群。对于管理域来说,所有 vSphere 集群的初始构建都只能使用 vSAN 作为主体存储,当构建完集群以后,可以添加其他类型的存储(如 NFS、vVols 等)作为该集群的补充存储;对于 VI 域来说,所有 vSphere 集群的初始构建可以使用除了 vSAN 以外的其他类型的存储作为主体存储,当构建完集群以后,可以添加其他类型的存储(如 NFS、vVols 等)作为该集群的补充存储。

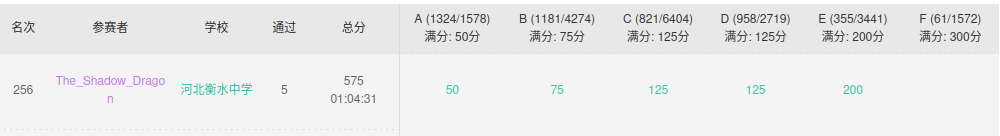

工作负载域中添加新的 vSphere 集群要求至少准备三台 ESXi 主机,当然这是使用 vSAN 存储类型的情况下,如果使用其他类型的存储,则只需要两台 ESXi 主机。与工作负载域中添加主机的流程一样,需要准备用于新的 vSphere 集群的 ESXi 主机,以及确保网络池和 NSX TEP IP 池具有可用的地址,然后使用“服役主机”工作流将这些主机添加到 SDDC Manager 主机清单中,如下图所示。

导航到 SDDC Manager->清单->工作负载域,点击需要添加新 vSphere 集群的工作负载域。

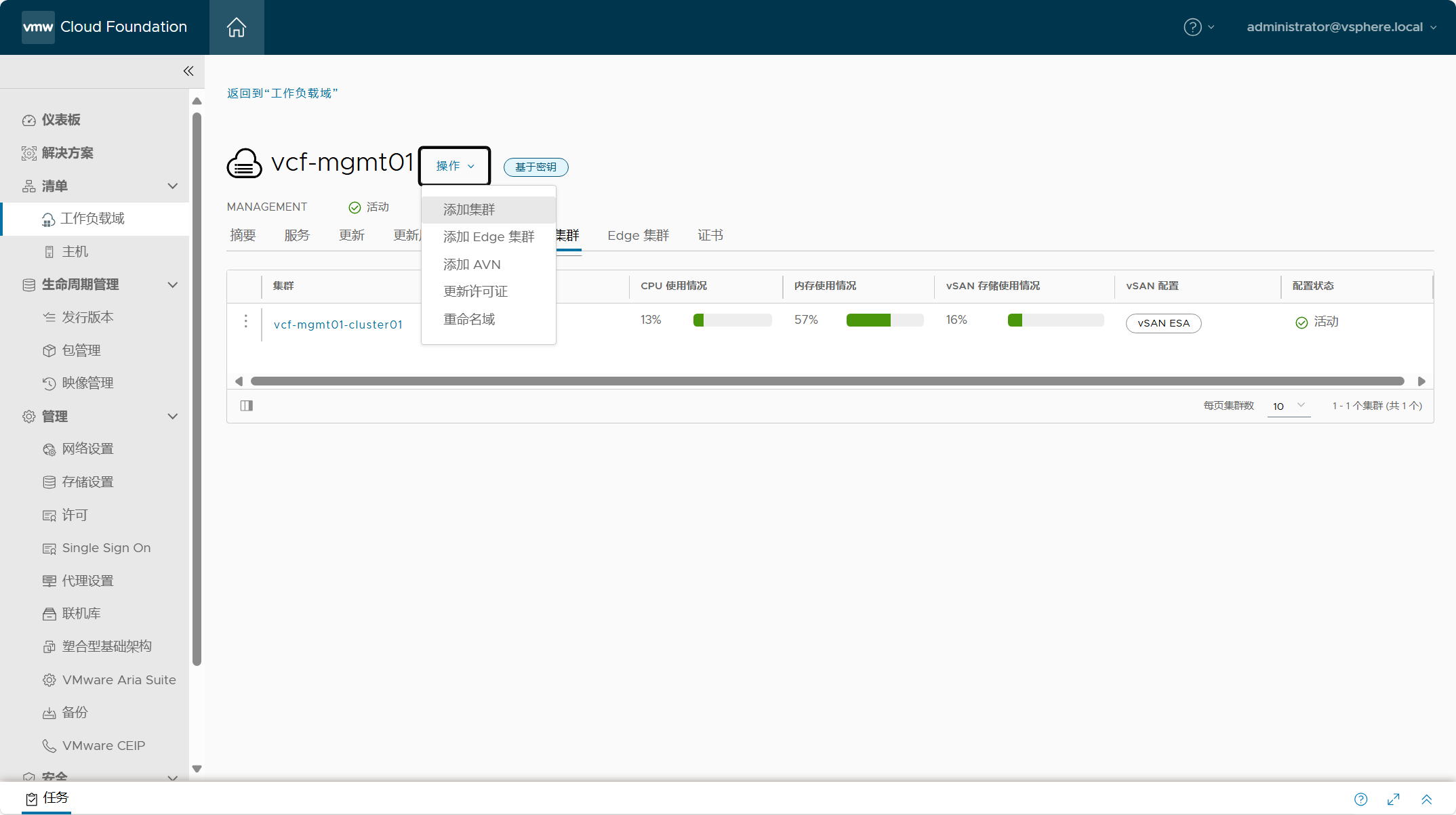

点击当前工作负载域中的“操作”,选择“添加集群”。

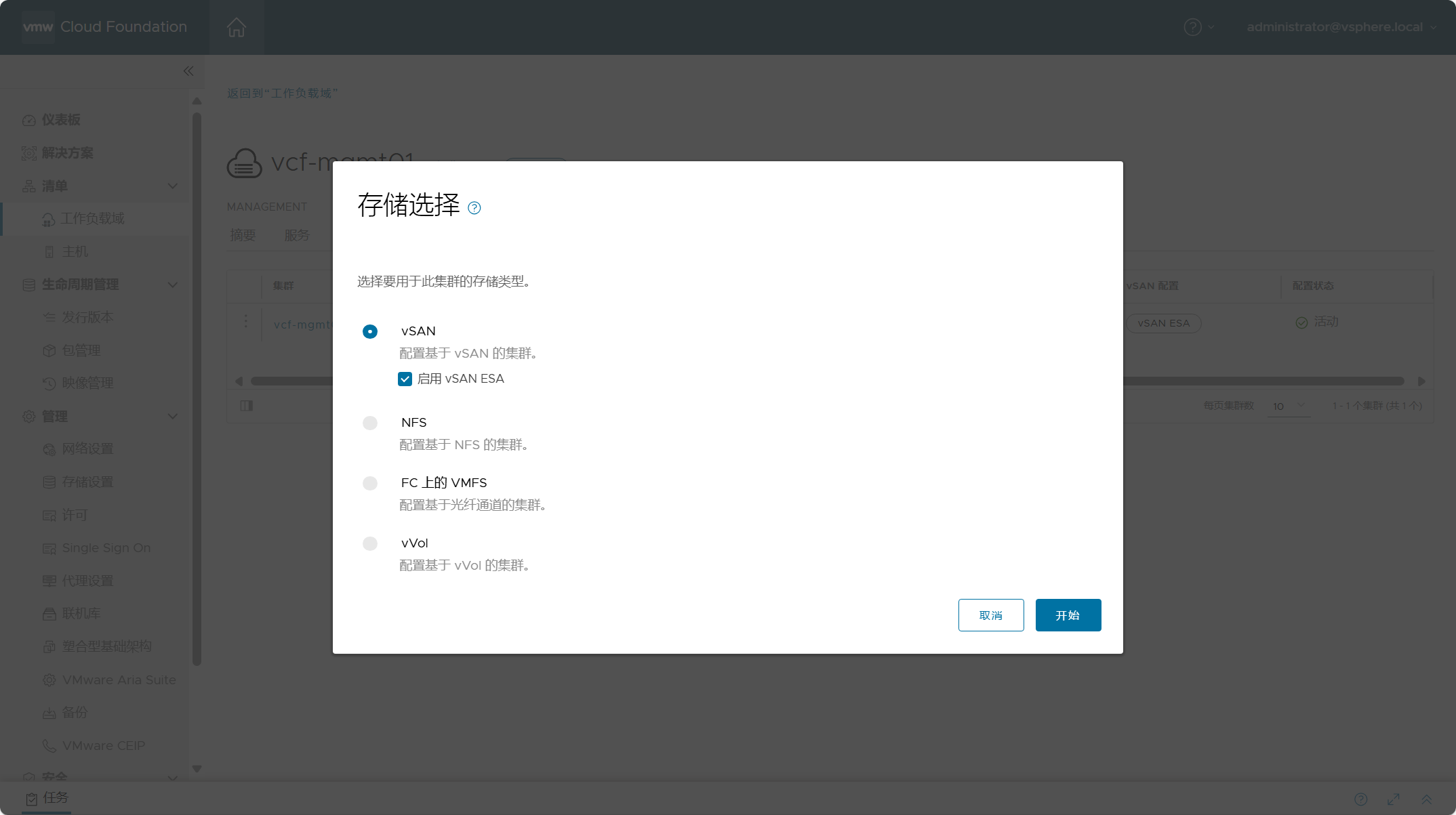

选择新集群所使用的存储类型,点击开始。

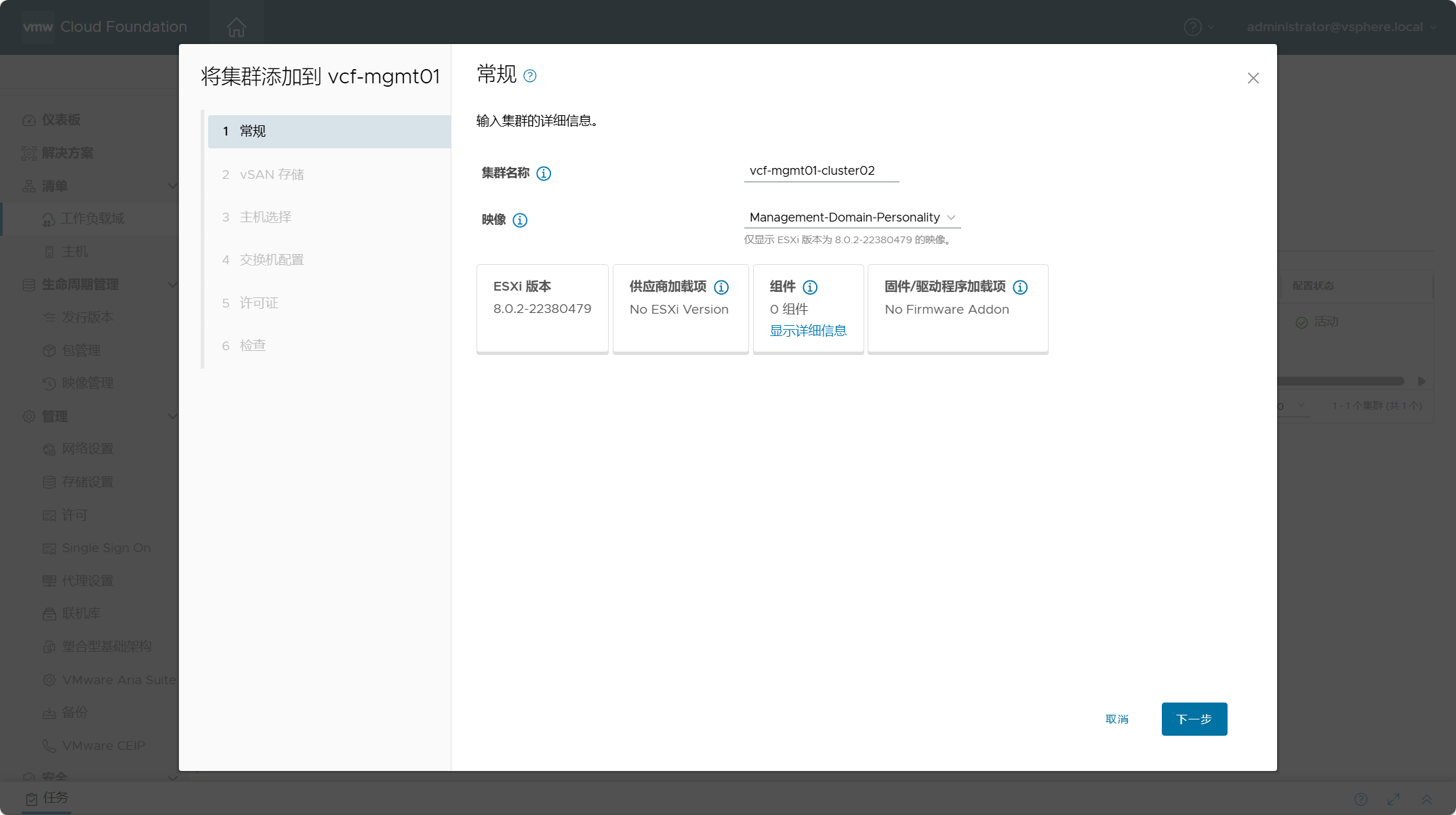

设置新集群的名称,并选择该集群的 LCM 映像。

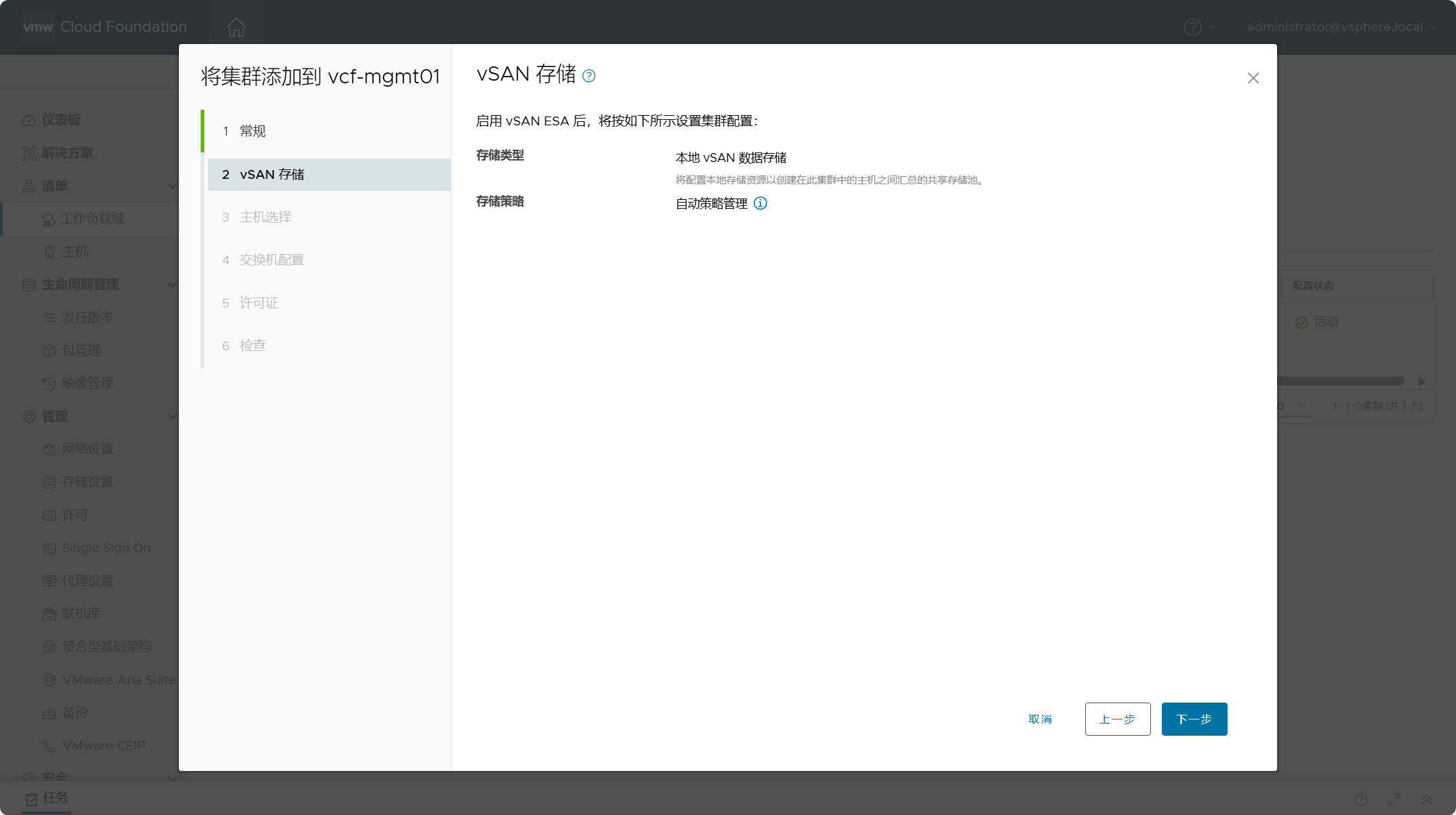

vSAN ESA 的默认存储策略将根据集群内的主机数自动进行调整。

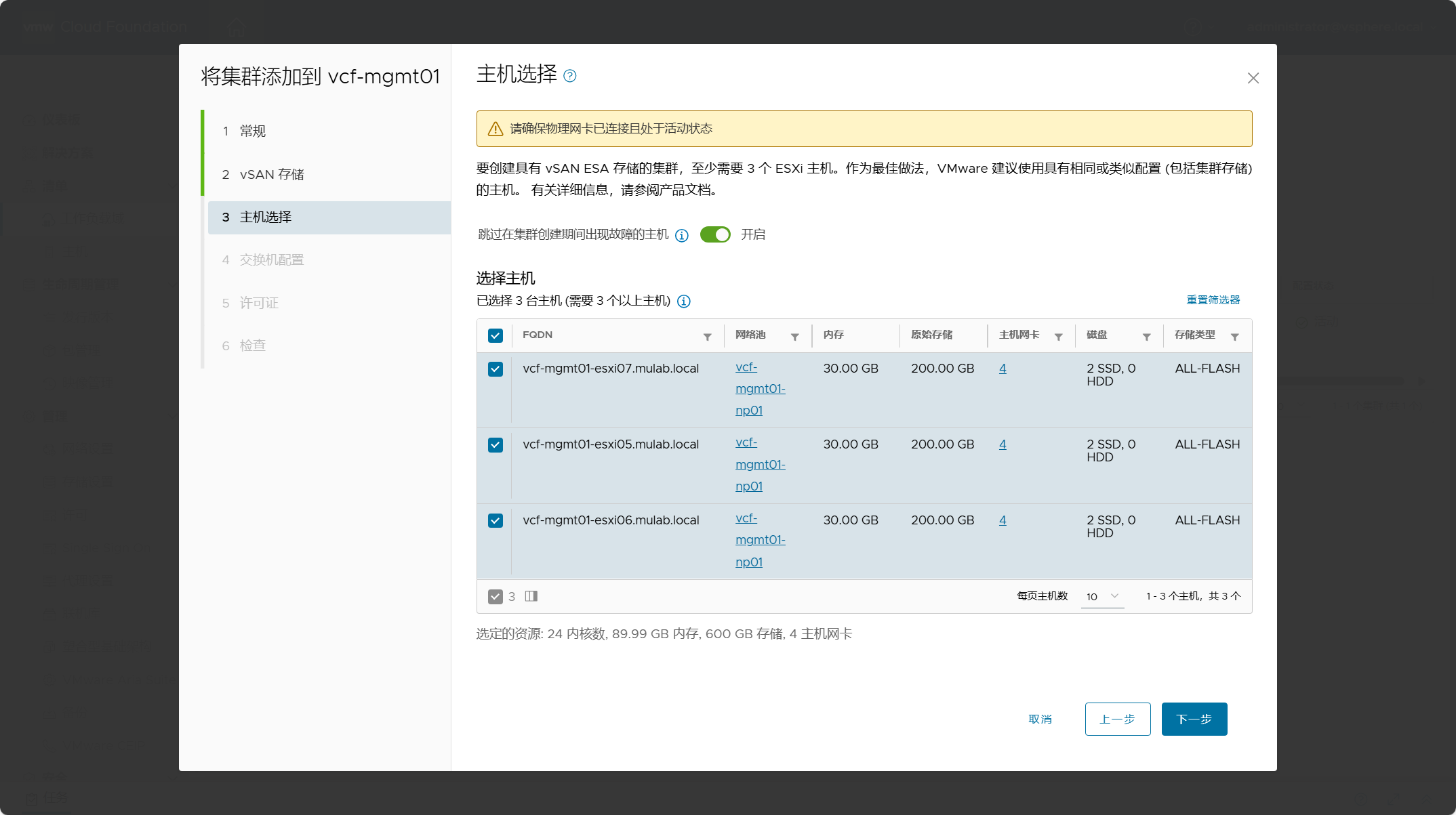

勾选用于新集群的主机,vSAN 集群要求至少需要 3 台 ESXi 主机。

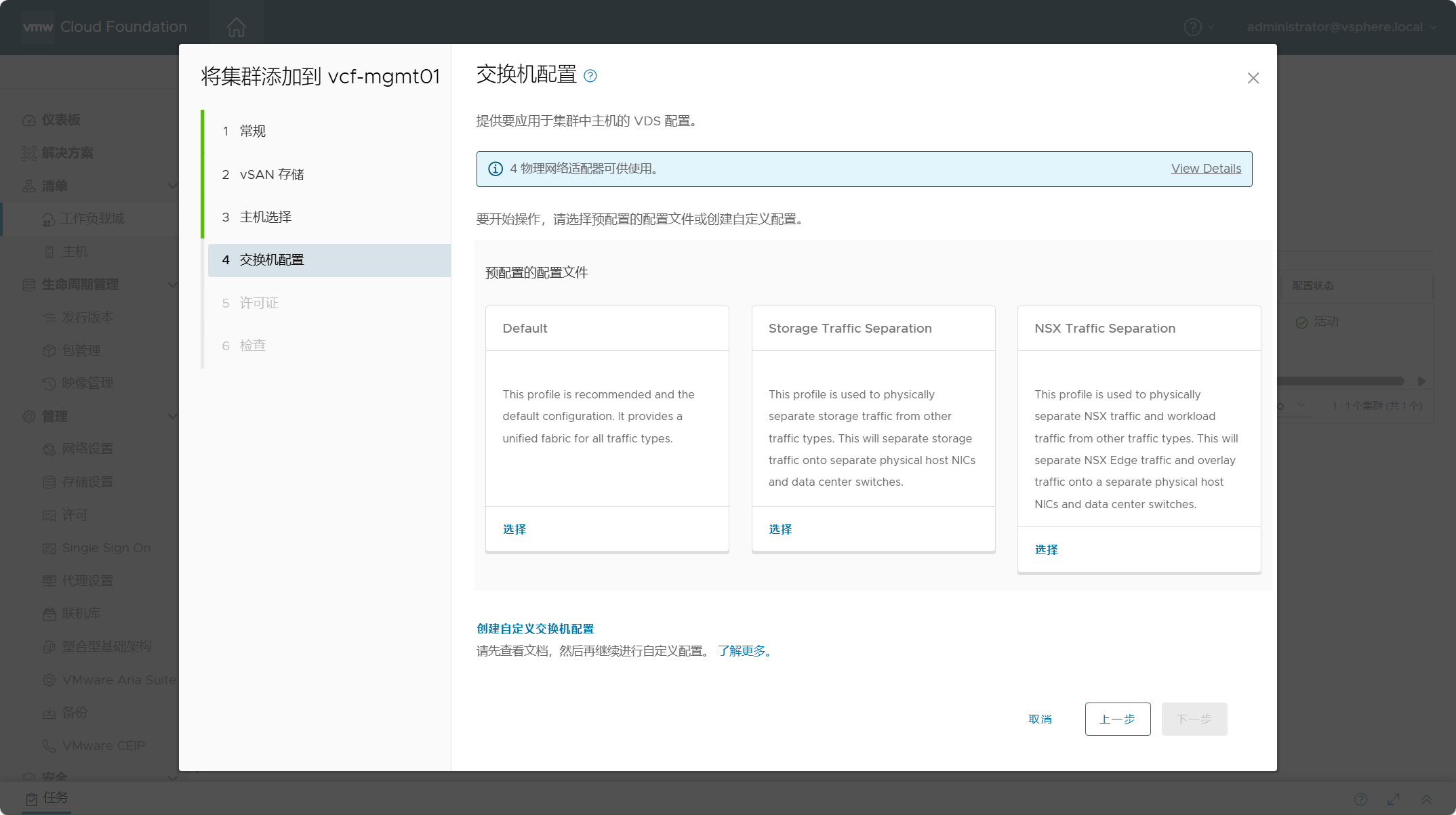

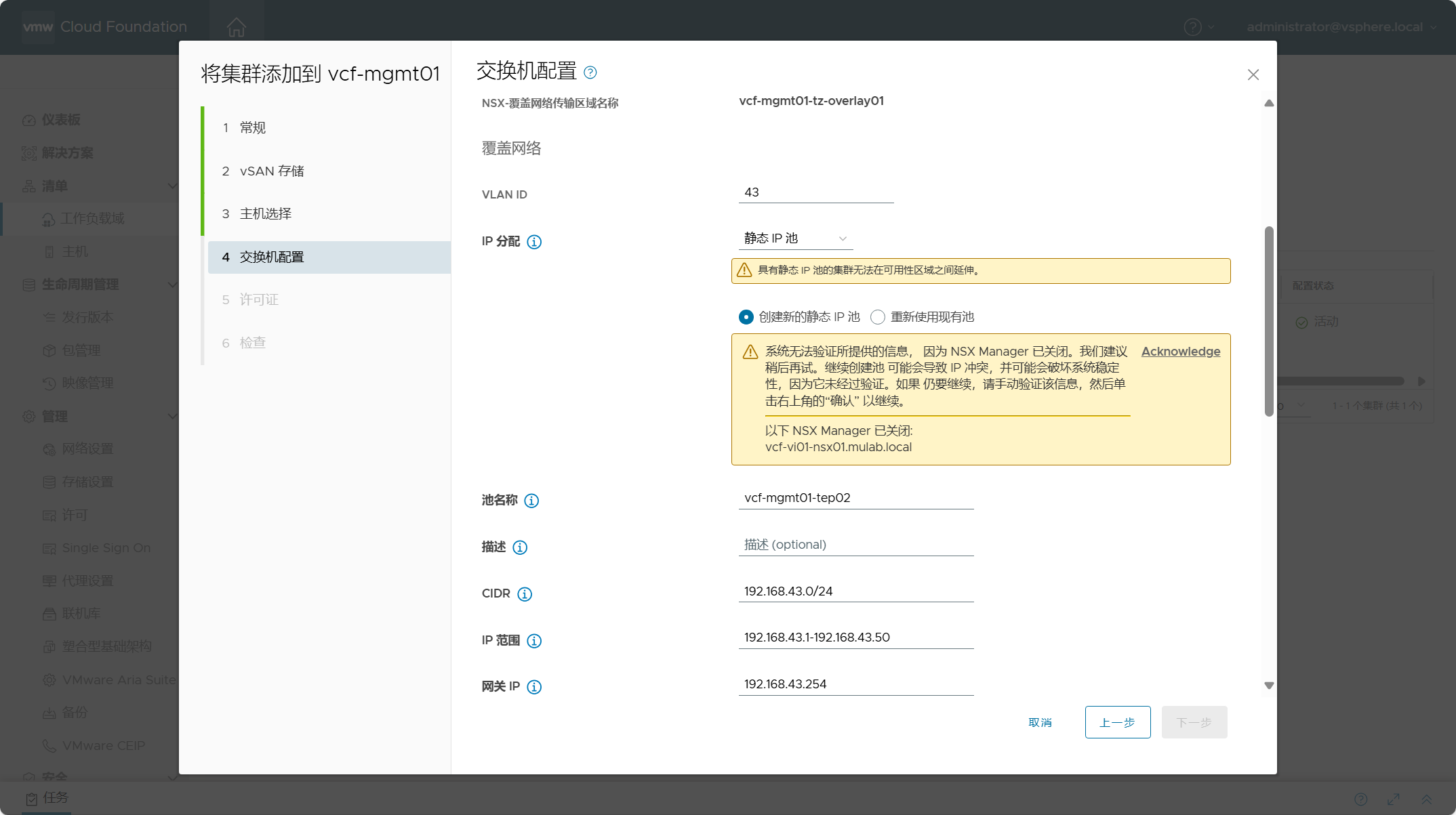

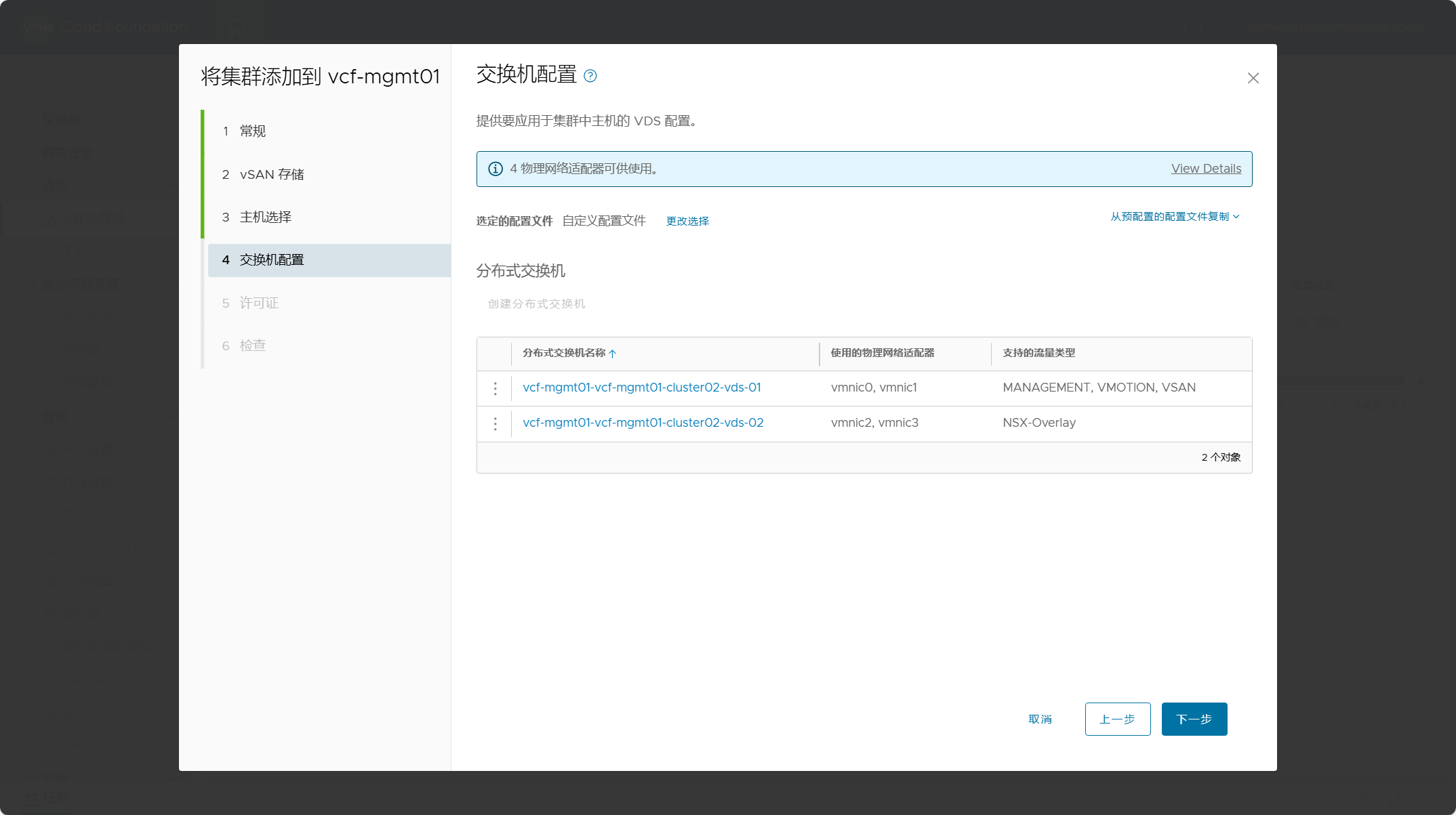

新集群主机的 VDS 配置。与初始构建工作负载域时的配置类似,默认提供三个预配置文件,以及可选择创建自定义交换机配置。由于预配置文件中的 NSX Overlay 网络主机所使用的 TEP IP 地址默认是通过 DHCP 进行分配的,这要求 TEP IP 地址所在 VLAN 具有可用的 DHCP 服务器,由于当前环境中没有,所以我这里就选择自定义交换机配置,手动创建静态 TEP IP 地址池。

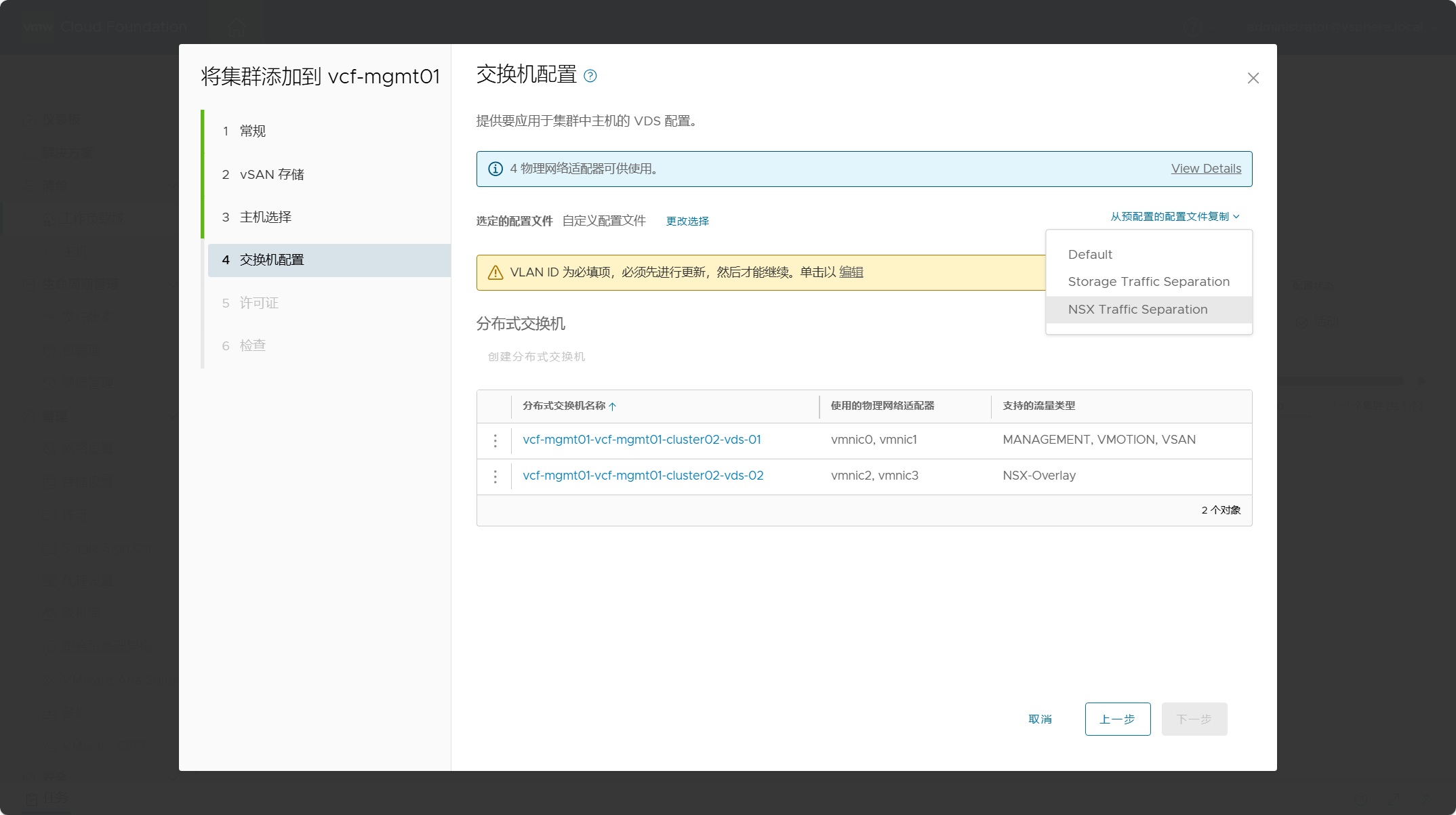

点击自定义交换机配置后,可以选择“从预配置的配置文件复制”选项,选择从某个预定义配置文件中复制配置过来,这样就不用一个一个去配置了。

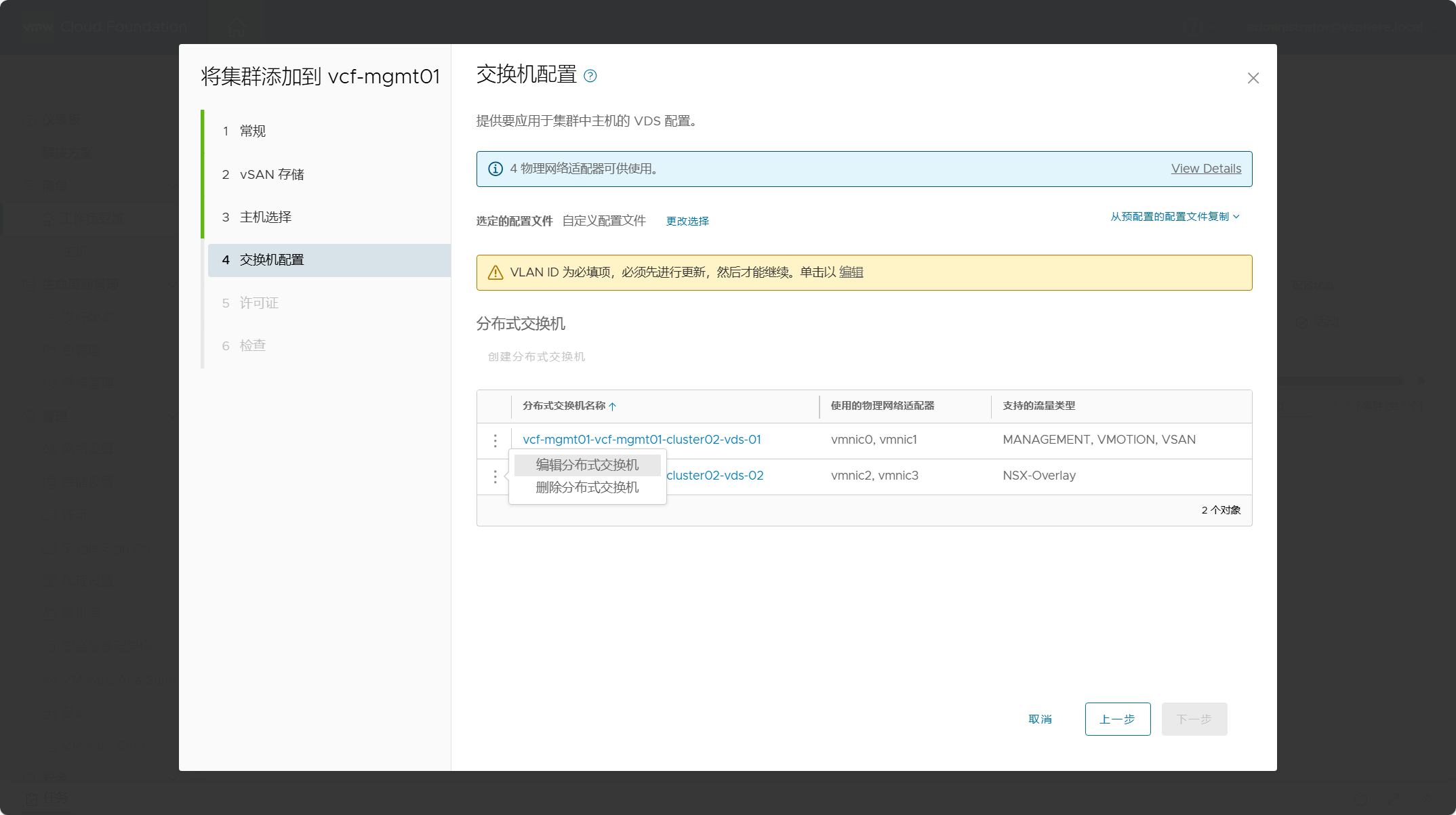

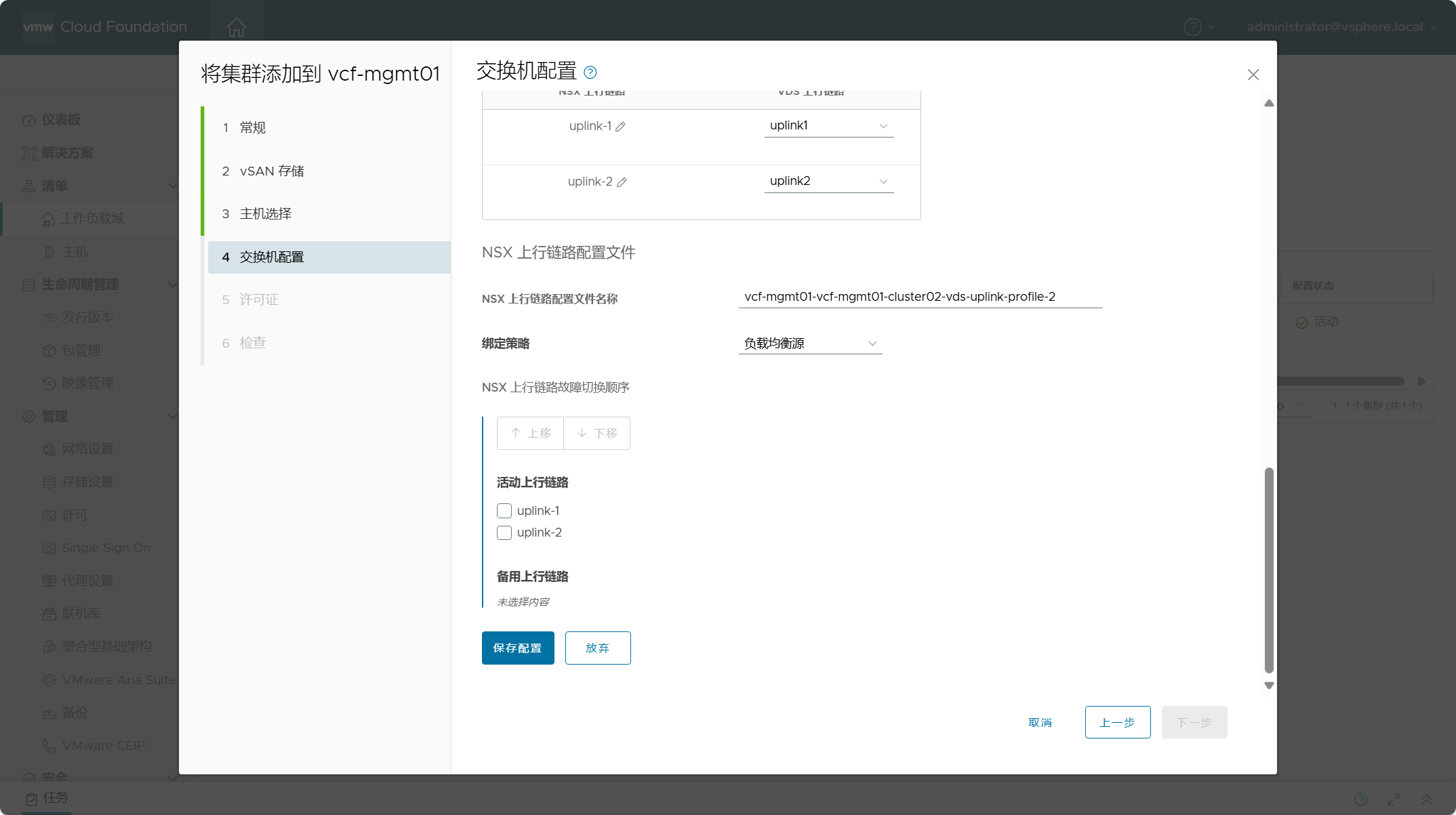

我把 VDS 02 这个交换机专用于 NSX 网络使用,但是需要对这个虚拟机交换机进行一些设置,点击编辑分布式交换机。

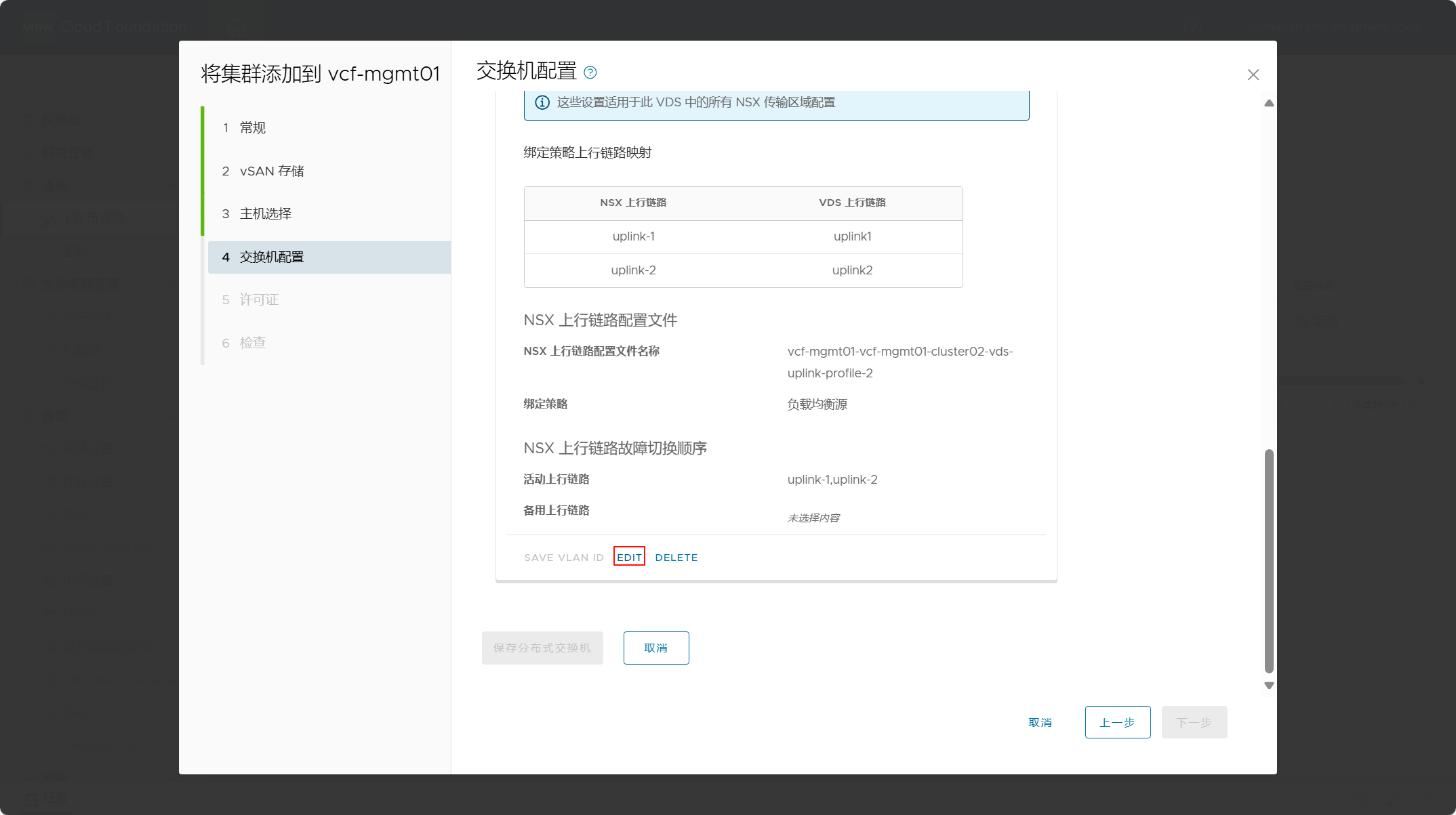

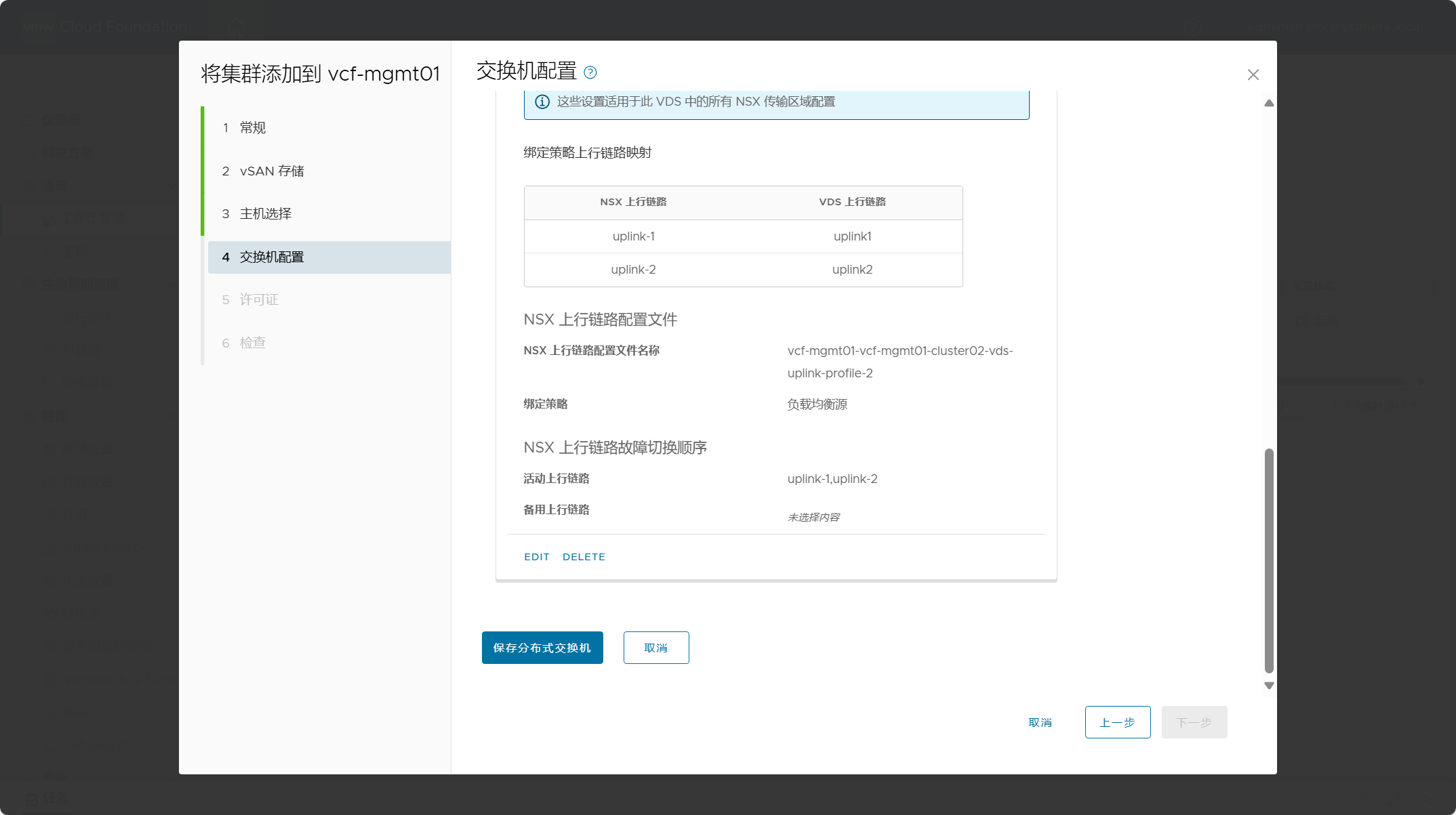

拉到最下面,点击“EDIT”编辑。

在该交换机的覆盖网络配置这里,配置 VLAN 以及 TEP IP 地址池。选择静态 IP 池并创建新的 IP 池。由于我另外一个 VI 域的 NSX Manager 已经关了,这里在配置 IP 池的时候,系统会去检测所有工作负载域中的 NSX Manager 中已经存在的 TEP IP 池,以防止 IP 冲突,自行确认所配置的 IP 池不会存在冲突,然后点击 Acknowledge 即可。如果已提前在工作负载域中的 NSX Manager 中创建了 TEP IP 池,也可以选择“重新使用现有池”,然后选择已存在的 TEP IP 池即可。

拉到最下面,点击保存配置。

拉到最下面,点击保存分布式交换机。

新集群主机的交换机配置好后,点击下一步。

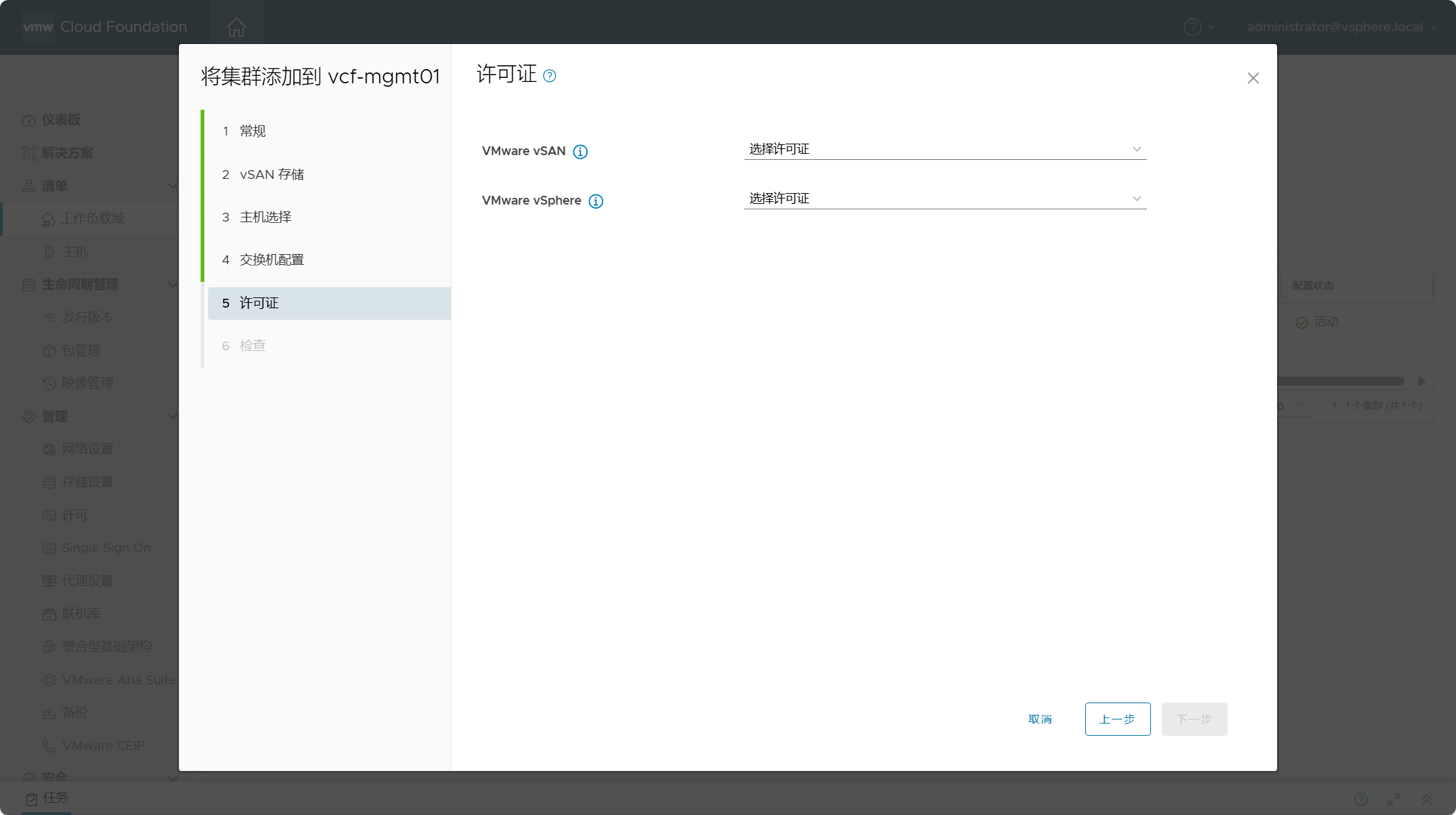

新集群主机的许可证配置。

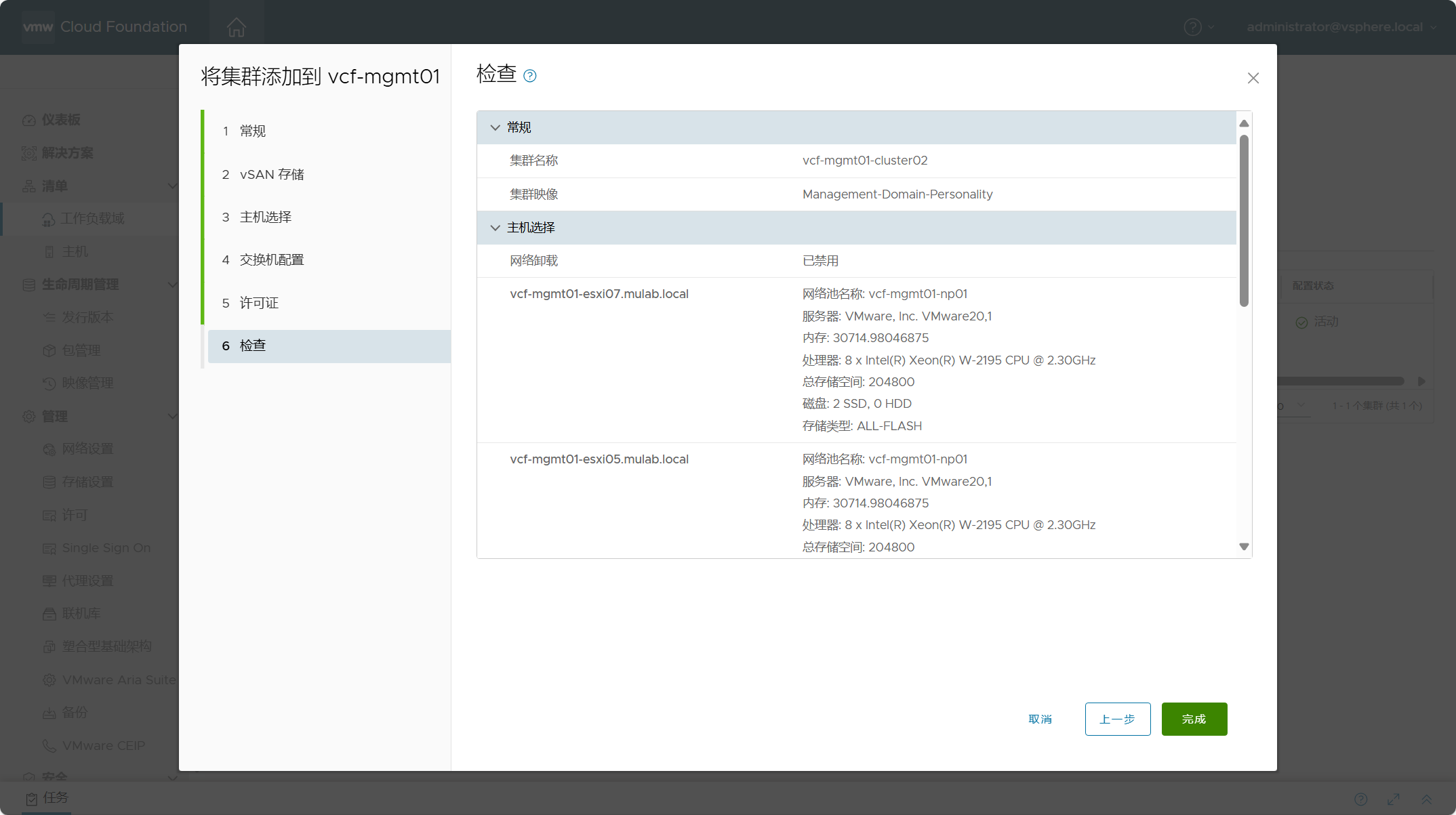

检测所有配置,点击完成。

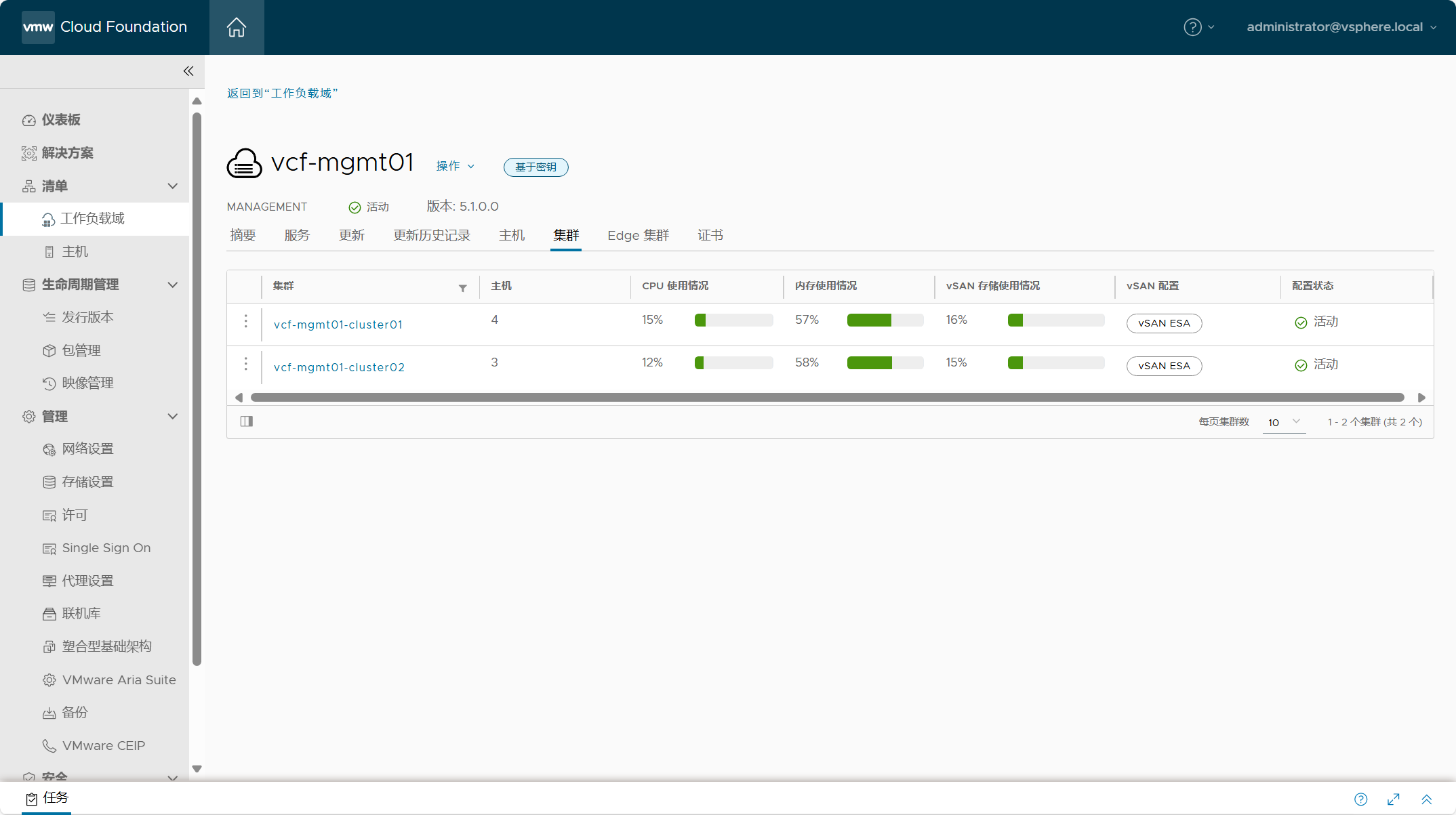

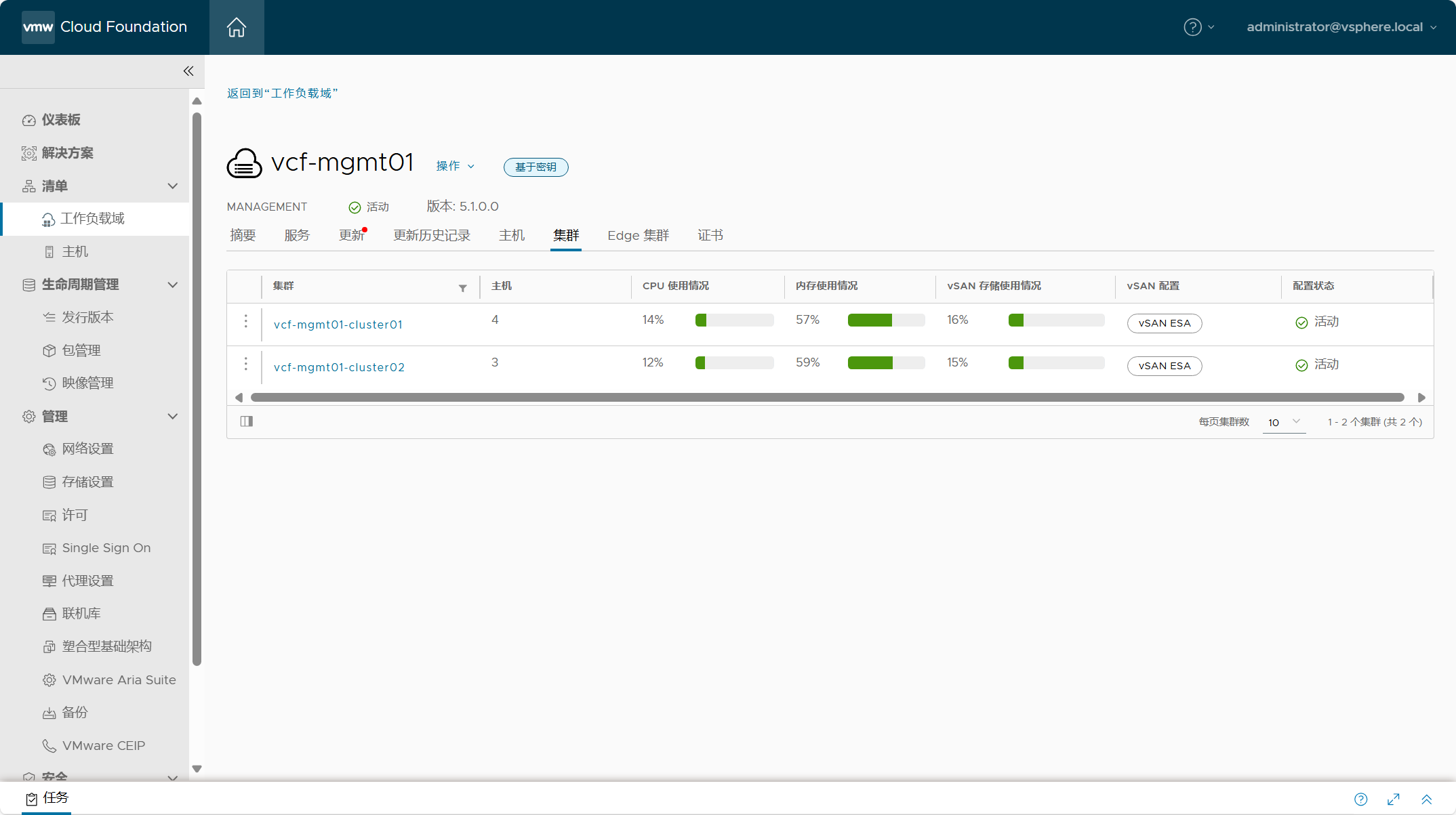

如果一切顺利,新集群会显示在列表中。

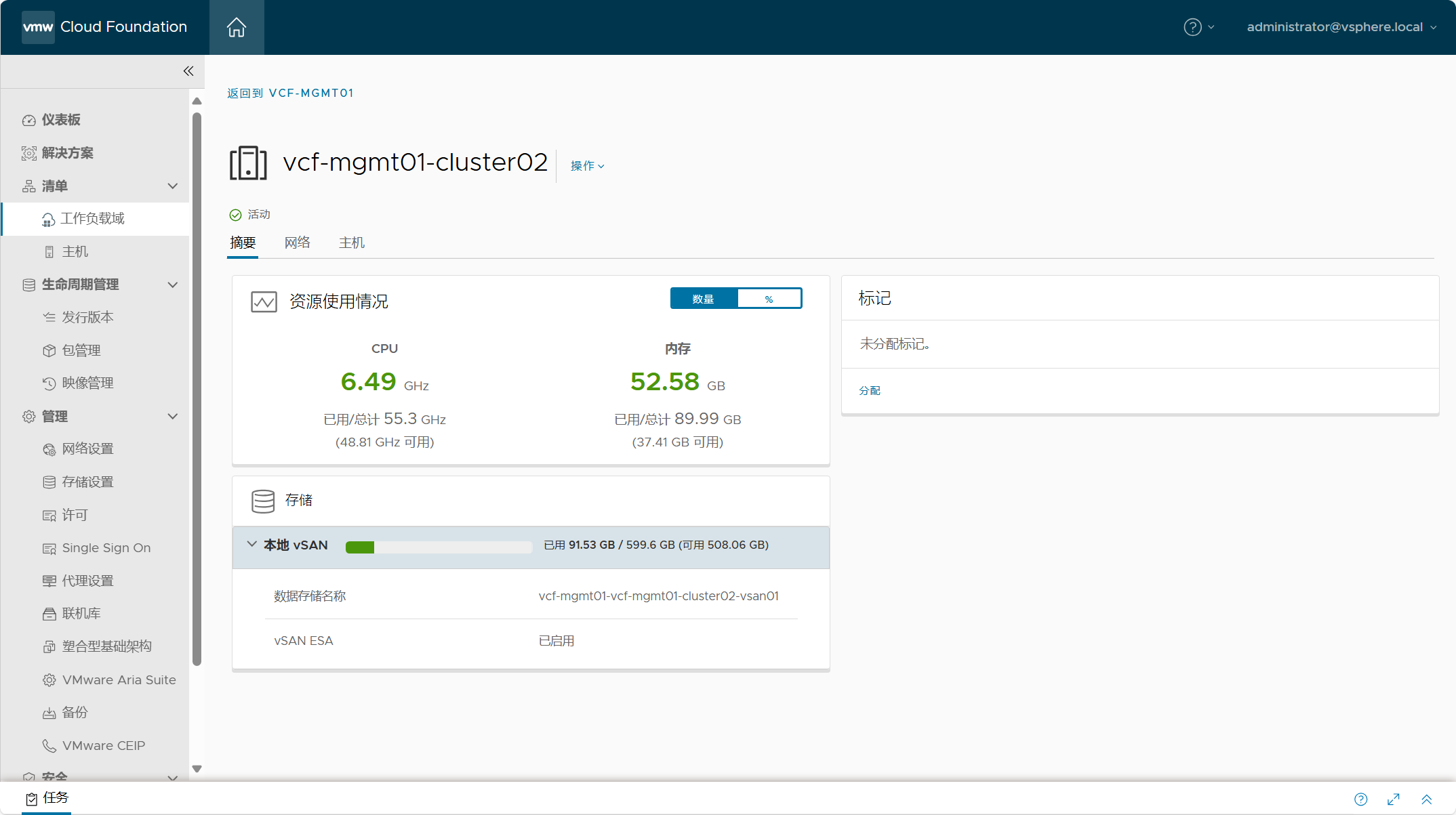

新集群 vcf-mgmt01-cluster02 摘要信息。

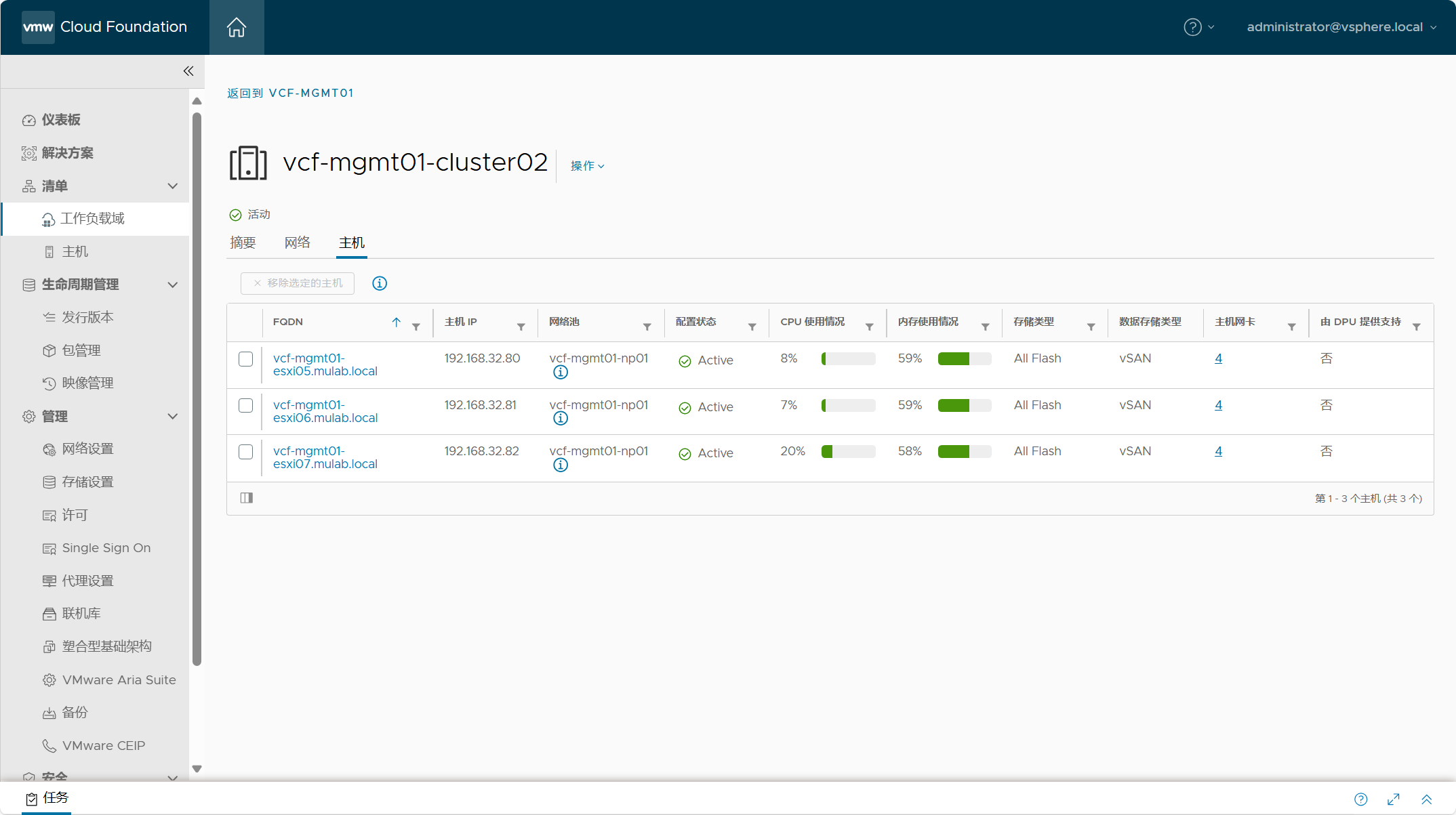

新集群 vcf-mgmt01-cluster02 主机列表。

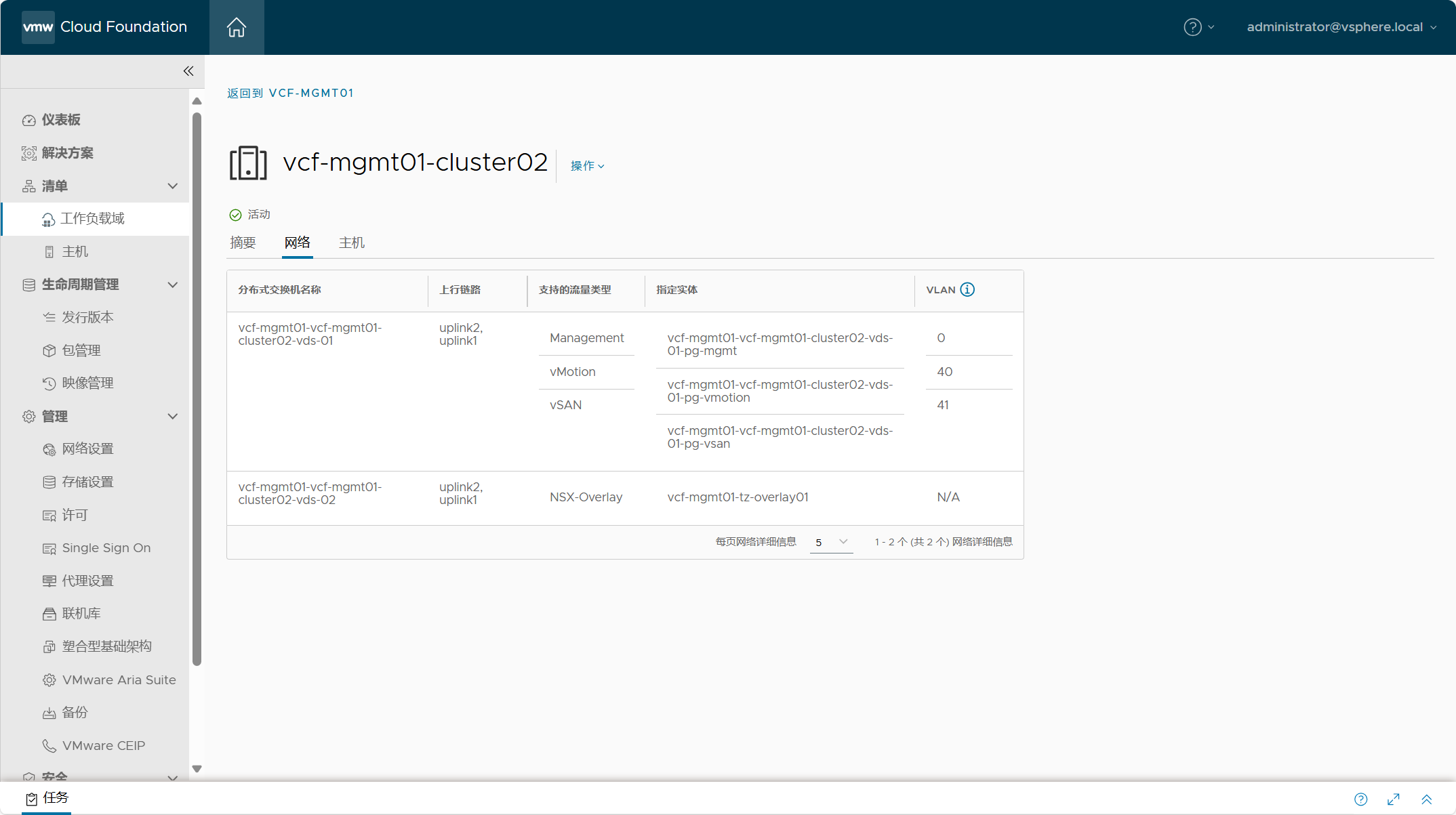

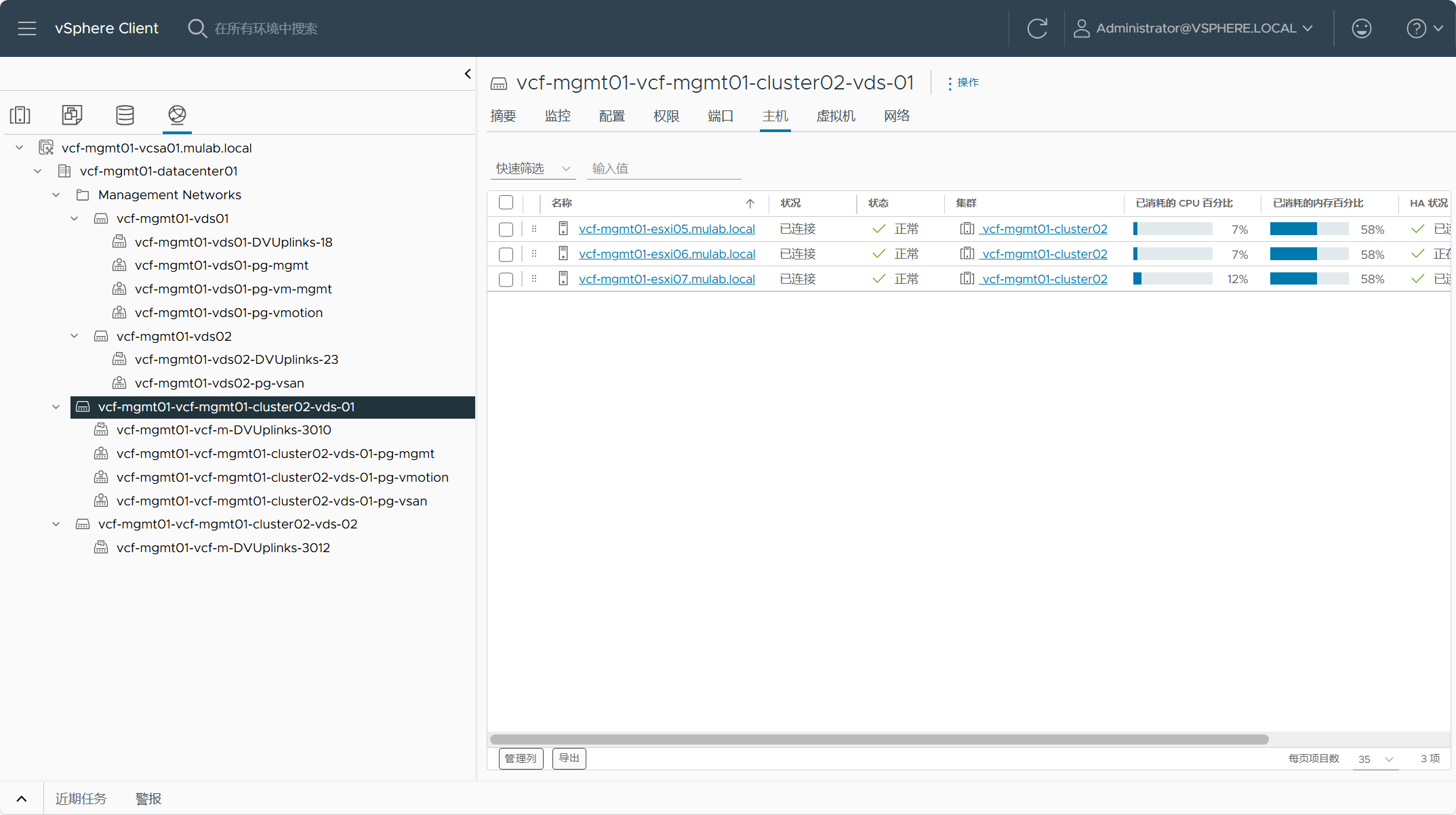

新集群 vcf-mgmt01-cluster02 网络配置。

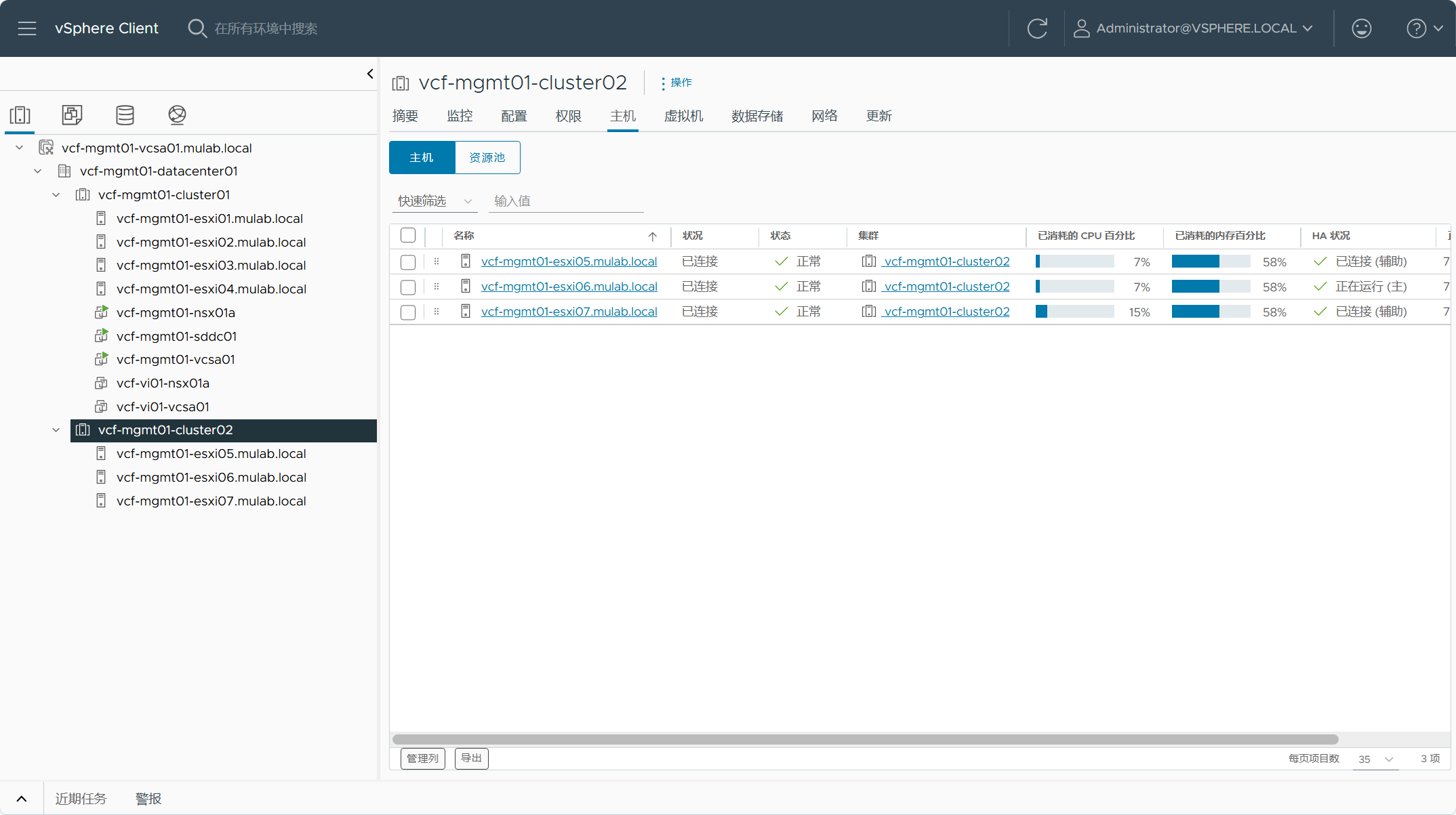

工作负载域 vCenter Server 中查看新集群。

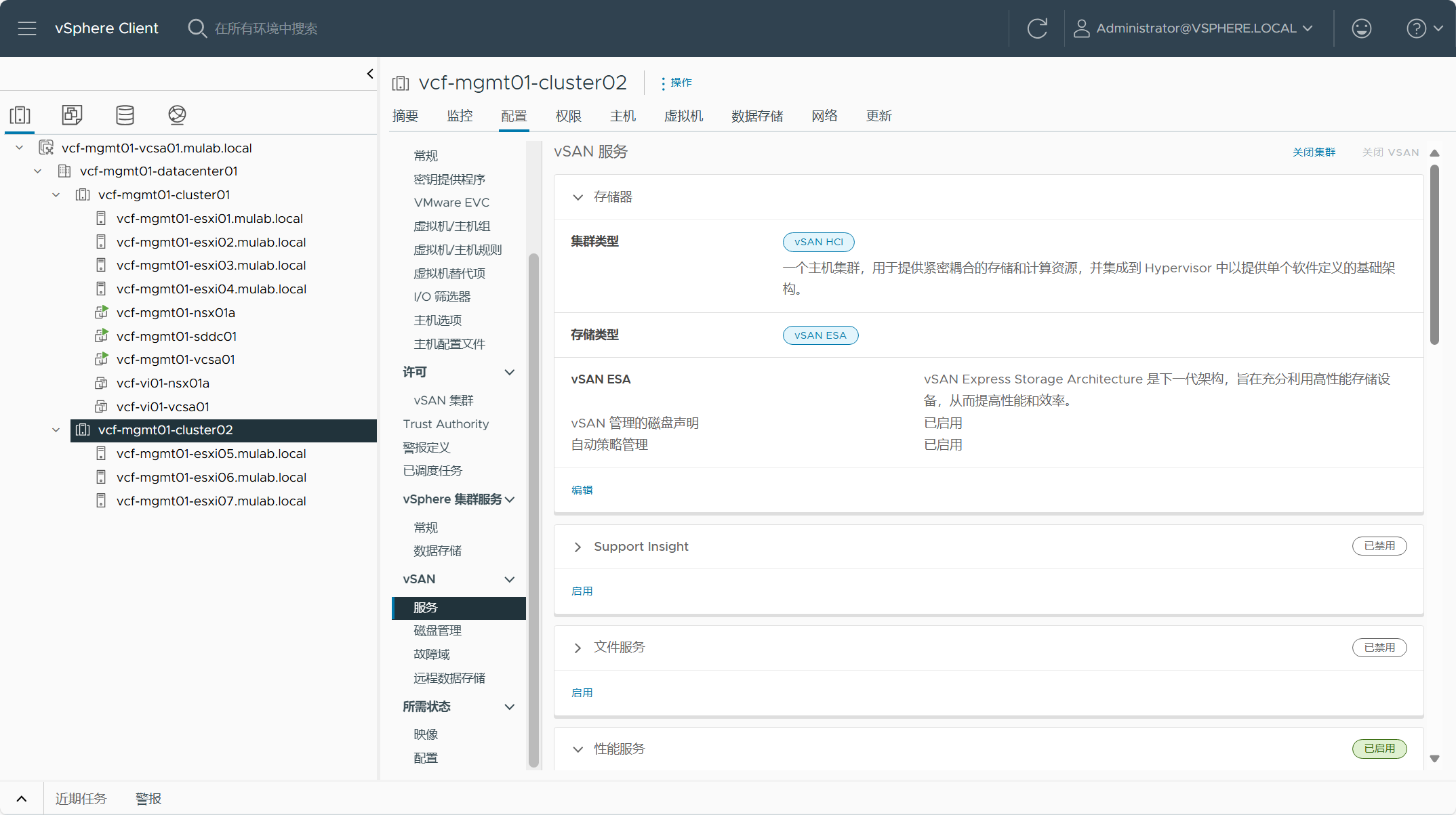

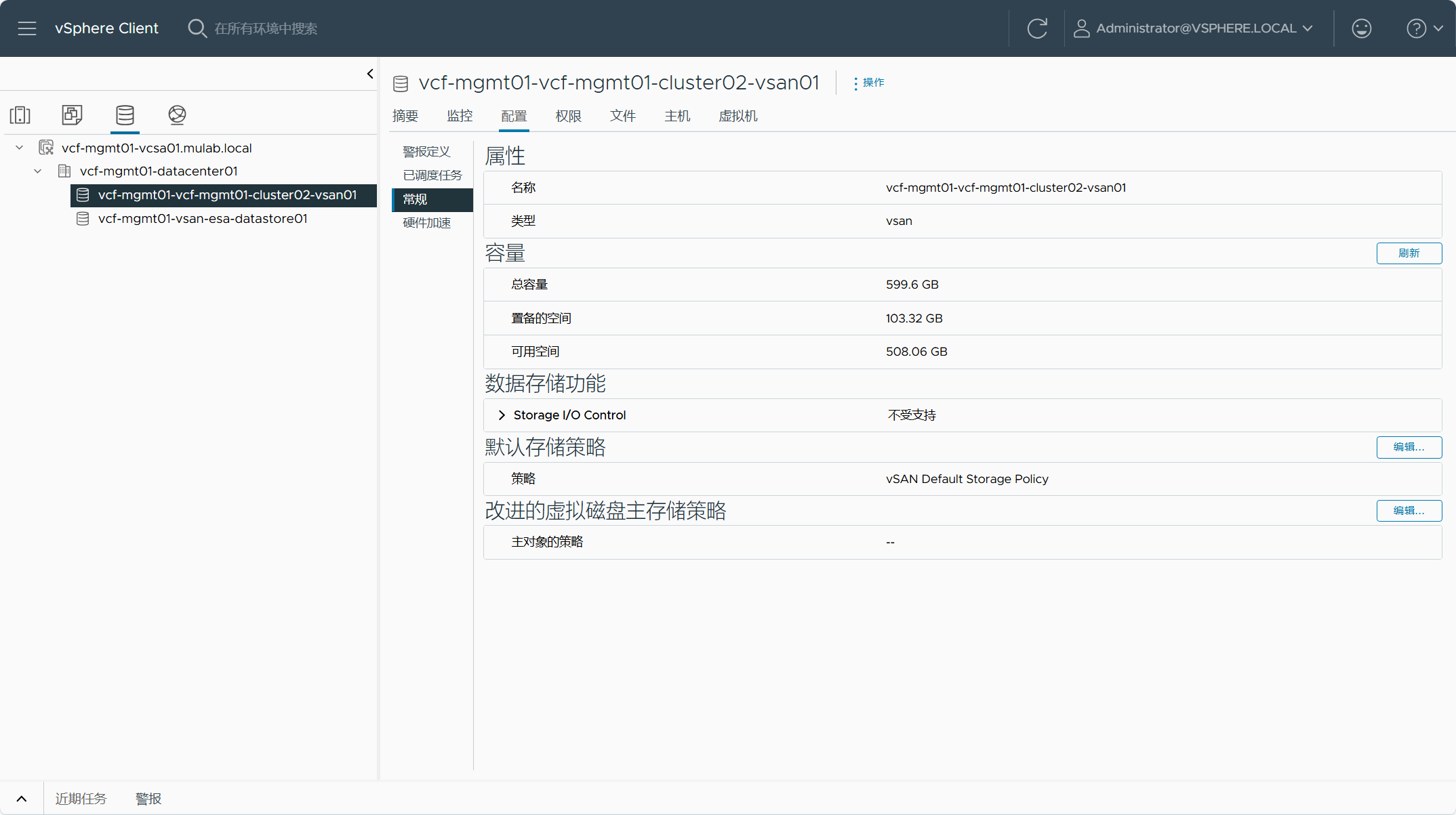

新集群的 vSAN 存储类型。

新集群的 vSAN 故障域。

新集群的 vSAN 存储。

新集群的 VDS 分布式交换机。

NSX 中新集群传输节点配置。

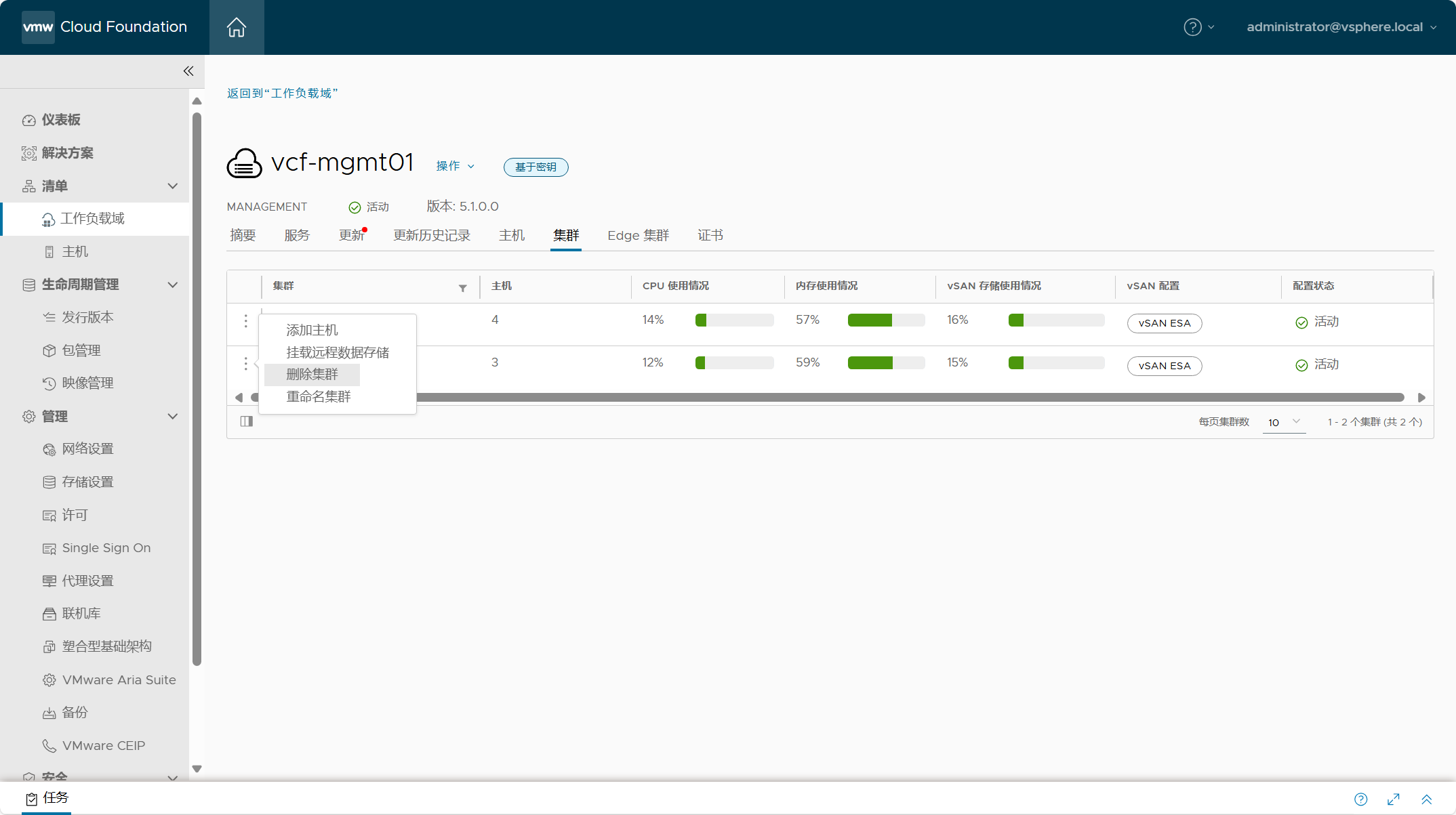

六、工作负载域中删除集群

如果想删除工作负载域中的 vSphere 集群,同样非常简单。但是有许多注意事项,集群中不应该运行任务工作负载,如果使用了 vSAN 存储,则 vSAN 数据存储将被删除,其他类型的存储会被移除,如果集群中挂载了远程 vSAN 数据存储,必须先移除挂载的数据存储。对于工作负载域中的初始集群,无法单独进行删除,只能通过删除工作负载域来删除集群。

导航到 SDDC Manager->清单->需要删除集群的工作负载域->集群,这里列出了所有集群清单。

在需要删除的集群左边点击“删除集群”。

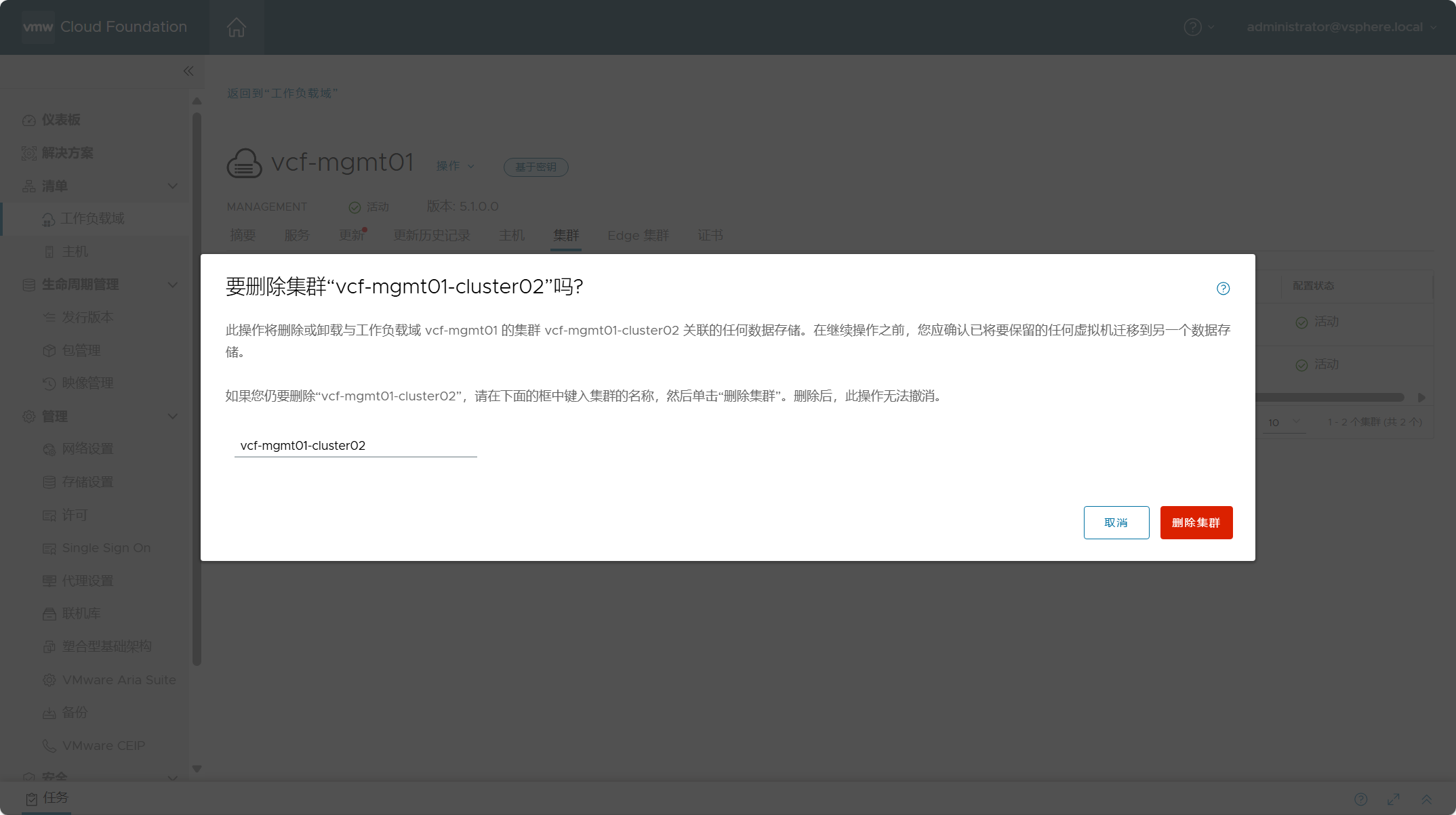

输入需要删除集群的名称,点击删除集群。如果一切顺利,集群会从工作负载域中删除。

同样,删除集群中的主机会转到未分配的主机清单中,需要将主机解除服役。

点击确认,解除服役。