该文章为 weibo-crawler 的官方文档,为了方便国内的同学阅读而转载。

原文地址:https://github.com/dataabc/weibo-crawler

源码我也下载了一份,读者可以在我的公众号上回复“分享资料”来获取,路径如下:

以下是正文:

功能

连续爬取一个或多个新浪微博用户(如迪丽热巴、郭碧婷)的数据,并将结果信息写入文件。写入信息几乎包括了用户微博的所有数据,主要有用户信息和微博信息两大类,前者包含用户昵称、关注数、粉丝数、微博数等等;后者包含微博正文、发布时间、发布工具、评论数等等,因为内容太多,这里不再赘述,详细内容见输出部分。具体的写入文件类型如下:

- 写入 csv 文件(默认)

- 写入 json 文件(可选)

- 写入 MySQL 数据库(可选)

- 写入 MongoDB 数据库(可选)

- 写入 SQLite 数据库(可选)

- 下载用户原创微博中的原始图片(可选)

- 下载用户转发微博中的原始图片(可选)

- 下载用户原创微博中的视频(可选)

- 下载用户转发微博中的视频(可选)

- 下载用户原创微博 Live Photo 中的视频(可选)

- 下载用户转发微博 Live Photo 中的视频(可选)

- 下载用户原创和转发微博下的一级评论(可选)

- 下载用户原创和转发微博下的转发(可选)

如果你只对用户信息感兴趣,而不需要爬用户的微博,也可以通过设置实现只爬取微博用户信息的功能。程序也可以实现爬取结果自动更新,即:现在爬取了目标用户的微博,几天之后,目标用户可能又发新微博了。通过设置,可以实现每隔几天增量爬取用户这几天发的新微博。具体方法见定期自动爬取微博。

输出

用户信息

- 用户 id:微博用户 id,如"1669879400"

- 用户昵称:微博用户昵称,如"Dear-迪丽热巴"

- 性别:微博用户性别

- 生日:用户出生日期

- 所在地:用户所在地

- 教育经历:用户上学时学校的名字

- 公司:用户所属公司名字

- 阳光信用:用户的阳光信用

- 微博注册时间:用户微博注册日期

- 微博数:用户的全部微博数(转发微博 + 原创微博)

- 粉丝数:用户的粉丝数

- 关注数:用户关注的微博数量

- 简介:用户简介

- 主页地址:微博移动版主页 url,如 https://m.weibo.cn/u/1669879400?uid=1669879400&luicode=10000011&lfid=1005051669879400

- 头像 url:用户头像 url

- 高清头像 url:用户高清头像 url

- 微博等级:用户微博等级

- 会员等级:微博会员用户等级,普通用户该等级为 0

- 是否认证:用户是否认证,为布尔类型

- 认证类型:用户认证类型,如个人认证、企业认证、政府认证等

- 认证信息:为认证用户特有,用户信息栏显示的认证信息

微博信息

- 微博 id:微博的 id,为一串数字形式

- 微博 bid:微博的 bid,与 cookie 版中的微博 id 是同一个值

- 微博内容:微博正文

- 头条文章 url:微博中头条文章的 url,如果微博中存在头条文章,就获取该头条文章的 url,否则该值为''

- 原始图片 url:原创微博图片和转发微博转发理由中图片的 url,若某条微博存在多张图片,则每个 url 以英文逗号分隔,若没有图片则值为''

- 视频 url: 微博中的视频 url 和 Live Photo 中的视频 url,若某条微博存在多个视频,则每个 url 以英文分号分隔,若没有视频则值为''

- 微博发布位置:位置微博中的发布位置

- 微博发布时间:微博发布时的时间,精确到天

- 点赞数:微博被赞的数量

- 转发数:微博被转发的数量

- 评论数:微博被评论的数量

- 微博发布工具:微博的发布工具,如 iPhone 客户端、HUAWEI Mate 20 Pro 等,若没有则值为''

- 话题:微博话题,即两个#中的内容,若存在多个话题,每个 url 以英文逗号分隔,若没有则值为''

- @ 用户:微博 @ 的用户,若存在多个 @ 用户,每个 url 以英文逗号分隔,若没有则值为''

- 原始微博:为转发微博所特有,是转发微博中那条被转发的微博,存储为字典形式,包含了上述微博信息中的所有内容,如微博 id、微博内容等等

- 结果文件:保存在当前目录 weibo 文件夹下以用户昵称为名的文件夹里,名字为"user_id.csv"形式

- 微博图片:微博中的图片,保存在以用户昵称为名的文件夹下的 img 文件夹里

- 微博视频:微博中的视频,保存在以用户昵称为名的文件夹下的 video 文件夹里

实例

以爬取迪丽热巴的微博为例,我们需要修改 config.json 文件,文件内容如下:

{"user_id_list": ["1669879400"],"only_crawl_original": 1,"since_date": "1900-01-01","query_list": [],"write_mode": ["csv"],"original_pic_download": 1,"retweet_pic_download": 0,"original_video_download": 1,"retweet_video_download": 0,"cookie": "your cookie"

}

对于上述参数的含义以及取值范围,这里仅作简单介绍,详细信息见程序设置。

user_id_list 代表我们要爬取的微博用户的 user_id,可以是一个或多个,也可以是文件路径,微博用户 Dear-迪丽热巴的 user_id 为 1669879400,具体如何获取 user_id 见如何获取 user_id;

only_crawl_original 的值为 1 代表爬取全部原创微博,值为 0 代表爬取全部微博(原创 + 转发);

since_date 代表我们要爬取 since_date 日期之后发布的微博,因为我要爬迪丽热巴的全部原创微博,所以 since_date 设置了一个非常早的值; query_list 代表要爬取的微博关键词,为空([])则爬取全部;

write_mode 代表结果文件的保存类型,我想要把结果写入 csv 文件和 json 文件,所以它的值为["csv", "json"],如果你想写入数据库,具体设置见设置数据库;

original_pic_download 值为 1 代表下载原创微博中的图片,值为 0 代表不下载;

retweet_pic_download 值为 1 代表下载转发微博中的图片,值为 0 代表不下载;

original_video_download 值为 1 代表下载原创微博中的视频,值为 0 代表不下载;

retweet_video_download 值为 1 代表下载转发微博中的视频,值为 0 代表不下载;

cookie 是可选参数,可填可不填,具体区别见添加 cookie 与不添加 cookie 的区别。

配置完成后运行程序:

python weibo.py

程序会自动生成一个 weibo 文件夹,我们以后爬取的所有微博都被存储在 weibo 文件夹里。然后程序在该文件夹下生成一个名为"Dear-迪丽热巴"的文件夹,迪丽热巴的所有微博爬取结果都在这里。"Dear-迪丽热巴"文件夹里包含一个 csv 文件、一个 img 文件夹和一个 video 文件夹,img 文件夹用来存储下载到的图片,video 文件夹用来存储下载到的视频。如果你设置了保存数据库功能,这些信息也会保存在数据库里,数据库设置见设置数据库部分。

csv 文件结果如下所示:

本 csv 文件是爬取“全部微博”(原创微博 + 转发微博)的结果文件。因为迪丽热巴很多微博本身都没有图片、发布工具、位置、话题和 @ 用户等信息,所以当这些内容没有时对应位置为空。"是否原创"列用来标记是否为原创微博, 当为转发微博时,文件中还包含转发微博的信息。为了简便起见,姑且将转发微博中被转发的原始微博称为源微博,它的用户 id、昵称、微博 id 等都在名称前加上源字,以便与目标用户自己发的微博区分。对于转发微博,程序除了获取用户原创部分的信息,还会获取源用户 id、源用户昵称、源微博 id、源微博正文、源微博原始图片 url、源微博位置、源微博日期、源微博工具、源微博点赞数、源微博评论数、源微博转发数、源微博话题、源微博 @ 用户等信息。原创微博因为没有这些转发信息,所以对应位置为空。若爬取的是"全部原创微博",则 csv 文件中不会包含"是否原创"及其之后的转发属性列;

为了说明 json 结果文件格式,这里以迪丽热巴 2019 年 12 月 27 日到 2019 年 12 月 28 日发的 2 条微博为例。

json 结果文件格式如下:

{"user": {"id": "1669879400","screen_name": "Dear-迪丽热巴","gender": "f","birthday": "双子座","location": "上海","education": "上海戏剧学院","company": "嘉行传媒","registration_time": "2010-07-02","sunshine": "信用极好","statuses_count": 1121,"followers_count": 66395881,"follow_count": 250,"description": "一只喜欢默默表演的小透明。工作联系jaywalk@jaywalk.com.cn 🍒","profile_url": "https://m.weibo.cn/u/1669879400?uid=1669879400&luicode=10000011&lfid=1005051669879400","profile_image_url": "https://tvax2.sinaimg.cn/crop.0.0.1080.1080.180/63885668ly8gb5sqc19mqj20u00u0mz5.jpg?KID=imgbed,tva&Expires=1584108150&ssig=Zay1N7KhK1","avatar_hd": "https://wx2.sinaimg.cn/orj480/63885668ly8gb5sqc19mqj20u00u0mz5.jpg","urank": 44,"mbrank": 7,"verified": true,"verified_type": 0,"verified_reason": "嘉行传媒签约演员 "},"weibo": [{"user_id": 1669879400,"screen_name": "Dear-迪丽热巴","id": 4454572602912349,"bid": "ImTGkcdDn","text": "今天的#星光大赏# ","pics": "https://wx3.sinaimg.cn/large/63885668ly1gacppdn1nmj21yi2qp7wk.jpg,https://wx4.sinaimg.cn/large/63885668ly1gacpphkj5gj22ik3t0b2d.jpg,https://wx4.sinaimg.cn/large/63885668ly1gacppb4atej22yo4g04qr.jpg,https://wx2.sinaimg.cn/large/63885668ly1gacpn0eeyij22yo4g04qr.jpg","video_url": "","location": "","created_at": "2019-12-28","source": "","attitudes_count": 551894,"comments_count": 182010,"reposts_count": 1000000,"topics": "星光大赏","at_users": ""},{"user_id": 1669879400,"screen_name": "Dear-迪丽热巴","id": 4454081098040623,"bid": "ImGTzxJJt","text": "我最爱用的娇韵诗双萃精华穿上限量“金”装啦,希望阿丝儿们跟我一起在新的一年更美更年轻,喜笑颜开没有细纹困扰!限定新春礼盒还有祝福悄悄话,大家了解一下~","pics": "","video_url": "","location": "","created_at": "2019-12-27","source": "","attitudes_count": 190840,"comments_count": 43523,"reposts_count": 1000000,"topics": "","at_users": "","retweet": {"user_id": 1684832145,"screen_name": "法国娇韵诗","id": 4454028484570123,"bid": "ImFwIjaTF","text": "#点萃成金 年轻焕新# 将源自天然的植物力量,转化为滴滴珍贵如金的双萃精华。这份点萃成金的独到匠心,只为守护娇粉们的美丽而来。点击视频,与@Dear-迪丽热巴 一同邂逅新年限量版黄金双萃,以闪耀开运金,送上新春宠肌臻礼。 跟着迪迪选年货,还有双重新春惊喜,爱丽丝们看这里! 第一重参与微淘活动邀请好友关注娇韵诗天猫旗舰店,就有机会赢取限量款热巴新年礼盒,打开就能聆听仙女迪亲口送出的新春祝福哦!点击网页链接下单晒热巴同款黄金双萃,并且@法国娇韵诗,更有机会获得热巴亲笔签名的礼盒哦! 第二重转评说出新年希望娇韵诗为你解决的肌肤愿望,截止至1/10,小娇将从铁粉中抽取1位娇粉送出限量版热巴定制礼盒,抽取3位娇粉送出热巴明信片1张~ #迪丽热巴代言娇韵诗#养成同款御龄美肌,就从现在开始。法国娇韵诗的微博视频","pics": "","video_url": "http://f.video.weibocdn.com/003vQjnRlx07zFkxIMjS010412003bNx0E010.mp4?label=mp4_hd&template=852x480.25.0&trans_finger=62b30a3f061b162e421008955c73f536&Expires=1578322522&ssig=P3ozrNA3mv&KID=unistore,video","location": "","created_at": "2019-12-27","source": "微博 weibo.com","attitudes_count": 18389,"comments_count": 3201,"reposts_count": 1000000,"topics": "点萃成金 年轻焕新,迪丽热巴代言娇韵诗","at_users": "Dear-迪丽热巴,法国娇韵诗"}}]

}

下载的图片如下所示:

本次下载了 788 张图片,大小一共 1.21GB,包括她原创微博中的所有图片。图片名为 yyyymmdd+ 微博 id 的形式,若某条微博存在多张图片,则图片名中还会包括它在微博图片中的序号。若某图片下载失败,程序则会以“weibo_id:pic_url”的形式将出错微博 id 和图片 url 写入同文件夹下的 not_downloaded.txt 里;若图片全部下载成功则不会生成 not_downloaded.txt;

下载的视频如下所示:

本次下载了 66 个视频,是她原创微博中的视频和原创微博 Live Photo 中的视频,视频名为 yyyymmdd+ 微博 id 的形式。有三个视频因为网络原因下载失败,程序将它们的微博 id 和视频 url 分别以“weibo_id:video_url”的形式写到了同文件夹下的 not_downloaded.txt 里。

因为我本地没有安装 MySQL 数据库和 MongoDB 数据库,所以暂时设置成不写入数据库。如果你想要将爬取结果写入数据库,只需要先安装数据库(MySQL 或 MongoDB),再安装对应包(pymysql 或 pymongo),然后将 mysql_write 或 mongodb_write 值设置为 1 即可。写入 MySQL 需要用户名、密码等配置信息,这些配置如何设置见设置数据库部分。

运行环境

- 开发语言:python2/python3

- 系统: Windows/Linux/macOS

使用说明

1.下载脚本

git clone https://github.com/dataabc/weibo-crawler.git

运行上述命令,将本项目下载到当前目录,如果下载成功当前目录会出现一个名为"weibo-crawler"的文件夹;

2.安装依赖

pip install -r requirements.txt

3.程序设置

打开 config.json 文件,你会看到如下内容:

{"user_id_list": ["1669879400"],"only_crawl_original": 1,"remove_html_tag": 1,"since_date": "2018-01-01","write_mode": ["csv"],"original_pic_download": 1,"retweet_pic_download": 0,"original_video_download": 1,"retweet_video_download": 0,"download_comment":1,"comment_max_download_count":1000,"download_repost": 1,"repost_max_download_count": 1000,"user_id_as_folder_name": 0,"cookie": "your cookie","mysql_config": {"host": "localhost","port": 3306,"user": "root","password": "123456","charset": "utf8mb4"},"mongodb_URI": "mongodb://[username:password@]host[:port][/[defaultauthdb][?options]]","post_config": {"api_url": "https://api.example.com","api_token": ""}

}

下面讲解每个参数的含义与设置方法。

设置 user_id_list

user_id_list 是我们要爬取的微博的 id,可以是一个,也可以是多个,例如:

"user_id_list": ["1223178222", "1669879400", "1729370543"],

上述代码代表我们要连续爬取 user_id 分别为“1223178222”、 “1669879400”、 “1729370543”的三个用户的微博,具体如何获取 user_id 见如何获取 user_id。

user_id_list 的值也可以是文件路径,我们可以把要爬的所有微博用户的 user_id 都写到 txt 文件里,然后把文件的位置路径赋值给 user_id_list。

在 txt 文件中,每个 user_id 占一行,也可以在 user_id 后面加注释(可选),如用户昵称等信息,user_id 和注释之间必需要有空格,文件名任意,类型为 txt,位置位于本程序的同目录下,文件内容示例如下:

1223178222 胡歌

1669879400 迪丽热巴

1729370543 郭碧婷

假如文件叫 user_id_list.txt,则 user_id_list 设置代码为:

"user_id_list": "user_id_list.txt",

设置 only_crawl_original

only_crawl_original 控制爬取范围,值为 1 代表爬取全部原创微博,值为 0 代表爬取全部微博(原创 + 转发)。例如,如果要爬全部原创微博,请使用如下代码:

"only_crawl_original": 1,

设置 since_date

since_date 值可以是日期,也可以是整数。如果是日期,代表爬取该日期之后的微博,格式应为“yyyy-mm-dd”,如:

"since_date": "2018-01-01",

代表爬取从 2018 年 1 月 1 日到现在的微博。

如果是整数,代表爬取最近 n 天的微博,如:

"since_date": 10,

代表爬取最近 10 天的微博,这个说法不是特别准确,准确说是爬取发布时间从 10 天前到本程序开始执行时之间的微博。

since_date 是所有 user 的爬取起始时间,非常不灵活。如果你要爬多个用户,并且想单独为每个用户设置一个 since_date,可以使用定期自动爬取微博方法二中的方法,该方法可以为多个用户设置不同的 since_date,非常灵活。

设置 query_list(可选)

query_list 是一个关键词字符串列表或以 , 分隔关键词的字符串,用于指定关键词搜索爬取,若为空 [] 或 "" 则爬取全部微博。例如要爬取用户包含“梦想”和“希望”的微博,则设定如下:

"query_list": ["梦想","希望"],

"query_list": "梦想,希望",

请注意,关键词搜索必须设定 cookie 信息。query_list 是所有 user 的爬取关键词,非常不灵活。如果你要爬多个用户,并且想单独为每个用户设置一个 query_list,可以使用定期自动爬取微博方法二中的方法,该方法可以为多个用户设置不同的 query_list,非常灵活。

设置 remove_html_tag

remove_html_tag 控制是否移除抓取到的 weibo 正文和评论中的 html tag,值为 1 代表移除,值为 0 代表不移除,如

"remove_html_tag": 1,

代表移除 html tag。

例如 专属新意,色彩启程~<a href='/n/路易威登'>@路易威登</a> CAPUCINES 手袋正合我意,打开灵感包袋的搭配新方式! 会被处理成 专属新意,色彩启程~@路易威登 CAPUCINES 手袋正合我意,打开灵感包袋的搭配新方式!。

设置 write_mode

write_mode 控制结果文件格式,取值范围是 csv、json、post、mongo、mysql 和 sqlite,分别代表将结果写入 csv、json 文件,通过 POST 发出,MongoDB、MySQL 和 SQLite 数据库。write_mode 可以同时包含这些取值中的一个或几个,如:

"write_mode": ["csv", "json"],

代表将结果信息写入 csv 文件和 json 文件。特别注意,如果你想写入数据库,除了在 write_mode 添加对应数据库的名字外,还应该安装相关数据库和对应 python 模块,具体操作见设置数据库部分。

设置 original_pic_download

original_pic_download 控制是否下载原创微博中的图片,值为 1 代表下载,值为 0 代表不下载,如

"original_pic_download": 1,

代表下载原创微博中的图片。

设置 retweet_pic_download

retweet_pic_download 控制是否下载转发微博中的图片,值为 1 代表下载,值为 0 代表不下载,如

"retweet_pic_download": 0,

代表不下载转发微博中的图片。特别注意,本设置只有在爬全部微博(原创 + 转发),即 only_crawl_original 值为 0 时生效,否则程序会跳过转发微博的图片下载。

设置 original_video_download

original_video_download 控制是否下载原创微博中的视频和原创微博 Live Photo 中的视频,值为 1 代表下载,值为 0 代表不下载,如

"original_video_download": 1,

代表下载原创微博中的视频和原创微博 Live Photo 中的视频。

设置 retweet_video_download

retweet_video_download 控制是否下载转发微博中的视频和转发微博 Live Photo 中的视频,值为 1 代表下载,值为 0 代表不下载,如

"retweet_video_download": 0,

代表不下载转发微博中的视频和转发微博 Live Photo 中的视频。特别注意,本设置只有在爬全部微博(原创 + 转发),即 only_crawl_original 值为 0 时生效,否则程序会跳过转发微博的视频下载。

设置 user_id_as_folder_name

user_id_as_folder_name 控制结果文件的目录名,可取值为 0 和 1,默认为 0:

"user_id_as_folder_name": 0,

值为 0,表示将结果文件保存在以用户昵称为名的文件夹里,这样结果更清晰;值为 1 表示将结果文件保存在以用户 id 为名的文件夹里,这样能保证多次爬取的一致性,因为用户昵称可变,用户 id 不可变。

设置 download_comment

download_comment 控制是否下载每条微博下的一级评论(不包括对评论的评论),仅当 write_mode 中有 sqlite 时有效,可取值为 0 和 1,默认为 1:

"download_comment": 1,

值为 1,表示下载微博评论;值为 0,表示不下载微博评论。

设置 comment_max_download_count

comment_max_download_count 控制下载评论的最大数量,仅当 write_mode 中有 sqlite 时有效,默认为 1000:

"comment_max_download_count": 1000,

设置 download_repost

download_repost 控制是否下载每条微博下的转发,仅当 write_mode 中有 sqlite 时有效,可取值为 0 和 1,默认为 1:

"download_repost": 1,

值为 1,表示下载微博转发;值为 0,表示不下载微博转发。

设置 repost_max_download_count

repost_max_download_count 控制下载转发的最大数量,仅当 write_mode 中有 sqlite 时有效,默认为 1000:

"repost_max_download_count": 1000,

值为 1000,表示最多下载每条微博下的 1000 条转发。

设置 cookie(可选)

cookie 为可选参数,即可填可不填,具体区别见添加 cookie 与不添加 cookie 的区别。cookie 默认配置如下:

"cookie": "your cookie",

如果想要设置 cookie,可以按照如何获取 cookie 中的方法,获取 cookie,并将上面的"your cookie"替换成真实的 cookie 即可。

设置 mysql_config(可选)

mysql_config 控制 mysql 参数配置。如果你不需要将结果信息写入 mysql,这个参数可以忽略,即删除或保留都无所谓;如果你需要写入 mysql 且 config.json 文件中 mysql_config 的配置与你的 mysql 配置不一样,请将该值改成你自己 mysql 中的参数配置。

设置 mongodb_URI(可选)

mongodb_URI 是 mongodb 的连接字符串。如果你不需要将结果信息写入 mongodb,这个参数可以忽略,即删除或保留都无所谓;如果你需要写入 mongodb,则需要配置为完整的 mongodb URI。

设置 start_page(可选)

start_page 为爬取微博的初始页数,默认参数为 1,即从所爬取用户的当前第一页微博内容开始爬取。 若在大批量爬取微博时出现中途被限制中断的情况,可通过查看 csv 文件内目前已爬取到的微博数除以 10,向下取整后的值即为中断页数,手动设置 start_page 参数为中断页数,重新运行即可从被中断的节点继续爬取剩余微博内容。

4.设置数据库(可选)

本部分是可选部分,如果不需要将爬取信息写入数据库,可跳过这一步。本程序目前支持 MySQL 数据库和 MongoDB 数据库,如果你需要写入其它数据库,可以参考这两个数据库的写法自己编写。

MySQL 数据库写入

要想将爬取信息写入 MySQL,请根据自己的系统环境安装 MySQL,然后命令行执行:

pip install pymysql

MongoDB 数据库写入

要想将爬取信息写入 MongoDB,请根据自己的系统环境安装 MongoDB,然后命令行执行:

pip install pymongo

MySQL 和 MongDB 数据库的写入内容一样。程序首先会创建一个名为"weibo"的数据库,然后再创建"user"表和"weibo"表,包含爬取的所有内容。爬取到的微博用户信息或插入或更新,都会存储到 user 表里;爬取到的微博信息或插入或更新,都会存储到 weibo 表里,两个表通过 user_id 关联。如果想了解两个表的具体字段,请点击"详情"。

详情

user 表

id:微博用户 id,如"1669879400";

screen_name:微博用户昵称,如"Dear-迪丽热巴";

gender:微博用户性别,取值为 f 或 m,分别代表女和男;

birthday:生日;

location:所在地;

education:教育经历;

company:公司;

sunshine:阳光信用;

registration_time:注册时间;

statuses_count:微博数;

followers_count:粉丝数;

follow_count:关注数;

description:微博简介;

profile_url:微博主页,如 https://m.weibo.cn/u/1669879400?uid=1669879400&luicode=10000011&lfid=1005051669879400;

profile_image_url:微博头像 url;

avatar_hd:微博高清头像 url;

urank:微博等级;

mbrank:微博会员等级,普通用户会员等级为 0;

verified:微博是否认证,取值为 true 和 false;

verified_type:微博认证类型,没有认证值为-1,个人认证值为 0,企业认证值为 2,政府认证值为 3,这些类型仅是个人猜测,应该不全,大家可以根据实际情况判断;

verified_reason:微博认证信息,只有认证用户拥有此属性。

weibo 表

user_id:存储微博用户 id,如"1669879400";

screen_name:存储微博昵称,如"Dear-迪丽热巴";

id:存储微博 id;

text:存储微博正文;

article_url:存储微博中头条文章的 url,如果微博中存在头条文章,就获取该头条文章的 url,否则该值为'';

pics:存储原创微博的原始图片 url。若某条微博有多张图片,则存储多个 url,以英文逗号分割;若该微博没有图片,则值为'';

video_url:存储原创微博的视频 url 和 Live Photo 中的视频 url。若某条微博有多个视频,则存储多个 url,以英文分号分割;若该微博没有视频,则值为'';

location:存储微博的发布位置。若某条微博没有位置信息,则值为'';

created_at:存储微博的发布时间;

source:存储微博的发布工具;

attitudes_count:存储微博获得的点赞数;

comments_count:存储微博获得的评论数;

reposts_count:存储微博获得的转发数;

topics:存储微博话题,即两个#中的内容。若某条微博没有话题信息,则值为'';

at_users:存储微博 @ 的用户。若某条微博没有 @ 的用户,则值为'';

retweet_id:存储转发微博中原始微博的微博 id。若某条微博为原创微博,则值为''。

SQLite 数据库写入脚本会自动建立并配置数据库文件 weibodata.db。

5.运行脚本

大家可以根据自己的运行环境选择运行方式,Linux 可以通过

python weibo.py

运行;

6.按需求修改脚本(可选)

本部分为可选部分,如果你不需要自己修改代码或添加新功能,可以忽略此部分。

本程序所有代码都位于 weibo.py 文件,程序主体是一个 Weibo 类,上述所有功能都是通过在 main 函数调用 Weibo 类实现的,默认的调用代码如下:

if not os.path.isfile('./config.json'):sys.exit(u'当前路径:%s 不存在配置文件config.json' %(os.path.split(os.path.realpath(__file__))[0] + os.sep))with open('./config.json') as f:config = json.loads(f.read())wb = Weibo(config)wb.start() # 爬取微博信息用户可以按照自己的需求调用或修改 Weibo 类。

通过执行本程序,我们可以得到很多信息:

wb.user:存储目标微博用户信息;

wb.user 包含爬取到的微博用户信息,如用户 id、用户昵称、性别、生日、所在地、教育经历、公司、阳光信用、微博注册时间、微博数、粉丝数、关注数、简介、主页地址、头像 url、高清头像 url、微博等级、会员等级、是否认证、认证类型、认证信息等,大家可以点击"详情"查看具体用法。

详情

id:微博用户 id,取值方式为 wb.user['id'],由一串数字组成;

screen_name:微博用户昵称,取值方式为 wb.user['screen_name'];

gender:微博用户性别,取值方式为 wb.user['gender'],取值为 f 或 m,分别代表女和男;

birthday:微博用户生日,取值方式为 wb.user['birthday'],若用户没有填写该信息,则值为'';

location:微博用户所在地,取值方式为 wb.user['location'],若用户没有填写该信息,则值为'';

education:微博用户上学时的学校,取值方式为 wb.user['education'],若用户没有填写该信息,则值为'';

company:微博用户所属的公司,取值方式为 wb.user['company'],若用户没有填写该信息,则值为'';

sunshine:微博用户的阳光信用,取值方式为 wb.user['sunshine'];

registration_time:微博用户的注册时间,取值方式为 wb.user['registration_time'];

statuses_count:微博数,取值方式为 wb.user['statuses_count'];

followers_count:微博粉丝数,取值方式为 wb.user['followers_count'];

follow_count:微博关注数,取值方式为 wb.user['follow_count'];

description:微博简介,取值方式为 wb.user['description'];

profile_url:微博主页,取值方式为 wb.user['profile_url'];

profile_image_url:微博头像 url,取值方式为 wb.user['profile_image_url'];

avatar_hd:微博高清头像 url,取值方式为 wb.user['avatar_hd'];

urank:微博等级,取值方式为 wb.user['urank'];

mbrank:微博会员等级,取值方式为 wb.user['mbrank'],普通用户会员等级为 0;

verified:微博是否认证,取值方式为 wb.user['verified'],取值为 true 和 false;

verified_type:微博认证类型,取值方式为 wb.user['verified_type'],没有认证值为-1,个人认证值为 0,企业认证值为 2,政府认证值为 3,这些类型仅是个人猜测,应该不全,大家可以根据实际情况判断;

verified_reason:微博认证信息,取值方式为 wb.user['verified_reason'],只有认证用户拥有此属性。

wb.weibo:存储爬取到的所有微博信息;

wb.weibo 包含爬取到的所有微博信息,如微博 id、正文、原始图片 url、视频 url、位置、日期、发布工具、点赞数、转发数、评论数、话题、 @ 用户等。如果爬的是全部微博(原创 + 转发),除上述信息之外,还包含原始用户 id、原始用户昵称、原始微博 id、原始微博正文、原始微博原始图片 url、原始微博位置、原始微博日期、原始微博工具、原始微博点赞数、原始微博评论数、原始微博转发数、原始微博话题、原始微博 @ 用户等信息。wb.weibo 是一个列表,包含了爬取的所有微博信息。wb.weibo[0]为爬取的第一条微博,wb.weibo[1]为爬取的第二条微博,以此类推。当 only_crawl_original=1 时,wb.weibo[0]为爬取的第一条原创微博,以此类推。wb.weibo[0]['id']为第一条微博的 id,wb.weibo[0]['text']为第一条微博的正文,wb.weibo[0]['created_at']为第一条微博的发布时间,还有其它很多信息不在赘述,大家可以点击下面的"详情"查看具体用法。

详情

user_id:存储微博用户 id。如 wb.weibo[0]['user_id']为最新一条微博的用户 id;

screen_name:存储微博昵称。如 wb.weibo[0]['screen_name']为最新一条微博的昵称;

id:存储微博 id。如 wb.weibo[0]['id']为最新一条微博的 id;

text:存储微博正文。如 wb.weibo[0]['text']为最新一条微博的正文;

article_url:存储微博中头条文章的 url。如 wb.weibo[0]['article_url']为最新一条微博的头条文章 url,若微博中不存在头条文章,则该值为'';

pics:存储原创微博的原始图片 url。如 wb.weibo[0]['pics']为最新一条微博的原始图片 url,若该条微博有多张图片,则存储多个 url,以英文逗号分割;若该微博没有图片,则值为'';

video_url:存储原创微博的视频 url 和原创微博 Live Photo 中的视频 url。如 wb.weibo[0]['video_url']为最新一条微博的视频 url,若该条微博有多个视频,则存储多个 url,以英文分号分割;若该微博没有视频,则值为'';

location:存储微博的发布位置。如 wb.weibo[0]['location']为最新一条微博的发布位置,若该条微博没有位置信息,则值为'';

created_at:存储微博的发布时间。如 wb.weibo[0]['created_at']为最新一条微博的发布时间;

source:存储微博的发布工具。如 wb.weibo[0]['source']为最新一条微博的发布工具;

attitudes_count:存储微博获得的点赞数。如 wb.weibo[0]['attitudes_count']为最新一条微博获得的点赞数;

comments_count:存储微博获得的评论数。如 wb.weibo[0]['comments_count']为最新一条微博获得的评论数;

reposts_count:存储微博获得的转发数。如 wb.weibo[0]['reposts_count']为最新一条微博获得的转发数;

topics:存储微博话题,即两个#中的内容。如 wb.weibo[0]['topics']为最新一条微博的话题,若该条微博没有话题信息,则值为'';

at_users:存储微博 @ 的用户。如 wb.weibo[0]['at_users']为最新一条微博 @ 的用户,若该条微博没有 @ 的用户,则值为'';

retweet:存储转发微博中原始微博的全部信息。假如 wb.weibo[0]为转发微博,则 wb.weibo[0]['retweet']为该转发微博的原始微博,它存储的属性与 wb.weibo[0]一样,只是没有 retweet 属性;若该条微博为原创微博,则 wb[0]没有"retweet"属性,大家可以点击"详情"查看具体用法。

详情

假设爬取到的第 i 条微博为转发微博,则它存在以下信息:

user_id:存储原始微博用户 id。wb.weibo[i-1]['retweet']['user_id']为该原始微博的用户 id;

screen_name:存储原始微博昵称。wb.weibo[i-1]['retweet']['screen_name']为该原始微博的昵称;

id:存储原始微博 id。wb.weibo[i-1]['retweet']['id']为该原始微博的 id;

text:存储原始微博正文。wb.weibo[i-1]['retweet']['text']为该原始微博的正文;

article_url:存储原始微博中头条文章的 url。如 wb.weibo[i-1]['retweet']['article_url']为该原始微博的头条文章 url,若原始微博中不存在头条文章,则该值为'';

pics:存储原始微博的原始图片 url。wb.weibo[i-1]['retweet']['pics']为该原始微博的原始图片 url,若该原始微博有多张图片,则存储多个 url,以英文逗号分割;若该原始微博没有图片,则值为'';

video_url:存储原始微博的视频 url 和原始微博 Live Photo 中的视频 url。如 wb.weibo[i-1]['retweet']['video_url']为该原始微博的视频 url,若该原始微博有多个视频,则存储多个 url,以英文分号分割;若该微博没有视频,则值为'';

location:存储原始微博的发布位置。wb.weibo[i-1]['retweet']['location']为该原始微博的发布位置,若该原始微博没有位置信息,则值为'';

created_at:存储原始微博的发布时间。wb.weibo[i-1]['retweet']['created_at']为该原始微博的发布时间;

source:存储原始微博的发布工具。wb.weibo[i-1]['retweet']['source']为该原始微博的发布工具;

attitudes_count:存储原始微博获得的点赞数。wb.weibo[i-1]['retweet']['attitudes_count']为该原始微博获得的点赞数;

comments_count:存储原始微博获得的评论数。wb.weibo[i-1]['retweet']['comments_count']为该原始微博获得的评论数;

reposts_count:存储原始微博获得的转发数。wb.weibo[i-1]['retweet']['reposts_count']为该原始微博获得的转发数;

topics:存储原始微博话题,即两个#中的内容。wb.weibo[i-1]['retweet']['topics']为该原始微博的话题,若该原始微博没有话题信息,则值为'';

at_users:存储原始微博 @ 的用户。wb.weibo[i-1]['retweet']['at_users']为该原始微博 @ 的用户,若该原始微博没有 @ 的用户,则值为''。

7.定期自动爬取微博(可选)

我们爬取了微博以后,很多微博账号又可能发了一些新微博,定期自动爬取微博就是每隔一段时间自动运行程序,自动爬取这段时间产生的新微博(忽略以前爬过的旧微博)。本部分为可选部分,如果不需要可以忽略。

思路是利用第三方软件,如 crontab,让程序每隔一段时间运行一次。因为是要跳过以前爬过的旧微博,只爬新微博。所以需要设置一个动态的 since_date。很多时候我们使用的 since_date 是固定的,比如 since_date="2018-01-01",程序就会按照这个设置从最新的微博一直爬到发布时间为 2018-01-01 的微博(包括这个时间)。因为我们想追加新微博,跳过旧微博。第二次爬取时 since_date 值就应该是当前时间到上次爬取的时间。 如果我们使用最原始的方式实现追加爬取,应该是这样:

假如程序第一次执行时间是2019-06-06,since_date假如为2018-01-01,那这一次就是爬取从2018-01-01到2019-06-06这段时间用户所发的微博;

第二次爬取,我们想要接着上次的爬,需要手动将since_date值设置为上次程序执行的日期,即2019-06-06

上面的方法太麻烦,因为每次都要手动设置 since_date。因此我们需要动态设置 since_date,即程序根据实际情况,自动生成 since_date。 有两种方法实现动态更新 since_date:

方法一:将 since_date 设置成整数

将 config.json 文件中的 since_date 设置成整数,如:

"since_date": 10,

这个配置告诉程序爬取最近 10 天的微博,更准确说是爬取发布时间从 10 天前到本程序开始执行时之间的微博。这样 since_date 就是一个动态的变量,每次程序执行时,它的值就是当前日期减 10。配合 crontab 每 9 天或 10 天执行一次,就实现了定期追加爬取。

方法二:将上次执行程序的时间写入文件(推荐)

这个方法很简单,就是用户把要爬的用户 id 写入 txt 文件,然后再把文件路径赋值给 config.json 中的 user_id_list 参数。

txt 文件名格式可以参考程序设置中的设置 user_id_list 部分,这样设置就全部结束了。

说下这个方法的原理和好处,假如你的 txt 文件内容为:

1669879400

1223178222 胡歌

1729370543 郭碧婷 2019-01-01

第一次执行时,因为第一行和第二行都没有写时间,程序会按照 config.json 文件中 since_date 的值爬取,第三行有时间“2019-01-01”,程序就会把这个时间当作 since_date。每个用户爬取结束程序都会自动更新 txt 文件,每一行第一部分是 user_id,第二部分是用户昵称,第三部分是程序准备爬取该用户第一条微博(最新微博)时的日期。爬完三个用户后,txt 文件的内容自动更新为:

1669879400 Dear-迪丽热巴 2020-01-18

1223178222 胡歌 2020-01-18

1729370543 郭碧婷 2020-01-18

下次再爬取微博的时候,程序会把每行的时间数据作为 since_date。这样的好处一是不用修改 since_date,程序自动更新;二是每一个用户都可以单独拥有只属于自己的 since_date,每个用户的 since_date 相互独立,互不干扰,格式为 yyyy-mm-dd 或整数。比如,现在又添加了一个新用户,以杨紫的微博为例,你想获取她 2018-01-23 到现在的全部微博,可以这样修改 txt 文件:

1669879400 迪丽热巴 2020-01-18

1223178222 胡歌 2020-01-18

1729370543 郭碧婷 2020-01-18

1227368500 杨紫 3 梦想,希望

注意每一行的用户配置参数以空格分隔,如果第一个参数全部由数字组成,程序就认为此行为一个用户的配置,否则程序会认为该行只是注释,跳过该行;第二个参数可以为任意格式,建议写用户昵称;第三个如果是日期格式(yyyy-mm-dd),程序就将该日期设置为用户自己的 since_date,否则使用 config.json 中的 since_date 爬取该用户的微博,第二个参数和第三个参数也可以不填。 也可以设置第四个参数,将被读取为 query_list。

方法三:将 const.py文件中的运行模式改为 append

以追加模式运行程序,每次运行,每个 id 只获取最新的微博,而不是全部,避免频繁备份微博导致过多的请求次数。

注意:

- 该模式会跳过置顶微博。

- 若采集信息后用户又编辑微博,则不会记录编辑内容。

8.使用 docker

docker run

docker build -t weibo-crawler .

docker run -it -d \-v path/to/config.json:/app/config.json \-v path/to/weibo:/app/weibo \-e schedule_interval=1 \ # 可选:循环间隔(分钟)weibo-crawler

docker compose

version: '3'

services:weibo-crawler:build:context: .dockerfile: Dockerfilevolumes:- path/to/config.json:/app/config.json- path/to/weibo:/app/weiboenvironment:- schedule_interval=1 # 可选:循环间隔(分钟)如何获取 user_id

1.打开网址 https://weibo.cn,搜索我们要找的人,如"迪丽热巴",进入她的主页;

2.按照上图箭头所指,点击"资料"链接,跳转到用户资料页面;

如上图所示,迪丽热巴微博资料页的地址为" https://weibo.cn/1669879400/info",其中的"1669879400"即为此微博的 user_id。

事实上,此微博的 user_id 也包含在用户主页 (https://weibo.cn/u/1669879400?f=search_0)中,之所以我们还要点击主页中的"资料"来获取 user_id,是因为很多用户的主页不是"https://weibo.cn/user_id?f=search_0"的形式,

而是" https://weibo.cn/个性域名?f=search_0 " 或 " https://weibo.cn/微号?f=search_0"的形式。其中"微号"和 user_id 都是一串数字,如果仅仅通过主页地址提取 user_id,很容易将"微号"误认为 user_id。

添加 cookie 与不添加 cookie 的区别(可选)

对于微博数 2000 条及以下的微博用户,不添加 cookie 可以获取其用户信息和大部分微博;对于微博数 2000 条以上的微博用户,不添加 cookie 可以获取其用户信息和最近 2000 条微博中的大部分,添加 cookie 可以获取其全部微博。

以 2020 年 1 月 2 日迪丽热巴的微博为例,此时她共有 1085 条微博,在不添加 cookie 的情况下,可以获取到 1026 条微博,大约占全部微博的 94.56%,而在添加 cookie 后,可以获取全部微博。

其他用户类似,大部分都可以在不添加 cookie 的情况下获取到 90% 以上的微博,在添加 cookie 后可以获取全部微博。具体原因是,大部分微博内容都可以在移动版匿名获取,少量微博需要用户登录才可以获取,所以这部分微博在不添加 cookie 时是无法获取的。

有少部分微博用户,不添加 cookie 可以获取其微博,无法获取其用户信息。对于这种情况,要想获取其用户信息,是需要 cookie 的。

如需抓取微博转发,请添加 cookie。

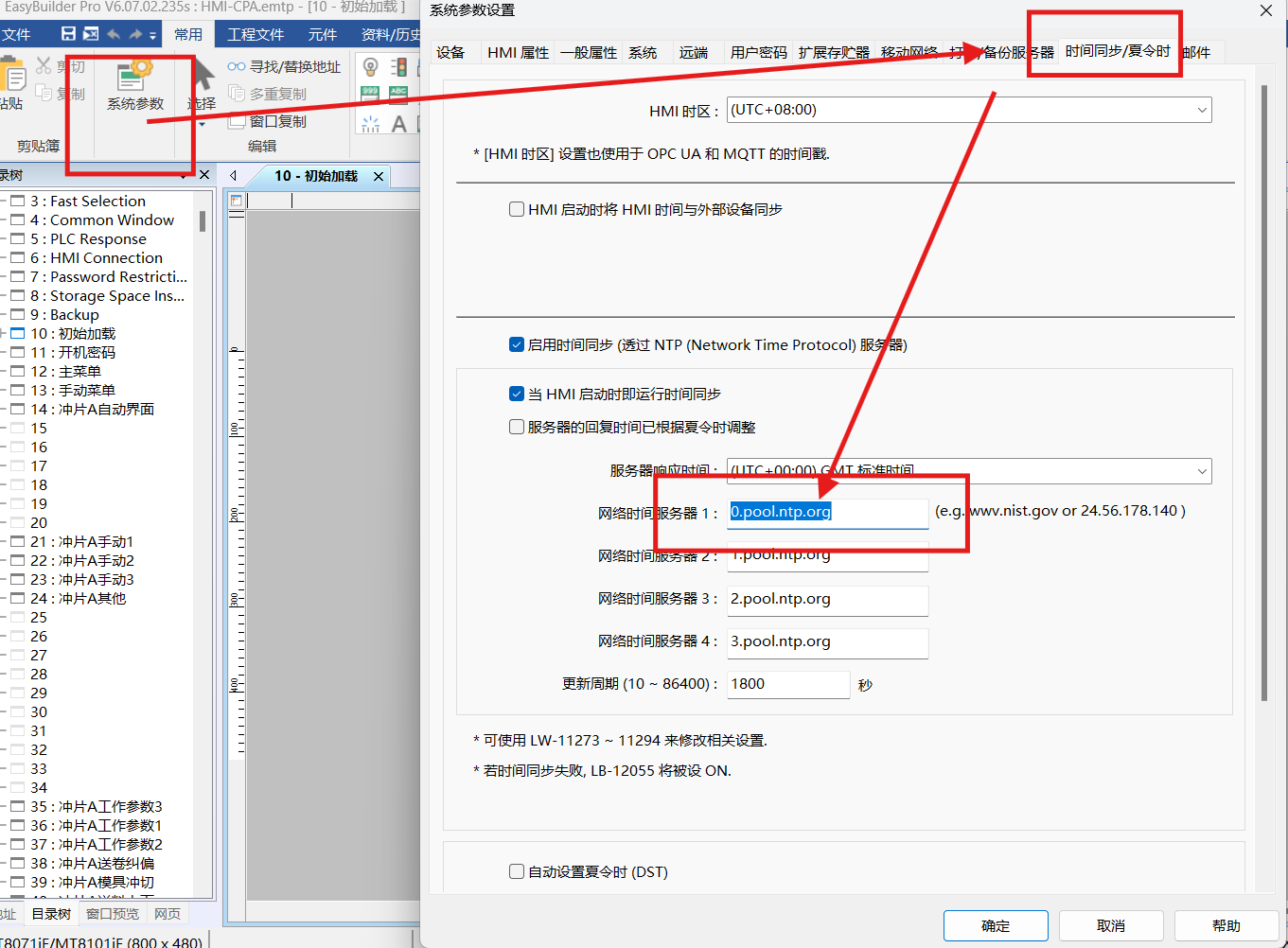

如何获取 cookie(可选)

1.用 Chrome 打开 https://passport.weibo.cn/signin/login;

2.输入微博的用户名、密码,登录,如图所示:登录成功后会跳转到 https://m.weibo.cn;

3.按 F12 键打开 Chrome 开发者工具,在地址栏输入并跳转到 https://weibo.cn,跳转后会显示如下类似界面:

4.依此点击 Chrome 开发者工具中的 Network->Name 中的 weibo.cn->Headers->Request Headers,"Cookie:"后的值即为我们要找的 cookie 值,复制即可,如图所示:

如何检测 cookie 是否有效(可选)

本程序 cookie 检查的逻辑是:使用 cookie 来源账号发布限定范围的微博,若 cookie 可用,则可以读取到该微博,否则读取不到。操作方法:

-

使用 cookie 的来源账号发布一条微博,该账号和微博需要满足以下条件:

- 该微博必须是非公开可见的,后续需要根据可见性判断 cookie 是否有效;

- 该微博需要是最近 5 条微博,不能在发布测试用微博内容后又发很多新微博;

- 在

config.json配置中的 since_date 之后,该账号必须有大于 9 条微博。

-

将

const.py文件中'CHECK': False中的False改为True,'HIDDEN_WEIBO': '微博内容'中的微博内容改为你发的限定范围的微博。 -

将提供 cookie 的微博 id 放置在

config.json文件中"user_id_list"设置项数组中的第一个。例如提供 cookie 的微博 id 为123456,则"user_id_list"设置为"user_id_list":["123456", "<其余id...>"]。

注:本方法也将会抓取提供 cookie 账号的微博内容。

在间歇运行程序时,cookie 无效会导致程序不能按照预设目标执行,因此可以打开 cookie 通知功能。本项目使用开源项目 pushdeer 进行通知,在使用前用户需要申请 push_key,具体可查看官网了解。打开方法为:

- 在

const.py文件中,将'NOTIFY': False中的False设为True; - 将

'PUSH_KEY': ''的''替换为'<你的push_key>'

该文章为 weibo-crawler 的官方文档,为了方便国内的同学阅读而转载。

该文章为 weibo-crawler 的官方文档,为了方便国内的同学阅读而转载。