TowardsDataScience 博客中文翻译 2022(四十四)

原文:TowardsDataScience

协议:CC BY-NC-SA 4.0

Python 中的求根方法

原文:https://towardsdatascience.com/root-finding-methods-from-scratch-in-python-84040c81a8ba

使用 Python 的二分法、牛顿法和割线法数学求根算法

介绍

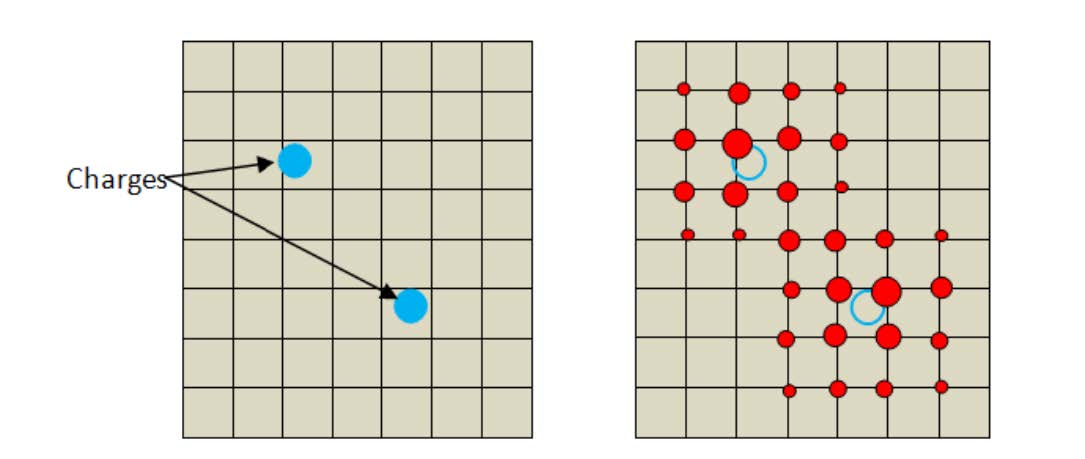

数值根 - 寻找算法迭代计算连续函数的零点的更好近似,也称为根。

本文介绍了四种标准求根算法背后的理论,以及它们在 Python 中的实现。

照片由 Esther Jiao 在 Unsplash 上拍摄

以等式 1 为例:

等式 1 —示例函数(图片由作者提供)

图 1 是在区间[-1,5]上等式 1 的图。一个零或根是 f(x)等于 0 时 x 的任意值。即曲线穿过 x 轴的位置。在这种情况下,根位于 x₀ = 1 和 x ₁ = 2 之间。

图 1 —等式 1 的曲线图(图片由作者提供)

本文的目标是使用一些数值运算来逼近 Python 中的根。

实现这一目标的三种方法是:

- 二分法

- 牛顿方法

- 割线法

二分法

二分法通过在中点重复划分区间来逼近连续函数的根。

该技术适用于两个符号相反的值已知的情况。

如果区间【x₀,x₁】上有一个 f(x) 的根,那么【f(x₀】【f(x₁】一定有不同的符号。即**【f(x₀)f(x₁】<0**。

如有必要,复习这篇介值定理文章。

*https://medium.com/@andrewdaviesul/checking-if-a-solution-exists-intermediate-value-theorem-53d85890350

设 x₀ 和 x₁ 为估计区间的起点和终点。然后,用等式 2 计算出*【x₀,x₁】*之间的中点( x₂ )。

等式 2 —二分法(图片由作者提供)

接下来的猜测要么是 x₀ 和 x₂ 的中点,要么是 x₂ 和 x₁ 的中点,就看根落在哪边了。收敛缓慢 。

要点 1 给出了二分法的示例实现。

要点 Python 中的二分法

存储逐次根逼近和绘图图 2 说明了算法的迭代性质。

图 2-对分根估计的迭代改进(图片由作者提供)

对等式 1 运行二分法,在*【1,2】之间指定一个区间*,在x≈1.324718475处返回一个解。查看图 1 可以看出,这个值在期望值附近。

这个过程大约需要 18 次迭代才能达到这个结果。评估改进是逐渐发生的*。*

关于该算法的最后一点是,可以使用等式 3估计实现特定误差界限所需的最小迭代次数*。*

等式 3 —迭代次数(图片由作者提供)

x₀ 和 x₁ 是区间起点和终点,例如【1,2】。**

*https://scicomp.stackexchange.com/questions/16458/deriving-the-error-bound-for-bisection-method

使用 Gist 3 中的 Python 代码实现该等式。

要点 2 —误差界限和迭代计数器*

牛顿方法

可能是最著名的求根算法,牛顿法 逼近实值连续函数的零点。从解的初始猜测开始,等式 4 迭代使用函数和导数在 xₙ 处的值的知识来改进近似。

- n :迭代计数器

- xₙ₊₁:下一步估计

- xₙ:目前最好的估计

- f(xₙ):函数在 xₙ 求值

- f'(xₙ) :在 xₙ 的 f 的导数

等式 4——牛顿法(图片由作者提供)

显然,这个过程需要 f(x) 的一阶导数,因此 f(x) 必须是可微的。**

Gist 3 提供了 Python 代码来实现牛顿法的迭代解*。它使用 Sympy 库来评估 f'(xₙ) 。在每次通过循环时,参数值被代入到等式 1 中,以确定 xₙ₊₁ 。*

一个公差 极限控制过程何时中断,当 f(xₙ) 接近零点时触发该条件。

要点 3——具有符号评估的牛顿法的迭代解

如上,保存每个猜测和绘图图 3 显示了牛顿法如何逼近正确解。

图 3 —牛顿零猜测的改进(图片由作者提供)

初始猜测为 x = 9 ,该方法返回的结果为f(x)= 0*@x = 1.324718834。需要 8 次迭代才能达到 1e-5 的精度。*

牛顿法的收敛速度比二分法快得多,但有其局限性,这取决于所讨论的函数的导数。

割线法

割线法*与二分法非常相似,只是不是在中点处划分,而是通过连接端点**的割线来划分区间。*

等式 4 将在 Python 中迭代地或递归地或实现。**

等式 4 —割线法(图片由作者提供)

Gist 4 中的 Python 方法递归地使用割线方法求解根。

要点 4——具有符号评估的牛顿法的迭代解

从初始值 x₀ = 1 和 x₁ = 2 开始,该过程在 8 次递归调用内,在 x = 1.324717957 处输出 f(x) 的根。图 4 显示了每次走刀产生的割线。

图 4——割线法可视化(图片由作者提供)

割线法是仅次于牛顿法的*。最适用于需要比二分法更快收敛的情况,但是对函数 f(x) 求解析导数太困难或者*不可能。**

结论

实现求根算法对于学工程和数学的学生来说很有价值。再者,还有很多其他的方法,用户可以探索和扩展自己的知识* 和编码技能,比如布伦特的或者斯特芬森的方法。*

如果你对 Python 、工程学和数据科学感兴趣,请关注并查看我的其他文章。

*https://medium.com/@andrewdaviesul/membership

参考

[1] 微积分:完整教程,第八版 —罗伯特·A·亚当斯,美国北卡罗来纳大学教堂山分校**

舍入器:对复杂 Python 对象中的数字进行舍入

原文:https://towardsdatascience.com/rounder-rounding-numbers-in-complex-python-objects-e4b6f3b563f8

rounder 包使您能够对任何对象中的所有数字进行舍入,只需一个命令

rounder:在 Python 中舍入数字从未如此简单。照片由米卡·鲍梅斯特在 Unsplash 上拍摄

舍入数字很少引起问题。在标准库中,我们有函数round()、math.ceil()和math.floor(),通过它们我们可以使用三种标准类型的舍入。这应该够了,不是吗?

实际上,并不总是这样。假设您有以下对象,您希望将其舍入到两位十进制数字:

注意:在本例中,对象及其特定字段的含义并不重要。它只是一个可能的复杂嵌套对象的表示。然而,为了简单起见,我没有把它弄得太复杂。然而,当使用它时,想象一个复杂的嵌套字典,它的字段是其他嵌套字典、列表和其他类型的对象。

你会怎么做?你如何处理这样一个对象中的所有数字?您可能认为这相对容易,因为只需编写一个专用函数来处理这种特定类型的嵌套对象就足够了。这是可行的,但是如果对象发生了一点点变化呢?你必须更新这个函数,以使它反映对象的新结构。或者,您可以编写一个递归函数来实现这一点,但是该函数不必那么容易编写,因为它需要处理 Python 提供的如此多的不同类型。

因此,从round(1.122, 1)的简单性,我们转移到一个硬编码舍入一个特定类型和结构的对象的函数,或者转移到一个相当困难的递归函数。这不再简单…

这是唯一的方法吗?没有更简单的方法吗?Python 不是承诺简单吗?

简单的方法:rounder

幸运的是,有一个简单的方法:T5 包。它提供了一些函数,允许对许多不同类型的复杂和嵌套对象中的数字进行舍入。

让我们回到我们的例子。我们希望将来自obj对象的数字四舍五入为两位十进制数字。这就是你如何使用rounder来做这件事:

这不是很简单吗?

现在,假设您已经决定将obj中的数字四舍五入到五位有效数字。Python 没有为此提供内置函数,但是rounder提供了。您可以使用rounder.signif()表示数字,使用rounder.signif_object()表示嵌套对象:

注意 : obj是一个可变对象,因为我们之前对它进行了舍入,所以它发生了变化。因此,要再次使用它的原始版本,您需要重新创建它,就像我们在上面创建它一样。

同理,也可以使用rounder.ceil_object()和rounder.floor_object(),分别对应math.ceil()和math.floor()功能。

更多关于rounder

可变对象与不可变对象

我们必须记住,不像不可变的对象,可变的对象在适当的位置被改变*。这意味着当您使用或不使用新名称对其进行更新时,原始对象将被更改。同样的,如果你改变它的(浅层)拷贝,原始对象也会被更新。*

同样的规则也适用于rounder操作。记住这不是典型的rounder而是 Python。换句话说,rounder实现了 Python 处理可变和不可变对象的典型方式。

rounder然而,函数使得处理可变对象更加简单。为了简单起见,这次我们将使用更简单、更小的对象:

我们确实预料到了这一点,但是由于列表是可变的,x也被改变了:

如果你不希望这种情况发生,rounder可以帮助你。可以使用参数use_copy,默认为False;这就是为什么默认情况下,rounder会改变原来的对象。这是 Python 的默认行为:如果你想创建一个对象的副本,你必须手动完成。

注:提浅抄和深抄的好地方。你可以在标准库 [copy](https://docs.python.org/3/library/copy.html) 模块或者这里阅读这个主题。如果你需要或想要加深或更新你的知识,你可以休息一下,现在就做。

这就是use_copy如何改变rounder函数的行为:

我们也可以使用use_copy的其他rounder功能:

至于四舍五入到有效数字,记住这个操作也影响整数:

自定义舍入

rounder包还提供了一个通用函数rounder.map_object(),它使您能够应用任何接受一个数字并返回一个数字的可调用函数(所以,Callable[numbers.Number, numbers.Number])。您可以使用它来应用自定义舍入。

例如,假设您想要对一个浮点数应用以下舍入,比如说x:

- 如果

x是一个整数,原封不动地返回 abs(x) > 100时四舍五入为整数100 > abs(x) > 10时四舍五入到 1 位小数10 > abs(x) > 1时四舍五入到 2 位小数- 否则,四舍五入到 3 位小数

例如,当您用不同单位或不同比例的数字对对象进行舍入时,可以使用这种舍入方法。下面的函数可以做到这一点:

这个函数的名字round_float意味着它将只对浮点进行舍入。它可以被命名为round_only_floats,但是这个名字不能完全代表它的功能;这是因为它不舍入非数字。所以,我把它命名为round_float,以区别于round。

让我们来看看实际情况:

现在,让我们对上面使用的obj对象使用这个函数:

如您所见,该函数的签名类似于[map()](/does-python-still-need-the-map-function-96787ea1fb05)函数的签名,第一个参数是一个可调用的,用于作为第二个参数提供的对象。这可以帮助你记住如何使用rounder.map_object()。

实际上,你可以使用这个函数将任何可调用的Callable[numbers.Number, numbers.Number]应用于对象中的所有数字,甚至是那些与舍入无关的数字。考虑这个例子:

类型

值得一提的是,rounder的函数支持许多不同的类型,比如所有内置的容器类型(如dict、list、tuple和set),还有生成器、map和filter对象、队列、命名元组、array.array等等。你会在包的仓库中找到他们的列表。注意,当您将一个generator类型输入到一个rounder函数中时,您也会收到一个生成器。

异常处理

典型的舍入函数在用于非数字时会抛出TypeError:

rounder.signif()功能的运行方式类似:

名称以_object结尾的rounder函数则不然:

这些函数的行为是这样的,因为当对象是对象的容器时,函数递归地在它们上面运行,舍入(如果不是数字,则不舍入)对象的每个最低级别的元素。

履行

高级开发人员可能会欣赏rounder的开发方式。这一想法来自该计划的合著者路德·范·德·哈姆。这个包的本质是使用闭包实现的,这是一种优雅的方法——比包的第一个版本(未发布)中使用的最初的基于类的方法优雅得多。

你可以从包库中,特别是从它的主模块 [rounder](https://github.com/nyggus/rounder/blob/main/rounder/rounder.py)中,了解更多关于包的实现。

结论

rounder封装使舍入变得容易。有了它,您可以使用最常见的舍入方法:

- 将一个数字四舍五入到特定的小数位数(

round_object()); - 将一个数字向下(

floor_object())或向上(ceil_object())舍入到最接近的整数; - 将数字舍入到特定的有效数字(

signif()和signif_object());

而且是一种定制的舍入方法,这要归功于

- 使用自定义函数(

map_object())对数字进行舍入。

但这并不是rounder如此有用的原因。它非常有用,因为您可以对任何复杂和/或嵌套的对象类型使用名称以_object结尾的rounder函数,该函数将对对象中的所有数字进行舍入。

这个包还简化了可变对象的操作。通常,当您想要创建一个可变对象的副本时,您需要调用copy.deepcopy(),这将创建该对象的深层副本。有了 rounder,你就不必这样做了;使用use_copy=True参数就够了,函数会帮你做。

简而言之,每当你需要在比一个数字更复杂的对象中舍入数字时(比如一个遵循numbers.Number抽象基类的对象),你会发现rounder特别有用。它的功能也适用于常规数字。随着rounder包的出现,我们想要舍入所有数字的对象的复杂性不再是问题。

资源

*https://github.com/nyggus/rounder https://realpython.com/copying-python-objects/ *

魔方求解器

原文:https://towardsdatascience.com/rubiks-cube-solver-96fa6c56fbe4

用 Python 3 构建魔方解算器

解魔方|作者图片

大家好,今天我们将使用 python 3 创建一个魔方解算器。在这篇博客文章中,我将介绍游戏理论和所需的算法,这样你就可以轻松地击败任何魔方。

随着魔方的流行,我敢肯定你以前见过一个,但以防万一你没有,我会给他们一个快速的纲要。魔方是由 ernő·鲁比克发明的一种流行游戏。魔方有一套简单的规则,解读混乱的三维拼图。传统上,魔方是一个 3x3 的立方体,但现在有许多经典游戏的变体。

魔方是要解决的复杂谜题,共有 43,252,003,274,489,856,000 种可能的组合。

魔方方程式的排列|作者图片

由于这种复杂性,从业余爱好者到数学家,许多人都在研究魔方。由于立方体的复杂群论,数学家们已经喜欢上了它,产生了许多关于这个主题的科学论文。

其中一张意义重大的纸是纸“魔方组的直径是二十个”在这篇论文中,他们确定“上帝的数字”是 20 转。“神数”是魔方的一个术语,指的是在任何构型下解决一个魔方的最大转动次数。

这项研究的另一个令人印象深刻的成果是各种解决立方体问题的标准化算法。

构建立方体

好了,现在我们有了魔方的背景知识,我们的第一步将是建立一个。为了简单起见,我们将坚持 nxn 立方体,这样我们就不需要处理任何其他三维形状的几何图形(有时拼图是其他形状,如正方形或三角形)。

平铺多维数据集视图|作者提供的图像

为了构建我们的多维数据集,让我们为用户创建一个自定义的交互类。这样,我们可以将内部状态存储在多维数据集对象中,以减少在操作多维数据集时需要传递给每个函数的变量数量。

首先,我们需要确定创建多维数据集的最有效的数据结构。为了这个项目,我们将使用一个三维数组(嵌套列表)。由于需要对立方体进行操作,我选择了这种数据结构。使用一个三维数组,我们可以创建映射来平均在 O(n) 时间内将方块切换到位。

3D 阵列表示|作者图片

接下来,我们需要构建三个独立的函数来操作立方体。使用魔方,您只能进行三种可能的移动。

魔方运动|作者图片

我们的三个动作功能都采取了非常相似的方法。我们使用映射来切换立方体的位置。对于垂直和侧向扭曲函数,我们使用 For 循环遍历列的每一行,使得这些函数的时间复杂度为 O(n)。但是,水平扭曲函数会原地切换行,时间复杂度为 O(1)。我们还检查是否需要在每次旋转时旋转最近的面。为了旋转魔方的面,我们转置各自的矩阵。

求解立方体

现在我们有了魔方的工作模型,让我们开始制作求解器。

对于求解者,我们可以采用多种方法来解决这个问题。然而,我们将采取游戏树的方法。

用博弈树的方法,我们知道我们将需要搜索博弈树来找到可能解决立方体的最少移动。我们可以使用蛮力方法,然而,以今天的计算限制,这是不可行的。相反,我们将使用更有效的搜索算法。

我们要用的算法是迭代深化 A* (IDA*)搜索算法。由于内存限制,该算法优于 A* 。A和 IDA使用类似的方法,其中 A记得哪些节点被访问过,而 IDA不记得。通常情况下,A是搜索问题的最佳选择,然而,对于如此大的搜索空间,如果我们使用 A,很可能会耗尽内存。

IDA是一种树形搜索方法,它结合了试探法和深度优先搜索 (DFS)。在 IDA中,启发式算法指导 DFS,树在每次迭代中扩展,类似于蒙特卡罗树搜索(参见我的博客文章构建国际象棋引擎:第二部分关于 MCTS 的解释)。

下面是 IDA*方法的示例树。在这个图中,我显示了 g_score(到达当前节点的成本)和 h_score(前面路径的预测成本)。该算法使用 g_score 和 h_score 的简单和来评估每个节点。

IDA*游戏树示例|作者图片

如之前在 IDA*中所述,我们不会保存已访问的节点。不保存访问过的节点有利也有弊。通过不保存被访问的节点,我们有机会访问同一个节点两次,这给了我们整个算法更差的时间复杂度。然而,通过不保存我们访问过的节点,我们不需要那么多的内存。对于我们的用例,节省内存是很重要的,因为我们正在处理一个可能有 43,252,003,274,489,856,000 个节点的博弈树。

好了,现在我们对将要使用的算法有了更好的理解,让我们来构建它。首先需要做的是建立我们的启发式。

对于我们的试探法,我们将采用简单的强力方法,并使用广度优先搜索算法来检查节点。在这里,我们将把立方体的不同状态以及从已求解的立方体到达那里的移动次数存储在一个哈希表中。通过将多维数据集状态存储在哈希表中,我们创建了一个简单的查找表来了解哪个状态需要解决的移动量最少。

现在我们有了试探法,我们可以实现 IDA*算法来求解立方体。构建该算法将使用简单的 DFS(深度优先搜索)算法和上述评分方法(g_score + h_score)。当访问每个节点时,会传入我们前一个节点的 g_score 来知道当前的开销。为了确定 h_score,将在我们的启发式图中快速查找节点。为了简单起见,如果我们发现一个不在我们的启发式地图中的节点,就将 h_score 设置为 20(上帝的数字)。在这里,我们可以创建一些额外的等式来获得更好的估计,但对于我们的简单用例,这是不需要的(如果你有一个等式,请随意在评论中留下它)。综上所述,我们应该得到类似下面的代码。

谢谢

就这样,我们成功地创建了我们的魔方解算器。你可以在我的 GitHub 上查看完整版本的代码。

感谢阅读。如果你喜欢这样,可以考虑订阅我的账户,以便在我最近发帖时得到通知。

参考

- https://en.wikipedia.org/wiki/Rubik%27s_Cube

- https://ruwix . com/the-Rubik-cube/how-to-solve-the-Rubik-cube-初学者-方法/

- https://medium . com/@ chaitanyaanimesh/calculating-of-number of-the-permutating-of-the-number of-the-rubkis-cube-121066 f5f 054

- https://en.wikipedia.org/wiki/Ern%C5%91_Rubik

- https://en.wikipedia.org/wiki/Big_O_notation

- http://kociemba.org/math/papers/rubik20.pdf

- https://en.wikipedia.org/wiki/Game_tree

- https://en.wikipedia.org/wiki/Iterative_deepening_A*

- https://en.wikipedia.org/wiki/A*_search_algorithm

- https://en . Wikipedia . org/wiki/Heuristic _(计算机科学)

- https://medium . com/forward-data-science/building-a-chess-engine-part 2-db 4784 e 843d 5

ruDALL-e,或来自俄罗斯的 AI

原文:https://towardsdatascience.com/rudall-e-or-from-russia-with-ai-5fbd098fc77b

用于文本 2 图像生成的多模态方法,具有示例和实验

“всянашажизнь—театр”//“整个世界是一个舞台”(ruDALLe) //作者截图

TL;博士: ruDALL-e 与 DALL E 毫无关系,却承载着许多惊喜和激动人心的现象。

I2021 年开始,OpenAI 以另一组里程碑事件再次震惊世界:多模态 CLIP 和 DALL E ,能够通过提示将文本直接转换为图像(我写了关于这种模式及其文化影响)。即使 DALL E 仍然不能公开使用(剧透:敬请关注),CLIP 还是以开源形式发布——全世界的聪明人都可以将其应用到独特的生成艺术形式中(我的分析即将到来)。

I2021 年开始,OpenAI 以另一组里程碑事件再次震惊世界:多模态 CLIP 和 DALL E ,能够通过提示将文本直接转换为图像(我写了关于这种模式及其文化影响)。即使 DALL E 仍然不能公开使用(剧透:敬请关注),CLIP 还是以开源形式发布——全世界的聪明人都可以将其应用到独特的生成艺术形式中(我的分析即将到来)。

正如 OpenAI 演示中所描述的,DALL E 的创造能力以敬畏和灵感影响了创造性的 AI 社区。

这不是创造力的昏睡,而是它的催化剂。

事实上,如果你要求创建一个"带有蓝色草莓图像的彩色玻璃窗,你会立即得到一组图像:

OpenAI 博客 //作者截图

你会看到各种各样的设计。他们中的一些是照片般真实的,一些是模糊的,风格和构图各不相同。但它给你带来了更接近视觉的想法。

或者,“一个甜甜圈形状的钟”怎么样?

OpenAI 博客 //作者截图

OpenAI 仍在为 DALL E 进行优化和用例工作,然后才会向全世界发布这一模型。他们肯定会的——他们发布了 GPT 3,现在没有等待名单。一切皆有可能(问题是“什么时候”)。

俄罗斯模特

但是突然间,DALL E 被释放了。

好吧,不是突然。而不是真正的 DALL E。

2020 年,由于 GPT-3 是最理想的 NLP 模型,俄罗斯研究人员公布了由俄罗斯储蓄银行 : ruGPT-3 的人工智能研究实验室创立的项目。它在 600 GB 俄语文本上进行训练,并以 760 Mio (ruGPT-3 Large) 和13 亿(ruGPT-3 XL) 参数发布,比较他们项目描述中的图表。

如果你将这些数据与开放的 GPT 模型进行比较,你会发现这一点。最大的 GPT-2 型号与15 亿参数一起工作。真正的 GPT-3 (带达芬奇发动机)运行1750 亿参数。

结论是:俄语 ruGPT-3 XL 处于 GPT-2 的水平上(但是在大量的俄语文本、文章、书籍数据集上进行训练)。显著差异:俄语模型可以生成比 OpenAI(在英语文本上训练)的 GPT-2 质量更好的俄语文本。数据集事关。然而,它不能用俄语用烤面包机写情书。它不具备抽象认知或文体转换的能力。

所以,去年年底,一个由 Sberbank 资助的新项目发布了:

ruDALL-e。

它与 ruGPT-3 在同一个 Christofari 集群上接受训练,获得 Apache 2.0 许可,并且“堪比 OpenAI 的英文 DALL-e”(引自 ruDALL-e 网站)。

让我们看看,在哪些方面具有可比性。

俄罗斯 DALL-e

ruDALL-e 有两种型号:

Malevich (XL) —运行在 13 亿个参数上,具有图像编码器(定制 VQGAN 型号),可作为储存库和 Colab 笔记本使用,具有实现的升级 RealERSGAN。

康定斯基(XXL) —更好的模型,运行在 120 亿个参数上(像 OpenAI 的 DALL-e),目前还不能用于测试。

由于 DALL-e 不可公开访问,研究人员试图通过与清华大学的 CogView 项目合作,与原始论文( PDF )一起重新创建模型,该项目也试图重新创建 DALL-e。

因此,由于最初的变压器不可用,他们试图重建它的架构——并将其命名为 ruDALL-e 。

但是真的管用吗?

幸运的是,有一个公开的 ruDALL-e 的 Colab 笔记本(使用较小的型号,Malevich )。

关于潜在空间不和谐(由剪辑研究员和艺术家 Advadnoun 创造)的聪明头脑甚至可以优化笔记本——并发现一些奇怪的现象。

明显的例子

因此,让我们看看 ruDALL-e 能否生成 DALL-e 原始文章中引用的示例。

著名的鳄梨椅

DALL-e by OpenAI ( 来源 ) //作者截图

ruDALL-e(马列维奇)//作者截图

在这两种方法的情况下,我们看到模型如何“理解”将现象“椅子”与现象“鳄梨”在“形状”的功能中结合的任务。

就 OpenAI DALL-e 而言,结果看起来比 ruDALL-e Malevich (XL) 更有机。后一种型号选择了特定的特征,如颜色或形状,但是它的生成不太有机(尽管如此有趣)。即使是更大的型号康定斯基(XXL) 也无法再现 DALL-e 的椅子设计质量:

来源:https://rudalle.ru/en/(康定斯基(XXL)) //作者截图

让我们看一些更具体的例子,比如…

桌子上放着一批钟表。

OpenAI 博客 //作者截图

在 OpenAI 的 DALL-e 的例子中,我们可以看到它已经知道了更多关于时钟和它们的设计,相比之下是一个很好的老 BigGAN 。你还记得,回到 2018 年:

比根时钟(2018) //作者创作

BigGAN 可以重新生成视觉元素,如“圆形”、“带箭头”等。在钟表上,通过 DALL-e 你可以看到数字、12 小时设计等。

ruDALL-e //由作者创建

ruDALL-e(上图)很好地传达了视觉效果——图案的多样性很好。然而,它仍然远离 DALL-e 的现实主义。它有 DALL-e 的视觉容量,但比根的理解等级,IMHO。

毕竟,ruDALL-e 的质量仍然令人惊叹——通过集成的 ERSGAN 放大过滤器,你甚至可以以更大的格式调整图像的大小(你也可以直接使用 ERSGAN 完成,然后再使用)。

俄罗斯风格(数据集很重要)

ruDALL-e 最令人兴奋的方面可能是训练数据集。你不会在西方实现中找到这样的内容,因为它源于俄语内容。

如果你用“закатвгороде”(城市的日落)来提示,你会看到一些俄罗斯城镇的美丽景色,主要是莫斯科和圣彼得堡(而不是纽约或伦敦)。在许多照片中,你可以认出莫斯科河、克里姆林宫以及俄罗斯/苏联建筑的古典主义和折衷主义风格。

ruDALL-e 完成,由作者创建

再比如,随着提示“портретгения”(天才的肖像),你会得到流行的俄语教科书的插图,而不是刻板的好莱坞“疯狂科学家”或背景中黑板上有复杂公式的老师的股票图像。(我可以重新构建这一分类,因为“天才”这个可怜的绰号在俄罗斯教科书中伴随着重要的科学家、作家或艺术家时非常明显)。

ruDALL-e 完成,由作者创建

我们甚至可以在这里找到几个被创造性扭曲的名人。

查尔斯-奥古斯丁·德·库仑?// ruDALL-e 完成,由作者创建

这幅肖像在物理教科书中关于库仑定律的描述广为人知,而这幅肖像也在俄罗斯教科书中使用。

数据集问题?

通过使用 ruDALL-e 进行实验,您将会发现并一点一点地重建模型被训练的数据集的内容。

一年前,作为 DALL-e 和 CLIP 由 OpenAI 推出,一位被称为advad noun的传奇艺术家和研究者创作了几本 CLIP Colab 笔记本,成为 2021 年 Text2Image Art 的复兴的基础。在这一年中,世界各地不同的艺术家和研究人员用不同的方法对 100 多台笔记本进行了微调(我会写一篇关于它的评论,我保证)。Advadnoun 用他的开创性实验和不和谐论坛开了一个 Patreon。聚集在那里的有创造力的人们正在探索更多不同的艺术人工智能模型,这些模型几乎每周都会在世界范围内出现,而 ruDALLe 成为了这个社区的焦点。

我们可以从 ruDALL-e 接受训练的数据集上部分识别出一些初始图像。

SberAI 写了关于他们的训练数据集:

我们的第一步是捕捉 OpenAI 在其出版物中提供的数据(超过 2.5 亿对)以及 Cogview 使用的数据(3000 万对)。这包括:概念说明、YFCC100m、维基百科数据和 ImageNet。然后我们添加了 OpenImages、LAION-400m、WIT、Web2M 和 HowTo 数据集作为人类活动的数据源。我们还包括了我们感兴趣的领域的其他数据集。关键领域包括人、动物、名人、室内、地标和景观、各种类型的技术、人类活动和情感。(来源)

另一方面,似乎有从网络上刮下来的图像(与 OpenAI 安全数据集方法相反)。通过创建一系列图像,您已经可以看到它了:

ruDALL-e 完成,由作者创建

是的,没错。 iStock 水印。似乎数据集突出地包含了股票图像公司的预览图像。

还有无处不在的迷因,它们似乎给社交网络记忆(和图像数据集)打上了烙印,比如电视频道标识的旧电视屏幕烙印。

我们看到著名的迷因有马龙·白兰度(维托·柯里昂)和小罗伯特·唐尼迷因(翻白眼)。但是用的是准俄语文本。

由丹尼尔·鲁斯发现

看起来像俄罗斯网站的图像被用于训练数据集。Elle / MichaelFriese 和 DanielRussRuss 发现了另一个奇怪的一致之处:

MichaelFriese10 截图

第三个图像看起来像一本书的封面,甚至更多,它几乎有 1/1 是从训练数据集转移到完成的。

使用图像反向搜索(,这可能是非常鼓舞人心的),特别是——在这种情况下——使用 Yandex 图像搜索,你可以找到原始图像,图像的根源。

例如,这张图片:

ruDALL-e 完成,由作者创建

Yandex 图片搜索,作者截图

在这种情况下,视觉完成(“上传的图像”)似乎源于莫斯科地铁的照片(在这种情况下,【Mayakovskaya 站)。

我们必须时刻注意人工智能有意或无意的抄袭(就像我们对莎士比亚和亚历山大波普的抄袭一样)。

类似的现象我也经历过,GPT-2 对非英语文本的过度训练。在我的例子中,我使用了一个单独的文件:歌德的《浮士德》(原文)。

在培训开始时,我们可以观察新的文本(用非常怪异的德语,但已经有了结构,与原戏剧相对应)。经过 7000 步后,补全接近原始文本;他们甚至重复了数据集的内容。

有限数据集上的过度训练重新构建了这个数据集。

****

****

在左边:训练步骤 600。右边:训练步骤 7400。//作者截图

在 ruDALL-e 的情况下,我想知道,如果训练数据集应该是非常多样化的,那么完整性如何变得与原始图像如此接近?

抽象思维?

像上面这样简单的任务,ruDALLe 都可以重新想象。但是如果你尝试抽象的话题,一个令人兴奋的现象出现了。ruDALLe 没有“幻想”这样的问题,而是重新制作了书籍、CD 和网站模型的封面(全部模仿俄语)。

《怀旧》

ruDALL-e //作者截图

《前世记忆》:

ruDALL-e //作者截图

尽管如此,一些完成的作品还是令人印象深刻。

文化参考

如前所述,ruDALLe 接受的是基于俄罗斯的主流图像的训练。

如果你深入挖掘俄罗斯的内容/背景,你会发现对历史和文化有趣的重新诠释:

六层(“шестидесятники”)

斯大林死后(1954 年),在赫鲁晓夫解冻(20 世纪 50-60 年代),苏联出现了一个迷人的文化景观:六层。部分反映了美国和欧洲的抗议运动,部分是为了将自己从斯大林的创伤中解放出来,苏联知识分子——艺术家、作家、音乐家——开始发展另类的第二文化,与社会主义现实主义和(后)斯大林时代的爱国主义紧张对立。

不幸的是,一场独特的运动在苏联/俄罗斯之外鲜为人知,但它带来了文化多样性、新鲜感和开放思想,影响了世界六分之一人口的几代创作者。

这是一部由真正的诗人和艺术家参与的电影中的一小段片段,你可以感受一下这种氛围:

1964 年在莫斯科理工博物馆的诗歌朗诵会

在我用自动点唱机进行的音乐实验中,当 AI 重新构建六阶的声音时,我偶然发现了一个诡异的现象。

正如你所看到的,这种背景很难表达,特别是如果它将由人工智能重新创建。ruDALLe(由于其预先培训)创建了带有提示“шестидесятники”(六层)的各种图像:

ruDALL-e //作者截图

我可能会过度解读它,但我看到了一些纪实照片,带有类似表演场景的团体照片。第一个图像类似于著名的六层图像(也用于他们的先锋杂志“青年”(“юность")):

Dmitri Bykov 关于“第六层”的选集封面,使用了青年标志(Stasys Krasauskas)

也许我过度解释了我的观察,但是我越深入兔子洞,我就有越多的考古发现。

ruDALLe 有创意吗?

虽然人们仍然在讨论机器的创造力,但我自己有一个明确的答案(自 2015 年以来与人工智能共同创造):是的。

接下来,我想展示一些 ruDALLe 关于创造力的有趣发现(所有的提示都是用俄语输入的,我为这篇文章翻译了它们)。

提示:村里的蒙娜丽莎

ruDALL-e //作者截图

即使不是每一部作品都展示了乡村的乔康达,其衍生作品也很有趣。即使是达芬奇的“sfumato”(烟熏色渐变)在大多数图像中都起作用。此外,她把脸转向不同方向的方式也很棒。

提示:克里姆林宫的神奇宝贝

ruDALL-e //作者截图

如果说第一张图片说明了叙事“皮卡丘在莫斯科参观观光”,那么第二张图片则需要更多的内容知识:在这里你看到了对鲍里斯·叶利钦发型的完美刻画。在第三幅图中,你看到一个类似普京的人,对一些可爱的东西感到高兴,可能是——神奇宝贝在克里姆林宫游荡。

提示:橱窗里的女孩。

ruDALL-e //作者截图

这个提示会生成一系列扭曲的人类图像(ruDALLe 仍然无法像 StyleGAN3 一样生成逼真的人脸)。但有些作品蕴含着艺术力量,比如这幅:

ruDALL-e //作者截图

我猜想 ruDALLe 训练的数据集包含艺术摄影——或者 Instagram 图像。

提示:《自然》****

ruDALL-e //作者截图

自从 BigGAN 以来,我们已经知道人工智能能够逼真地再现自然。首先是,自然特征包含在数据集内的大多数** 图像中(即使只是作为背景主题)。其次,是我们的大脑在购买自然图像,即使看了第二眼后这些图像并不令人信服。当我们看到人脸图像时,我们会立即发现 AI 所做的所有扭曲,因为我们的大脑被训练来检测面部特征。历史上,如果树或云看起来很奇怪,对我们的大脑来说并不重要。**

提示:“街头搞笑怪兽。”

ruDALL-e //作者截图

我是说,很迷人,不是吗?

提示:“建构主义生日派对”

ruDALL-e //作者截图

提示:“空间里的恋人”

这些作品传达了苏联艺术家的科幻风格(其中还有宇航员阿列克谢·列昂诺夫),蓝色的太空,地球大气层的朦胧烟雾,未来的理想主义和乌托邦氛围。

ruDALL-e //作者截图

提示:“云中列宁”

毫无疑问,ruDALLe 数据集应该包含许多俄罗斯/苏联历史的镜头。探索这种特定的预训练模型来重新解释视觉叙事是很有趣的。

这个提示给了我几个非常有趣的补充,在这里你可以认出列宁(即使中间的图像描绘了不同苏联政治家的组合)。

ruDALL-e //作者截图

但是下面的结果让我起了鸡皮疙瘩。不仅仅是重新想象列宁。这是一个独特的视角,是苏联末期概念主义者(如科马尔&梅拉米德)和其他艺术家异议运动的特征。

ruDALL-e //作者截图

这幅从整个历史视角直到苏联解体的戏剧性肖像是独一无二的。

提示:“复活”

在这里,ruDALLe 把提示分配给了它占优势的内容领域:宗教,基督教背景。可视化是预先确定的,由于附属:希腊东正教的图标。

ruDALL-e //作者截图

但是在规范的视觉特征之外的重新解释也在这里重新提出:

ruDALL-e //作者截图

摘要

ruDALLe 不是 DALLe,它不包含符号转换、隐喻能力和 OpenAI 多模态方法的灵活性。

尽管如此,这是一个体面和自力更生的模型,它产生鼓舞人心的和独特的视觉效果,适合灵感迸发,头脑风暴和跳出框框思考。

ruDALL-e //作者截图

在现有的虚拟环境中运行新的 Jupyter 笔记本电脑

原文:https://towardsdatascience.com/run-a-new-jupyter-notebook-in-an-already-existing-virtual-environment-7490b3dd5ab6

解决无法从默认的 Jupyter 笔记本安装中访问虚拟环境模块的问题

照片由斯科特·韦伯在 Unsplash 拍摄

问题是

有几种不同的 Python 工作流,了解多种工作流可以让您在处理不同类型的问题时更加容易。对我来说,我喜欢使用 VS 代码和终端,但是当我需要一些快速的数据可视化时,没有什么比 Jupyter 笔记本更适合快速迭代了。

问题是,**你如何从现有的虚拟环境中运行你的 Jupyter 笔记本?**如果您运行命令jupyter notebook,即使是在虚拟环境中,它也会使用默认内核启动 Jupyter 笔记本服务器,例如: Python 3 (ipykernel)。如果您尝试导入您环境中安装的任何模块,您可能会得到模块未找到错误。

Extra: 在此阅读更多关于设置虚拟环境的信息:

https://medium.com/swlh/painless-easy-virtual-environment-setup-for-your-python-project-5aed144acebf

经过一番疯狂的谷歌搜索,我终于找到了这个快速可靠的解决方案:

设置 Jupyter 笔记本

- 导航并激活您的虚拟环境*(如果您在这一步需要帮助,请参阅上面的文章)。*

- 使用以下命令在您的虚拟环境中安装一个 Jupyter 内核:

ipython kernel install --user --name=venv

其中--user将安装限制在本地用户,而--name在步骤 1 中被设置为环境名。

3.接下来,用恰当命名的命令打开您的笔记本:

jupyter notebook

4.查看笔记本的右上角,看看哪个内核正在运行。它可能会以默认内核启动。点击菜单栏中的内核,导航至更改内核。然后,从下拉列表中选择您在上一步中提供的环境名称。

**重述:**从菜单中选择内核→更改内核→您的内核名称

将内核更改为您在上面的示例中设置的内核。在这里,选择“venv”将允许访问安装在该环境中的所有模块。

提示和技巧

- 如果您想查看已经设置的可用内核,请键入以下命令:

jupyter kernelspec list

2.要删除以前安装的内核,请使用:

jupyter kernelspec uninstall venv

其中" venv" 是您的环境的名称。

关闭

应该可以了!现在,当您在笔记本(即import pandas as pd)中运行导入语句时,您将可以访问您环境中的所有模块。现在,您已经了解在虚拟环境中运行 Jupyter 笔记本电脑需要什么了。

**注意:**在这个用例中,我没有安装 Anaconda。如果您安装了 Anaconda,有一个有用的 GUI 可以帮助您管理环境设置,有些人可能更喜欢这种方法。

写这篇文章是为了在你多次遇到这个问题时,作为一个快速的书签参考。

以批处理模式运行 SageMaker TensorFlow 对象检测模型

原文:https://towardsdatascience.com/run-a-sagemaker-tensorflow-object-detection-model-in-batch-mode-66989346390b

如何使用 Sagemaker 批量转换作业处理大型图像

对于一个计算机视觉项目,我需要在一大组图像上应用对象检测模型。这篇博文描述了如何在 Amazon SageMaker 中通过 TensorFlow 对象检测模型 API 使用批量转换作业来实现这一点。

首先,基于一个 AWS 示例笔记本,我将解释如何使用 SageMaker 端点在单个图像上运行模型。对于小图像,这种方法是可行的,但是对于大图像,我们会遇到问题。为了解决这些问题,我改用批量转换作业。最后,我最后说几句话。

用于检测徽标的对象检测。图片由作者提供。

起点:使用 SageMaker TensorFLow 对象检测 API 进行模型推断

AWS 在 GitHub 上提供了一些如何使用 SageMaker 进行物体检测的好例子。我用这个例子通过一个使用 TensorFlow 对象检测 API 的对象检测模型进行预测:https://github . com/AWS-samples/Amazon-sage maker-tensor flow-object-detection-API。

当模型被部署为端点时,您可以通过调用端点,一次一个图像地使用模型进行推理。这段代码摘自示例笔记本,展示了如何定义 TensorFlowModel 并将其部署为模型端点:

来源:https://github . com/AWS-samples/Amazon-sage maker-tensor flow-object-detection-API/blob/main/3 _ predict/deploy _ endpoint . ipynb。

然后,将图像作为 NumPy 数组加载,并作为列表进行解析,以便将其传递给端点:

来源:https://github . com/AWS-samples/Amazon-sage maker-tensor flow-object-detection-API/blob/main/3 _ predict/deploy _ endpoint . ipynb。

最后,调用端点:

来源:https://github . com/AWS-samples/Amazon-sage maker-tensor flow-object-detection-API/blob/main/3 _ predict/deploy _ endpoint . ipynb。

同样,完整的笔记本可以在这里找到。

问题:端点请求负载太大

这在使用小图像时非常好,因为 API 调用的请求负载足够小。但是,当使用较大的图片时,API 会返回 413 错误。这意味着有效负载超过了允许的大小,即 6 MB。

当然,我们可以在调用端点之前调整图像的大小,但是我想使用批处理转换作业。

解决方案:改用批处理转换作业

使用 SageMaker 批处理转换作业,您可以定义自己的最大有效负载大小,这样我们就不会遇到 413 错误。除此之外,这些作业可以用来一次性处理全套图像。

这些图像需要存储在 S3 桶上。所有图像都以批处理模式处理(顾名思义),预测也存储在 S3 上。为了使用批处理转换作业,我们再次定义了一个 TensorFlowModel,但是这次我们还定义了一个entry_point和一个source_dir:

来源:https://github . com/AWS-samples/Amazon-sage maker-tensor flow-object-detection-API/blob/main/3 _ predict/deploy _ endpoint . ipynb并由作者改编。

inference.py代码转换模型的输入和输出数据,如文档中所述。这段代码需要将请求负载(图像)更改为 NumPy 数组,解析为 list 对象。从这个例子开始,我修改了代码,让它加载图像并将其转换成 NumPy 数组。inference.py中input_handler功能的内容变更如下:

来源:https://sage maker . readthe docs . io/en/stable/frameworks/tensor flow/using _ TF . html # how-to-implementation-the-pre-and-or-post-processing-handler-s并由作者改编。

注意,我在上面的代码中排除了output_handler函数。确保在您的代码中也包含该函数(取自文档)。

该函数需要 Python 包 NumPy 和 Pillow,它们没有安装在运行批处理推理作业的映像上。我们可以创建自己的图像并使用那个图像(在初始化 TensorFlowModel 对象时使用image_uri关键字),或者我们可以提供一个requirements.txt并将它存储在与您的笔记本相同的文件夹中(称为source_dir='.’)。该文件在映像启动过程中使用,以便使用 pip 安装所需的软件包;内容是:

内容由作者提供。

首先,我想使用 OpenCV(就像端点示例中一样),但是这个包不太容易安装。

我们现在使用模型来创建一个 transformer 对象,而不是将模型部署为模型端点:

作者代码。

最后,使用输入路径调用转换器:

作者代码。

瞧!图像由模型处理,结果将作为 JSON 文件保存在output_path桶中。命名等同于输入文件名,后跟一个.out扩展名。顺便说一下,您还可以调整和优化实例类型、最大负载等。

布鲁斯·马尔斯在 Unsplash 上拍摄的照片。

最后的想法

这很可能不是最划算的方法,因为我们将图像作为 NumPy 数组传递给转换器。从的另一个示例笔记本中,我发现建议您的 SavedModel 应该接受二进制数据的 base-64 编码字符串,因为二进制数据的 JSON 表示可能很大。

此外,我们可以调整inference.py中的output_handler函数来压缩返回并存储在 S3 上的 JSON,或者只返回相关的检测。

使用 Crontab 和 HTTP 请求按照自定义计划运行 Airbyte 同步

原文:https://towardsdatascience.com/run-airbyte-syncs-on-a-custom-schedule-with-crontab-and-http-requests-8d6fbb3ea112

利用 Airbyte 的简单 REST API 进行复杂配置

照片由尹英松在 Unsplash 拍摄

Airbyte 是一个神奇的工具,最近在数据工程社区掀起了波澜。这是一个用于运行 ELT(提取、加载和转换)过程的开源工具。它是 Fivetran 等昂贵软件的绝佳替代品,每月可为您的公司节省数千美元。

从现在开始,我将假设您对 Airbyte 的结构以及如何在生产环境中使用它有一定的了解。

Airbyte 很棒,但是,就目前的情况来看,Airbyte 对连接同步的 cron 式调度没有一流的支持。这很快就会到来,但还没有完全准备好,我的公司运行的是旧版本的 Airbyte,还不需要升级。

当谈到目前的日程安排,有几个选项,如让您的同步运行每分钟,每小时,每天等。,但是如果你想要更具体的东西,或者如果你想自己编排你的同步,在 UI 中是不可能的,这是大多数用户在大多数情况下与 Airbyte 交互的方式。

但是不要害怕!Airbyte 不仅提供了一个很好的 UI 来管理您的 ELT 过程,而且还提供了一个 HTTP REST API,允许您使用 POST 请求来触发来自外部源的连接。

完整的 API 文档在这里是,但是如果你继续读下去,我将向你展示如何使用 Crontab 和 Python 来按照你自己的计划运行你的同步。当然,您可以使用任何您喜欢的工具和语言。

⚙️连接到 API

Airbyte 公开的所有端点都是 POST 端点,这使得它非常容易交互。因为 Airbyte 是容器化的,所以我将假设您正在使用 Airbyte 附带的所有默认端口,并且您将在同一台机器上运行您的 Python 脚本。

下面的代码非常简单,将使用 API 同时触发每个启用的连接,但是它应该让您对需要访问的端点有一定的了解。

如果您使用 Python,您需要确保安装了requests模块,然后开始编写一个函数来获取与您的安装相关联的 Airbyte 工作空间:

Airbyte 中的每个工作区都有多个源、多个目的地和多个连接,这些连接决定了数据从源到目的地的流动。为了触发同步,我们首先必须获得每个工作区的连接列表,然后单独触发每个连接。我们可以通过以下两个函数来实现:

然后,我们要做的就是把它打包成一个整洁的小包,这样整个程序看起来就像这样:

这就是 Python 的一面。剩下的就是安排这个脚本运行了!

🕒计划 Airbyte 同步

同样,您可以使用任何您喜欢的工具,但是我喜欢使用 Crontab,因为它简单快捷。将上面的脚本调整为使用 Python schedule包并一直在后台运行也是可行的。

如果您决定只使用 Crontab,请确保它安装在您的机器上。我喜欢使用 Crontab.guru 来确保我会得到我想要的时间表。我不会在这里给出完整的教程,但是如果您想在每小时的早上 6 点到下午 6 点之间运行 Airbyte 同步,您可以使用crontab -e命令将下面一行插入 Crontab:

00 6-18 * * * python3 force_airbyte_sync.py

保存您的 Crontab,并确保使用crontab -l将其正确插入。然后坐下来,放松,享受在你的英语教学过程中少花 50%的钱!

我希望这篇文章至少对你们有些人有用!如果你有任何问题,欢迎评论这篇文章或发邮件给我,地址是 isaac@isaacharrisholt.com。我喜欢谈论数据和所有工程方面的东西,所以为什么不开始一个对话呢!

也可以在 GitHub 上找我或者在 LinkedIn 上联系我!我喜欢写我的项目,所以你可能也想在 Medium 上关注我。

这一条就这么多了!我希望你喜欢它,任何反馈都非常感谢!

如何使用 Docker 在本地运行气流

原文:https://towardsdatascience.com/run-airflow-docker-1b83a57616fb

在本地机器上使用 Docker 运行 Airflow 的分步指南

约书亚·雷德科普在 Unsplash 上拍摄的照片

介绍

Apache Airflow 是数据工程领域最热门的技术之一,它允许用户大规模地构建、编排和监控数据管道。

很有可能你已经通过pip安装了 Airflow,试图在本地运行它,但是很有可能你会遇到问题,甚至更糟,搞乱你的本地环境。

如果您想在本地机器上测试气流,那么最简单的方法就是使用 Docker 图像。在今天的简短教程中,我们将逐步完成一个指南,帮助您在几分钟内通过 Docker 启动并运行 Airflow。

先决条件

首先,您需要确保您已经安装了

- Docker 社区版

- Docker Compose (注意,你需要版本≥ 1.29.1)

步骤 1:获取 docker-compose.yaml

我们首先需要的是 docker-compose.yaml 文件。在您的主目录上创建一个新目录(姑且称之为airflow-local):

$ mkdir airflow-local

$ cd airflow-local

并获取docker-compose.yaml文件(注意,我们将使用 Airflow v2.3.0)

$ curl -LfO 'https://airflow.apache.org/docs/apache-airflow/2.3.0/docker-compose.yaml'

您可以随意查看撰写文件以及其中定义的服务,即airflow-scheduler、airflow-webserver、airflow-worker、airflow-init、flower、postgres和redis。

步骤 2:创建目录

现在,当您在airflow-local目录中时,我们将需要创建另外三个目录:

dagslogsplugins

$ mkdir ./dags ./logs ./plugins

步骤 3:设置气流用户

现在,我们必须导出一个环境变量,以确保主机上的文件夹和容器中的文件夹共享相同的权限。我们将简单地将这些变量添加到一个名为.env的文件中。

$ echo -e "AIRFLOW_UID=**$(**id -u**)**\nAIRFLOW_GID=0" > .env

使用cat检查.env的内容,确保其包含上述两个变量。

$ cat .env

AIRFLOW_UID=501

AIRFLOW_GID=0

步骤 4:初始化气流数据库

现在我们已经准备好初始化气流数据库,首先启动airflow-init容器:

$ docker-compose up airflow-init

该服务将运行airflow db init,并为气流数据库创建管理员用户。默认情况下,创建的帐户有登录名airflow和密码airflow。

步骤 5:启动气流服务

让气流启动并运行的最后一件事是启动我们在步骤 1 中看到的气流服务。

$ docker-compose up

请注意,上述命令可能需要一段时间,因为需要启动多个服务。完成后,您可以在新的命令行选项卡中使用以下命令来验证这些映像已启动并正在运行:

$ docker ps

气流图像启动并运行——来源:作者

步骤 6:访问气流用户界面

要访问 Airflow 用户界面,只需前往您喜欢的浏览器并打开localhost:8080。

气流管理员登录——来源:作者

键入您的凭据(如前所述,默认情况下,这些凭据将被设置为airflow并点击“登录”)。现在,您应该可以访问气流控制面板,在这里您可以看到一些用气流修补的 Dag 示例。

气流界面上的 DAGs 示例—来源:作者

第七步:进入气流工作者容器

您甚至可以进入 worker 容器,以便使用下面的命令运行airflow命令。您可以通过运行docker ps找到气流工作者服务的<container-id>:

$ docker exec -it <container-id> bash

举个例子,

$ docker exec -it d2697f8e7aeb bash

$ default@d2697f8e7aeb:/opt/airflow$ airflow version

2.3.0

第八步:收拾残局

一旦你完成了你的实验,你可以通过简单的运行来清理我们刚刚创造的混乱

$ docker-compose down --volumes --rmi all

此命令将停止并删除所有正在运行的容器,删除包含数据库数据和已下载映像的卷。

如果您再次运行docker ps,您可以验证没有容器启动并运行

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

最后的想法

在今天的简短教程中,我们探索了一个分步指南,它可以帮助您通过 Docker 在本地计算机上安装和运行 Apache Airflow v2.3.0。

请注意,Airflow Docker 图像仅用于测试目的。如果你计划在生产环境中部署气流,我推荐你在 Kubernetes 上用官方的舵图运行它。

成为会员 阅读介质上的每一个故事。你的会员费直接支持我和你看的其他作家。你也可以在媒体上看到所有的故事。

https://gmyrianthous.medium.com/membership

相关文章你可能也喜欢

https://betterprogramming.pub/kafka-cli-commands-1a135a4ae1bd

使用 Python API 客户端运行 BigQuery SQL

原文:https://towardsdatascience.com/run-bigquery-sql-using-python-api-client-b5287ac05b99

从零开始一步一步来

图片来源于unsplash.com

今年我正在积极地与谷歌云(GCP)合作,我将分享如何在 WSL (Windows 子系统 Linux)中用 Python 和 Anaconda 设置 API 客户端,以从头开始执行 BigQuery SQL 查询。

如果你需要更多关于 WSL2 和 Anaconda (Miniconda)安装的信息,我可以在这个的前一篇文章中帮助你。

摘要

在这篇文章中,我们将了解如何:

- 使用 WSL 创建一个新的 Anaconda 环境。

- 使用 PIP 安装 Google API 客户端库

- 使用 Web 控制台创建一个 Google 服务帐户

- 使用 JSON 密钥文件生成 Google 应用程序凭证

- 设置 Google 应用程序凭据环境变量

- 将 USA Names 公共数据集添加到 BigQuery 并测试 SQL 查询

- 设置 Visual Studio 代码以在 WSL 上运行

- 调用 Python 脚本来执行 SQL 查询

- 奖励:故障排除

- 谢谢

- 结论

- 有用的资源

1.使用 WSL 创建一个新的 Anaconda 环境。

如果你没有 Windows 子系统 Linux (WSL)和 Anaconda (Miniconda ),我建议你看看我的上一篇文章。

为了不与现有库混淆,我们将设置一个本地项目,执行以下步骤:

- 打开一个 WSL2 端子

- 转到你的个人文件夹 a 创建一个新文件夹 gcp_projects

- 创建一个名为 gcp_prj 的 Anaconda 环境

- 检查新环境是否已创建

- 使用 activate 切换到新环境。

使用以下命令:

mkdir gcp_projects

cd gcp_projects/conda create --name gcp_prj

conda info --envs

conda activate gcp_prj

我正在创建一个新的 Anaconda 环境。图片由作者提供。

2.使用 PIP 安装 Google API 客户端库

我们将在新的 Anaconda 环境中安装 PIP,然后使用以下命令安装 Google API 客户端库:

sudo apt install python3-pip

pip install --upgrade google-cloud-bigquery

安装 PIP。图片由作者提供。

为 Python 安装 Google API 客户端库。图片由作者提供。

3.使用 Web 控制台创建一个 Google 服务帐户

下一步是通过转到https://console.cloud.google.com/IAM&管理>服务帐户或https://console.cloud.google.com/iam-admin/serviceaccounts创建一个新的项目和服务帐户

谷歌云控制台,服务账号。作者图片

创建一个名为 MyBigQueryTest 的新项目

谷歌云控制台,创建一个项目。作者图片

创建一个名为 sa_python_scripts 的新服务帐户,并选择角色来访问您的项目。

在谷歌云控制台中创建服务帐户。作者图片

出于测试目的,我将使用所有者角色,而不授予用户访问服务帐户**的权限。**请注意,不建议在生产环境中使用所有者角色

授予服务帐户,谷歌控制台的角色。作者图片

4.使用 JSON 密钥文件生成 Google 应用程序凭证

转到服务帐户,选择位于https://console.cloud.google.com/iam-admin/serviceaccounts的 MyBigQueryTest 项目,点击为服务帐户创建的电子邮件,查看详细信息。

服务帐户可通过电子邮件获得。图片由作者编辑。

创建一个新的密钥并将其下载为一个 JSON 文件

创建新的服务帐户密钥。作者图片

将文件另存为mybigquerytest . JSON;我使用的是直接的 WSL 路径**\ \ WSL $**\ Ubuntu \ home \ csaavedra \ workspace _ Linux \ GCP _ projects

使用\wsl$ hide Windows 共享网络保存到 WSL。图片由作者提供。

在 WSL 终端 Ubuntu 中检查文件。作者图片

5.设置 Google 应用程序凭据环境变量

为您的配置文件永久设置 GOOGLE_APPLICATION_CREDENTIALS 变量。bashrc 文件。

sudo nano ~/.bashrc

编辑您的个人资料。图片由作者提供。

在文件末尾添加导出GOOGLE _ APPLICATION _ CREDENTIALS:

export GOOGLE_APPLICATION_CREDENTIALS="/home/csaavedra/workspace_linux/gcp_projects/mybigquerytest.json"

将导出 GOOGLE_APPLICATION_CREDENTIALS 添加到您的个人资料中。图片由作者提供。

按下 Control + X ,选择 Y 为是,保存修改后的缓冲区(文件)

确认更改。作者图片

并按回车键确认文件名和更改。

确认文件名。作者图片

我正在重新加载概要文件,并使用变量 GOOGLE_APPLICATION_CREDENTIALS 的 echo 和 printenv 命令检查路径

source ~/.bashrc

echo $GOOGLE_APPLICATION_CREDENTIALS

printenv GOOGLE_APPLICATION_CREDENTIALS

重新加载配置文件并检查 Google 应用程序凭证路径。图片由作者提供。

6.将 USA Names 公共数据集添加到 BigQuery 并测试 SQL 查询

进入https://console.cloud.google.com/bigquery的 BigQuery 控制台,添加数据公共数据集,如下图:

向 BigQuery 添加公共数据集。作者图片

在市场中,搜索 USA names 并选择美国社会安全管理局数据集

谷歌公共数据集市场。图片由作者提供。

点击名为的蓝色按钮,通过数据集添加数据集:

添加美国名称数据集。作者图片

USA Names 数据集已添加,但您无法在 explorer 项目树中找到它。

添加了美国名称。图片由作者提供。

要添加它,你需要搜索美国名称,然后选择将搜索范围扩大到所有项目:

搜索美国名字。图片由作者提供。

然后你需要点击项目名称 bigquery-public-data 旁边的大头针图标,移动鼠标靠近三个点。

Pinging BigQuery 公共项目。图片由作者提供。

现在,您可以在项目树中看到美国的名称:

图片由作者提供。

下一步是使用编辑器窗口并执行以下 SQL 查询:

SELECT name, SUM(number) as total_people

FROM `bigquery-public-data.usa_names.usa_1910_2013`

WHERE state = 'TX'

GROUP BY name, state

ORDER BY total_people DESC

LIMIT 20

我们将使用结果来检查 Python 脚本是否正常工作:

美国姓名查询结果。图片由作者提供。

7.设置 Visual Studio 代码以在 WSL 上运行

从 https://code.visualstudio.com/[下载并安装 Visual Studio 代码后](https://code.visualstudio.com/)进入扩展并安装

- Python 扩展

- 远程 WSL 扩展

如下图所示:

Visual Studio 代码,扩展。图片由作者提供。

然后点击左下角带有

大于号和小于号的绿色图标

图片由作者提供。

并选择新建 WSL 窗口打开一个远程连接 WSL 的 Visual Studio 新实例。

图片由作者提供。

你可以在左下角看到不同的标签,就像文本 WSL: Ubuntu 一样

WSL: Ubuntu。图片由作者提供。

现在,您将通过转到文件并打开文件夹来打开 WSL 中的文件夹:

Visual Studio 代码,打开文件夹。图片由作者提供。

选择路径/home/csaavedra/workspace _ Linux/GCP _ projects/

打开远程文件夹。图片由作者提供。

我们可以在那里找到 JSON 密钥文件。现在,右键单击名为big query-usanames-test . py的文件,创建一个新文件

创建新的远程文件。图片由作者提供。

8.调用 Python 脚本来执行 SQL 查询

将以下代码复制到big query-usanames-test . py文件中

作者修改的代码。基于https://github . com/Google APIs/python-big query/blob/HEAD/samples/client _ query . py

按 Control + F5 运行big query-usanames-test . py文件

图片由作者提供。

执行的结果在 Web 编辑器中显示为查询结果

执行的结果。图片由作者提供。

奖励:故障排除

注入环境变量

注入环境变量。图片由作者提供。

如果您没有权限设置一个环境变量,您可以通过使用 os.environ 对象直接将值传递到您的代码中:

os.environ['GOOGLE_APPLICATION_CREDENTIALS'] = '/home/csaavedra/workspace_linux/gcp_projects/mybigquerytest_injection.json'

没有名为 Google 的模块

没有名为 google error 的模块。图片由作者提供。

如果您得到错误 No module named Google,请使用以下命令检查 google cloud library 的安装:

pip install --upgrade google-cloud-bigquery

无法自动确定凭据

如果出现错误:无法自动确定凭据。请设置 GOOGLE_APPLICATION_CREDENTIALS 或显式创建凭据并重新运行应用程序。更多信息请见https://cloud . Google . com/docs/authentic ation/getting-started

该问题与作为环境变量导出的GOOGLE _ APPLICATION _ CREDENTIALS有关。

你可以测试运行代码 os.environ 或者在终端打印 printenv 看看是否返回变量。

import os

print(os.environ)

如果没有,您可以导出或重新加载带有源文件的概要文件。bashrc 和 printenv。

export GOOGLE_APPLICATION_CREDENTIALS="/home/csaavedra/workspace_linux/gcp_projects/mybigquerytest.json"source ~/.bashrc

echo $GOOGLE_APPLICATION_CREDENTIALS

printenv GOOGLE_APPLICATION_CREDENTIALS

此外,您可以在 visual Studio 终端中退出,以使用环境变量强制重新加载会话

谢谢

最后,我要感谢克里斯·冯·塞法尔威,他给了我继续写作的灵感。

快乐发展!

结论

通过使用 API 客户端和一个服务帐户,用 Python 连接到谷歌云服务(GCP)是很容易的。在这第一步之后,您可以进行复杂的自动化操作,比如使用 Python Pandas 处理 Excel 文件,在 Google Big Query 中加载和合并,以及刷新 Tableau 仪表板。

有用的资源

https://github.com/googleapis/python-bigquery/ https://cloud.google.com/bigquery/docs/reference/libraries#client-libraries-install-python https://codelabs.developers.google.com/codelabs/cloud-bigquery-python#0 https://cloud.google.com/apis/design/errors

了解 BLOOM,最大的开放存取人工智能,并在您的本地计算机上运行它

原文:https://towardsdatascience.com/run-bloom-the-largest-open-access-ai-model-on-your-desktop-computer-f48e1e2a9a32

查看 BLOOM 解决数学、翻译和编码问题的实践。

BLOOM 是一个开放访问的多语言模型,包含 1760 亿个参数,在 384 个 A100–80GB GPU 上训练了 3.5 个月。一个 BLOOM 检查点需要 330 GB 的磁盘空间,因此在台式计算机上运行这个模型似乎不可行。然而,你只需要足够的磁盘空间,至少 16GB 的内存,和一些耐心(你甚至不需要一个 GPU),在你的计算机上运行这个模型。

BLOOM 是 1000 多名科学家和神奇拥抱脸团队的合作成果。值得注意的是,这种大型多语言模型对每个人都开放。本教程结束时,你将学会如何在你的本地计算机上运行这个庞大的语言模型,并看到它生成如下文本:

- INPUT: "The SQL command to extract all the users whose name starts with A is: "OUTPUT: "SELECT * FROM users WHERE name LIKE 'A%'"- INPUT: "The Spanish translation of thank you for your help is: "OUTPUT: "gracias por su ayuda"- INPUT: "John is 4 times as old as Bob. Bob is 3 years younger than Mike. Mike is 10 years old. What is John's age? Let's think step by step. "OUTPUT: "First, we need to find out how old Bob is. Bob is 3 years younger than Mike. So, Bob is 10–3=7 years old. Now, we need to find out how old John is. John is 4 times as old as Bob. So, John is 4 times 7=28 years old"

本教程使用拥抱脸的transformers库的一些组件,以及定制的 Python 代码,有策略地从磁盘加载模型权重,并生成一系列令牌。为了便于学习,本教程中的推理 Python 代码是从头开始编写的,没有使用 Hugging Face Accelerate 中的现成实现。对于生产,拥抱脸加速是更强大和多才多艺。本教程中的 Python 代码在配有 i5 11gen 处理器、16GB RAM 和 Samsung 980 PRO NVME 硬盘的计算机上每 3 分钟生成一个令牌(快速硬盘可以显著提高推理速度)。

布鲁姆建筑

BLOOM 是一种因果模型语言,这意味着它被训练为下一个令牌预测器。这种基于一组前面的标记来预测句子中的下一个标记的明显简单的策略,已经显示出对于大型语言模型的一定程度的推理能力(arXiv:2205.11916)。这使得 BLOOM 和类似的模型能够在一个句子中连接多个概念,并以相当的准确性解决算术、翻译和编程等重要问题。BLOOM 使用由输入嵌入层、70 个转换器块和输出语言建模层组成的转换器架构,如下图所示。每个变压器块有一个自我注意层和一个多层感知器层,输入和后注意层规范。

布鲁姆建筑

要使用 BLOOM 预测句子中的下一个标记,我们只需将输入标记(以嵌入的形式)传递给 70 个 BLOOM 块中的每一个。假设这是一个顺序操作,我们可以一次只加载一个块到 RAM 中,以避免内存溢出。类似地,单词嵌入和输出语言建模层可以按需从磁盘加载。

下载预先训练的 BLOOM 检查点

使用下面的代码从拥抱脸模型库中下载 BLOOM (176-B 版本):https://huggingface.co/bigscience/bloom。这将下载特定的 BLOOM 检查点2a3d62e。虽然 BLOOM 的模型大小在 330GB 左右,git lfs下载额外的链接文件,那么下载大小差不多是 700GB。确保您有足够的磁盘空间。

git lfs install

export GIT_LFS_SKIP_SMUDGE=1

git clone [https://huggingface.co/bigscience/bloom](https://huggingface.co/bigscience/bloom)

cd bloom

git lfs fetch origin 2a3d62e

git lfs checkout

下载的文件夹包含一个分片的 BLOOM 检查点,如下所示。分片意味着检查点被分成 72 个不同的文件,命名为pytorch_model_00001-of-00072.bin到pytorch_model_00001-of-00072.bin,以便于处理。

> ls -la

6.7 GB pytorch_model_00001-of-00072.bin

4.6 GB pytorch_model_00002-of-00072.bin

...

4.6 GB pytorch_model_00071-of-00072.bin57 KB pytorch_model_00072-of-00072.bin

0.5 KB config.json14 MB tokenizer.json13 KB pytorch_model.bin.index.json

文件00001包含单词嵌入和相关层规范,文件00002 到00071 包含 70 个 BLOOM 块,文件00072包含最终层规范。输出语言建模层使用与单词嵌入相同的权重。如果你好奇的话,pytorch_model.bin.index.json文件指定了 BLOOM 层是如何分布在碎片上的。

推理

现在我们用下载的 BLOOM 模型来做推断。首先我们需要安装拥抱脸transformers v4.20.0,如下图。这个特定的版本是必需的,因为本教程中的定制 Python 代码使用了仅在这个特定版本的transformers中可用的方法。

pip install transformers==4.20.0

第二,我们创建一个方法(get_state_dict),它接受一个碎片号(1 到 72)作为输入,从磁盘中读取碎片,并返回一个包含模型对象状态的字典。该方法允许从字典键中移除前缀,以便于使用torch.load_state_dict将权重加载到模型对象中。我们还通过从下载的文件夹中加载来创建令牌化器和配置对象。

第三,我们创建了三种方法来将状态字典加载到不同的模型对象中。我们在推理过程中使用这些方法,只将模型的特定部分加载到 RAM 中。这三种方法遵循相似的模式,包括:1)从磁盘读取碎片,2)创建模型对象,3)使用torch.load_state_dict填充模型对象的权重,以及 4)返回模型对象。唯一的例外是load_block 方法,它不创建新的块对象,而是覆盖作为参数传递的对象,以节省 RAM 内存。

第四,我们创建了一个方法来完全向前遍历 BLOOM 的所有层。该方法将令牌输入 id 的数组作为输入,并返回预测为句子中下一个的令牌 id。该方法从创建注意屏蔽和位置编码(alibi)开始。然后,它在嵌入层上向前传递以创建初始的hidden_states。接下来,它将hidden_states依次通过 70 个 BLOOM 块和输出语言模型头来生成输出 logits。argmax获取输出逻辑并返回预测概率最高的令牌 id。注意,在使用嵌入之后,我们删除它们以避免溢出内存。同样,每次我们调用 bloom 块时,我们从磁盘读取一个新的对象,但是覆盖现有的block 对象的权重以节省内存。

最后,我们定义一个输入句子,将其标记化,然后依次调用 forward 方法来预测句子中的下一个标记,一次一个标记。注意,在每一步,我们将新生成的令牌与之前的令牌(input_ids)连接起来,以进一步生成额外的令牌。

INPUT: The SQL command to extract all the users whose name starts with A is:OUTPUT:

Token 1 ....... SELECT

Token 2 ....... *

Token 3 ....... FROM

Token 4 ....... users

Token 5 ....... WHERE

Token 6 ....... name

Token 7 ....... LIKE

Token 8 ....... 'A

Token 9 ....... %'

Token 10 ....... The SQL command to extract all the users whose name starts with A is: SELECT * FROM users WHERE name LIKE 'A%'

这个例子说明 BLOOM 可以生成一个有意义的 SQL 语句。您可以运行其他示例(例如,本教程开头提到的示例)来看看 BLOOM 有多强大。只需记住使用max_tokens 变量增加要生成的令牌数量。

结论

由于其开放访问和多语言特性,BLOOM 被认为是十年来最重要的人工智能模型之一。这项突破性的技术将彻底改变自然语言处理的研究和实践。通过阅读本教程,即使您的计算资源有限,也可以利用 BLOOM 的强大功能来生成文本。此外,您可以使用伟大的拥抱脸transformers库来微调 BLOOM 以执行下游任务,如问题回答和文本分类。如果 BLOOM 的大版本对于您的应用程序或可用的计算资源来说太大,您可以利用拥抱人脸模型库中可用的较小版本的 BLOOM(https://huggingface.co/bigscience)。

在我网站的博客部分有一个 Jupyter 笔记本,里面有本教程的所有源代码:https://arte agac . github . io

用 Python 的 AtExit 在程序退出后运行代码

原文:https://towardsdatascience.com/run-code-after-your-program-exits-with-pythons-atexit-82a0069b486a

注册脚本结束或出错后运行的清理函数

(图片由 Andrew Teoh 在 Unsplash 上拍摄)

在本文中,我将向您展示如何使用 python 的内置模块 atexit 注册程序退出时执行的函数。这意味着您可以在代码退出后运行代码*(由于完成时的错误),为您提供各种必要的工具来执行清理功能,保存数据,并使调试更容易。我们来编码吧!*

1.用简单的例子理解 atexit

主要概念是注册一个在脚本退出时执行的函数。发生这种情况的原因有很多,我们将在后面讨论。让我们从最简单的例子开始,逐渐让它变得更有用。

最简单的例子——注册函数

下面的代码演示了注册出口函数的最基本方法。

在上面的代码中,我们简单地注册了say_goodbye函数,然后调用simple_example函数。当脚本在simple_example()完成后结束时,你会看到say_goodbye执行了。这也可以在输出中看到:

calling the function..

Function enter

Function exit

exiting now, goodbye

轻松点。让我们把它变得复杂一点。

简单的例子——退出循环

我们稍微调整了一下simple_example 函数:它现在包含了一个无限循环,显示“仍在运行”每一秒钟。我们再次注册了say_goodbye函数,只是现在是在simple_example函数的开始。

现在,当我们运行代码时,我们会看到“仍在运行..”每秒发送一条消息。当我们通过按 ctrl-c 退出时,我们看到以下输出:

still running..

still running..

still running..

still running..

still running..

exiting now, goodbye

所以在进入无限循环之前,我们注册了say_goodbye函数。该函数将在解释器终止时执行。

https://medium.com/geekculture/applying-python-multiprocessing-in-2-lines-of-code-3ced521bac8f

2.更简单的多次注册

在前一部分中,我们已经看到了放置atexit.register位代码的位置非常重要。如果我们在 while 循环之后注册函数,那么这个函数将永远不会被注册。

在这一部分中,我们将探索一种注册函数的新方法,这样您就不必担心这个问题。我们还发现你可以注册多个函数

我们可以退出所有我们想退出的,在一个 exit 中注册多个函数是可能的。还有,注册可以简单一点。

更简单的注册装饰

通过用 装饰器 注册函数,你不必担心何时注册函数,因为一旦解释器到达你的函数定义,它们就会发生。它们也非常容易使用:

另一个好处是你的代码更干净;simpel_example()函数没有被 atexit 注册“污染”。如果您想了解更多关于装饰器如何工作以及如何创建自己的装饰器,请查看本文。

注册多个功能

很容易注册多个函数以在退出时执行。重要的是要记住它们是按照注册的相反顺序执行的。查看下面的代码:

您可以通过下面的输出看到订单:

still running..

still running..

# 1 says au revoir

# 2 says later

# 3 says goodbye

注销函数

这就像注册一个函数一样简单:

上面的代码将产生以下输出(注意“# 2”没有显示):

Function enter

Function exit

# 1

您也可以使用atexit._clear()清除所有已注册的功能。

注册带有参数的函数

下面的代码允许您向注册的出口函数传递参数。这对于向您事先不知道的注册函数传递数据非常有用:

上面的代码产生以下输出:

what is your name? mike

Function enter

Function exit-mike says hoi after 0:00:01.755111-mike says hello after 0:00:01.755111-mike says bonjour after 0:00:01.755111-mike says gutentag after 0:00:01.755111

手动触发所有注册的出口功能

下面的代码演示了如何通过atexit._run_exitfuncs()功能手动触发所有已注册的退出功能:

输出如下所示:

start

exiting now, au revoir

exiting now, later

exiting now, goodbye

continue with code

atexit 什么时候运行注册的函数?

好问题。在正常解释器终止时执行退出功能。这意味着它们在你的脚本正常结束时运行,当sys.exit(0) quit()或引发类似raise ValueError("oops")的异常时运行。

异常终止是指程序被非 Python 处理的信号杀死或检测到 Python 致命内部错误的情况。最后一种情况是调用os._exit(0)时;这将在不调用清理处理程序、刷新 stdio 缓冲区等的情况下退出。举个例子:

将产生:

start

exiting now, goodbye

用os._exit(0)替换sys.exit(0)的方向盘不会运行say_goodbye功能。

结论

在本文中,我们探索了 Python 的 atexit 函数的内部工作方式,以及如何和何时使用它。

我希望这篇文章像我希望的那样清楚,但如果不是这样,请让我知道我能做些什么来进一步澄清。同时,看看我的其他关于各种编程相关主题的文章,比如:

- Git 绝对初学者:借助视频游戏理解 Git

- 创建并发布自己的 Python 包

- 使用 Docker 和 Compose 环境变量和文件的完整指南

编码快乐!

—迈克

又及:喜欢我正在做的事吗? 跟我来!

https://mikehuls.medium.com/membership

将 Jupyter 笔记本作为后台服务运行

原文:https://towardsdatascience.com/run-jupyter-notebook-as-a-background-service-on-ubuntu-c5d6298ed1e

再也不会丢失远程笔记本服务器,甚至可以让笔记本服务器在系统重新启动时启动

克里斯托弗·高尔在 Unsplash 上拍摄的照片

如何在后台运行 Jupyter 笔记本,而不需要为它们打开一个终端?在本文中,我将向您展示两种方法,一种是使用nohup的简单的一行程序,另一种是使用守护程序服务的更高级的方法。

在本地运行时,避免为您的笔记本电脑打开终端是非常有用的,但在可能暂时断开连接的远程笔记本服务器上更是如此。如果我们可以将笔记本服务器作为一个长期的后台任务作为系统服务来运行,会怎么样?因此我们可以随时连接到它,它甚至可以在任何故障或机器重启时重新启动。

本教程假设你在基于 unix 的系统上,我在 ubuntu 上,并且已经测试了 18.04 和 20.04 版本。第二种方式需要 root 权限,第一种方式不需要。

简单的一行程序

不要使用任何选项来运行jupyter-notebook ...,比如指定所使用的端口,而是在您希望笔记本根目录所在的目录中使用以下内容:

nohup jupyter-notebook --no-browser --port=8888 &

注意命令末尾的&字符,这使得它在后台运行。默认情况下,任何输出都将被写入一个名为nohup.out的文件中,您可以在那里查看笔记本日志。

像任何其他进程一样,这个进程也有一个 PID,以后可以用它来停止。(通常jupyter-notebook stop <port>不会用这种方法。)PID 是在执行上述命令时打印出来的,虽然只是在屏幕上显示,但没有必要记下来,因为以后可以找到它:

您可以检查打开了输出文件的进程的 PID:

$ lsof nohup.outCOMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME

jupyter-n 44361 username 1w REG 0,51 884 19846171 nohup.out

或者使用ps查找计算机所有运行进程之间的进程:

$ ps au | grep jupyter

最后,使用

$ kill -9 <PID>

扼杀这一进程。

这相对简单,允许您随时检查该目录中的日志,即使终端会话结束,也能保持笔记本运行。尽管服务器在机器重新启动时也不会重新启动,但是不需要 root 权限。

Avi Richards 在 Unsplash 上拍摄的照片

系统上的守护进程

如果您有 root 权限,您可以使笔记本服务器作为系统服务运行,甚至在重新启动时启动。这是针对基于 linux 的系统,使用内置的服务管理器。

第 1 步:找到您的jupyter-notebook可执行文件的路径

您需要在激活正确的 python 环境后才能这样做。

$ which jupyter-notebook/home/username/.local/share/virtualenvs/notebook/bin/jupyter-notebook

(可选)步骤 1.1:设置笔记本密码和任何其他配置

如果您依赖于安全的密码集,而不是复制服务器在启动时生成的令牌,您会发现以后使用该服务会更容易。

$ jupyter-notebook password[... password prompt, type it in twice] [NotebookPasswordApp] Wrote hashed password to /home/username/.jupyter/jupyter_notebook_config.json

您需要输入两次密码,然后密码以种子格式存储在本地 jupyter config 目录中。

步骤 2:编写服务设置文件

系统服务的设置和属性在类似 INI 的文件中指定。这些存储在/etc/systemd/system/目录中。

我们来写一个服务文件吧!这是一个相对简单的例子,我们已经为 jupyter 指定了可执行文件和参数,包括启动笔记本目录的目录,该目录与执行服务的目录相同。将用户和组设置更改为您自己的用户,确保它不是 root 用户。

注意Restart部分,它定义了如果出现故障,服务应该重启,守护进程等待 60 秒。

步骤 3:启用并启动服务

我们希望将该服务设置文件放入正确的系统目录中,然后“启用”并“启动”该服务。Enable 表示该服务在计算机重启时启动,否则需要手动启动。

# add the service file

$ sudo cp jupyter-notebook.service /etc/systemd/system/# let the daemon reload all the service files

$ sudo systemctl daemon-reload# (optional) "enable" -> started when the computer boots

$ sudo systemctl enable jupyter-notebook.service# start the service

$ sudo systemctl start jupyter-notebook.service

完成后,您可以查看服务状态。请注意,显示状态不需要 root 权限。

$ systemctl status jupyter-notebook

如果你想停止服务,你可以使用sudo systemctl stop ...来禁用启动启动使用sudo systemctl disable ...

第四步:享受!

现在,您有了一个笔记本守护程序服务,它也可以在重新启动时运行,并且您可以随时访问它。如果服务退出,系统会自动重启,这样你就可以安心工作了。

例如,如果您在一台远程机器上运行您的笔记本,比如您的家庭/工作计算机或云中,您只需要通过 SSH 连接到它,并让笔记本启动和运行。

结论

我们已经看到了在后台运行 Jupyter 笔记本服务器的两种方法,一种简单的方法适用于非 root 用户,另一种更高级的方法适用于 root 用户。第一个需要一点监控来启动和停止,而后者应该让你在服务器上一劳永逸。

我在不同的计算机上使用这两种方法,这取决于我拥有的用户权限。例如,第一个在科学计算集群上是最好的,而后者对于 AWS EC2 实例来说是惊人的,该实例用于笔记本和数据分析,可以在任何地方进行。

由乔治·克罗克在 Unsplash 上拍摄

参考和有用的链接

man systemd.service和man systemd.unit提供了系统服务文件选项的综合文档,本是其摘要- 这个教程很久以前我第一次使用它来建立一个系统服务,后来在多台机器上进行了修改

使用动态设置在任何地方运行 Python 应用程序

原文:https://towardsdatascience.com/run-your-python-app-anywhere-with-dynamic-settings-aafd27e04b8e

图片来自 Pavlofox 来自 Pixabay

使用配置文件参数化您的应用程序,并使用 ConfigParser 读取

当我们使用 Python 编写应用程序时,我们可能希望它能够在不同的环境中运行。或者,我们希望它在运行时有不同的行为。也就是说,参数化这个应用程序,而不是硬编码一切,因为我们不想改变代码来适应情况。

这可以通过多种方式实现。一种常见的方法是给程序添加参数。这是我以前的一篇文章,详细介绍了这种方法。

然而,使用参数的局限性也是显而易见的。

- 当我们运行程序时,添加大量的参数是不实际的。

- 运行时不能更改初始化参数。我们必须重新运行程序来改变参数。

- 保留值或参数对用户不友好。所以,不容易和别人分享。

当我们至少满足上面的一个约束时,值得考虑使用配置文件。所以,所有的参数都可以物理化成一个文本文件。

在本文中,我将介绍 Python 内置模块之一,名为configparser。它将使我们能够开箱即用地读取和写入配置文件。

1.写入配置文件

图片来自 Pixabay

从读取配置文件开始会更有意义。但是,如果你熟悉我的写作风格,你就会知道,我总是尽量写出可以按顺序进行的文章。因此,我们可以从这个实验开始,首先将配置写入文件。

由于configparser是 Python 3 内置的,所以我们只需要导入它并开始使用它。不需要下载和安装任何东西。

import configparserconfig = configparser.ConfigParser()

这里,我们使用模块中的ConfigParser类初始化一个名为config的对象。因此,我们得到了一个配置对象。

1.1 建立一个配置对象

当我们使用一个config物体时,和使用字典没有太大的区别。当我们想给对象添加一些配置项时,可以像这样添加。

config['PERSON'] = {'name': 'Christopher Tao','age': '34'

}

“顶层”键PERSON将被视为配置文件的一部分。对于PERSON部分,我们定义了一个包含两个条目的字典。然后,我们可以尝试将这个配置对象写入一个文本文件,如下所示。

with open('settings.cfg', 'w') as configfile:config.write(configfile)

这是我们刚刚写好的文件。

就是这样!当然,我们不必一次性提供整个词典。按如下方式逐步构建配置部分是完全没问题的。

config['RUN_PARAMETERS'] = {}

config['RUN_PARAMETERS']['start_time'] = '2020-05-01 00:00:00'

config['RUN_PARAMETERS']['end_time'] = '2020-05-31 00:00:00'

config['RUN_PARAMETERS']['frequency_min'] = '10'

config['RUN_PARAMETERS']['is_active'] = 'True'with open('settings.cfg', 'w') as configfile:config.write(configfile)

然后,该文件将被追加新的部分。

1.2 配置值必须是字符串

然而,与实际的字典相比,一些约束是有目的地添加到配置对象中的。例如,值得一提的是,所有的配置值都必须是字符串。如果我们试图给一个非字符串值如下,它会抱怨。

# Must be string

config['RUN_PARAMETERS']['is_active'] = True

这是有意义的,因为所有的配置值稍后将被写入一个文本文件。强制使用字符串值会降低出错的可能性,保持一致性。

2.从配置文件中读取

图片来自 Pixabay 的 MustangJoe

现在我们可以进入今天的主题了。从配置文件中读取。请注意,文本文件的扩展名并不重要,甚至作为内容的键值对的格式也不重要,这将在本节中详细介绍。

2.1 读取配置对象的参数

在我们想从配置文件中读取之前,我们还需要一个config对象。

config = configparser.ConfigParser()config.read('settings.cfg')

函数将返回一个列表中的配置文件名。这是因为configparser可以将多个配置文件读入一个对象。一旦我们已经阅读了项目,我们也可以使用sections()功能检查所有部分。

config.sections()

如果您没有跳过前面的部分,您可以很容易地获得我们已经写入配置文件的参数。

print(config['PERSON']['name'])

print(config['PERSON']['age'])

print(config['RUN_PARAMETERS']['start_time'])

print(config['RUN_PARAMETERS']['is_active'])

2.2 读取数据类型的参数

配置文件中有一些非字符串参数是很常见的,比如 integer、float 或 boolean。没有什么可以阻止您将它们读入字符串,然后将它们转换成应该的数据类型。类似下面的内容。

int(config['PERSON']['age'])

然而,configparser允许我们将值读入特定的数据类型,而不需要额外的转换步骤。例如,getint()方法将读取整数形式的值,而getboolean()方法将它们读入 bool 类型。

print(config['PERSON'].getint('age'))

type(config['PERSON'].getint('age'))print(config['RUN_PARAMETERS'].getboolean('is_active'))

type(config['RUN_PARAMETERS'].getboolean('is_active'))

2.3 回退值

有时,配置文件本身也可能是动态的。期望的功能之一是,我们可能希望用户只需要添加必要的参数,而不是一切。但是,对于那些不存在的参数,它会引发一个KeyError。

# Fallback Values

config['PERSON']['middle_name']

解决方案与普通词典非常相似。我们可以使用get()函数来获取键的值,并在没有值时提供一个后备值。

config['PERSON'].get('name', '')

config['PERSON'].get('middle_name', '')

在上面的例子中,当我们试图获取name时,它存在,因此我们可以取回值,而键middle_name不存在,因此空字符串将被用作回退值。

2.4 多级价值获取

我们还可以使用get()方法直接从 config 对象中获取键值,这意味着我们也可以将节名放入方法中。

# Multilevel

config.get('PERSON', 'name')

当我们使用上面的get()方法时,我们也可以显式地定义 fallback 值,如下所示。

config.get('PERSON', 'middle_name', fallback='I do not have middle name')

值得一提的是,多级特性也可以与“获取数据类型”方法一起使用。

print(config.getint('PERSON', 'age'))

type(config.getint('PERSON', 'age'))

2.5 检查密钥是否存在

最后,就像 Python 字典一样,我们也可以检查一个键是否存在于一个节中,如下所示。

# Check key

'name' in config['PERSON']

'middle_name' in config['PERSON']

3.默认部分

图片来自 Pixabay 的迈克尔·施瓦森伯格

configparser中有一个神奇的版块,就是DEFAULT版块。当配置文件有默认节时,可以从任何节访问该值。

让我们通过将DEFAULT部分写入配置文件来构建一个示例。

config['DEFAULT'] = {'version': '1.0','author': 'Christopher Tao'

}with open('settings.cfg', 'w') as configfile:config.write(configfile)

然后,如果我们试图列出 config 对象中的所有部分,我们会发现默认部分不会在那里。

但是,可以证明它肯定是存在的。

for key in config['DEFAULT']:print(key, '=', config['DEFAULT'][key])

这是configparser默认部分的特性,正如我之前所说的,默认部分中的项目可以从任何其他部分访问。如果我们尝试在其他两个部分列出所有的键值对,我们会发现它们都存在。

for key in config['PERSON']:print(key, '=', config['PERSON'][key])for key in config['RUN_PARAMETERS']:print(key, '=', config['RUN_PARAMETERS'][key])

4.支持的键值对格式

图片来自 Pixabay 的迈克尔·施瓦森伯格

对键值属性使用等号=在配置文件中很常见。然而,在不同的标准中确实使用了其他格式。configparser模块的美妙之处在于我们可以发现它支持几乎所有的流行风格。

让我们如下定义另一个配置文件。然后,命名为examples.cfg。

[Equal With Padding]

name = Christopher Tao[Equal]

name=Christopher Tao[Colon]

name: Christopher Tao[Multiline]

name = Christopher

Tao[No Values]

key_without_value

empty key =[Comments]

# This is comment

; This is comment, too# Empty line is OK [Indented Section]name=Christopher Tao

在这个示例配置文件中,混合了多种不同的样式。如果我们尝试读取文件,所有的场景都可以处理得很好。

config = configparser.ConfigParser()

config.read('examples.cfg')

config.sections()

等号和冒号都可以。

# name=Christopher Tao

config['Equal']['name']# name: Christopher Tao

config['Colon']['name']

当值中存在换行符时,可以正确捕获。

# name = Christopher

# Tao

config['Multiline']['name']

有评论的时候会忽略。因此,对于[Comments]部分,不存在键值对。

# [Comments]

# # This is comment

# ; This is comment, too

# # Empty line is OK

len(config['Comments'])

如果一个节是缩进的,或者在节头或键的前面有意外的空格,就不会有任何问题。

# [Indented Section]

# name=Christopher Tao

config['Indented Section']['name']

摘要

图片来自 Pixabay 的诺尔·包萨

在本文中,我介绍了一个名为configparser的 Python 内置库。它允许我们动态地从文本文件中读取和写入参数。它还提供了许多现成的特性,例如将值读入某些数据类型和回退值。它还支持多种键值对格式,可以很好地处理注释、空键和无用的缩进。

https://medium.com/@qiuyujx/membership

如果你觉得我的文章有帮助,请考虑加入 Medium 会员来支持我和成千上万的其他作者!(点击上面的链接)

除非另有说明,所有图片均出自作者之手

借助 Spark-on-Kubernetes 大规模运行您的 R (SparklyR)工作负载

原文:https://towardsdatascience.com/run-your-r-sparklyr-workloads-at-scale-with-spark-on-kubernetes-3db4f26d3348

教程:如何建立正确的 Docker 映像,开始您的 Spark 会话,并大规模运行!

r 是一种用于统计计算的编程语言。它被统计学家和数据科学家广泛使用。长期以来,在单台机器上运行应用程序已经足够了,但是当需要更多数据和高级分析时,这就成了一个限制因素。

这就是为什么 R 社区开发了 sparklyr 来使用 Apache Spark 扩展数据工程、数据科学和机器学习。它支持 Apache Spark 用例:Batch、Streaming、ML 和 Graph、SQL,此外还有众所周知的 R 包:dplyr、DBI、broom。更多信息可以在 sparklyr.ai 上找到。

Spark lyr 如何建立在 Spark 之上(来源: sparklyr.ai ,根据 Apache License 2.0 授权商业使用转贴)

问题是,Sparklyr 和 Apache Spark 之间的集成很脆弱,很难得到库和环境设置的正确组合。我们的一个客户试图让它在 EMR 上工作,并将其描述为“一场噩梦”。相反,通过构建他们自己的 Docker 映像并在我们的 Spark-on-Kubernetes 平台上运行,他能够使他的 SparklyR 设置可靠地工作。

因此,让我们看看如何使用 Spark-on-Kubernetes 让您的 SparklyR 应用程序大规模运行!本教程的所有代码都可以在这个 Github 库上获得。

要求

您必须配置 Docker 映像。这是最困难的部分,但我们为你做到了!下面的 dockerhub 文件使用了我们发布的一张图片作为基础——参见这篇博客文章和我们的 dockerhub 资源库,了解关于这些图片的更多细节。

作者代码。全公开回购。

您可以在 RUN install2.r 部分调优您的包。 Tidyverse 包含了很多众所周知的包,比如 dplyr,ggplot2。一旦您的映像被构建并在注册表中可用,它就包含了您所有的依赖项,在您运行应用程序时需要几秒钟的时间来加载。

开发您的 SparklyR 应用程序

首先,我们将向您展示一些代码示例。您可以在 sparklyr github repo 中找到更多示例。有两个关键话题:

- 创建 Spark 会话

- 理解 R 对象是 Spark 数据帧或 R 数据集的接口。

有经验的 Sparklyr 开发者可以查看 Spark 会话的创建,然后直接切换到大规模运行 Spark 应用。

创建 Spark 会话

作者代码。全公开回购。

如何操作你的 R 对象和火花数据帧

没有比阅读代码示例更好的学习方法了(见下文)!以下是需要注意的主要事项:

- sparklyr copy_to 函数返回对生成的 Spark 数据帧的引用,作为 tbl_spark 。返回的对象将作为底层 Spark 表的 dplyr 兼容接口(见文档)。

- 您可以使用 spark_apply 将 R 函数应用于 Spark 数据帧

- 您可以通过调用 tbl_cache (或 tbl_uncache )显式缓存(或取消缓存)Spark 数据帧

- 可以用 dbGetQuery 用 SQL 查询 Spark 表

- 你可以用 spark_read_parquet (或 spark_write_parquet )读取(或写入)镶木地板表格

- 您可以使用 ggplot2 包绘制您的 R 对象。

- 不要忘记在应用程序代码结束时用 spark_disconnect 关闭 Spark 会话。您仍然可以在这一行之后运行 R 代码,但是不能使用 Spark 运行任何分布式命令。

作者代码。完全公开回购。

Run 你的星火大规模应用

您必须首先通过模板或 configOverride 定义一个数据机制配置。对于开源的 Spark-on-Kubernetes 用户来说,很容易适应这种配置,特别是如果你使用开源项目 Spark-on-Kubernetes 操作器。

示例数据机制配置(JSON)。来源:作者。

要执行的The 代码在文件 rexamples 中。这就是为什么 mainApplicationFile 指向 Docker 映像内部的本地路径。

然后,您可以使用 Delight 来监控和优化您的 Spark 应用程序,这是一个适用于 Spark 的开源监控 UI,可以在任何 Spark 平台(商业/开源、云/本地等)上运行。

来自 Delight UI 的截图。来源:作者。

特别感谢在 Data Mechanics 平台上运行 SparklyR 工作负载的客户分享他们的技巧和设置。我们希望本教程能帮助你成功使用 Spark 和 R!

最初发表于【https://www.datamechanics.co】。

在不到 10 分钟的时间内运行 Spark 作业,无需基础架构

原文:https://towardsdatascience.com/running-a-spark-job-in-less-than-10-minutes-with-no-infrastructure-fe79f1c41780

大数据|云计算|数据工程

关于使用 Google 云平台设置 Spark 的快速实践教程

泰勒·维克在 Unsplash 上的照片

Apache Spark 是一个分布式数据处理系统,使我们能够处理高速数据管道。Apache Spark 还为 SQL、机器学习和数据科学以及图形计算提供了库。

Spark 一次可以处理数 Pb 的数据,比 Hadoop 的 MapReduce 快得多(快 100 倍)。

Spark 最常用于 Hadoop 集群之上,设置本地 Hadoop 集群需要相当多的来回操作。这是一个冗长而耗时的过程。

当我在为我的硕士学位进行实验时,我发现自己需要更多的计算能力来执行我的任务。我记得我试图使用我们实验室周围的几台旧 PC 来建立我自己的 Hadoop 集群,但这个过程非常费力,尤其是对于没有基础设施系统背景的人来说。

因此,本教程的目的是帮助那些希望在分布式集群上快速、廉价地执行 spark 任务的人。我想记录下当时对我有很大帮助的过程!

在本文中,我们将讨论如何利用云计算在不到 10 分钟的时间内启动并运行我们的第一个 Spark 作业!我们将使用 GCP 的云数据系统来提高时间和效率。

那么,部署 Spark 集群的过程是什么样的呢?

- 第一步: 前往 GCP,搜索 Dataproc

- 第 2 步: 调配一个 Apache Hadoop 集群

GCP Dataproc 集群部分。图片作者。

- 第三步: 命名并选择集群属性——对于试点项目,您也可以保留默认属性

- 步骤 4: 在作业部分,点击提交作业

- 第五步: 填写工作详情。将作业类型设置为 Spark,并链接到您的 Spark 类(以及您的。jar 文件)

作为一个例子,您可以尝试这个近似圆周率值的火花工作。

- 步骤 6: 确保 Spark 作业现在在作业部分下可见

GCP 数据公司工作部门。作者图片

- 第七步: 等待作业执行。请注意,您还可以单击集群来监控其资源使用情况,并查看当前正在执行的作业

- 步骤 8: 一旦作业执行完毕,您还可以关闭集群以节省资源——除非您需要持久数据。

仅此而已。设置集群和 Spark pi 任务,只花了我不到 4 分钟的时间。Spark 作业在 37 秒内执行(使用具有默认属性的集群)。

你喜欢这篇文章吗?如果是,请考虑订阅我的电子邮件列表,以便在我发布新内容时得到通知。

https://david-farrugia.medium.com/subscribe

此外,考虑成为会员,使用我下面的推荐链接来支持我和你在 Medium 上喜欢的其他作家。每月 5 美元,你就可以无限制地阅读 Medium 上的每一篇文章。

https://david-farrugia.medium.com/membership

想给我买杯咖啡吗?

https://paypal.me/itsdavidfarrugia?country.x=MT&locale.x=en_US

想联系吗?

我很想听听你对这个话题的想法,或者其他什么。如果你想联系我,请发邮件到 davidfarrugia53@gmail.com给我。

Linkedin——Twitter

使用 Gitlab CI/CD 运行 dbt

原文:https://towardsdatascience.com/running-dbt-using-gitlab-ci-cd-8a2ef0f05af0

免费部署、运行和安排 dbt 的最简单方式

由 Samuel Sianipar 在 Unsplash 拍摄的照片

我第一次实现 dbt 是在 Sirena 管理数据团队的时候,我立刻成为了它的超级粉丝。我们用它来运行我们所有的转换,并在我们的数据仓库中创建我们的模型(雪花)。能够将维度建模应用于我们的数据,尤其是有大量非结构化数据来源的数据,确实是一个游戏规则的改变者。更好的是,我们所有的模型和业务逻辑都受版本控制,变化完全可见,协作极其容易。不过,我最喜欢的部分可能是它在原始数据和业务实体之间创建的抽象层。例如,我们可以创建一个dim_customers模型,并从生成模型的原始数据中完全提取出我们公司客户的唯一真实来源。对于我们的利益相关者来说,他们在 BI 工具中使用的表格是来自我们的 CRM、产品数据库、ERP 还是客户成功软件并不重要。重要的是,在这张表中,他们可以找到我们客户的所有信息,这对他们来说是完全透明的。如果我们的数据源上游发生了变化,我们作为一个数据团队可以通过这个抽象层修复这些变化。更令人惊讶的是,希望没有人必须处理这一点,它允许我们在数据源中进行巨大的更改(例如 CRM 迁移或同时运行多个 CRM),同时最小化对我们的 BI 层的影响(是的,我有一些战斗伤疤)。哦,还有,所有这一切都得益于 SQL 的简单性。太神奇了。

正如我提到的,我们对 dbt 项目进行版本控制,为此我们使用了 Gitlab。当我看到 Gitlab 数据团队的视频解释他们如何使用 Gitlab CI 运行 dbt 时,这变得非常有趣。同时,Gitlab 作为一家开源公司,让他们的 dbt 项目的所有代码完全可用。我建议你在那里花一点时间,很多有用的东西。

在这篇文章中,我将详细介绍如何使用 Gitlab 的 CI/CD 来“部署”您的 dbt 项目。注意,使用 Github 动作可以实现类似的工作流程。

入门指南

Gitlab 的 CI/CD 工具非常容易使用,你需要做的就是在你的库的根目录下创建一个名为.gitlab-ci.yml的文件。这个文件基本上是 Gitlab 应该如何执行管道的配方。在本帖中,我们将回顾我们可以实现的最简单的工作流,重点是在生产中运行 dbt 模型。我将在后面的文章中讨论如何进行实际的 CI/CD(包括测试)、生成文档和存储元数据。现在,我们的目标是能够每天运行dbt build,这样我们所有的模型都是最新的。

这是一个使用 Gitlab 的 CI/CD 运行 dbt 的最简单设置之一的.gitlab-ci.yml文件示例:

我们首先定义希望在管道中运行的阶段。在这种情况下,我们将只有一个阶段称为deploy-production。如果我们现在忽略.gitlab-ci.yml文件的中间部分,直接跳到底部,我们可以看到我们定义了这个阶段实际做什么:

因为我们将when参数( docs )定义为只有manual,这个阶段只有在通过 Gitlab 的 UI 触发后才会运行。除此之外,stage 还定义了一个名为TARGET_NAME的变量,其值为postgres(稍后会详细介绍)。当谈到这个阶段实际上做什么时,它只是扩展了.deploy中的定义。同时,.deploy由dbt_jobs的定义延伸而来,也就是.dbt_run。这由下面一行指定:<<: *dbt_jobs,它实际上插入了dbt_jobs定义。

查看.dbt_run,我们看到我们定义了运行所有内容的映像,在本例中是python:3.8.1-slim-buster Docker 映像( docs )。之后,我们运行一些脚本来安装依赖项,并定义一个名为CI_PROFILE_TARGET的变量。为此,我们使用之前定义的TARGET_NAME变量。在这种情况下,CI_PROFILE_TARGET变量看起来会像--profiles-dir . --target postgres。你大概可以看到这是怎么回事。我们可以在运行 dbt 命令时使用这个变量来指定到我们的profiles.yml的路径和我们想要使用的目标。

就profiles.yml而言,我们可以使用与相似的设置,使用 docker 运行 dbt,从 env 变量获取数据仓库凭证。

使用 Gitlab 的 CI/CD 变量设置这些变量非常容易:

在 Gitlab 中添加 CI/CD 变量(图片由作者提供)

之后,我们终于可以看一看.deploy了。由于添加了 0.21.0 中引入的dbt build 命令,我们可以简单地安装依赖项,然后运行dbt build命令,该命令将根据我们的 dbt DAG 按照运行模型、测试、快照和种子的顺序来处理它们。

就这样,如果我们将代码推送到 Gitlab,我们应该会看到一个新的管道被创建,我们可以手动触发它(记住,因为有了when: manual配置)。一旦我们这样做了,我们的 dbt 项目就会运行。

在 Gitlab 中检查 CI/CD 管道(图片由作者提供)

安排 dbt 每天运行

使用这个设置,至少有两种方法可以安排 dbt 每天运行。第一种方法是使用 Gitlab 内置的流水线调度,第二种方法是使用 Gitlab 的 API 触发流水线。

流水线调度

这可能是最简单、最直接的方法。在 Gitlab 的 CI/CD 部分下,有一个用于创建管道计划的部分。

您可以按照说明每天运行管道,或者以任何频率运行您的 dbt 模型。

通过 API 触发管道

安排管道的另一种方式是使用您当前正在使用的任何编排工具,例如气流或 Dagster 。这还有一个额外的好处,就是可以与数据管道的其余部分集成在一起。使用它,您可以在数据加载到仓库后触发 dbt 构建。

您可以在这里找到用于触发管道的 API 文档,但是基本上您需要做的就是创建一个触发令牌,并在对 URL: https://gitlab.example.com/api/v4/projects/<project_id>/trigger/pipeline的POST请求中使用它。这种方法的一个惊人的特性是,您可以将变量传递给管道。这意味着,当数据管道的不同部分已经加载时,您可以触发 dbt 的构建。

以下是如何使用 Python 触发管道的示例:

请记住,要做到这一点,您需要移除when: manual条件。

进一步的改进

希望这篇文章向您展示了如何将 Gitlab CI/CD(或 Github Actions)与 dbt 结合使用。然而,我希望这能成为灵感,因为有很多方法可以利用这一点。例如,在 Sirena 和 Zenvia 中,我们使用此工作流来利用雪花零拷贝克隆进行实际的 CI/CD。每当一个合并请求(或拉请求)被创建时,它将触发一个管道来克隆我们的雪花数据库,并在其上运行代码更改和测试。这给了我们很大的信心,我们的改变不会引入任何问题。我们使用这个工作流实现的另一件事是存储元数据并生成 dbt 文档来记录我们的数据仓库。如果这一切听起来很有趣,请考虑在媒体上关注我,因为我将在未来创造更多关于这方面的内容。

跑得比以往任何时候都快

原文:https://towardsdatascience.com/running-faster-than-ever-before-afd1d213a3ae

Python 3.11 与 Python 3.10 和 Julia 1.7 相比表现如何?

肯尼·埃利亚松在 Unsplash 上的照片

性能并不总是数据科学家优先考虑的事情。然而,随着我们手上的数据量不断增加,更快地完成计算不是很好吗?即将到来的 Python 3.11 版本被寄予厚望,因为与当前稳定的版本 3.10 相比,预计性能会提高 10-60%。我真的对这一声明很感兴趣,我想尝试一下我的应用程序的新版本,这些应用程序主要集中在蛋白质组学和质谱学上。

在这篇文章中,我关注了截至 2022 年 6 月的当前 Python 3.10 和 3.11 测试版的性能。与 MS 相关的函数包括从磁盘读取文本文件,对字符串和字典的操作,以及对 numpy 数组的循环和操作。这些操作非常通用,因此这些函数的性能应该反映一般的性能趋势。

既然我们在这里谈论速度,我在想,我们为什么不也比较一下 Python 3.11 和 Julia 的性能。它是一种正在积极发展的编程语言,是专门为科学计算设计的,考虑到了可伸缩性和性能。Julia 的语法与 Python 并没有太大的不同,这使得它对于希望进一步扩展其计算工具箱的数据科学家来说是一种非常有吸引力的语言。

如果您希望直接查看基准测试的结果,请随意跳到文章末尾的总结部分。

设置

这些测试已经在 Kubuntu 22.04 中用 Python 3.10.4、Python 3.11 beta3 和 Julia 1.7.3 运行过。最初,我在 Jupyter 笔记本上运行 Python 3.10 和 Julia 测试,然而,我在安装 3.11 测试版的所有必要依赖项时遇到了一些困难。因此,我通过运行脚本完成了对两个 Python 版本的测试。

代码、笔记本和示例数据可以在 GitHub 库中找到。

读取和解析文本文件

第一个函数从光盘中读取一个文本文件,将 MS 数据解析到一个字典中,该字典包括文本字符串、数值和 pandas dataframes。函数 load_mgf 的完整代码相当长,你可以在的脚本中找到。该函数转换一个纯文本文件,如下所示:

一个对象列表(字典),每个代表一个质谱,包含文本、数字数据和一个pandasdata frame*‘ms _ data’*,如下所示:

Github 存储库中的示例文件包含 1000 个项目(光谱):

1000

在库 timeit 的帮助下,我们在 Python 的两个版本中重复运行这个函数:

Running version:

3.10.4 (main, Apr 2 2022, 09:04:19) [GCC 11.2.0]

Timing the load_mgf function:

Mean time 251.7 ms, standard deviation 7.5 ms for 200 repeatsRunning version:

3.11.0b3 (main, Jun 1 2022, 23:49:29) [GCC 11.2.0]

Timing the load_mgf function:

Mean time 217.8 ms, standard deviation 8.6 ms for 200 repeats

我们观察到 Python 3.11 的处理时间减少了 10%以上!这非常令人兴奋,因为我们不需要以任何方式更改代码就可以获得这种性能提升!

让我们在 Julia 中实现相同的功能,尽可能地模仿 Python 函数的逻辑。使用 @benchmark ,看看有多快:

Julia 的性能证明在这个基准测试中得到证实,平均运行时间不到 Python 的一半!看起来很有希望!

循环和字典操作

下一个函数从列表中读取文本字符串,使用字典匹配字符,并计算相应值的总和。对于质谱分析人员来说,这个函数从列表中计算肽的质量。

让我们准备一个 10,000 个肽(字符串)的列表,每个肽由 20 个氨基酸残基(字符)组成,指定为单独的大写字母:

10000

'FFKGSQDTGYTYFNFMSHFY'

我们现在可以使用普通循环来计算列表中每个序列的质量。每个可能的残基对应一个数字质量值,我们可以使用字典来指定:

另一种更简洁的方法是使用 functools 包中的 reduce 函数:

让我们用两个版本的 Python 对函数进行基准测试:

Running version:

3.10.4 (main, Apr 2 2022, 09:04:19) [GCC 11.2.0]

Timing the calculate_masses_loop function:

Mean time 11.83 ms, standard deviation 0.97 ms for 200 repeats

Timing the calculate_masses_reduce function:

Mean time 24.15 ms, standard deviation 1.95 ms for 200 repeatsRunning version:

3.11.0b3 (main, Jun 1 2022, 23:49:29) [GCC 11.2.0]

Timing the calculate_masses_loop function:

Mean time 7.90 ms, standard deviation 0.88 ms for 200 repeats

Timing the calculate_masses_reduce function:

Mean time 19.65 ms, standard deviation 1.72 ms for 200 repeats

Python 3.11 在基于循环的函数上快了 49%!不幸的是,聪明的calculate _ mass _ reduce实现通常要慢得多,但是 Python 3.11 在这个函数上仍然比 3.10 版本快 18%。

这些计算应该在 Julia 中变得更快吗?让我们创建一个类似的循环函数,它将计算每个序列的质量,并在一个 10,000 长的序列列表上对其进行基准测试:

令人惊讶的是,这个实现比 Python 中的函数慢多了!我们可以通过预先分配 masses 数组来优化代码,而不是在每次迭代中添加一个新的单元素数组。让我们看看这是否有所不同:

这两种实现在 Julia 中略有不同,但 Python 3.11 是这一轮的明显赢家!

数值数组上的运算

谈到 Python 中的数字运算,我们当然希望避免多级 for 循环和重复的 if-else 语句。因此,在实现一个用于处理大量实验质谱数据的函数时,我们将使用 numpy 数组对逻辑进行矢量化。完整的功能 find_matches 可以在脚本中找到[。该算法的核心部分采用数值,作为 pandas 系列 *s'ms_data']['m/z']* 引入,并对相应的 numpy 数组执行一系列操作:

让我们使用我们之前通过 load_mgf 加载到内存中的 1000 MS 光谱对函数 find_matches 进行基准测试。重复运行该函数,我们得到:

Running version:

3.10.4 (main, Apr 2 2022, 09:04:19) [GCC 11.2.0]

Timing the find_matches function:

Mean time 2.08 s, standard deviation 89.2 ms for 50 repeatsRunning version:

3.11.0b3 (main, Jun 1 2022, 23:49:29) [GCC 11.2.0]

Timing the find_matches function:

Mean time 2.07 s, standard deviation 26.0 ms for 50 repeats

两个版本的平均时间惊人地相似。也许,在 3.11 的测试版中,numpy 代码没有太大的变化。这将是很有趣的,看看它是否会被修改。

在 Julia 中实现一个类似的函数,我们可以在数组s[' ms _ data '][' m/z ']【T21]上重复上面 Python 代码中相同的操作。在 Julia 代码中,矢量化运算以点为前缀:

上面的基准测试结果显示,Julia 中的函数比 numpy 中快一倍,但这并不是终点。Julia 允许将数组操作融合到一个循环中,避免分配临时的中间数组。融合操作以“at-dot”宏为前缀:

做了这一点小小的改变后,让我们对结果函数 matchesfuse 进行基准测试:

融合进一步削减了 60%的运行时间!由此,Julia 完全主导了数组操作基准测试,优化后的函数运行速度比 Python/numpyanalog 快 5 倍!这个令人印象深刻的表演真的激励我,至少对我来说,投入更多的时间去研究朱莉娅。

摘要

我们在基本操作(循环、字符串操作、算术运算)和数值数组的计算中测试了 Python 3.11 beta,所有这些都是在质谱数据的上下文中进行的。我们将 3.11 与当前的 Python 版本 3.10.4 以及最新的 Julia 1.7.3 进行了比较。测试结果汇总如下图所示:

质谱相关基准功能的运行时间总结。作者图片

与 Python 3.10 相比,新的 3.11 在循环、字符串和字典操作等一般操作上提供了显著的性能提升,完成基准测试的速度提高了 10–49%。与此同时,使用 numpy 的计算在两个 Python 版本中花费的时间完全相同,而 Julia 在同一组数值计算的速度上提供了 2 到 5 倍的显著提升。然而,在 Python 中,使用循环和字典匹配的函数工作得更快,尤其是在新版本 3.11 中。

在 Docker 容器上运行 Jupyter 笔记本

原文:https://towardsdatascience.com/running-jupyter-notebooks-on-docker-containers-47862f6b96a0

与 SageMaker Studio Lab 和 Docker 合作的项目

伊恩·泰勒在 Unsplash 上拍照

这篇文章的目标是在 AWS 上运行数据科学工作流,然后使用 Docker 发布它,从而创建一个端到端的机器学习任务。

此外,我将更多地关注“如何”对数据科学项目进行分类,而不是“为什么这个项目很酷”。也就是说,使用 Docker 有很多的好处:

- 轻便

- 表演

- 灵活

- 隔离

- 可量测性

另一方面,AWS SageMaker Studio Lab 提供了 SageMaker 的强大功能,无需显式定义每个子流程。

挑选数据集

对于这个项目,我们将使用来自斯坦福网络分析项目( SNAP )的 2,441,053 个产品的 6,643,669 个用户的 34,686,770 条亚马逊评论。这些数据是在 BSD 许可下发布的,学术和商业用途都是免费的。

使用的数据是在 Kaggle 上找到的数据的子集。它包含 1,800,000 个训练样本,200,000 个测试样本,因此每个评论要么是“正面的”,要么是“负面的”。

https://www.kaggle.com/datasets/kritanjalijain/amazon-reviews

由于这是一个大型数据集,并且我们正在使用 AWS,因此数据存储在 S3 存储桶中。此外,确保您正在使用的 bucket 和 AWS 服务在同一个区域中。对于这个项目,选择的地区是美国东部-2 (美国东俄亥俄州)。

IAM:了解你的角色

使用 AWS,一个常见的缺陷是没有所需的权限,或者不知道您的权限范围。转到身份和访问管理 (IAM),创建一个角色,并为其附加以下策略:

- 亚马逊 3FullAcess

- AmazonSageMakerFullAccess

- awsglueconsolesagemakernotebook full access

- AWSImageBuilderFullAccess

- AmazonSageMakerPipelinesIntegrations

- amazonseagemakergroundtrutheexecution

为什么选择 SageMaker Studio Lab?

SageMaker Studio Lab 提供了一个轻量级环境,可以比在 SageMaker 上更快地执行任务。它也有一些缺点,例如无法访问 AWS Data Wrangler,也没有大规模的分布式培训。

要开始使用 SageMaker Studio Lab,您只需要一个 AWS 帐户,然后等待大约 24 小时,让您的帐户获得批准。一旦进入实验室,环境看起来就像一个 Jupyter 笔记本。

你可以在这里申请一个免费账户:【https://studiolab.sagemaker.aws/

开始会话

下面的代码简介是连接到您的 AWS 资源的标准方式,并定义了基本资源。可以把它看作是开始使用 AWS 的一种方式。

预处理步骤

在 SageMaker Studio 中,第一步是编写一个预处理脚本,如下所示。这个脚本和所有后续脚本需要包含所有必需的库,并且能够独立运行。

此外,在 ML 工作流中采用的思维模式是“t his 将在其他人的机器上运行”。因此,在 Jupyter 笔记本环境中编写的内容能够包含在一个简洁的 python 脚本中是至关重要的。

对于 SageMaker 的入门者,记得坚持规定的目录格式:“ /opt/ml/… ”。事实上,“/opt/ml”及其所有子目录都由 SageMaker 根据文档保留。例如,“ /opt/ml/model/ ”是您编写算法生成的模型的目录。

培训脚本

在预处理之后是训练,就像前一部分一样包含在脚本中。特定的模型没有建立正确的工作流重要。一旦模型按预期运行,请随意插入您选择的算法。

模型评估

数据完全平衡:50%正,50%负。因此,精确度是一个足够的度量。精确度和召回率也包括在内,以发现预测中的任何问题。

在任何参数优化之前,准确率徘徊在 80%,精度/召回率也是如此。

使用 FrameworkProcessor 处理作业

SageMaker 处理模块允许我们使用一个框架处理器来添加依赖项,该处理器允许一组 Python 脚本作为处理作业的一部分运行。此外,它允许处理器访问一个目录中的多个脚本,而不是只指定一个脚本。

运送到码头

现在我们的工作流程运行顺利,是时候发货了!首先在实验室中创建一个名为 docker 的目录,并编写 docker 文件来创建处理容器:

下一步是使用 docker 命令构建容器,这会创建一个弹性注册容器(ECR)并推送 docker 映像:

附言如果你使用的是苹果 M1 电脑或更新的电脑,确保在构建 docker 镜像时明确地调用你的平台。

运行 Docker 容器

首先我们调用 ScriptProcessor 类,它允许您在容器中运行命令,现在我们可以运行以前的相同脚本,只是它们在 docker 容器中。

就这样,我们成功地在 docker 容器上运行了一个处理作业。为了简洁起见,没有显示训练和评估容器,因为它们遵循相似的步骤。

结论

借助 AWS 服务和 Docker,我们能够将 python 代码推入容器,并将数据科学工作流产品化。

如果您有兴趣查看完整的代码和输出来验证您自己的工作,请查看下面的 Github repo:

https://github.com/NadimKawwa/amazon-review-docker/blob/main/README.md

在云中运行无服务器应用程序—教程

原文:https://towardsdatascience.com/running-serverless-applications-in-the-cloud-a-tutorial-2b5b38457d8d

为什么没有服务器?又是怎么做到的?AWS ECS 的实际应用

作者照片

在这篇文章中,我们将在 AWS 上设计和部署一个 FastAPI 应用程序。

我们将使用无服务器计算服务和托管数据库服务来设计应用程序。这种微服务架构有助于构建一个解耦系统,从而提高健壮性。接下来,我们使用 AWS CDK 将我们的整个基础设施捆绑成代码。这样做的好处很多。简而言之,它使部署和基础设施更新更加容易。它允许在 VCS(版本控制系统)如 git 中提交定义基础设施的整个代码。

但是什么是无服务器,我们为什么需要它?

无服务器简介

AWS 提供了几个无服务器计算选项。有了无服务器计算,我们无需担心服务器的管理和配置。安装补丁、更新和安全修复等维护任务完全消失了。这释放了时间和资源。我们也不需要担心容量供应,因为如果负载增加,AWS 会自动扩展实例。无服务器计算选项提供随用随付的定价模式。这意味着我们只为我们实际使用的计算时间付费。根据用例,这可以降低运行我们软件的相关成本。

EC2 上的 Docker 和对 ECS 的需求

在介绍这个架构之前,我们先看看如何使用简单的虚拟服务器(AWS EC2)在 AWS 中运行一个容器化的应用程序。

涉及的步骤有:

- 构建 Docker 映像

- 部署 EC2 实例

- 管理 Docker 应用程序和 EC2 实例

- 为 EC2 实例付款

这似乎很简单。但是也有一些不利的方面。

首先,我们需要管理我们的 EC2 实例。所以随着时间的推移安装更新和补丁。其次,我们需要管理 Docker 应用程序。万一容器停止工作,或者 FastAPI 版本需要更新,我们需要手动更新容器。这可能会很麻烦,因为正在运行的容器需要停止。

另一点是规模。生产系统是由数百个容器组成的大规模系统。使用上述方法同时运行几个容器是不可行的。我们需要分别管理每个容器。例如,确保容器平稳运行(健康检查),并且它们可以安全地相互通信。或者在不危及整个应用程序的情况下更新容器使用的图像。如果用户需求增加,我们如何处理增加容器数量的用例?类似地,对于如此多的容器,负载平衡变得至关重要,因为我们不想让选定的几个容器不堪重负,而让其他容器闲置。

AWS ECS 可以帮助我们解决所有这些问题,甚至更多。

AWS ECS

为了简单起见,我们只考虑 Fargate 上的 AWS ECS,不考虑 EC2。

弹性集装箱服务。这是一个容器编排服务,允许我们运行和管理容器化的 Docker 应用程序。对于可能有数百个容器的大型工作流,管理它们既具有挑战性又非常耗时。这里有一张解释 ECS 的图表。

用 Fargate、服务和任务说明 AWS ECS。图片作者。

ECS 由以下组件组成:

- 集群——这只是一个被称为容量提供者的 Fargate 实例的逻辑分组。任务在运行前被放入集群。

- AWS Fargate — Fargate 与 ECS 集成,并“在幕后”提供无服务器计算服务。Fargate 本质上运行我们的 Docker 容器,而我们不必担心管理服务器。

- 服务—服务允许您指定希望运行多少任务,是否希望启用负载平衡等。一个集群中可以有多个服务。例如,您可以让一个服务处理所有生产流量(生产环境),另一个服务处理测试/开发流量(测试环境)。上图中,您可以看到集群中运行着两个服务— 服务 1 和服务 2 。任务在服务内部运行。

- 任务定义——这是一个用 JSON 编写的模板文件。它就像一个蓝图,指定运行什么容器、内存和 CPU 规格、应该打开什么端口以及其他配置,如使用什么 Docker 映像。本质上,它定义了要运行的实际代码。

- 任务—这是任务定义的实例。它可以是挂起、运行或停止。正在运行的任务意味着任务定义中指定的所有容器都正在运行,即您的应用程序正在运行。

还可以运行几个任务来处理应用程序的大负载。在上图中,有两个任务 A 的实例在服务 1 中运行。

架构图

架构图如下所示:

AWS 架构图。图片作者。

首先,我们使用虚拟私有云(VPC)。这是我们专用的 ip 地址集合,与我们的 AWS 帐户相关联。一个因特网网关被连接到 VPC,以便于与因特网的连接。

FastAPI 应用程序将在公共子网内的 ECS 上运行。PostgreSQL 数据库将在私有子网内的 RDS(关系数据库服务)上运行。RDS 只是 AWS 提供的一项托管数据库服务,意味着 AWS 为我们管理数据库。

用户请求被路由到 ECS,因为它位于公共子网内。在本教程中,这是通过简单的 HTTP,端口 80 完成的。对于所有实际使用案例,这应该在 HTTPS 端口 443 上完成。RDS 禁止任何公共访问。这是因为它存储了敏感的用户数据。但是,由于 ECS 和 RDS 在同一个 VPC 中,所以 ECS 可以与 RDS 通信来存储和检索数据。这是通过默认的 PostgreSQL 端口 TCP: 5432 完成的。

密码

完整的回购代码是 这里的 。

这篇文章假设你的系统已经安装了 AWS CLI 和 CDK。

如果没有请查看此 帖子 获取教程。

好了,现在我们终于可以进入正题,写一些实际的代码了👩🏾💻

第一站,CDK!

CDK 初始化

创建一个名为ecs

的新项目目录,运行以下命令为 CDK 创建一些样板代码:

cdk init sample-app --language python

如果在 Python 中创建 venv 时出现错误,可以执行以下命令为 Python 创建一个新的虚拟环境:

py -m venv .venv

然后使用以下命令激活它:

.\.venv\Scripts\activate

创建和激活 Python 虚拟环境

启用虚拟环境后,我们可以通过以下方式安装 Python 依赖项:

pip3 install -r requirements.txt

编辑app.py并确保提供了地区和帐户。它应该是这样的:

接下来,打开ecs_stack.py。这是我们定义要创建的架构和资源的地方。

粘贴以下代码:

我们从定义一个vpc开始。您可以将此视为与您的帐户相关联并可供使用的 ip 地址的集合。

接下来,我们定义两个安全组,一个用于数据库,另一个用于 fargate。安全组的作用类似于有状态的防火墙,默认情况下,它们允许所有传出的网络流量并阻止所有传入的流量。我们明确允许通过 TCP 从 fargate 连接到我们的数据库服务器。

接下来,我们创造秘密。这些可以是任何东西,包括 API 密钥、数据库凭证或其他需要存储和访问的敏感数据。通过 AWS secrets manager,可以轻松地存储、检索和循环使用,以获得最大的安全性。在这里,我们为数据库实例创建凭证。我们提供用户名为postgres,让 cdk 自动为我们生成一个密码。这里的好处是我们不会暴露代码中的秘密,因为我们可以简单地传递templatedSecret变量来引用敏感的密码。

我们创建一个新的数据库实例,将templatedSecret作为凭证传入,并将之前创建的安全组传入。

最后,我们创建一个新的 fargate 服务。默认情况下会创建一个应用程序负载平衡器,但其详细信息不在讨论范围之内。这里最重要的事情是我们提供了一个到 docker 映像的路径。我们将用户名和密码作为task_image_options secrets传递,并将数据库实例的端点作为environment变量传递。这允许 docker 容器能够连接到数据库。注意我们没有以明文形式传递任何东西!甚至数据库实例端点也是在运行时自动生成的,所以我们事先并不知道,但我们只是用rdsInstance.db_instance_endpoint_address将它传递给 fargate。

最后,我们添加了对rdsInstance的依赖。这确保了数据库在 fargate 服务之前创建。否则,我们的 FastAPI 应用程序将无法连接。

太好了!大部分工作已经完成。

接下来,我们需要为 ECS 创建一个 FastAPI 应用程序和一个 docker 文件。

REST API 与 FastAPI

确保虚拟环境已激活,并逐一安装以下软件包:

pip3 install psycopg2

pip3 install fastapi

pip3 install uvicorn[standard]

pip3 install sqlalchemy

接下来,在根目录下创建一个main.py文件。

为main.py粘贴以下代码:

这是一个简单的 REST API,有两个端点。我们可以存储一个book或者基于book_name检索一个book。在第 30 行,我们为插入和检索数据库记录所需的book创建了一个数据库模型。

注意如何简单地引用username、password和endpoint作为环境变量。这是可行的,因为我们在前面的 CDK 代码中明确地将它们作为秘密和环境变量传递。

我们还需要为 FastAPI 创建一个 Pydantic 数据模型。这具有在向端点发出请求时提供输入数据的自动验证的优点。例如,当 POST 请求存储一本新书时,pydantic 会自动验证是否提供了正确的book字段。继续在名为schemas.py的新文件中创建一个 Pydantic 模型。

应该是这样的:

现在开始有趣的部分!

Dockerfile 文件

而在根目录下运行pip freeze > requirements.txt得到一个requirements.txt。这是建立我们码头工人形象的需要:

pip 冻结要求

在根目录下创建一个新的Dockerfile,如下所示:

我们简单地提取 Python:3.9 的官方 Docker 映像,设置一个命名的工作目录,我们将在后面引用它。然后我们在requirements.txt上运行一个 pip 安装,最后将所有代码从我们的主机复制到 Docker 容器中。容器运行时执行最后的CMD命令。

在这种情况下,它启动了我们的 FastAPI 应用程序。

您现在应该有一个如下所示的目录结构:

项目目录结构

好了😇为自己出色的工作给自己一点鼓励!

现在最激动人心的时刻到来了!

部署🚀

注意: 运行下面的命令将向您的 AWS 帐户支付费用。

喝杯咖啡,然后跑步:

cdk deploy

这将启动资源的创建并部署应用程序。

请耐心等待。这一步可能需要几分钟。

如果几分钟后控制台上看不到任何输出,点击 CTRL+C ,然后点击 cdk destroy。在这种情况下,您可以直接联系我/在下面评论,以获得故障排除帮助。

瞧吧🎆

我们需要获得ECS任务的 ip 地址来与服务器交互。

因为我们启动的 fargate 任务包含一个负载平衡器,所以我们使用负载平衡器的名称DNS。这是 AWS 自动生成的。继续在 AWS 控制台上搜索EC2。在左侧导航窗格中,找到并选择load balancers。打开的页面应该会列出一个负载平衡器。从描述中复制DNS name。

从负载平衡器获取 DNS 名称

粘贴复制的 URL 并在浏览器上点击 enter。您应该看到:

到达端点以测试应用程序

您还可以使用 Postman 或类似的命令,通过 POST 和 GET 调用 API 端点。

记得销毁堆栈,防止跑费。

从终端执行以下命令,销毁所有创建的资源:

cdk destroy

请耐心等待,这可能需要几分钟。

您也可以通过在 AWS 控制台中搜索 ***Cloudformation*** 来手动删除堆栈。

销毁堆栈后,您可能需要检查任何 RDS 快照。在控制台中搜索 RDS,并在左侧导航窗格中找到Snapshots。如果您看到列出了任何快照,请将其全部删除。

结论

在本文中,我们研究了如何在 AWS ECS 和 RDS 上部署 FastAPI 应用程序。

我们剖析并描述了 ECS(一种无服务器计算服务)的时间和资源优势。我们还使用了 RDS——一种托管数据库服务,AWS 负责为我们管理服务器。同样,像 ECS 一样,我们获得了不需要管理服务器的好处。

为了实现自动化部署,我们使用了 AWS IaC(基础设施即代码)产品 CDK。通过 CDK,我们可以将我们的架构定义为代码,轻松地将其提交给版本控制,并在未来进行更改等等。这也使得将来更改和更新基础设施变得更加容易。

希望你喜欢这篇相当长的帖子。

如果你喜欢这部作品,可以考虑关注并订阅 这里 。

原载于 2022 年 8 月 26 日https://haseebkamal.com。

运行时自省:Julia 最强大、保守得最好的秘密

原文:https://towardsdatascience.com/runtime-introspection-julias-most-powerful-best-kept-secret-bf845e282367

在 Julia 中使用内省处理类型

(图片由 Pixabay 上的 Skitterphoto 拍摄)

介绍

当谈到最终执行您的代码时,我们经常使用的许多高级编程语言都没有提供很多工具来允许人们在执行时查看语言。当然,我们可以打印值,我们可以有一些输出来告诉我们代码是否工作,但是在执行时使用已定义的类型和名称要困难得多。我的意思是这是有意义的,这不是一个人通常想在执行过程中做的事情,到处剖析类型和定义的字段——在大多数情况下,这根本不值得。

然而,虽然在大多数情况下,自省对你来说可能是不必要的,但对你的语言的编译器来说,为了更好地理解正在发生的事情以及你的环境,自省是必要的。也就是说,在某些情况下,人们可能与编译器一起工作,或者像编译器一样控制作用域。此外,在 Julia 中进行元编程时,自省可以产生非常有效的效果。尽管在 Julia 文档中可以获得这方面的信息,但它是在 Julia 的开发者文档中,而不是常规文档中。也就是说,我的假设是,大多数使用 Julia 的人不会开发这种语言本身,但肯定会在他们使用这种语言的某个时候利用自省,因为我认为这是这种语言在许多不同的应用程序中可以做的一件有价值的事情。也就是说,如果你更愿意阅读文档而不是我对这些特性的解释,这里有一个 Julia 文档的链接:

此外,对于那些想要自己运行这些示例的人来说,我在这个小概述中使用的代码是笔记本格式的:

https://github.com/emmettgb/Emmetts-DS-NoteBooks/blob/master/Julia/runtime%20introspection.ipynb

数据类型

关于数据类型,我们需要了解的第一件事是,在 Julia 中,它们有称为“字段”的属性。我们可以检查任何给定类型或数据类型的字段。当然,字段有几种不同的属性,但是最重要的两种是字段名和它们的类型。我们可以通过使用同名的方法来获取字段名,

mutable struct Noodleclass::Symbollength::Integer

endfieldnames(Noodle)(:class, :length)

这将返回一个表示该类型中每个字段名的符号元组。在 Julia 中,你定义的所有东西都有一个对应的符号。也就是说,也有一些符号对应于在你的全球环境中创造的每一个价值。我们还可以使用 getfield()和 setfield 来获取和设置字段!()然而,有许多情况下 setfield!()是行不通的。每当我们使用。,例如

Noodle.class

我们实际上是在调用 getfield 方法。如果我们使用

Noodle.class = :spaghet

然后我们调用 setfield 方法。我们可以从模块和类型中获取字段。例如,我们可以从 main 获得一个:

getfield(Main, :Noodle)Noodle

Main 只是 Julia 中顶层全局模块的名字。

最后,Julia 中任何类型的参数或数据的一个重要组成部分是它的类型。我们可以使用 fieldtypes()方法或者只使用。添加到 Julia 中每个类型的类型字段。

fieldtypes(Noodle)

(Symbol, Integer)Noodle.typessvec(Symbol, Integer)

子类型

尽管它们不太适合运行时,但在自省给定模块的类型层次结构的组件时,它们仍然很有价值。我们可以通过使用子类型操作符<:来识别一个类型是否是某物的子类型。此运算符既用于表示类型在其定义中使用时是抽象类型的子类型,也用于返回一个布尔值,表明所提供的类型是否是抽象类型的子类型。首先,让我们看看如何设置子类型:

abstract type Pasta endstruct Spaghet <: Pastalength::Integer

end

这个新的 Spaghet 类型将继承应用于 Pasta 类型的任何方法。我们现在还可以使用相同的语法来了解 Spaghet 实际上是否是 Pasta 的子类型,这将是正确的:

Spaghet <: Pastatrue

我们还可以通过使用 subtypes()方法获得给定抽象类型的所有子类型:

subtypes(Pasta)

1-element Vector{Any}:Spaghet

如果你没有接触过朱利安式的等级制度,我有一整篇文章可以更详细地介绍:

此外,这里有一个子类型树函数,它对于更好地可视化子类型也很有价值。我只是在这里的某个问题上发现了这一点,但我认为对于那些可能想更好地掌握某个类型的人来说,这绝对是非常好的:

function subtypetree(t, level=1, indent=4)level == 1 && println(t)for s in subtypes(t)println(join(fill(" ", level * indent)) * string(s))subtypetree(s, level+1, indent)endendsubtypetree(Number)NumberComplexRealAbstractFloatBigFloatFloat16Float32Float64AbstractIrrationalIrrationalIntegerBoolSignedBigIntInt128Int16Int32Int64Int8UnsignedUInt128UInt16UInt32UInt64UInt8Rational

在后台

我想展示的最后几样东西是为了一些更深入的内省。对于我们的第一个例子,我们将查看@code_llvm 宏,它只给出给定表达式的 llvm 代码:

[@code_llvm](http://twitter.com/code_llvm) subtypetree(Number); @ In[16]:1 within `subtypetree`

define nonnull {}* @japi1_subtypetree_2021({}* %0, {}** %1, i32 %2) #0 {

top:%3 = **alloca** {}**, align 8**store** volatile {}** %1, {}*** %3, align 8%4 = **load** {}*, {}** %1, align 8

; @ In[16]:2 within `subtypetree`**call** void @j_subtypetree_2022({}* nonnull %4, i64 signext 1, i64 signext 4) #1**ret** {}* inttoptr (i64 139868392615944 to {}*)

}

另一个很酷的类似的小宏是@code_typed。这与 Meta 有相似的用法。@lower,在大多数情况下,我认为这可能是一个更好的选择,除非我们想要获取的信息是一个单独的方法调用,例如,这是行不通的:

[@code_typed](http://twitter.com/code_typed) debuginfo = :source begin+(1, 1, 5)-(7, 3)

endexpression is not a function call, or is too complex for @code_typed to analyze; break it down to simpler parts if possible. In some cases, you may want to use Meta.@lower.

相比 Meta。@较低:

Meta.[@lower](http://twitter.com/lower) begin+(1, 1, 5)-(7, 3)

end:($(Expr(:thunk, CodeInfo(@ In[24]:2 within `top-level scope`

1 ─ 1 + 1 + 5

│ @ In[24]:3 within `top-level scope`

│ %2 = 7 - 3

└── return %2

))))

关于自省,我想分享的最后一件事是 varinfo()方法。这种方法很棒,因为它可以说明不同类型的记忆的用法,也可以很好地描述我们的环境中有什么。

varinfo()

(图片由作者提供)

结论

自省是编程语言的一个重要方面。当我们处理那些我们可能并不真正了解字段的类型时,这真的很方便。我认为,当我们使用动态类型语言时,情况更是如此。此外,对于不允许我们监视或控制内存和其他硬件组件的高级语言来说,在许多情况下尽可能多地使用内省确实很有意义。我认为朱利安的内省方法在大多数情况下是非常恰当的,我可能在内省方面使用最多的是 varinfo()方法。了解事情占用了多少内存真是太好了,尤其是在开发自己的包的时候。感谢您阅读我的文章,我真的很感激,我希望这篇概述有助于阐明一些更好的控制 Julia 语言的方法!

人工智能应用的安全性

原文:https://towardsdatascience.com/safety-of-artificial-intelligence-applications-1ab19606bf43

对使用人工智能可能引发的问题的探讨

阿瑟尼·托古列夫在 Unsplash 上的照片

人工智能(AI)不是上图中的机器人,它可能与电视上看到的任何东西都不相似。它是关于使用技术来帮助完成特定的任务,从接下来看什么电影,你可能有兴趣购买什么商品,你可能会点击什么广告,或者将智能手机摄像头对准你的脸以拍摄完美的自拍。

对于 AI 的未来,不同的人有不同的看法和猜想。但是,这些仅仅是这些;猜测。是的,有担忧,应该有关于我们如何在道德上使用人工智能的担忧,但是,我们不知道我们不知道什么。要更深入地了解什么是人工智能,你可以在这里阅读。

真正的担忧不应该是人工智能变得邪恶,而是它的目标是否会恶意或意外地偏离最初的意图,从而导致各种不同的问题。

在下面的段落中,我们提出了在开发或使用人工智能系统时可能出错的关键问题。这包括从高层次的哲学甚至观点到更多的技术考虑。

目录

–偏见和公平

–道德和责任

–可解释性和可解释性

–数据隐私

–健壮性–再现性和一致性

–评估

–局部最小值/最大值

–类别不平衡

偏见和公平

偏见可以通过各种方式进入人工智能模型。通常,根本原因在于数据。由于人工智能模型从数据中学习,如果数据是以引入偏见的特定方式收集的(例如,它们包括有偏见的人类决策或反映历史或社会不平等),这将影响从这些数据中训练的模型。另一个原因可能是人工智能模型没有在足够的数据上进行适当的训练(也称为欠拟合),并且正在犯不可接受的错误,或者相反,它已经在太多的数据上进行训练,以至于它失去了概括(也称为过拟合)的能力,而不是产生有偏见的预测。

为了更具体,这里有三个例子:

- 预测未来的罪犯:

2016 年 ProPublica 的一项调查得出结论,法官用来确定被定罪的罪犯是否有可能犯下更多罪行的人工智能系统似乎对少数族裔有偏见。【1】有趣的是,2019 年,英国政府发布了解决警务偏见问题的指导方针和法规。【2】

- 谷歌图像识别:

谷歌的人工智能图像识别系统混淆了动物和少数民族的人。【3】该系统没有经过足够的正确数据训练,无法做出更准确的预测,它的一些错误令人不快。

- 流氓 Twitter 聊天机器人:

早在 2016 年,一个微软聊天机器人在推特上耍流氓,骂人,发表种族主义言论和煽动性政治言论。聊天机器人接受了包括这种语言和评论的数据训练。

道德和责任:是否有与道德、角色和责任相关的标准?

道德和责任是人工智能领域的热门话题,一整篇论文都可以专门讨论这个问题。在这里,我们将简要解释我们的意思,并给出一些例子来更详细地理解由于更广泛地采用人工智能,我们作为人类将面临的困境。具体来说,这个领域是关于什么是人工智能系统的道德部署,以及如果出现问题,谁应该负责。

道德问题的一个例子可能与自动驾驶汽车(无人驾驶汽车)有关。这与电车问题类似。【5】具体来说,想一想一辆汽车 2 秒内即将撞车,车上乘客全部遇难的不幸事件。2 秒钟的时间滞后可以被看作是一个小的机会窗口来操纵和拯救乘客。问题是,另一种选择是轧死一些行人,而不是杀死他们。车到底该不该做?

在伦理人工智能下可以调查的其他问题有:

1.如果人工智能系统的部署导致失业或错失机会怎么办?例如,一个简历被自动系统筛选的求职者可能会因为某些甚至不是工作要求的特征而被拒绝。

2.应该允许人工智能系统杀人吗?

在问责制方面,问题是谁对人工智能系统的给定行为负责?是建造系统的 AI 工程师吗?是 AI 系统本身还是别人?

我们再讲一个例子来更好的理解这个问题。

一个病人去医院,由人工智能系统检查。系统检查肺部图像并输出结果。病人是阴性的,意味着图像是清晰的。几个月后,病人再次接受测试,结果是毁灭性的。病人处于肺癌晚期。不幸的是,人工智能系统错了。在这种情况下会发生什么?人工智能系统能对预测误差负责吗?是医生从系统中得到的结果吗?是最初建造它的工程师吗?

本节要提出的最后一点是关于人工智能系统反人类的问题。即使围绕这一点有很多炒作,但大多数也只是一个神话。任何人工智能系统都不存在固有的恶意,除非它被明确编程或在数据中训练成这样。当然,人工智能可以是一种工具或武器,就像刀可以是工具和武器一样。AI 依然可以被恶意使用;你可以将人工智能技术武器化,就像任何其他新技术一样。简而言之,这个话题目前不构成风险,但它肯定是我们应该继续讨论的问题,以避免这成为一个巨大的风险。

一份由著名的英国研究所撰写的更详细的报告更详细地描述了这一部分的许多方面,并提供了一个在其中运作的道德框架。此外,英国政府出于同样的目的发布了数据伦理框架,该框架与上述报告相关联。【7】

人工智能系统的可解释性/可解释性:

人工智能系统的可解释性和可解释性是经常被问到的问题,因为知道为什么和如何做出某些决定对于审计目的是重要的,而不仅仅是。

模型如何决定这是对我的公司最好的行动?它如何知道这个客户比另一个客户更有可能购买我的产品?业内许多高管向数据科学家和人工智能专家提出了这个问题,因为他们不想将他们的决策建立在他们不理解他们最初是如何得出结果的模型上。这可能是一个困难的问题,也是数据科学家和人工智能专家可能无法始终回答的问题。例如,在机器学习领域内使用特定技术,即深度学习,利用人工神经网络来进行预测。这个系统类似于大脑,其中每个神经元都以这样的方式与其他神经元相连,即信息可以在神经元之间传递,直到返回结果。【8】这种类型的人工智能系统在某些任务(图像识别、自然语言处理)中表现优于其他机器学习算法,但更具挑战性的是询问和理解结论是如何得出的。

近年来,随着美国和欧盟引入解释权,这个问题变得更加紧迫。【9】鉴于算法的输出与个人相关并对个人产生重大影响,特别是在法律或财务方面,这是对算法输出做出解释的权利。例如,某人可以申请贷款,而 AI 系统由于此人不可信而拒绝了该申请。关键问题是,系统是如何得出这个结论的。

一些说明人工智能系统中可解释性重要性的例子是图像识别软件学会作弊而不是识别图像。特别是,一个被训练来识别杂志中的马图像的系统实际上并没有识别马,但事实证明,它学会了检测马图像上可见的版权标签。【10】

数据隐私:

隐私是一个与人工智能和一般数据相关的大问题。在欧洲,2018 年生效的《一般数据保护条例》( GDPR)规范了个人数据的收集和使用。【11】数据保护法并未明确提及人工智能或机器学习,但对个人数据的大规模自动化处理和自动化决策有着重要的关注。这意味着,如果人工智能使用个人数据,它就属于该条例的范围,并适用 GDPR 原则。这可以通过使用个人数据来训练、测试或部署人工智能系统。不遵守 GDPR 可能会导致相关公司受到巨额处罚。

个人数据的例子包括出生日期、邮政编码、性别,甚至是用户的 IP 地址。

GDPR 教赋予个人不受完全自动化的决定支配的权利。对人工智能专家来说,关键问题是:当你在人工智能的帮助下对一个人做出决定时,你如何证明你公平、透明地对待了他,或者给他们机会质疑这些决定?

不利条件下的鲁棒性:

当进行对抗性攻击时,人工智能系统可能会遇到不利条件。对抗性攻击就是对人工智能系统的任何恶意干扰,目的是迫使它做出错误的预测。在这一节中,我们讨论两种情况,在这两种情况下,对人工智能系统的对抗性攻击会使系统完全混乱。

- 图像识别:图像识别是指能够识别图像中的对象的人工智能系统,即能够对图像进行分类,例如,能够区分猫图像和狗图像。这种人工智能系统被证明有弱点或者容易受到敌对攻击。研究人员已经表明,即使人工智能系统在数以千计的图像上进行训练,图像中精心放置的像素也可以从根本上改变人工智能系统对它的感知,从而导致错误的预测。【12】

- 自然语言处理(NLP):当人工智能系统处理自然语言时,自然语言也容易受到对抗性攻击。例如,研究表明,在电影评论中使用特定的同义词会改变人工智能系统对该评论的看法。【13】例如,句子/评论“在不可思议的人为情况下塑造的人物,完全脱离现实”就有负面情绪。一篇类似的评论仔细选择了如下词汇:“在不可能的工程环境中塑造的角色,完全脱离现实”,人工智能系统在将其归类为正面时感到困惑。这种攻击的主要目的是集中攻击那些根据上下文可能会产生歧义的词。NLP 环境中的对抗性攻击的其他示例包括特定单词中的字符交换或在句子中添加常见的人类打字错误。【14】

再现性和一致性

人工智能中的一个常见问题是,复制我们获得的结果或生成的模型有多容易。许多算法在训练它们的模型时具有随机元素,这意味着不同的训练尝试产生不同的模型,并且不同的模型具有不同的预测结果。此外,在本地机器上使用我们的数据表现良好的系统,在现场测试时可能表现不佳。我们如何确保我们最初拥有的性能传播到部署的应用程序?我们如何确保系统的性能不会随着时间的推移而下降?

评估