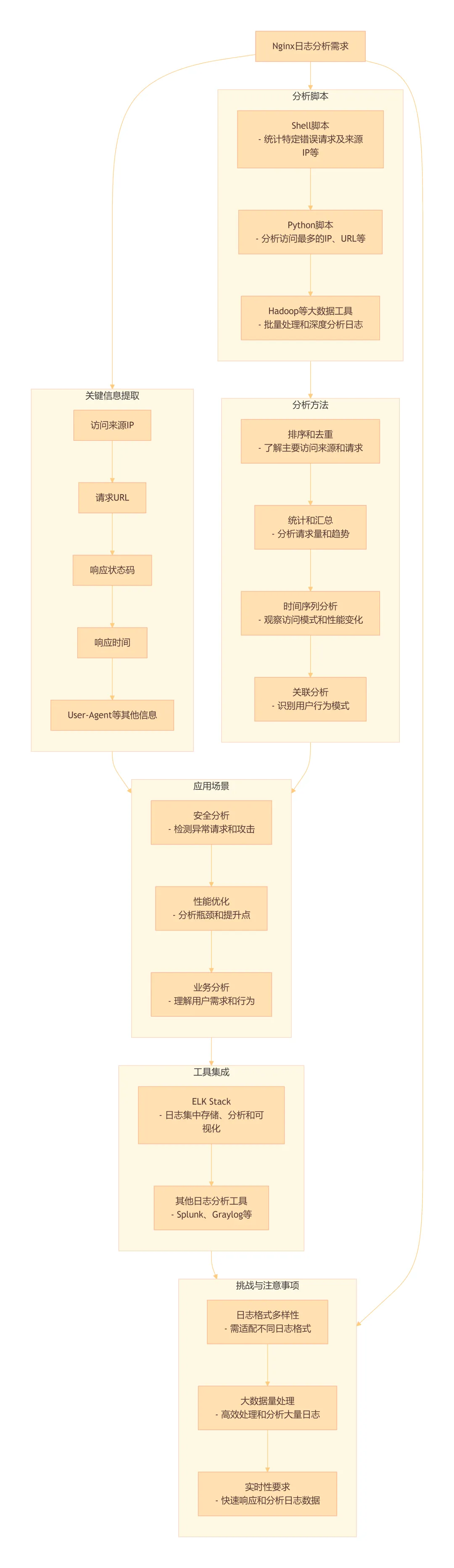

Nginx日志分析是网站运维和性能优化的重要环节。10个常用的Nginx日志分析脚本,脚本涵盖了从基本访问统计到高级性能分析的多个方面。供参考学习。

1、统计访问最多的前10个IP地址

#!/bin/bash

LOG_FILE=$1

echo "统计访问最多的10个IP"

awk '{a[$1]++}END{print "UV:",length(a);for(v in a)print v,a[v]}' $LOG_FILE | sort -k2 -nr | head -10

echo "----------------------"

2、统计指定时间段内访问最多的IP地址

#!/bin/bash

LOG_FILE=$1

START_TIME="[01/Jan/2024:00:00:00"

END_TIME="[31/Dec/2024:23:59:59"

echo"统计时间段 $START_TIME 至 $END_TIME 内访问最多的IP"

awk -v start="$START_TIME"-v end="$END_TIME"'$4 >= start && $4 <= end {a[$1]++}END{for(v in a)print v,a[v]}'$LOG_FILE|sort-k2 -nr |head-10

echo "----------------------"

3、统计访问最多的前10个页面

#!/bin/bash

LOG_FILE=$1

echo "统计访问最多的前10个页面"

awk '{a[$7]++}END{print "PV:",length(a);for(v in a)print v,a[v]}' $LOG_FILE | sort -k2 -nr | head -10

echo "----------------------"

4、统计不同页面状态码的数量

#!/bin/bash

LOG_FILE=$1

echo "统计不同页面状态码的数量"

awk '{a[$9]++}END{for(v in a)print v,a[v]}' $LOG_FILE | sort -k2 -nr

echo "----------------------"

5、统计每秒的请求数(TOP 100)

#!/bin/bash

LOG_FILE=$1

echo"统计每秒的请求数(TOP 100)"

awk '{print substr($4, 15, 2)}'$LOG_FILE|sort|uniq-c |sort-nr |head-100

echo "----------------------"

6、列出传输时间超过3秒的页面(前20条)

#!/bin/bash

LOG_FILE=$1

echo"列出传输时间超过3秒的页面(前20条)"

awk '$NF > 3 {print $7}'$LOG_FILE|sort|uniq-c |sort-nr |head-20

echo "----------------------"

7、统计蜘蛛抓取次数及404次数

#!/bin/bash

LOG_FILE=$1

SPIDER="Baiduspider"

echo"统计蜘蛛 $SPIDER 抓取次数"

grep "$SPIDER"$LOG_FILE|wc-l

echo"----------------------"

echo"统计蜘蛛 $SPIDER 抓取404的次数"

grep "$SPIDER"$LOG_FILE| grep "404"|wc-l

echo "----------------------"

8、分析并生成deny.conf以阻止高频访问IP

#!/bin/bash

LOG_PATH=/var/log/nginx

NGINX_HOME=/etc/nginx

SPIDERFILE=/data/operations/op_script/spider.txttail-2000"$LOG_PATH"/access.log | egrep -iv "$(cat $SPIDERFILE)"| awk '$7~/\/shop\/detail/ {b[$1]++} END {for (i in b) print i, b[i]}'>/tmp/b.txta=$(awk '{print $2}'/tmp/b.txt | grep -E '[5-9][0-9]{1,}'|wc-l)

b=($(awk '{print $2}'/tmp/b.txt | grep -E '[5-9][0-9]{1,}'))for((i=0; i<$a; i++));do

if["${b[i]}"-gt 300];thenawk -v ip="${b[i]}"'{if ($1 == ip) print "deny " ip ";"}'/tmp/b.txt >>$NGINX_HOME/settings.d/deny.conf

fi

donesort-u $NGINX_HOME/settings.d/deny.conf -o $NGINX_HOME/settings.d/deny.conf

nginx -t && nginx -s reload

9、综合性能分析脚本(包含多个性能指标)

#!/bin/bash

LOG_FILE=$1echo"统计访问最多的前10个IP"

awk '{a[$1]++}END{print "UV:",length(a);for(v in a)print v,a[v]}'$LOG_FILE|sort-k2 -nr |head-10

echo"----------------------"echo"统计访问最多的前10个页面"

awk '{a[$7]++}END{print "PV:",length(a);for(v in a)print v,a[v]}'$LOG_FILE|sort-k2 -nr |head-10

echo"----------------------"echo"统计每秒的请求数(TOP 10)"

awk '{print substr($4, 15, 2)}'$LOG_FILE|sort|uniq-c |sort-nr |head-10

echo"----------------------"echo"列出传输时间超过3秒的页面(前10条)"

awk '$NF > 3 {print $7}'$LOG_FILE|sort|uniq-c |sort-nr |head-10

echo"----------------------"echo"统计不同页面状态码的数量"

awk '{a[$9]++}END{for(v in a)print v,a[v]}'$LOG_FILE|sort-k2 -nr

echo "----------------------"

10、按时间段和状态码统计访问量

#!/bin/bash

LOG_FILE=$1

START_TIME="[01/Oct/2023:00:00:00"

END_TIME="[31/Oct/2023:23:59:59"

STATUS_CODE="200"echo "统计 $START_TIME 至 $END_TIME 内状态码为 $STATUS_CODE 的访问量"

awk -v start="$START_TIME" -v end="$END_TIME" -v code="$STATUS_CODE" '$4 >= start && $4 <= end && $9 == code {count++} END {print "Total accesses with status code", code, "during the specified time range:", count}' $LOG_FILE

echo "----------------------"

Nginx日志分析总结

原创 北京二锅头 运维网工