题记部分

001 || 简介

Azure Data Factory (ADF) 是微软 Azure 云平台提供的一种数据集成服务,它允许用户创建、安排和管理数据管道,以实现从不同来源抽取数据、转换数据并加载到目标存储的过程。这个过程通常被称为 ETL(Extract, Transform, Load)。

002 || 适用场景

【1】数据迁移:将数据从一个系统迁移到另一个系统,例如从本地数据库迁移到云端。

【2】数据整合:聚合来自多个异构数据源的数据,为分析或报告准备统一的数据集。

【3】实时处理:虽然ADF主要用于批处理,但也可以与Azure Stream Analytics等服务结合适用来处理近实时数据流。

【4】机器学习工作流:通过与Azure Machine Learning集成,可以构建包含训练模型步骤的数据管道。

【5】企业级BI解决方案:支持复杂的企业级商业智能(BI)应用,如数据仓库填充、报表生成等。

003 || 作用

使用ADF可以:

【1】创建管道(Pipeline),从不同的数据存储(Azure Storage,File,SQL DataBase、Azure Data Lake等)中提取数据。

【2】处理和转换原始数据,获得一个结构化的数据。

【3】把处理之后的数据发布到数据存储(Azure Synapse Analytics),供商业智能(BI)应用程序使用。

004 || 关键组件

管道(Pipeline)

数据工厂包含一个或多个Pipeline,管道是Activity的逻辑分组,一个管道作为一个工作单元,管道中的Activity作为一个整体来执行任务。管道中的Activity对数据执行动作。管道使用户可以把多个Activity作为一个整体进行管理,而不必单独管理每个Activity,管道中的Activity可以连接在一起按照顺序串联执行,也可以单独以并发方式执行。

活动(Activity)

支持三种类型的活动:数据移动活动、数据转换活动和控制流活动。

- 数据移动活动:用于把数据从源数据存储赋值到接收数据存储,来自任何源的数据都可以写入到任何接收器。

- 数据转换活动:用户对数据进行转换处理

- 控制流活动:控制流负责对管道活动进行控制,包含按照顺序连接活动、在管道级别定义参数、进行循环控制等。

数据集(Datasets)

数据集代码数据中的数据结构,这些结构指向或引用在活动中使用的数据(输入或输出),也就是说,一个活动使用零个或多个数据集作为输入,使用一个或多个数据集作为输出。数据集(Dataset)类似于数据的视图,只是简单地指向或引用在活动中用于输入地数据源或者用于输出地数据目标。在创建Dataset之前,必须创建Linked Service,把数据连接到数据工厂。Linked Service就像连接字符串,定义数据工厂如何和外部资源进行连接。而Dataset代表的是数据的结构(Schema),而Linked Service定义如何连接到数据。

连接(Connection)

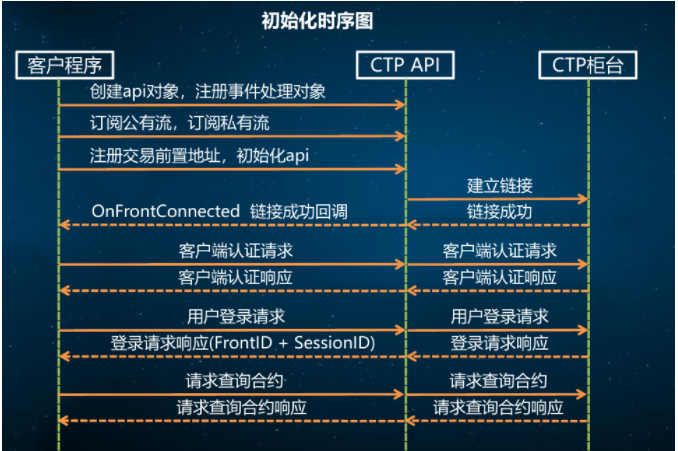

连接有两种类型:Linked Services 和Integration runtimes,Linked Services是基于Integration runtimes的连接服务。

Integration runtime(IR)是Azure数据工厂在不同的网络环境中进行数据集成的组件,连接服务(Linked Service)类似于连接字符串,用于定义ADF连接到外部资源时所需要的连接信息,连接服务定义如何连接到外部数据源,而数据集代表外部源数据的结构。