文章来源于:AustinDatabases,作者:liuaustin3

在数据管理中,“提取(Extract)、转换(Transform)、加载(Load)”是高效数据集成解决方案的支柱。正确的 ETL 工具可以将来自多个数据源的大量不同数据转化为滋养企业自主洞察分析能力的土壤。作为以低延迟数据移动为特色的实时数据集成工具,TapData 提供了 Cloud 以及 On-Prem 两种部署方式。本篇内容由 AustinDatabase 提供,内容围绕 TapData Cloud 的实测展开,希望能为大家提供更多角度的参考。

最近忙,更新率低了,今天说说其中的一个原因,最近和业内的 ETL 方面的更新的技术在进行学习,之前一些 ETL 的观念在这次的学习中,也彻底被更新了,这是整个的学习过程进行一个记录,每天都是新知识,每天都是崭新的。

在 ETL 数据传输和数据处理中,我们习惯使用的方法多是 Kettle,otter,canal,ogg 这样的数据迁移 ETL 软件。可时代变迁了,再用这些软件在很多场合已经不合时宜了。尤其是短平快的需求下,我实在是没有精力时间去研究这些东西,还要进行数据库对应的配置,而最近赶时髦,用上了云迁移的 ETL 软件,TapData Cloud,非常神奇的软件,如果要我用一句话来概括,彻底让我了解到现在的 ETL 是什么样子,或者该是什么样子,和之前的那些傻大笨粗已经毫无关系。

废话不说,马上进行测试。打开 https://tapdata.net/ 网站,点击 cloud 。

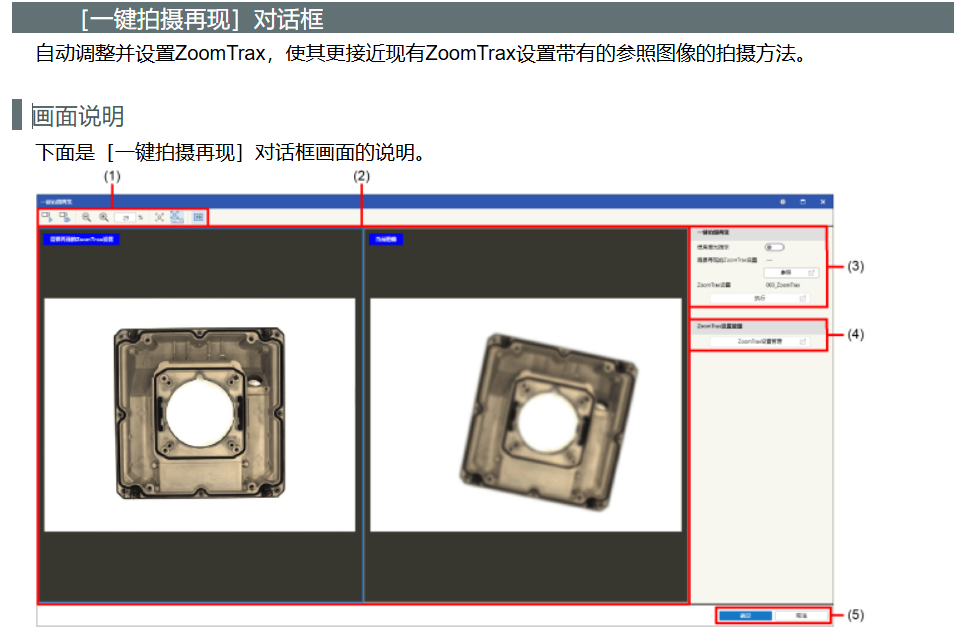

通过这个软件我两分钟内我就配置好了一个从 PolarDB 到 PolarDB 的数据流复制。

大家见上图数据已经开始进行了同步,非常的便捷,这里我简单的介绍一下,TapData 云 ETL,这个免费的工具可以干点什么。

1 云免费 ETL 可以进行各种开源数据库到国产数据库的同步,你知道的国产数据库基本都在支持列表

2 使用者根本不关心配置,因为都是自动的,我可以专心的搞我的数据库,复制的监控和过程都由 TapData 云来负责。

3 核心的数据不会经过 TapData 而是你自建的主机,让使用者完全不用担心数据的安全性的问题。

有了这个功能,基本上数据迁移的过程上步骤

1 云注册账号

2 开通免费的服务

3 安装好 agent

4 配置好本地和远程的连接

5 工作完毕

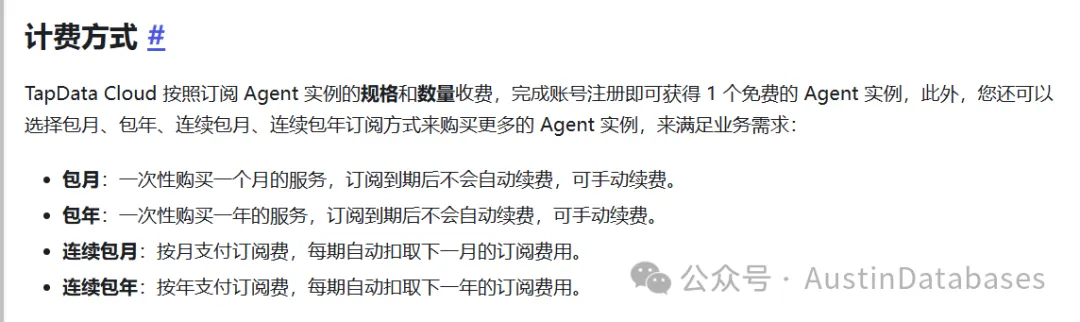

这个服务可以把数据从 MySQL , PostgreSQL ,Sql Server, Oracle 往国产数据库搬运,这里需要说明如果是企业性质可以开通收费的服务,他将提供更多的功能,服务等。

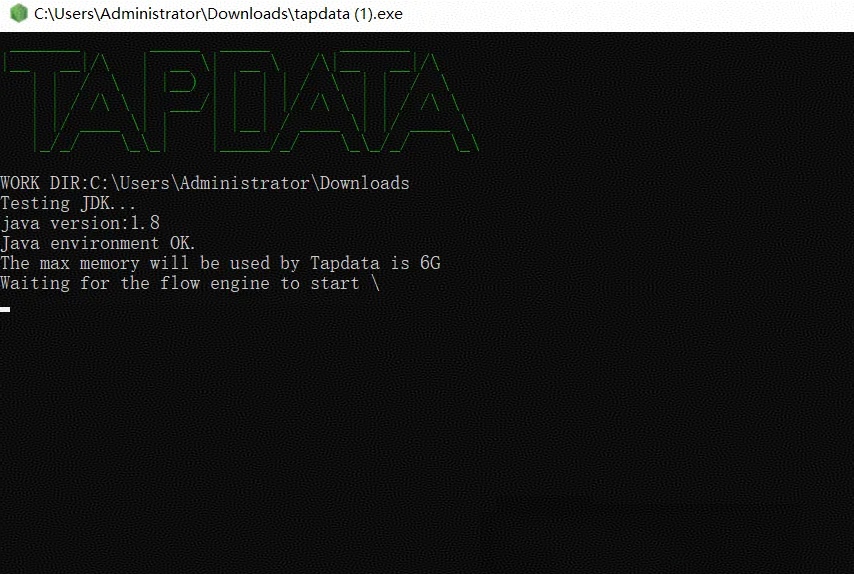

这里有官方的付费方式

这里我小声说一句,如果实在是不想花钱,还想要高性能,自己可以用自己的服务器利用 TapData 管理数据传输,比如我现在就是这么干的,我需要从 PolarDB 传输数据到另一个 PolarDB,数据量不大,TapData 可以直接将服务的 agent 自动安装在我的笔记本上,然后我就开始远程将一个 PolarDB 的数据,传输到另一个 PolarDB 上。在默认的情况下,简单的数据传输迁移,TapData 是不收费的。

操作界面异常的简单,源目的地,选择连接到你的数据库上,本地、远程、云均可,TapData 对于数据库的 ETL 是“不挑食的”。

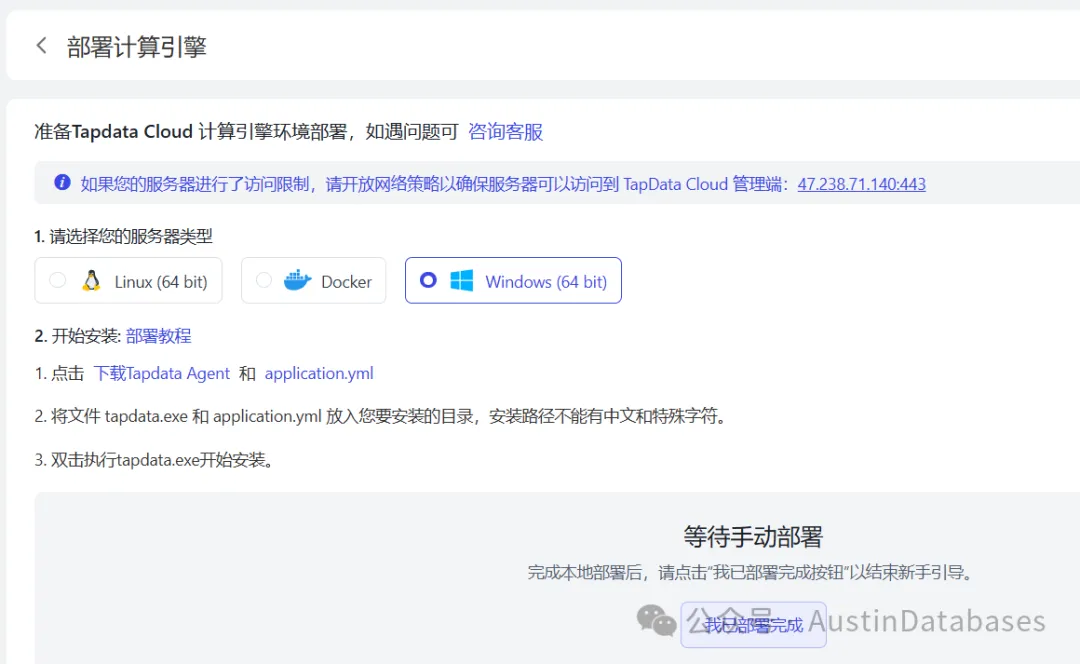

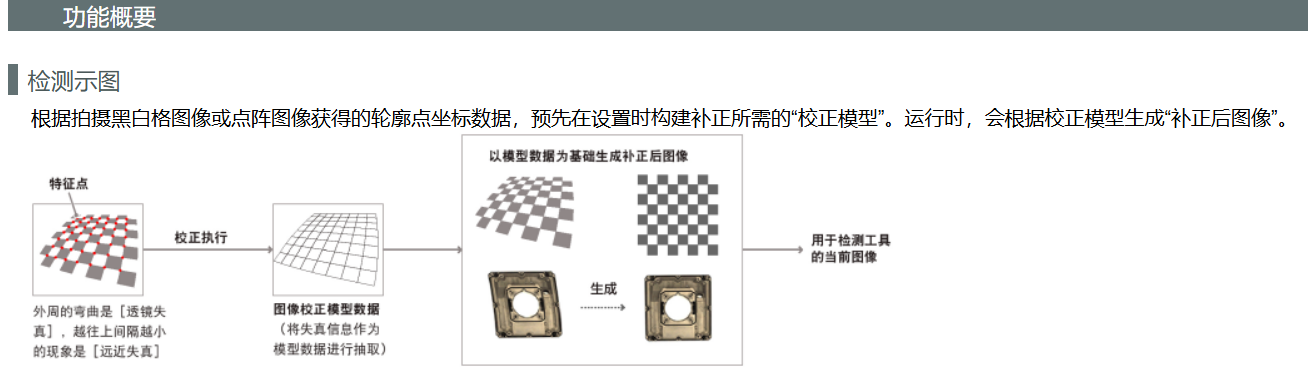

关于大部分人可能担心自己安装 Agent 到服务器上的难度,这里可以看此页面,非常简单,支持 LINUX、WINDOWS、Docker、云上部署服务器等方式。同时你自己还可以通过云来监控你自己的 ETL 服务器,可以通过手动来启动自己的服务器的上的 ETL 服务,这里我简单的画一个图。

在建立好 Agent 后,我们就可以建立源库和目的库的链接测试了,在测试通过后,就直接可以进行数据库的传输了。

由于过程太简单,我就不叙述了,如同打开冰箱门,把大象塞进去,然后再关上门那么简单,如果我再详细叙述,是对看文章的人的不尊重。

工作到这里,我突然意识到一个问题,在之前各种本地安装,调试,各种问题的 ETL 的软件的生命历史中,他们意识到现在的 ETL 软件已经可以云化了吗,作为一个对新产品不拒绝,不挑食的 IT 工作者,我觉得我在 ETL 探索更先进了,这 ETL 使用的方式太简单了,这里我先看官方文档中详细的一些产品的介绍,看完介绍,在将一些疑问总结起来在和 ETL 方面的专家进行快速学习。

B~9%250LU36$U_%60A465WRI.png)