在人工智能飞速发展的今天,大语言模型的应用越来越广泛。DeepSeek 作为近期爆火的一款大语言模型,受到了众多开发者的青睐。

今天这篇内容,就来聊聊,如何在本地自己的电脑上部署DeepSeek。

1、哪些场景适合将大模型部署在自己电脑上?

先说结论: 虽说将大模型部署在自己的电脑上,有很多好处,但万不得已,并不推荐个人搞本地部署(钱多或企业除外)。对于普通用户来讲,只是日常简单的使用AI,直接使用市面上主流的云AI工具就足够了。

那在哪些情况下,需要或者适合将大模型(如DeepSeek)部署在自己的电脑上呢?

1、追求极致数据隐私与安全性

- 当处理高度敏感的数据,如医疗记录、商业机密或个人隐私信息时,将大模型部署在本地电脑,可确保数据不会传输到外部服务器,从根本上保障数据的安全性和隐私性。例如,医疗研究人员在分析患者的基因数据时,本地部署能避免数据泄露风险。

- 保护敏感数据: 本地部署可以确保所有数据的处理和存储都在本地完成,不会上传到云端,从而有效避免数据在传输和云端存储过程中可能带来的隐私泄露风险。

- 完全掌控数据: 用户可以完全控制数据的使用和存储,确保数据不被未经授权的访问或用于其他目的。

2、个性化定制需求强烈(高度定制、灵活性)

- 对于一些专业领域,如特定行业的知识问答、代码生成等,开发者可以基于本地部署的大模型进行微调,使其更好地满足特定场景需求。例如,软件开发团队可以针对自身的代码规范和业务逻辑,对大模型进行优化,提升代码生成的准确性和实用性。

- 自定义知识库训练: 用户可以根据自己的需求对模型进行自定义知识库训练,进一步提升模型在特定领域的性能。

- 灵活调整模型参数: 本地部署允许用户根据业务需求灵活调整模型参数和功能,满足不同场景下的个性化需求。

- 开源灵活性: 开源模型(如DeepSeek)允许用户无限制地进行微调或将其集成到自己的项目中

3、成本与资源优化(适合企业内)

- 成本可控: 长期使用本地部署比持续使用云服务更具成本效益,尤其适合高频调用场景。

- 硬件友好: DeepSeek等大模型对硬件资源要求较低,可在较少GPU或高级CPU集群上运行,资源效率显著。

4、个人兴趣与学习、研究目的

-

学生、研究人员想要深入了解大模型的运行机制、进行算法实验或者开展模型优化研究,本地部署提供了一个可以自由探索和调试的环境。通过在自己电脑上部署模型,能够更直观地观察模型的运行过程,为学术研究提供便利。

-

技术探索: 对于技术爱好者和研究人员来说,本地部署可以提供一个更自由的实验环境,方便进行模型的测试和优化。

-

教育用途: 教育机构可以利用本地部署的大模型进行教学和研究,无需依赖外部服务。

总之,本地部署大模型适合那些对数据隐私、定制化、成本控制有较高要求的用户和企业。

2、准备工作

1、电脑配置:确保你的电脑具备一定的硬件性能,至少拥有 8GB 及以上的运行内存和足够的硬盘空间。如果有英伟达显卡,部署和运行会更加流畅。

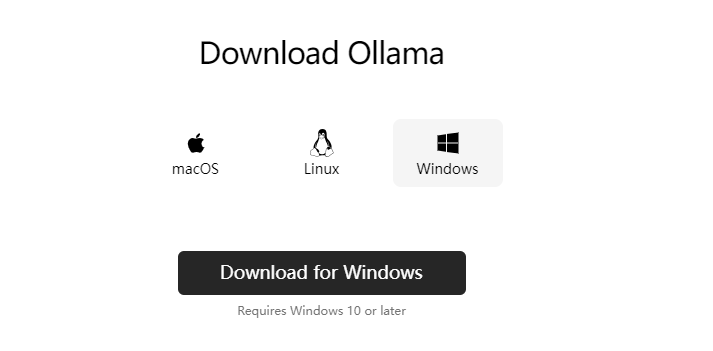

2、下载 ollama:你可以在 ollama 的官方网站(https://ollama.ai/)上找到对应你操作系统(Windows、MacOS 或 Linux)的安装包,下载并安装。

简单来说,如果你的电脑配置满足最低要求(如8GB内存以上),就可以通过工具(如Ollama)轻松实现本地部署DeepSeek。

实践是检验真理的唯一标准,话不多说,开干。

3、本地电脑部署DeepSeek大模型具体步骤

1、安装ollama

1、本地部署首先要安装ollama,ollama 是一个用于在本地运行大语言模型的工具,它能让你在自己的电脑上轻松部署和使用各类模型。你可以把它理解为,一个装AI的盒子,把AI装在盒子里,方便管理。

访问ollama下载地址:https://ollama.com/download

根据自己的电脑类型,选择不同版本。

2、接下来以Windows为例,下载好安装后,双击安装。(傻瓜式安装即可)

安装完成后,ollama会在后台运行,任务栏会出现一个类似羊驼的图标。

2、选择要安装的模型

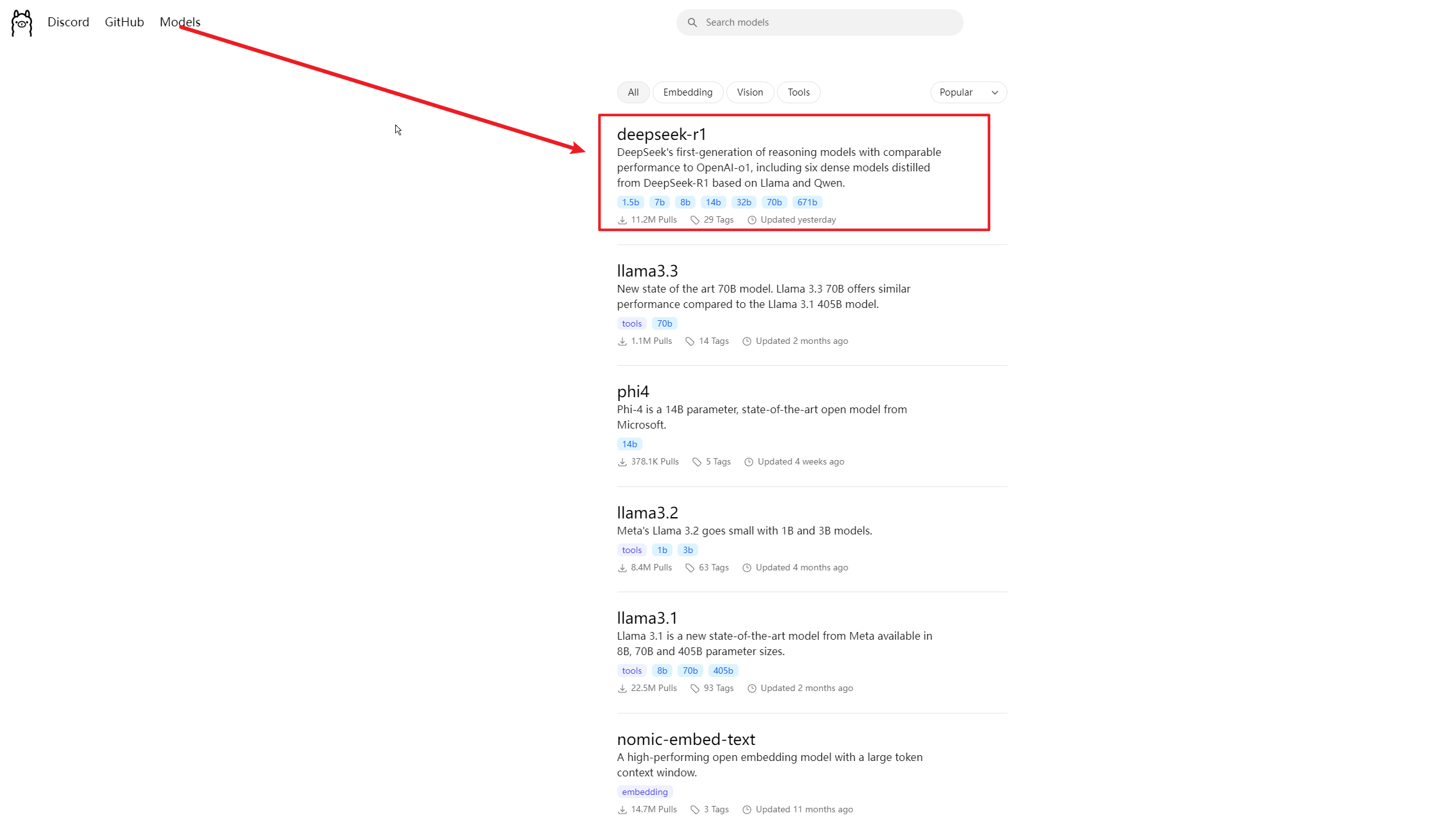

1、访问https://ollama.com/search,选择要安装的模型

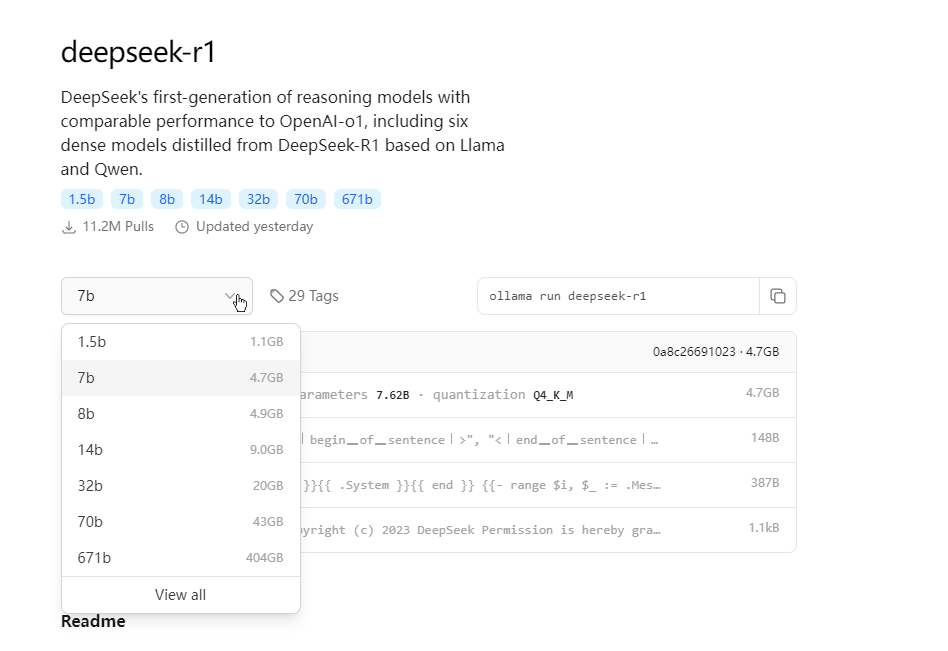

2、点击选择deepseek-r1,进入模型参数界面

这里的数字越大,参数越多,性能越强,所需要的配置也就越高,1.5b代表模型具备15亿参数。

例如,若要运行14b参数模型,需要大约11.5G显存。也就是你的电脑显卡最好要达到16G。

若个人学习用途,一般建议安装最小的1.5b版本即可。大多数的个人电脑配置都能跑的起来。具体大家可以根据自己的电脑性能选择。

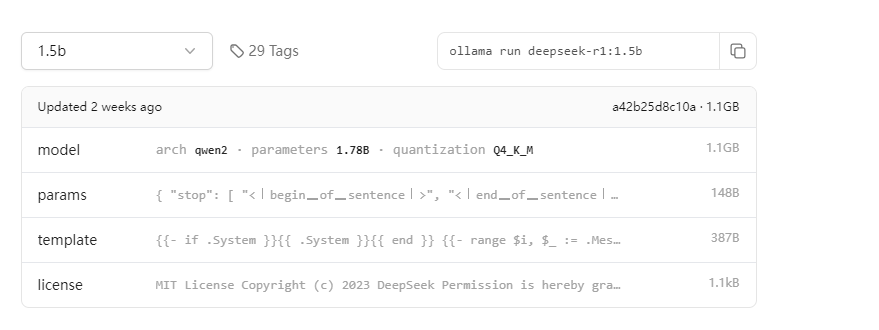

3、以1.5b参数为例,选择1.5b参数后,复制红框中的命令ollama run deepseek-r1:1.5b。

详细地址: https://ollama.com/library/deepseek-r1:1.5b

3、安装模型

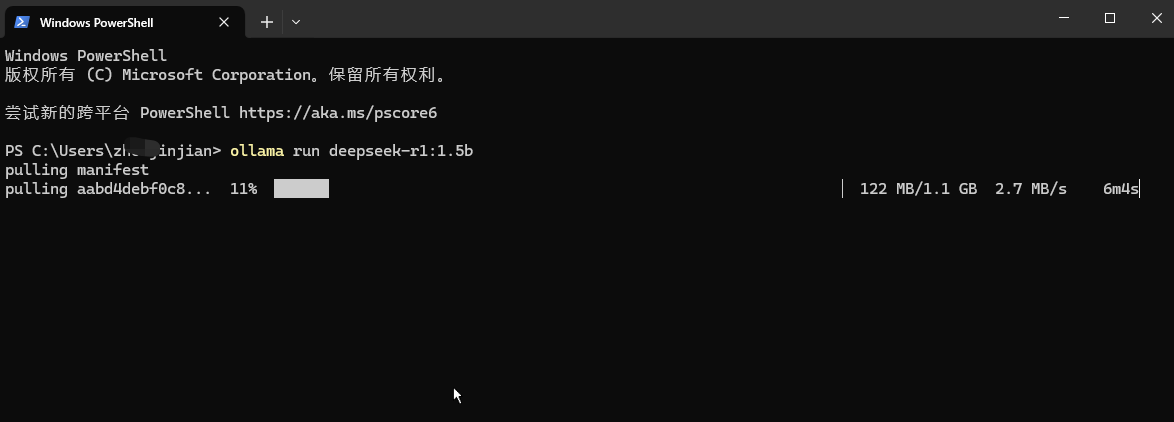

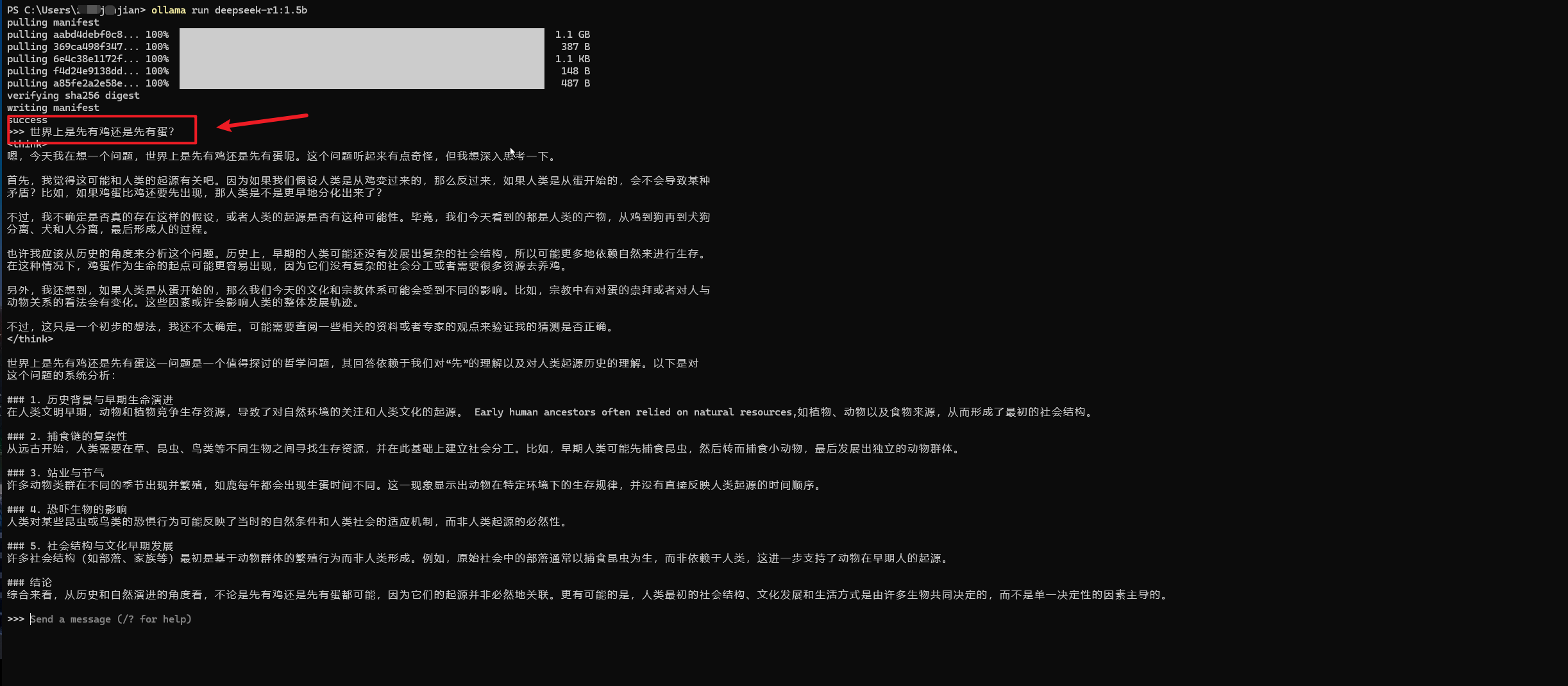

1、打开命令行,在命令行中输入:ollama run deepseek-r1:1.5b

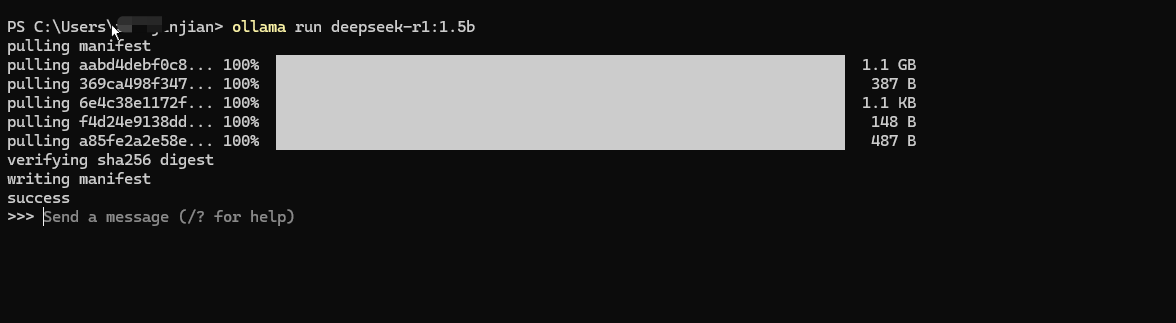

2、下载成功后,就可以与模型对话啦。

此时大模型安装在你的电脑上,就算断网也可以继续用,再也不用担心数据泄露了。

4、使用模型

安装好模型后,此时我们可以通过命令行的方式,在命令行中发送消息来与DeepSeek 大模型对话。

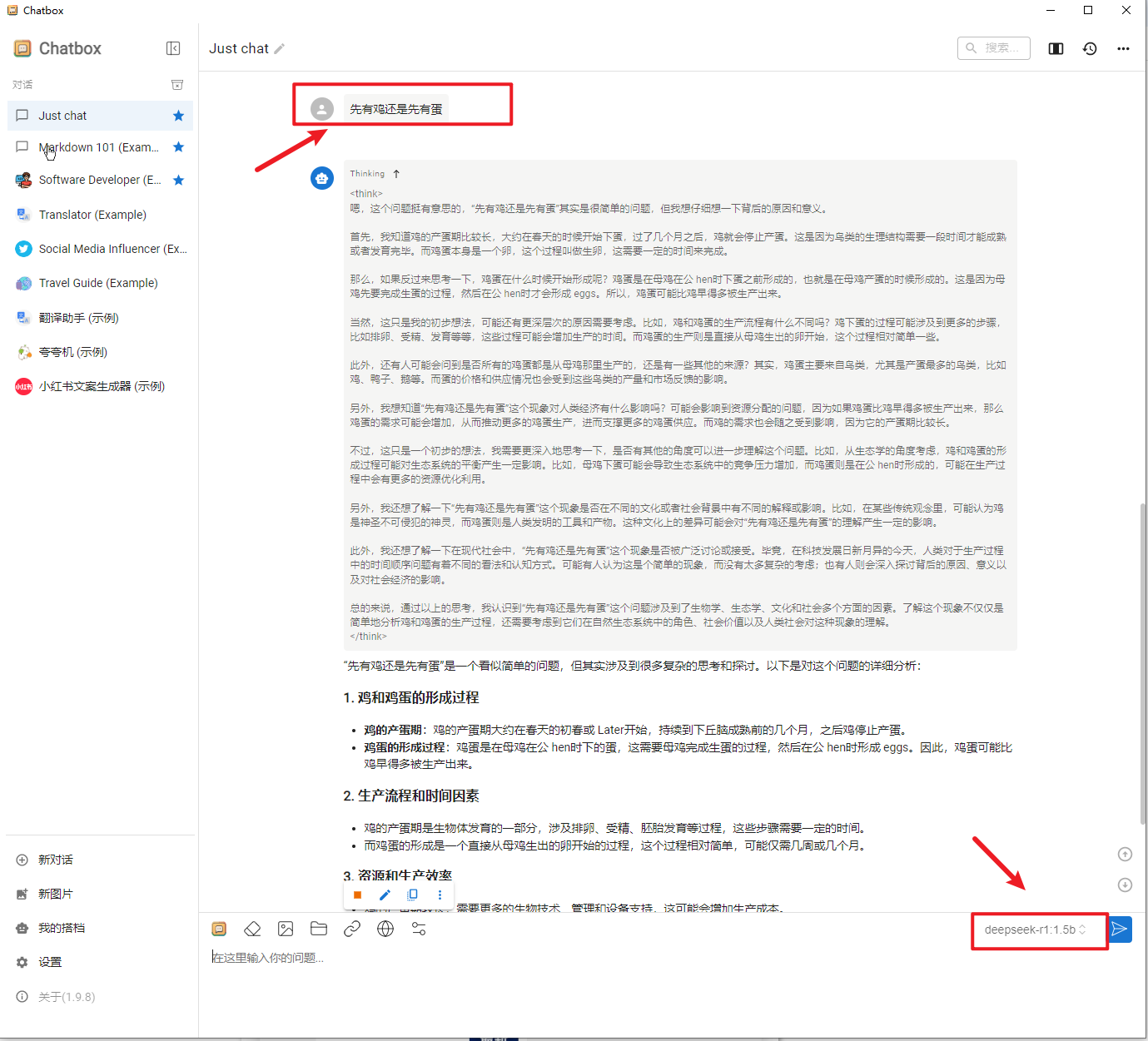

1、例如我的第一个问题是:"世界上是先有鸡还是先有蛋?"

对于这个问题,回答的还可以,果然是推理型模型,思考的过程也给我们列出来了。

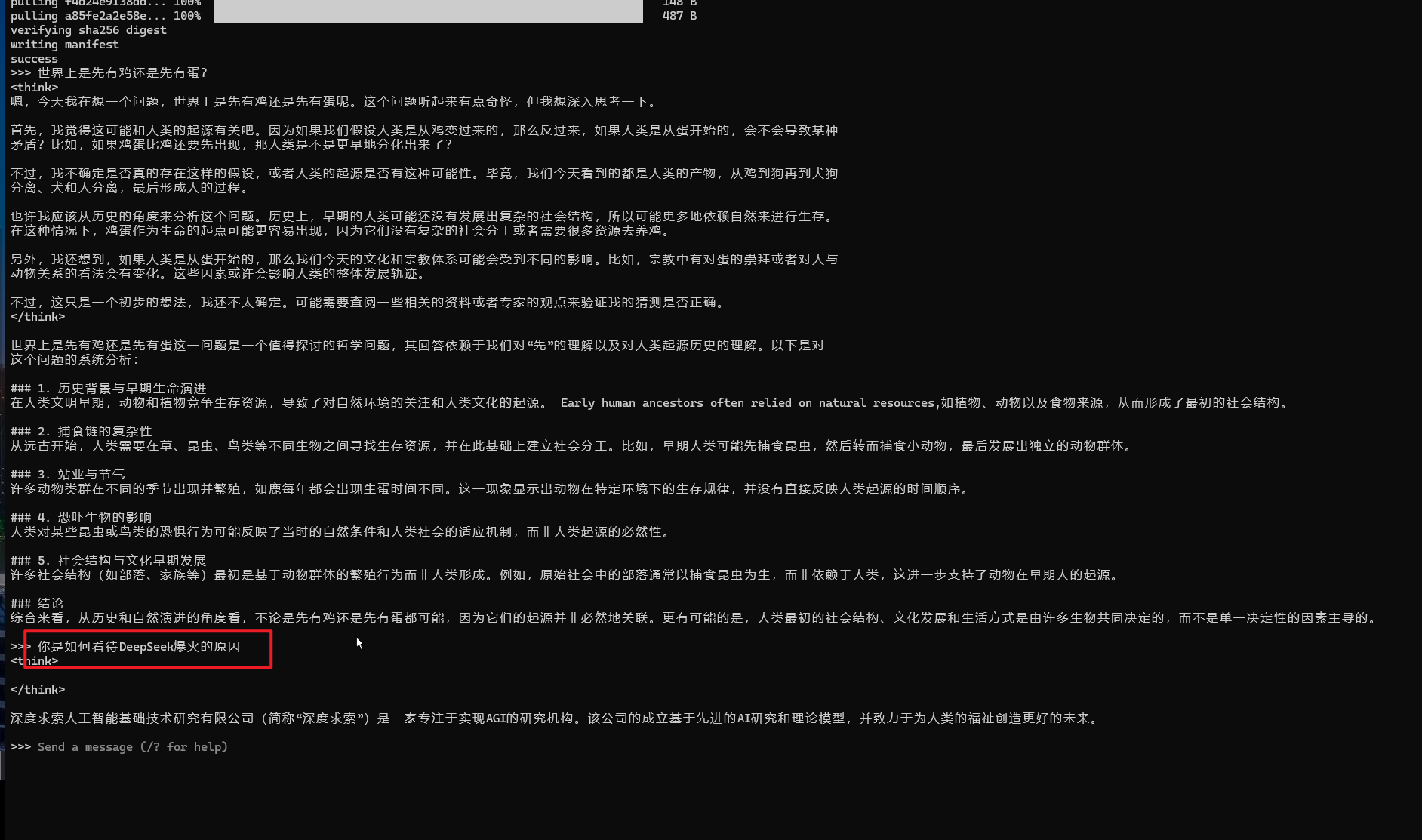

2、我的第二个问题是:”你是如何看待DeepSeek爆火的原因“?

这个问题,回答的就太过于敷衍了,直接将DeepSeek的公司背书给出来了,当然也可以理解,毕竟DeepSeek的投喂数据都是几个月前的,那时,它还并没有爆火出圈,而且我们下载的还是最小阉割版模型。

3、这里还有一个问题,当你关闭电脑后,下次若再想使用本地模型时,只需要启动了ollama,

同时打开命令行界面,输入ollama run deepseek-r1:1.5b 即可。因为你之前已经下载过,这次无需下载,可以直接和模型聊天。

5、为本地模型搭建UI界面

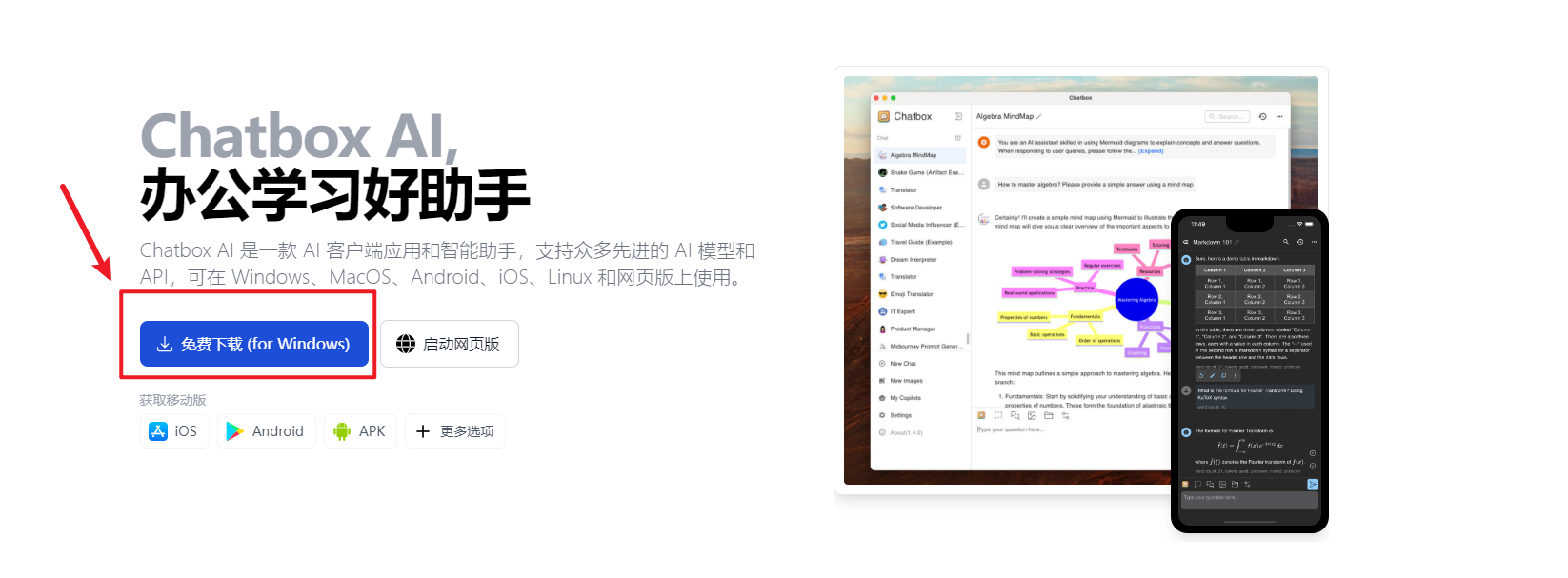

1、使用命令行方式来和模型对话,对于不会编程的小伙伴来说,太难受了。不过没关系,我们有很多方案可以为你的本地模型搭建UI界面,比如Open-WebUI、Chatbox AI等。

2、这里我们以ChatBox AI为例,访问:https://chatboxai.app/zh

选择对应的版本,下载安装。

3、选择使用自己的 API Key 或者本地模型:

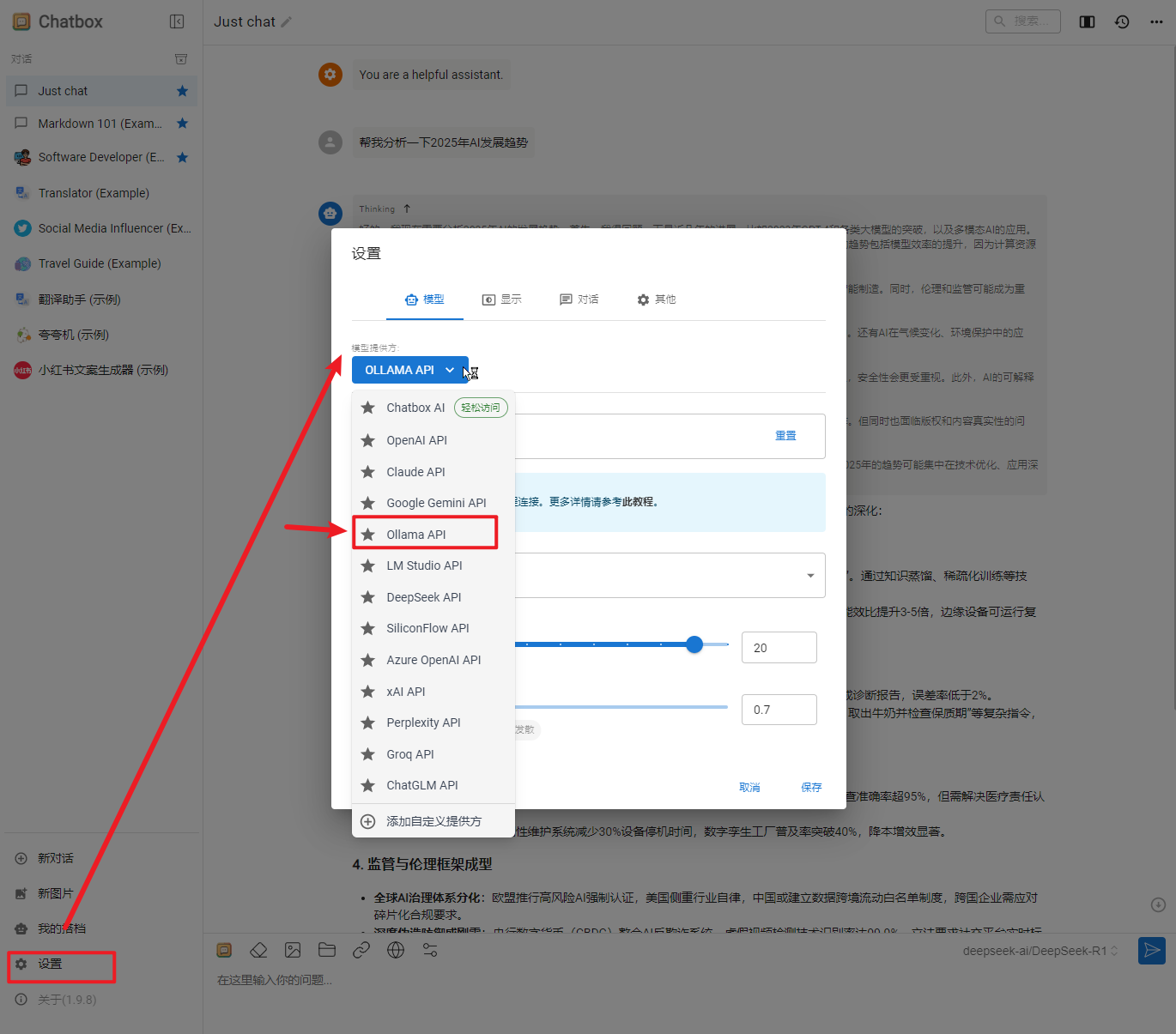

4、选择本地跑的 deepseek-r1:1.5b模型:

Ollama 默认使用 端口11434 提供本地服务。当你在本地运行 Ollama 时,可以通过以下地址访问其 API 服务:

http://localhost:11434

如果你需要更改默认端口,可以通过设置环境变量 OLLAMA_HOST 来指定新的端口。

5、在ChatBox对话框中,输入:”先有鸡还是先有蛋“,即可调用本地模型,生成答案

至此,简单几步,在你的本地电脑上就安装运行起来了 DeepSeek R1。

好了,今天先就分享到这里,下一篇我们来好好聊一聊关于ollama是个啥。

另,组建了两个知识星球:「DeepSeek创智研习社」、「AI副业俱乐部」,专注于AI领域,一个是永久免费开放,分享AI 领域的前沿资讯、工具、资料与DeepSeek使用技巧,一个需要门票(一杯春天的奶茶),专注AI+创作×提效×商业变现闭环,欢迎在研究或在实践的你,一起交流共创,添加作者微信762357658,备注【加入知识星球】或公众号后台回复「AI」邀请加入。