DeepSeek 已成为人工智能领域的突破性工具,因其能够超越 ChatGPT、Gemini 和 Copilot 等先前模型的局限性而脱颖而出。DeepSeek 如此有效的关键方面之一是其自适应解码算法,这是一种优化用户交互并提高生产力的创新系统。本文将揭示该算法的工作原理,提供技术解释和实际类比,以帮助您了解它在现实世界中的运作方式。

什么是自适应解码?

自适应解码是 AI 模型动态生成响应的过程,以适应手头的对话或任务。与依赖基于一组预定义规则的静态响应的传统方法不同,DeepSeek 使用一种可以根据交互上下文微调其响应的算法。这意味着它不仅参与信息交换,而且还不断优化其处理和呈现信息的方式,从而有效地适应用户的需求。以下是DeepSeek的回答:

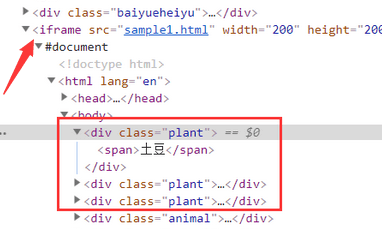

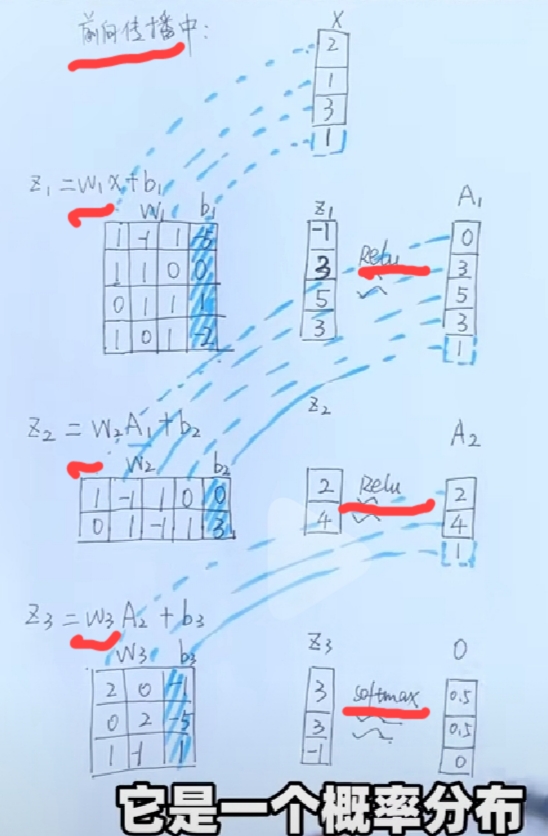

动态标记化:数据理解的范式转变

DeepSeek 的基础创新之一是它能够处理动态标记化,这是一种先进的自然语言处理技术,可让 AI 更准确地理解和生成文本。要理解标记化,可以将其视为将文本分解为较小部分或“标记”的一种方式。在传统模型中,标记是静态生成的,这些标记的长度可能受到限制,这会影响模型处理长文本或复杂上下文的能力。

然而,DeepSeek 实现了动态标记化,可根据正在处理的文本的内容和复杂性调整标记的数量和类型。这不仅提高了它对复杂上下文的理解,还使其能够处理更广泛的数据,从简单查询到更深入、更复杂的请求。通过采用更灵活的方法,DeepSeek 避免了其他 AI 模型中常见的瓶颈,使其即使在输入较长且复杂的情况下也能保持连贯性和准确性。

长上下文管理:DeepSeek 如何超越先前模型的限制

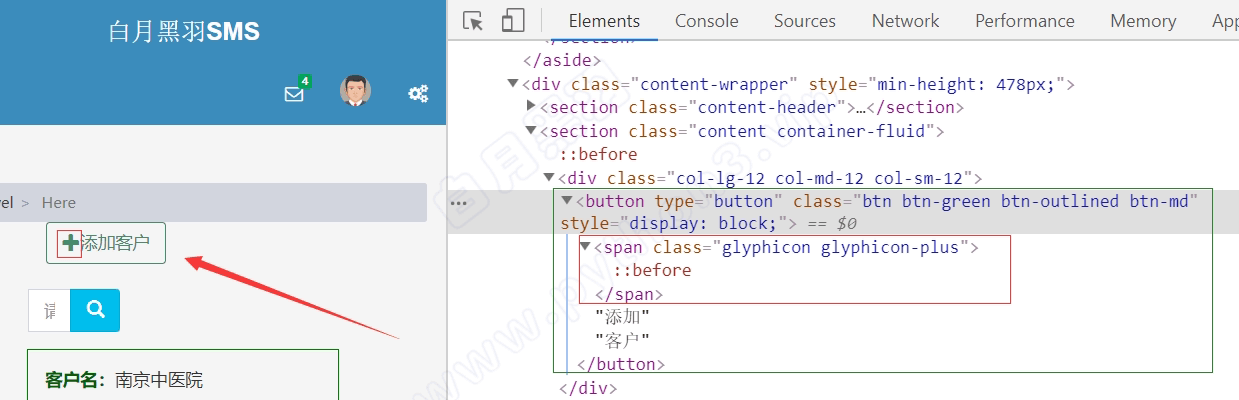

管理长上下文的能力对于任何对话式 AI 模型的有效性都至关重要。传统模型(例如 ChatGPT 或 Gemini)在单个交互周期中可以处理的标记数量方面存在限制。这通常被称为“标记限制”。例如,像 ChatGPT 这样的模型可以处理大约 4,096 个标记,这相当于相对较短的上下文。这意味着,如果您参与需要扩展上下文的对话或任务,模型可能会丢失重要细节,甚至忘记之前说过的内容。

这就是 DeepSeek 的长上下文管理大放异彩的地方。它能够处理多达 128,000 个标记,使其能够以更大的上下文深度处理复杂任务。这相当于与一个不会忘记说过的话的人交谈,让模型“记住”扩展交互的所有重要细节而不会失去踪迹。

想象一下,你正在从事一个长期项目,例如撰写文章或创建复杂的代码。使用传统模型,每次你返回 AI 寻求更多帮助时,你可能会失去已经完成工作的连续性。使用 DeepSeek,AI 可以在整个交互过程中保持连贯的记忆,使你能够继续前进而无需不断重复信息。

降低出错率:DeepSeek 如何最大限度地减少响应中的错误

包括 ChatGPT、Gemini 和 Copilot 在内的 AI 模型面临的最大挑战之一是被称为“幻觉”的现象。当模型生成不正确、不精确或完全虚构的响应时,就会出现幻觉,出错率也会大幅提高。这通常是由于学习过程的限制或缺乏适当的背景。当寻求准确信息或将 AI 用于编程或客户服务等关键任务时,这个问题尤其令人沮丧。

DeepSeek 通过使用其自适应解码算法来优化响应生成来解决这一挑战。系统可以更准确地微调其输出,从而降低出现幻觉的可能性。此外,通过处理更大、更详细的上下文(最多 128,000 个标记),AI 拥有更多信息来生成准确的响应,从而进一步降低出错的可能性。

想象一下,有幻觉的 AI 和没有幻觉的 AI 之间的区别,就像犯错误的人类翻译和提供精确翻译的人类翻译之间的区别。对上下文和单词含义有很好理解的翻译要准确和可靠得多。同样,DeepSeek 凭借其自适应解码算法,可以像人类翻译一样准确和可靠地翻译。

附清华大学DeepSeek三部曲:

DeepSeek从入门到精通 - 好运工具

DeepSeek如何赋能职场应用? - 好运工具

普通人如何抓住DeepSeek红利 - 好运工具