在人工智能飞速发展的当下,大语言模型(LLM)已然成为焦点。从智能聊天机器人到内容创作辅助,大语言模型的应用无处不在。但你是否了解其背后的推理过程,以及如何让这些模型运行得又快又好?今天,我们就来深入探讨大语言模型推理的奥秘。

一、🌟大语言模型推理指标详解

在大语言模型推理中,有四个关键指标,它们从不同维度衡量着模型的性能。

吞吐量(Throughput)

吞吐量是指当系统负载达到最大时,单位时间内能够执行的 decoding 数量,即生成字符的数量。理想状态下,假设所有用户同时到来,提出相同问题,输入和生成长度一致,组成完整的 batch,此时系统吞吐量最高,但这在现实中几乎不可能。实际测试时,我们会测量每秒系统能执行的独立 decoding 阶段数。例如,在特定测试环境下,某模型每秒可执行 50 个独立 decoding 阶段,这便是它的吞吐量表现。

首字延迟(First Token Latency)

首字延迟指一批用户进入推理系统后,完成 Prefill 阶段所需的时间,也就是系统生成第一个字符的响应时间。许多应用场景对这个指标十分关注,通常希望用户提问后得到回答的时间小于 2 - 3 秒。如当用户输入长度较短时,某些模型的首字延迟能控制在 100 毫秒以内,但当输入长度大幅增加,首字延迟可能会飙升至数秒。

延迟(Latency)

延迟是指每一个 decoding 所需的时长,反映了模型在线上处理时生成字符的流畅度。一般来说,我们期望生成延迟小于 50 毫秒,即每秒生成 20 个字符,这样大语言模型的生成过程才较为流畅。以某知名模型为例,在常规配置下,其 decoding 延迟稳定在 40 毫秒左右,生成效果良好。

每秒请求数(QPS)

每秒请求数反映线上系统服务中,每秒能处理的用户请求数。由于实际使用中,用户到来时间和生成长度都不确定,导致在 Prefill 阶段 GPU 会出现空闲,使得 QPS 无法完全发挥吞吐量优势。所以在 QPS 指标上,需要诸多优化方案来避免计算空洞,提高显卡利用率。

二、🚀大语言模型推理性能优化策略

为了提升大语言模型的推理性能,业界采用了多种优化方法。

模型压缩与优化

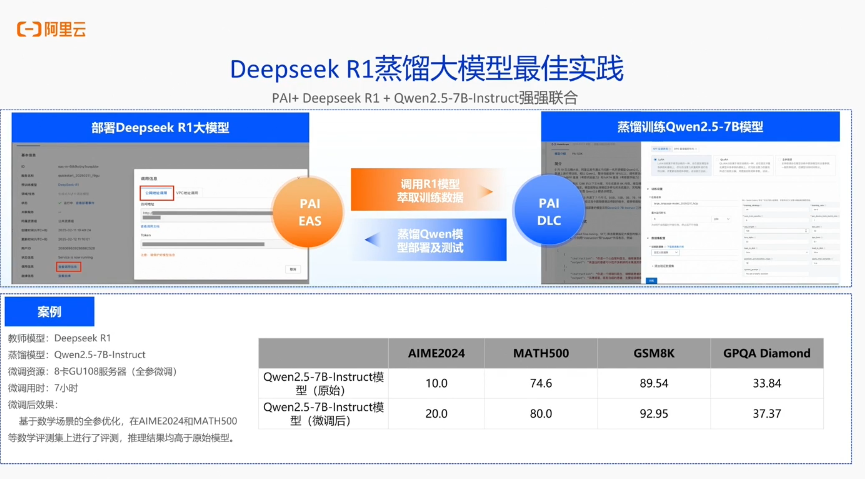

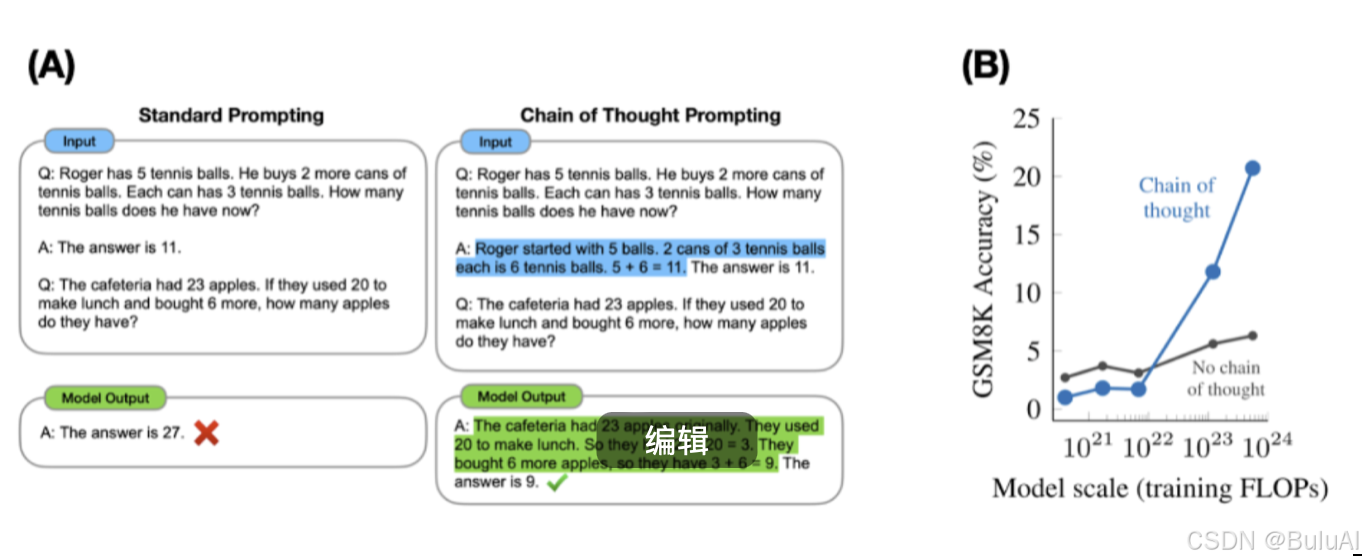

- 模型蒸馏(Model Distillation) :训练一个较小的学生模型来模仿大型教师模型的输出,学生模型学习教师模型的“软标签”,在减少模型参数量的同时保留大部分性能。研究表明,经过模型蒸馏后,模型参数量可减少 50% 以上,而性能损失控制在 5% 以内。

- 剪枝(Pruning) :分为结构化剪枝和非结构化剪枝。结构化剪枝按层级或神经元进行,不影响模型整体结构;非结构化剪枝对单个权重裁剪。剪枝后的模型能在硬件上更高效运行,推理时间可缩短 30% 左右。

- 量化(Quantization) :将模型浮点数参数转换为低精度表示。静态量化在推理前处理,动态量化在推理中动态调整。量化可显著减少存储需求,加速推理过程,在某些资源受限设备上,量化后的模型推理速度提升 2 倍以上。

并行计算策略

- 数据并行(Data Parallelism) :把训练数据分成多个批次,在多个计算设备上并行处理。实验显示,采用数据并行,在 4 个 GPU 设备上训练,训练速度可提升 3 倍左右。

- 模型并行(Model Parallelism) :将模型不同部分分配到多个计算设备,适用于超大规模模型。比如,对于参数规模达万亿级别的模型,模型并行可使其在多个设备上正常运行。

三、🔍主流大语言模型推理框架对比

目前,市面上有多种大语言模型推理框架,各有特点和优势。

vLLM

vLLM 是一个专注于高性能推理和服务的开源框架。其核心创新是 PagedAttention 技术,优化了注意力机制的内存使用效率,通过连续批处理技术提升 GPU 利用率。它支持多种量化方法,与 OpenAI API 兼容,和 Hugging Face 生态系统深度集成。在大批量 Prompt 输入且对推理速度要求高的场景中表现出色,其吞吐量比 HuggingFace Transformers 高出 24 倍。

Text Generation Inference (TGI)

Text Generation Inference (TGI) 依赖 HuggingFace 模型,提供模型并行、张量并行和流水线并行等优化技术。本机支持 HuggingFace 模型,适合在多种硬件环境下高效推理,尤其适用于不需要为核心模型增加多个 adapter 的场景。

TensorRT-LLM

TensorRT-LLM 由英伟达推出,提供层融合、自回归模型推理优化等技术。使用最新优化技术将 LLM 模型转换为 TensorRT Engines,推理时直接使用优化后的引擎,适合对高性能推理和模型优化要求较高的场景。

四、🎉总结

大语言模型推理的性能优化和框架选择,直接关系到模型的应用效果和用户体验。无论是企业开发者,还是 AI 爱好者,了解这些知识都能帮助我们更好地利用大语言模型,推动人工智能技术的发展与应用。如果你对大语言模型推理还有其他疑问,欢迎在评论区留言讨论。

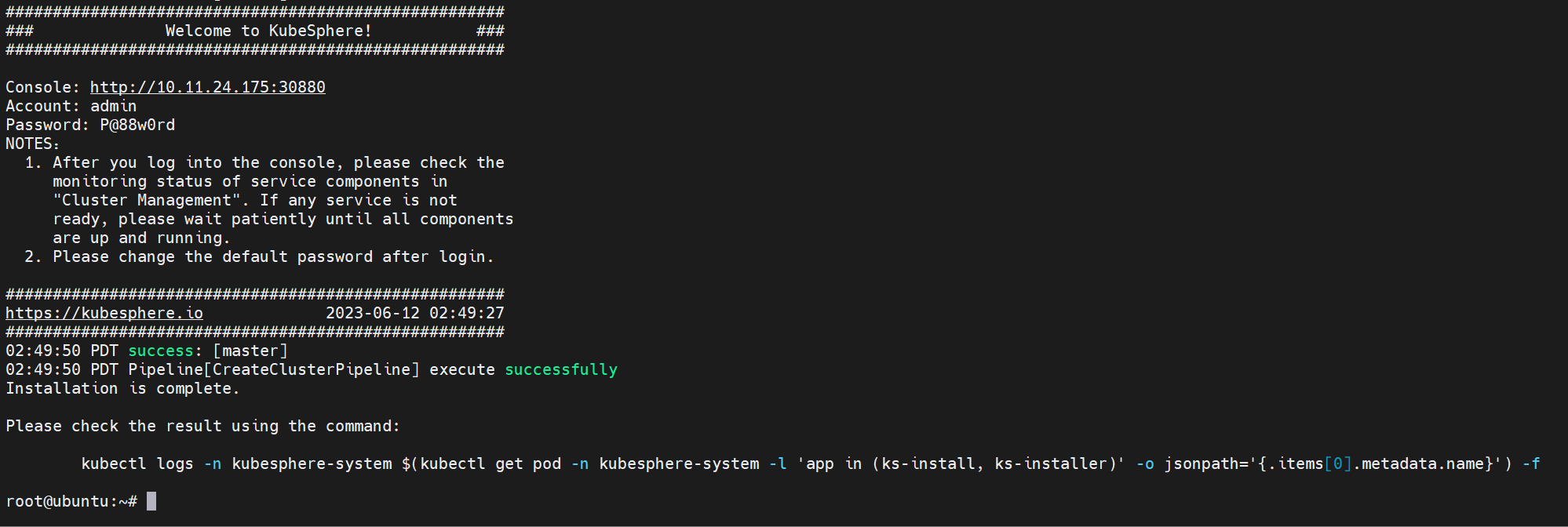

BuluAI算力平台现已上线,一键部署deepseek!告别等待!再也不用为算力发愁嘞,点击官网了解吧!新用户送50元算力金,快来体验吧!