声明

本账号中的所有内容仅供学习交流使用,不用于其他任何目的,不提供完整代码,抓包内容、敏感网址、数据接口等均已做脱敏处理,严禁,用于商业用途和非法用途,否则有此产生的一切后果均与作者无关!

scrapy

在使用scrapy前准备工作,首先在pycharm中运行

pip install scrapy

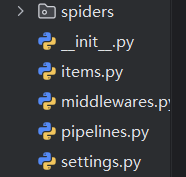

scrapy在使用时,和创建的py文件有所不同,正常我们直接创建运行就好,但是创建scrapy需要创建scrapy项目,需要运行以下代码

scrapy startproject 项目名

运行以后会得到以下文件

这些我不一一记录了,主要运用的文件是:spiders文件夹中定义的项目名,还有items,middlewares,pipelines,settings

scrapy组成

在具体讲解各个文件时,我们先来插入一下scrapy的构成,scrapy由五个组件构成:调度器,下载器,引擎,管道,爬虫。这五个组件,前三个我们不能修改,scrapy已经给我们全部构造好了,我们需要调整的是管道和爬虫组件。在具体使用时,这五个组件怎么互相交流呢?通过中间件,也就是项目中的middlewares,通过中间件我们可以对我们的请求进行代理,也可以对我们的相应进行加工。

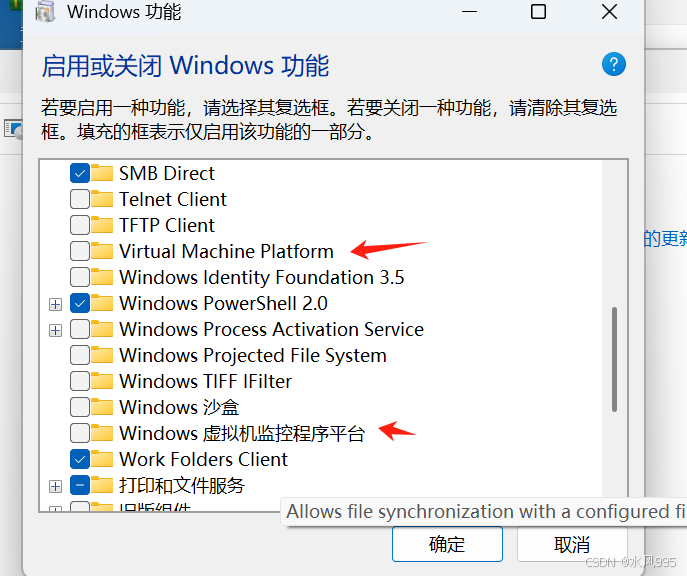

使用前的操作

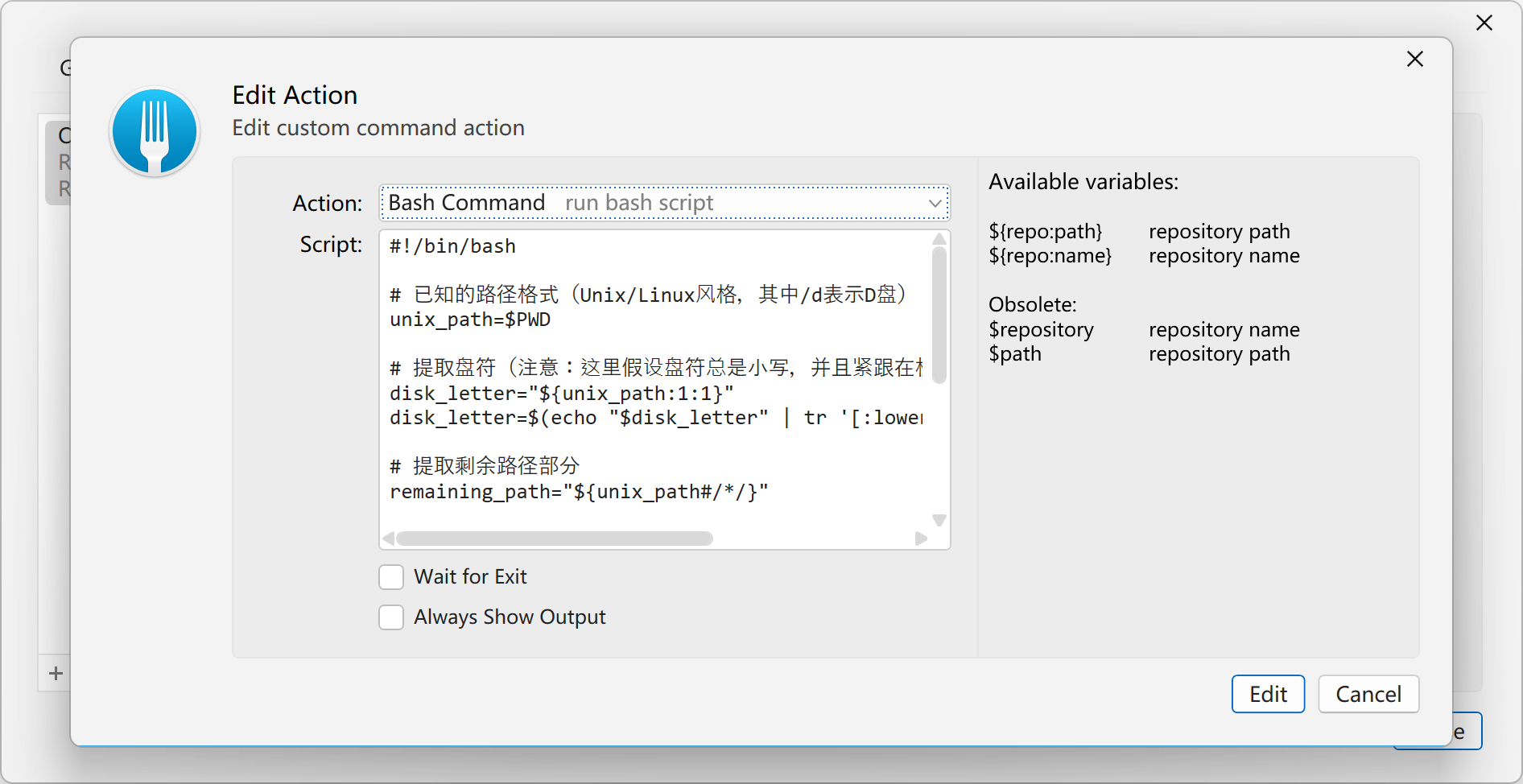

在使用时我们需要先调整settings,我们需要添加setting中的语句如下

LOG_LEVEL = 'ERROR' #设置日志

ROBOTSTXT_OBEY = True #设置是否遵守robots协议,默认遵守ITEM_PIPELINES = {"First.pipelines.FirstPipeline": 300,#开启管道,默认不开启,后面的数字代表管道优先级,越小越快执行

}DOWNLOADER_MIDDLEWARES = {"First.middlewares.FirstDownloaderMiddleware": 543,#开启中间件,默认不开启,后面数字同上

}

USER_AGENT = ""#user_agent需要自行设置

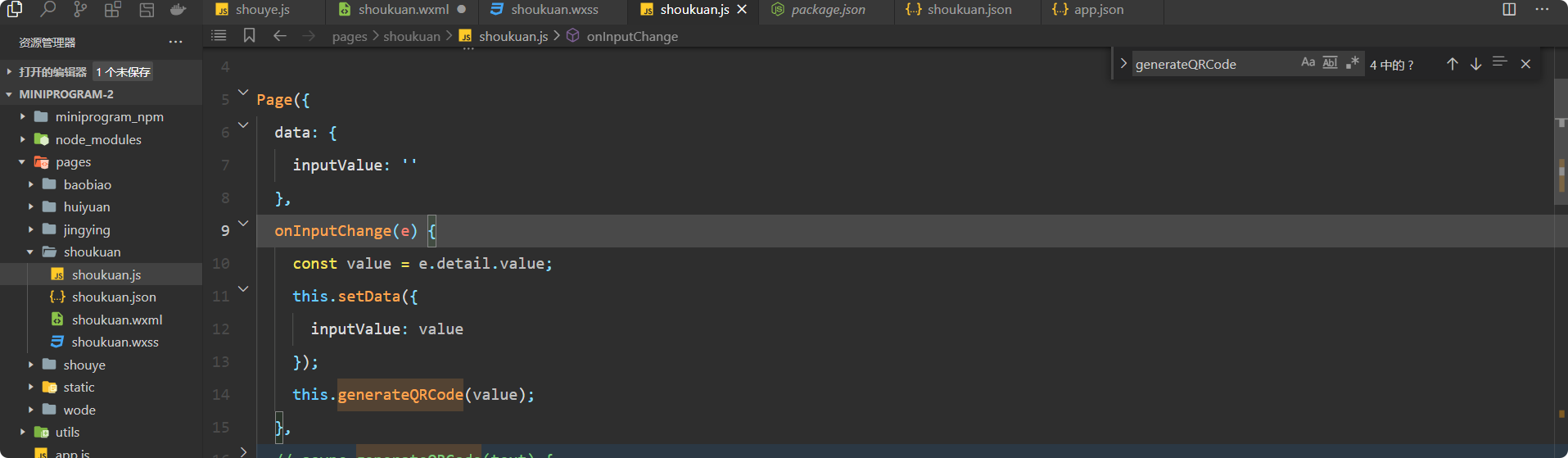

settings中我们差不多设置到这里,现在我们需要重新设置一下,spider文件

allowed_domains = ["www.baidu.com"] #默认域名,超出域名不做操作的,所以最好是备注掉

具体使用注意事项

在使用时,我们通常需要解析数据,下载数据。在spider中我们发现,有一个方法叫parse,在其中response我们可以解析我们获得的html,他会自动传的(具体例子不举了),还可以通过设置item传到管道里,由管道进行数据的持久化存储,管道设置也很简单,在items中添加东西即可,我们传到管道的内容必须是items,这是内置的。具体还有什么注意事项,我后续补充

再次声明

本文未经允许禁止转载,禁止任何修改后二次传播,擅自使用本文的讲解的技术而导致的任何意外,作者均不负责,若有侵权,请立刻联系我删除