目录

- DEEPSEEK

- 1 DeepSeek 深度优化混合专家模型

- 2 MLA 多头潜注意力

- 3 多令牌预测机制

- Deepseek的 MLA VS OpenapiI的 MHL

- 计算和存储优化方面

- 位置编码处理方面

- 模型性能和应用场景方面

- 参考资料

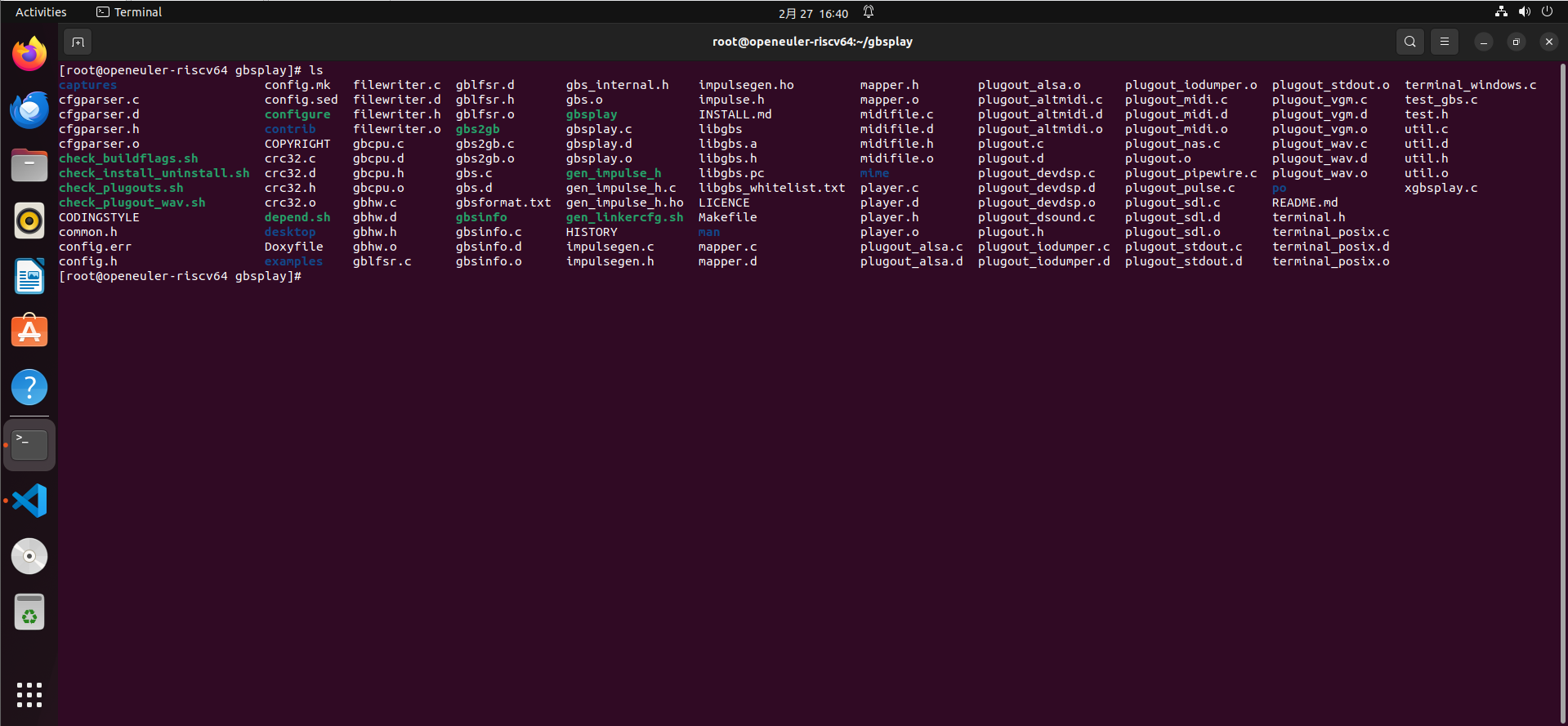

DEEPSEEK

3个创新

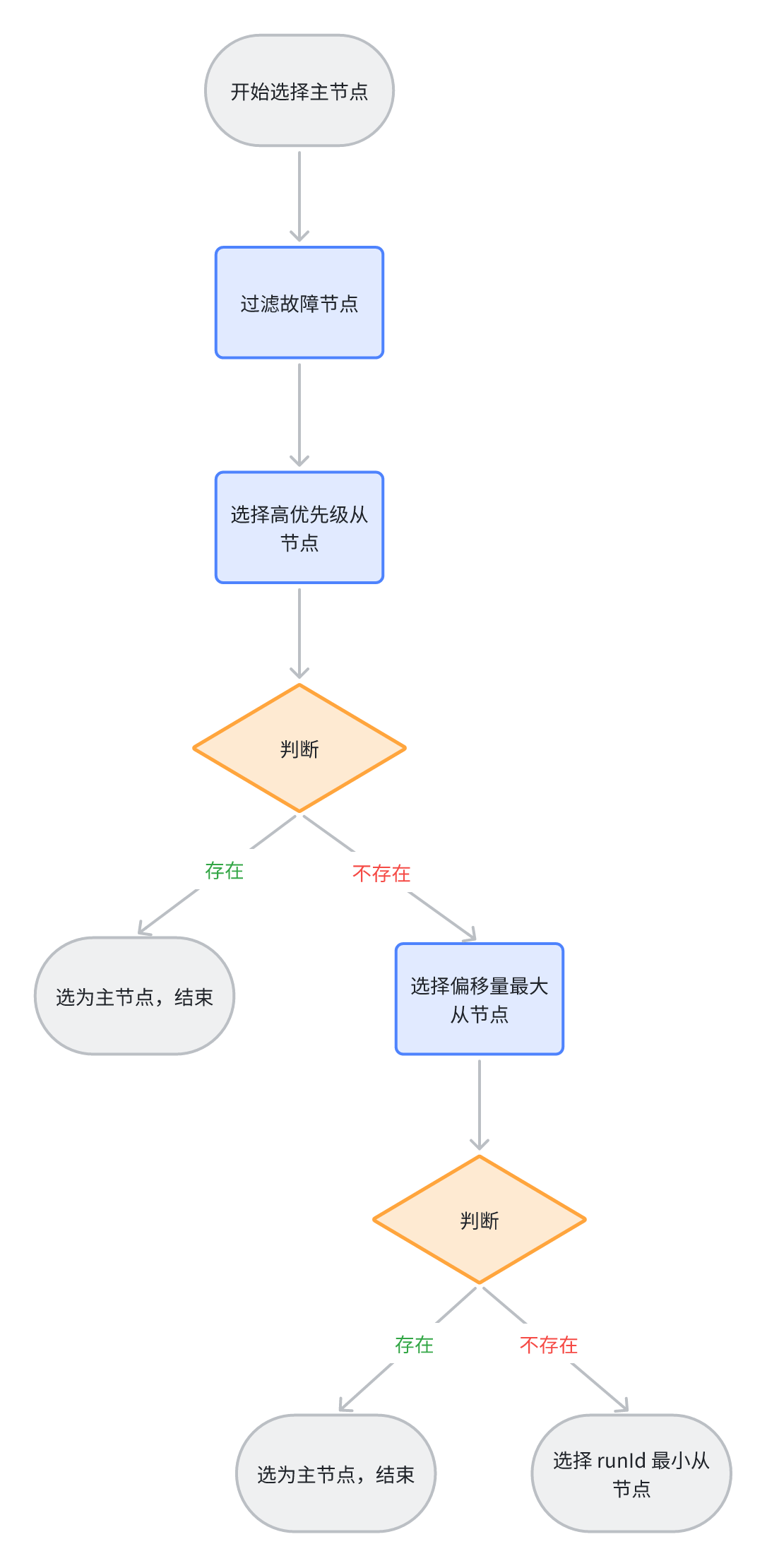

1 DeepSeek 深度优化混合专家模型

推理成本降低,速度变快,推理并发变多

6700亿参数,有100个专家组成。 1个专家消耗67亿 token

100个专家分组100个并发

2 MLA 多头潜注意力

提升预测的速度

3 多令牌预测机制

基于Transformer架构。原来Transformer基于next token,吞吐量不高。

改成多令牌预测机制,一个词,或句子往外OUTPUT

Deepseek的 MLA VS OpenapiI的 MHL

DeepSeek多头潜注意力机制(Multi-Head Latent Attention,MLA)和多头注意力机制(Multi-Head Attention,MHA)有以下区别:

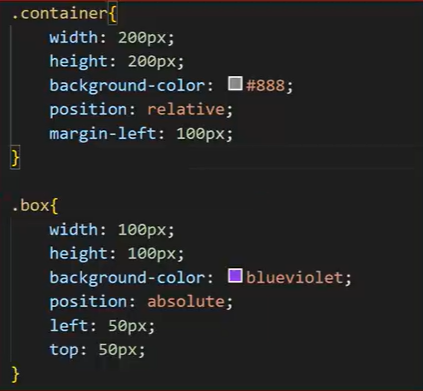

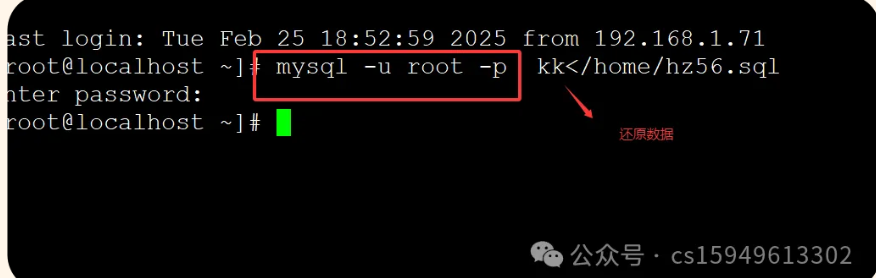

计算和存储优化方面

- MHA:计算复杂度与输入序列长度的平方成正比,每个头都需要独立存储查询(Query)、键(Key)和值(Value)矩阵,内存占用大,在处理长序列或大规模数据时,计算和存储成本会显著增加。

- MLA:通过对键(Key)和值(Value)进行低秩联合压缩,将它们投影到一个更小的压缩潜在向量,大大减少了推理过程中的键值缓存(KV Cache)。同时对查询(Query)也进行低秩压缩,减少训练时的激活存储需求,降低了计算成本。

位置编码处理方面

- MHA:传统的旋转位置编码(RoPE)在MHA中需要在每个注意力头的查询和键上分别执行旋转变换,计算量较大,且对于长序列输入,RoPE位置编码的结果存储在KV缓存中会使缓存大小随序列长度线性增长,占用大量GPU显存。

- MLA:采用解耦RoPE策略,额外引入“解耦查询”,拆分查询为普通查询和解耦查询,使得部分信息不受RoPE影响,并且共享Key的RoPE变换,减少计算量和KV缓存大小,降低GPU内存占用,提高推理速度,更适用于长序列任务和大规模Transformer。

模型性能和应用场景方面

- MHA:作为Transformer模型架构中的核心组件,能让模型在处理输入序列时关注到不同位置和不同表示子空间的信息,但存在特征冗余、模型解释性差、过拟合风险等问题,在推理效率上也有待提升,尤其是在长序列任务和资源受限场景中表现可能不佳。

- MLA:通过创新的KV缓存压缩和恢复机制,在减少资源消耗的同时,能够保持甚至提升模型性能,实现了在资源消耗、推理速度和模型性能之间的更好平衡,为大语言模型在长序列处理、高效部署和应用等方面提供了新的可能性,更适合对计算效率和内存占用要求较高的场景。