在Windows系统上安装Ollama并运行DeepSeek R1模型,同时结合Page Assist浏览器插件实现本地使用,可以按照以下步骤操作:

一、安装Ollama

下载Ollama:

访问Ollama官方网站,下载适用于Windows的版本。

安装路径默认在c盘

创建符号链接

原路径:

C:\Users\18368\.ollama

目标路径:

D:\Project\AI Project\.ollama

创建目标路径将原路径内容剪切至目标路径,然后删除原路径创建链接

New-Item -ItemType SymbolicLink -Path "C:\Users\18368\.ollama" -Target "D:\Project\AI Project\.ollama"

原路径:

C:\Users\18368\AppData\Local\Programs\Ollama

目标路径:

D:\Project\AI Project\Ollama

New-Item -ItemType SymbolicLink -Path "C:\Users\18368\AppData\Local\Programs\Ollama" -Target "D:\Project\AI Project\Ollama"

更改Ollama安装位置

Ollama默认安装在用户目录下(例如:C:\Users\<用户名>\AppData\Local\Programs\Ollama),但可以通过安装程序的参数更改安装位置。

步骤:

-

下载Ollama安装程序(

OllamaSetup.exe)。 -

使用命令行启动安装程序,并指定安装路径。例如:

-

OllamaSetup.exe /DIR="D:\Ollama" -

将Ollama安装到D盘的

Ollama文件夹。

更改模型存储位置

Ollama的模型默认存储在C:\Users\<用户名>\.ollama\models,可以通过设置环境变量OLLAMA_MODELS来更改模型存储位置。

步骤:

- 打开“此电脑”或“计算机”属性,选择“高级系统设置”。

- 在“系统属性”窗口中,点击“环境变量”。

- 在“系统变量”或“用户变量”中点击“新建”,添加以下环境变量:

- 变量名:

OLLAMA_MODELS - 变量值:目标路径,例如

D:\AIModels\Ollama。

- 变量名:

- 如果之前已下载模型,可以将

C:\Users\<用户名>\.ollama\models中的内容剪切到新路径。 - 重启Ollama以使更改生效。

配置环境变量(可选):

- 如果需要更改模型的存储路径(例如避免占用C盘空间),可以设置环境变量

OLLAMA_MODELS,例如:

OLLAMA_MODELS=E:\ai\ollama\models

- 如果使用多GPU,可以设置

CUDA_VISIBLE_DEVICES环境变量。

二、下载并运行DeepSeek R1模型

获取模型:

- 打开Ollama的模型库页面,找到DeepSeek R1模型。

- 根据需要选择模型版本(如

deepseek-r1:7b或deepseek-r1:1.5b),并复制对应的运行命令。

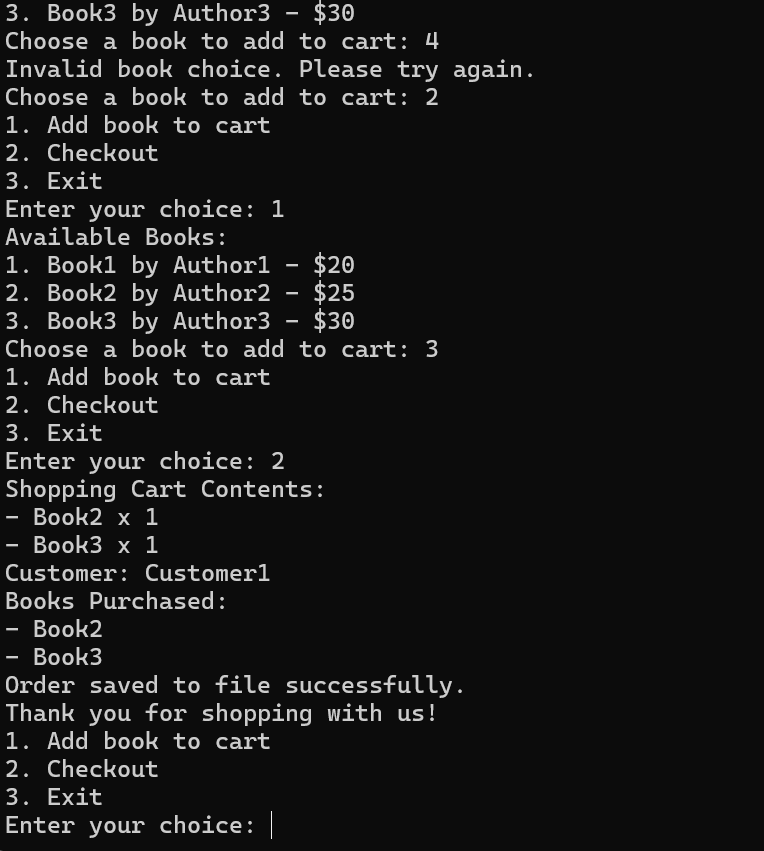

运行模型:

打开命令提示符,以管理员身份运行以下命令:

ollama run deepseek-r1:7b

等待模型下载和加载完成。

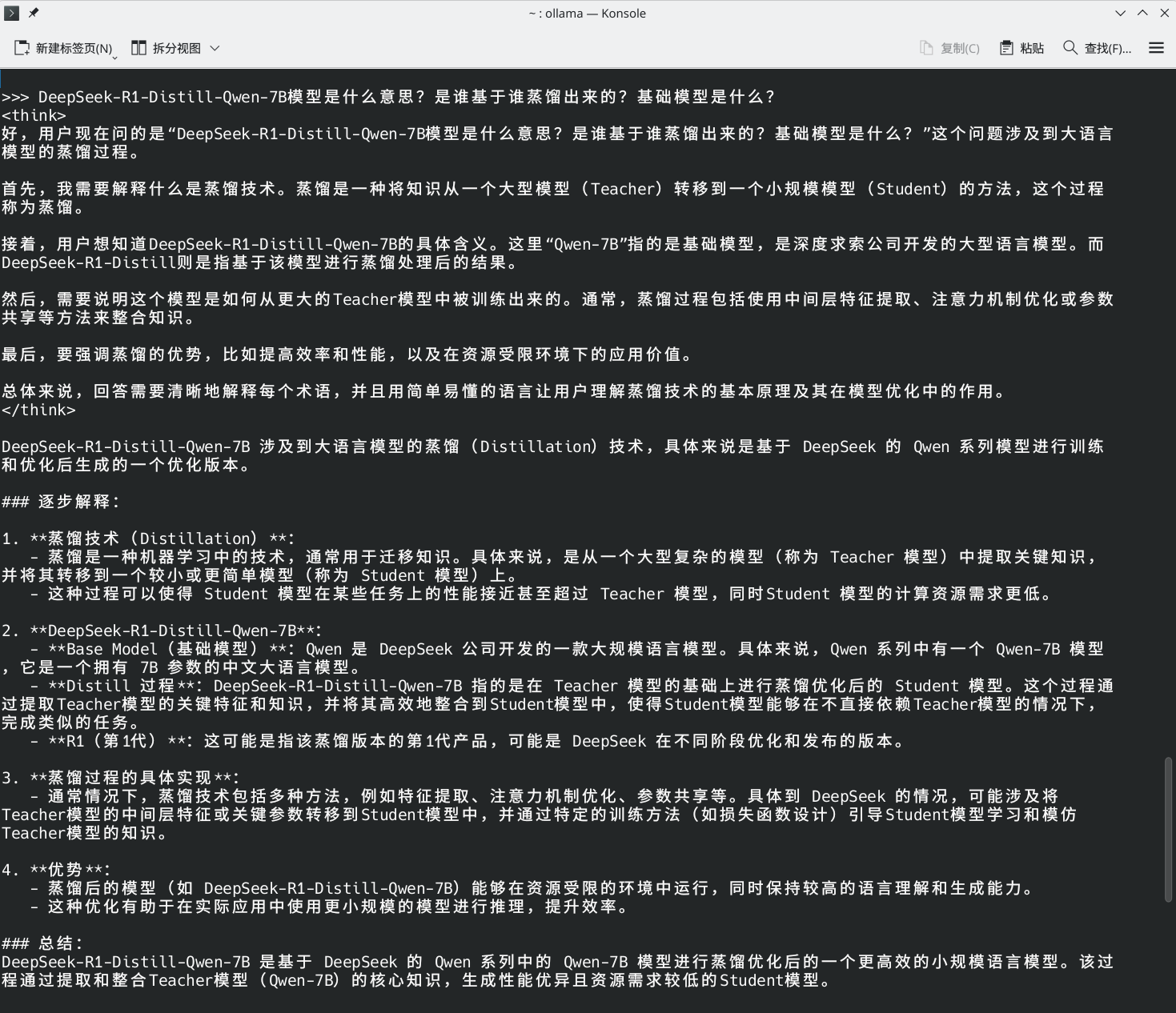

验证模型:

在终端中输入一些问题(如“请用Python写一个快速排序算法”),检查模型是否能正常响应。

三、安装Page Assist浏览器插件

安装插件:

打开Chrome浏览器,进入Chrome Web Store,搜索并安装Page Assist插件。

如果无法访问Chrome商店,可以下载.crx文件,并通过浏览器的扩展程序页面手动安装。

配置插件:

-

安装完成后,打开Page Assist插件。

-

在设置中选择Ollama作为本地AI模型的提供商,并配置API地址为

http://localhost:11434。

使用插件:

1. 在Page Assist的界面中选择DeepSeek R1模型。2. 可以通过输入框与模型进行交互,支持联网搜索、对话历史记录等功能。

完成!