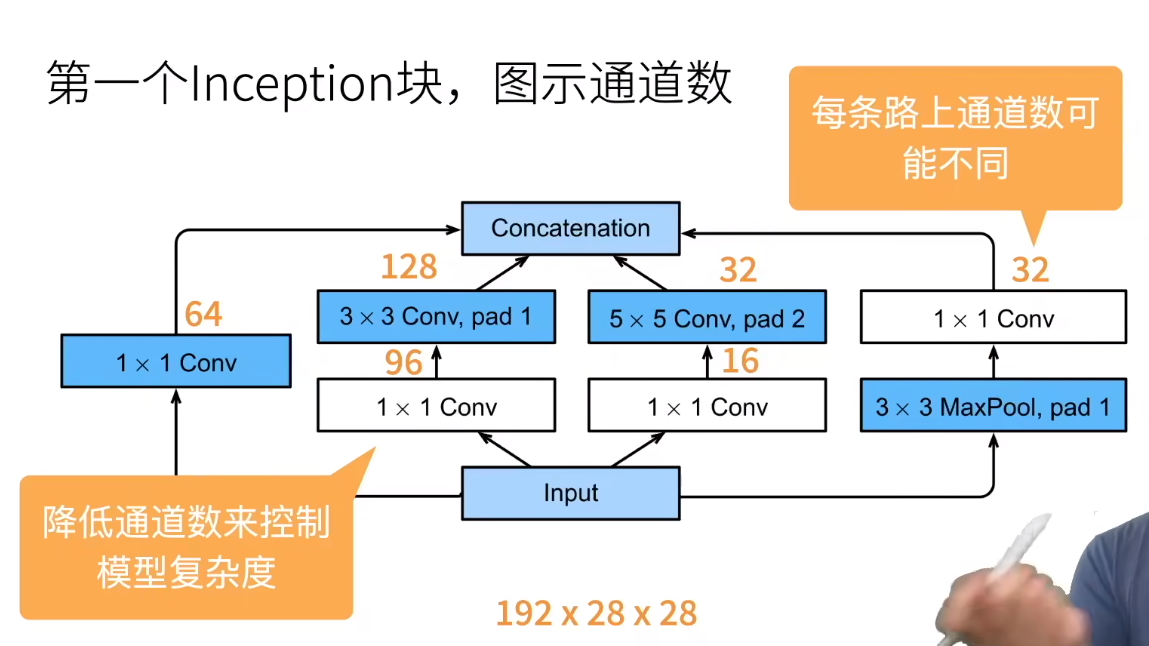

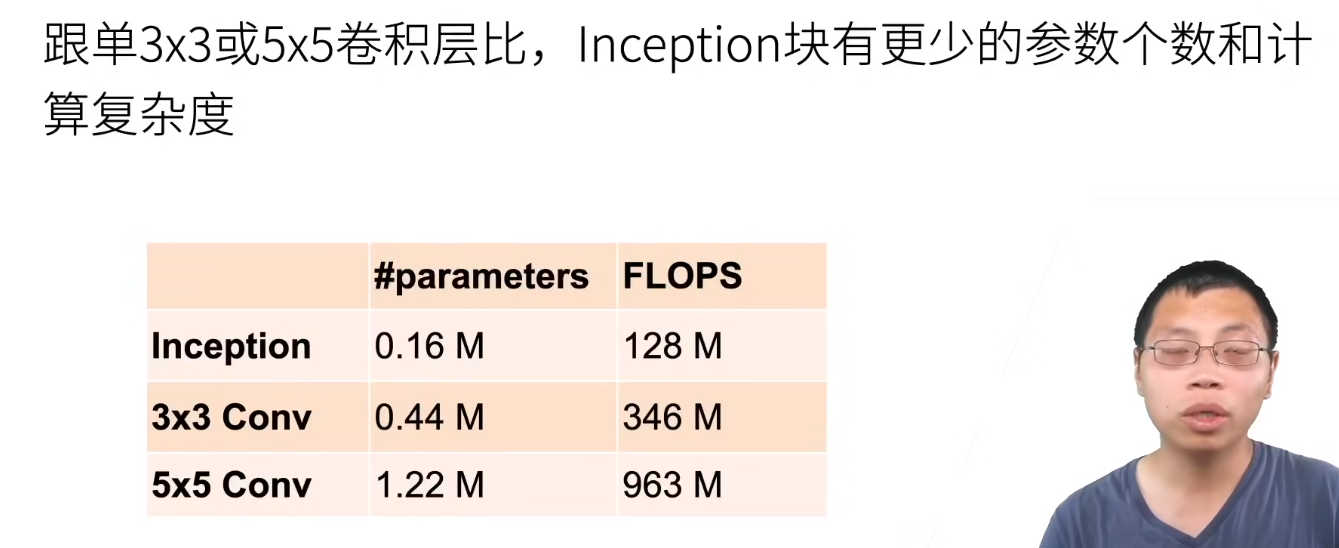

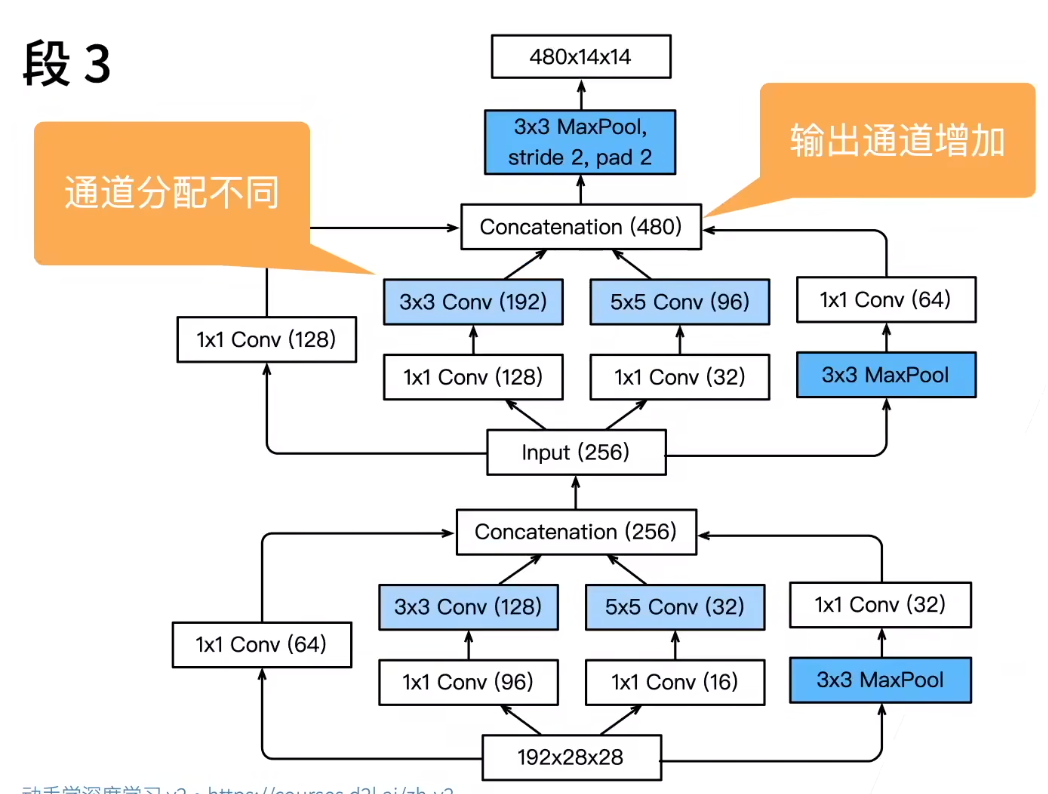

白色的\(1\times 1\)卷积层是用来降低通道数的,蓝色的卷积层是用来学习特征的

大致解释一下这些数字是怎么分配的。现在我们的通道数是\(192\),于是我们假设最后输出的通道数是\(256\);考虑这些通道如何分配:我们知道\(3\times 3\)的卷积层性质很好(参数不算太多,学习能力也比较强),所以分配一半的通道;剩下的通道的一半在分配给\(1\times 1\)卷积,也就是不看空间信息,只看像素信息;再剩下的通道数对半分即可。实际上这些参数都是调出来的

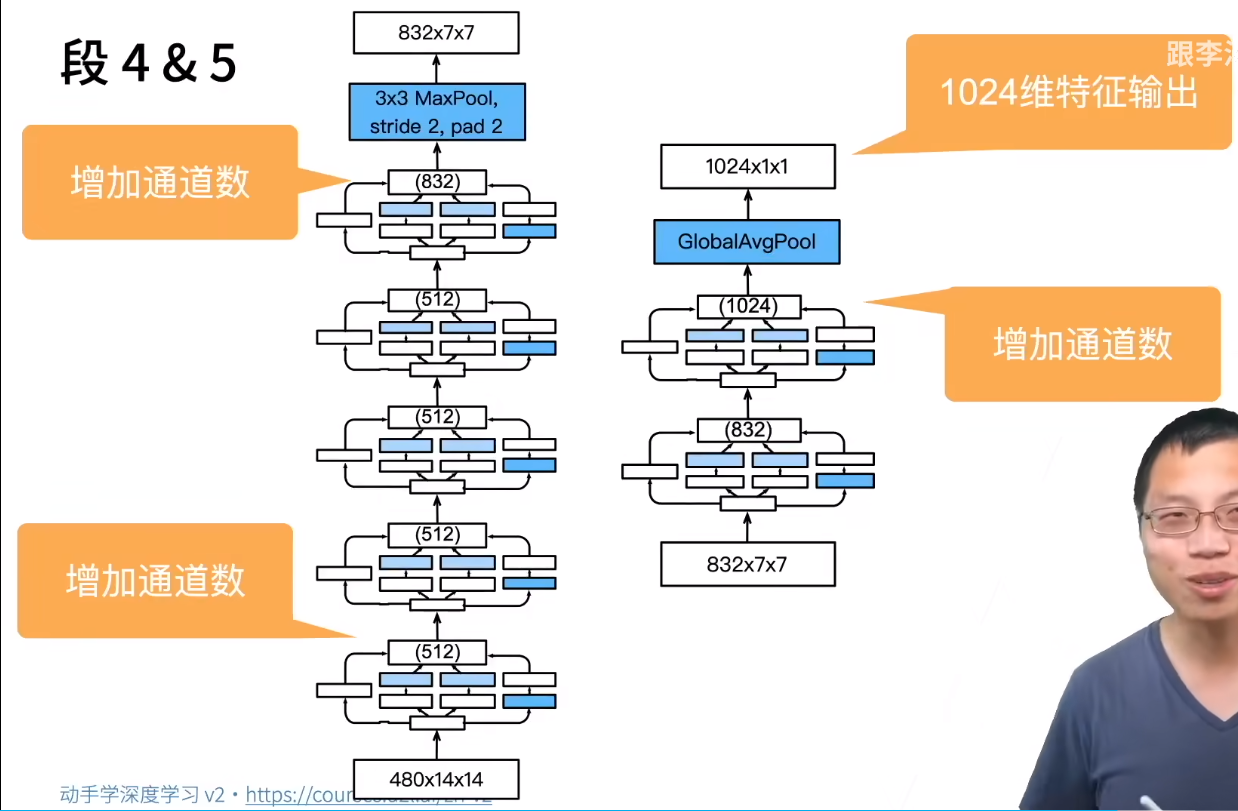

接下来仔细看一下各层的设计

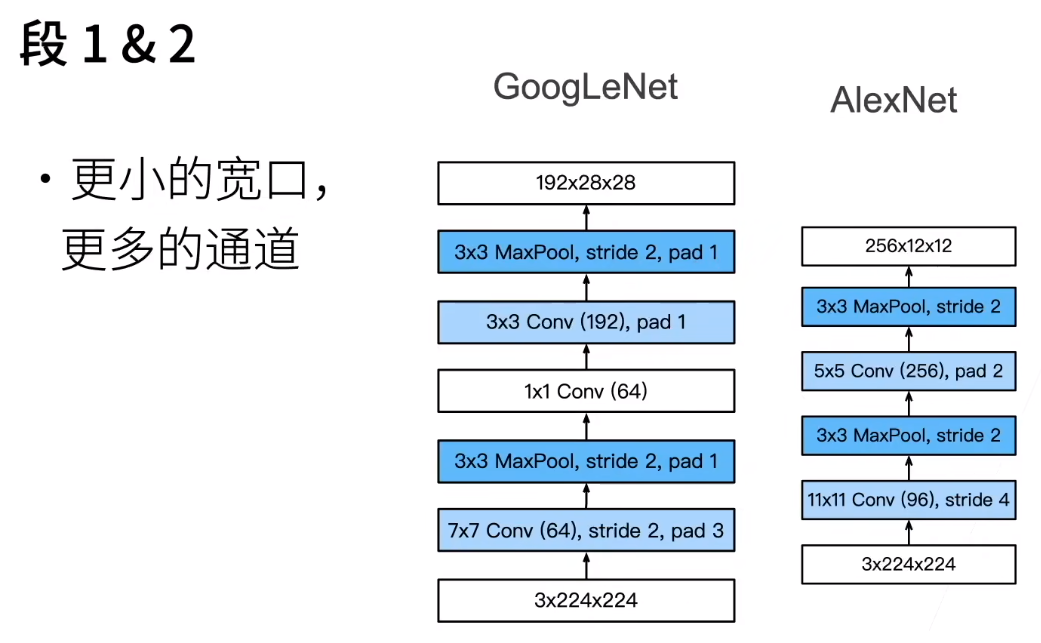

可以看出,GoogleNet没有Alexnet这么狠,降低宽高的过程更缓慢。复习一下为什么要降低宽高增加通道数:降低宽高是为了降低复杂度,增加通道数是为了学习更多特征

可以看出,超参数之间是总结不出什么规律的。所以上面的设计思路是大概的,真正的参数都是调出来的

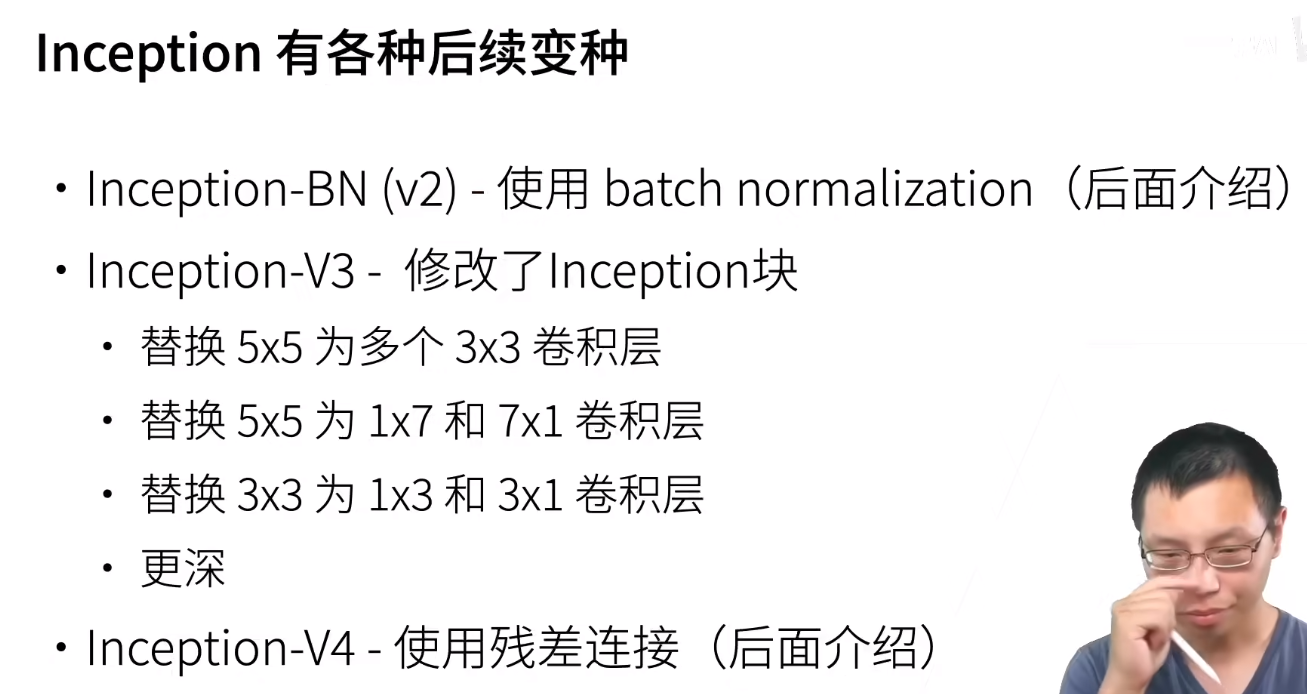

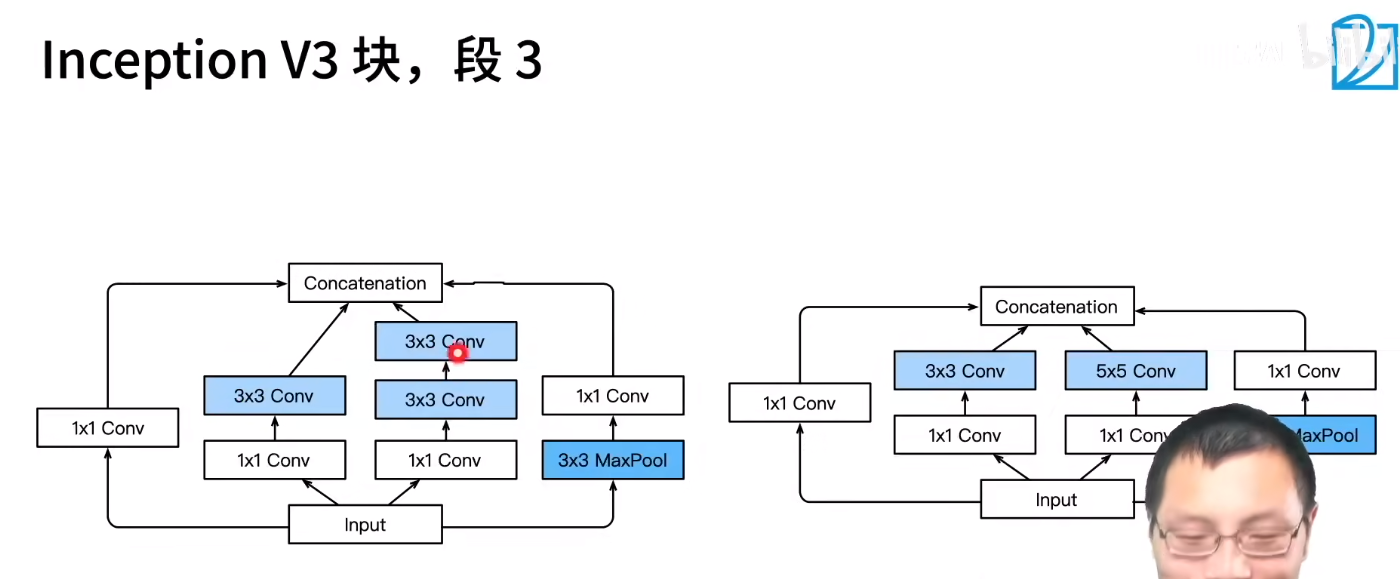

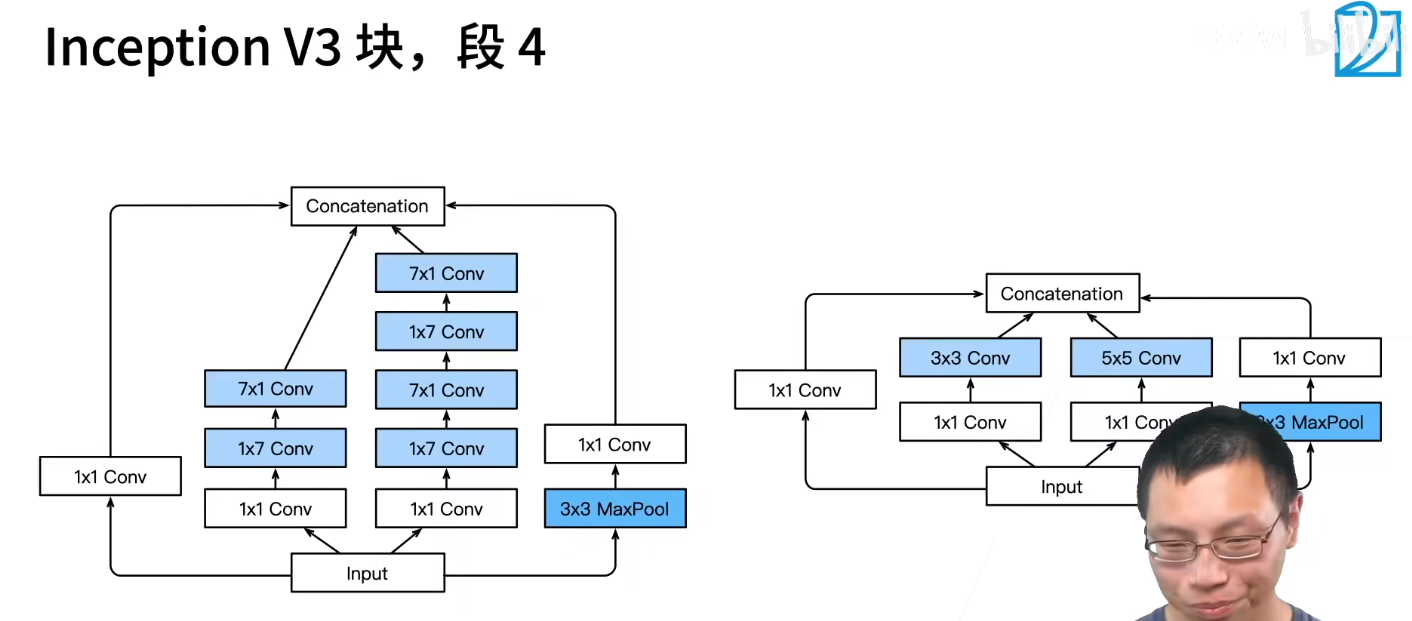

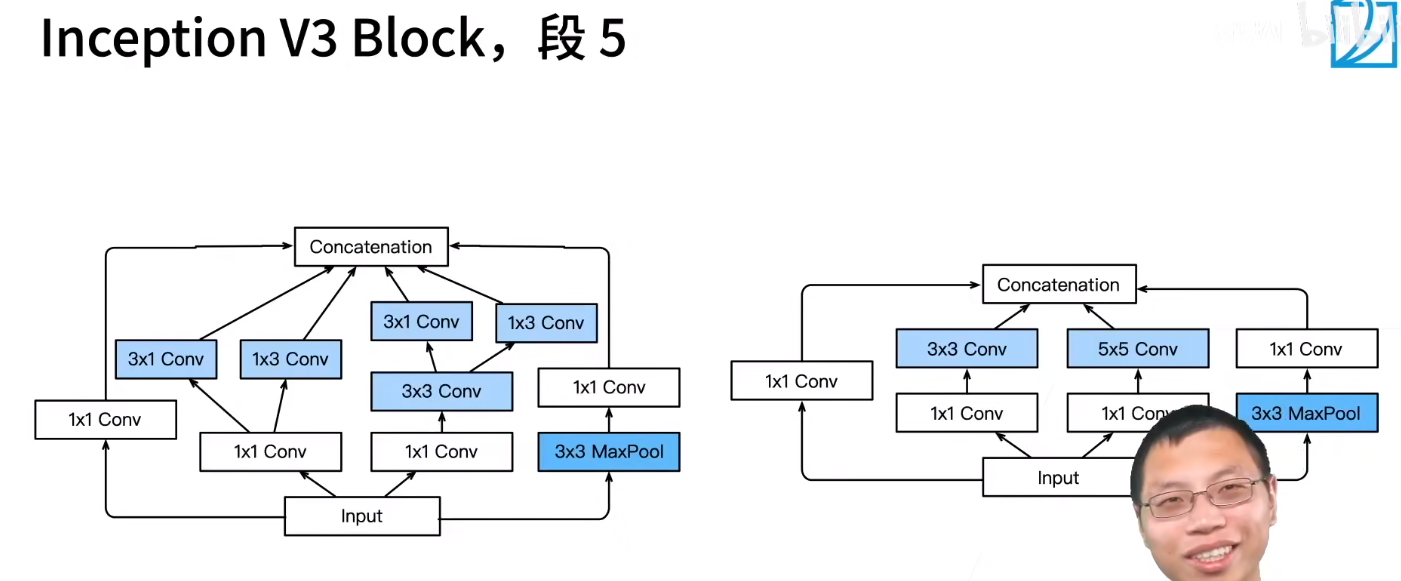

V3用的挺多的。中间两种修改的思想就是我先看行信息不看列信息,再看列信息不看行信息

左边是V3,右边是原始的

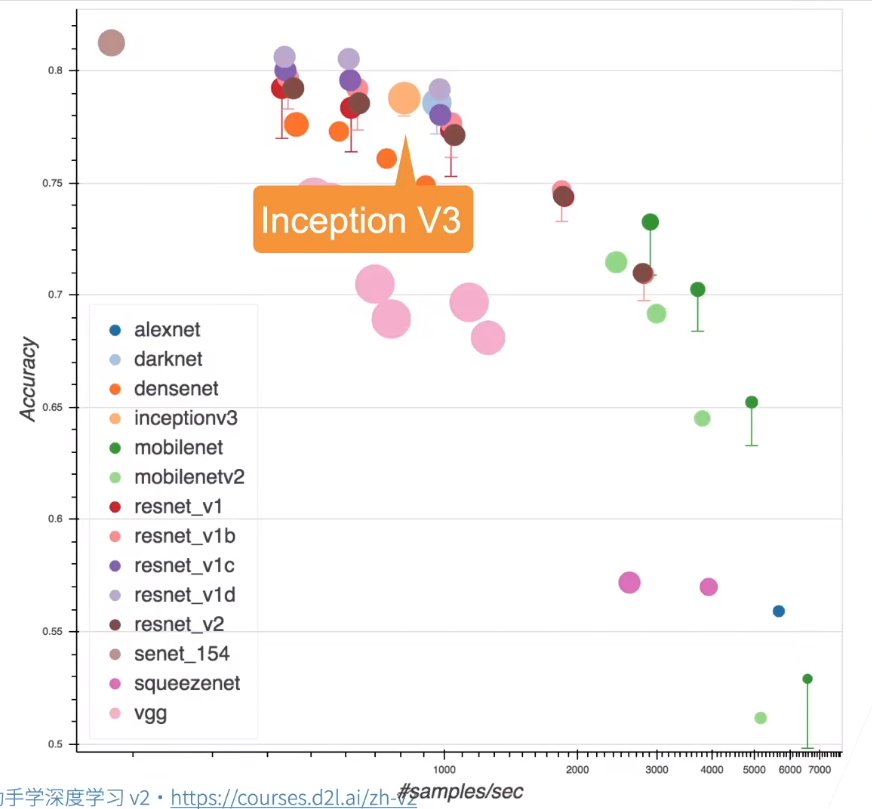

效果见下

提醒一下,圆的大小代表内存占用大小

注意这里上百层不是指深度,而是指块

GoogleNet的问题就是太复杂了

7.4.1 Inception 块

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.hqwc.cn/news/890888.html

如若内容造成侵权/违法违规/事实不符,请联系编程知识网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

Windows安装ollama运行deep seek R1模型+Page Assist浏览器插件本地使用

在Windows系统上安装Ollama并运行DeepSeek R1模型,同时结合Page Assist浏览器插件实现本地使用,可以按照以下步骤操作:

一、安装Ollama

下载Ollama:

访问Ollama官方网站,下载适用于Windows的版本。安装路径默认在c盘创建符号链接

原路径:C:\Users\18368\.ollama目标路径:…

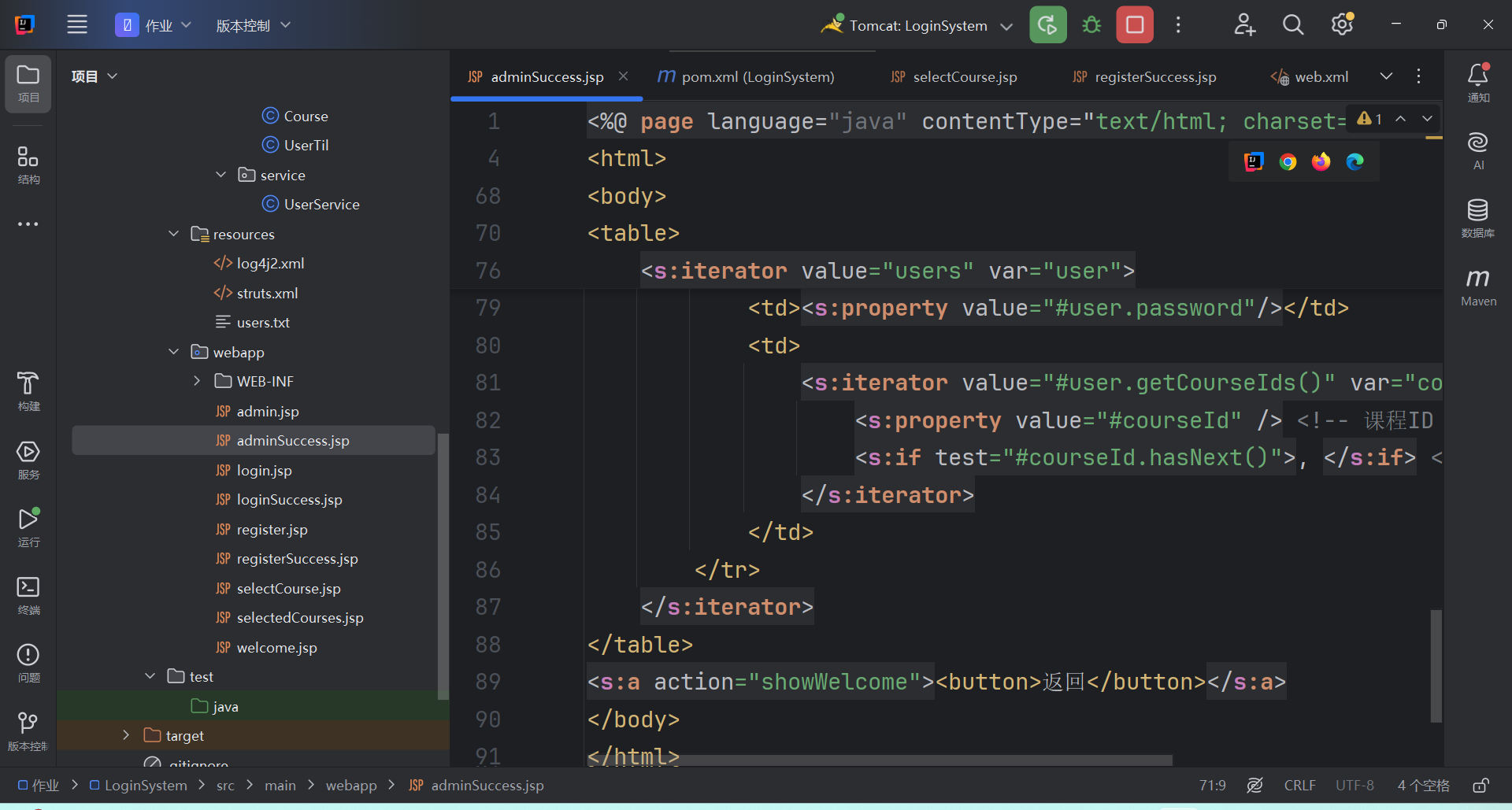

上海海洋大学软件开发与创新课程设计作业

我给上学期其他同学的大作业添加了一些功能,已有的功能只有用户注册并填写账号密码,然后点击登录按钮成功登录

现在添加的新功能如下:

1,添加了一个真正可以选课的页面,添加了一些课程选项

2,可以存储用户选课的历史和方案

3,添加了一个管理员页面用于查看用户账号密码以…

Qwen2.5-0.5B siglip 预训练 / 微调实验

前言视频 | 仓库跟着教程做的,记录学习过程。

环境双卡 3090 24G

CUDA 12.2

transformers 4.49概述

通过在 Qwen2.5-0.5B 和 siglip 之间训练一个中间层构造 VLM。作者提到首次微调时,只冻结了视觉模型的参数,导致阶梯状的 loss 曲线,即发生过拟合。应冻结文本和视觉模型的…

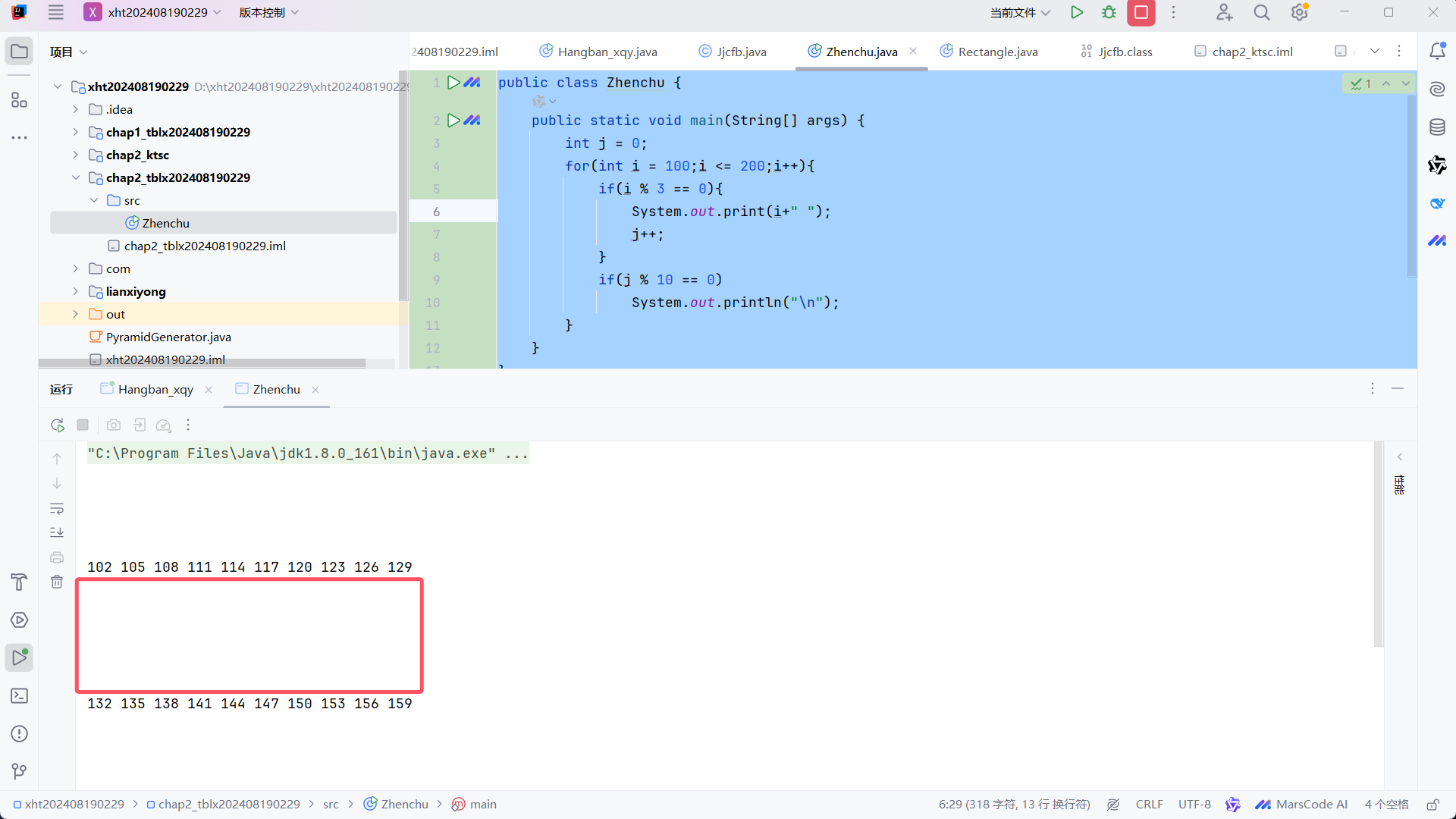

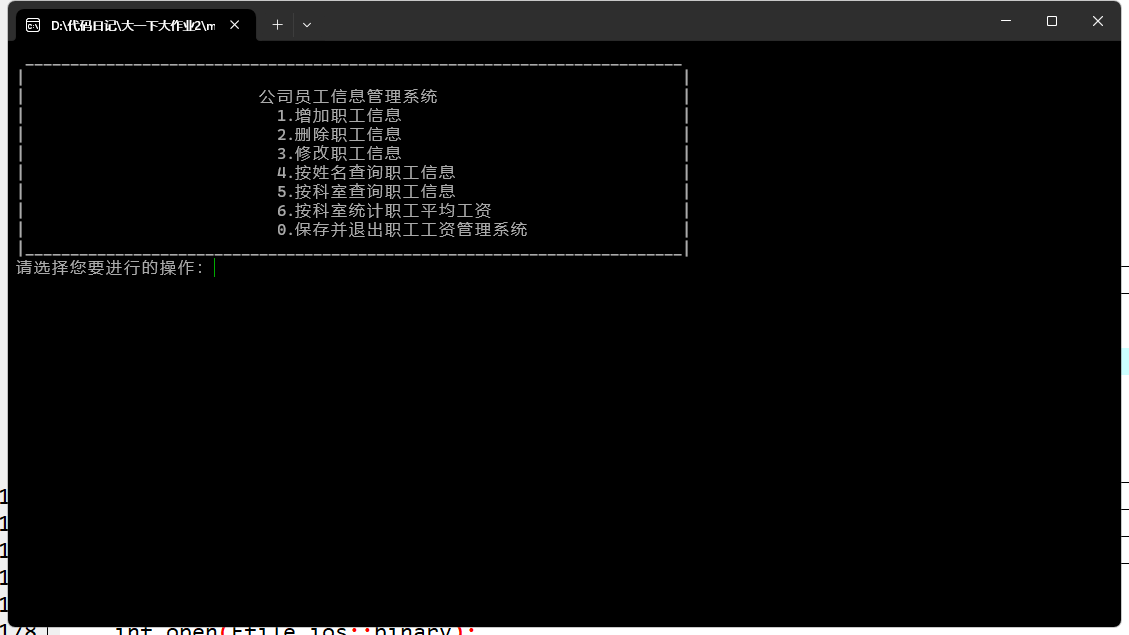

优化职工信息系统文件读写错误

该系统取自于大一时期的一个同班同学的期末大作业,该职工信息系统分别实现了职工信息的增删改查,以及计算职工的总工资和平均工资等功能。但是在编写了该系统之后,出现了一些问题,其中一个文件读写的问题我觉得需要进行改进,这个代码不能自己创建文本文档在指定的文件夹,…

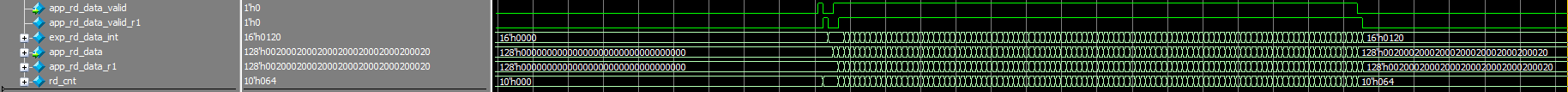

PL端DDR4的MIG IP核配置及example design分析(个人记录)

第一种配置方法如下。按最高2666MHz配置,这边输入的参考时钟看个人板卡情况,我这边输入是200MHz。第二种配置方法如下。按2400MHz配置(需要换芯片型号),这边输入的参考时钟看个人板卡情况,我这边输入是200MHz。这边是输入时钟设置及输出时钟设置。我这边输入是差分时钟,…

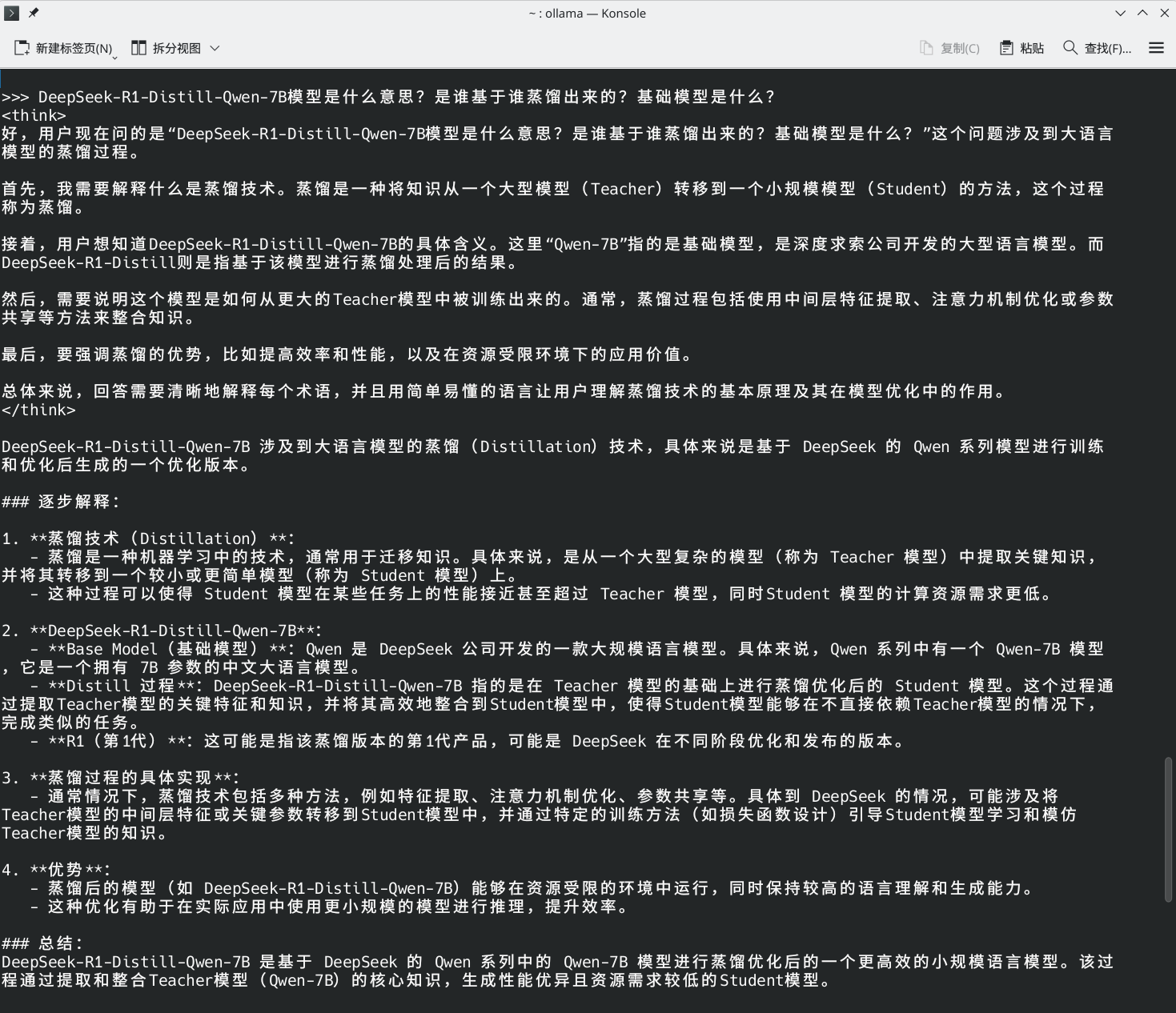

Linux上部署deepseek-r1:7b模型

通过ollama在debian上安装部署deepseek-r1:7b模型。一、安装ollama框架

访问 ollama 官网,点击下载,选择 Linux,复制安装命令执行即可。二、下载并运行模型

选择 deepseek:7b 模型,复制安装命令执行即可。

(这里的模型参数大小,可根据自己的显存大小选择,可简单安装 0.5b…

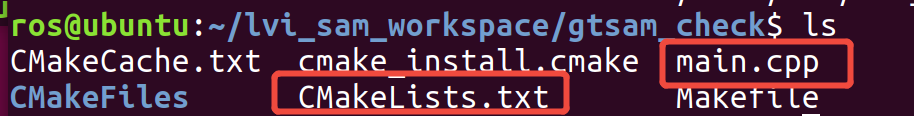

LVI_SAM虚拟机安装复现(二)

0. 前言

前一篇文章里面,已经完成了 Ubuntu 18.04 和 ROS Melodic 的安装。

还没有安装好的读者,可以回去看这一篇文章。

前情概要:

LVI_SAM虚拟机安装复现(一)

本文主要记录了GTSAM源码编译安装过程中经历的坑

警告:并非从零开始零基础教你安装 GTSAM 哦

GTSAM是一个开源…

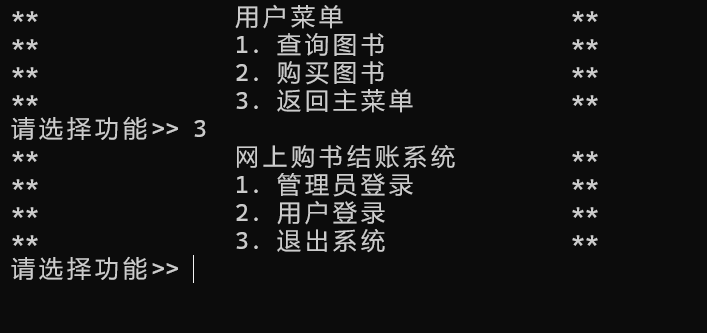

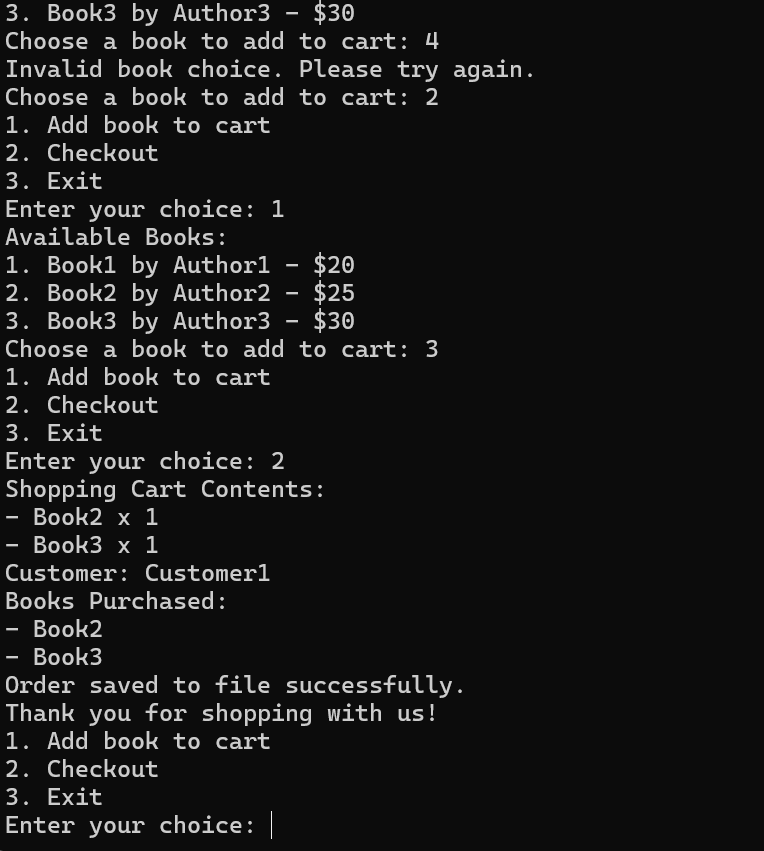

逆向软件设计—网上购书结账系统

一、作业要求找一个已有的项目(同学、高年级同学、网络下载),阅读分析,找出软件尚存的缺陷, 改进其软件做二次开发,并将这个过程整理成一份博客。

二、原项目介绍

本次课程设计我逆向开发的软件是一个使用c++编写的网上购书结账系统,原作者是22软工2班的熊知宇学长,学号…

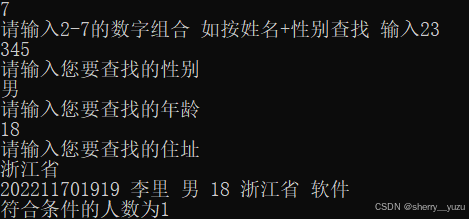

学生管理系统二次开发与优化实践

在软件开发中,对现有项目进行优化和二次开发是一种常见的任务。本次实验中,我选择了一个基于C++开发的学生管理系统作为优化对象。该系统实现了学生信息的增删改查功能,并支持学号排序和模糊查找等功能。通过分析原项目,我发现了几个可以改进的地方,并对系统进行了优化。以…

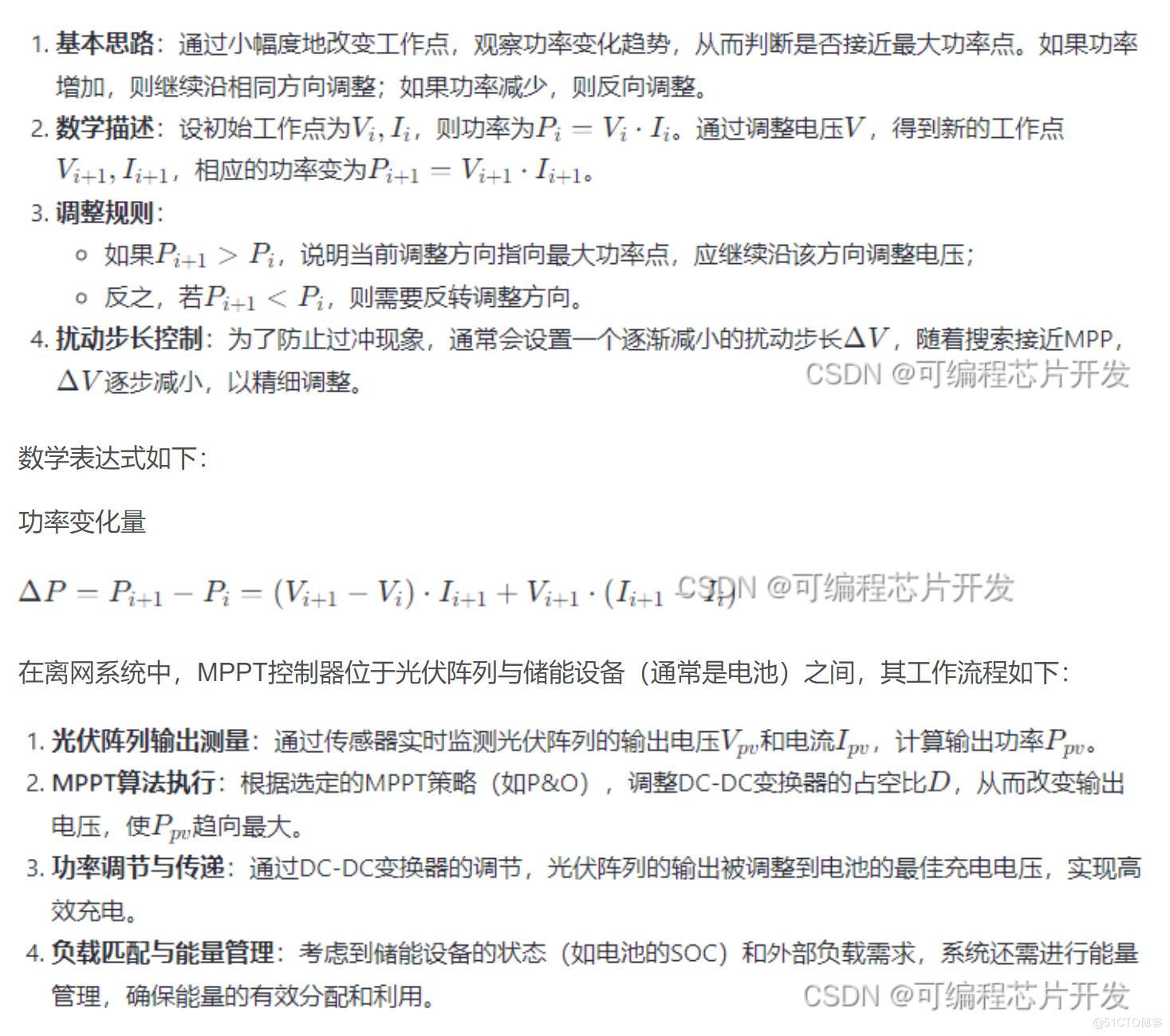

基于MPPT最大功率跟踪的离网光伏发电系统Simulink建模与仿真

1.课题概述

基于MPPT最大功率跟踪的离网光伏发电系统Simulink建模与仿真。2.系统仿真结果

(完整程序运行后无水印)3.核心程序与模型

版本:MATLAB2022a4.系统原理简介基于最大功率点跟踪(Maximum Power Point Tracking, MPPT)的离网光伏发电系统是利用太阳光直接转换为电能…