这方面的研究专家,参考西安交通大学的

孟德宇老师

他最近的研究方向:

Fundamental problems in machine learning and computer vision, especially including:

Meta-learning

Variational bayesian methods on inverse problems

Robust and interpretable deep learning

1.1 课程学习

参考阅读

http://huangc.top/2021/06/13/Curriculum-Learning-2021/

1.2 Self-paced curriculum learning

https://ojs.aaai.org/index.php/AAAI/article/view/9608;

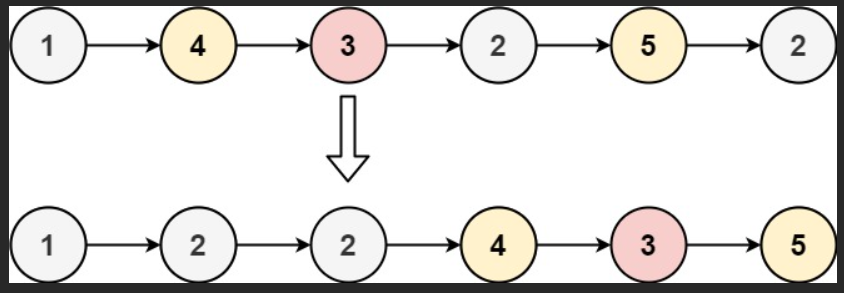

课程学习(CL)或自定进度学习(SPL)代表了最近提出的一种学习制度,其灵感来自人类和动物的学习过程,在训练中逐渐从简单到更复杂的样本。这两种方法具有相似的概念学习范式,但具体的学习方案不同。

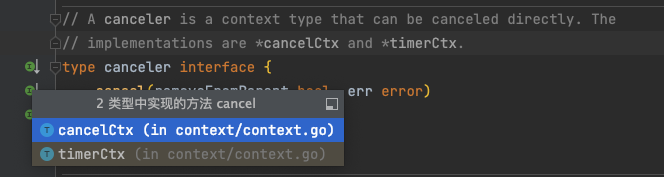

在CL中,课程由先验知识预先确定,此后保持固定。因此,这种方法在很大程度上依赖于先验知识的质量,而忽略了对学习者的反馈。在SPL中,课程是动态确定的,以适应精益者的学习速度。然而,SPL无法处理先验知识,使其容易过度拟合。

在本文中,我们发现了CL和SPL之间缺失的联系,并提出了一个名为自定进度课程倾斜(SPCL)的统一框架。SPCL被表述为一个简洁的优化问题,它既考虑了训练前已知的先验知识,也考虑了训练期间的学习进度。与人类教育相比,SPCL类似于“讲师-学生-协作”学习模式,而不是CL中的“讲师驱动”或SPL中的“学生驱动”。根据经验,我们证明了SPCL在两个任务上的优势

1.3 两者的关联

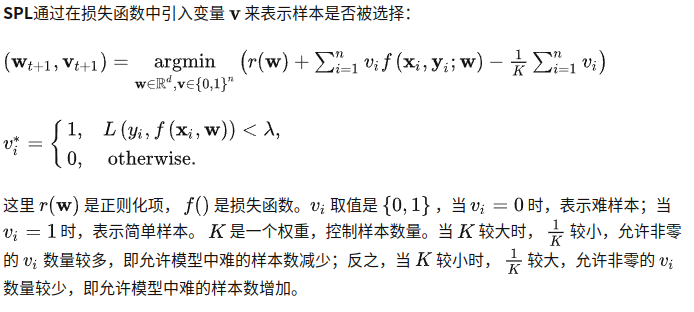

自步学习(Self-Paced Learning,SPL)就是按照自己设定的步伐进行学习。本文在09年Bengio提出的课程学习(Curriculum Learning,CL)的基础上进行改进。CL受到人类认知过程启发——人在学习的时候一般先学习简单的,然后再循序渐进到学习相对难的部分。但Bengio提出的CL是根据某种固定先验,将样本难易程度排好序之后再输入到模型中。而SPL与CL最大的不同之处在于样本调度可直接嵌入到模型,是动态且可优化的过程。

文章链接:Self-Paced Learning for Latent Variable Models NIPS 2010

作者单位:斯坦福大学 计算机学院

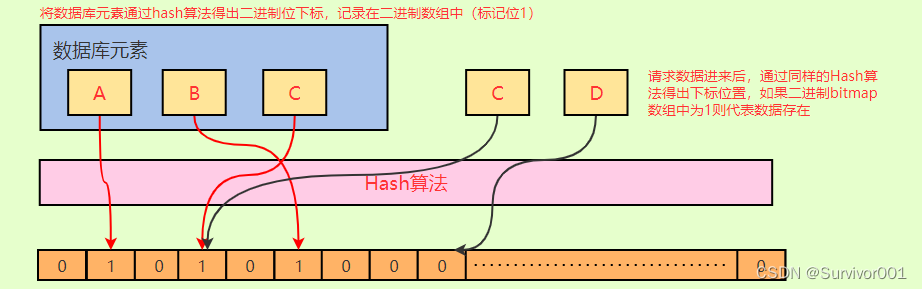

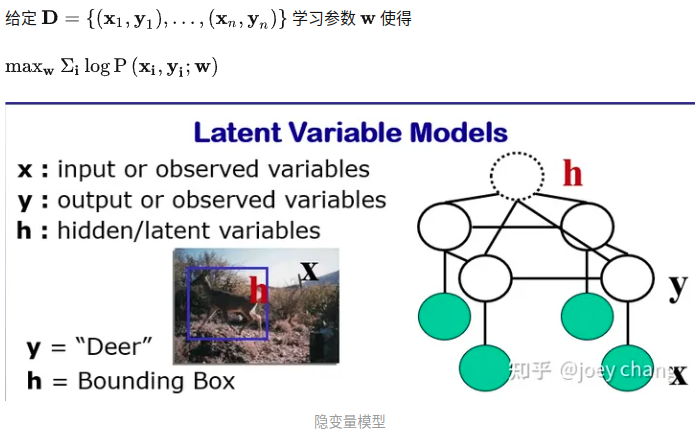

基本思路是利用损失大小与难易程度之间的对偶关系进行对所学样本的加权。这种加权格式类似于引入隐含变量后的EM算法,使得模型对于数据分布的学习更加稳健。

孟老师相关文章

SPaR: Lu Jiang, Deyu Meng, Qian Zhao, Shiguang Shan, Alexander Hauptmann. Self-pacedCurriculum Learning. AAAI, 2015.

SPMF: Qian Zhao, Deyu Meng, Lu Jiang, Qi Xie, Zongben Xu, Alexander Hauptmann.Self-paced Matrix Factorization. ACM MM, 2014.

SPLD: Lu Jiang, Deyu Meng, Shoou-I Yu, Zhen-Zhong Lan, Shiguang Shan, AlexanderHauptmann. Self-paced Learning with Diversity. NIPS, 2014.

SPCL: Lu Jiang, Deyu Meng, Teruko Mitamura, Alexander Hauptmann. Easy Samples First:Self-paced Reranking for Zero-Example Multimedia Search. AAAI. 2015.