Python连接Hive

- 1、Python如何连接Hive?

- 2、Python连接Hive数据仓库

1、Python如何连接Hive?

Python连接Hive需要使用Impala查询引擎

由于Hadoop集群节点间使用RPC通信,所以需要配置Thrift依赖环境

Thrift是一个轻量级、跨语言的RPC框架,主要用于服务间的RPC通信。由Facebook于2007年开发,2008年进入Apache开源项目

sasl模块是Python中用于实现SASL(Simple Authentication and Security Layer)认证的第三方库,提供了对各种SASL机制的支持,例如与Kafka、Hadoop等进行安全通信

经过验证,以下模块都是Python连接Hive的环境依赖:

pip install bitarray

pip install bit_array

pip install thrift

pip install thriftpy

pip install pure_sasl

pip install --no-deps thrift-sasl==0.2.1

安装Impyla模块:

pip install impyla

如果安装Impyla报错:

ERROR: Failed building wheel for impyla

则需要下载对应的whl文件安装:

Python扩展包whl文件下载:https://www.lfd.uci.edu/~gohlke/pythonlibs/

Ctrl+F查找需要的whl文件,点击下载对应版本

安装:

pip install whl文件绝对路径

2、Python连接Hive数据仓库

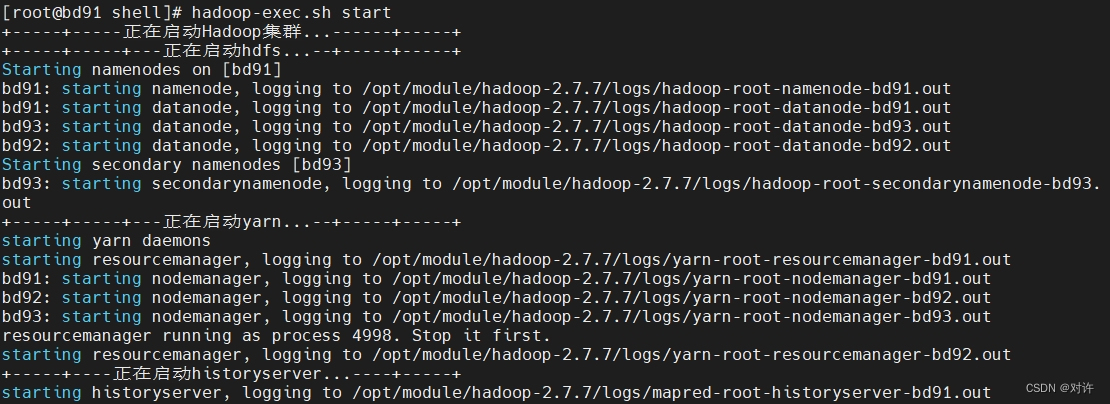

1) 启动Hadoop集群

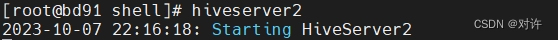

2) 使用hiveserver2开启Hive的JDBC服务

3) 基本使用

from impala.dbapi import connect

from impala.util import as_pandas# 连接Hive

conn = connect(host='bd91', port=10000, auth_mechanism='PLAIN', user="root", password="123456", database="default")

# 创建游标

cursor = conn.cursor()

# 执行查询

cursor.execute("select * from stu")

# 结果转换为DataFrame

df = as_pandas(cursor)

print(df.to_string())

# 关闭连接

cursor.close()

conn.close()