目标检测+车道线识别+追踪+测距

本文主要讲述项目集成:从车道线识别、测距、到追踪,集各种流行模型于一体!

不讲原理,直接上干货!

把下文环境配置学会,受益终生!

各大项目皆适用!

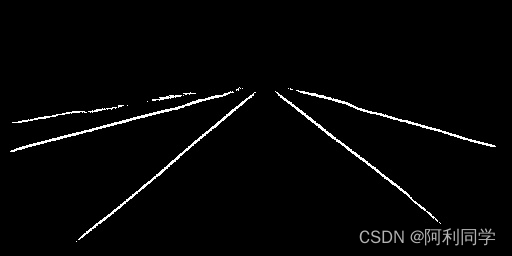

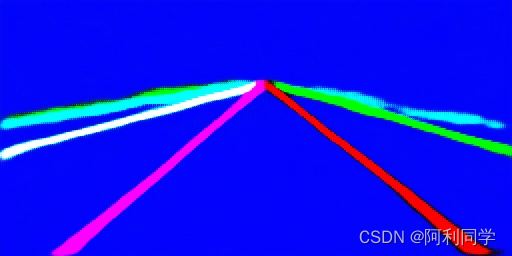

先看下本项目的效果:

环境配置

1.进入项目

cd lane_distance

2.创建虚拟环境

conda crate -n lane python=3.9

3.激活虚拟环境

conda activate lane

4.安装环境

pip install -r requirements.txt

5.运行带代码

python test.py

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qmfjC7tw-1688790465860)(./data/source_image/input.jpg)]

项目介绍

目标检测、车道线识别、追踪以及测距是计算机视觉和自动驾驶领域的关键技术,下面将对这四个方面进行简单介绍。

-

目标检测: 目标检测是指从图像或视频中准确地检测和定位出感兴趣的目标物体。目标可以是人、车辆、动物等。常见的目标检测算法包括基于深度学习的方法,如Faster R-CNN、YOLO和SSD等。这些算法通过在图像中生成候选框,并使用分类模型确定每个框内是否存在目标来实现目标检测。

-

车道线识别: 车道线识别是自动驾驶系统中的重要一环,它可以识别和提取车辆前方道路上的车道线信息。通常,车道线识别算法会使用图像处理技术,如边缘检测、色彩过滤和霍夫变换等,来提取车道线的位置和形状信息。这些信息可用于导航、路径规划和车道保持等任务。

-

追踪: 目标追踪是指在视频序列中对一个或多个目标物体进行连续跟踪的过程。追踪算法会在视频帧中检测目标,然后使用运动模型和特征匹配等技术来预测和更新目标的位置。常见的目标追踪算法包括卡尔曼滤波器、粒子滤波器和相关滤波器等。

-

-

测距: 测距是指通过图像信息来估计目标物体与相机之间的距离。传统的方法包括使用双目视觉、结构光或者时间飞行等技术。在自动驾驶系统中,常常使用单个摄像头进行单目深度估计。这需要根据目标物体在图像中的大小、形状和视差等因素,利用几何关系和机器学习模型来计算目标的真实距离。

将当下算法集成,再也不用左一扒,右一挠,相信会学到会多!

项目集成

目标检测、车道线识别、追踪和测距是计算机视觉和自动驾驶领域的重要任务,而将它们集成到一个算法中可以提高系统的全面感知能力和决策准确性。下面是一个简单的集成算法框架,基于深度学习和计算机视觉技术。

-

数据获取和预处理:

首先,从摄像头或传感器获取图像或视频流,并进行预处理。预处理步骤可能包括图像去噪、色彩校正和尺度调整等。 -

目标检测:

使用深度学习的目标检测算法YOLO对图像或视频中的目标进行检测和定位。这些算法可以输出每个目标的类别、位置和置信度等信息。 -

车道线识别:

对于每个图像帧,利用图像处理技术(如边缘检测和霍夫变换)来识别图像中的车道线。这可以提供关于道路结构和车道位置的信息。 -

追踪:

将目标检测结果与前一帧的跟踪结果进行匹配,以实现目标的连续追踪。使用运动模型和特征匹配等技术来预测和更新目标的位置。这可以提供目标的运动轨迹和速度等信息。 -

测距:

利用单目视觉或其他深度估计技术,根据目标在图像中的大小、形状和视差等信息,计算目标与相机之间的真实距离。这可以提供关于目标与车辆的相对距离,从而帮助系统做出更准确的决策。 -

集成和决策:

将目标检测、车道线识别、追踪和测距的结果进行集成,并进行高级决策和规划。例如,根据目标的类别、位置和速度等信息,进行避障、路径规划和车辆控制等决策。

集成算法的性能和准确度取决于各个模块的质量和相互之间的协调。因此,需要根据具体应用场景进行算法优化和参数调整,以满足实时性、鲁棒性和准确性要求。

![[分块][STL][树]【Centroids】不一样的解法](https://img-blog.csdnimg.cn/img_convert/721eed7ecc8c5d7b7441aab740df1eae.png)