✨作者主页:IT研究室✨

个人简介:曾从事计算机专业培训教学,擅长Java、Python、微信小程序、Golang、安卓Android等项目实战。接项目定制开发、代码讲解、答辩教学、文档编写、降重等。

☑文末获取源码☑

精彩专栏推荐⬇⬇⬇

Java项目

Python项目

安卓项目

微信小程序项目

文章目录

- 一、前言

- 二、开发环境

- 三、系统界面展示

- 四、代码参考

- 五、论文参考

- 六、系统视频

- 结语

一、前言

随着信息技术的快速发展,招聘信息推荐系统作为一种能够有效地将招聘信息和求职者进行匹配的工具,越来越受到人们的关注。本课题的研究背景在于,现有的招聘信息推荐系统往往存在着信息质量不高、推荐精准度不够等问题,无法满足用户的需求。因此,本研究旨在开发一个更加智能化、精准化的招聘信息推荐系统,以提高招聘效率和效果,解决现有问题的不足。

目前的招聘信息推荐系统主要存在着以下问题:

信息质量不高:许多招聘网站的信息更新不及时,招聘信息不完整或者已经过期,导致用户获取不到最新的、有用的信息。

用户体验不佳:一些招聘网站的设计混乱,使用流程复杂,让用户感到不便。同时,缺乏个性化的推荐服务也使得用户体验大打折扣。

本课题的研究目的是开发一个更加智能化、精准化的招聘信息推荐系统,以提高招聘效率和效果。具体来说,本课题需要实现以下功能:

招聘信息的爬取和筛选:爬取最新的招聘信息,并进行筛选和清洗,以保证信息的真实性和完整性。

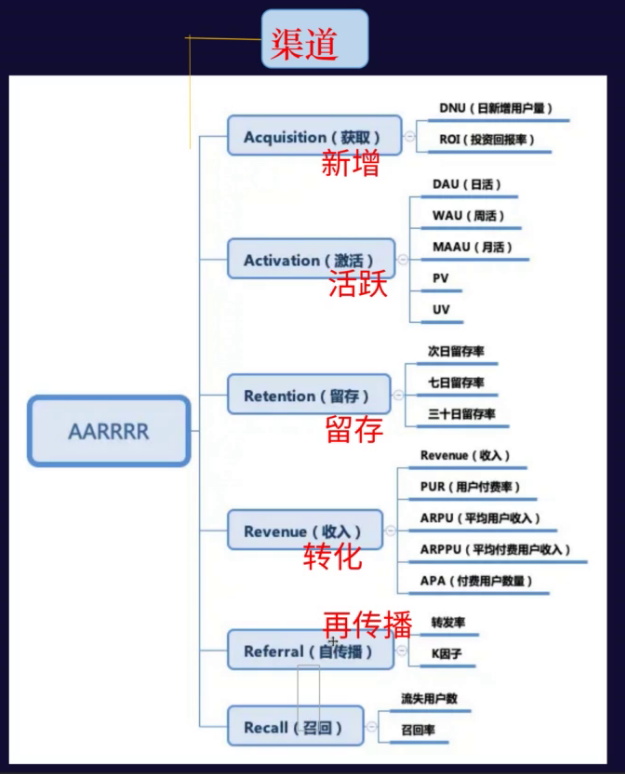

用户画像的建立:根据用户的背景、技能、兴趣等因素建立用户画像,以实现个性化的推荐服务。

可视化看板的实现:通过可视化看板对系统运行情况进行监控和分析,以便管理员能够及时发现问题并进行调整。

本课题的研究意义在于解决现有招聘信息推荐系统存在的问题,提高招聘效率和效果。具体来说,本课题的意义包括以下几点:

提高招聘效率:通过智能化、精准化的推荐服务,使用户能够更快地找到适合自己的职位,从而降低招聘成本和时间成本。

提高招聘效果:通过考虑用户的个人背景、技能和兴趣等因素进行推荐,可以更好地满足用户的需求,从而提高招聘效果。

改善用户体验:通过提供个性化的推荐服务、设计简洁易用的界面以及实时监控系统运行情况等功能,可以大大改善用户体验。

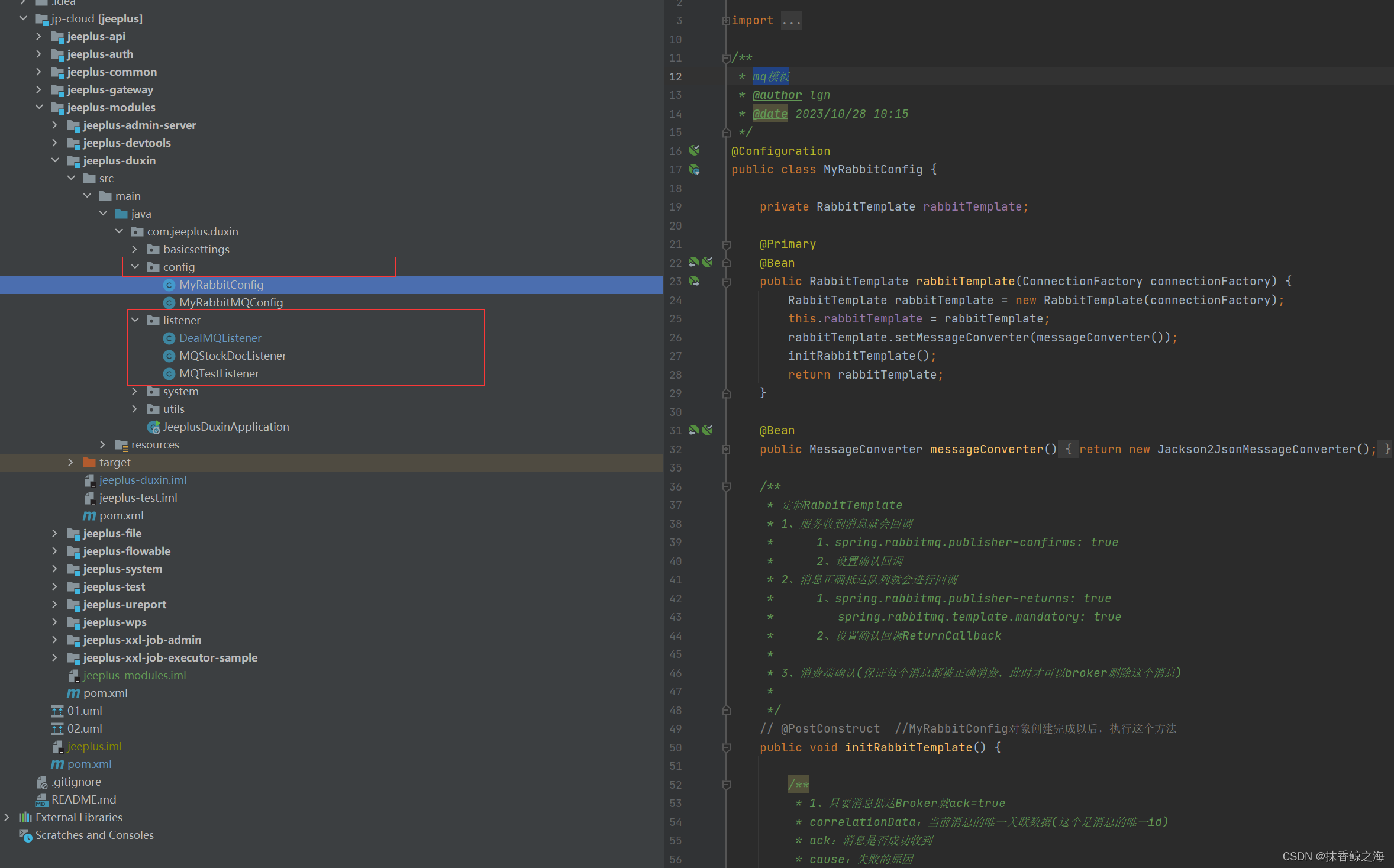

二、开发环境

- 开发语言:Python

- 数据库:MySQL

- 系统架构:B/S

- 后端:Django

- 前端:Vue

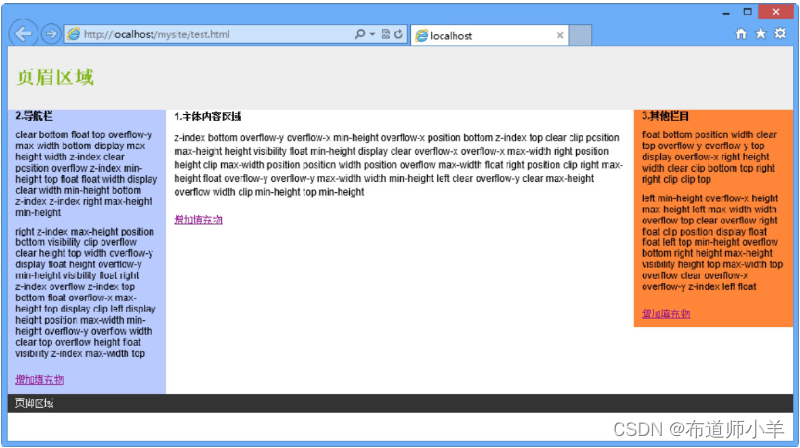

三、系统界面展示

- 招聘信息推荐系统界面展示:

四、代码参考

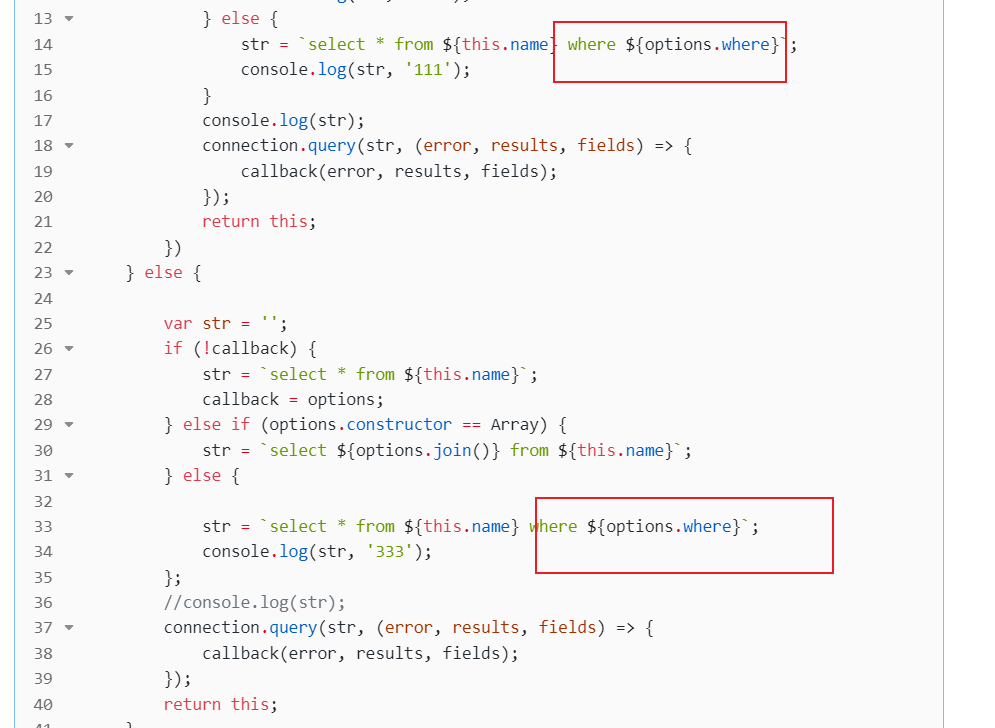

- 招聘信息推荐系统项目实战代码参考:

class Spider51JobPipeline:def process_item(self, item, spider):print(item)return itemclass Spider51JobMysqlPipeline:def open_spider(self, spider):# 读取settings.py中的配置项host = spider.settings.get("MYSQL_DB_HOST")port = spider.settings.get("MYSQL_DB_PORT")dbname = spider.settings.get("MYSQL_DB_NAME")user = spider.settings.get("MYSQL_DB_USER")pwd = spider.settings.get("MYSQL_DB_PASSWORD")# 创建数据库链接self.db_conn = pymysql.connect(host=host, port=port, db=dbname, user=user, password=pwd)# 打开游标self.db_cur = self.db_conn.cursor()def process_item(self, item, spider):job_table_name = spider.settings.get("MYSQL_DB_JOB_TABLE_NAME")# print(dict(it,这调整一下。values = (item["title"],item['company'],item["salary"],item['address'],item["post"],item['experience'],item['message'],) # 与占位符%s对应的数据# sql语句,数据部分使用占位符%s代替sql = "insert into "+ job_table_name +"(job_title,job_company,job_salary,job_address,job_post,job_experience,job_message) values(%s,%s,%s,%s,%s,%s,%s)"self.db_cur.execute(sql, values) # 执行SQL语句self.db_conn.commit()return itemdef close_spider(self, spider):self.db_cur.close() # 关闭游标self.db_conn.close() # 关闭数据库连接class Spider51JobSpiderMiddleware:# Not all methods need to be defined. If a method is not defined,# scrapy acts as if the spider middleware does not modify the# passed objects.@classmethoddef from_crawler(cls, crawler):# This method is used by Scrapy to create your spiders.s = cls()crawler.signals.connect(s.spider_opened, signal=signals.spider_opened)return sdef process_spider_input(self, response, spider):# Called for each response that goes through the spider# middleware and into the spider.# Should return None or raise an exception.return Nonedef process_spider_output(self, response, result, spider):# Called with the results returned from the Spider, after# it has processed the response.# Must return an iterable of Request, or item objects.for i in result:yield idef process_spider_exception(self, response, exception, spider):# Called when a spider or process_spider_input() method# (from other spider middleware) raises an exception.# Should return either None or an iterable of Request or item objects.passdef process_start_requests(self, start_requests, spider):# Called with the start requests of the spider, and works# similarly to the process_spider_output() method, except# that it doesn’t have a response associated.# Must return only requests (not items).for r in start_requests:yield rdef spider_opened(self, spider):spider.logger.info('Spider opened: %s' % spider.name)class Spider51JobDownloaderMiddleware:# Not all methods need to be defined. If a method is not defined,# scrapy acts as if the downloader middleware does not modify the# passed objects.@classmethoddef from_crawler(cls, crawler):# This method is used by Scrapy to create your spiders.s = cls()crawler.signals.connect(s.spider_opened, signal=signals.spider_opened)return sdef process_request(self, request, spider):# Called for each request that goes through the downloader# middleware.# Must either:# - return None: continue processing this request# - or return a Response object# - or return a Request object# - or raise IgnoreRequest: process_exception() methods of# installed downloader middleware will be calledreturn Nonedef process_response(self, request, response, spider):# Called with the response returned from the downloader.# Must either;# - return a Response object# - return a Request object# - or raise IgnoreRequestreturn responsedef process_exception(self, request, exception, spider):# Called when a download handler or a process_request()# (from other downloader middleware) raises an exception.# Must either:# - return None: continue processing this exception# - return a Response object: stops process_exception() chain# - return a Request object: stops process_exception() chainpassdef spider_opened(self, spider):spider.logger.info('Spider opened: %s' % spider.name)

五、论文参考

- 计算机毕业设计选题推荐-招聘信息推荐系统-论文参考:

六、系统视频

招聘信息推荐系统项目视频:

计算机毕业设计选题推荐-招聘信息推荐系统-Python项目

结语

计算机毕业设计选题推荐-招聘信息推荐系统-Python项目实战

大家可以帮忙点赞、收藏、关注、评论啦~

源码获取:私信我

精彩专栏推荐⬇⬇⬇

Java项目

Python项目

安卓项目

微信小程序项目