技术概述

微博是一个社交媒体平台,用户可以在上面发布和分享各种内容,包括文字、图片、音频和视频。微博视频是微博上的一种重要的内容形式,有时我们可能想要下载微博视频到本地,以便于观看或分析。但是,微博视频并没有提供直接的下载链接,而是通过一些加密和混淆的方式,将视频嵌入到网页中。因此,如果我们想要爬取微博视频,就需要使用一些特殊的技术和工具。

在本文中,我们将介绍一种利用RoboBrowser库和爬虫代理实现微博视频的爬取的方法。RoboBrowser是一个Python库,它可以模拟浏览器的行为,自动处理网页的解析、表单的提交、Cookie的管理等。爬虫代理是一种服务,它可以提供一些代理IP地址,让我们的爬虫程序可以通过这些代理IP地址访问目标网站,从而避免被目标网站的反爬虫机制识别和封禁。我们将使用爬虫代理的服务,它提供了稳定和高效的代理IP地址,以及方便的API接口。

我们的爬虫程序的主要流程如下:

- 获取需要爬取的微博视频的URL列表。

- 对每个URL,使用RoboBrowser库打开网页,并获取页面中的视频元素。

- 从视频元素中提取视频的真实链接,并下载视频到本地。

- 使用多线程技术,提高爬取效率。

技术细节

获取微博视频的URL列表

为了获取微博视频的URL列表,我们可以使用一些第三方的工具或网站,例如微博视频下载,它可以根据用户的ID或关键词,搜索和筛选出相关的微博视频,并提供视频的URL。我们可以手动或自动地从这些工具或网站中获取微博视频的URL列表,并保存到一个文本文件中,例如video_urls.txt。每个URL占一行,例如:

https://weibo.com/tv/show/1034:4629506353161728?from=old_pc_videoshow

https://weibo.com/tv/show/1034:4629506353161728?from=old_pc_videoshow

https://weibo.com/tv/show/1034:4629506353161728?from=old_pc_videoshow

使用RoboBrowser库打开网页,并获取页面中的视频元素

为了使用RoboBrowser库,我们需要先安装它,可以使用pip命令:

pip install robobrowser

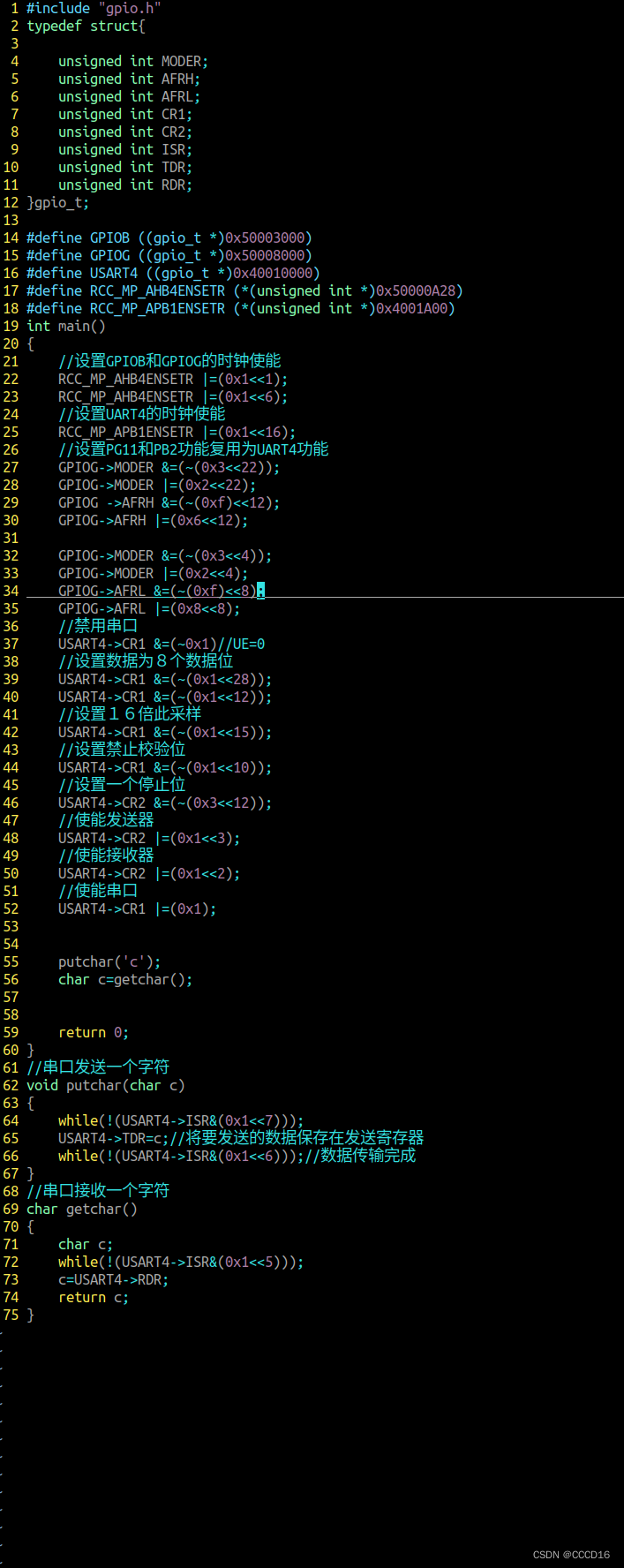

然后,我们需要导入RoboBrowser库,并创建一个RoboBrowser对象,设置用户代理和代理服务器。我们需要使用爬虫代理的域名、端口、用户名和密码,这些信息可以从下面爬虫代理的官网获取。我们可以使用以下代码:

# 导入RoboBrowser库

from robobrowser import RoboBrowser# 亿牛云 爬虫代理标准版 设置代理服务器的郁闷和端口

proxy_host = "www.16yun.cn" #官网注册后提取

proxy_port = "9020"# 亿牛云 爬虫代理标准版,设置代理服务器的用户名和密码

# 请将your_username和your_password替换为你的实际用户名和密码

proxy_username = "your_username"

proxy_password = "your_password"# 创建RoboBrowser对象

# 设置用户代理和代理服务器

browser = RoboBrowser(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36",proxy_host=proxy_host,proxy_port=proxy_port,proxy_username=proxy_username,proxy_password=proxy_password,

)

接下来,我们需要定义一个函数,用于打开指定的URL,并获取页面中的视频元素。我们可以使用以下代码:

# 定义获取视频元素的函数

def get_video_element(url):# 打开指定的URLbrowser.open(url)# 获取页面中的视频元素# 视频元素的标签是video,类名是weibo_player_videovideo_element = browser.get_element_by_tag("video", class_="weibo_player_video")# 返回视频元素return video_element

从视频元素中提取视频的真实链接,并下载视频到本地

为了从视频元素中提取视频的真实链接,我们需要获取视频元素的src属性,它是视频的真实链接。我们可以使用以下代码:

# 定义提取视频链接的函数

def get_video_url(video_element):# 获取视频元素的src属性,即视频的真实链接video_url = video_element.get_attribute("src")# 返回视频链接return video_url

为了下载视频到本地,我们需要使用requests库,它可以发送HTTP请求,获取视频的内容,并保存到本地。我们需要先安装requests库,可以使用pip命令:

pip install requests

然后,我们需要导入requests库,并定义一个函数,用于下载视频到本地。我们可以使用以下代码:

# 导入requests库

import requests# 定义下载视频的函数

def download_video(video_url):# 发送HTTP请求,获取视频的内容video_content = requests.get(video_url).content# 生成视频的文件名,使用视频的URL的最后一部分video_filename = video_url.split("/")[-1]# 打开一个文件,以二进制写入模式with open(video_filename, "wb") as f:# 将视频的内容写入文件f.write(video_content)# 打印下载成功的信息print("视频下载成功:", video_filename)

使用多线程技术,提高爬取效率

为了使用多线程技术,我们需要导入threading库,并定义一个函数,用于执行爬取视频的任务。我们可以使用以下代码:

# 导入threading库

import threading# 定义爬取视频的任务函数

def crawl_video(url):# 获取视频元素video_element = get_video_element(url)# 提取视频链接video_url = get_video_url(video_element)# 下载视频download_video(video_url)

然后,我们需要读取微博视频的URL列表,并使用线程执行爬取视频的任务。我们可以使用以下代码:

# 读取微博视频的URL列表

with open("video_urls.txt", "r") as f:video_urls = f.read().splitlines()# 使用线程爬取视频

threads = []

for url in video_urls:# 创建一个线程,执行爬取视频的任务函数thread = threading.Thread(target=crawl_video, args=(url,))# 启动线程thread.start()# 将线程添加到线程列表threads.append(thread)# 等待所有线程完成

for thread in threads:thread.join()

技术总结

本文介绍了如何利用RoboBrowser库和爬虫代理爬取微博视频的方法。我们利用了RoboBrowser库的网页解析和表单提交功能,获取了微博视频的真实链接;我们利用了爬虫代理的代理IP服务,避免了被微博的反爬虫机制识别和封禁。我们还使用了多线程技术,提高了爬取效率。这种方法可以帮助我们下载微博视频到本地,以便于观看或分析。