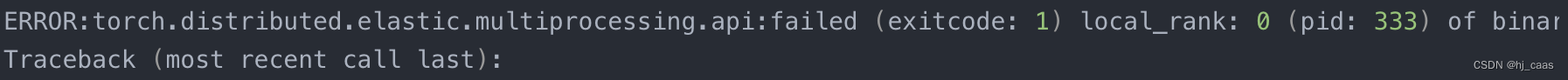

在多卡运行时,会出现错误(ERROR:torch.distributed.elastic.multiprocessing.api:failed),但是单卡运行并不会报错,通常在反向梯度传播时多卡梯度不同步。但我是在多卡处理数据进行tokenizer阶段报错,这竟然也会出错,还没涉及到训练,有点不明所以。

1. 错误

2. 解决方法

设置find_unused_parameters=True.

3. 参考

[1] https://blog.csdn.net/QLeelq/article/details/130404416

[2] https://zhuanlan.zhihu.com/p/592515484