感想:由于看不懂官方代码的原因,自己这方面耽误了一段时间,一方面,在AI与经济学之间犹豫了许久,另一方面,工作 了半年,也没发工资,没空找培训代码的课程,所以停止更新了三四个月,现在想通了。路要一步一步的走。事情也要一点一点的去深耕细作。今天,AI又重新搞起来啦,先从研读论文开始吧!

摘要

* RNNs中不同类型的循环单元。特别关注,实现门机制的复杂的单元。比如:LSTM、GRU。

传统的循环单元: tanh 单元。

介绍

数据集: three polyphonic music datasets

two internal datasets

背景:RNN

* RNN是传统前馈神经网络的拓展,传统前馈神经网络能够处理a variable-length sequence input

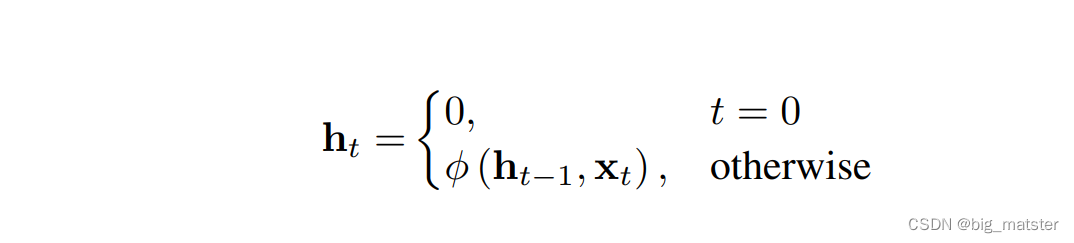

RNN处理变长序列,通过使用:a recurrent hidden state 循环隐藏状态。

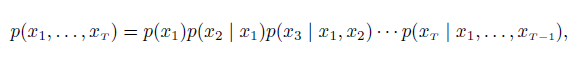

RNN更新循环隐藏状态

传统的循环隐藏状态更新方程:

a smooth, bounded function(平滑有界函数)

一个生成式RNN的输出是一个序列下一个元素的概率分布。给定当前状态 生成时模型可以捕获可变长度的模型分布。只需用一个特别的输出标记一个序列的末尾就可以实现可变长度。

RNN很难捕捉到长短时依赖(Long-term dependencies) : 梯度消失或梯度爆炸。

解决方法: simple clipped gradient 裁剪的梯度。

设计比通常激励函数更复杂的激励函数。一个简单非线性元素级别的仿射变换

通过门单元实现的: LSTM单元、GRU单元。

门循环神经网络

Hochreiter and Schmidhuber(1997): 提出LSTM。

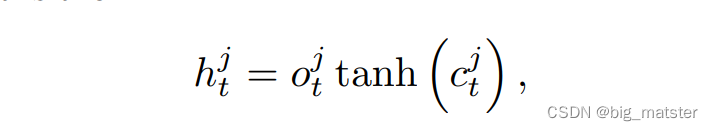

本文使用的:

the implementation of LSTM as used in Graves(2013)

是一个输出门。计算公式如下:

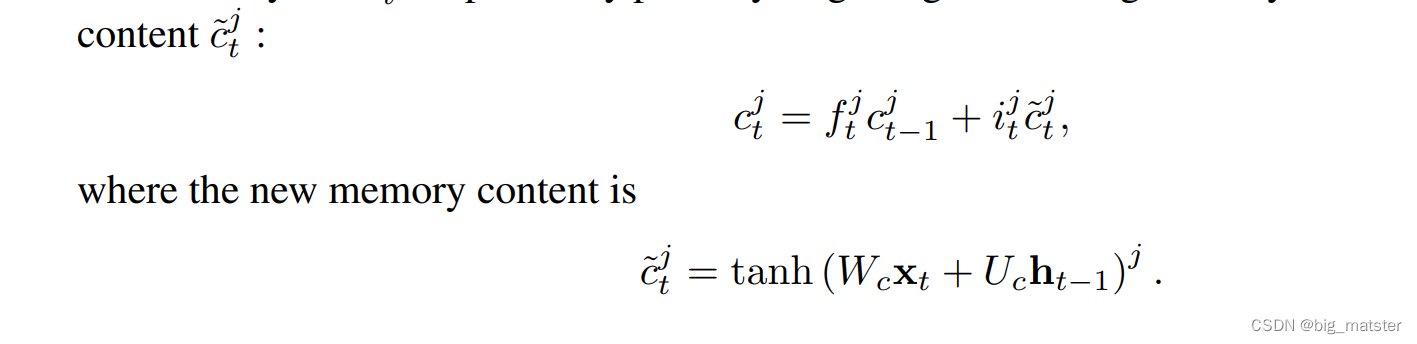

记忆单元:

通过部分已经存在记忆部分来更新,增加一个新的记忆内容。

遗忘门:

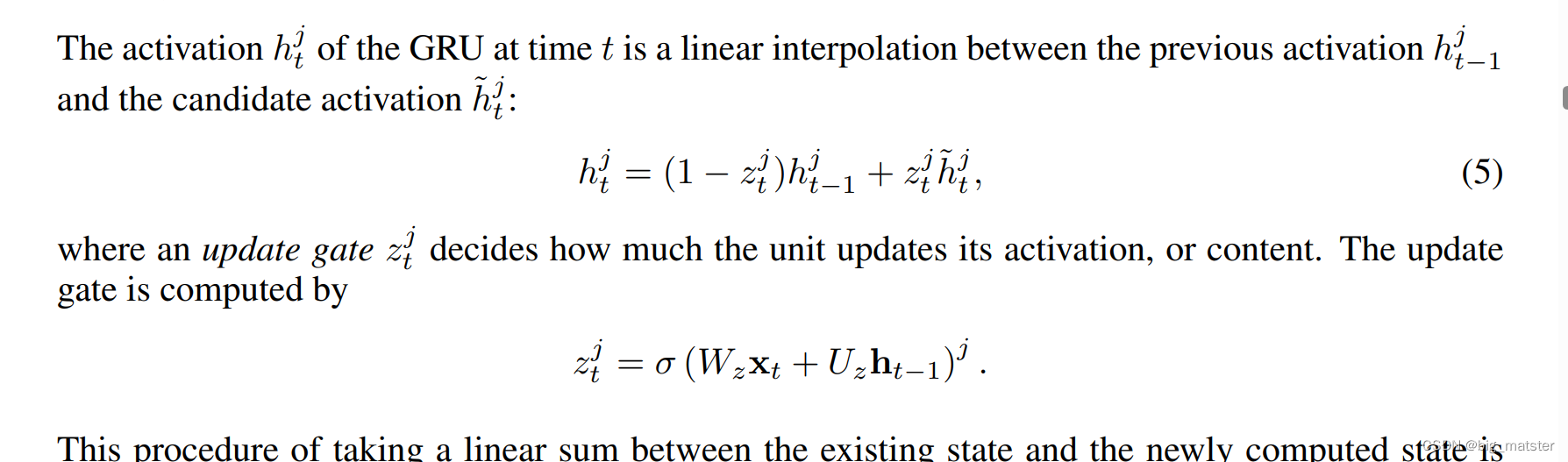

门循环单元(GRU)

每个循环单元可以自适应的捕捉不同时间刻度下的依赖。GRU具有调节信息流动的门单元,但是没有一个单独的记忆单元。

讨论

LSTM和GRU共有的特征从t时刻到t+1时刻的更新。

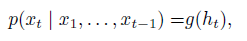

实验

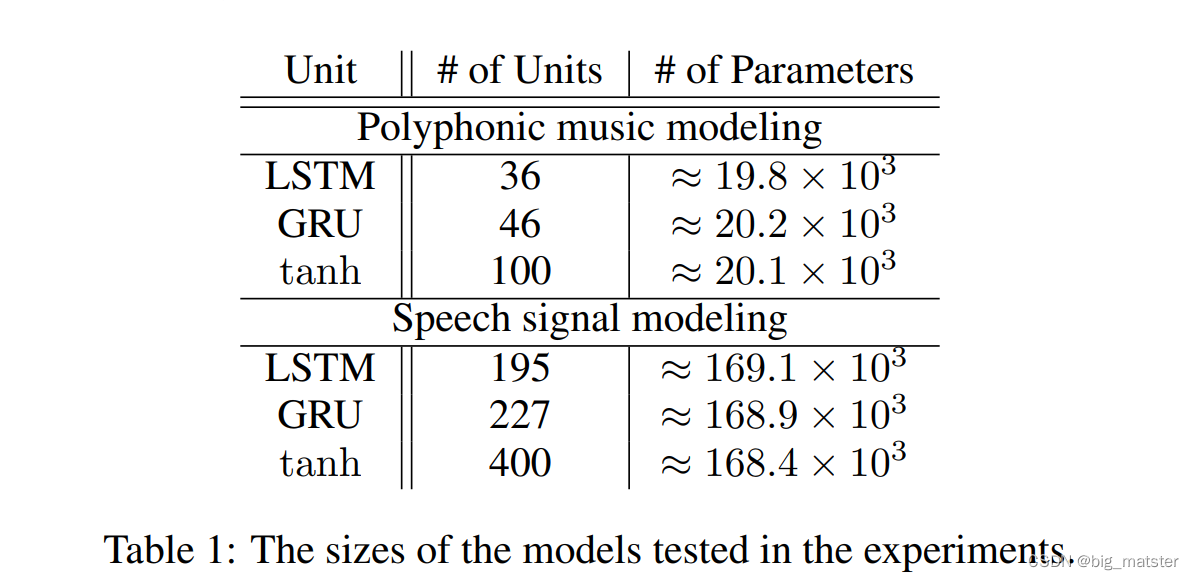

模型

LSTM units

, GRUs

tanh units

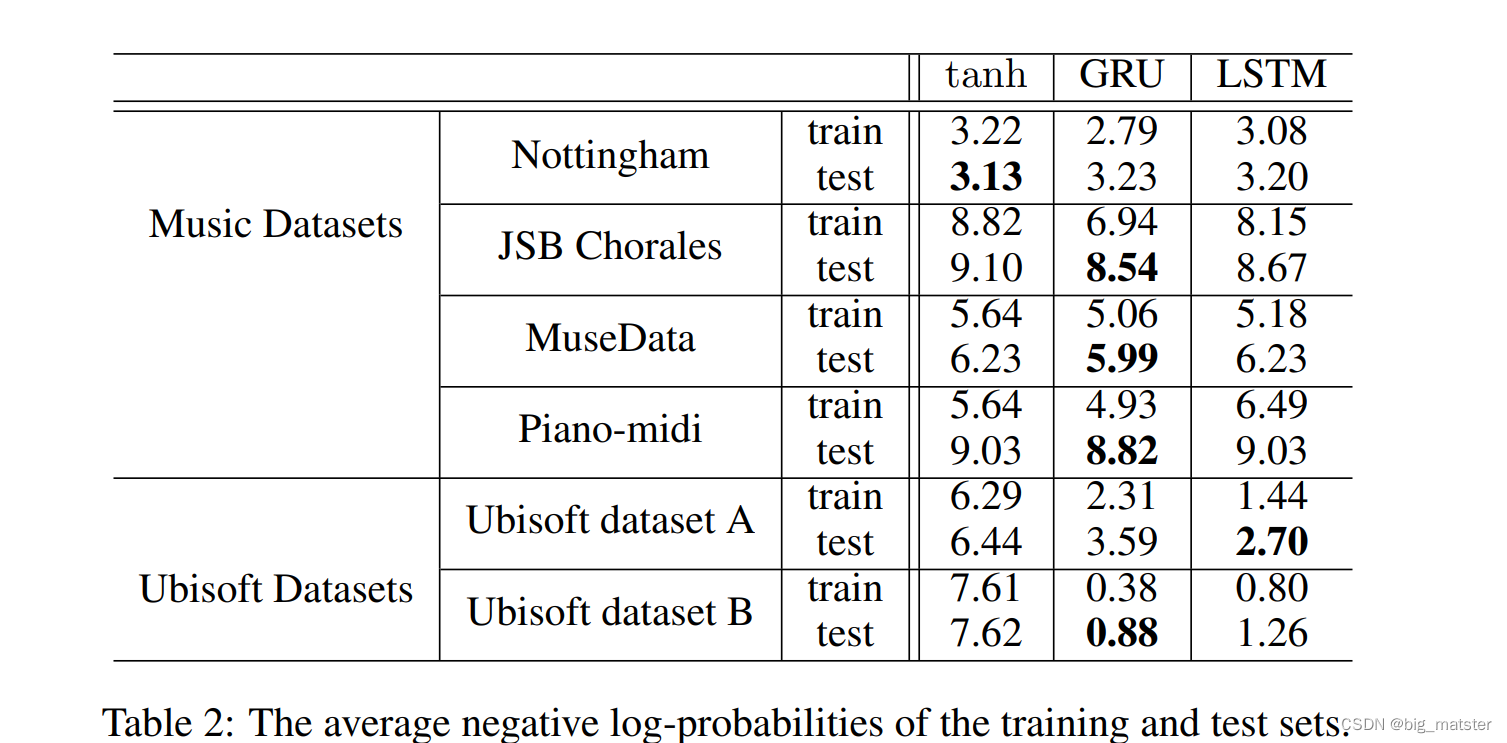

结果和分析

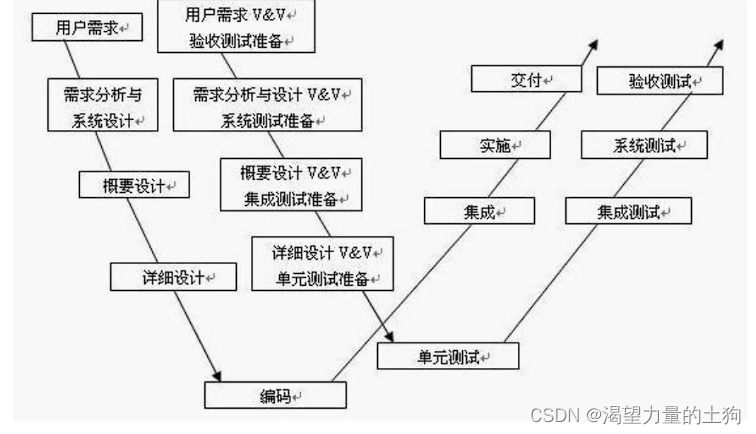

论文思路

在同一数据集上比较两个门单元:LSTM、GRU,并对其表现进行评价其优劣。

解决问题:训练RNN捕捉长期依赖时,经常出现梯度消失和梯度爆炸。

报课之前,先自己总结论文写作思路以及解决问题,不但的积累!争取在老师的辅导下冲刺二区。