hadoop fs -help rm 查看rm命令作用

hadoop fs 查看命令

1. 创建文件夹:

# hdfs前缀也是可以的。更推荐hadoop

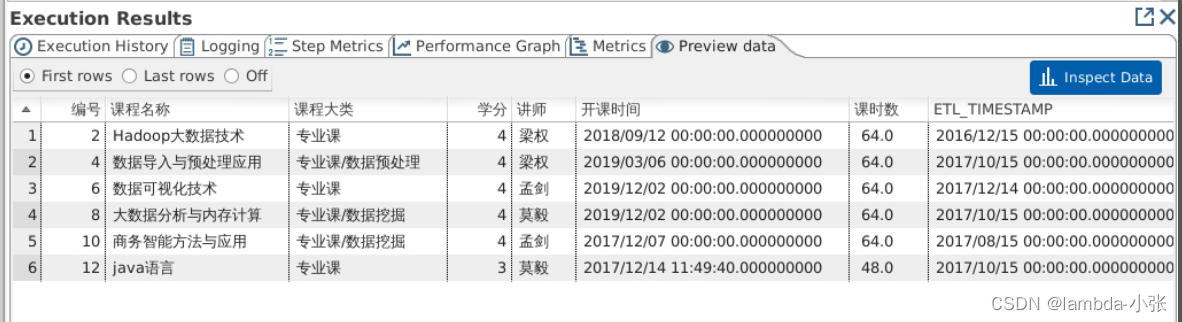

hadoop fs -mkdir /sanguo2.上传至hdfs命令:

作用: 从本地上传hdfs系统 (本地文件被剪切走,不存在了)

命令:

# 新建文件

vi shuguo.txt

#进入后 输入一些文字,保存退出即可#同shuguo.txt要在同目录下,输入命令

hadoop fs -moveFromLocal shuguo.txt /sanguo

3. 拷贝文件上传到hdfs系统:

#新增文件

vi weiguo.txt

# 输入一些文字,保存并退出# 从本地复制一份文件,至hdfs文件系统

hadoop fs -copyFromLocal weiguo.txt /sanguo# 同上相同,更推荐这种,更加简洁

hadoop fs -put weiguo.txt /sanguo

4. 追加文件内容:

# 新建文件

vi liubei.txt

# 输入一些文字,保存并退出#

hadoop fs -appendToFile liubei.txt /sanguo/shuguo.txt5. 从hdfs下载至本地:

# copy

hadoop fs -copyToLocal /sanguo/shuguo.txt ./# 更推荐这种,简洁

# 下载

hadoop fs -get /sanguo/shuguo.txt ./6. ls命令:

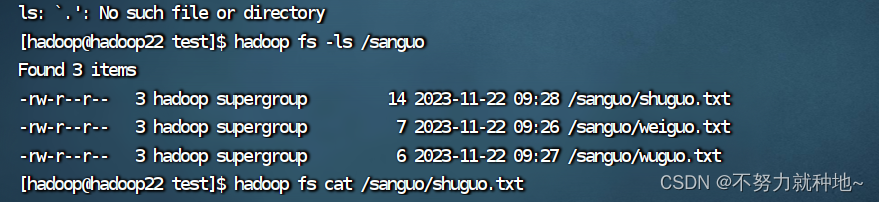

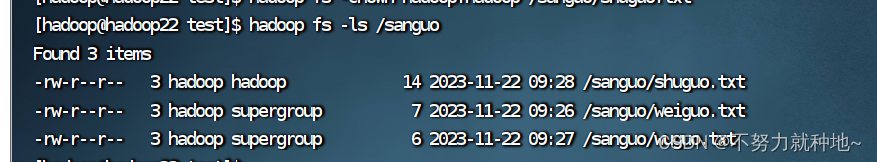

hadoop fs -ls /sanguo

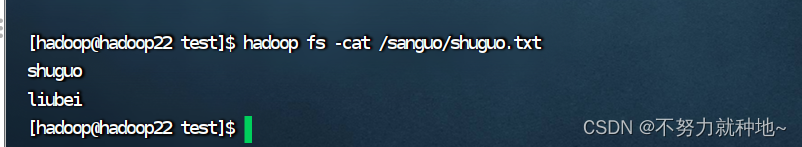

7. cat命令:

hadoop fs -cat /sanguo/shuguo.txt

8.更改权限:

hadoop fs -chown hadoop:hadoop /sanguo/shuguo.txt

9. cp 复制:

# 创建文件夹

hadoop fs -mkdir /jinguo

# 复制

hadoop fs -cp /sanguo/shuguo.txt /jinguo10. mv 移动:

hadoop fs -mv /sanguo/weiguo.txt /jinguo11. tail 查看

hadoop fs -tail /sanguo/shuguo.txt12. 删除文件或文件夹

# 删除文件

hadoop fs -rm /sanguo/shuguo.txt# 递归删除文件夹

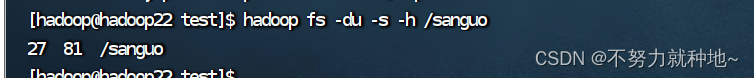

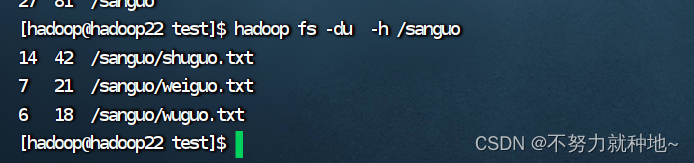

hadoop fs -rm -r /sanguo13. 统计文件夹大小信息:

hadoop fs -du -s -h /sanguo

27 文件大小, 81 副本*文件大小

下面是查看文件夹每个文件的统计信息

hadoop fs -du -h /sanguo

14. 设置副本数量:

hadoop fs -setrep 2 /sanguo/shuguo.txt副本数量记录在NameNode,不要设置超过节点数量的副本,设置超过节点数,最多也只是总节点数量的副本,不会超过DataNode节点数, 如果设置8个副本,如果DataNode节点数有8个,才会有8个副本

总结:命令太多不一一列举了,同centos系统一样,只是前面加了hadoop fs, 很容易记住