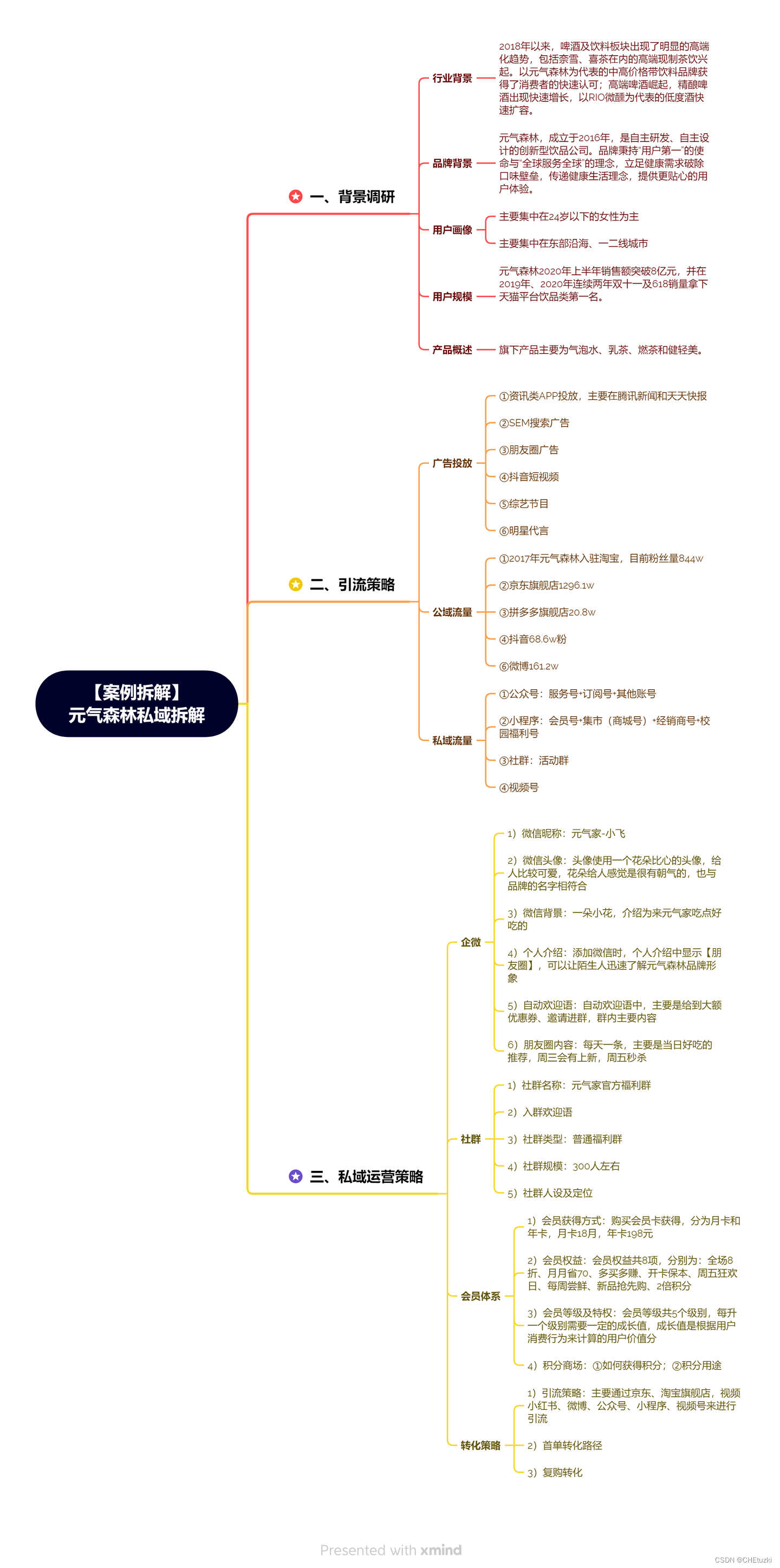

随着人工智能技术的飞速发展,存储在其中发挥着至关重要的作用。特别是在AI训练过程中,存储SSD(固态硬盘)的高性能和可靠性对于提升训练效率和保证数据安全具有不可替代的作用。

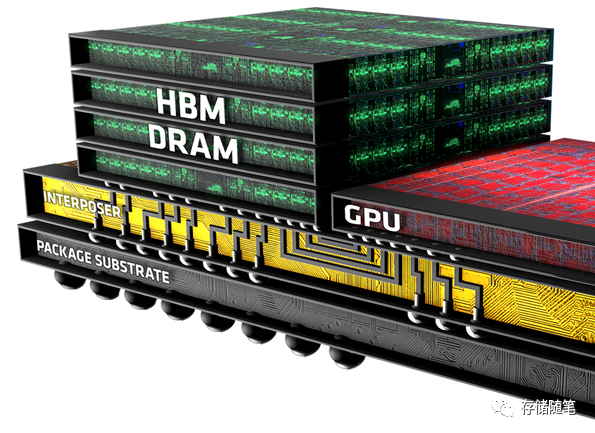

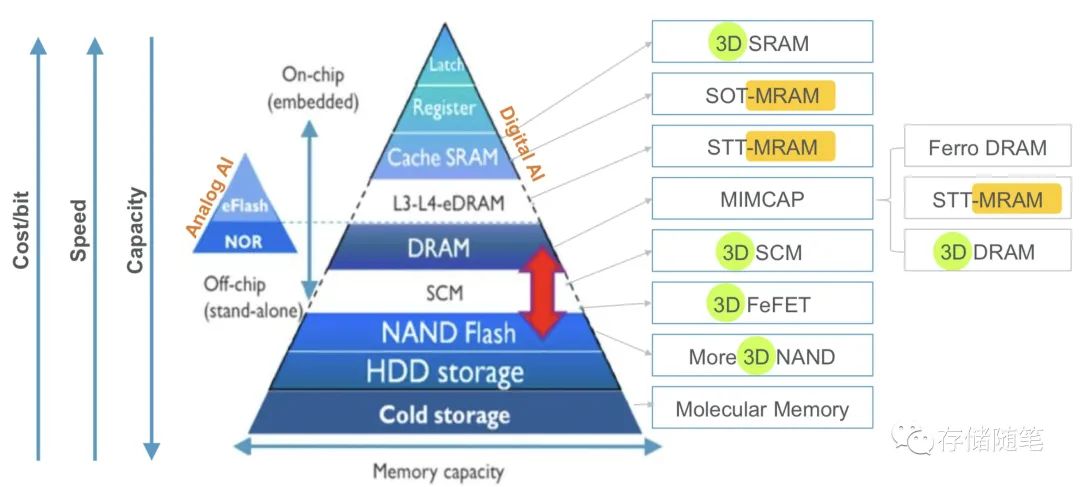

存储SSD在AI发展中的作用和趋势,存储将在两个方面发挥至关重要的作用。一种是本地高速存储,用作缓存,用于将训练数据馈送到 GPU 上的 HBM。由于性能需求,使用了高性能 SSD。存储的另一个关键作用是将所有训练数据集保存在大型数据湖中。

一、本地高速存储:缓存与GPU加速

-

缓存与I/O优化:

-

-

高性能SSD被用作本地高速缓存,将训练数据快速地馈送到GPU上的高带宽内存(HBM)。这大大减少了数据传输延迟,使得AI计算能够更高效地运行。

扩展阅读:三家内存原厂争抢英伟达高端GPU HBM市场

-

使用NVMe(Non-Volatile Memory Express)接口的SSD提供了极高的I/O吞吐量和低延迟,这对于减少数据访问瓶颈非常重要。

-

-

存储层级结构:

-

-

AI应用程序通常会利用多层存储架构,其中SSD位于主存(如DRAM)和磁盘之间,形成一个高效的存储层次结构。这种设计可以显著提高整体系统的响应速度和吞吐能力。

-

-

GPU直连存储:

-

-

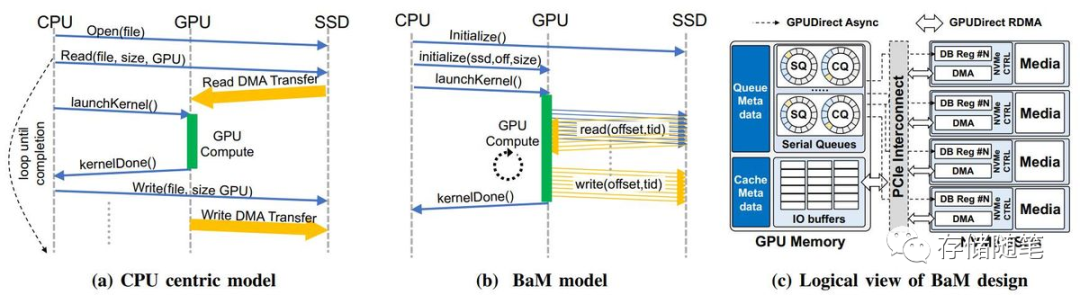

随着PCIe Gen 4及更高版本的推出,GPU可以直接连接到高性能的SSD上,进一步缩短数据路径并降低延迟。GPU直连存储是一个旨在克服传统存储体系结构限制的技术,它通过提供更快的数据访问速度、更高的带宽和更低的延迟,极大地提升了依赖于快速数据处理的应用程序的性能

-

GPU直连存储是一种将GPU直接与固态硬盘(SSD)连接的技术,以减少数据传输路径中的瓶颈并提高整体性能。GPU直连存储的优势:

-

降低延迟:通过绕过CPU和内存,GPU可以直接访问存储设备上的数据,这大大减少了数据在系统中传输的时间,从而降低了延迟。

-

提升带宽:GPU直连存储通常利用PCIe总线,这种高速接口可以提供高带宽的数据传输能力,尤其是随着PCIe标准的升级,如Gen 4及更高版本,带宽得到了显著提升。

-

简化架构:直接连接减少了系统的复杂性,消除了对额外硬件(如桥接芯片)的需求,使得设计更加简洁和高效。

-

优化工作负载:对于计算密集型任务,如机器学习、高性能计算和图形处理,GPU直连存储能够更有效地为GPU提供所需的大量数据,从而优化工作负载执行。

-

加速AI训练:在深度学习模型的训练过程中,需要频繁地访问大量的训练数据。GPU直连存储能够显著加快这个过程,缩短模型训练时间。

-

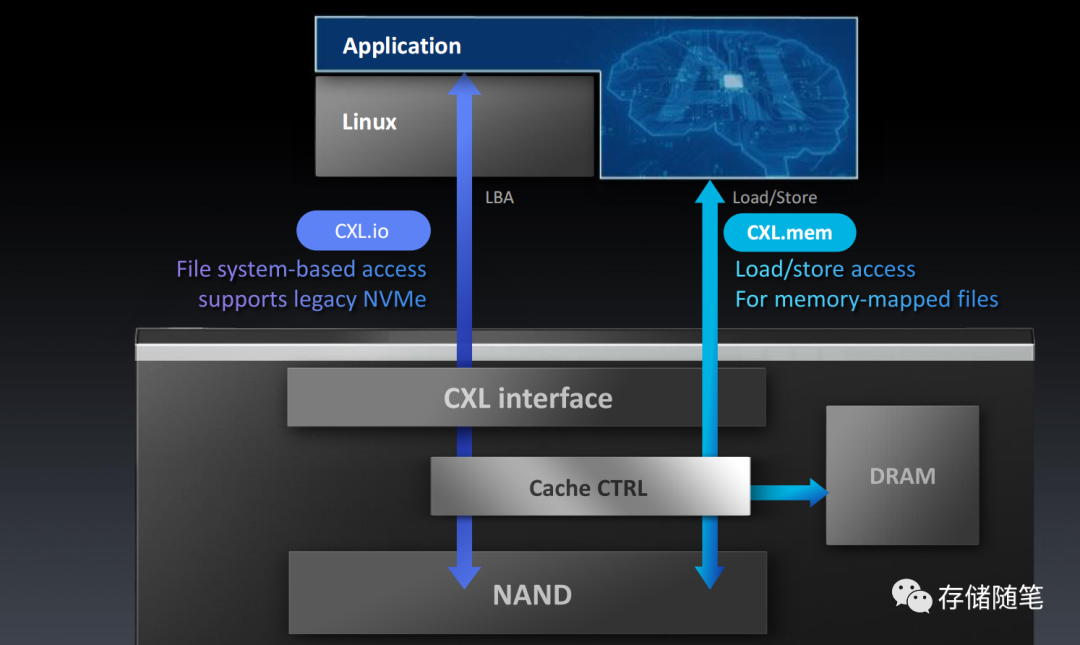

未来潜力:随着新的接口标准和技术的出现,例如Compute Express Link (CXL),GPU直连存储有望继续发展,并提供更高的性能和更低的延迟。

扩展阅读:CXL崛起:2024启航,2025年开启新时代