一、Attention is all you need——李沐论文精读Transformer

论文地址:

https://arxiv.org/pdf/1706.03762.pdf

Transformer论文逐段精读【论文精读】

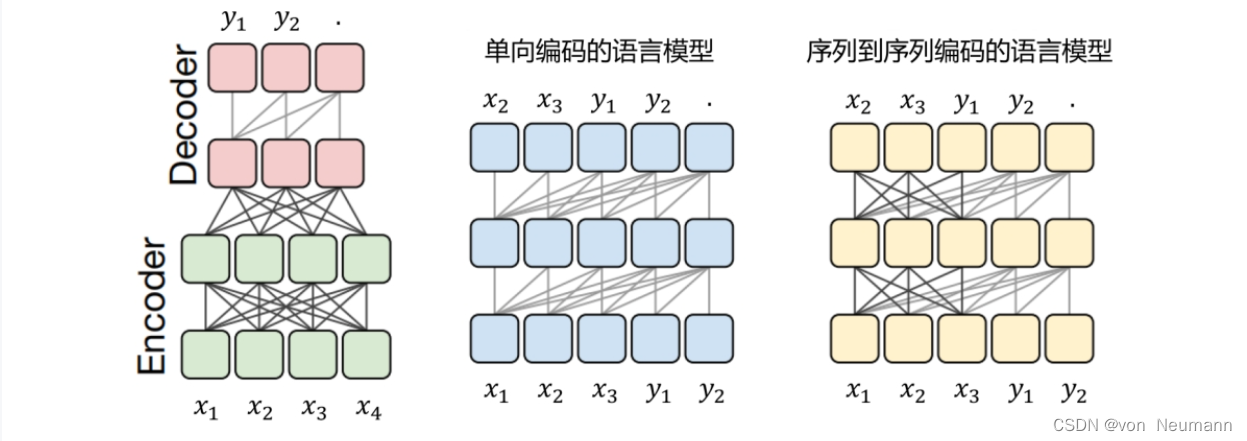

卷积神经网络对较长的序列难以建模,因为他每次看一个比较小的窗口,如果两个像素隔得比较远,要用到很多层卷积才能把隔得很远的两个像素融合起来。但是用Transformer一层就能把整个序列看到。但是卷积有一个好处就是一个输出通道可以认为它可以识别不一样的模式,Transformer也想要这样子的多输出通道的效果,所以就提出了多头注意力。

Transformer

二、李宏毅《深度学习》- Transformer

李宏毅《深度学习》- Transformer

三、Transformer & 时间序列预测

利用Transformer建立时间序列预测模型(附代码)

【长时间序列预测】Autoformer 代码详解之[1]数据预处理及数据读取

电力变压器数据集 (ETDataset)——ETT 时序数据

【python量化】大幅提升预测性能,将NSTransformer用于股价预测

神经网络笔记一:Non-stationary Transformers: Exploring the Stationarity in Time Series Forecasting

NeurIPS2022 | NSTransformers: 非平稳时间序列的通用预测框架

Transformer论文详解——想不懂都难