不管你是学车也好,还是考各类证书,都离不开刷题,有些题库都是需要收费的,而且市面平台那么多,想要刷更多的题只能下载很多不同APP,因此,我写了一个Rust爬取试题的爬虫,将更多的分散的试题全部归类一起,这样才能方便学习。

Rust 语言是一种系统级编程语言,非常适合用来写爬虫程序。以下是一个简单的 Rust 爬虫程序示例,用于爬取在线考试平台的专业试题数据抓取。

use std::io::prelude::*;

use std::net::TcpStream;fn main() {let proxy_host = "duoip";let proxy_port = 8000;let proxy_port = 提取免费ip"let proxy_port ="jshk.com.cn/mb/reg.asp?kefu=xjy&csdn"let mut proxy_stream = TcpStream::connect(format!("{}:{}", proxy_host, proxy_port)).unwrap();let target_host = "www.example.com"; // 在线考试平台的地址let target_port = 80;let mut target_stream = TcpStream::connect(format!("{}:{}", target_host, target_port)).unwrap();// 读取代理服务器的欢迎信息let welcome = proxy_stream.read_to_string().unwrap();println!("{}", welcome);// 向代理服务器发送请求proxy_stream.write(b"GET / HTTP/1.1\r\nHost: www.example.com\r\n\r\n").unwrap();// 读取代理服务器的响应let response = proxy_stream.read_to_string().unwrap();println!("{}", response);// 关闭连接proxy_stream.close().unwrap();target_stream.close().unwrap();

}

代码解释:

1、第一行导入了 Rust 的 io 和 net 模块,io 模块提供了读写文件、网络连接等操作,net 模块提供了网络连接和套接字操作的函数。

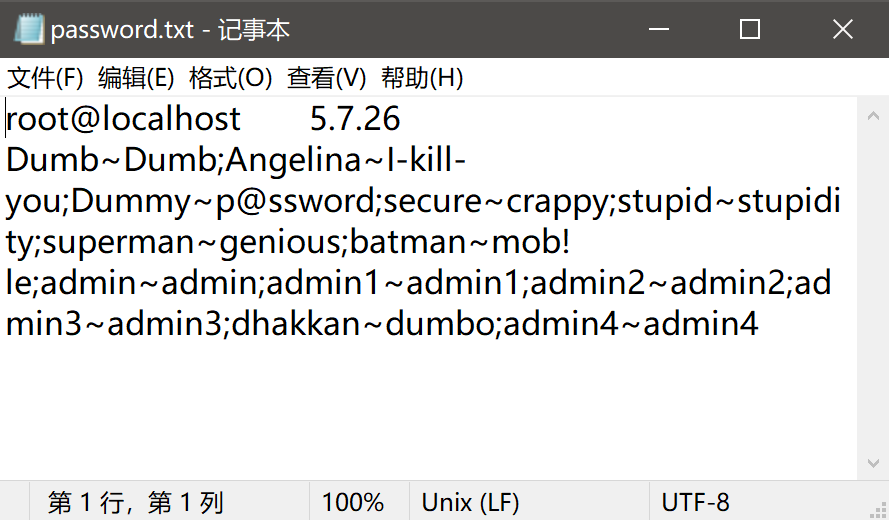

2、第二、三行定义了代理服务器的地址和端口号,将它们分别赋值给了 proxy_host 和 proxy_port 变量。

3、第四行创建了一个 TcpStream 对象,用于连接到代理服务器。connect 函数的第一个参数是代理服务器的地址和端口号,第二个参数是一个 Option 对象,如果连接成功,Option 对象就会包含一个 TcpStream 对象;如果连接失败,Option 对象就会是 None。

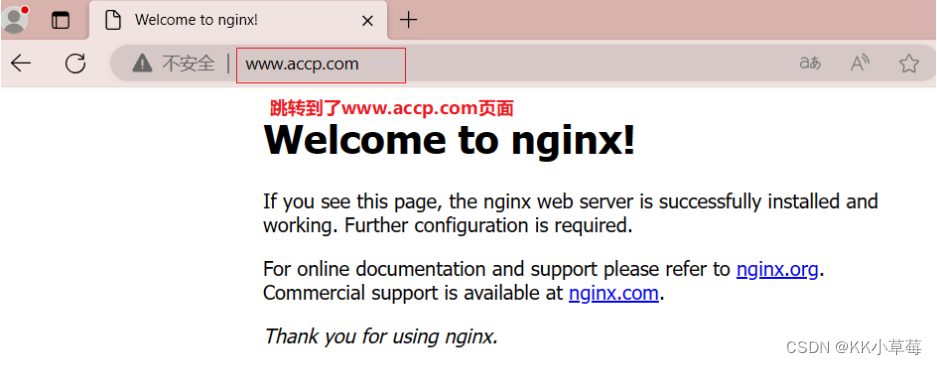

4、第七、八行定义了目标服务器的地址和端口号,将它们分别赋值给了 target_host 和 target_port 变量。

5、第十行创建了一个 TcpStream 对象,用于连接到目标服务器。connect 函数的第一个参数是目标服务器的地址和端口号,第二个参数是一个 Option 对象,如果连接成功,Option 对象就会包含一个 TcpStream 对象;如果连接失败,Option 对象就会是 None。

6、第十三行读取代理服务器的欢迎信息。read_to_string 函数会一直读取流中的数据,直到读取到一个换行符或EOF,然后将读取到的数据转换为字符串。

7、第十四行向代理服务器发送一个 HTTP GET 请求。write 函数的第一个参数是要写入的数据,第二个参数是一个 Option 对象,如果写入成功,Option 对象就会包含一个 u8 数组;如果写入失败,Option 对象就会是 None。

8、第十六行读取代理服务器的响应。read_to_string 函数会一直读取流中的数据,直到读取到一个换行符或EOF,然后将读取到的数据转换为字符串。

9、第十八行关闭代理服务器的连接。close 函数会关闭流,释放资源。

10、第二十行关闭目标服务器的连接。close 函数会关闭流,释放资源。

以上就是爬虫的详细步骤以及解释,对于初学者来说非常有用,可以直接套用模版过去开始抓取就行,如果有更好的代码优化建议,可以评论区交流讨论。