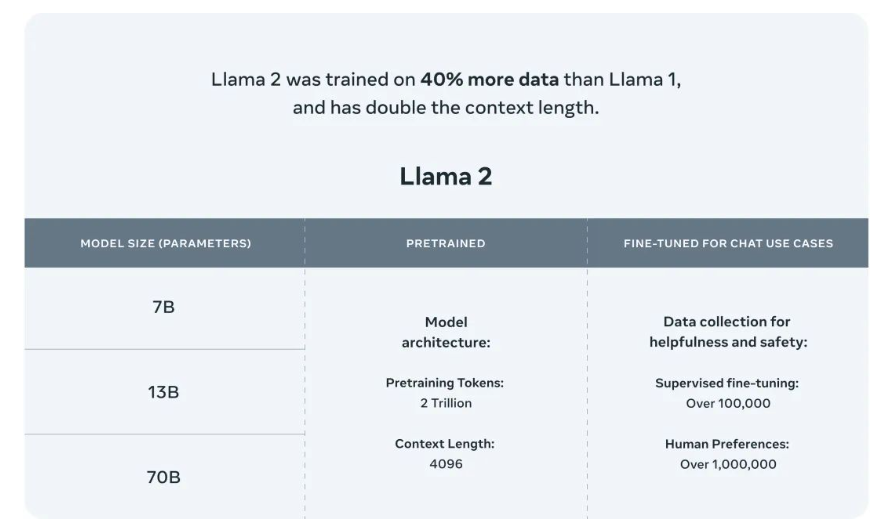

2023年7月18日,Meta 发布了LLaMA 2,包含7B,13B,70B三种参数(34B暂时还未发布)。

官方: https://ai.meta.com/llama/

论文:Llama 2: Open Foundation and Fine-Tuned Chat Models

模型:https://huggingface.co/meta-llama

github:https://github.com/facebookresearch/llama

LLaMA 2相比LLaMA最大亮点之一是允许商业化,但需要注意的是如果使用LLaMA 2的企业月活人数超过7亿,将需要向Meta申请特定的商业许可。

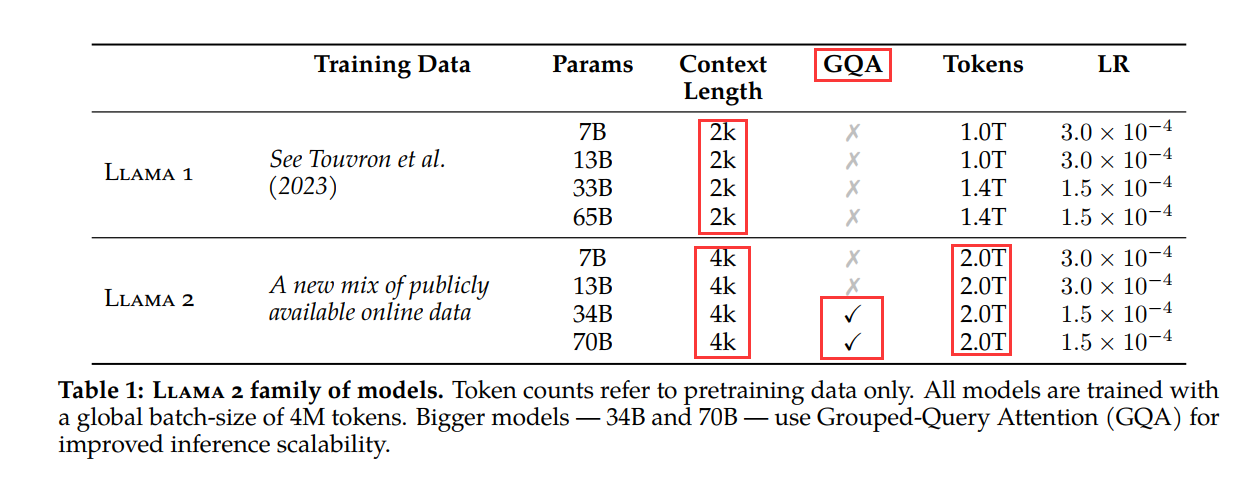

Llama 2 训练语料相比LLaMA多出40%,接受了 2 万亿个标记的训练;

Llama 2 上下文长度是由之前的2048升级到4096,可以理解和生成更长的文本;

Llama 2 的34B、70B模型采用分组查询注意力(GQA),代替了MQA和MHA,主要是考虑效果和易扩展性的权衡。

Llama-2-chat 模型还接受了超过 100 万个新的人类注释的训练,使用来自人类反馈的强化学习来确保安全性和帮助性。

Llama-2-chat 模型可以使用工具和插件。